Wstęp

Droga od zbudowania działającego prototypu AI do wdrożenia systemu produkcyjnego od dawna należy do największych wyzwań w rozwoju sztucznej inteligencji. To, co podczas demo wydaje się prostym procesem — pobieranie istotnych informacji, wzbogacanie promptów, generowanie odpowiedzi — staje się wielokrotnie bardziej złożone przy wdrożeniu na produkcję. Ta złożoność sprawiła, że wielu w branży mówiło raczej o “alchemii” niż inżynierii: tajemniczym procesie, w którym programiści poprawiają konfiguracje, kręcą parametrami i mają nadzieję, że ich systemy nadal będą działać niezawodnie. Pojawienie się inżynierii kontekstu jako dyscypliny oznacza fundamentalną zmianę w podejściu do budowy systemów AI — odejście od metody prób i błędów na rzecz systematycznego, inżynierskiego podejścia. W tej obszernej analizie przyjrzymy się, jak nowoczesne bazy wektorowe i zasady inżynierii kontekstu zmieniają oblicze rozwoju aplikacji AI, umożliwiając budowanie systemów nie tylko działających, ale i rzeczywiście niezawodnych oraz łatwych w utrzymaniu na dużą skalę.

Czym jest inżynieria kontekstu i dlaczego ma znaczenie

Inżynieria kontekstu wyłoniła się jako jedna z najważniejszych dyscyplin we współczesnym rozwoju AI, choć wciąż jest słabo rozumiana przez wielu nowych programistów w tej dziedzinie. W istocie to praktyka systematycznego zarządzania, organizowania i optymalizowania informacji kontekstowych, z których korzystają systemy AI do podejmowania decyzji i generowania wyników. W przeciwieństwie do tradycyjnego Retrieval-Augmented Generation (RAG), które skupia się głównie na wyszukiwaniu odpowiednich dokumentów do promptu przed przekazaniem go do modelu językowego, inżynieria kontekstu obejmuje znacznie szerszy obraz całego pipeline’u. Zawiera ona sposób, w jaki dane przepływają przez system, jak są przechowywane i indeksowane, jak odbywa się wyszukiwanie, jak wyniki są rangowane i filtrowane, oraz ostatecznie jak ten kontekst jest prezentowany modelowi. To holistyczne spojrzenie uznaje, że jakość wyjścia systemu AI jest zasadniczo ograniczona jakością i trafnością otrzymywanego kontekstu. Jeśli kontekst jest źle zarządzany — gdy zwracane są nieistotne informacje, gdy ważne szczegóły są pomijane, gdy te same dane są przetwarzane wielokrotnie — cały system się degraduje. Inżynieria kontekstu rozwiązuje te wyzwania, traktując zarządzanie kontekstem jako pełnoprawny problem inżynierski, wymagający równie dużej uwagi jak inne krytyczne komponenty infrastruktury.

Znaczenie inżynierii kontekstu staje się oczywiste, gdy spojrzymy na skalę działania współczesnych systemów AI. Model językowy może otrzymać zadanie przetworzenia setek tysięcy dokumentów, syntezy informacji z wielu źródeł i wygenerowania spójnej odpowiedzi na podstawie tej syntezy. Bez odpowiedniej inżynierii kontekstu ten proces staje się chaotyczny. Nieistotne dokumenty zaśmiecają okno kontekstu, istotne informacje giną w szumie, a wydajność modelu spada. Co więcej, wraz z rosnącą złożonością i krytycznością wdrożeń AI — od obsługi klienta po diagnozę medyczną i analizę finansową — stawka błędów w kontekście rośnie dramatycznie. System, który czasem zwraca nieistotne informacje, może być akceptowalny w rozrywce, ale jest niedopuszczalny, gdy decyduje o zdrowiu czy finansach ludzi. Inżynieria kontekstu gwarantuje, że informacje przepływające przez system są nie tylko liczne, ale naprawdę istotne, odpowiednio zorganizowane i zoptymalizowane pod konkretne zadanie.

Gotowy na rozwój swojej firmy?

Rozpocznij bezpłatny okres próbny już dziś i zobacz rezultaty w ciągu kilku dni.

Ewolucja od demo do produkcji: problem alchemii

Jednym z najbardziej uporczywych wyzwań w rozwoju AI jest tzw. “przepaść między demo a produkcją”. Zbudowanie działającego prototypu AI, który demonstruje możliwości, jest relatywnie proste. Programista może szybko połączyć model językowy z prostym systemem wyszukiwania i stworzyć coś imponującego w kontrolowanym środowisku. Jednak w momencie, gdy taki system musi obsługiwać rzeczywiste dane na dużą skalę, zachować niezawodność w czasie i dostosowywać się do zmieniających się wymagań, wszystko staje się dużo trudniejsze. Historycznie tę przepaść pokonywano za pomocą “alchemii” — tajemniczej mieszanki poprawek konfiguracji, zmian parametrów i empirycznych prób, które jakoś prowadziły do działającego systemu. Problem w takim podejściu polega na tym, że nie jest ono powtarzalne, skalowalne ani łatwe w utrzymaniu. Kiedy coś psuje się na produkcji, często nie wiadomo dlaczego i trzeba znów przechodzić przez tę samą magiczną procedurę.

Główną przyczyną problemu alchemii jest to, że większość infrastruktury AI nie była projektowana z myślą o systemach produkcyjnych. Wczesne bazy wektorowe i systemy wyszukiwania powstawały głównie by zademonstrować możliwości wyszukiwania semantycznego i retrievalu na embeddingach. Sprawdzały się w kontrolowanych środowiskach z małymi zbiorami danych i przewidywalnymi zapytaniami. Jednak przy skalowaniu do milionów dokumentów, tysięcy użytkowników i nieprzewidywalnych zapytań takie systemy często zawodzą. Pojawia się problem spójności danych, wydajność zapytań spada, system staje się trudny do debugowania i monitorowania. Programiści zamiast inżynierii, zajmują się zarządzaniem skomplikowanym, kruchym tworem, działającym przez szczęście i ciągłe interwencje. Tutaj z pomocą przychodzą nowoczesna inżynieria kontekstu i dedykowana infrastruktura. Traktując przejście od demo do produkcji jako prawdziwe wyzwanie inżynierskie i budując systemy z myślą o obciążeniach produkcyjnych, możemy zamienić alchemię w rzeczywistą inżynierię.

Zrozumienie nowoczesnej infrastruktury wyszukiwania dla AI

Tradycyjna infrastruktura wyszukiwania — ta, która napędza Google czy inne wyszukiwarki — powstawała z konkretnymi założeniami, jak będzie wykorzystywana. Systemy te były optymalizowane pod kątem zapytań opartych na słowach kluczowych od ludzi, którzy przeglądali wyniki i decydowali, w co kliknąć. Infrastruktura była projektowana do tego celu: szybkie dopasowanie słów, algorytmy rankingowe pod kątem ludzkich ocen trafności i prezentacja wyników jako “dziesięć niebieskich linków” — łatwych do przeskanowania przez człowieka. Jednak systemy AI mają zupełnie inne potrzeby. Model językowy konsumujący wyniki wyszukiwania nie patrzy na dziesięć linków — może przetwarzać znacznie większe ilości informacji. Nie potrzebuje wyników sformatowanych dla człowieka, lecz ustrukturyzowanych danych do dalszego rozumowania. Zapytania nie są oparte na słowach kluczowych, lecz semantyczne, bazujące na embeddingach i podobieństwie wektorowym. Te fundamentalne różnice sprawiają, że tradycyjna infrastruktura wyszukiwania średnio nadaje się do zastosowań AI.

Nowoczesna infrastruktura wyszukiwania dla AI uwzględnia te różnice na kilku poziomach. Po pierwsze, używa się zupełnie innych narzędzi i technologii — zamiast indeksów słów kluczowych i algorytmów rankingowych zoptymalizowanych pod ludzi, stosuje się embeddingi wektorowe i miary podobieństwa semantycznego. Zamiast opierać się na słowach kluczowych, rozumieją one znaczenie i intencję zapytania. Po drugie, wzorce obciążeń są inne — tradycyjne systemy obsługują proste zapytania zwracające kilka wyników, podczas gdy AI musi często pobrać setki lub tysiące dokumentów i złożyć je w spójną całość. Po trzecie, programiści korzystający z tych systemów mają inne potrzeby: potrzebują łatwej integracji, dobrego doświadczenia developerskiego i nie muszą być ekspertami od wyszukiwania. I wreszcie — najważniejsze — konsumentem wyników nie jest już człowiek, ale model językowy, który może przetworzyć znacznie więcej wyników niż człowiek. Ta zmiana fundamentalnie wpływa na projektowanie całej infrastruktury.

Dołącz do naszego newslettera

Otrzymuj najnowsze wskazówki, trendy i oferty za darmo.

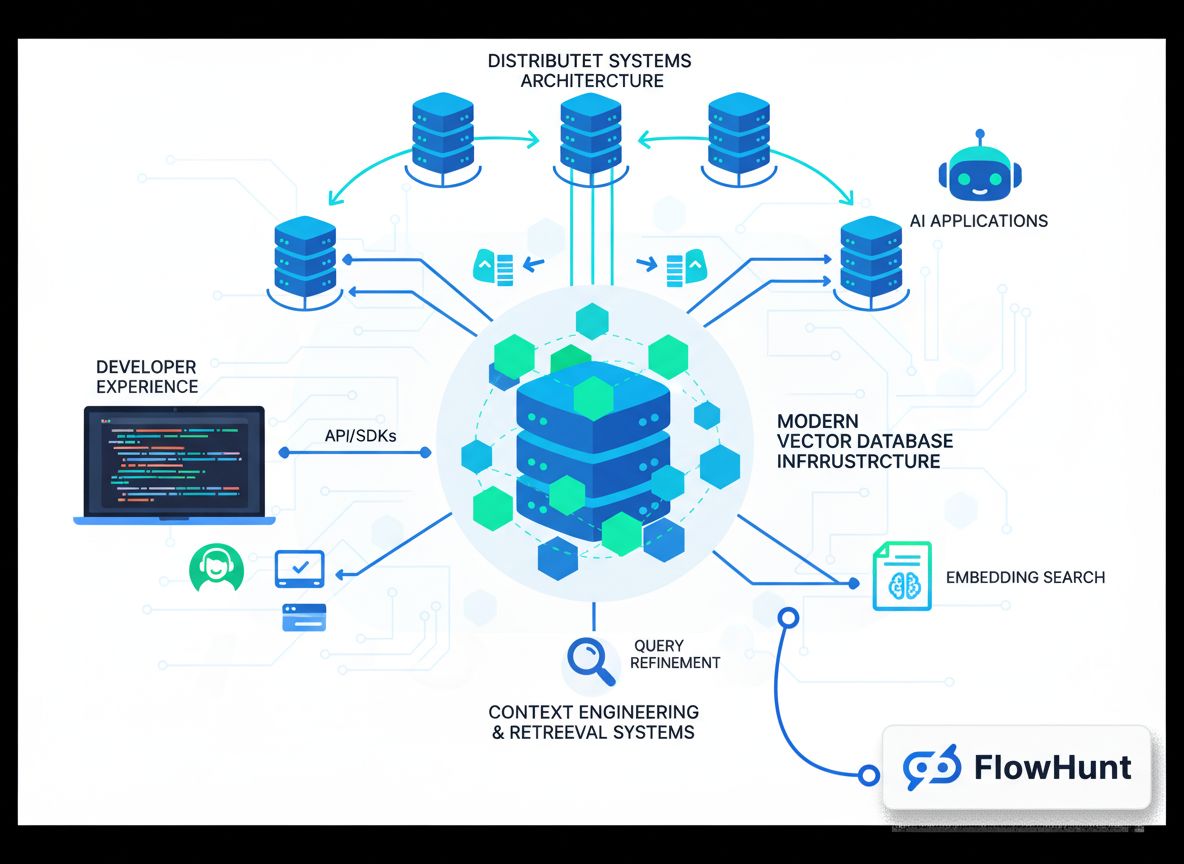

FlowHunt i przyszłość automatyzacji workflow AI

W miarę jak organizacje coraz lepiej rozumieją znaczenie inżynierii kontekstu i nowoczesnej infrastruktury wyszukiwania, pojawia się wyzwanie: jak zintegrować te możliwości z istniejącymi procesami i workflow rozwoju. Tutaj pojawiają się platformy takie jak FlowHunt, oferujące zintegrowane środowisko do budowania, testowania i wdrażania aplikacji AI korzystających z zaawansowanego zarządzania kontekstem i systemów retrievalu. FlowHunt rozumie, że inżynieria kontekstu to nie tylko odpowiednia baza danych — to także odpowiednie narzędzia i workflowy do zarządzania kontekstem na każdym etapie cyklu życia rozwoju AI. Od pobierania i indeksowania danych, przez retrieval i ranking, po końcowe wnioskowanie i generowanie wyjścia — każdy etap pipeline’u musi być starannie orkiestrony i monitorowany. FlowHunt dostarcza automatyzację, która czyni tę orkiestrację płynną, pozwalając programistom skupić się na tworzeniu świetnych aplikacji AI zamiast zmagać się z infrastrukturą.

Podejście platformy do automatyzacji inżynierii kontekstu jest szczególnie cenne dla zespołów budujących wiele aplikacji AI lub potrzebujących zarządzać złożonymi pipeline’ami retrievalu. Zamiast budować infrastrukturę od zera do każdej aplikacji, zespoły mogą korzystać z gotowych komponentów i workflowów FlowHunt, przyspieszając rozwój. Platforma zajmuje się żmudną pracą związaną z pobieraniem danych, generowaniem embeddingów, zarządzaniem indeksami i orchestracją retrievalu, uwalniając programistów do skupienia się na unikalnych aspektach ich aplikacji. Co więcej, FlowHunt daje wgląd i monitoring, ułatwiający zrozumienie przepływu kontekstu przez system, identyfikację wąskich gardeł i optymalizację wydajności. To połączenie automatyzacji i przejrzystości zmienia inżynierię kontekstu z tajemniczego procesu prób i błędów w systematyczną, mierzalną dyscyplinę.

Architektura baz wektorowych gotowych na produkcję

Zbudować bazę wektorową działającą w demo to jedno; zbudować taką, która niezawodnie obsłuży produkcyjne obciążenia — to zupełnie inna sprawa. Produkcyjne bazy wektorowe muszą obsłużyć wielu jednoczesnych użytkowników, zapewnić spójność danych, niezawodną trwałość i skalować się wraz z rosnącą ilością danych. Muszą być łatwe do debugowania, monitorowania i utrzymania, by zespół mógł je rozwijać w czasie. Te wymagania doprowadziły do powstania nowoczesnych architektur baz wektorowych, czerpiących z zasad systemów rozproszonych sprawdzonych przez dekady praktyki.

Jedną z najważniejszych zasad architektonicznych jest rozdzielenie pamięci masowej i obliczeń. W tradycyjnych, monolitycznych bazach, storage i compute są ściśle powiązane — ten sam serwer przechowuje dane i obsługuje zapytania. Przy dużej skali powoduje to problemy: jeśli potrzebujesz większej mocy obliczeniowej, musisz dokupić też storage, i odwrotnie — co prowadzi do marnowania zasobów i wyższych kosztów. Rozdzielając storage i compute, nowoczesne bazy pozwalają skalować je niezależnie. Storage może być realizowany przez tanie rozwiązania typu object storage (jak Amazon S3), a compute skalowany według zapotrzebowania na zapytania. To daje ogromną elastyczność i oszczędność. Kolejną kluczową zasadą jest wielodzierżawność — jedna instancja bazy może bezpiecznie obsłużyć wiele niezależnych aplikacji lub zespołów. Wymaga to odpowiedniej izolacji, ale kiedy jest dobrze zaimplementowane, znacząco zwiększa efektywność zasobów i obniża złożoność operacyjną.

Nowoczesne bazy wektorowe czerpią też z praktyk systemów rozproszonych, które stały się standardem ostatniej dekady: rozdział odczytów i zapisów (czyli optymalizacja osobno pod każdy typ operacji), asynchroniczna replikacja (gwarantująca trwałość danych bez utraty wydajności zapisu), mechanizmy konsensusu rozproszonego zapewniające spójność między węzłami. Połączenie tych zasad z nowoczesnymi językami programowania (np. Rust — wydajność i bezpieczeństwo) pozwala bazom wektorowym osiągać cechy niezawodności i wydajności wymagane na produkcji. Efekt? Infrastruktura, która nie przypomina już alchemii, a prawdziwą inżynierię.

Podejście Chroma do doświadczenia programisty

Gdy powstawała Chroma, zespół miał jasną tezę: przepaść między demo a produkcją przypominała bardziej alchemię niż inżynierię i trzeba ją zniwelować. Postawiono na obsesyjne skupienie się na doświadczeniu programisty. Zamiast budować system najbogatszy w funkcje czy najwydajniejszy, skupiono się na tym, by programiści mogli zacząć korzystać z bazy wektorowej i wyszukiwania semantycznego w kilka minut, bez skomplikowanej konfiguracji czy infrastruktury. To doprowadziło do jednej z najbardziej charakterystycznych cech Chroma: możliwość instalacji jednym poleceniem pip i natychmiastowej pracy. Taka prostota była rewolucyjna. Większość baz wymaga złożonej konfiguracji, zanim uruchomisz najprostsze zapytanie. Chroma wyeliminowała te przeszkody, pozwalając eksperymentować z bazami wektorowymi i wyszukiwaniem semantycznym w ciągu minut, nie godzin czy dni.

Zaangażowanie w doświadczenie programisty wychodziło poza pierwsze kroki. Zespół inwestował w niezawodność systemu na różnych architekturach i środowiskach wdrożeniowych. Już we wczesnych dniach użytkownicy raportowali uruchamianie Chroma na wszystkim — od serwerów Linux po Arduina czy Power PC. Zamiast ignorować takie przypadki, Chroma zadbała, by i tam działało niezawodnie. To podejście do uniwersalnej kompatybilności i niezawodności zbudowało zaufanie społeczności i przyczyniło się do szybkiej adopcji. Zespół zrozumiał, że doświadczenie programisty to nie tylko łatwość użycia, ale też niezawodność, przewidywalność i pewność, że system zadziała w każdym środowisku i przypadku użycia.

Wraz z rozwojem Chroma i budową Chroma Cloud zespół stanął przed ważnym wyborem: mógłby szybko wypuścić hostowaną wersję produktu dla jednego węzła, szybko wejść na rynek i korzystać z zapotrzebowania na zarządzane bazy wektorowe. Tak zrobiło wiele firm, zdobywając duże inwestycje i rozgłos. Chroma wybrała jednak inaczej: rozumieli, że proste hostowanie produktu single-node nie spełni oczekiwań wobec doświadczenia programisty. Prawdziwie dobry produkt chmurowy musi być zaprojektowany od podstaw z myślą o chmurze, oferować tę samą łatwość i niezawodność co lokalny produkt, ale przy zachowaniu skalowalności i niezawodności produkcyjnej. Ta decyzja wymagała więcej czasu, ale zaowocowała produktem, który rzeczywiście sprawia, że inżynieria kontekstu staje się inżynierią, nie alchemią.

Cztery wymiary “AI” w nowoczesnej infrastrukturze wyszukiwania

Omawiając nowoczesną infrastrukturę wyszukiwania dla AI, warto zauważyć, że “AI” znaczy co innego w różnych kontekstach. W rzeczywistości są cztery odrębne wymiary, według których nowoczesne systemy różnią się od tradycyjnych, i ich zrozumienie jest kluczowe dla budowania skutecznych aplikacji. Pierwszy wymiar to technologiczny. Narzędzia i technologie używane w nowoczesnym wyszukiwaniu są zupełnie inne niż w tradycyjnych systemach — zamiast indeksów odwróconych i dopasowania słów kluczowych, stosuje się embeddingi wektorowe i podobieństwo semantyczne; zamiast TF-IDF, sieci neuronowe i uczone funkcje rankingowe. To wynika z zupełnie innej natury rozwiązywanych problemów i nowych możliwości AI.

Drugi wymiar to wzorce obciążeń. Tradycyjne systemy wyszukiwania były projektowane do prostych zapytań bezstanowych i małej liczby wyników. Nowoczesne systemy AI często muszą obsłużyć złożone pipeline’y wyszukiwania wieloetapowego: wielokrotne rankingowanie, filtrowanie, re-ranking, często na tysiącach dokumentów. Obciążenia te są fundamentalnie inne i wymagają innej architektury. Trzeci wymiar to programista. Tradycyjne systemy były rozwijane i utrzymywane przez wyspecjalizowanych inżynierów wyszukiwania, ekspertów w dziedzinie IR. Dziś programiści AI to często generalistyczni developerzy, którzy nie muszą być ekspertami od wyszukiwania, ale potrzebują zaawansowanych funkcji retrievalu. Dlatego nowoczesna infrastruktura musi być łatwa w użyciu i dostępna, nie tylko wydajna.

Czwarty i najważniejszy wymiar to konsument wyników wyszukiwania. W tradycyjnych systemach jest nim człowiek, który może przejrzeć tylko kilka wyników i sam ocenia trafność. W nowoczesnych systemach AI konsumentem jest model językowy, który może przetworzyć setki czy tysiące dokumentów i zsyntetyzować z nich wiedzę. Ta fundamentalna różnica zmienia wszystko w projektowaniu infrastruktury — algorytmy rankingowe można optymalizować pod maszyny, nie pod ludzi; prezentację wyników — pod przetwarzanie, nie pod czytelność; cały pipeline — z myślą, że to AI wykona ostatni krok, nie człowiek.

Budowanie i utrzymanie wizji na zatłoczonym rynku

Rynek baz wektorowych w 2023 był jednym z najgorętszych segmentów infrastruktury AI. Firmy pozyskiwały ogromne środki, robiły efektowne debiuty i ścigały się w liczbie funkcji. W takim środowisku Chroma mogłaby łatwo zatracić fokus, gonić każdy trend i próbować być wszystkim dla wszystkich. Zamiast tego zespół wybrał skoncentrowanie się na swojej wizji: budowie silnika retrievalu dla AI z wyjątkowym doświadczeniem programisty i prawdziwym mostem między demo a produkcją. To wymagało dyscypliny i przekonania, zwłaszcza gdy inni gracze zdobywali większe inwestycje i robili większy rozgłos.

Kluczowe było posiadanie jasnej, kontrariańskiej tezy o tym, co naprawdę się liczy. Zespół Chroma wierzył, że najważniejsza jest nie liczba funkcji czy kapitał, ale jakość doświadczenia programisty i niezawodność systemu. Wierzyli, że robiąc jedną rzecz — silnik retrievalu — na światowym poziomie, zyskają prawo do rozwijania kolejnych. Ta filozofia skupienia nie jest unikalna dla Chroma, ale coraz rzadsza w świecie startupów, gdzie presja na szybki wzrost często prowadzi do rozproszenia. Chroma trzymała się swojej wizji, nawet jeśli oznaczało to wolniejsze wydania i potencjalnie rezygnację z krótkoterminowych okazji — co okazało się słuszne.

Utrzymanie wizji wymaga też mądrego podejścia do rekrutacji i budowania zespołu. To, kogo zatrudniasz, kształtuje kulturę firmy, a ta decyduje o tym, co i jak budujesz. Chroma celowo rekrutowała powoli i bardzo selektywnie, stawiając na ludzi podzielających wizję, dbających o jakość i potrafiących samodzielnie realizować zadania na wysokim poziomie. Takie podejście spowolniło wzrost zespołu, ale zapewniło, że każdy jest autentycznie zaangażowany w misję i wnosi realny wkład. To trudne do osiągnięcia w dynamicznych startupach, ale niezbędne dla utrzymania wizji.

Znaczenie rzemiosła i jakości w infrastrukturze

Jednym z najbardziej wyrazistych aspektów podejścia Chroma jest nacisk na rzemiosło i jakość. W infrastrukturze łatwo wpaść w pułapkę: więcej funkcji, wydajności czy skali — zawsze lepiej. Chroma dostrzegła, że najważniejsze jest budowanie systemów niezawodnych, łatwych w użyciu i rzeczywiście rozwiązujących problemy programistów. Ten nacisk widać w wielu decyzjach: napisanie Chroma w Rust — dla wydajności i bezpieczeństwa, zamiast wygodniejszego, ale mniej niezawodnego języka; dbałość o działanie na różnych architekturach i środowiskach, nawet tych nietypowych; rezygnacja z pośpiechu na rzecz dopracowania Chroma Cloud.

Ten nacisk na rzemiosło i jakość obejmuje też szersze spojrzenie na problem. Chroma nie traktuje inżynierii kontekstu jako wąskiego problemu technicznego do rozwiązania sprytnym algorytmem, lecz jako wyzwanie obejmujące doświadczenie programisty, niezawodność, skalowalność i łatwość utrzymania. Takie całościowe podejście prowadzi do lepszych rozwiązań, bo system jest tylko tak dobry, jak jego najsłabsze ogniwo. Możesz mieć najnowocześniejsze algorytmy retrievalu, ale jeśli system jest trudny w użyciu lub zawodny na produkcji, nie rozwiązuje realnego problemu. Skupiając się na jakości we wszystkich aspektach, Chroma zbudowała coś, co rzeczywiście sprawdza się w praktyce i naprawdę łączy demo z produkcją.

Praktyczne wskazówki dla zespołów rozwijających AI

Dla zespołów tworzących aplikacje AI wnioski z podejścia Chroma mają kilka praktycznych konsekwencji. Po pierwsze, trzeba uznać, że inżynieria kontekstu nie jest pobocznym zadaniem w rozwoju AI — to część głównej misji. Jakość systemu AI jest ograniczona jakością otrzymywanego kontekstu, więc inwestycja w odpowiednią infrastrukturę inżynierii kontekstu nie jest opcją — jest koniecznością. Po drugie, warto sceptycznie podchodzić do systemów obiecujących wszystko naraz. Najbardziej niezawodne i skuteczne są często te, które robią jedną rzecz naprawdę dobrze, a potem na tym budują. Wybierając bazę wektorową czy system retrievalu, postaw na taki, który ma jasny cel i robi tę jedną rzecz na światowym poziomie. Po trzecie, doświadczenie programisty ma znaczenie. System teoretycznie potężniejszy, ale trudny w użyciu, będzie mniej wartościowy niż trochę słabszy, ale prosty — bo programiści faktycznie użyją tego drugiego i zbudują na nim świetne rzeczy.

Po czwarte, niezawodność i przewidywalność liczą się bardziej, niż może się wydawać. W początkowych fazach rozwoju AI łatwo przedkładać funkcje i wydajność nad niezawodność. Jednak na produkcji, przy dużych wolumenach zapytań, niezawodność jest kluczowa. System niezawodny w 95% może wydawać się dobry, ale przy milionach zapytań dziennie oznacza to setki tysięcy błędów. Inwestycja w niezawodność od początku jest tańsza niż późniejsze naprawy. Wreszcie, trzeba myśleć długofalowo — infrastruktura wybrana dziś przesądza o możliwościach jutro. Warto stawiać na rozwiązania projektowane od początku do produkcji, łatwo skalowalne, z dobrym monitoringiem — to się zwraca wraz z rozwojem systemów.

{{ cta-dark-panel

heading=“Przyspiesz swój workflow z FlowHunt”

description=“Przekonaj się, jak FlowHunt automatyzuje Twoje procesy AI i SEO — od researchu i generowania treści po publikację i analitykę — wszystko w jednym miejscu.”

ctaPrimaryText=“Umów Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Wypróbuj FlowHunt za darmo”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Rola open source w budowaniu zaufania i społeczności

Jedną z najważniejszych decyzji Chroma było otwarcie kodu produktu. To miało kilka konsekwencji. Po pierwsze, zbudowało zaufanie wśród programistów — gdy mogą zobaczyć kod, zrozumieć jak działa i wnieść ulepszenia, chętniej go używają i polecają. Open source tworzy też pozytywną pętlę: kontrybucje społeczności ulepszają produkt, co przyciąga kolejnych użytkowników i kolejnych kontrybutorów. Po drugie, otwarcie kodu zbudowało silną społeczność wokół Chroma. Programiści korzystający z produktu angażują się w jego rozwój, zgłaszają uwagi, promują go dalej. Taka społeczność to ogromny atut, trudny do skopiowania przez konkurencję.

Po trzecie, open source daje naturalną ścieżkę monetyzacji przez usługi hostowane. Udostępniając produkt open source, Chroma sprawiła, że każdy może go używać za darmo samodzielnie, ale wielu woli skorzystać z zarządzanej wersji w chmurze, gdzie cała obsługa, skalowanie i utrzymanie jest po stronie usługodawcy. Tak działa Chroma Cloud. Oferując lepsze doświadczenie hostowane, a jednocześnie pozostając open source, Chroma trafia zarówno do zwolenników self-hostingu, jak i rynku usług zarządzanych. To podejście okazało się bardziej zrównoważone i bliższe oczekiwaniom programistów niż próba zamknięcia produktu.

Mierzenie sukcesu: naprawdę istotne metryki

Ocena sukcesu projektów infrastrukturalnych, takich jak Chroma, powinna skupiać się na wskaźnikach odzwierciedlających realną wartość. Chroma osiągnęła imponujące liczby: ponad 21 000 gwiazdek na GitHubie, ponad 5 milionów pobrań miesięcznie i ponad 60–70 milionów pobrań łącznie. To pokazuje szeroką adopcję w społeczności programistycznej. Jednak poza liczbami najważniejsze jest, czy projekt rozwiązuje realne problemy programistów: czy ułatwia budowę aplikacji AI, skraca czas od demo do produkcji, umożliwia tworzenie niezawodnych systemów? Odpowiedź — sądząc po opiniach społeczności i tempie adopcji — brzmi: tak.

Ważny jest też rodzaj społeczności i kontrybucji. Chroma przyciągnęła wkład programistów z całej branży, w tym integracje z popularnymi frameworkami, jak LangChain czy Llama Index. Ta szeroka integracja i adopcja świadczy, że Chroma rozwiązuje realne problemy i wnosi autentyczną wartość. Fakt, że Chroma stała się domyślnym wyborem bazy wektorowej w wielu narzędziach AI, to dowód jakości