Czym jest serwer MCP? Kompletny przewodnik po Model Context Protocol

Dowiedz się, czym są serwery MCP (Model Context Protocol), jak działają i dlaczego rewolucjonizują integrację AI. Odkryj, jak MCP upraszcza łączenie agentów AI ...

Kompleksowy przewodnik po budowie, wdrażaniu i rozbudowie serwera MCP, który łączy modele AI z zewnętrznymi narzędziami, źródłami danych i przepływami pracy za pomocą Model Context Protocol.

Model Context Protocol (MCP) to otwarty standard, który umożliwia modelom sztucznej inteligencji (AI) łatwe łączenie się z zewnętrznymi narzędziami, źródłami danych i systemami programowymi. MCP działa jako uniwersalny interfejs, pozwalając asystentom AI i różnym aplikacjom na wymianę danych oraz uruchamianie funkcji bez przeszkód. Możesz myśleć o nim jak o „USB-C dla aplikacji AI”, ponieważ ułatwia współpracę różnych systemów bez problemów ze zgodnością. Budując własny serwer MCP, poznajesz, jak działa architektura backendowa, a także zdobywasz praktyczne umiejętności w zakresie łączenia AI z rzeczywistymi narzędziami i codziennymi przepływami pracy.

Ten przewodnik po serwerze MCP przeprowadzi Cię krok po kroku przez wszystkie niezbędne zagadnienia. Zaczniesz od podstawowych pojęć, a następnie przejdziesz do praktycznej konfiguracji, testowania i wdrażania. Jeśli chcesz zautomatyzować zadania biznesowe, połączyć agentów AI z aplikacjami produktywności lub wypróbować nowe metody integracji AI, znajdziesz tu przydatne instrukcje i najlepsze praktyki. Przewodnik dostarczy Ci narzędzi i wiedzy, by zacząć działać z pewnością siebie.

Model Context Protocol, czyli MCP, to otwarty standard, który pozwala modelom sztucznej inteligencji (AI) łatwo wymieniać informacje z różnym oprogramowaniem i narzędziami. MCP działa jak wspólny most, umożliwiając systemom AI, takim jak duże modele językowe (LLM), komunikację z wieloma typami oprogramowania, bazami danych i zasobami na żywo poprzez spójny i przejrzysty zestaw zasad.

MCP pomaga asystentom AI bezpiecznie i efektywnie korzystać z zewnętrznych danych. Bez MCP deweloperzy musieliby tworzyć unikalne połączenia dla każdej nowej aplikacji, co jest czasochłonne i skomplikowane. MCP rozwiązuje ten problem, oferując standardowe formaty wiadomości i jasne sposoby komunikacji pomiędzy systemami AI a zewnętrznymi narzędziami. Niezależnie od technologii używanej przez każde narzędzie, mogą one się nawzajem rozumieć dzięki MCP.

Deweloperzy często używają z MCP ustrukturyzowanych formatów danych, takich jak JSON. Pozwala to na łatwe wykorzystanie MCP w różnych językach programowania i na wielu platformach. Dzięki MCP modele AI mogą żądać informacji, wykonywać zadania lub inicjować akcje w innych systemach. Na przykład asystent AI może skorzystać z MCP, by sprawdzić wydarzenia w kalendarzu, przejrzeć bazę danych lub wysłać powiadomienie — wszystko to bez budowania osobnych połączeń dla każdego zadania.

MCP wspiera wiele praktycznych przypadków użycia:

Dzięki MCP możesz łatwiej podłączać nowe narzędzia lub dodawać funkcje. Rozwój staje się szybszy, bezpieczeństwo lepsze dzięki jasnym zasadom dostępu, a Ty możesz budować rozwiązania AI, które łatwo się skalują.

MCP daje deweloperom prostą i elastyczną metodę łączenia funkcji AI z innymi narzędziami i danymi. Pomaga to szybko tworzyć nowe rozwiązania, zapewniać płynność działania systemów i dostosowywać się do zmieniających się potrzeb. Gdy organizacje wdrażają MCP, ich asystenci AI mogą korzystać z aktualnych, szczegółowych informacji, aby udzielać lepszych odpowiedzi i wykonywać dokładniejsze zadania.

Poznanie Model Context Protocol daje Ci podstawy do budowy niezawodnych i elastycznych systemów AI, które współpracują z wieloma różnymi narzędziami i źródłami danych.

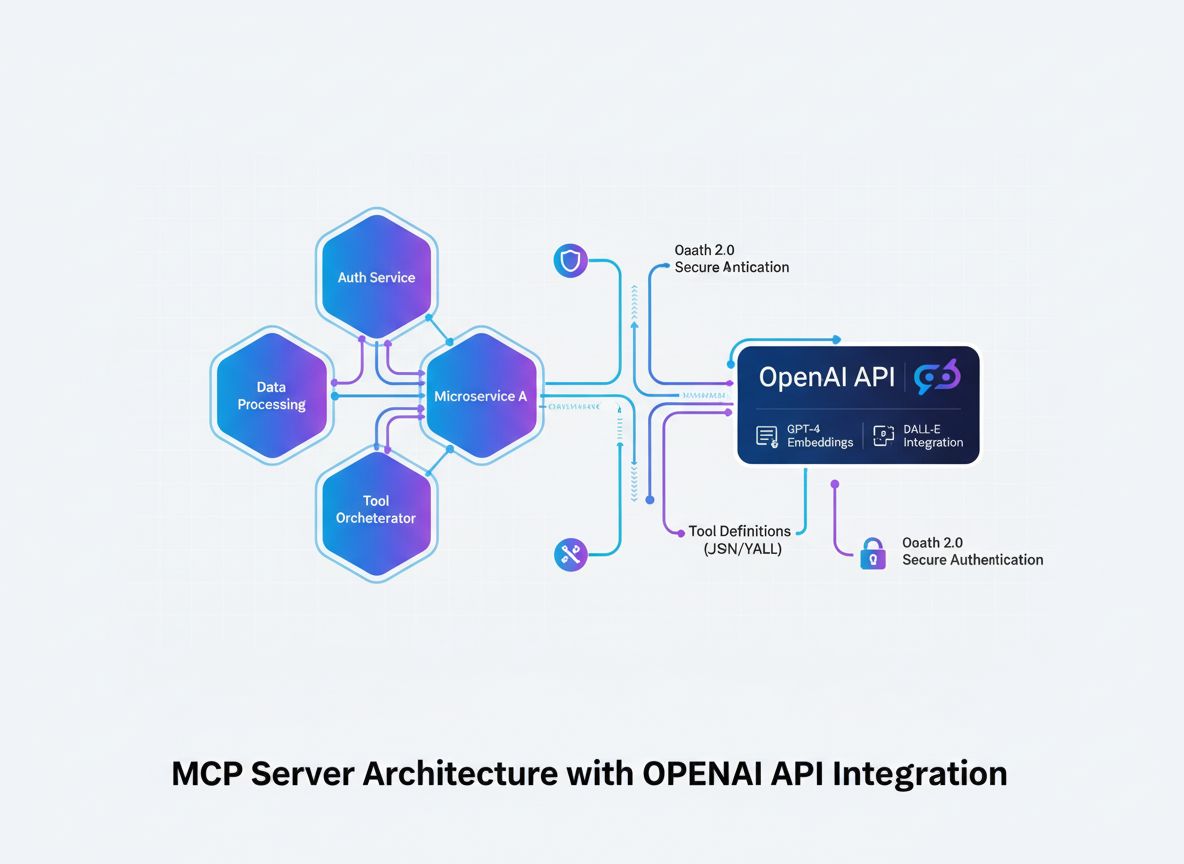

Serwer MCP zarządza komunikacją opartą na protokole pomiędzy asystentami AI a zewnętrznymi narzędziami lub źródłami danych. Architektura opiera się na konstrukcji modułowej, gdzie każda część odpowiada za konkretne zadanie w systemie.

Aplikacja serwerowa pełni rolę głównego centrum. Odbiera, interpretuje i odpowiada na wiadomości protokołu MCP. Obejmuje to obsługę bezpiecznych połączeń sieciowych, sprawdzanie tożsamości klientów i zarządzanie przepływem danych pomiędzy różnymi częściami serwera. Aplikacja serwerowa zapewnia stabilność systemu i często obsługuje wiele połączeń oraz zadań jednocześnie.

Moduły narzędzi i zasobów to oddzielne jednostki kodu rejestrowane przez serwer. Każde narzędzie wykonuje określone zadanie, np. pobieranie danych, wykonywanie obliczeń czy automatyzację procesów. Serwer MCP prowadzi rejestr tych narzędzi, co pozwala wywołać odpowiednie narzędzie po otrzymaniu żądania. Dzięki temu możesz łatwo dodawać nowe narzędzia bez konieczności zmiany głównej logiki serwera.

Obsługa komunikacji zajmuje się odczytywaniem wiadomości zgodnych z protokołem MCP. Sprawdza, czy każde żądanie ma poprawny format i kieruje je do odpowiedniego modułu narzędzi lub zasobów. Obsługa komunikacji również przygotowuje odpowiedź w odpowiednim formacie i przesyła ją z powrotem do klienta. Ta część serwera ukrywa szczegóły protokołu, dzięki czemu różni klienci mogą się łączyć bez problemów.

Punkty integracyjne to specjalne interfejsy łączące serwer MCP z zewnętrznymi klientami, takimi jak asystenci AI czy inne aplikacje. Interfejsy te mogą wykorzystywać endpointy HTTP, WebSockety lub inne obsługiwane metody transportu. Punkty integracyjne umożliwiają klientom korzystanie z narzędzi serwera, zapewniając komunikację i wymianę danych w czasie rzeczywistym.

Architektura serwera MCP kładzie nacisk na modułowość. Oddzielając aplikację serwerową, narzędzia, obsługę komunikacji i punkty integracyjne, możesz łatwo aktualizować lub dodawać nowe funkcje. Taka konstrukcja ułatwia utrzymanie i rozbudowę systemu, wspierając nawet duże i złożone wdrożenia.

Ten przegląd pokazuje, jak poszczególne elementy serwera MCP współpracują i jak ich połączenia wspierają przejrzystą oraz niezawodną komunikację opartą na protokole.

Zacznij od wyboru języka programowania, który ma silne wsparcie społeczności i jest wygodny do budowy serwera MCP. Zarówno Python, jak i Node.js sprawdzają się świetnie. Python jest znany z przejrzystej składni i wielu przydatnych bibliotek. Node.js efektywnie obsługuje zadania asynchroniczne. Wybierz edytor kodu, który odpowiada Twojemu stylowi pracy, np. Visual Studio Code, PyCharm lub WebStorm, aby ułatwić pisanie i zarządzanie kodem.

Do zarządzania zależnościami i paczkami używaj pip i venv dla Pythona lub npm/yarn dla Node.js. Skonfiguruj system kontroli wersji Git, aby śledzić zmiany i lepiej współpracować z innymi. Te narzędzia pomagają utrzymać porządek w rozwoju i ułatwiają odtworzenie środowiska na innych komputerach.

Dobrze zorganizowana struktura folderów ułatwia utrzymanie i rozbudowę projektu. Rozmieść pliki projektu serwera w następujący sposób:

/mcp-server-project

/tools

/handlers

server.py (lub server.js)

requirements.txt (lub package.json)

README.md

Każde narzędzie lub zasób umieść w osobnym module w folderze /tools. Całą logikę związaną z protokołem umieść w folderze /handlers. Taka organizacja utrzymuje kod w czystości i rozdziela różne części projektu zgodnie z najlepszymi praktykami.

python -m venv venv && source venv/bin/activate.npm init -y.pip install flask. Dla Node.js użyj npm install express..gitignore, aby nie dodawać środowisk wirtualnych i plików systemowych do repozytorium.README.md, aby inni mogli łatwo odtworzyć środowisko.Pracuj w wirtualnych środowiskach, aby oddzielić zależności. Używaj jasnych i spójnych nazw plików oraz folderów, a kod dokumentuj na bieżąco. Regularnie wykonuj commity do repozytorium Git i twórz kopie zapasowe. Dzięki temu Twoje środowisko MCP będzie stabilne, skalowalne i gotowe do profesjonalnego rozwoju.

Możesz zbudować prosty serwer MCP, stosując przejrzysty i modułowy kod. Używając Pythona i Flask, konfigurujesz endpoint przyjmujący żądania w formacie MCP i zwracający uporządkowane odpowiedzi. W tej sekcji znajdziesz przykład minimalnego, działającego serwera MCP. Kod opiera się na dobrych praktykach, więc łatwo go rozwiniesz, gdy zajdzie taka potrzeba.

Najpierw zaimportuj Flask i utwórz instancję aplikacji. Skonfiguruj endpoint /mcp akceptujący żądania POST. MCP używa POST, ponieważ jest to standardowa metoda przesyłania wiadomości protokołu.

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/mcp', methods=['POST'])

def handle_mcp():

data = request.json

# Miejsce na logikę obsługi wiadomości MCP

return jsonify({'result': 'Hello, MCP!'})

if __name__ == '__main__':

app.run(port=5000)

Uzasadnienie naukowe:

Żądania POST z JSON pozwalają przesyłać ustrukturyzowane dane, które działają w różnych językach programowania. Obsługa żądań w Flask sprawdza poprawność treści i odpowiednio obsługuje błędy.

Teraz zaktualizuj handler tak, by mógł kierować żądania protokołu w zależności od narzędzia wskazanego w danych wejściowych. Dzięki temu kod pozostaje przejrzysty i łatwy w utrzymaniu.

def handle_mcp():

data = request.json

tool = data.get('tool')

if tool == 'calculator':

result = calculator_tool(data)

else:

result = 'Tool not found'

return jsonify({'result': result})

Aby uruchomić serwer, wpisz:

python server.py

Możesz przetestować serwer, wysyłając żądanie przez curl:

curl -X POST -H "Content-Type: application/json" -d '{"tool":"calculator","num1":2,"num2":3}' http://localhost:5000/mcp

Jeśli serwer działa poprawnie, odpowie wiadomością w formacie JSON. Potwierdza to, że serwer przyjmuje i przetwarza żądania dotyczące różnych narzędzi.

Ten przykład stanowi solidny punkt wyjścia do budowy serwera MCP. Możesz dodawać kolejne narzędzia zgodne z protokołem i rozbudowywać jego funkcjonalność wraz z rozwojem projektu.

W serwerze MCP narzędzia to oddzielne funkcje lub endpointy, z których klienci lub modele AI mogą korzystać w celu wykonania określonych akcji lub uzyskania dostępu do danych. Każde narzędzie realizuje jedno zdefiniowane zadanie — na przykład wykonuje obliczenia, pobiera dane z bazy lub łączy się z zewnętrznym API. Narzędzia te przestrzegają zasad Model Context Protocol (MCP) dotyczących odbioru i przesyłania informacji.

Każde narzędzie rejestrujesz w serwerze MCP jako osobną funkcję. Każde z nich posiada schemat opisujący zadanie, wymagane dane wejściowe i zwracane wyniki. Specyfikacja Model Context Protocol wymaga, by każde narzędzie miało:

Dzięki temu klienci, w tym modele AI, mogą łatwo znaleźć i wykorzystać narzędzia w razie potrzeby. Ułatwia to współpracę różnych systemów i zmniejsza ryzyko błędów komunikacyjnych. Badania nad projektowaniem protokołów pokazują, że używanie jasnych schematów ogranicza liczbę błędów i ułatwia integrację systemów. Więcej informacji znajdziesz w dokumentacji Model Context Protocol.

Narzędzia przechowujesz w rejestrze, zwykle jako słownik lub mapowanie w kodzie serwera MCP. Po otrzymaniu żądania serwer sprawdza nazwę narzędzia i przekazuje żądanie do odpowiedniej funkcji. Aby dodać nowe narzędzie, należy:

Taka konstrukcja modułowa pozwala na dodawanie narzędzi bez modyfikacji głównego kodu serwera, dzięki czemu łatwo rozbudowujesz funkcjonalność.

tools = {

'calculator': calculator_tool,

'weather': weather_tool,

# Dodaj więcej narzędzi tutaj

}

def handle_mcp():

data = request.json

tool_name = data.get('tool')

if tool_name in tools:

result = tools[tool_name](data)

else:

result = 'Tool not found'

return jsonify({'result': result})

Narzędzia to funkcje, które można uruchomić. Zasoby to dane, usługi lub zewnętrzne API, do których te narzędzia mają dostęp. Narzędzia mogą łączyć się z bazami danych, magazynami plików czy usługami zewnętrznymi. Dzięki temu serwer MCP może łączyć klientów AI z wieloma zasobami cyfrowymi.

Aby przetestować swój serwer MCP, zacznij od sprawdzenia każdego endpointu za pomocą narzędzi takich jak MCP Inspector, Postman czy cURL. Pozwalają one wysyłać przykładowe wiadomości protokołu do serwera. Po wysłaniu wiadomości upewnij się, że serwer zwraca poprawną strukturę danych i kody błędów zgodnie ze specyfikacją Model Context Protocol.

Możesz stosować automatyczne testy do sprawdzania poszczególnych części kodu. Przykładowo, użyj pytest dla Pythona lub mocha dla Node.js. Frameworki te pomagają testować logikę każdego narzędzia oraz to, jak serwer obsługuje różne wiadomości. Testuj zarówno poprawne, jak i błędne żądania, by sprawdzić reakcję serwera na błędy. Testy integracyjne pozwalają odtworzyć zachowanie rzeczywistych klientów i sprawdzić, czy serwer poprawnie kieruje żądania i zarządza informacjami.

Podczas debugowania serwera MCP monitoruj logi w czasie rzeczywistym i przechodź przez kod krok po kroku, by znaleźć problemy. Włącz szczegółowe logowanie w kluczowych momentach, takich jak odbiór żądania, parsowanie wiadomości protokołu, uruchamianie narzędzia czy wysyłanie odpowiedzi. Dzięki temu prześledzisz przepływ danych przez serwer i łatwiej zlokalizujesz błędy. Używaj bibliotek logujących, takich jak logging dla Pythona lub winston dla Node.js, aby logi były czytelne i uporządkowane.

Aby dokładniej przeanalizować kod, użyj debuggera w swoim środowisku programistycznym, np. wbudowanego debuggera PyCharm lub VS Code. Pozwalają one ustawiać punkty przerwania i sprawdzać wartości zmiennych podczas działania. Jeśli serwer działa w chmurze, możesz potrzebować narzędzi do zdalnego debugowania lub usług zbierających logi, takich jak Dynatrace lub CloudWatch.

Podczas testowania serwera MCP możesz napotkać problemy, takie jak błędne adresy endpointów, nieprawidłowe formaty wiadomości czy brakujące zależności. Aby ich uniknąć, dokładnie sprawdź ustawienia serwera, np. konfigurację i numery portów. Używaj walidacji schematu, by upewnić się, że przychodzące wiadomości mają oczekiwany format. Jeśli narzędzie nie zwraca oczekiwanych wyników, przetestuj jego logikę osobno za pomocą testów jednostkowych i sprawdź najnowsze zmiany w kodzie.

Dobre testy i szczegółowe logi ułatwiają wykrywanie i naprawę błędów, pomagając utrzymać serwer stabilnym i łatwym w utrzymaniu.

Możesz wdrażać instancje serwera MCP na lokalnych komputerach — przydatne podczas testowania funkcji — lub w chmurze, gdy potrzebujesz niezawodności na poziomie produkcyjnym. Dostawcy chmury, tacy jak Google Cloud Run, AWS Elastic Container Service (ECS) czy Microsoft Azure App Service, oferują funkcje takie jak automatyczne skalowanie, wbudowane zabezpieczenia i wysoką dostępność. Kontenery Docker pomagają tworzyć spójne środowiska serwerowe i ułatwiają przenoszenie serwera między platformami.

Przed wdrożeniem ustaw zmienne środowiskowe dla poufnych danych, takich jak klucze API czy dane dostępowe do baz. Dostosuj limity zasobów (CPU, RAM) do przewidywanego obciążenia. Zawsze korzystaj z HTTPS z certyfikatami TLS, by chronić dane przesyłane między klientami a serwerem. Ogranicz ruch sieciowy wyłącznie do niezbędnych portów, konfigurując reguły zapory lub grupy bezpieczeństwa.

Chroń endpointy serwera MCP, wdrażając mechanizmy uwierzytelniania, takie jak klucze API lub OAuth. Zezwalaj na dostęp tylko zaufanym klientom. Regularnie aktualizuj i rotuj dane uwierzytelniające, by zmniejszyć ryzyko nieautoryzowanego dostępu.

Włącz logowanie serwera i korzystaj z narzędzi monitorujących chmurę, takich jak CloudWatch lub Google Operations Suite, aby śledzić wydajność i wykrywać błędy. Utwórz endpointy do health checków, aby automatycznie monitorować dostępność serwera. Skonfiguruj alerty, które powiadomią Cię o nietypowej aktywności lub awariach.

Wykorzystaj opcje automatycznego skalowania oferowane przez dostawcę chmury, by dostosować liczbę instancji serwera do zmiennego obciążenia. Jeśli narzędzia wymagają dużo CPU lub RAM, przydzielaj zasoby dynamicznie. Jeśli platforma to umożliwia, stosuj skalowanie horyzontalne, dodając kolejne instancje, zamiast zwiększać zasoby pojedynczego serwera. Ta metoda pozwala obsłużyć większą liczbę żądań.

Zapewnij regularne aktualizacje zależności i łatki systemu operacyjnego, by chronić serwer przed zagrożeniami. Przy wdrażaniu zmian stosuj metody blue/green lub rolling updates, by uniknąć przestojów i zapewnić ciągłość usług.

Stosując te kroki, przygotujesz serwer MCP na bezpieczną, stabilną i przyszłościową pracę. Proces ten wspiera tworzenie niezawodnych integracji produkcyjnych.

Aby rozbudować serwer MCP, zacznij od dodawania nowych, bardziej zaawansowanych narzędzi. Przykładowo, możesz wprowadzić moduły analizy danych, automatyczne generatory raportów lub konektory do platform automatyzacji przepływów pracy. Upewnij się, że każde narzędzie działa jako osobna funkcja lub mikroserwis. Postępuj zgodnie z protokołem rejestracji narzędzi MCP przy każdym nowym dodatku. Dzięki temu serwer pozostaje łatwy w zarządzaniu nawet przy rosnącej liczbie funkcji.

Aby włączyć AI do serwera MCP, dodaj interfejsy do zewnętrznych modeli językowych i API AI. Możesz łączyć się z dostawcami, takimi jak OpenAI, Claude czy Mistral, korzystając z ich SDK lub endpointów REST. Skonfiguruj serwer tak, by był w stanie śledzić stan rozmowy między sesjami. Umożliwia to wykonywanie bardziej złożonych zadań opartych na AI i łączenie kilku akcji w jednym procesie. Możesz skorzystać z adapterów społecznościowych lub SDK, np. Vercel AI SDK czy LangChain MCP Adapters, by ułatwić integrację i zapewnić szeroką kompatybilność.

Połącz swój serwer z zewnętrznymi API, takimi jak usługi pogodowe, płatności czy powiadomienia, budując dedykowane narzędzia MCP. Każde narzędzie powinno obsługiwać uwierzytelnianie, formatowanie żądań i analizę odpowiedzi. Wykorzystuj bezpieczne metody uwierzytelniania, takie jak OAuth 2.1 lub klucze API. Uruchamiaj te narzędzia w bezpiecznych środowiskach, np. w kontenerach lub WebAssembly, by chronić serwer i dane użytkowników.

Przeglądaj oficjalną dokumentację MCP i projekty open source, by znaleźć przykładowe wdrożenia i rozszerzenia społeczności. Dołącz do forów programistycznych i wspieraj rozwój wspólnych standardów oraz dobrych praktyk. Każde nowe narzędzie rozbudowuje Twój serwer i daje praktyczne doświadczenie w inżynierii protokołów.

Stosując te metody, rozbudujesz serwer MCP o zaawansowane, gotowe na AI i bezpieczne aplikacje.

Budując serwer MCP, zdobywasz praktyczne doświadczenie w integracji opartej o protokoły, modułowym projektowaniu backendu i łączeniu AI z innymi systemami. W tym przewodniku przeszedłeś przez kluczowe etapy: poznanie zasad działania Model Context Protocol, złożenie głównych części serwera, napisanie i przetestowanie kodu, wdrożenie serwera z zachowaniem bezpieczeństwa oraz zaplanowanie dalszego rozwoju o zaawansowane funkcje.

Framework MCP daje Ci jasną metodę wymiany danych w czasie rzeczywistym pomiędzy agentami AI a narzędziami zewnętrznymi. Taka struktura upraszcza integrację i wspiera automatyzację odporną na zmianę i skalowanie (Anthropic, 2024). Rozwijając te umiejętności, nadążysz za nowymi przepływami pracy AI i zmieniającymi się potrzebami backendu.

Możesz dalej się rozwijać, testując nowe narzędzia

Model Context Protocol (MCP) to otwarty standard, który umożliwia modelom AI łączenie się, wymianę danych i uruchamianie funkcji z zewnętrznymi narzędziami, źródłami danych i systemami programowymi za pośrednictwem uniwersalnego interfejsu.

Budowa własnego serwera MCP pozwala zdobyć praktyczne doświadczenie z architekturą backendową, projektowaniem protokołów oraz integracją AI. Umożliwia automatyzację przepływów pracy, łączenie agentów AI z aplikacjami produktywności i eksperymentowanie z nowymi podejściami do integracji.

Możesz użyć dowolnego języka programowania. Popularne wybory to Python, JavaScript (Node.js) i C#, w zależności od Twojej znajomości i dostępnych bibliotek do obsługi serwerów WWW i protokołów.

Serwer MCP składa się z głównej aplikacji serwerowej, modułów narzędzi/zasobów, obsługi komunikacji dla wiadomości protokołu oraz punktów integracyjnych do łączenia klientów i modeli AI.

Możesz testować swój serwer MCP za pomocą narzędzi takich jak MCP Inspector, Postman lub cURL. Używaj automatycznych frameworków testowych, szczegółowego logowania i debuggerów, aby zapewnić zgodność z protokołem i identyfikować problemy.

Tak, serwery MCP można wdrażać za pomocą usług chmurowych, takich jak Google Cloud Run, AWS lub Azure, aby zapewnić skalowalność i niezawodny dostęp z dowolnego miejsca.

Dodawaj nowe narzędzia jako modułowe funkcje lub mikroserwisy, rejestruj je zgodnie z protokołem i łącz z zewnętrznymi API modeli AI, korzystając z bezpiecznych interfejsów i najlepszych praktyk dotyczących sandboxingu i uwierzytelniania.

Odkryj płynną integrację AI z zewnętrznymi narzędziami i źródłami danych dzięki Model Context Protocol. Skorzystaj z praktycznego przewodnika, aby skonfigurować, przetestować i wdrożyć własny serwer MCP.

Dowiedz się, czym są serwery MCP (Model Context Protocol), jak działają i dlaczego rewolucjonizują integrację AI. Odkryj, jak MCP upraszcza łączenie agentów AI ...

Dowiedz się, jak stworzyć serwer Model Context Protocol (MCP), który bezproblemowo integruje się z API OpenAI, umożliwiając potężne wykonywanie narzędzi opartyc...

Poznaj kompleksowe przykłady serwerów MCP i dowiedz się, jak budować, wdrażać i integrować serwery Model Context Protocol, aby zwiększyć możliwości agentów AI w...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.