Hugging Face Transformers

Hugging Face Transformers to wiodąca otwarta biblioteka Pythona, która ułatwia wdrażanie modeli Transformer do zadań uczenia maszynowego w NLP, wizji komputerow...

Kompleksowy przewodnik po nowoczesnych strategiach pretrenowania modeli językowych, technikach kuracji danych i metodach optymalizacji wykorzystywanych przez HuggingFace do budowania wydajnych, wysokiej jakości modeli open-source.

W ostatnich latach krajobraz rozwoju modeli językowych przeszedł fundamentalną zmianę. Podczas gdy duże firmy technologiczne wciąż przesuwają granice skali modeli, społeczność open-source odkryła, że znakomite wyniki nie wymagają modeli liczących biliony parametrów. Ten kompleksowy przewodnik omawia najnowocześniejsze techniki i strategie wykorzystywane przez badaczy HuggingFace do budowania wydajnych, wysokiej jakości modeli językowych dzięki rygorystycznym metodom pretrenowania. Przeanalizujemy, jak SmolLM 3, FineWeb i FinePDF reprezentują nowy paradygmat w rozwoju modeli — skupiony na maksymalizacji wydajności w praktycznych ograniczeniach obliczeniowych przy zachowaniu naukowej rzetelności i powtarzalności. Przedstawione tu spostrzeżenia to efekt miesięcy badań i eksperymentów — to swoisty masterclass w podejściu do pretrenowania modeli w nowoczesnej rzeczywistości.

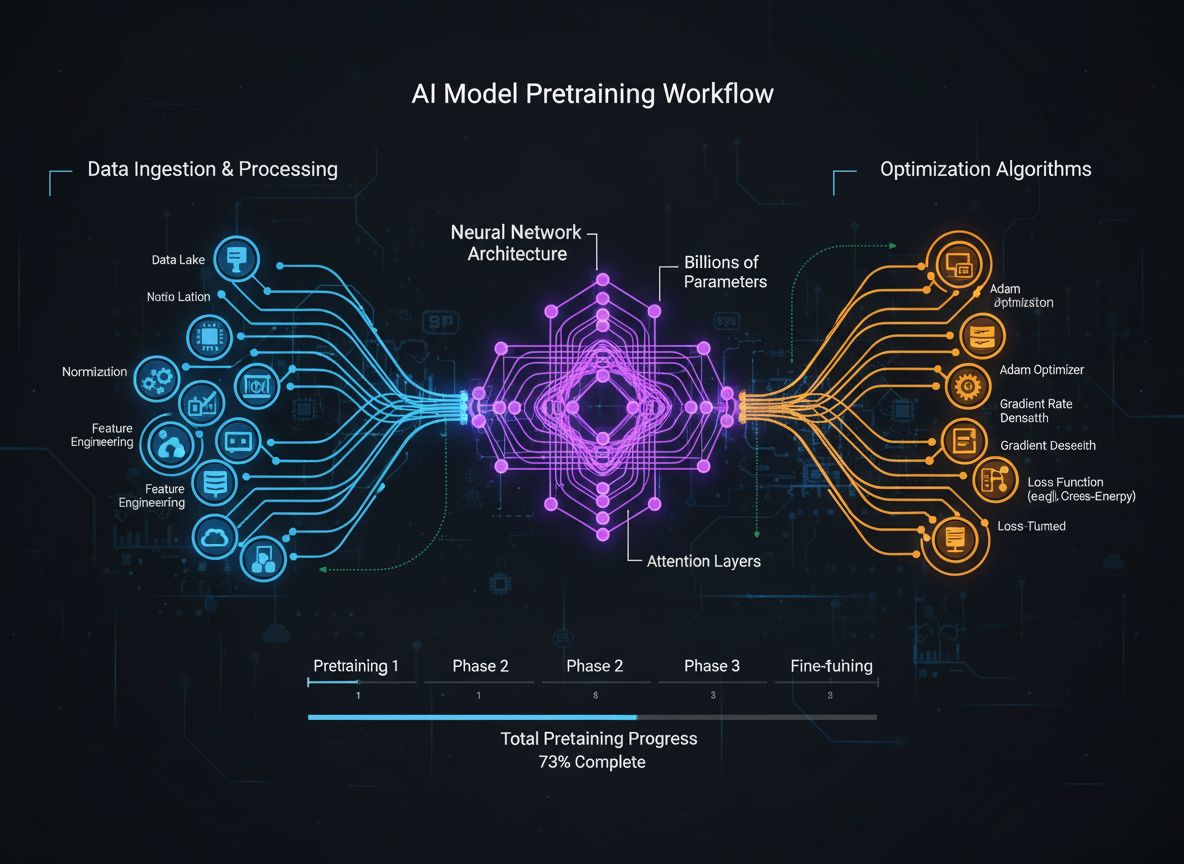

Pretrenowanie modeli językowych ewoluowało od stosunkowo prostego procesu podawania surowych danych tekstowych do sieci neuronowych, do zaawansowanej dyscypliny obejmującej wiele powiązanych celów optymalizacyjnych. U podstaw pretrenowania leży ekspozycja modelu na ogromne ilości danych tekstowych, co pozwala mu uczyć się statystycznych wzorców języka poprzez samouczenie. Współczesne podejście do pretrenowania uznaje jednak, że samo skalowanie danych i mocy obliczeniowej nie wystarcza. Zamiast tego, badacze muszą starannie orkiestrę całego procesu — od selekcji i kuracji danych, przez wybór architektury, po algorytmy optymalizacji. Dziedzina dojrzała na tyle, że zrozumienie tych niuansów oddziela modele klasy światowej od przeciętnych. Ta ewolucja odzwierciedla głębsze przekonanie, że na wydajność modelu wpływa nie pojedynczy czynnik, a przemyślana orkiestracja wielu, częściowo ortogonalnych celów optymalizacyjnych, które można równolegle udoskonalać. Coraz częściej społeczność badawcza uznaje, że „sekretny składnik” skutecznego rozwoju modeli tkwi nie w brutalnej sile skalowania, lecz w inteligentnych decyzjach projektowych na każdym etapie pipeline’u treningowego.

Jedną z najważniejszych lekcji płynących z ostatnich badań jest to, że jakość i różnorodność danych treningowych fundamentalnie determinują skuteczność modelu — znacznie bardziej niż sama ich ilość. Zasada ta, często podsumowywana jako „śmieci na wejściu, śmieci na wyjściu”, jest coraz lepiej potwierdzana przez badania empiryczne i praktyczne doświadczenie. Modele trenowane na źle wyselekcjonowanych, zduplikowanych lub niskiej jakości danych uczą się pozornych wzorców i nie potrafią efektywnie generalizować do nowych zadań. Z kolei starannie wybrane, zdeduplikowane i przefiltrowane zbiory danych umożliwiają modelom szybszą naukę i osiąganie lepszych efektów przy mniejszej liczbie kroków treningowych. Wnioski są znaczące: oznacza to, że organizacje i badacze powinni inwestować przede wszystkim w kurację danych i zapewnienie ich jakości, a nie po prostu w gromadzenie coraz większych wolumenów surowych danych. Ta zmiana perspektywy doprowadziła do powstania wyspecjalizowanych zespołów i narzędzi skupionych wyłącznie na tworzeniu i udoskonalaniu datasetów. Zbiór FineWeb, zawierający ponad 18,5 biliona tokenów oczyszczonych i zdeduplikowanych danych z anglojęzycznego internetu, jest tego przykładem. Zamiast wykorzystywać surowe dane z CommonCrawl, zespół FineWeb wdrożył zaawansowane filtrowanie, deduplikację i metody oceny jakości, tworząc zbiór, który konsekwentnie przewyższa większe, nieprzetworzone alternatywy. To fundamentalne odkrycie: droga do lepszych modeli prowadzi przez lepsze dane, a niekoniecznie przez większą ich ilość.

Współczesne pretrenowanie modeli można rozumieć przez pryzmat pięciu powiązanych, lecz częściowo ortogonalnych celów, które badacze muszą optymalizować równocześnie. Zrozumienie tych filarów to podstawa myślenia o całym procesie treningowym i identyfikowania miejsc, gdzie można dokonać ulepszeń. Pierwszy filar to maksymalizacja trafności i jakości surowych informacji w zbiorze treningowym, obejmująca zarówno jakość pojedynczych rekordów, jak i różnorodność całego zbioru. Model trenowany na wysokiej jakości, zróżnicowanych danych nauczy się bardziej ogólnych wzorców niż model trenowany na wąskich lub niskiej jakości danych, niezależnie od innych optymalizacji. Drugi filar to projekt architektury modelu, decydujący o wydajności przetwarzania informacji oraz ograniczeniach sprzętowych. Wybór architektury wpływa na szybkość wnioskowania, zużycie pamięci, wymagania cache i możliwość uruchamiania na określonym sprzęcie. Trzeci filar to maksymalizacja informacji wydobywanej z danych treningowych na każdym kroku — obejmuje to techniki takie jak destylacja wiedzy (gdzie mniejsze modele uczą się od większych) oraz predykcja wielu tokenów (gdzie modele przewidują kilka tokenów na raz). Czwarty filar to jakość gradientów i dynamika optymalizacji — tu wchodzi wybór optymalizatora, harmonogramy uczenia oraz techniki zapewniające stabilność treningu. Piąty filar to tuning hiperparametrów i strategie skalowania, które zapewniają stabilność treningu wraz ze wzrostem modelu i zapobiegają problemom takim jak eksplozja gradientów czy rozbieżność aktywacji. Te filary nie są niezależne — oddziałują na siebie w złożony sposób — ale rozpatrywanie ich osobno pomaga zidentyfikować obszary wymagające uwagi i miejsca największych potencjalnych usprawnień.

FineWeb to przełomowy moment w tworzeniu zbiorów danych do pretrenowania modeli językowych. Zamiast akceptować surowy wynik crawlerów takich jak CommonCrawl, zespół HuggingFace wdrożył kompleksowy pipeline do czyszczenia, filtrowania i deduplikacji danych internetowych na ogromną skalę. Efektem jest zbiór ponad 18,5 biliona tokenów wysokiej jakości tekstu angielskiego — jeden z największych tego typu w społeczności open-source. Tworzenie FineWeb obejmowało wiele etapów przetwarzania, z których każdy miał na celu usunięcie niskiej jakości treści przy zachowaniu wartościowych informacji. Wdrożono zaawansowane algorytmy deduplikacji, filtry jakości usuwające spam i słabe strony oraz detekcję języka, by zapewnić przewagę tekstów angielskich. Wartość FineWeb wynika nie tylko z rozmiaru, ale również z empirycznych dowodów na lepszą wydajność modeli trenowanych na tym zbiorze w porównaniu z większymi, nieprzetworzonymi alternatywami. Po zmieszaniu z innymi datasetami FineWeb konsekwentnie przewyższa znacznie większe surowe zbiory, co potwierdzają krzywe wydajności na benchmarkach. Sukces ten zainspirował szerszą społeczność badawczą do inwestowania w kurację danych, uznając ją za główne źródło zysków wydajnościowych. FineWeb jest dostępny bezpłatnie dla badaczy, co demokratyzuje dostęp do wysokiej jakości danych treningowych i umożliwia mniejszym organizacjom oraz zespołom akademickim trenowanie konkurencyjnych modeli.

Podczas gdy FineWeb skupiał się na danych internetowych, zespół HuggingFace zauważył, że innym ogromnym źródłem wysokiej jakości tekstu są dokumenty PDF. Zawierają one ogromne ilości ustrukturyzowanych, wartościowych informacji — od publikacji naukowych, przez dokumentacje techniczne, książki, po raporty branżowe. Jednak ekstrakcja tekstu z PDF-ów to wyzwanie techniczne, a wcześniejsze podejścia nie eksplorowały tej dziedziny na dużą skalę. FinePDF to pierwsza kompleksowa próba ekstrakcji, czyszczenia i kuracji danych PDF do pretrenowania modeli językowych. Zespół wdrożył zaawansowany pipeline zmagający się z wyzwaniami takimi jak złożone układy stron, ekstrakcja tekstu z dokumentów wielokolumnowych oraz obsługa osadzonych obrazów i tabel. Szczególnie innowacyjnym elementem jest etap „ponownego pobrania z internetu”, który rozwiązuje kluczowy problem: PDF-y z CommonCrawl są często źle wyodrębnione lub nieaktualne. Pobierając PDF-y bezpośrednio ze źródła, zespół zapewnia dostęp do najnowszych i najlepszych wersji dokumentów. Wyniki są imponujące — po zmieszaniu z innymi datasetami FinePDF osiąga bardzo dobre rezultaty w porównaniu z najnowszymi benchmarkami jak NeoTron B2. Zbiór dostarcza nowe, wysokiej jakości źródło danych treningowych, uzupełniające dane internetowe i pozwalające modelom uczyć się z bardziej zróżnicowanych, ustrukturyzowanych informacji. Praca ta otwiera nowe możliwości w tworzeniu datasetów, sugerując, że inne, dotąd pomijane źródła mogą dawać podobne korzyści. Pipeline FinePDF jest szczegółowo dokumentowany w blogach i dokumentacji technicznej, umożliwiając innym badaczom korzystanie z tych rozwiązań i adaptację do swoich potrzeb.

SmolLM 3 to zwieńczenie zastosowania zaawansowanych technik kuracji danych i optymalizacji treningu w celu stworzenia niezwykle wydajnego modelu językowego. Przy 3 miliardach parametrów SmolLM 3 jest znacznie mniejszy od wielu współczesnych modeli, a mimo to osiąga konkurencyjne wyniki dzięki skrupulatnej optymalizacji wszystkich pięciu filarów treningu modeli. Obsługuje tryb podwójnego rozumowania, wielojęzyczność (sześć języków) oraz rozumienie długiego kontekstu, co czyni go niezwykle wszechstronnym mimo niewielkiego rozmiaru. Rozwój SmolLM 3 obejmował staranny dobór architektury maksymalizującej wydajność – zastosowano transformery równoważące efektywność obliczeniową i pojemność modelu, wdrażając m.in. grouped query attention, by ograniczyć zużycie pamięci i opóźnienie inferencji. Model trenowano w trzech etapach, z których każdy progresywnie wzmacniał określone zdolności, umożliwiając optymalizację pod konkretne zastosowania. SmolLM 3 udowadnia, że społeczność open-source może obecnie konkurować z największymi modelami komercyjnymi w wielu zadaniach. Podważa to przekonanie, że „większy zawsze znaczy lepszy” i sugeruje, że branża osiągnęła już pewien pułap korzyści czysto ze skali. Teraz uwaga przesuwa się w stronę wydajności, interpretowalności i praktycznych możliwości wdrożeniowych. SmolLM 3 działa na sprzęcie konsumenckim, urządzeniach brzegowych i w środowiskach o ograniczonych zasobach, czyniąc zaawansowane AI dostępnym dla znacznie szerszego grona użytkowników. Wielojęzyczność i rozumienie długiego kontekstu pokazują, że wydajność nie musi oznaczać rezygnacji z kluczowych funkcji.

Destylacja wiedzy to potężna technika pozwalająca mniejszym modelom korzystać z wiedzy nabytej przez większe modele. Zamiast trenować mały model od zera na surowych danych, proces ten polega na uczeniu go naśladownictwa wyników większego, bardziej zaawansowanego modelu. W pretrenowaniu jest to szczególnie wartościowe, gdyż pozwala mniejszemu modelowi uczyć się wzorców już odkrytych przez większy model, co przyspiesza naukę i poprawia końcowe wyniki. Technicznie polega to na minimalizowaniu różnicy (np. poprzez dywergencję KL) pomiędzy rozkładami prawdopodobieństw generowanymi przez model nauczyciela (większy) i ucznia (mniejszy). Parametr „temperatury” kontroluje, jak „wygładzone” są rozkłady — wyższa temperatura daje płynniejsze rozkłady i więcej informacji o względnej pewności różnych predykcji. Destylacja wiedzy okazała się szczególnie skuteczna przy pretrenowaniu modeli językowych, bo umożliwia transfer wiedzy z dużych do mniejszych, wydajnych modeli. To szczególnie ważne dla wdrożeń na urządzeniach brzegowych i w środowiskach o ograniczonych zasobach, które chcą korzystać z możliwości dużych modeli. Technika ta stale się rozwija — badacze eksperymentują m.in. z transferem uwagi (uczeń naśladuje wzorce uwagi nauczyciela) czy destylacją cech (dopasowanie reprezentacji w warstwach pośrednich).

Tradycyjne trenowanie modeli językowych skupia się na przewidywaniu następnego tokenu na podstawie poprzednich. Jednak najnowsze badania pokazują, że trenowanie modeli do przewidywania kilku przyszłych tokenów jednocześnie może znacznie poprawić wyniki, zwłaszcza w zadaniach kodowania i złożonych problemach wymagających rozumowania. Predykcja wielu tokenów wymusza na modelu naukę długoterminowych zależności i głębsze zrozumienie wzorców w danych. Podejście to polega na dodaniu kilku „głów predykcyjnych”, z których każda odpowiada za przewidywanie tokenu oddalonego o kilka pozycji. Model otrzymuje sygnały o stracie ze wszystkich głów jednocześnie, co zachęca go do uczenia się reprezentacji przydatnych do przewidywania na wielu krokach naprzód. Choć trudniejsze od klasycznej predykcji jednego tokenu, daje lepsze reprezentacje. Korzyści z predykcji wielu tokenów wykraczają poza lepsze wyniki na samym celu treningowym: modele uczone w ten sposób często lepiej radzą sobie z zadaniami downstream, lepiej generalizują i lepiej rozumieją złożoność danych. Technika ta jest szczególnie skuteczna w generowaniu kodu, gdzie rozumienie długich zależności jest kluczowe dla poprawności składni i semantyki. Badania pokazują, że predykcja wielu tokenów może poprawić wyniki modelu o 5-15% na różnych benchmarkach, czyniąc ją jedną z najistotniejszych nowości ostatnich lat. Sama implementacja jest stosunkowo prosta, ale wymaga starannego doboru liczby głów i wag strat.

Przez lata AdamW był domyślnym wyborem przy trenowaniu dużych modeli językowych. Łączy aktualizacje gradientów z momentem oraz weight decay, zapewniając stabilny trening i dobre zbieżności. Jednak najnowsze badania dowodzą, że AdamW nie zawsze jest optymalny, szczególnie przy bardzo dużych modelach. Nowe optymalizatory, jak Muon i King K2, eksplorują alternatywne podejścia, dające lepszą dynamikę treningu i wyższą wydajność. Główną ideą stojącą za tymi rozwiązaniami jest lepsze przybliżanie macierzy Hessego (opisującej krzywiznę funkcji straty) przy użyciu m.in. metod Newtona-Schulza. Dzięki temu optymalizatory mogą dostarczać bardziej informatywne aktualizacje gradientów, prowadząc do szybszej zbieżności i lepszych końcowych wyników. Muon stosuje iterację Newtona-Schulza do ortogonalizacji macierzy gradientu, co pozwala rozłożyć naukę na większą liczbę wymiarów niż klasyczne podejścia z momentem. Skutkuje to stabilniejszym treningiem i eksploracją nowych obszarów przestrzeni parametrów. King K2 śledzi z kolei takie wielkości jak maksymalny log per head i na tej podstawie adaptacyjnie dostosowuje tempo uczenia i obcinanie gradientów. Znaczenie innowacji w optymalizatorach jest ogromne. Wielu praktyków nadal używa AdamW z hiperparametrami zoptymalizowanymi dla znacznie mniejszych modeli, nawet trenując modele o rząd wielkości większe. To sugeruje, że znaczne zyski są możliwe już dzięki samemu dostosowaniu wyboru optymalizatora i hiperparametrów do współczesnych modeli. Coraz więcej badań potwierdza, że wybór optymalizatora nie jest problemem rozwiązanym — ciągłe innowacje mogą przynieść znaczne korzyści w efektywności i wydajności treningu.

Utrzymanie wysokiej jakości gradientów przez cały proces treningowy jest kluczowe dla uzyskania dobrych wyników. Wraz ze wzrostem rozmiaru modeli do miliardów lub bilionów parametrów, trening staje się coraz bardziej niestabilny, a gradienty mogą eksplodować lub zanikać. Rozwiązanie tych problemów wymaga uwagi i wdrożenia technik utrzymania stabilności przez cały czas trwania treningu. Jednym ze sposobów poprawy jakości gradientów jest stosowanie obcinania gradientów, by zapobiec ich zbyt dużym wartościom destabilizującym trening. Jednak naiwne obcinanie może powodować utratę cennych informacji. Bardziej zaawansowane podejścia polegają na normalizacji gradientów w sposób pozwalający zachować istotne dane przy jednoczesnej stabilności. Ważny jest też wybór funkcji aktywacji i technik normalizacji warstw — różne funkcje mają różne właściwości przepływu gradientów, co może znacząco wpływać na stabilność. Normalizacja warstwowa (layer normalization) stała się standardem w transformerach, bo daje lepszy przepływ gradientów niż batch normalization. Harmonogram tempa uczenia także odgrywa kluczową rolę: zbyt wysokie tempo powoduje eksplozję gradientów, a zbyt niskie — wolną zbieżność lub utknięcie w minimum lokalnym. Nowoczesny trening często wykorzystuje harmonogramy z fazą rozgrzewki (warm-up), stopniowo zwiększając tempo, a następnie je obniżając w miarę postępu treningu. Zrozumienie i optymalizacja tych aspektów są kluczowe przy trenowaniu dużych modeli i pozostają przedmiotem bieżących badań.

Złożoność współczesnego pretrenowania modeli — liczne cele optymalizacyjne, zaawansowane pipeline’y danych, staranny tuning hiperparametrów — tworzy duże wyzwania dla zespołów wdrażających te techniki. FlowHunt odpowiada na te wyzwania, oferując platformę do automatyzacji i orkiestracji złożonych workflow treningowych. Zamiast ręcznego zarządzania przetwarzaniem danych, treningiem i ewaluacją, zespoły mogą zdefiniować workflow, które automatycznie realizują te zadania, ograniczając ryzyko błędów i poprawiając powtarzalność. Automatyzacja FlowHunt jest szczególnie cenna na etapie kuracji i przetwarzania danych, który w największym stopniu decyduje o skuteczności modelu. Platforma automatycznie wdraża zaawansowane pipeline’y jak te z FineWeb i FinePDF, obejmujące deduplikację, filtrowanie jakości i konwersję formatów. Pozwala to zespołom skupić się na decyzjach dotyczących zawartości i strategii przetwarzania danych, bez konieczności zagłębiania się w szczegóły implementacyjne. FlowHunt wspiera też zarządzanie tuningiem hiperparametrów i eksperymentami optymalizacyjnymi — automatyzuje uruchamianie wielu eksperymentów z różnymi konfiguracjami i zbieranie wyników, co pozwala szybciej znaleźć optymalne ustawienia. Platforma oferuje też narzędzia do monitorowania postępu treningu, wykrywania problemów (np. eksplozji gradientów, rozbieżności) oraz automatycznej korekty parametrów treningowych dla utrzymania stabilności. Dla organizacji budujących własne modele językowe lub fine-tuningujących istniejące, FlowHunt znacząco skraca czas i nakład pracy, podnosząc jakość efektów.

Jednym z największych wyzwań w trenowaniu modeli jest zrozumienie, jak skalować je od małych do dużych, zachowując stabilność i wysoką wydajność. Zależność między rozmiarem modelu a optymalnymi hiperparametrami nie jest prosta — to, co działa dla małych modeli, często wymaga korekty przy większych. Dotyczy to zwłaszcza tempa uczenia, które zwykle trzeba zmniejszać wraz ze wzrostem modelu. Zrozumienie praw skalowania jest kluczowe do przewidywania wydajności na różnych poziomach i podejmowania decyzji o alokacji zasobów. Badania pokazują, że wydajność modeli podlega przewidywalnym prawom skalowania — poprawia się wykładniczo wraz ze wzrostem wielkości modelu, zbioru danych i budżetu obliczeniowego. Umożliwia to szacowanie zysków z powiększania modelu lub zbioru danych i świadome inwestowanie zasobów. Prawa te nie są jednak uniwersalne — zależą od architektury, procedury treningowej i datasetu. Dlatego zespoły muszą przeprowadzać własne eksperymenty skalowania, by zrozumieć, jak rośnie wydajność w ich konkretnym przypadku. Proces skalowania obejmuje też dbałość o stabilność treningu — duże modele są bardziej podatne na eksplozję gradientów czy rozbieżności. Rozwiązaniem są techniki takie jak obcinanie gradientów, staranne harmonogramy nauki, a czasem zmiany architektury lub optymalizatora. Coraz więcej badań pokazuje, że skalowanie to nie tylko zwiększanie rozmiaru, ale przede wszystkim umiejętne zarządzanie procesem treningu, by duże modele rzeczywiście można było skutecznie trenować.

Uczenie cech (feature learning) to proces, w którym modele uczą się wydobywać użyteczne cechy z surowych danych podczas treningu. W kontekście pretrenowania modeli językowych oznacza to, że model uczy się reprezentować pojęcia lingwistyczne, relacje semantyczne i wzorce składniowe w swoich wewnętrznych reprezentacjach. Maksymalizacja uczenia cech — czyli zapewnienie, że model wydobywa jak najwięcej użytecznych informacji z danych na każdym kroku — to jeden z kluczowych celów nowoczesnego treningu modeli. Można o tym myśleć jako o stopniu, w jakim reprezentacje modelu zmieniają się pod wpływem aktualizacji gradientów. Jeśli model uczy się efektywnie, każda aktualizacja powinna przynosić istotne zmiany poprawiające trafność predykcji. Jeśli nie — zmiany są nieznaczne lub nie przekładają się na lepsze wyniki. Poprawę uczenia cech umożliwia m.in. staranna inicjalizacja wag modelu, która znacząco wpływa na tempo nauki przy pierwszych krokach. Istotny jest też harmonogram tempa uczenia — szybka nauka na początku (gdy model uczy się podstawowych cech), potem stopniowe zwalnianie w miarę nauki bardziej subtelnych wzorców. Koncepcja ta wiąże się z „kolapsem cech” — gdy model zaczyna ignorować część cech lub wymiarów wejścia, np. gdy znajduje skrót do rozwiązania zadania bez nauki wszystkich wymaganych cech. Pomagają tu techniki regularizacji i staranne projektowanie funkcji straty, które zapobiegają kolapsowi i wymuszają uczenie się różnorodnych, użytecznych cech.

{{ cta-dark-panel heading=“Przyspiesz Swoją Pracę z FlowHunt” description=“Sprawdź, jak FlowHunt automatyzuje Twój workflow AI i SEO — od researchu i generowania treści po publikację i analitykę — wszystko w jednym miejscu.” ctaPrimaryText=“Umów Demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Wypróbuj FlowHunt za Darmo” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Przez kilka lat dominował w AI pogląd, że większy model to lepszy model. Doprowadziło to do wyścigu na coraz większe modele, a firmy ścigały się w liczbie parametrów. Ostatnie osiągnięcia sugerują jednak zmianę tego paradygmatu. Sukces SmolLM 3 i innych wydajnych modeli pokazuje, że znakomite wyniki można osiągnąć przy modelach o rząd wielkości mniejszych od największych. Zmiana ta odzwierciedla głębsze zrozumienie, że na wydajność modelu wpływa wiele czynników, nie tylko liczba parametrów. Model z 3 miliardami parametrów, trenowany na wysokiej jakości danych z zastosowaniem zaawansowanych technik optymalizacyjnych, może przewyższyć znacznie większy model trenowany na słabszych danych i mniej starannie. Ta świadomość ma fundamentalne znaczenie dla branży. Sugeruje, że najbardziej przełomowe badania niekoniecznie polegają na budowaniu coraz większych modeli, lecz na poprawie jakości danych, opracowywaniu lepszych technik treningowych i tworzeniu wydajniejszych architektur. Demokratyzuje to także rozwój AI — mniejsze organizacje i zespoły akademickie mogą budować konkurencyjne modele bez konieczności posiadania ogromnych zasobów obliczeniowych wymaganych przez bilionowe modele. Odeście od czystej skali ma również praktyczne znaczenie dla wdrożeń: mniejsze modele mogą działać na urządzeniach brzegowych, w środowiskach o ograniczonych zasobach, z niższymi opóźnieniami i mniejszym zużyciem energii. To czyni zaawansowane AI dostępnym dla szerszego grona zastosowań i użytkowników. Coraz więcej badań potwierdza, że przyszłość AI to portfolio modeli o różnych rozmiarach, zoptymalizowanych pod konkretne zastosowania, a nie jeden wyścig na największy możliwy model.

Tuning hiperparametrów to proces doboru wartości parametrów sterujących treningiem, takich jak tempo uczenia, wielkość batcha czy weight decay. Mają one ogromny wpływ na wyniki modelu, a znalezienie optymalnych wartości jest kluczowe dla sukcesu. Często tuning traktowany jest bardziej jako sztuka niż nauka — praktycy polegają na intuicji i metodzie prób i błędów zamiast systematycznych procedur. Współczesne podejścia obejmują systematyczną eksplorację przestrzeni hiperparametrów. Techniki takie jak optymalizacja bayesowska pozwalają efektywnie przeszukiwać przestrzeń możliwych wartości, identyfikując obiecujące regiony i skupiając się na nich. Grid search i random search to prostsze metody, także skuteczne, zwłaszcza połączone z równoległym uruchamianiem eksperymentów. Ważnym wnioskiem z ostatnich badań jest to, że optymalne hiperparametry zależą od konkretnego modelu, zbioru danych i setupu treningowego. To oznacza, że wartości dobre w jednym przypadku mogą nie sprawdzić się w innym, nawet przy podobnych modelach. Dlatego coraz częściej wykonuje się tzw. sweepy hiper

SmolLM 3 to model z 3 miliardami parametrów, zaprojektowany z myślą o maksymalnej wydajności przy zachowaniu wysokiej skuteczności w wielu językach oraz zadaniach wymagających rozumienia długiego kontekstu. W przeciwieństwie do większych modeli, SmolLM 3 skupia się na optymalnych wynikach w ograniczonych warunkach obliczeniowych, dzięki czemu idealnie nadaje się do wdrożeń na urządzeniach brzegowych i w środowiskach o ograniczonych zasobach.

Zasada 'śmieci na wejściu, śmieci na wyjściu' jest fundamentalna w uczeniu maszynowym. Wysokiej jakości, zróżnicowane dane mają bezpośredni wpływ na skuteczność modelu – znacznie większy niż sama ilość danych. FineWeb i FinePDF pokazują, że staranna kuracja, deduplikacja i filtrowanie danych treningowych prowadzą do znacznie lepszych efektów niż praca na surowych, nieprzetworzonych zbiorach.

Destylacja wiedzy to technika, w której mniejszy model uczy się od większego, bardziej zaawansowanego modelu. Podczas pretrenowania takie podejście pozwala mniejszym modelom wydobyć maksimum informacji z danych treningowych poprzez naukę wzorców, które większe modele już odkryły, co przekłada się na lepsze wyniki przy mniejszej liczbie parametrów.

Predykcja wielu tokenów polega na trenowaniu modeli do przewidywania kilku kolejnych tokenów jednocześnie, a nie tylko następnego. Takie podejście jest szczególnie skuteczne w zadaniach kodowania i poprawia zdolność modelu do rozumienia długoterminowych zależności, prowadząc do lepszych wyników w złożonych zadaniach wymagających rozumowania.

Nowoczesne optymalizatory, takie jak Muon, wykraczają poza tradycyjny AdamW, stosując techniki takie jak metody Newtona-Schulza w celu lepszego przybliżania macierzy Hessego. Przekłada się to na stabilniejsze trenowanie, wyższej jakości gradienty i lepszą dynamikę uczenia, szczególnie przy skalowaniu modeli do dużej liczby parametrów.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

FlowHunt pomaga zespołom usprawnić pretrenowanie modeli, przetwarzanie danych i procesy optymalizacyjne dzięki inteligentnej automatyzacji.

Hugging Face Transformers to wiodąca otwarta biblioteka Pythona, która ułatwia wdrażanie modeli Transformer do zadań uczenia maszynowego w NLP, wizji komputerow...

Odkryj, jak Jamba 3B od AI21 łączy mechanizmy uwagi transformera z modelami przestrzeni stanów, osiągając niespotykaną wydajność i możliwości obsługi długich ko...

Wykrywanie języka w dużych modelach językowych (LLM) to proces, w którym modele te identyfikują język tekstu wejściowego, umożliwiając dokładne przetwarzanie dl...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.