Sora 2: Generowanie wideo przez AI dla twórców treści

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo przez AI: od realistycznego odtwarzania postaci po symulację fizyki i zobacz, jak ta technologia zmienia...

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo AI — od realistycznego odtwarzania postaci po symulację fizyki — i odkryj, jak ta technologia zmienia tworzenie i automatyzację treści.

Sora 2 to znaczący krok naprzód w technologii generowania wideo przez sztuczną inteligencję. Najnowsza wersja modelu OpenAI oferuje niespotykane dotąd możliwości dla twórców treści, marketerów i firm dążących do usprawnienia procesów produkcji wideo. Ten kompleksowy przewodnik omawia niezwykłe funkcje Sora 2, jej praktyczne zastosowania oraz konsekwencje dla przyszłości tworzenia treści. Od odtwarzania ulubionych postaci fikcyjnych po generowanie realistycznych wystąpień ludzi — Sora 2 pokazuje przełomowy potencjał generatywnej AI w produkcji mediów wizualnych. Niezależnie czy interesują Cię aspekty techniczne, kreatywne możliwości, czy zastosowania biznesowe, ten artykuł szczegółowo omawia, co czyni Sora 2 przełomową technologią.

Generowanie wideo przez sztuczną inteligencję to jeden z najciekawszych obszarów technologii generatywnej AI. W przeciwieństwie do tradycyjnej produkcji, wymagającej kamer, aktorów, oświetlenia i żmudnej postprodukcji, generowanie AI tworzy filmy bezpośrednio z opisów tekstowych lub promptów. Technologia ta wykorzystuje modele głębokiego uczenia, trenowane na ogromnych zbiorach danych wideo, by zrozumieć relacje między opisami językowymi a treściami wizualnymi. Modele te uczą się schematów dotyczących ruchu obiektów, interakcji światła z powierzchniami, gestykulacji ludzi, wyrażania emocji i naturalnych przejść między scenami. Po otrzymaniu promptu tekstowego, model AI analizuje go i generuje film klatka po klatce, dbając o spójność wyglądu postaci, ruchu i szczegółów otoczenia przez cały film. Technologicznie opiera się to o modele dyfuzyjne oraz architekturę transformerów, które zostały specjalnie zaadaptowane do generowania wideo, co pozwala utrzymać spójność czasową — czyli postacie i obiekty poruszają się w sposób naturalny i konsekwentny, a nie pojawiają się przypadkowo czy migoczą.

Znaczenie generowania wideo AI wykracza daleko poza zwykłą nowinkę. Technologia ta rozwiązuje kluczowe wyzwania w produkcji treści: czas, koszt i skalowalność. Tradycyjna produkcja wideo może trwać tygodniami lub miesiącami i wymagać zespołów specjalistów: reżyserów, operatorów, montażystów, specjalistów efektów specjalnych. Generowanie AI pozwala uzyskać podobny efekt w ciągu minut, czyniąc profesjonalne wideo dostępnym dla małych firm, niezależnych twórców czy przedsiębiorstw, które dotąd nie mogły sobie na to pozwolić. Demokratyzacja produkcji wideo przez AI ma ogromne znaczenie dla marketingu, edukacji, rozrywki i komunikacji korporacyjnej. Wraz z rozwojem tej technologii i jej dostępnością zmienia się podejście firm do strategii wizualnych i organizacji procesów produkcji treści.

Biznesowe argumenty za generowaniem wideo AI są przekonujące i wielowymiarowe. W dzisiejszym cyfrowym świecie to właśnie wideo dominuje w statystykach zaangażowania na wszystkich platformach. Według branżowych danych, treści wideo generują znacznie wyższe zaangażowanie niż obrazy czy tekst, a platformy takie jak TikTok, YouTube czy Instagram promują wideo w swoich algorytmach. Jednak produkcja wysokiej jakości wideo na dużą skalę była dotąd bardzo kosztowna. Generowanie AI rozwiązuje ten problem, umożliwiając firmom tworzenie nieograniczonej liczby wariantów wideo do testów A/B, personalizacji i szybkiej iteracji. Zespoły marketingowe mogą generować dziesiątki filmów demonstracyjnych w różnych stylach bez konieczności ponownych nagrań. Instytucje edukacyjne mogą na masową skalę tworzyć spersonalizowane materiały. Działy obsługi klienta generują filmy szkoleniowe do nowych procedur w czasie rzeczywistym. Ekonomiczny efekt jest ogromny: firmy mogą obniżyć koszty produkcji wideo o 70-90%, jednocześnie zwielokrotniając liczbę materiałów.

Poza oszczędnościami, generowanie wideo AI otwiera nowe możliwości kreatywności i eksperymentowania. Twórcy mogą testować nawet najbardziej szalone pomysły bez angażowania dużych środków. Mogą generować wiele wersji tego samego konceptu i sprawdzać, które najlepiej rezonują z odbiorcami. Mogą tworzyć treści w różnych stylach, tonacjach i formatach, dopasowanych do segmentów odbiorców lub wymagań platform. Ta elastyczność zmienia wideo z rzadkiego, starannie planowanego zasobu w obfite, eksperymentalne medium. Zmienia się też strategia tworzenia treści: zamiast kilku dużych produkcji kwartalnie, firmy mogą przejść do modelu ciągłego publikowania, gdzie wideo staje się tak rutynowe jak wpisy na blog. Dzięki temu możliwe jest bardziej elastyczne, spersonalizowane i szybkie reagowanie na potrzeby odbiorców i cele biznesowe. Co więcej, generowanie AI umożliwia tworzenie interaktywnych i dynamicznych materiałów, które dostosowują się do widza, otwierając nowe możliwości angażowania i konwersji.

Sora 2 rozwija wcześniejsze modele generowania wideo, wnosząc znaczące udoskonalenia na wielu polach. Najbardziej widoczną zmianą jest radykalny wzrost jakości i realizmu obrazu. Filmy generowane przez Sora 2 cechują się znacznie lepszym oświetleniem, naturalnym kolorem, bogatymi teksturami i wiarygodnymi właściwościami materiałów. Oglądając wideo z Sora 2, można mieć wrażenie, że poziom wizualny dorównuje profesjonalnej kinematografii. Model świetnie radzi sobie z renderowaniem złożonych scen z wieloma obiektami, utrzymuje spójność oświetlenia w całym kadrze i tworzy realistyczne odbicia czy cienie. Ta jakość jest kluczowa dla profesjonalnych zastosowań, gdzie słaba realizacja podważyłaby wiarygodność i wizerunek marki.

Symulacja fizyki to kolejny ogromny krok naprzód. Wcześniejsze modele często miały problem z konsekwencją fizyczną — obiekty poruszały się nienaturalnie, grawitacja była niekonsekwentna, kolizje nie były prawidłowo odwzorowane. Sora 2 znacznie lepiej rozumie prawa fizyki i interakcje obiektów z otoczeniem. Rzucona piłka leci realistyczną trajektorią. Chodząca osoba zachowuje się naturalnie, a rozkład ciężaru i ruchy są wiarygodne. Kolizje wyglądają przekonująco. To szczególnie ważne przy filmach produktowych, edukacyjnych lub rozrywkowych, gdzie nienaturalna fizyka byłaby od razu zauważona. Lepsze rozumienie fizyki umożliwia też tworzenie bardziej dynamicznych i złożonych scen.

Spójność czasowa i koherencja to kluczowe usprawnienia, dzięki którym filmy z Sora 2 przypominają rzeczywiste nagrania, a nie zbiór przypadkowych klatek. Model utrzymuje tożsamość postaci od początku do końca filmu — ludzie wyglądają tak samo, nie zmieniają się ani nie morfują. Szczegóły otoczenia pozostają niezmienne — jeśli na początku w tle jest roślina, pozostaje ona w tym samym miejscu przez cały film. To niezbędne dla profesjonalnych zastosowań i tworzy immersyjne, naturalne doświadczenie. Model lepiej rozumie ruch i sekwencje akcji, generując płynne, realistyczne przejścia między pozami.

Jedną z najbardziej imponujących funkcji Sora 2 jest precyzyjne odtwarzanie ludzkich twarzy dzięki technologii skanowania. Użytkownicy wykonujący skan twarzy zgłaszają, że model odwzorowuje ich wygląd z około 90% dokładnością — zarówno cechy, mimikę, jak i najdrobniejsze szczegóły, takie jak tekstura skóry czy odbicia światła. To osiągnięcie otwiera możliwości dotąd zarezerwowane dla science fiction. Oglądając wygenerowany przez Sora 2 film z własnym udziałem, można zobaczyć siebie w sytuacjach, w których nigdy się nie było, wykonującego nieznane czynności. Model oddaje nie tylko statyczne cechy, lecz także dynamikę ruchu i wyrazu twarzy. Oświetlenie, odbicia w oczach, ruch włosów — wszystko wygląda przekonująco.

Konsekwencje tej technologii są zarówno ekscytujące, jak i budzące obawy. Z jednej strony twórcy mogą nagrywać treści z własnym udziałem bez obecności na planie. YouTuber wygeneruje dziesiątki wariantów bez powtórek. Nauczyciel przygotuje spersonalizowane materiały dydaktyczne z sobą w roli wykładowcy. Dyrektor firmy stworzy ogłoszenia czy szkolenia bez rezerwowania czasu na nagrania. Oszczędność czasu i kosztów jest ogromna. Jednak pojawiają się też pytania o zgodę, autentyczność i potencjalne nadużycia. Teoretycznie można tworzyć deepfake’i lub wprowadzające w błąd filmy z udziałem prawdziwych osób bez ich aprobaty. OpenAI wdrożyło mechanizmy bezpieczeństwa, w tym możliwość decydowania, czy wizerunek użytkownika może być wykorzystywany przez innych, ale ryzyko niewłaściwego użycia technologii pozostaje poważnym wyzwaniem dla społeczeństwa i regulatorów.

Sora 2 umożliwia kreatywne zastosowania, które wcześniej były niemożliwe lub zbyt kosztowne. Jednym z najciekawszych przykładów jest odtwarzanie ulubionych postaci fikcyjnych w nowych scenariuszach. Użytkownicy generowali już filmy ze SpongeBobem rapującym drill, z zachowaniem stylu animacji, projektowania postaci oraz syntezy głosu. Model odwzorowuje charakterystyczny styl wizualny i zachowuje go przez cały film. Podobnie odtworzono klasyczne sceny z gier, np. Halo z oryginalnym wyglądem, elementami interfejsu i narracją. To pokazuje, jak Sora 2 potrafi rozumieć oraz powielać specyficzne style wizualne, projekty postaci i konwencje estetyczne.

Rozrywka to także możliwość tworzenia nowych treści w stylu znanych franczyz. Użytkownicy generowali pełne odcinki SpongeBoba, łącząc sekwencje z Sora 2 w spójną historię z zachowaną stylistyką. To sugeruje, że w przyszłości AI może wspierać animację, generując kluczowe sceny lub warianty, które później dopracowują animatorzy. Technologia demokratyzuje animację, dając samodzielnym twórcom narzędzia dotąd dostępne tylko dużym studiom. Rekreacje gier komputerowych to kolejne fascynujące pole — użytkownicy umieszczali postacie w środowisku Minecrafta lub odtwarzali Mario Kart w fotorealistycznym stylu. To pokazuje elastyczność modelu i zdolność adaptacji do różnych kontekstów i stylów wizualnych.

Choć Sora 2 to ogromny postęp, warto znać jej obecne ograniczenia. Testy pokazują, że choć rekonstrukcja twarzy jest zwykle bardzo dobra, zdarzają się przypadki niespójności. Generując kilka filmów z tym samym promptem, można uzyskać różnej jakości rezultaty. Czasem twarz jest niemal idealna, innym razem pojawiają się subtelne zniekształcenia lub zmiany cech. To oznacza, że model nie jest jeszcze w pełni deterministyczny i czasem trzeba wygenerować kilka wersji, by znaleźć najlepszą. Niespójności szczególnie widać w skrajnych przypadkach i złożonych scenach.

Ruchy dłoni i manipulacja obiektami to istotne ograniczenie obecnej wersji. Przy szczegółowych ruchach rąk lub precyzyjnych czynnościach wyniki często nie przekonują. Dłonie bywają zdeformowane, palce nienaturalnie ułożone, a obiekty nie są prawidłowo trzymane. Jest to szczególnie widoczne przy zadaniach wymagających precyzji, jak gra na instrumencie, operacje chirurgiczne czy manualne czynności. Wynika to z ogólnego wyzwania dla AI: odwzorowania biomechaniki ruchu ludzkich dłoni. Ulepszanie renderowania rąk i manipulacji to aktywny obszar badań.

Błędy fizyczne wciąż czasem występują, zwłaszcza w scenach z wieloma obiektami lub siłami. Zdarza się, że samochody jadą w niewłaściwą stronę, przedmioty unoszą się zamiast spadać, kolizje nie są właściwie odwzorowane. Takie błędy są rzadsze niż w poprzednich modelach, ale nadal zauważalne. Najczęściej występują w nietypowych przypadkach lub przy złożonych interakcjach nieobecnych w danych treningowych. Synteza głosu także bywa nierówna — niektóre głosy brzmią sztucznie lub mają cyfrowe artefakty. Jakość zależy od konkretnego głosu i trudności mowy.

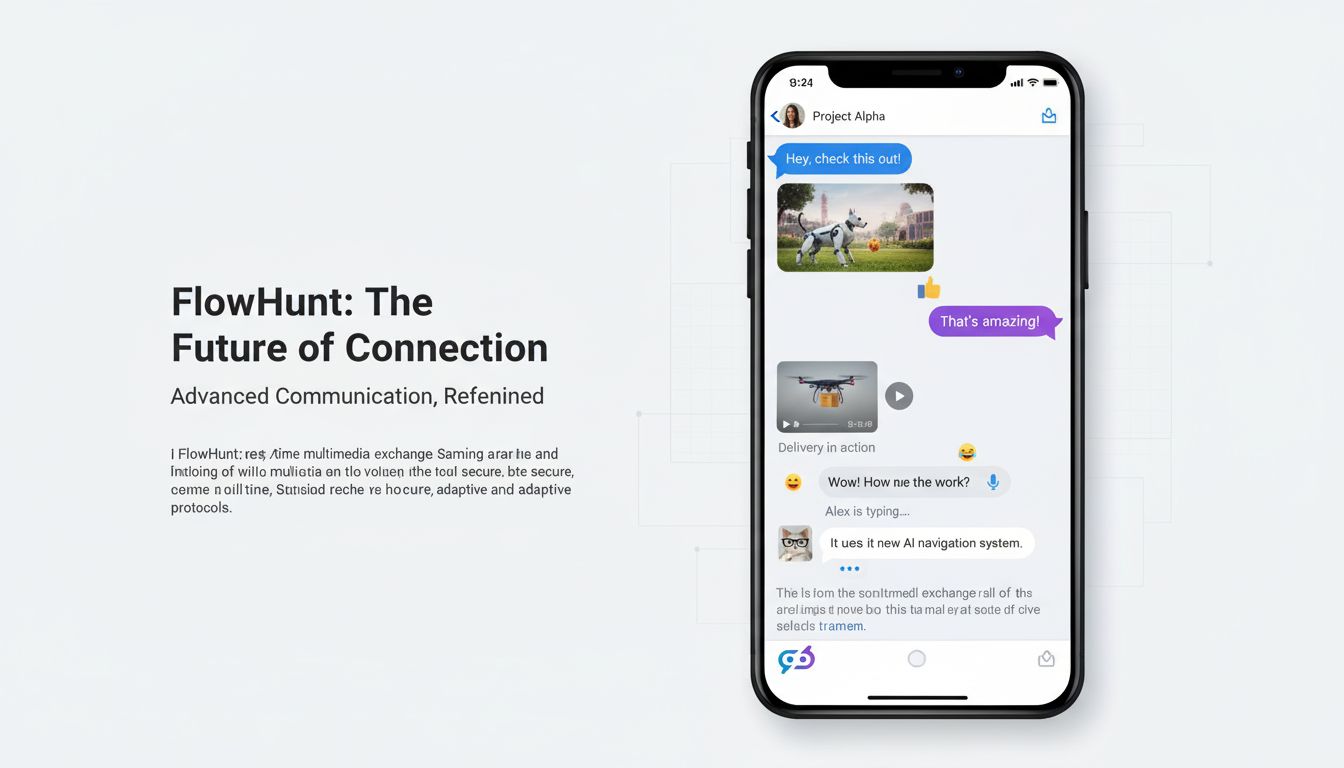

FlowHunt dostrzega przełomowy potencjał generowania wideo AI i integruje te możliwości ze swoją platformą automatyzacji, by pomóc firmom usprawnić procesy tworzenia treści. Zamiast traktować generowanie filmów jako osobne narzędzie, FlowHunt łączy je z ekosystemem automatyzacji contentu. Pozwala to firmom budować kompletne workflow — od generowania filmów, przez dodawanie napisów i brandingu, publikację na różnych platformach, po analizę zaangażowania — wszystko bez ręcznej ingerencji.

Integracja Sora 2 i innych modeli wideo z platformą FlowHunt umożliwia realizację zaawansowanych scenariuszy automatyzacji. Zespoły contentowe mogą ustawić cykliczne zadania generowania filmów. Sklepy internetowe automatycznie tworzą filmy produktowe dla nowego asortymentu. Marketing generuje spersonalizowane warianty dla różnych grup odbiorców. Szkoły przygotowują treści szkoleniowe na żądanie. Działy wsparcia tworzą filmy instruktażowe do najczęstszych problemów. Połączenie generowania wideo z automatyzacją FlowHunt pozwala osiągnąć niespotykaną skalę i efektywność produkcji treści. Platforma zarządza orkiestracją, harmonogramem i integracją z innymi systemami, by zespoły mogły skupić się na strategii i kreatywności.

Sora 2 znajduje zastosowanie praktycznie w każdej branży i funkcji biznesowej. W marketingu i reklamie umożliwia tworzenie filmów demonstracyjnych, testimoniali czy promocyjnych na dużą skalę. Marki generują różne wersje reklam, testując przekazy, style i wezwania do działania. E-commerce tworzy filmy produktowe dla tysięcy produktów bez indywidualnych sesji. Agenci nieruchomości generują wirtualne wycieczki po domach. Biura podróży prezentują kierunki turystyczne. Oszczędności i szybkość to przełom dla działów marketingu zmagających się wcześniej z barierami produkcji.

W edukacji i szkoleniach Sora 2 umożliwia tworzenie spersonalizowanych materiałów dydaktycznych i instruktażowych. Szkoły generują filmy z udziałem wykładowców w różnych scenariuszach. Działy HR tworzą filmy onboardingowe, szkolenia BHP, materiały rozwojowe. Możliwość generowania materiałów na żądanie pozwala na szybką aktualizację treści, gdy zmieniają się procedury czy pojawiają nowe informacje. Personalizacja na masową skalę — każdy uczeń może dostać film dopasowany do swoich potrzeb i poziomu wiedzy.

W rozrywce i mediach Sora 2 otwiera możliwości animacji, efektów specjalnych i produkcji treści, które dotąd były ograniczone budżetem i czasem. Niezależni twórcy tworzą animacje bez zespołów animatorów. Produkcje filmowe i telewizyjne wykorzystują AI do efektów, tła czy nawet całych scen. Tworzone są teledyski, platformy streamingowe generują własne treści. Technologia demokratyzuje rozrywkę, umożliwiając wysokiej jakości produkcję nawet przy ograniczonym budżecie.

W komunikacji korporacyjnej i działaniach wewnętrznych Sora 2 pozwala na tworzenie komunikatów zarządu, ogłoszeń firmowych, szkoleń czy dokumentacji. Dyrektorzy generują spersonalizowane wiadomości bez sesji nagraniowych. HR tworzy filmy szkoleniowe do nowych polityk. IT przygotowuje instrukcje obsługi systemów. Szybkie i tanie generowanie treści pozwala firmom efektywnie komunikować się z pracownikami i interesariuszami.

Obecny krajobraz generowania wideo AI to prawdziwy „dziki zachód” praw autorskich. Sora 2 potrafi tworzyć filmy z udziałem postaci objętych prawami autorskimi, celebrytów czy własności intelektualnej bez zgody właścicieli. Użytkownicy generują filmy ze SpongeBobem, Mario, Zeldą czy innymi znanymi markami. Mogą także tworzyć filmy z udziałem celebrytów i osób publicznych. To rodzi poważne pytania prawne i etyczne dotyczące praw własności, zgody i stosowania treści generowanych przez AI. Tak dokładne odtwarzanie wizerunków i postaci stwarza duże ryzyko nadużyć.

OpenAI wprowadziło pewne zabezpieczenia, np. możliwość kontrolowania, czy nasz wizerunek może być wykorzystywany przez innych. Jednak to nie rozwiązuje problemu generowania treści z udziałem postaci lub celebrytów bez zgody właścicieli praw. Otoczenie prawne wciąż się kształtuje — sądy i regulatorzy dopiero zaczynają mierzyć się z zagadnieniami dozwolonego użytku, naruszeń praw autorskich i granic dla treści generowanych przez AI. Niektórzy uważają, że tworzenie takich filmów na własny użytek mieści się w ramach dozwolonego użytku, inni, że każda komercyjna eksploatacja powinna wymagać zgody właściciela praw. Dodatkową komplikacją są różnice w przepisach w poszczególnych krajach.

Etyka wykracza poza prawa autorskie i obejmuje autentyczność, zgodę oraz ewentualne nadużycia. Widzowie oglądający film z udziałem celebryty mogą założyć, że jest on autentyczny, jeśli nie zostaną poinformowani inaczej. To rodzi ryzyko dezinformacji i manipulacji. Technologia może posłużyć do tworzenia deepfake’ów szkodzących wizerunkowi lub rozpowszechniających fałszywe informacje. Choć obecne ograniczenia Sora 2 utrudniają stworzenie perfekcyjnego deepfake’a, technologia rozwija się bardzo szybko. Społeczeństwo musi wypracować normy, regulacje i zabezpieczenia techniczne, by zapobiec nadużyciom przy zachowaniu korzyści płynących z rozwoju tej technologii.

Ulepszenia Sora 2 względem poprzednich modeli wynikają z postępu w kilku obszarach technicznych. Model wykorzystuje udoskonalone architektury dyfuzyjne, lepiej rozumiejąc relacje między opisem tekstowym a treścią wizualną. Proces treningu oparto na bardziej zróżnicowanych i wyższej jakości danych wideo, co pozwoliło modelowi uczyć się bardziej subtelnych wzorców funkcjonowania świata. Lepsze zrozumienie fizyki, światła i właściwości materiałów wynika ze staranniej dobranych danych treningowych i nowych funkcji strat, które penalizują niefizyczne efekty. Spójność czasową poprawiono dzięki lepszemu utrzymywaniu stanu między klatkami oraz udoskonalonym mechanizmom uwagi, pozwalającym zrozumieć długie zależności w sekwencjach wideo.

Skanowanie twarzy i odtwarzanie postaci opiera się na wyspecjalizowanych komponentach kodujących cechy i tożsamość w sposób zachowany podczas całego procesu generowania. Komponenty te korzystają z technik zbliżonych do systemów rozpoznawania twarzy, ale dostosowanych do kontekstu generowania filmów. Model uczy się powiązywać informacje o tożsamości z konkretnymi wzorcami wizualnymi i zachowuje tę koherencję w całym filmie. Ulepszenia syntezy głosu wynikają z lepszych modeli text-to-speech oraz lepszej integracji komponentów generujących dźwięk i obraz — obecnie dźwięk lepiej odpowiada ruchowi ust i mimice, co daje bardziej przekonujący efekt.

Choć Sora 2 to ogromny krok naprzód, warto wiedzieć, jak wypada na tle konkurencji. Modele takie jak Runway, Synthesia czy otwarte alternatywy mają swoje mocne i słabe strony. Runway skupia się na prostocie i społeczności twórców. Synthesia specjalizuje się w generowaniu wideo z awatarami do komunikacji biznesowej. Otwarte modele, jak Stable Video Diffusion, dają większą swobodę i możliwości modyfikacji. Sora 2 wyróżnia się najwyższą jakością obrazu, lepszą symulacją fizyki oraz dokładniejszym odtwarzaniem postaci. Potrafi generować dłuższe filmy i obsługiwać bardziej złożone sceny, co daje przewagę w wielu zastosowaniach.

Jednak Sora 2 ma również swoje ograniczenia na tle konkurencji. Niektóre modele szybciej generują filmy w czasie rzeczywistym lub mają mniejsze wymagania sprzętowe. Inne pozwalają precyzyjniej kontrolować wybrane aspekty filmu. Jeszcze inne są lepiej zintegrowane z wybranymi platformami czy workflow. Wybór odpowiedniego modelu zależy od specyficznych wymagań i zastosowań. Jeśli kluczowa jest najwyższa jakość i realizm — Sora 2 to najlepszy wybór. Jeśli potrzebna jest generacja na żywo lub szczegółowa personalizacja — lepiej sprawdzi się inny model. Rozwój branży będzie oznaczał dalsze ulepszenia wszystkich modeli i pojawianie się nowych, wyspecjalizowanych rozwiązań.

Przekonaj się, jak FlowHunt automatyzuje Twoje procesy generowania treści i wideo AI — od badań, przez tworzenie i publikację, po analitykę — w jednym miejscu.

Obecny rozwój technologii generowania wideo AI sugeruje, że jesteśmy dopiero na początku drogi. Przyszłe wersje Sora i konkurencyjnych modeli prawdopodobnie rozwiążą obecne ograniczenia w zakresie ruchów dłoni, symulacji fizyki i spójności. Spodziewać się można wydłużenia filmów, wyższej rozdzielczości i obsługi coraz bardziej złożonych scen. Modele staną się wydajniejsze, wymagając mniej mocy obliczeniowej. Integracja z innymi systemami AI umożliwi bardziej zaawansowane workflow, gdzie generowanie wideo będzie jednym z elementów szerokiego procesu tworzenia i analizy treści.

Konsekwencje dla świata treści są ogromne. Wraz z rozwojem tej technologii wideo stanie się tak powszechne jak tekst w komunikacji cyfrowej. Firmy przestaną traktować wideo jako rzadki, drogi zasób, a zaczną traktować je jako medium obfite i eksperymentalne. Pozwoli to na bardziej responsywne, spersonalizowane i angażujące treści. Pojawią się jednak także nowe wyzwania, jak autentyczność, dezinformacja czy potrzeba nowych norm i regulacji dla treści generowanych przez AI. Technologia wywoła rewolucję w branżach kreatywnych — część ról zniknie, ale pojawią się nowe szanse dla tych, którzy potrafią efektywnie kierować i kuratorować treści generowane przez AI.

Firmy chcące efektywnie wykorzystywać Sora 2 powinny stosować kilka dobrych praktyk. Po pierwsze, należy poznać mocne strony i ograniczenia modelu. Sora 2 świetnie radzi sobie z realistycznymi scenami, światłem i fizyką, ale słabiej złożonymi ruchami dłoni i czasami daje niespójne wyniki. Warto projektować prompty pod kątem tych mocnych stron. Po drugie, generować kilka wariantów tego samego promptu i wybierać najlepsze efekty. Model daje różne wyniki, dlatego warto próbować kilka razy. Po trzecie, do odtwarzania postaci najlepiej korzystać ze skanowania twarzy — daje to dużo lepszą dokładność niż same opisy tekstowe.

Po czwarte, lepiej dzielić złożone filmy na kilka klipów i łączyć je później, zamiast generować całość na raz. Daje to większą kontrolę i lepsze efekty. Po piąte, opisy powinny być szczegółowe i precyzyjne — określać nie tylko co ma się wydarzyć, ale także styl wizualny, oświetlenie, nastrój. Ogólne prompty dają przeciętne wyniki, a doprecyzowane — dużo lepsze. Po szóste, warto integrować generowanie wideo z szerszym workflow, np. za pomocą FlowHunt, by zautomatyzować cały proces od generacji po publikację i analitykę. To pozwala skalować produkcję treści na niespotykaną dotąd skalę.

Wraz z upowszechnianiem generowania wideo AI pojawiają się uzasadnione obawy o autentyczność, dezinformację i wypieranie miejsc pracy. Organizacje korzystające z tej technologii powinny transparentnie informować o jej użyciu, zwłaszcza tam, gdzie odbiorcy mogą uznać treść za autentyczną. Ujawnianie, że dane treści powstały dzięki AI, buduje zaufanie i pomaga zrozumieć, co się ogląda. Jest to szczególnie ważne tam, gdzie treści mogą wpływać na decyzje lub przekonania odbiorców. W branżach regulowanych, takich jak zdrowie, finanse czy prawo, mogą obowiązywać konkretne wymagania dotyczące ujawniania generowania przez AI.

Zagrożenie deepfake’ami i dezinformacją jest realne i wymaga działań prewencyjnych. Zabezpieczenia techniczne, jak znakowanie wytworzonych treści, pomagają je identyfikować. Polityka i regulacje będą się rozwijać, by przeciwdziałać nadużyciom. Edukacja medialna pomoże odbiorcom zrozumieć, jak działa AI i budować krytyczne podejście do autentyczności treści. Firmy powinny wdrażać własne zasady odpowiedzialnego korzystania z generowania wideo AI. Celem powinno być wykorzystanie zalet tej technologii przy jednoczesnym zapobieganiu nadużyciom i utrzymaniu zaufania do mediów i komunikacji.

Sora 2 to punkt zwrotny w rozwoju technologii generowania wideo AI, oferując możliwości dotąd zarezerwowane dla science fiction. Model pozwala tworzyć realistyczne, fizycznie wiarygodne filmy z dokładnym odtwarzaniem postaci, co otwiera nowe perspektywy dla twórców, marketerów, edukatorów i firm ze wszystkich branż. Mimo obecnych ograniczeń w odwzorowaniu ruchów dłoni, fizyce czy powtarzalności wyników, kierunek rozwoju jest jasny. Technologia będzie coraz lepsza, wydajniejsza i bardziej dostępna. Firmy, które poznają możliwości i ograniczenia Sora 2 i zintegrują ją z własnym workflow, zyskają przewagę dzięki niższym kosztom, większej liczbie produkowanych treści oraz możliwości eksperymentowania na

Sora 2 to najnowszy model generowania wideo od OpenAI, który tworzy realistyczne, fizycznie poprawne filmy na podstawie opisów tekstowych. W porównaniu do poprzednich systemów oferuje lepszą symulację fizyki, wyższą jakość obrazu, dłuższe generowanie wideo oraz bardziej zaawansowane narzędzia kreatywne dla użytkowników.

Tak, Sora 2 potrafi z wysoką dokładnością odtworzyć wygląd prawdziwych osób dzięki technologii skanowania twarzy. Użytkownicy zgłaszają, że model osiąga ok. 90% precyzji w odwzorowaniu cech twarzy, mimiki, a nawet elementów tła, jeśli dostarczone są odpowiednie dane referencyjne.

Mimo imponujących możliwości Sora 2 wciąż ma pewne ograniczenia, takie jak sporadyczne morfowanie między kilkoma postaciami, niespójność ruchów dłoni, błędy fizyczne w złożonych scenach oraz zmienną jakość wyników przy wielokrotnym generowaniu tego samego promptu. Synteza głosu w niektórych przypadkach także wymaga dopracowania.

Firmy mogą wykorzystać Sora 2 do tworzenia filmów marketingowych, prezentacji produktów, materiałów szkoleniowych, klipów na media społecznościowe i rozrywki. Technologia ta znacząco skraca czas i koszty produkcji dzięki automatyzacji generowania wideo na podstawie opisów tekstowych, co jest szczególnie wartościowe w marketingu, edukacji i branży rozrywkowej.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Zintegruj generowanie wideo AI z procesem tworzenia treści i usprawnij produkcję od pomysłu po publikację.

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo przez AI: od realistycznego odtwarzania postaci po symulację fizyki i zobacz, jak ta technologia zmienia...

Poznaj wszystko, co musisz wiedzieć o aplikacji Sora-2 — jej możliwości, zastosowania oraz porównanie z czołowymi generatorami wideo AI. Dowiedz się, jak zacząć...

Odkryj, jak Genie 3 generuje w pełni kontrolowane światy 3D z tekstu, rewolucjonizując trening agentów, tworzenie gier i symulację AI. Poznaj technologię, możli...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.