Sora 2: Generowanie Wideo AI dla Twórców Treści

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo AI — od realistycznego odtwarzania postaci po symulację fizyki — i odkryj, jak ta technologia zmienia tw...

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo przez AI: od realistycznego odtwarzania postaci po symulację fizyki i zobacz, jak ta technologia zmienia tworzenie i automatyzację treści.

Sora 2 to znaczący skok naprzód w technologii generowania wideo przez sztuczną inteligencję. Najnowsza wersja modelu AI od OpenAI oferuje niespotykane dotąd możliwości twórcom treści, marketerom i firmom, które chcą usprawnić produkcję wideo. Ten kompleksowy przewodnik omawia wyjątkowe funkcje Sora 2, jej praktyczne zastosowania oraz konsekwencje dla przyszłości tworzenia treści. Od odtwarzania ulubionych postaci fikcyjnych po generowanie realistycznych wystąpień ludzkich – Sora 2 pokazuje przełomowy potencjał generatywnej AI w produkcji obrazu. Niezależnie, czy interesują Cię aspekty techniczne, kreatywne możliwości czy zastosowania biznesowe, ten artykuł szczegółowo omawia, co czyni z Sora 2 technologię zmieniającą zasady gry.

Generowanie wideo przez sztuczną inteligencję to jedna z najbardziej ekscytujących dziedzin technologii generatywnej AI. W przeciwieństwie do tradycyjnej produkcji, wymagającej kamer, aktorów, oświetlenia i długiej postprodukcji, AI generuje filmy bezpośrednio na podstawie opisów tekstowych lub promptów. Technologia ta wykorzystuje modele głębokiego uczenia wytrenowane na ogromnych zbiorach danych wideo, by zrozumieć relację pomiędzy opisami językowymi a treścią wizualną. Modele te uczą się rozpoznawać wzorce w ruchu obiektów, interakcji światła z powierzchniami, gestach i mimice ludzi czy naturalnych przejściach między scenami. Po otrzymaniu promptu tekstowego model AI przetwarza informacje i generuje film klatka po klatce, zachowując spójność wyglądu postaci, ruchu oraz szczegółów otoczenia przez cały czas trwania sekwencji. U podstaw tej technologii leżą modele dyfuzyjne i architektury transformerów, specjalnie dostosowane do generowania wideo, pozwalające na utrzymanie spójności czasowej – czyli tego, by obiekty i postaci poruszały się naturalnie i konsekwentnie między klatkami, zamiast “teleportować się” lub migotać.

Znaczenie generowania wideo przez AI wykracza daleko poza zwykłą nowinkę. Technologia ta rozwiązuje podstawowe problemy produkcji treści: czas, koszt i skalowalność. Tradycyjna produkcja wideo może trwać tygodnie lub miesiące, wymaga zespołów profesjonalistów – reżyserów, operatorów, montażystów, specjalistów od efektów wizualnych. Generowanie wideo przez AI pozwala osiągnąć porównywalne efekty w kilka minut, czyniąc je dostępnym dla małych firm, niezależnych twórców oraz przedsiębiorstw, które dotąd nie mogły sobie pozwolić na profesjonalne produkcje. Demokratyzacja tworzenia wideo przez AI ma ogromne znaczenie dla marketingu, edukacji, rozrywki i komunikacji korporacyjnej. Wraz z rozwojem i upowszechnieniem tych systemów firmy na nowo definiują strategie związane z treściami wizualnymi i procesami produkcyjnymi.

Biznesowy potencjał generowania wideo przez AI jest przekonujący i wielowymiarowy. W dzisiejszym cyfrowym świecie to właśnie treści wideo dominują statystyki zaangażowania na wszystkich platformach. Według danych branżowych, wideo generuje znacznie wyższe wskaźniki zaangażowania niż statyczne obrazy czy tekst, a platformy takie jak TikTok, YouTube i Instagram priorytetowo traktują filmy w swoich algorytmach. Jednak produkcja wysokiej jakości wideo na skalę była dotąd bardzo droga dla większości organizacji. AI rozwiązuje ten problem, pozwalając firmom na tworzenie nieograniczonej liczby wariantów wideo do testów A/B, personalizacji i szybkich iteracji. Zespoły marketingowe mogą generować dziesiątki wersji prezentacji produktu w różnych stylach i formatach bez potrzeby ponownych nagrań. Instytucje edukacyjne mogą na masową skalę tworzyć spersonalizowane materiały dydaktyczne. Działy obsługi klienta generują filmy instruktażowe do nowych procedur w czasie rzeczywistym. Ekonomiczne skutki są ogromne: firmy mogą zmniejszyć koszty produkcji wideo o 70–90% i jednocześnie wielokrotnie zwiększyć wolumen produkcji.

Poza redukcją kosztów, generowanie wideo przez AI umożliwia nowe formy kreatywności i eksperymentowania. Twórcy mogą sprawdzać nawet najbardziej szalone pomysły bez angażowania dużych zasobów. Mogą generować wiele wersji koncepcji, by zobaczyć, która najlepiej trafia w gusta odbiorców. Mogą tworzyć treści w różnych stylach, tonacjach i formatach, dopasowanych do różnych segmentów odbiorców i wymogów platformy. Ta elastyczność zmienia wideo z rzadkiego, starannie planowanego zasobu w obfite, eksperymentalne medium. Ma to fundamentalne znaczenie dla strategii treści. Zamiast planować kilka dużych produkcji kwartalnie, firmy mogą wdrożyć model ciągłego tworzenia, gdzie wideo staje się równie rutynowe jak publikowanie wpisów na blogu. Umożliwia to bardziej elastyczną, spersonalizowaną i angażującą komunikację, lepiej realizującą potrzeby odbiorców i cele biznesowe. Ponadto AI otwiera możliwość tworzenia treści interaktywnych i dynamicznych, które dostosowują się do indywidualnego widza, oferując niespotykane dotąd szanse na zaangażowanie i konwersję.

Sora 2 rozwija wcześniejsze modele generowania wideo, oferując znaczące ulepszenia w wielu aspektach. Najbardziej rzucającą się w oczy zmianą jest wyraźna poprawa jakości wizualnej i realizmu. Filmy generowane przez Sora 2 cechują się lepszym oświetleniem, bardziej naturalną kolorystyką, większą szczegółowością tekstur i przekonującym odtworzeniem właściwości materiałów. Oglądając film z Sora 2, można miejscami odnieść wrażenie profesjonalnie nakręconego materiału. Model świetnie radzi sobie z renderowaniem złożonych scen z wieloma obiektami, utrzymuje spójność oświetlenia w całym kadrze, tworzy realistyczne odbicia i cienie. Ta jakość obrazu jest kluczowa w zastosowaniach, gdzie słabe efekty mogłyby zaszkodzić wiarygodności i postrzeganiu marki.

Symulacja fizyki to kolejny duży krok naprzód w Sora 2. Poprzednie modele często miały problemy ze spójnością fizyczną – obiekty poruszały się nienaturalnie, grawitacja działała niespójnie, zderzenia nie były rejestrowane poprawnie. Sora 2 znacznie lepiej rozumie prawa fizyki i zachowanie obiektów w środowisku. Rzucona piłka leci realistycznym torem, postacie chodzą z naturalnym rozkładem ciężaru i ruchem, a interakcje przy zderzeniach wyglądają przekonująco. To szczególnie ważne tam, gdzie dokładność fizyki jest kluczowa, np. w prezentacjach produktów, materiałach edukacyjnych czy rozrywce, gdzie widz szybko zauważy nienaturalności. Poprawa tych aspektów umożliwia także generowanie bardziej dynamicznych, złożonych scen.

Spójność czasowa i konsekwencja to kluczowe ulepszenia sprawiające, że filmy Sora 2 wyglądają jak prawdziwe nagrania, a nie zlepek niespójnych klatek. Model utrzymuje tożsamość postaci przez cały film – ludzie wyglądają tak samo od początku do końca, nie zmieniając wyglądu ani nie “morfując”. Szczegóły otoczenia pozostają spójne – jeśli na początku w tle stoi roślina, zostaje w tym samym miejscu i wygląda tak samo do końca filmu. Ta konsekwencja jest niezbędna w zastosowaniach profesjonalnych i zapewnia naturalny, immersyjny odbiór. Model lepiej rozumie też ruch i sekwencje akcji, generując płynne, naturalne przemieszczenia zamiast skokowych lub nienaturalnych zmian pozycji.

Jedną z najbardziej imponujących funkcji Sora 2 jest zdolność do wiernego odtwarzania ludzkich twarzy i podobizn dzięki technologii skanowania twarzy. Użytkownicy, którzy wykonują skan, zgłaszają, że model z około 90-procentową dokładnością odwzorowuje rysy twarzy, mimikę oraz subtelne detale jak faktura skóry czy odbicia światła. Ten poziom precyzji jest naprawdę niezwykły i otwiera możliwości dotychczas znane jedynie z science fiction. Oglądając wygenerowany przez Sora 2 film z samym sobą, doświadczasz surrealistycznego efektu – to Ty, ale w sytuacjach, w których nigdy nie byłeś, wykonując czynności, których nigdy nie robiłeś. Model uchwytuje nie tylko statyczne cechy, ale również dynamiczne aspekty ruchu twarzy i ekspresji emocji. Oświetlenie wygląda przekonująco, w oczach pojawiają się refleksy, a detale jak faktura skóry czy ruch włosów są oddane wiarygodnie.

Implikacje tej technologii są zarówno ekscytujące, jak i budzące obawy. Z jednej strony twórcy mogą teraz generować filmy z własnym udziałem bez fizycznej obecności przed kamerą. YouTuber może stworzyć dziesiątki wariantów filmu bez wielokrotnego nagrywania. Nauczyciel przygotuje spersonalizowane materiały z własnym wizerunkiem. Dyrektor firmy nagra szkolenie lub komunikat bez umawiania nagrań. Oszczędność czasu i kosztów jest ogromna. Jednak pojawiają się też pytania o zgodę, autentyczność i potencjalne nadużycia. Teoretycznie technologia może posłużyć do tworzenia deepfake’ów lub wprowadzających w błąd materiałów z udziałem prawdziwych osób bez ich pozwolenia. OpenAI wprowadziło zabezpieczenia pozwalające użytkownikom decydować, czy ich wizerunek może być wykorzystywany przez innych, ale potencjał nadużyć pozostaje wyzwaniem wymagającym regulacji i odpowiedniej polityki.

Sora 2 umożliwia kreatywne zastosowania, które wcześniej były niemożliwe lub zbyt kosztowne. Jednym z najciekawszych przykładów jest odtwarzanie kultowych postaci fikcyjnych w nowych scenariuszach. Użytkownicy wygenerowali filmy z SpongeBobem wykonującym drill rap, z zachowaniem charakterystycznego stylu postaci, animacji i syntezy głosu. Model oddaje unikalny wygląd bohatera i utrzymuje go przez cały film. Podobnie odtworzono legendarne sceny z gier, np. Halo, z oryginalną oprawą graficzną, elementami UI i głosem narratora. Pokazuje to, że Sora 2 rozumie i potrafi odtworzyć konkretne style wizualne, projekty postaci czy konwencje estetyczne.

Możliwości rozrywkowe obejmują także tworzenie całkowicie nowych treści w stylistyce istniejących franczyz. Użytkownicy generowali całe odcinki SpongeBoba, łącząc wiele klipów Sora 2 w spójną narrację z zachowaniem stylu i postaci. Sugeruje to przyszłość, w której AI wspomaga produkcję animacji, generując kluczowe sceny lub warianty do dalszej obróbki przez animatorów. Technologia może zdemokratyzować produkcję animacji, pozwalając niezależnym twórcom tworzyć filmy bez rozbudowanych zespołów. Odwzorowywanie gier to kolejne ciekawe zastosowanie – twórcy umieszczali postaci w środowiskach Minecrafta czy odtwarzali klasyczne gry jak Mario Kart w fotorealistycznym stylu. Wszystko to pokazuje elastyczność modelu i zdolność adaptacji do różnych kontekstów.

Choć Sora 2 to duży krok naprzód, warto znać jej obecne ograniczenia i obszary wymagające dalszego rozwoju. Testy pokazują, że choć odtwarzanie twarzy jest na ogół bardzo dobre, czasami model ma problemy ze spójnością. Przy wielokrotnym generowaniu filmów z tym samym promptem, wyniki potrafią się znacznie różnić – raz twarz jest niemal idealna, innym razem widać drobne morfowania lub niespójności w rysach. Sugeruje to, że jakość wyników nie jest jeszcze w pełni deterministyczna i warto wygenerować kilka wersji, by wybrać najlepszą. Zmienność jest szczególnie widoczna w nietypowych lub złożonych przypadkach.

Dużym ograniczeniem obecnie jest odwzorowanie ruchu i manipulacji dłońmi. Przy filmach wymagających szczegółowego ruchu rąk lub operowania przedmiotami, efekty bywają mało przekonujące. Dłonie mogą być zdeformowane, palce poruszać się nienaturalnie, a obiekty nie są chwytane realistycznie. Szczególnie widać to przy czynnościach wymagających precyzji, np. grze na instrumentach, zabiegach medycznych czy skomplikowanych gestach. Wynika to z faktu, że biomechanika ludzkiej dłoni i palców jest bardzo złożona – poprawa tego aspektu to jedno z głównych wyzwań w rozwoju AI do generowania wideo.

Błędy fizyczne wciąż się pojawiają, szczególnie w złożonych scenach z wieloma obiektami lub siłami. Zdarza się, że samochody jadą do tyłu, przedmioty unoszą się zamiast upaść, a zderzenia nie są zarejestrowane poprawnie. Te błędy zdarzają się rzadziej niż w poprzednich modelach, ale nadal są zauważalne. Najczęściej występują w nietypowych przypadkach lub gdy prompt opisuje bardzo złożone interakcje fizyczne. Synteza głosu również wymaga dopracowania – czasem głosy brzmią sztucznie lub pojawiają się cyfrowe artefakty, a jakość zależy od konkretnego głosu i złożoności wypowiedzi.

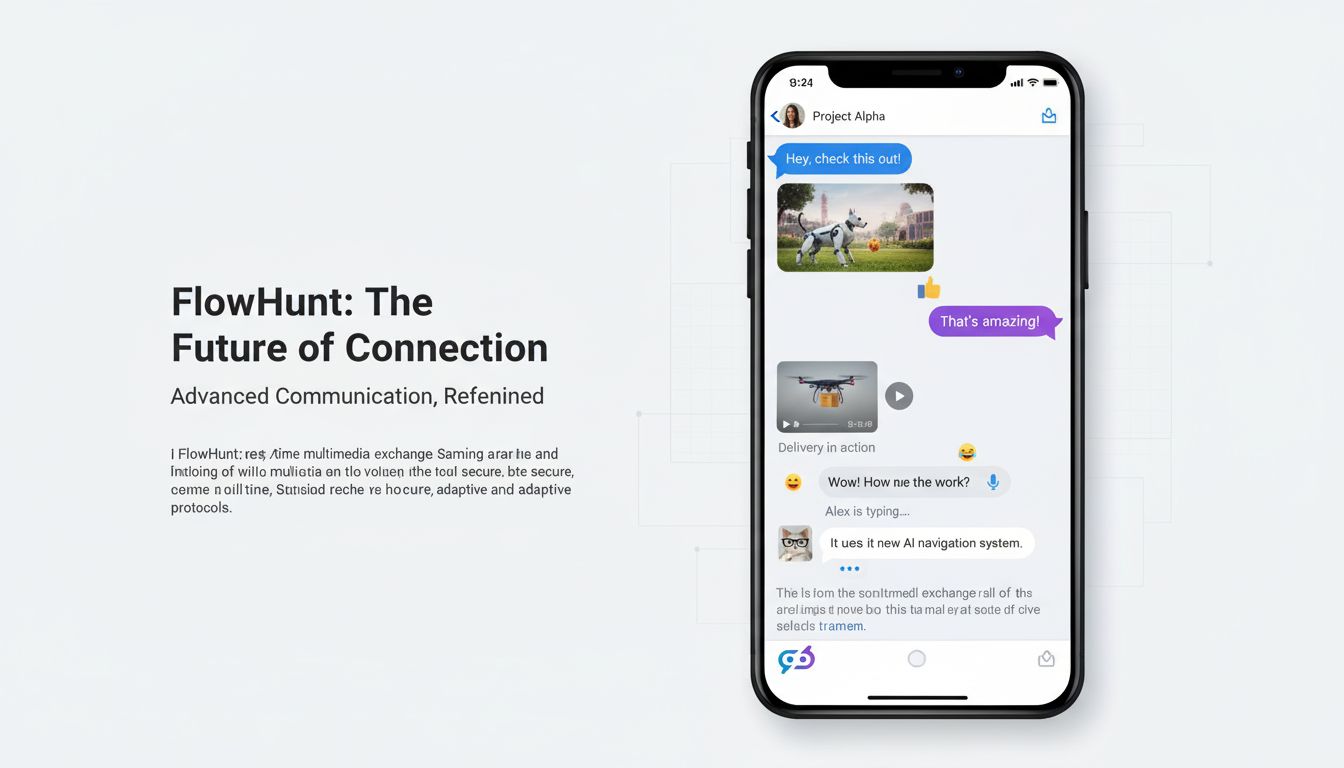

FlowHunt dostrzega przełomowy potencjał generowania wideo przez AI i integruje te możliwości ze swoją platformą automatyzacji, by usprawnić procesy tworzenia treści w firmach. Zamiast traktować generowanie wideo jako osobne narzędzie, FlowHunt postrzega je jako element kompleksowego ekosystemu automatyzacji treści. Pozwala to budować przepływy pracy obejmujące generowanie, edycję, dystrybucję i analizę treści wideo. Przykładowo, zespół marketingowy może stworzyć proces automatycznie generujący filmy produktowe, dodający napisy i branding, publikujący na wielu platformach i śledzący zaangażowanie – bez udziału człowieka.

Integracja Sora 2 i podobnych modeli z platformą FlowHunt umożliwia szereg scenariuszy automatyzacji. Zespoły mogą zaplanować cykliczne zadania generowania nowych filmów. E-commerce automatycznie tworzy filmy produktowe dla nowych produktów. Marketing generuje spersonalizowane warianty filmów dla różnych segmentów odbiorców. Instytucje edukacyjne przygotowują szkolenia na żądanie. Działy obsługi klienta generują filmy instruktażowe do najczęstszych problemów. Połączenie generowania wideo z automatyzacją workflow w FlowHunt pozwala osiągnąć niespotykaną dotąd skalę i efektywność produkcji. Platforma zarządza orkiestracją, harmonogramem i integracjami z innymi systemami, a zespoły mogą skupić się na strategii i aspektach kreatywnych, nie na ręcznej produkcji.

Sora 2 znajduje praktyczne zastosowanie niemal w każdej branży i funkcji biznesowej. W marketingu i reklamie umożliwia masową produkcję filmów produktowych, referencyjnych i promocyjnych. Marki mogą generować wiele wariantów reklam, testując różne przekazy, style wizualne i wezwania do działania. E-commerce tworzy filmy dla tysięcy produktów bez indywidualnych nagrań. Agenci nieruchomości generują wirtualne spacery po nieruchomościach. Biura podróży promują kierunki wyjazdów. Oszczędności kosztów i przyspieszenie produkcji rewolucjonizują działy marketingu, które dotąd zmagały się z wąskimi gardłami wideo.

W edukacji i szkoleniach Sora 2 pozwala tworzyć spersonalizowane materiały dydaktyczne, filmy instruktażowe i szkoleniowe. Uczelnie mogą generować filmy z wykładowcami w różnych scenariuszach, tłumaczącymi zagadnienia na wiele sposobów czy prezentującymi procedury. Firmowe działy HR tworzą filmy onboardingowe, szkolenia BHP i materiały rozwojowe. Możliwość generowania treści na żądanie sprawia, że szkolenia mogą być zawsze aktualne, gdy tylko zmieniają się procedury lub pojawiają nowe wymagania. Możliwa staje się personalizacja na masową skalę – różni uczniowie otrzymują treści dopasowane do ich stylu uczenia, tempa i poziomu wiedzy.

W rozrywce i produkcji medialnej Sora 2 otwiera możliwości animacji, efektów specjalnych i tworzenia treści, które dotąd były ograniczone budżetem i czasem. Niezależni twórcy mogą produkować animacje bez zespołów animatorów. Produkcje filmowe i telewizyjne wykorzystują AI do efektów, tła czy całych scen. Teledyski powstają automatycznie do nowych utworów. Platformy streamingowe produkują własne treści szybciej i taniej. Technologia demokratyzuje produkcję rozrywki, pozwalając nawet małym twórcom osiągać profesjonalną jakość.

W komunikacji korporacyjnej i operacjach wewnętrznych Sora 2 umożliwia generowanie komunikatów zarządu, ogłoszeń, szkoleń i dokumentacji. Dyrektorzy mogą przygotować spersonalizowane wiadomości do zespołu bez organizowania nagrań. HR tworzy materiały szkoleniowe do nowych procedur. IT generuje filmy instruktażowe do systemów informatycznych. Szybkość i niskie koszty sprawiają, że firmy mogą częściej i skuteczniej komunikować się z pracownikami i interesariuszami.

Obecnie generowanie wideo przez AI przypomina “prawny dziki zachód”. Sora 2 może generować filmy z udziałem chronionych postaci, celebrytów i własności intelektualnej bez zgody właścicieli praw. Użytkownicy tworzą filmy ze SpongeBobem, Mario, Zeldą czy innymi zastrzeżonymi bohaterami. Mogą generować filmy z udziałem znanych osób publicznych. To rodzi poważne pytania prawne i etyczne o prawa autorskie, zgodę i dopuszczalne użycie treści generowanych przez AI. Ponieważ technologia tak wiernie odtwarza wizerunki i postacie, ryzyko nadużyć jest duże.

OpenAI wprowadziło pewne zabezpieczenia, np. możliwość decydowania przez użytkownika, czy jego wizerunek może być wykorzystywany przez innych (ustawienia cameo). Jednak te środki są ograniczone i nie rozwiązują szerszego problemu – czy AI powinna generować treści z udziałem postaci lub celebrytów bez pozwolenia. Sytuacja prawna wciąż się kształtuje, a sądy i regulatorzy rozważają kwestie dozwolonego użytku, naruszenia praw autorskich i granic dla treści AI. Niektórzy uważają, że generowanie chronionych postaci na własny użytek mieści się w ramach dozwolonego użytku, inni twierdzą, że każda komercyjna eksploatacja wymaga zgody właściciela praw. Sytuację komplikuje fakt, że różne kraje mają odmienne regulacje prawne i interpretacje dozwolonego użytku.

Kwestie etyczne wykraczają poza prawa autorskie – dotyczą autentyczności, zgody i potencjalnych nadużyć. Widzowie mogą uznać film z udziałem celebryty lub osoby publicznej za autentyczny, jeśli nie zostaną wyraźnie poinformowani, że to AI. Może to prowadzić do dezinformacji i manipulacji. Technologia może posłużyć do deepfake’ów, szkodzenia reputacji lub rozpowszechniania fałszywych informacji. Choć obecne ograniczenia utrudniają tworzenie całkowicie wiarygodnych deepfake’ów konkretnych osób w konkretnych sytuacjach, technologia rozwija się szybko. Społeczeństwo będzie musiało wypracować normy, regulacje i zabezpieczenia techniczne, by zapobiegać nadużyciom przy jednoczesnym wykorzystaniu korzyści płynących z tej technologii.

Postępy Sora 2 w stosunku do poprzednich modeli to efekt rozwoju wielu aspektów technicznych. Model korzysta z ulepszonych architektur opartych na dyfuzji, które lepiej rozumieją relację między opisem tekstowym a treścią wizualną. Proces treningowy wykorzystuje bardziej zróżnicowane i lepszej jakości dane wideo, dzięki czemu model uczy się subtelnych wzorców funkcjonowania świata. Zrozumienie fizyki, oświetlenia i właściwości materiałów poprawiono dzięki bogatszym danym i lepszym funkcjom kosztu, “karzącym” niefizyczne wyniki. Spójność czasowa jest efektem lepszych mechanizmów utrzymania stanu pomiędzy klatkami i udoskonalonych mechanizmów uwagi, pomagających modelowi rozumieć zależności w dłuższych sekwencjach wideo.

Skanowanie twarzy i odtwarzanie postaci opiera się na wyspecjalizowanych komponentach, które kodują cechy twarzy i informacje o tożsamości tak, by zachować je przez cały proces generowania filmu. Prawdopodobnie korzystają z technik podobnych do tych z systemów rozpoznawania twarzy, ale przystosowanych do kontekstu generowania wideo. Model uczy się kojarzyć tożsamość z określonymi wzorcami wizualnymi i zachowuje tę zgodność przez cały proces. Ulepszenia syntezy głosu wynikają z lepszych modeli tekst-na-mowę i lepszej integracji generowania audio i wideo, dzięki czemu dźwięk lepiej pasuje do ruchu ust i mimiki postaci.

Choć Sora 2 to przełom, warto wiedzieć, jak wypada w porównaniu z innymi modelami dostępnymi na rynku. Inne systemy, jak Runway, Synthesia czy różne projekty open-source, mają swoje mocne i słabe strony. Runway skupia się na dostępności dla twórców i budowaniu społeczności wokół platformy. Synthesia specjalizuje się w generowaniu wideo z awatarami na potrzeby komunikacji biznesowej. Open-source’owy Stable Video Diffusion daje programistom dużą elastyczność i możliwość personalizacji. Sora 2 wyróżnia się jakością obrazu, lepszą symulacją fizyki i dokładniejszym odtwarzaniem postaci. Model radzi sobie z dłuższymi filmami i bardziej skomplikowanymi scenami, co daje przewagę w wielu zastosowaniach.

Sora 2 ma też pewne ograniczenia w porównaniu do alternatyw. Niektóre modele oferują szybsze generowanie lub niższe wymagania sprzętowe. Inne pozwalają na bardziej szczegółową kontrolę poszczególnych aspektów filmu. Są też takie, które lepiej integrują się z określonymi platformami i workflow. Wybór modelu zależy od konkretnych wymagań, zastosowań i ograniczeń. Tam, gdzie liczy się maksymalna jakość i realizm – Sora 2 będzie najlepszym wyborem. Przy potrzebie generowania w czasie rzeczywistym lub bardzo określonej personalizacji – mogą się sprawdzić inne rozwiązania. Wraz z rozwojem branży można spodziewać się dalszych postępów i pojawienia się wyspecjalizowanych modeli do różnych zastosowań.

Przekonaj się, jak FlowHunt automatyzuje generowanie treści i wideo AI — od researchu i produkcji treści po publikację i analitykę — wszystko w jednym miejscu.

Trajektoria rozwoju AI do generowania wideo sugeruje, że jesteśmy dopiero na początku drogi. Przyszłe wersje Sora i konkurencyjnych modeli prawdopodobnie wyeliminują obecne ograniczenia dotyczące ruchu dłoni, symulacji fizyki i spójności. Można spodziewać się wydłużenia filmów, wyższej rozdzielczości i obsługi coraz bardziej złożonych scen. Modele będą coraz wydajniejsze i mniej zasobożerne. Integracja z innymi systemami AI umożliwi jeszcze bardziej zaawansowane przepływy pracy, łączące generowanie wideo z innymi formami treści i analizą.

Konsekwencje dla świata tworzenia treści są ogromne. Wraz z upowszechnieniem i rozwojem AI, wideo stanie się równie powszechne jak tekst w komunikacji cyfrowej. Firmy zaczną traktować wideo nie jako rzadki, starannie planowany zasób, ale jako obfite, eksperymentalne medium. Umożliwi to szybszą, bardziej spersonalizowaną i angażującą komunikację. Jednak pojawią się też wyzwania: autentyczność, dezinformacja, konieczność nowych norm i regulacji dla treści AI. Technologia zrewolucjonizuje branże kreatywne, wypierając niektóre role, ale też tworząc nowe możliwości dla tych, którzy potrafią efektywnie zarządzać i kuratorować AI.

Firmy chcące efektywnie wykorzystać Sora 2 powinny stosować się do kilku zasad. Po pierwsze, warto znać mocne i słabe strony modelu – Sora 2 świetnie radzi sobie z realistycznymi scenami, oświetleniem i fizyką, ale gorzej z precyzyjnymi ruchami dłoni i czasem jest niespójna. Projektuj prompt tak, by wykorzystywał mocne strony modelu. Po drugie, generuj kilka wariantów tego samego promptu i wybieraj najlepszy – wyniki się różnią, więc warto nie poprzestawać na pierwszym wygenerowanym filmie. Po trzecie, do odtwarzania postaci używaj skanowania twarzy, gdy zależy Ci na dokładności – ta funkcja znacznie poprawia efekty w porównaniu do opisów tekstowych.

Po czwarte, dziel złożone filmy na kilka klipów i łącz je później, zamiast próbować generować całość na raz – daje to większą kontrolę i lepsze efekty. Po piąte, twórz szczegółowe, konkretne prompty, opisując nie tylko akcję, ale także styl wizualny, oświetlenie czy nastrój – ogólne opisy dają przeciętne wyniki, zaś szczegółowe (np. kąty kamery, preferencje estetyczne) wyraźnie poprawiają jakość. Po szóste, integruj generowanie wideo z szerszymi workflow np. w FlowHunt, by zautomatyzować cały proces od produkcji po publikację i analitykę – to pozwala skalować produkcję jak nigdy dotąd.

Wraz z upowszechnieniem generowania wideo przez AI, rosną obawy o autentyczność, dezinformację i zmiany na rynku pracy – są one uzasadnione i wymagają poważnej refleksji. Firmy korzystające z AI powinny być transparentne co do jej użycia, zwłaszcza tam, gdzie widz mógłby uznać treść za autentyczną. Informowanie, że film został wygenerowany przez AI, buduje zaufanie i pomaga odbiorcom właściwie interpretować przekaz. Jest to szczególnie waż

Sora 2 to najnowszy model generowania wideo AI firmy OpenAI, który tworzy realistyczne, fizycznie poprawne filmy na podstawie opisów tekstowych. W porównaniu do poprzednich systemów oferuje lepszą symulację fizyki, wyższą jakość obrazu, dłuższe generowane filmy oraz bardziej zaawansowane opcje kreatywnej kontroli dla użytkowników.

Tak, Sora 2 potrafi z dużą precyzją odtworzyć wygląd prawdziwych osób dzięki technologii skanowania twarzy. Użytkownicy zgłaszają, że model osiąga około 90% zgodności w odwzorowywaniu rysów twarzy, mimiki, a nawet elementów tła, jeśli dostarczone zostaną odpowiednie dane referencyjne.

Pomimo imponujących możliwości Sora 2 wciąż ma pewne ograniczenia, m.in. okazjonalne morfowanie pomiędzy wieloma postaciami, niespójność w odwzorowaniu dłoni, błędy fizyczne w złożonych scenach oraz zmienną jakość wyników przy wielokrotnym generowaniu tego samego promptu. Synteza głosu również w niektórych przypadkach wymaga dopracowania.

Firmy mogą wykorzystać Sora 2 do tworzenia filmów marketingowych, prezentacji produktów, materiałów szkoleniowych, klipów do mediów społecznościowych i rozrywki. Technologia ta znacząco skraca czas produkcji i obniża jej koszty poprzez automatyzację generowania wideo na podstawie opisów tekstowych, co czyni ją wartościową dla branż marketingu, edukacji i rozrywki.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Zintegruj generowanie wideo przez AI z przepływem pracy nad treściami i usprawnij produkcję od pomysłu po publikację.

Poznaj przełomowe możliwości Sora 2 w generowaniu wideo AI — od realistycznego odtwarzania postaci po symulację fizyki — i odkryj, jak ta technologia zmienia tw...

Poznaj wszystko, co musisz wiedzieć o aplikacji Sora-2 — jej możliwości, zastosowania oraz porównanie z czołowymi generatorami wideo AI. Dowiedz się, jak zacząć...

Odkryj, jak Genie 3 generuje w pełni kontrolowane światy 3D z tekstu, rewolucjonizując trening agentów, tworzenie gier i symulację AI. Poznaj technologię, możli...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.