Wprowadzenie

Sfera sztucznej inteligencji przeżywa bezprecedensowe przyspieszenie – przełomowe technologie pojawiają się równocześnie w wielu dziedzinach. Od ubieralnych okularów AI rozszerzających ludzką percepcję, przez modele rozumowania przewyższające ludzi w rozwiązywaniu złożonych problemów, po generowanie światów 3D i infrastrukturę umożliwiającą agentom autonomicznym współpracę i wymianę usług. To wszystko fundamentalnie zmienia sposób, w jaki pracujemy z technologią i automatyzujemy procesy. W tym kompleksowym opracowaniu omawiamy najważniejsze osiągnięcia AI roku 2025, w tym zaawansowane okulary Ray-Ban od Meta, nadludzkie możliwości rozumowania OpenAI, rewolucyjną technologię generowania światów 3D i rozwijającą się infrastrukturę umożliwiającą agentom autonomicznym współpracę i transakcje. Zrozumienie tych zmian jest kluczowe dla firm i osób chcących wykorzystać transformacyjny potencjał AI w swojej działalności i planowaniu strategicznym.

Aktualny stan sprzętu AI i urządzeń ubieralnych

Ewolucja AI była historycznie ograniczana przez interfejsy, za pomocą których ludzie komunikują się z inteligentnymi systemami. Przez dekady korzystaliśmy z klawiatur, myszy i ekranów, co tworzyło zasadniczą barierę między naturalną percepcją a cyfrowymi narzędziami. Pojawienie się ubieralnej AI to zmiana paradygmatu – komputeryzacja przechodzi z urządzeń stacjonarnych do form, które naturalnie integrują się z codziennym życiem. Inwestycja Meta w okulary Ray-Ban to przykład tej transformacji, oparty na dekadach badań nad rzeczywistością rozszerzoną i doświadczeniu firmy z platformą Oculus. Skala tej zmiany jest olbrzymia – około jedna trzecia światowej populacji nosi okulary na co dzień, co stanowi ogromny potencjał rynku dla okularów wzbogaconych o AI. Dzięki bezpośredniemu wbudowaniu AI w urządzenie, które ludzie już noszą, Meta staje na przecięciu komputerów osobistych i sztucznej inteligencji, tworząc platformę, na której AI może w czasie rzeczywistym obserwować, rozumieć i współdziałać ze światem razem z użytkownikiem.

Gotowy na rozwój swojej firmy?

Rozpocznij bezpłatny okres próbny już dziś i zobacz rezultaty w ciągu kilku dni.

Dlaczego ubieralne AI jest kluczowe dla przyszłości pracy i interakcji

Znaczenie urządzeń ubieralnych z AI wykracza daleko poza wygodę konsumencką, dotykając fundamentalnych aspektów pracy, nauki i komunikacji. Kiedy system AI widzi to, co Ty, słyszy to, co Ty, i wyświetla informacje bezpośrednio w Twoim polu widzenia, zmienia się fundamentalnie natura interakcji człowiek-komputer. Zamiast przerywać uwagę, by sprawdzić urządzenie, informacje pojawiają się naturalnie przed oczami. Zamiast pisać zapytania, wystarczy mówić do asystenta AI, nie tracąc kontaktu z otoczeniem. Dla zastosowań profesjonalnych to ogromny skok produktywności – wyobraź sobie technika w okularach AI, które rozpoznają sprzęt, podpowiadają procedury i prowadzą naprawę w czasie rzeczywistym albo chirurga, któremu AI na bieżąco dostarcza anatomicznych wskazówek podczas operacji. Ulepszona bateria w najnowszych okularach Ray-Ban (o 42% większa pojemność, do 5 godzin ciągłego działania) eliminuje jedną z głównych barier wdrożenia. Wraz ze wzrostem praktyczności i możliwości te urządzenia mogą stać się równie powszechne jak smartfony, zmieniając sposób, w jaki korzystamy z informacji i współpracujemy z AI na co dzień.

Przełom w rozumowaniu AI: Nadludzka wydajność na ICPC

Jednym z najważniejszych osiągnięć AI w 2025 roku jest uzyskanie przez systemy AI nadludzkich wyników w złożonych zadaniach rozumowania. Finał International Collegiate Programming Contest (ICPC) to szczyt programistycznych zmagań, gdzie najlepsze zespoły uczelniane świata rozwiązują niezwykle trudne zadania algorytmiczne pod presją czasu. Te wyzwania wymagają nie tylko wiedzy programistycznej, ale głębokiego myślenia matematycznego, kreatywności oraz opanowania przypadków brzegowych i złożonych ograniczeń. System rozumowania OpenAI uzyskał perfekcyjny wynik 12 na 12 w ICPC 2025, przewyższając wszystkich ludzkich uczestników. Co ważne, system otrzymywał zadania dokładnie w tym samym formacie PDF co ludzie, miał identyczny pięciogodzinny limit czasu i nie korzystał ze specjalnych narzędzi testowych ani optymalizacji konkursowych. W jedenastu z dwunastu przypadków już pierwsza odpowiedź była poprawna – co dowodzi nie tylko umiejętności rozwiązywania, ale i pewności oraz weryfikacji rozwiązań. Najtrudniejsze zadanie wymagało dziewięciu prób, nadal przewyższając najlepszy zespół ludzki, który rozwiązał jedenaście zadań.

Podejście techniczne opierało się na zespole modeli rozumowania (w tym GPT-5 i eksperymentalnym modelu rozumowania), które wspólnie generowały i oceniały rozwiązania. To zasadnicza zmiana w podejściu AI do trudnych problemów – zamiast rozwiązywać wszystko w jednym przebiegu, systemy te stosują iteracyjne ulepszanie, adaptację w trakcie testów i metody zespołowe, by stopniowo poprawiać rozwiązania. Konsekwencje są ogromne: jeśli AI potrafi już pokonać najlepszych ludzi w rozwiązywaniu nowych, złożonych problemów algorytmicznych, oznacza to, że wiele zadań wymagających dotąd ludzkiej ekspertyzy może być zautomatyzowanych lub wspieranych przez AI. Sukces został potwierdzony przez ekspertów branżowych, w tym Scotta Woo, CEO Cognition i mistrza konkursów matematycznych, który podkreślił skalę trudności tego osiągnięcia. Mark Chen, Chief Research Officer w OpenAI, zwrócił uwagę, że kluczowe zdolności modeli są już wystarczające – teraz pozostaje budowa odpowiedniej infrastruktury i „rusztowania”, by te możliwości skutecznie wdrażać.

Dołącz do naszego newslettera

Otrzymuj najnowsze wskazówki, trendy i oferty za darmo.

Choć rozumowanie to jeden z kierunków rozwoju AI, praktyczne wdrożenie systemów AI wymaga solidnej infrastruktury do zarządzania informacją i kontekstem. Retrieval Augmented Generation (RAG) stał się kluczową technologią umożliwiającą systemom AI dostęp do zewnętrznych źródeł wiedzy – dokumentów firmowych, publikacji czy baz danych. Tradycyjne systemy RAG napotykają poważny problem: im więcej informacji można pobrać, tym większy koszt obliczeniowy wyszukiwania i przetwarzania. Super Intelligence Labs od Meta rozwiązało ten problem dzięki ReRAG, innowacji zwiększającej szybkość RAG 30-krotnie i pozwalającej obsługiwać 16x większe konteksty bez utraty precyzji. Mechanizm polega na zastępowaniu większości pobieranych tokenów wstępnie wyliczonymi i wielokrotnego użytku osadzeniami fragmentów tekstu. Zamiast analizować surowy tekst przy każdym zapytaniu, system korzysta z przygotowanych wcześniej wektorów oddających sens fragmentów, co pozwala na szybsze wyszukiwanie i efektywne wykorzystanie okna kontekstu modelu.

Ta optymalizacja ma natychmiastowe znaczenie dla wdrożeń AI w firmach. Przedsiębiorstwa mogą zapewnić swoim systemom AI dostęp do ogromnych baz wiedzy bez proporcjonalnego wzrostu kosztów obliczeniowych czy opóźnień. AI w obsłudze klienta może mieć dostęp do milionów stron dokumentacji i odpowiadać w milisekundy. Asystent naukowy może przeszukiwać całe biblioteki publikacji bez narzutu obliczeniowego, który wcześniej uniemożliwiałby takie zadania. Zysk 30x na szybkości sprawia, że RAG staje się praktycznym domyślnym rozwiązaniem dla każdego systemu AI wymagającego zewnętrznej wiedzy. W połączeniu z większymi oknami kontekstu, ReRAG pozwala AI zachować spójność w analizie długich dokumentów i złożonych struktur informacji – kluczowe dla analizy prawnej, syntezy badań naukowych czy zaawansowanej analityki biznesowej.

FlowHunt i orkiestracja przepływów pracy AI

Konwergencja zaawansowanych możliwości AI – modeli rozumowania, systemów wyszukiwania informacji i agentów autonomicznych – stwarza dla organizacji zarówno szanse, jak i wyzwania. Prawdziwa wartość pojawia się nie z pojedynczych możliwości, lecz z ich połączenia w spójne przepływy rozwiązywania realnych problemów biznesowych. FlowHunt odpowiada na tę potrzebę, oferując platformę do budowania i zarządzania złożonymi przepływami automatyzacji AI, które łączą narzędzia, źródła danych i modele AI w jeden proces. Przykład: zamiana newsów w sformatowane treści na media społecznościowe. Pozornie proste zadanie wymaga orkiestracji wielu możliwości AI i narzędzi zewnętrznych. Przepływ zaczyna się od pobrania URL artykułu i utworzenia rekordów w systemach zarządzania projektami, automatycznie uruchamiając równoległe ścieżki dla różnych platform społecznościowych. Dla każdej z nich AI generuje nagłówki, pobiera dodatkowe materiały przez web scraping, tworzy grafiki z tekstem i publikuje treści w narzędziach do planowania postów. Każdy etap łączy inne narzędzia i modele AI, a wyjście z jednego kroku stanowi wejście dla następnego.

Taka orkiestracja staje się niezbędna w miarę rozwoju możliwości AI. Zamiast budować integracje od zera dla każdej kombinacji narzędzi i modeli, platformy takie jak FlowHunt dają infrastrukturę do szybkiego projektowania i wdrażania przepływów pracy. Integracja z ponad 8000 narzędzi sprawia, że praktycznie każdy proces biznesowy można zautomatyzować przez połączenie istniejących narzędzi z AI. To demokratyzuje automatyzację AI, umożliwiając organizacjom bez własnych zespołów inżynierii AI budowę zaawansowanych workflowów. Wraz ze wzrostem autonomii agentów AI kluczowe staje się zarządzanie ich działaniami, interakcjami z innymi systemami i zapewnianie zgodności wyników z wymaganiami biznesu. Połączenie wizualnych kreatorów workflowów i orkiestracji AI czyni FlowHunt istotną warstwą infrastruktury rodzącej się gospodarki AI.

Powstawanie infrastruktury dla autonomicznych agentów

Poza pojedynczymi możliwościami AI, rok 2025 przynosi pojawienie się infrastruktury zaprojektowanej specjalnie dla umożliwienia agentom autonomicznym współdziałania między sobą i z systemami zewnętrznymi. Ogłoszenie przez Google protokołu Agent Payment Protocol (AP2) to ważny krok w tym kierunku. Bazując na wcześniejszym protokole Agent-to-Agent dla komunikacji agentów, AP2 rozszerza go o możliwość transakcji finansowych. Protokół zapewnia wspólny język dla bezpiecznych i zgodnych transakcji między agentami a sprzedawcami, otwierając nową klasę autonomicznej aktywności gospodarczej. Wyobraź sobie agenta AI zarządzającego Twoją firmą, który samodzielnie kupuje usługi, negocjuje kontrakty i zarządza relacjami z dostawcami bez udziału człowieka. Albo optymalizację łańcucha dostaw, gdzie agenci różnych firm mogą negocjować ceny, stany magazynowe i dostawy w czasie rzeczywistym.

Protokół już przyciągnął kluczowych partnerów technologicznych i biznesowych, jak Adobe, Accenture, OnePassword, Intuit, Red Hat, Salesforce czy Okta. Tak szerokie wsparcie branży wskazuje, że transakcje agentów nie są odległą wizją, lecz kształtującą się rzeczywistością, do której firmy właśnie się przygotowują. Konsekwencje wykraczają poza proste transakcje – AP2 umożliwia powstawanie sieci agentów, gdzie autonomiczne systemy mogą współpracować, konkurować i koordynować działania w celu realizacji złożonych celów. Agent AI w fabryce może automatycznie zamawiać surowce od agentów dostawców, koordynować dostawy z agentami logistycznymi i rozliczać płatności przez protokół – wszystko bez udziału ludzi. To przesuwa model biznesowy z ręcznego zarządzania do ekosystemów koordynowanych przez agentów AI, operujących coraz bardziej autonomicznie w określonych ramach.

Zaawansowane rozumowanie AI i konkurencja z ludźmi

Osiągnięcie nadludzkich wyników w programowaniu konkursowym wpisuje się w szerszy trend, w którym AI dorównuje lub przewyższa ludzi w coraz bardziej złożonych dziedzinach. Sukces na ICPC opiera się na wcześniejszych osiągnięciach, takich jak szóste miejsce na Międzynarodowej Olimpiadzie Informatycznej (IOI), złoto na Międzynarodowej Olimpiadzie Matematycznej (IMO) i drugie miejsce w AtCoder Heuristic Contest. Ta progresja pokazuje, że zdolności rozumowania AI nie ograniczają się do wąskich specjalizacji, ale generalizują na różne typy problemów. Konsekwencje dla pracy umysłowej są ogromne – jeśli AI rozwiązuje nowe zadania programistyczne wymagające głębokiej wiedzy algorytmicznej, może też wspierać lub automatyzować wiele innych zadań opartych na podobnych schematach rozumowania.

Należy jednak umieścić te osiągnięcia w szerszym kontekście rozwoju AI. Jak zauważył Mark Chen, kluczowa „inteligencja” tych modeli już wystarcza do wielu zadań – teraz najważniejsze jest budowanie infrastruktury i procesów organizacyjnych, które pozwolą bezpiecznie i skutecznie wdrażać te możliwości w realnych strukturach biznesowych i społecznych. Następna faza rozwoju AI będzie prawdopodobnie koncentrować się nie na poprawie surowych możliwości, lecz na praktycznym wdrażaniu, integracji oraz orkiestracji istniejących już rozwiązań.

Inteligencja przestrzenna i generowanie światów 3D

Podczas gdy rozumowanie i infrastruktura agentowa wyznaczają jeden kierunek rozwoju AI, inteligencja przestrzenna stanowi kolejny. World Labs, założone przez Fei-Fei Li, tworzy Large World Models (LWM) generujące i rozumiejące trójwymiarowe środowiska. Technologia World Labs potrafi, na podstawie pojedynczego obrazu, wygenerować interaktywny świat 3D, który użytkownik może swobodnie eksplorować. To fundamentalny przełom w rozumieniu i reprezentacji przestrzeni przez AI – zamiast traktować obrazy jako statyczne dane 2D, systemy budują spójne modele 3D, zachowując konsekwencję podczas poruszania się po wirtualnej przestrzeni. Generowane światy mają szczegółowe elementy środowiska, realistyczne oświetlenie, cienie i fizykę, tworząc immersyjne doświadczenie.

Zastosowania tej technologii wykraczają daleko poza rozrywkę czy wizualizacje. W architekturze i urbanistyce projektanci mogą generować pełne środowiska 3D z koncepcji, umożliwiając ocenę projektów przed budową. W edukacji uczniowie mogą eksplorować historyczne miejsca, środowiska naukowe czy złożone systemy w immersyjnej przestrzeni 3D. W szkoleniach i symulacjach można generować realistyczne środowiska treningowe bez kosztów i ograniczeń fizycznych obiektów. Technologia ta ma także duże znaczenie dla robotyki – jeśli AI potrafi generować spójne modele 3D, może efektywniej planować ruch i rozumieć relacje przestrzenne. Wraz z dojrzewaniem tej technologii stanie się ona zapewne standardowym narzędziem wizualizacji, projektowania i symulacji w wielu branżach.

Otwartoźródłowi agenci AI i benchmarking

Rywalizacja o zaawansowanie możliwości AI nabiera tempa – wiele organizacji rozwija modele rozumowania i systemy agentowe. Tongyi DeepResearch od Alibaba to znaczący wkład open source, osiągający stan sztuki na wielu benchmarkach przy zaledwie 30 miliardach parametrów, z których podczas wnioskowania aktywowanych jest tylko 3 miliardy. Ta efektywność jest imponująca – system dorównuje większym modelom zamkniętym, wykorzystując ułamek zasobów. Uzyskuje 32,9 punktu na Humanity’s Last Exam, 45,3 na BrowseComp oraz 75 na XBench Deep Research, pokazując bardzo dobre wyniki w różnych zadaniach rozumowania i wyszukiwania.

Otwartoźródłowy charakter Tongyi DeepResearch jest szczególnie ważny – demokratyzuje dostęp do zaawansowanej AI. Zamiast ograniczać się do organizacji dysponujących zasobami na trenowanie gigantycznych modeli, naukowcy i deweloperzy mogą korzystać z najnowszych osiągnięć. Fundamentem technicznym Tongyi DeepResearch jest automatyczna, wieloetapowa strategia generowania ogromnych ilości wysokiej jakości danych treningowych agentowych bez kosztownej ręcznej anotacji. To odpowiedź na jedno z głównych wyzwań rozwoju AI – potrzebę znacznych ilości precyzyjnych danych. Automatyzacja procesu generowania danych dowodzi, że można osiągać szczytowe wyniki bez ogromnych nakładów na ręczną anotację.

Inwestycje w infrastrukturę AI i skalowanie

Szybki postęp AI napędza ogromne inwestycje w infrastrukturę, zwłaszcza w centra danych i wyspecjalizowany sprzęt. GRQ, producent chipów AI, pozyskał 750 milionów dolarów przy wycenie 6,9 miliarda dolarów, z planami rozbudowy centrów danych, w tym w regionie Azji i Pacyfiku. Ta runda finansowania, prowadzona przez Disruptive i z udziałem m.in. BlackRock oraz Neuberger Berman, odzwierciedla rosnącą konkurencję o moc obliczeniową i świadomość, że infrastruktura AI będzie wąskim gardłem w najbliższych latach. Olbrzymi popyt na moc do wnioskowania – zasoby niezbędne do działania wytrenowanych modeli AI – sprawia, że firmy takie jak Nvidia, GRQ i Cerebras maksymalnie przyspieszają produkcję.

Te inwestycje są kluczowe dla realizacji potencjału zaawansowanych modeli AI. Modele rozumowania, duże modele językowe i agenci autonomiczni wymagają potężnych zasobów obliczeniowych. Wraz z rosnącym wdrożeniem tych systemów popyt na moc będzie tylko rósł. Inwestycje te nie są spekulacją – odzwierciedlają fakt, że firmy już wdrażają AI na skalę produkcyjną i potrzebują niezawodnej, skalowalnej infrastruktury. Ekspansja na Azję i Pacyfik potwierdza globalny charakter wdrożeń AI i konieczność dystrybucji zasobów dla zapewnienia niskich opóźnień i zgodności z lokalnymi regulacjami.

Nowe trendy w rozwoju modeli AI

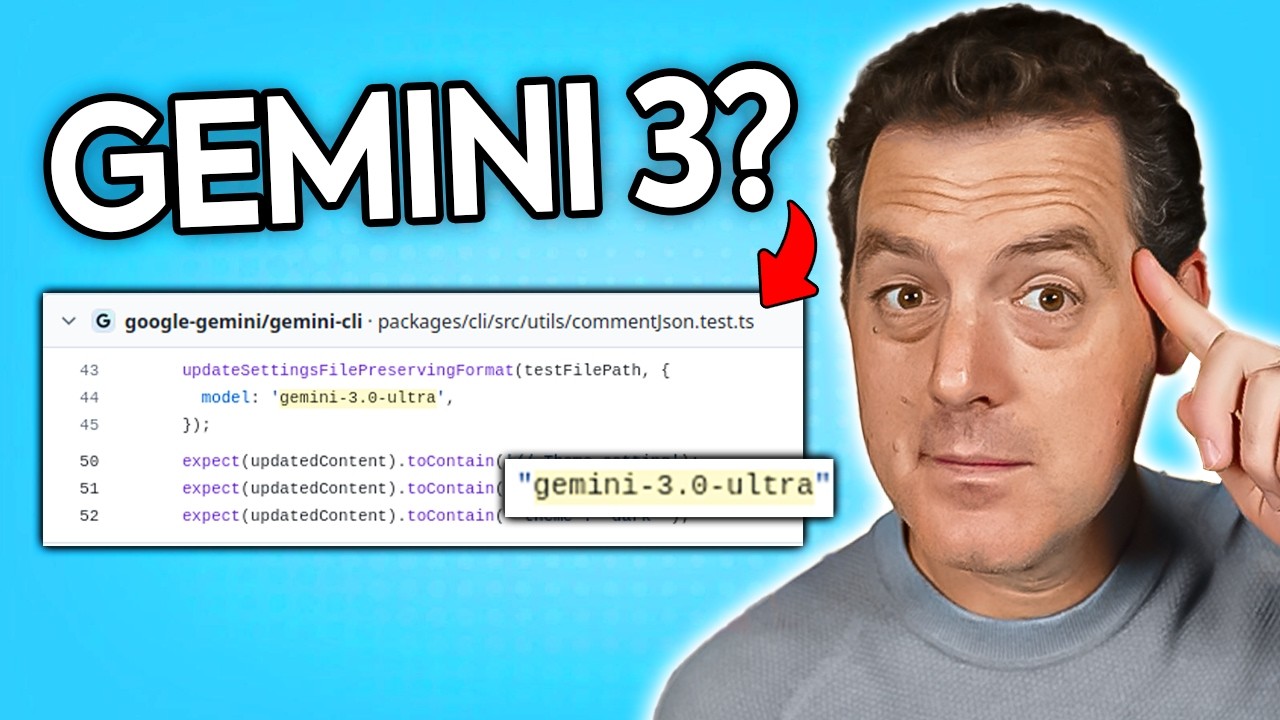

Rynek modeli AI ewoluuje bardzo szybko – różne organizacje wybierają odmienne ścieżki rozwoju. Pogłoski o Gemini 3.0 Ultra, odkryte w repozytorium Gemini CLI Google, sugerują, że firma przygotowuje się do wydania nowej generacji flagowego modelu rozumowania. Odnalezienie odwołań do Gemini 3.0 Ultra w kodzie tuż przed ujawnieniem wiadomości wskazuje, że premiery nowych modeli są poprzedzane przygotowaniami infrastrukturalnymi. Sposób wersjonowania i cyklów wydawniczych pokazuje, że możemy spodziewać się regularnych aktualizacji i usprawnień, z każdą generacją przynoszącą kolejne przyrosty możliwości.

Zapowiedź Elona Muska o rozpoczęciu treningu Grok 5 w ciągu kilku tygodni pokazuje, że xAI również rozwija swoje modele rozumowania. Pytanie, co oznacza przeskok wersji modelu – czy to nowa faza treningu, istotne zmiany architektury, czy przekroczenie konkretnego progu możliwości – pozostaje otwarte, ale trend jest jasny: wiele firm inwestuje w rozwój zaawansowanych modeli rozumowania i możemy spodziewać się regularnych premier coraz lepszych wersji. Ta konkurencja napędza innowacje i gwarantuje, że żadna firma nie zdobędzie monopolu na najbardziej zaawansowane AI.

Autonomiczne pojazdy i wdrożenia AI w świecie rzeczywistym

Choć wiele uwagi poświęca się modelom rozumowania i infrastrukturze agentowej, rzeczywiste wdrożenia AI szybko postępują w dziedzinach takich jak pojazdy autonomiczne. Zgoda na pilotaż Waymo na lotnisku w San Francisco to ważny krok w komercjalizacji autonomicznych pojazdów. Stopniowe wdrożenie, zaczynając od obsługi lotniska i rozszerzając usługę na kolejne obszary, odzwierciedla ostrożne podejście niezbędne przy wdrażaniu AI w środowiskach krytycznych dla bezpieczeństwa. Konkurencja ze strony innych firm, jak Zoox (własność Amazona), pokazuje, że wiele organizacji osiąga znaczne postępy.

Wdrożenie autonomicznych pojazdów na dużych węzłach transportowych, jak SFO, jest istotne, bo oznacza przejście od testów do rzeczywistej obsługi klientów. Lotnisko stanowi wprawdzie środowisko częściowo kontrolowane, ale nadal pełne wyzwań: zmienna pogoda, złożony ruch i konieczność interakcji z kierowcami i pieszymi. Udane wdrożenie pokazuje, że technologia autonomicznych pojazdów dojrzała do pracy w realnych warunkach. Z czasem, wraz z gromadzeniem doświadczenia operacyjnego, systemy te będą się doskonalić, umożliwiając szersze wdrożenia w coraz trudniejszych środowiskach.

Integracja możliwości AI z procesami biznesowymi

Konwergencja zaawansowanych możliwości AI, infrastruktury agentowej i platform automatyzacji umożliwia firmom integrację AI z kluczowymi procesami biznesowymi na niespotykaną dotąd skalę. Praktyczny przykład konwersji newsów w treści na media społecznościowe, choć pozornie prosty, pokazuje złożoność rzeczywistej automatyzacji AI. Przepływ wymaga koordynacji wielu modeli AI (generowanie nagłówków, tworzenie grafik), narzędzi zewnętrznych (web scraping, planowanie publikacji) i logiki biznesowej (formatowanie pod platformy, harmonogramy). Wdrożenie takich workflowów wymaga nie tylko pojedynczych możliwości AI, ale również platform orkiestrujących współpracę różnych komponentów.

Podejście FlowHunt – wizualne kreatory przepływów i orkiestracja AI – odpowiada na te potrzeby. Abstrahując techniczną złożoność integracji narzędzi i modeli, platformy te umożliwiają tworzenie zaawansowanych automatyzacji użytkownikom biznesowym, bez potrzeby specjalistycznej wiedzy inżynieryjnej AI. Wraz ze wzrostem możliwości AI, kluczowa staje się umiejętność łączenia tych zasobów w spójne procesy biznesowe. Firmy, które skutecznie zintegrują AI z workflowami, zyskają znaczną przewagę – większą efektywność, niższe koszty i szybsze wdrożenia nowych usług i produktów.

Przyszłość automatyzacji napędzanej przez AI

Wszystkie opisane tu zjawiska wskazują na przyszłość, w której AI jest głęboko zintegrowane z procesami biznesowymi i codziennym życiem. AI nie będzie już narzędziem do wybranych zadań, lecz domyślnym sposobem automatyzacji i optymalizacji pracy. Autonomiczni agenci będą koordynować złożone procesy, AI z zaawansowanym rozumowaniem rozwiąże nowe problemy i podejmie decyzje strategiczne, a ubieralna AI zapewni wsparcie w czasie rzeczywistym. Inteligencja przestrzenna umożliwi nowe formy wizualizacji i symulacji. To nie jest wizja odległej przyszłości – technologie ją umożliwiające są już wdrażane i doskonalone.

W tym kontekście rola platform takich jak FlowHunt staje się coraz ważniejsza. W miarę wzrostu dostępności i możliwości AI, kluczowa staje się umiejętność orkiestracji tych narzędzi w spójne workflowy. Firmy, które skutecznie zintegrują AI ze swoimi procesami, będą najlepiej przygotowane do rywalizacji w coraz bardziej AI-napędzanej gospodarce. Inwestycje infrastrukturalne GRQ, otwarte rozwiązania Alibaba czy komercyjne platformy FlowHunt sprawiają, że zaawansowane możliwości AI stają się coraz bardziej dostępne i praktyczne w zastosowaniach biznesowych.

Podsumowanie

Krajobraz AI w 2025 roku to szybki postęp na wielu płaszczyznach – od sprzętu ubieralnego, który rozszerza ludzką percepcję, przez modele rozumowania przewyższające ludzi w złożonym rozwiązywaniu problemów, po infrastrukturę umożliwiającą transakcje agentów autonomicznych i systemy inteligencji przestrzennej generujące immersyjne środowiska 3D. To nie są odosobnione osiągnięcia – to powiązane postępy, które razem oznaczają fundamentalną zmianę w sposobie wdrażania i integracji AI z biznesem i społeczeństwem. Konwergencja tych możliwości, wspierana przez platformy orkiestrujące i ogromne inwestycje infrastrukturalne, tworzy fundament pod przyszłość napędzaną przez AI, gdzie systemy autonomiczne realizują coraz bardziej złożone zadania przy minimalnej ingerencji człowieka. Organizacje i osoby, które zrozumieją te zmiany i nauczą się wykorzystywać nowe możliwości, będą najlepiej przygotowane do rozwoju w nadchodzącej gospodarce AI.