18 najlepszych platform AI w 2025 roku: funkcje, zastosowania i jak wybrać

Poznaj 18 najlepszych platform AI w 2025 roku, ich funkcje, zastosowania oraz wskazówki, jak wybrać odpowiednią dla potrzeb swojej firmy. Pozostań na czele zmia...

Przewodnik po ryzyku i kontrolach AI KPMG zapewnia organizacjom uporządkowane, etyczne podejście do zarządzania ryzykiem AI, wspierając odpowiedzialne wdrażanie i zgodność z globalnymi standardami.

Ta pierwsza statystyka może pochodzić z zeszłego roku, ale dziś jest równie aktualna. Zgodnie z KPMG’s 2024 U.S. CEO Outlook, aż 68% prezesów wskazało AI jako najwyższy priorytet inwestycyjny. Liczą na nią, aby zwiększyć efektywność, podnieść kwalifikacje pracowników i napędzać innowacje w swoich organizacjach.

To ogromny wyraz zaufania do AI — ale rodzi też ważne pytanie: skoro stawka jest tak wysoka, jak organizacje mogą zapewnić odpowiedzialne i etyczne wykorzystanie AI?

W tym miejscu pojawia się Przewodnik po ryzyku i kontrolach AI KPMG. Oferuje on jasne, praktyczne ramy pomagające firmom wykorzystać potencjał AI, jednocześnie zarządzając realnymi ryzykami. W dzisiejszych czasach budowanie zaufanej AI to nie tylko dobra praktyka — to konieczność biznesowa.

Sztuczna inteligencja (AI) rewolucjonizuje branże, odblokowując nowe poziomy efektywności, innowacyjności i konkurencyjności. Jednak ta transformacja wiąże się z nowym zestawem ryzyk i wyzwań etycznych, którymi organizacje muszą umiejętnie zarządzać, by utrzymać zaufanie i zapewnić odpowiedzialne użytkowanie. Przewodnik po ryzyku i kontrolach AI KPMG został stworzony, by wspierać organizacje w poruszaniu się po tych zawiłościach, oferując praktyczne, uporządkowane i oparte na wartościach podejście do zarządzania AI.

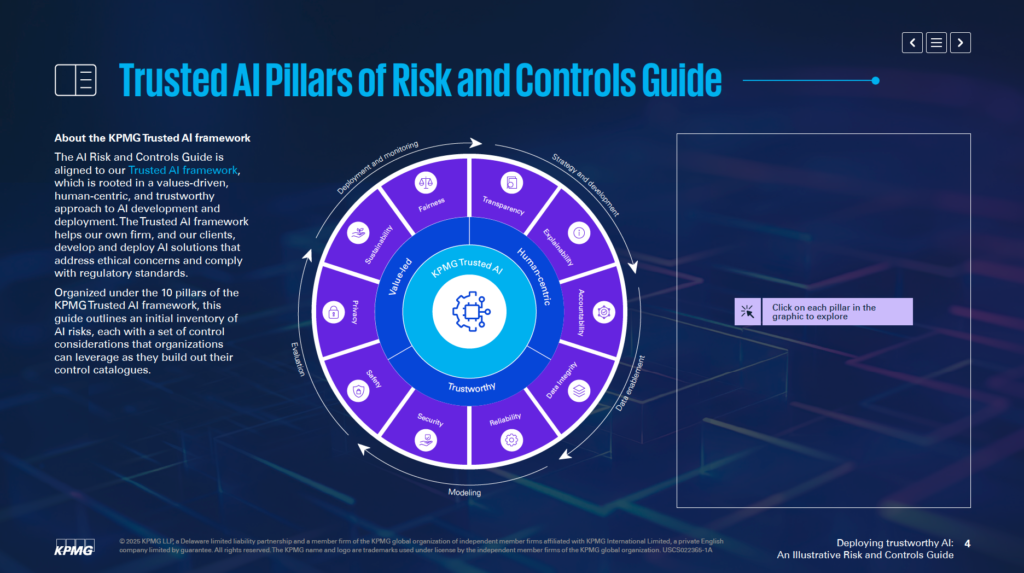

Zgodny z Zaufanymi Ramami AI KPMG, przewodnik pomaga firmom rozwijać i wdrażać rozwiązania AI w sposób etyczny, skoncentrowany na człowieku i zgodny z globalnymi standardami regulacyjnymi. Jest zorganizowany wokół 10 fundamentalnych filarów, z których każdy dotyczy kluczowego aspektu zarządzania ryzykiem AI:

Skupiając się na tych filarach, organizacje mogą wdrażać zasady etyczne na każdym etapie cyklu życia AI — od strategii i rozwoju po wdrożenie i monitorowanie. Przewodnik ten nie tylko wzmacnia odporność na ryzyko, ale też wspiera innowacje, które są trwałe, godne zaufania i zgodne z oczekiwaniami społecznymi.

Niezależnie od tego, czy jesteś specjalistą ds. ryzyka, liderem, naukowcem danych, czy doradcą prawnym, ten przewodnik dostarcza kluczowych narzędzi i wiedzy, by odpowiedzialnie wykorzystywać potencjał AI.

Przewodnik po ryzyku i kontrolach AI KPMG to wyspecjalizowane źródło, które pomaga organizacjom zarządzać specyficznym ryzykiem związanym ze sztuczną inteligencją. Uznaje, że choć AI oferuje ogromny potencjał, jej złożoność i wyzwania etyczne wymagają szczególnego podejścia do zarządzania ryzykiem. Przewodnik proponuje uporządkowane ramy do odpowiedzialnego i skutecznego radzenia sobie z tymi wyzwaniami.

Przewodnik nie ma zastępować dotychczasowych systemów, lecz uzupełniać istniejące procesy zarządzania ryzykiem. Jego głównym celem jest uwzględnienie specyficznych dla AI aspektów w strukturach zarządzania organizacji, zapewniając płynne dopasowanie do obecnych praktyk operacyjnych. Dzięki temu firmy mogą wzmocnić swoje możliwości bez konieczności całkowitej przebudowy ram zarządczych.

Przewodnik opiera się na Zaufanych Ramach AI KPMG, które promują wartościowe i skoncentrowane na człowieku podejście do AI. Integruje zasady z szeroko uznawanych standardów, w tym ISO 42001, NIST AI Risk Management Framework i unijnego AI Act. Dzięki temu przewodnik jest praktyczny i zgodny z globalnie rozpoznawalnymi najlepszymi praktykami oraz wymogami prawnymi w zakresie zarządzania AI.

Przewodnik oferuje praktyczne przykłady i działania dostosowane do zarządzania ryzykiem AI. Zachęca organizacje do adaptacji wskazówek do własnych realiów, biorąc pod uwagę m.in. to, czy systemy AI są budowane wewnętrznie, czy kupowane od dostawców, a także typy danych i stosowane techniki. Taka elastyczność sprawia, że przewodnik pozostaje aktualny dla różnych branż i zastosowań AI.

Przewodnik skupia się na umożliwieniu organizacjom bezpiecznego, etycznego i przejrzystego wdrażania technologii AI. Poruszając aspekty techniczne, operacyjne i etyczne ryzyk AI, pomaga budować zaufanie interesariuszy i jednocześnie czerpać korzyści z transformacyjnych możliwości tej technologii.

Przewodnik służy jako narzędzie zapewniające, by systemy AI były zgodne z celami biznesowymi przy jednoczesnym ograniczaniu ryzyk. Wspiera innowacje w sposób stawiający na odpowiedzialność i rzetelność.

Przewodnik po zarządzaniu AI KPMG jest przeznaczony dla profesjonalistów odpowiedzialnych za wdrożenie AI i dbających o to, by była ona stosowana bezpiecznie, etycznie i efektywnie. Dotyczy zespołów w różnych obszarach organizacji, m.in.:

Członkowie zarządów i wyższego kierownictwa, tacy jak CEO, CIO czy CTO, znajdą w przewodniku wsparcie w zarządzaniu AI jako strategicznym priorytetem. Według KPMG’s 2024 US CEO Outlook, 68% prezesów traktuje AI jako kluczowy kierunek inwestycji. Przewodnik umożliwia dopasowanie strategii AI do celów firmy, przy jednoczesnym zarządzaniu ryzykami.

Inżynierowie oprogramowania, naukowcy danych i inne osoby odpowiadające za tworzenie i wdrażanie AI mogą wykorzystać przewodnik do wdrażania zasad etycznych i silnych kontroli bezpośrednio w systemach. Skupia się on na adaptacji zarządzania ryzykiem do architektury i przepływów danych modeli AI.

Przewodnik jest elastyczny dla firm rozwijających AI wewnętrznie, korzystających z rozwiązań dostawców lub używających własnych zbiorów danych. Szczególnie istotny jest dla branż takich jak finanse, zdrowie, czy technologie, gdzie zaawansowane AI i wrażliwe dane są kluczowe dla działalności.

Wdrażanie AI bez jasnych ram zarządzania może prowadzić do ryzyk finansowych, regulacyjnych i reputacyjnych. Przewodnik KPMG współdziała z istniejącymi procesami, dostarczając uporządkowanego, etycznego podejścia do zarządzania AI. Promuje odpowiedzialność, przejrzystość i etyczność, pomagając organizacjom korzystać z AI w sposób odpowiedzialny i innowacyjny.

Organizacje powinny zacząć od powiązania ryzyk specyficznych dla AI z aktualną taksonomią ryzyka. Taksonomia ryzyka to uporządkowana struktura do identyfikacji, organizacji i zarządzania potencjalnymi zagrożeniami. Ponieważ AI wprowadza nowe wyzwania, klasyczne taksonomie wymagają rozszerzenia o czynniki związane z AI, takie jak dokładność przepływu danych, logika algorytmów czy wiarygodność źródeł danych. Dzięki temu ryzyka AI stają się częścią ogólnych działań zarządczych, a nie są traktowane odrębnie.

Przewodnik podkreśla konieczność oceny pełnego cyklu życia systemów AI. Kluczowe obszary to pochodzenie danych, sposób ich przepływu oraz logika leżąca u podstaw modelu AI. Tak szerokie spojrzenie pozwala zidentyfikować miejsca podatne na błędy już podczas tworzenia i użytkowania AI.

Systemy AI różnią się celem, metodą tworzenia i typem wykorzystywanych danych. To, czy model powstał wewnątrz firmy, czy został dostarczony z zewnątrz, znacząco wpływa na skalę zagrożeń. Podobnie rodzaj danych — własne, publiczne czy wrażliwe — oraz techniki budowy AI wymagają indywidualnych strategii zarządzania ryzykiem.

Przewodnik zaleca dostosowanie środków kontroli do specyficznych potrzeb systemów AI. Przykładowo, przy korzystaniu z danych własnych konieczne mogą być ścisłe zasady dostępu. Z kolei system AI dostarczany przez zewnętrznego dostawcę wymaga dogłębnej oceny ryzyka stron trzecich. Takie dostosowanie pozwala skuteczniej ograniczać konkretne wyzwania związane z AI.

Przewodnik zaleca wdrażanie praktyk zarządzania ryzykiem na każdym etapie życia AI. Obejmuje to planowanie już w fazie projektowania, wdrażanie silnego monitoringu podczas uruchamiania, a także regularne aktualizacje oceny ryzyk w miarę rozwoju systemu AI. Dzięki temu ograniczasz podatności i zapewniasz etyczność oraz niezawodność systemów AI.

Pierwsze kroki — powiązanie ryzyk AI z istniejącą taksonomią i dostosowanie kontroli do potrzeb — pozwalają zbudować solidne podstawy dla zaufanej AI. Umożliwiają systematyczną identyfikację, ocenę i zarządzanie ryzykami, budując silne ramy zarządzania AI.

Zaufane Ramy AI KPMG opierają się na dziesięciu kluczowych filarach, które odpowiadają na wyzwania etyczne, techniczne i operacyjne sztucznej inteligencji. Te filary prowadzą organizacje przez projektowanie, rozwój i wdrażanie AI w sposób odpowiedzialny, zapewniając zaufanie i odpowiedzialność przez cały cykl życia AI.

Nadzór człowieka i odpowiedzialność powinny być obecne na każdym etapie cyklu życia AI. Oznacza to określenie, kto odpowiada za zarządzanie ryzykiem AI, zapewnienie zgodności z przepisami oraz możliwość ingerencji, zastopowania lub cofnięcia decyzji AI, gdy to konieczne.

Systemy AI powinny ograniczać lub eliminować uprzedzenia mogące negatywnie wpływać na osoby, społeczności czy grupy. Wymaga to dokładnej analizy danych pod kątem reprezentatywności, stosowania środków równościowych podczas rozwoju oraz ciągłego monitorowania wyników, by zapewnić równe traktowanie.

Przejrzystość wymaga otwartego informowania o działaniu systemów AI i powodach podejmowanych decyzji. Obejmuje dokumentację ograniczeń systemu, rezultatów testów i metod weryfikacji. Użytkownicy powinni być informowani o zbieraniu danych, treści generowane przez AI muszą być odpowiednio oznaczone, a wrażliwe zastosowania (np. biometryka) wymagać jasnych komunikatów dla użytkownika.

Systemy AI muszą podawać zrozumiałe powody swoich decyzji. W tym celu organizacje powinny dokładnie dokumentować zbiory danych, algorytmy i wskaźniki wydajności, umożliwiając interesariuszom analizę i powtarzanie wyników.

Jakość i wiarygodność danych w całym cyklu życia — od zbierania, etykietowania, przechowywania po analizę — są kluczowe. Należy wdrożyć kontrole ograniczające ryzyka takie jak uszkodzenie czy uprzedzenia danych. Regularne testy jakości i regresyjne po aktualizacjach systemu pomagają utrzymać dokładność i niezawodność AI.

Rozwiązania AI muszą spełniać wymogi dotyczące ochrony prywatności i danych osobowych. Organizacje powinny właściwie realizować żądania osób dotyczące ich danych, przeprowadzać oceny wpływu na prywatność oraz stosować zaawansowane metody (np. prywatność różnicową), by równoważyć użyteczność danych z ochroną prywatności.

Systemy AI powinny działać zgodnie z przeznaczeniem i wymaganą dokładnością. Oznacza to gruntowne testy, mechanizmy wykrywania anomalii oraz nieprzerwane pętle zwrotne weryfikujące wyniki działania.

Środki bezpieczeństwa chronią systemy AI przed wyrządzeniem szkód osobom, firmom czy mieniu. Należą do nich projektowanie zabezpieczeń awaryjnych, monitorowanie ataków (np. zatruwanie danych, ataki prompt injection) oraz dbanie o zgodność z normami etycznymi i operacyjnymi.

Silne praktyki bezpieczeństwa są niezbędne do ochrony AI przed zagrożeniami i złośliwymi działaniami. Organizacje powinny regularnie przeprowadzać audyty, testy podatności i stosować szyfrowanie w celu zabezpieczenia danych.

Systemy AI powinny być projektowane z myślą o minimalizacji zużycia energii i wspieraniu celów środowiskowych. Aspekty zrównoważonego rozwoju należy uwzględniać już na etapie projektowania, monitorując zużycie energii, efektywność i emisje przez cały cykl życia AI.

Stosując te dziesięć filarów, organizacje mogą tworzyć systemy AI etyczne, godne zaufania i zgodne z oczekiwaniami społecznymi. Ramy te zapewniają jasną strukturę zarządzania wyzwaniami AI i wspierają odpowiedzialną innowacyjność.

Integralność danych jest kluczowa dla zachowania dokładności, sprawiedliwości i niezawodności systemów AI. Słabe zarządzanie danymi prowadzi do ryzyk takich jak uprzedzenia, błędy i niewiarygodne wyniki. Problemy te mogą podważyć zaufanie do wyników AI i powodować poważne konsekwencje operacyjne lub reputacyjne. Zaufane Ramy AI KPMG podkreślają znaczenie utrzymywania wysokiej jakości danych przez cały cykl życia, aby AI działała skutecznie i spełniała normy etyczne.

Bez silnego zarządzania danymi systemy AI mogą generować wadliwe wyniki. Problemy takie jak niekompletne, nieprecyzyjne lub nieistotne dane prowadzą do stronniczych lub niewiarygodnych rezultatów, zwiększając ryzyko w różnych zastosowaniach AI.

Dane często przemieszczają się między systemami podczas treningu, testowania czy eksploatacji. Jeśli transfery nie są odpowiednio zabezpieczone, dane mogą ulec uszkodzeniu, zgubieniu lub pogorszeniu jakości, co wpływa na wyniki AI.

Aby poprawić zarządzanie danymi, organizacje powinny:

Aby ograniczyć ryzyka podczas przesyłania danych, warto:

Wykorzystanie systemów ciągłego monitoringu pomaga utrzymać integralność danych przez cały cykl życia AI. Pozwala to wykrywać problemy, takie jak niespodziewane zmiany jakości danych lub niespójności w obsłudze zbiorów, umożliwiając szybką reakcję naprawczą.

Utrzymanie integralności danych jest niezbędne dla wdrażania godnych zaufania systemów AI. Organizacje mogą ograniczać ryzyka poprzez tworzenie solidnych ram zarządzania, zabezpieczanie interakcji z danymi i ciągłą ich walidację. Takie działania zwiększają wiarygodność wyników AI, spełniając standardy etyczne i operacyjne, a także budując zaufanie do technologii AI.

Zarządzanie żądaniami dotyczącymi dostępu do danych osobowych to istotne wyzwanie w obszarze prywatności AI. Organizacje muszą umożliwić osobom korzystanie z praw do dostępu, poprawiania lub usuwania danych zgodnie z przepisami takimi jak RODO czy CCPA. Niewłaściwa obsługa takich żądań może prowadzić do naruszeń przepisów, utraty zaufania klientów i szkód wizerunkowych.

Aby ograniczyć to ryzyko, firmy powinny tworzyć programy edukujące użytkowników o ich prawach wobec danych przy korzystaniu z AI. Systemy muszą umożliwiać szybkie i przejrzyste obsługiwanie żądań. Organizacje powinny także prowadzić szczegółową dokumentację sposobu realizacji żądań, by udowodnić zgodność podczas audytów.

Systemy AI często przetwarzają wrażliwe dane osobowe, przez co stanowią atrakcyjny cel ataków cybernetycznych. Wyciek danych może skutkować dotkliwymi karami, utratą reputacji firmy i brakiem zaufania klientów.

Aby przeciwdziałać temu ryzyku, Zaufane Ramy AI KPMG zalecają przeprowadzanie etycznych przeglądów systemów AI korzystających z danych osobowych pod kątem zgodności z przepisami o prywatności. Niezbędne są regularne audyty ochrony danych i oceny wpływu na prywatność (PIA), zwłaszcza gdy wrażliwe dane służą do trenowania modeli AI. Dodatkowo, metody takie jak prywatność różnicowa (dodająca szum statystyczny do danych) mogą pomóc w anonimizacji informacji przy zachowaniu możliwości analizy.

Systemy AI, które nie uwzględniają ochrony prywatności już na etapie projektowania, mogą generować poważne ryzyka. Brak zasady „privacy by design” grozi ujawnieniem wrażliwych danych i niezgodnością z wymogami prawnymi.

Firmy powinny wdrażać zabezpieczenia prywatności już podczas tworzenia systemów AI. Obejmuje to przestrzeganie przepisów o ochronie danych poprzez solidne praktyki zarządzania. Kluczowa jest przejrzysta dokumentacja sposobu zbierania, wykorzystania i przechowywania danych. Organizacje muszą także uzyskać wyraźną zgodę użytkownika na przetwarzanie danych, szczególnie w przypadku danych biometrycznych.

Gdy systemy AI nie informują jasno, jak przetwarzają dane użytkowników, może to prowadzić do utraty zaufania i konsekwencji prawnych. Użytkownicy powinni wiedzieć, kiedy ich dane są zbierane i w jakim celu…

Przewodnik po ryzyku i kontrolach AI KPMG to praktyczne ramy zaprojektowane, by pomagać organizacjom zarządzać unikalnym ryzykiem związanym z AI, zapewniając odpowiedzialne, etyczne i zgodne wdrażanie AI w różnych branżach.

Przewodnik opiera się na dziesięciu kluczowych filarach: Odpowiedzialność, Sprawiedliwość, Przejrzystość, Wytłumaczalność, Integralność danych, Niezawodność, Bezpieczeństwo, Bezawaryjność, Prywatność i Zrównoważony rozwój — każdy z nich dotyczy kluczowych aspektów zarządzania ryzykiem AI.

Przewodnik jest przeznaczony dla specjalistów ds. ryzyka, zespołów ds. zgodności, ekspertów cyberbezpieczeństwa, doradców prawnych, kadry zarządzającej, twórców AI, inżynierów oraz organizacji każdej wielkości, które chcą odpowiedzialnie zarządzać AI.

Jest zgodny z globalnymi standardami, takimi jak ISO 42001, NIST AI Risk Management Framework i unijny AI Act, pomagając organizacjom integrować AI z istniejącymi procesami zarządczymi i spełniać wymogi regulacyjne.

Zaleca działania takie jak silne zarządzanie danymi, prywatność w fazie projektowania, ciągłe monitorowanie, transparentność decyzji AI, wykrywanie anomalii, pętle zwrotne oraz cele zrównoważonego rozwoju w celu ograniczenia ryzyk związanych z AI.

Dowiedz się, jak Przewodnik po ryzyku i kontrolach AI KPMG może pomóc Twojej organizacji korzystać z innowacji AI, zapewniając jednocześnie etyczne, bezpieczne i zgodne wdrożenie.

Poznaj 18 najlepszych platform AI w 2025 roku, ich funkcje, zastosowania oraz wskazówki, jak wybrać odpowiednią dla potrzeb swojej firmy. Pozostań na czele zmia...

Wskaźniki adopcji AI wskazują procent organizacji, które włączyły sztuczną inteligencję do swoich operacji. Wskaźniki te różnią się w zależności od branż, regio...

Zwrot z inwestycji w sztuczną inteligencję (ROAI) mierzy wpływ inwestycji w AI na działalność, produktywność i rentowność firmy. Dowiedz się, jak oceniać, mierz...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.