Halucynacja

Halucynacja w modelach językowych występuje, gdy AI generuje tekst, który wydaje się prawdopodobny, ale w rzeczywistości jest nieprawidłowy lub zmyślony. Dowied...

Dowiedz się, jak najnowsze badania OpenAI wyjaśniają, dlaczego modele językowe halucynują i generują przekonujące nieprawdziwe informacje. Poznaj główne przyczyny oraz praktyczne rozwiązania pozwalające ograniczyć halucynacje w systemach AI.

Modele językowe stały się niezwykle potężne, jednak wciąż są podatne na poważną wadę: halucynacje. To przekonujące, brzmiące wiarygodnie stwierdzenia, które są niezgodne z faktami. Najnowsza publikacja OpenAI, „Why Language Models Hallucinate”, rzuca nowe światło na źródła tego zjawiska i proponuje praktyczne rozwiązania. Halucynacje nie są przypadkowymi błędami czy nieuniknionymi wadami — są wpisane w sposób budowania i trenowania współczesnych modeli językowych. Zrozumienie tych badań jest kluczowe dla każdego, kto pracuje z systemami AI, bo pokazuje, że halucynacje to nie tylko problem techniczny, lecz systemowy — zakorzeniony w sposobie trenowania, oceny i motywowania modeli. Ten artykuł przybliża najważniejsze wnioski z publikacji i analizuje, co oznaczają one dla przyszłości niezawodnych systemów AI.

Modele językowe są znane z generowania tzw. „nadmiernie pewnych nieprawdziwych informacji” — wypowiedzi, które brzmią sensownie i są wyrażane z przekonaniem, lecz są błędne. To zasadniczo różni się od zwykłych pomyłek. Model, który przyznaje „nie jestem pewien” w sytuacji niepewności, zachowuje się inaczej niż taki, który przekonująco podaje fałszywe informacje. Problem polega na tym, że gdy model myli się z pełnym przekonaniem, staje się niezwykle trudny do zaufania w jakimkolwiek kontekście. Użytkownicy nie są w stanie łatwo odróżnić informacji prawdziwych od halucynowanych, co podważa użyteczność całego systemu. Jest to szczególnie niebezpieczne w zastosowaniach o wysokiej stawce, jak diagnoza medyczna, badania prawne czy analiza finansowa, gdzie błędne informacje przedstawione z przekonaniem mogą prowadzić do poważnych konsekwencji. Wyzwanie polega więc nie tylko na tym, że modele popełniają błędy — ale że robią to, będąc całkowicie pewne swoich odpowiedzi.

Źródło problemu leży w zrozumieniu, na jakim etapie procesu rozwoju modeli pojawiają się halucynacje. Choć łatwo założyć, że wynikają one głównie z błędów w danych treningowych, rzeczywistość jest znacznie bardziej złożona i fundamentalna. Nawet gdyby udało się stworzyć idealnie czysty zbiór uczący, pozbawiony wszelkich błędów — co jest teoretycznie niemożliwe — halucynacje i tak by się pojawiały. Wynika to z faktu, że problem nie sprowadza się tylko do tego, czego model uczy się z danych, lecz do tego, jak model jest trenowany do określonych zachowań i do jakich celów jest optymalizowany. Sam proces trenowania — poprzez mechanizmy sprzężenia zwrotnego i struktury nagród — aktywnie zachęca modele do działań prowadzących do halucynacji.

Podczas trenowania modele językowe uczą się na podstawie ogromnych korpusów tekstów, które zawierają nieuniknione błędy, nieścisłości i półprawdy. Model trenujący na Wikipedii, książkach, artykułach i treściach z Internetu przyswoi nie tylko poprawne informacje, ale także błędy, nieporozumienia i fałszywe twierdzenia obecne w tych źródłach. Jeśli 20% informacji o datach urodzenia pojawia się tylko raz w danych treningowych, model będzie halucynował w ok. 20% zapytań o daty urodzenia, bo nie nauczył się ich wystarczająco dobrze, by trafnie je odtworzyć. To oczywiście realne źródło halucynacji, ale nie jest ono najważniejsze.

Bardziej istotny problem polega na tym, że nawet z idealnie poprawnymi danymi treningowymi, cele optymalizacyjne stosowane w uczeniu modeli językowych nadal prowadziłyby do halucynacji. To kluczowy wniosek, który zmienia sposób postrzegania problemu. Cele treningowe — sposób, w jaki modele są nagradzane lub karane za odpowiedzi — są zasadniczo niedostosowane do ograniczania halucynacji. W trakcie treningu modele uczą się optymalizować pod konkretne metryki i sygnały nagrody, które często faworyzują zgadywanie z przekonaniem zamiast szczerego przyznania się do niepewności. Model uczy się, że udzielenie konkretnej, pewnej odpowiedzi jest bardziej nagradzane niż przyznanie, że nie zna odpowiedzi. Tworzy to wypaczoną strukturę motywacyjną, w której z punktu widzenia modelu halucynowanie staje się racjonalną strategią.

Jednym z najważniejszych wniosków z badań OpenAI jest to, że generowanie poprawnych odpowiedzi jest znacznie trudniejsze niż ich weryfikacja. Ta asymetria jest kluczowa dla zrozumienia, dlaczego pojawiają się halucynacje. Kiedy mamy zweryfikować odpowiedź — sprawdzić, czy dane twierdzenie jest prawdziwe czy fałszywe — mierzymy się ze znacznie prostszym zadaniem. Możemy sprawdzić fakty, szukać sprzeczności, oceniać spójność. Natomiast generowanie odpowiedzi od zera wymaga nie tylko podania poprawnej odpowiedzi, ale również unikania wszystkich potencjalnych błędnych odpowiedzi, których może być nieskończenie wiele. W przypadku większości pytań istnieje znacznie więcej błędnych odpowiedzi niż poprawnych, przez co zadanie generowania jest z natury trudniejsze niż weryfikacja.

Ta asymetria tłumaczy, dlaczego współpraca wielu agentów AI zwykle daje lepsze rezultaty niż działanie pojedynczego agenta. Gdy jeden agent sprawdza odpowiedzi drugiego, wykonuje zadanie weryfikacyjne, które jest łatwiejsze i bardziej wiarygodne niż generowanie od podstaw. To również wyjaśnia, dlaczego użytkownicy często zauważają, że gdy powiedzą modelowi językowemu „Nie, to nie jest poprawne. Popraw to”, model często generuje poprawioną odpowiedź. Model przechodzi w tryb weryfikacji — sprawdza, czy poprzednia odpowiedź była właściwa i generuje alternatywę, zamiast tworzyć odpowiedź od zera. To spostrzeżenie ma ogromne znaczenie dla projektowania systemów AI i sposobu myślenia o poprawie ich niezawodności.

W artykule użyto trafnej analogii wyjaśniającej, dlaczego modele językowe halucynują: ich zachowanie przypomina studentów przystępujących do egzaminów wielokrotnego wyboru, gdy nie są pewni odpowiedzi. Na teście z czterema możliwymi odpowiedziami, jeśli nie znasz odpowiedzi, masz 25% szans na trafienie poprzez zgadywanie. Jeśli natomiast wstrzymasz się od odpowiedzi — zostawisz puste pole lub powiesz „nie wiem” — masz gwarancję zera punktów. W systemie binarnym, gdzie poprawna odpowiedź to jeden punkt, a brak odpowiedzi lub „nie wiem” to zero, zgadywanie maksymalizuje oczekiwaną liczbę punktów. Właśnie tego uczą się modele językowe podczas treningu.

W sytuacji niepewności modele uczą się „blefować” — udzielać konkretnej, pewnej odpowiedzi, zamiast przyznać się do niepewności. Co ważne, te blefy są zwykle bardzo konkretne, a nie ogólne. Model powie „30 września”, a nie „gdzieś jesienią”, gdy zostanie zapytany o nieznaną datę. Sama ta konkretność jest formą halucynacji, bo przekazuje fałszywą pewność. Model nauczył się, że konkretne, pewne odpowiedzi są wyżej punktowane niż ostrożne lub niepewne wypowiedzi. Takie zachowanie jest wzmacniane przez metryki oceny wydajności modeli. Większość benchmarków modeli językowych, w tym GPQA, MMLU Pro i Math, stosuje binarny system oceniania, analogiczny do standardowych egzaminów ludzkich. Nagradzają poprawne odpowiedzi i karzą błędne, ale nie nagradzają wstrzymania się lub wyrażenia niepewności. Tylko benchmarki takie jak WildBench uwzględniają pozytywnie odpowiedzi typu „nie wiem” i modele wypadają na nich wyraźnie inaczej.

Faza post-treningowa, gdzie modele są dopracowywane z użyciem uczenia ze wzmocnieniem i innych technik, powinna ograniczać halucynacje. Jednak badania pokazują, że uczenie ze wzmocnieniem może wręcz pogłębiać ten problem. W trakcie post-treningu modele są zwykle nagradzane za bycie pomocnym, zdecydowanym i pewnym siebie. To pożądane cechy w wielu kontekstach, ale mogą być osiągane kosztem dokładności i kalibracji. Kalibracja oznacza zgodność pomiędzy deklarowaną przez model pewnością a rzeczywistą poprawnością odpowiedzi. Model dobrze skalibrowany, który twierdzi, że jest pewny na 70%, powinien mieć rację mniej więcej w 70% przypadków. Model, który twierdzi, że jest pewny na 80%, powinien mieć rację w 80% przypadków.

Podczas uczenia ze wzmocnieniem ta kalibracja się rozmywa. Model bazowy może być całkiem dobrze skalibrowany, z poziomami pewności zbliżonymi do rzeczywistej trafności. Jednak po uczeniu ze wzmocnieniem model staje się nadmiernie pewny siebie. Może deklarować 80% pewności, będąc poprawnym tylko w 45% przypadków. Dzieje się tak, ponieważ uczenie ze wzmocnieniem skłania model do bycia bardziej pomocnym i bardziej zdecydowanym, co przekłada się na wyższą pewność niż faktyczna trafność. Model uczy się, że wyrażanie niepewności jest karane, a podawanie pewnych odpowiedzi — nawet błędnych — jest nagradzane. To fundamentalny problem obecnego sposobu trenowania modeli językowych i wymaga systemowych zmian.

Problem halucynacji to nie tylko kwestia treningu, ale także oceny. Benchmarki używane do pomiaru wydajności modeli językowych często wzmacniają zachowania prowadzące do halucynacji. Główne benchmarki stosowane w branży — GPQA, MMLU Pro, Wildbench, Math i SWEBench — niemal wszystkie używają binarnego oceniania. Albo przyznają pełne punkty za poprawną odpowiedź, albo zero za błędną. Co ważniejsze, zazwyczaj nie przyznają punktów za wstrzymanie się lub odpowiedź „nie wiem”. To powoduje niedopasowanie pomiędzy tym, co mierzymy, a tym, czego naprawdę chcemy od modeli.

Jedynym większym benchmarkiem, który nie stosuje czystej oceny binarnej i docenia odpowiedzi „nie wiem”, jest WildBench. To istotna różnica, bo oznacza ocenę modelu według metryki, która nie karze niepewności. Gdy modele są trenowane i oceniane według metryk nagradzających pewność zamiast szczerej niepewności, uczą się priorytetowo traktować pewność ponad dokładność. To problem systemowy obejmujący całą branżę. Twórcy benchmarków, deweloperzy modeli i badacze wszyscy przyczyniają się do tego problemu, stosując metryki, które nie nagradzają odpowiednio wstrzymania się od odpowiedzi. Rozwiązanie wymaga skoordynowanych zmian w skali całej branży — aktualizacji benchmarków i praktyk oceny.

Przy budowaniu przepływów pracy i systemów automatyzacji opartych na AI niezawodność jest kluczowa. FlowHunt dostrzega, że halucynacje i niepewność modeli to krytyczne wyzwania, które należy rozwiązywać na poziomie systemu. Zamiast polegać na wyjściu pojedynczego modelu, architektura FlowHunt wprowadza wielowarstwową weryfikację i progi pewności. Takie podejście odzwierciedla wnioski z badań, że weryfikacja jest łatwiejsza i bardziej wiarygodna niż generowanie. Dzięki systemom, w których agenci AI wzajemnie sprawdzają swoje odpowiedzi, FlowHunt ogranicza ryzyko propagacji halucynacji w automatycznych przepływach pracy.

Dodatkowo platforma FlowHunt pozwala użytkownikom ustalać progi pewności dla różnych typów zadań. W generowaniu treści, badaniach czy analizie użytkownicy mogą określić, że system ma akceptować wyłącznie odpowiedzi spełniające określony próg pewności lub oznaczać niepewne wyniki do weryfikacji przez człowieka. To zgodne z rekomendacją badawczą, by model wstrzymywał się od odpowiedzi, gdy jego pewność jest zbyt niska. Dzięki wbudowaniu tych zasad platforma FlowHunt umożliwia organizacjom tworzenie bardziej niezawodnych przepływów AI, które nie tylko maksymalizują wydajność, ale przede wszystkim wiarygodność wyjść.

Badania OpenAI proponują proste, lecz skuteczne rozwiązanie problemu halucynacji: wdrożenie progów pewności i nagradzanie modeli za wstrzymanie się od odpowiedzi w sytuacji niepewności. Zamiast wymagać, by modele zawsze odpowiadały, należy sprawić, by przyznanie się do „nie wiem” było akceptowane, a nawet nagradzane. Wymaga to zmian na kilku poziomach: w sposobie trenowania modeli, ich oceny i projektowania systemów, które z nich korzystają.

Praktyczna implementacja jest elegancka w swej prostocie. W fazie post-treningowej modele można szkolić tak, by odpowiadały tylko wtedy, gdy ich pewność przekracza określony próg, np. 75%. Poniżej tego progu powinny odpowiadać „nie wiem” lub podobnym wyrażeniem niepewności. Można to wzmocnić odpowiednimi sygnałami nagrody w uczeniu ze wzmocnieniem. Zamiast obecnego systemu binarnego, w którym poprawna odpowiedź to +1, błędna to -1, a „nie wiem” to 0, lepszy system przyznawałby +1 za poprawną, 0 za „nie wiem” i -1 za błędną odpowiedź. Tworzy to właściwe motywacje: poprawne odpowiedzi są nagradzane, błędne karane bardziej niż wstrzymanie się, które jest neutralne.

Co ważne, podejście to nie wymaga idealnych danych czy perfekcyjnych modeli. Działa, ponieważ dostosowuje motywacje modelu do tego, czego naprawdę oczekujemy: wiarygodnych informacji, gdy model jest pewny, i szczerej niepewności, gdy nie jest. Model uczy się, że najlepsza strategia to nie blefowanie lub halucynowanie, lecz podawanie prawdziwych informacji, gdy to możliwe, i przyznawanie się do niepewności w razie potrzeby. To uczciwsze i ostatecznie bardziej użyteczne zachowanie niż obecne zgadywanie z przekonaniem.

Aby to rozwiązanie zadziałało na szeroką skalę, benchmarki muszą być zaktualizowane tak, by doceniały wstrzymanie się od odpowiedzi. Jeśli modele będą trenowane do wstrzymywania się przy niepewności, a potem oceniane na benchmarkach karzących takie zachowanie, nauczą się ignorować fazę szkolenia i wrócą do zgadywania. Dlatego reforma benchmarków jest niezbędna. Twórcy benchmarków powinni wprowadzić systemy oceniania, które nagradzają poprawne odpowiedzi, przyznają neutralne lub pozytywne punkty za „nie wiem” i karzą błędne odpowiedzi. Może to wyglądać tak: +1 za poprawną, 0 za „nie wiem”, -1 za niepoprawną.

Dobrą wiadomością jest to, że zmiana już się zaczyna. Według doniesień, GPT-5 zaczyna wdrażać takie zachowanie. Gdy zostaje zapytany o coś, czego nie jest pewien, GPT-5 czasem odpowiada „nie wiem” po przeanalizowaniu problemu, zamiast próbować udzielać pewnej, lecz potencjalnie błędnej odpowiedzi. To oznacza zmianę w sposobie trenowania modeli i nagradzanych zachowań. Wraz z upowszechnianiem się tego podejścia i aktualizacją benchmarków doceniających wstrzymanie się od odpowiedzi, powinniśmy zaobserwować istotny spadek liczby halucynacji.

Wnioski z tych badań mają duże znaczenie praktyczne. W realnych zastosowaniach halucynacje mogą mieć poważne konsekwencje. Model, który z przekonaniem udziela błędnych informacji medycznych, prawnych czy finansowych, może wyrządzić realną szkodę. Zrozumienie, że halucynacje nie są nieuniknione, lecz wynikają z konkretnych praktyk treningowych i oceny, pozwala branży wdrożyć celowe zmiany prowadzące do ich ograniczenia. Badania te stanowią drogowskaz do tych zmian.

Reakcja czołowych laboratoriów AI jest obiecująca. Anthropic, w swoich badaniach nad wewnętrznym działaniem modeli językowych, zidentyfikował podobne problemy i zaproponował uzupełniające rozwiązania. Zauważyli, że modele mają pewnego rodzaju „impet” do udzielania kompletnych, pewnych odpowiedzi, nawet gdy są niepewne. Ten impet jest wpisany w architekturę i proces treningowy modelu. Zrozumienie tego pozwala projektować interwencje przeciwdziałające temu zjawisku i promujące szczere wyrażanie niepewności. Zbieżność badań różnych laboratoriów wskazuje, że branża zbliża się do konsensusu zarówno co do problemu, jak i rozwiązania.

Przekonaj się, jak FlowHunt automatyzuje Twoje przepływy treści i SEO AI — od badań i generowania treści po publikację i analitykę — wszystko w jednym miejscu. Buduj niezawodne, świadome halucynacji przepływy AI z wbudowaną kalibracją pewności.

Poza wdrażaniem progów pewności, badania wprowadzają koncepcję kalibracji behawioralnej. To więcej niż tylko sprawdzanie rozkładów prawdopodobieństwa wyjść modelu. Kalibracja behawioralna polega na testowaniu, czy deklarowana przez model pewność rzeczywiście odpowiada jego skuteczności. Przy 50% pewności, czy model ma rację w połowie przypadków? Przy 90% pewności, czy jest poprawny w 90%? To pozwala ocenić, czy model zachowuje się uczciwie i wiarygodnie.

Testowanie kalibracji behawioralnej wymaga innego podejścia do oceny niż tradycyjne benchmarki. Zamiast mierzyć tylko ogólną dokładność, trzeba sprawdzać skuteczność przy różnych poziomach pewności. Pozwala to wykryć, czy model jest dobrze skalibrowany, czy nadmiernie pewny siebie. Model może mieć wysoką ogólną skuteczność, a jednocześnie być słabo skalibrowany, tzn. jego pewność nie pokrywa się z rzeczywistymi osiągami. Odwrotnie, model o niższej ogólnej skuteczności, ale dobrej kalibracji może być użyteczniejszy, bo wiadomo, kiedy można mu zaufać, a kiedy lepiej poprosić o weryfikację lub opinię człowieka.

Rozwiązanie problemu halucynacji wymaga zmian na wielu poziomach procesu rozwoju AI. Po pierwsze, twórcy modeli muszą wdrożyć progi pewności i nagradzanie wstrzymania się od odpowiedzi podczas treningu i post-treningu. Po drugie, twórcy benchmarków muszą zaktualizować metryki oceny, by doceniały odpowiedzi typu „nie wiem” i mierzyły kalibrację behawioralną. Po trzecie, organizacje wdrażające systemy AI muszą projektować przepływy pracy, uwzględniające weryfikację i recenzję ludzką dla wyjść niepewnych. Po czwarte, użytkownicy systemów AI powinni zrozumieć, że wyrażanie niepewności przez modele to zaleta, a nie wada, i odpowiednio to doceniać.

To nie jest problem, który może rozwiązać pojedynczy podmiot. Wymaga koordynacji i współpracy twórców modeli, badaczy, autorów benchmarków i użytkowników. Dobrą informacją jest to, że rozwiązanie jest stosunkowo proste i nie wymaga fundamentalnych przełomów w architekturze czy metodach treningu AI. Chodzi głównie o dostosowanie motywacji i praktyk oceny do tego, czego faktycznie oczekujemy: rzetelnych, uczciwych systemów AI, które znają granice swojej wiedzy.

Wraz z upowszechnianiem się tych praktyk w branży powinniśmy obserwować istotny wzrost niezawodności i wiarygodności modeli językowych.

Badania OpenAI nad przyczynami halucynacji modeli językowych pokazują, że problem ten nie jest nieunikniony, lecz wynika ze specyficznych praktyk treningowych i oceniania, które premiują zgadywanie z przekonaniem ponad szczerą niepewność. Halucynacje pojawiają się, bo modele są trenowane i oceniane według metryk nagradzających poprawne odpowiedzi, a jednakowo karzących zarówno błędy, jak i wstrzymanie się — przez co zachęcają do blefowania w razie wątpliwości. Rozwiązanie polega na wdrożeniu progów pewności, nagradzaniu modeli za odpowiedź „nie wiem” oraz aktualizacji benchmarków tak, by doceniały wstrzymanie się od odpowiedzi. Ta zmiana systemowa, już widoczna w nowszych modelach jak GPT-5, oznacza fundamentalną zmianę w podejściu do niezawodności AI. Dostosowując motywacje modeli do tego, czego naprawdę oczekujemy — wiarygodnej informacji przy pewności i szczerej niepewności w razie wątpliwości — możemy znacząco ograniczyć halucynacje i budować bardziej niezawodne systemy AI.

Halucynacja występuje, gdy model językowy generuje przekonujące, ale nieprawdziwe informacje z dużą pewnością siebie. Na przykład model może z przekonaniem podać błędną datę urodzenia lub wymyślić fakty, których nigdy nie było w danych treningowych. Takie halucynacje są szczególnie problematyczne, ponieważ model przedstawia je jako prawdziwe, co utrudnia użytkownikowi rozpoznanie błędu.

Modele językowe są trenowane z wykorzystaniem metryk oceny, które nagradzają poprawne odpowiedzi i karzą niepoprawne, ale zazwyczaj przyznają zero punktów za wstrzymanie się od odpowiedzi lub przyznanie 'nie wiem'. Tworzy to strukturę motywacyjną podobną do egzaminów wielokrotnego wyboru, gdzie zgadywanie daje 25% szansy na trafienie, a brak odpowiedzi gwarantuje zero punktów. Modele uczą się, że udzielenie konkretnej odpowiedzi — nawet błędnej — jest punktowane wyżej niż przyznanie się do niepewności.

Według badań OpenAI, halucynacje są nieuniknione w modelach bazowych, ale można je znacząco ograniczyć poprzez odpowiedni dobór metod post-treningowych i projektowanie oceny. Rozwiązanie polega na wprowadzeniu progów pewności, nagradzaniu modeli za wstrzymanie się, gdy są niepewne, oraz aktualizacji benchmarków tak, by doceniały odpowiedzi typu 'nie wiem'. Całkowita eliminacja wymaga jednak zmian systemowych w sposobie trenowania i oceny modeli.

Uczenie ze wzmocnieniem w fazie post-treningowej może w rzeczywistości sprawić, że modele będą bardziej pewne siebie, ale mniej dokładne. Badania pokazują, że modele bazowe mogą być dobrze skalibrowane (ich pewność odpowiada dokładności), jednak uczenie ze wzmocnieniem często sprawia, że stają się one nadmiernie pewne siebie. Model może deklarować 80% pewności, będąc poprawnym tylko w 45% przypadków, co odciąga go od szczerego wyrażania niepewności na rzecz bardziej zdecydowanych, lecz mniej wiarygodnych odpowiedzi.

Obecnie używane benchmarki, takie jak GPQA, MMLU Pro czy Math, stosują binarny system oceniania, który nie nagradza odpowiedzi 'nie wiem'. Powiela to problem z uczenia — modele uczą się, że najlepszą strategią jest zawsze udzielić odpowiedzi, zamiast przyznać się do niepewności. Benchmarki takie jak WildBench, które doceniają wstrzymanie się od odpowiedzi, pokazują lepsze rezultaty, co sugeruje, że aktualizacja metryk oceny jest kluczowa dla ograniczania halucynacji.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Buduj niezawodną automatykę AI z wbudowaną kalibracją pewności i inteligentną obsługą błędów.

Halucynacja w modelach językowych występuje, gdy AI generuje tekst, który wydaje się prawdopodobny, ale w rzeczywistości jest nieprawidłowy lub zmyślony. Dowied...

Czym są halucynacje w AI, dlaczego się pojawiają i jak ich unikać? Dowiedz się, jak utrzymać dokładność odpowiedzi chatbota AI dzięki praktycznym, skoncentrowan...

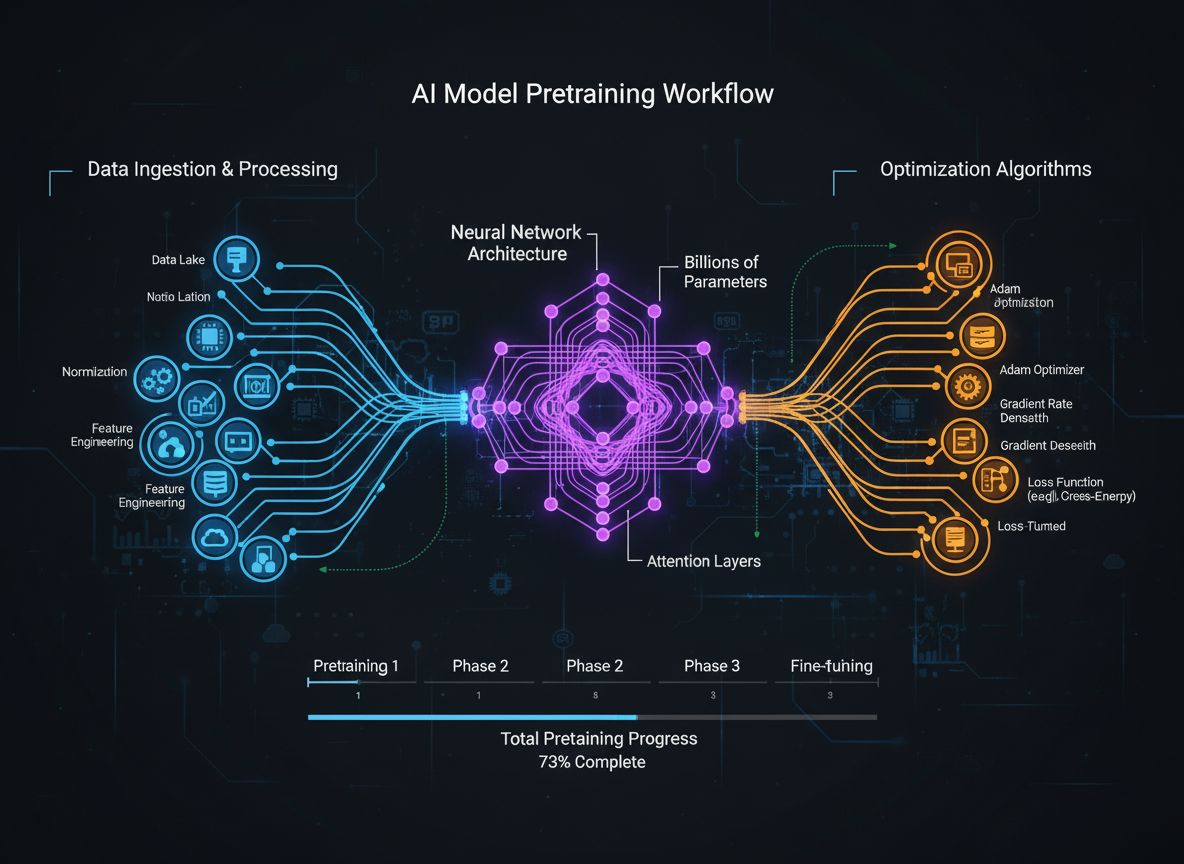

Kompleksowy przewodnik po nowoczesnych strategiach pretrenowania modeli językowych, technikach kuracji danych i metodach optymalizacji wykorzystywanych przez Hu...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.