Premiera GPT 5.2 i rewolucja modeli AI: analiza najważniejszych ogłoszeń grudnia

Poznaj przełomowe osiągnięcia AI z 11 grudnia, w tym premierę GPT 5.2 od OpenAI, wydania open-source, przejście MCP pod egidę Linux Foundation oraz krajobraz ko...

Poznaj, jak uczenie przez wzmacnianie i dostrajanie stały się dominującymi metodami optymalizacji modeli AI — od destylacji GPT-4 po wzrost otwartoźródłowych modeli — z perspektywy drogi OpenPipe i przejęcia przez CoreWeave.

Krajobraz sztucznej inteligencji przeszedł w ciągu ostatnich dwóch lat ogromną transformację, zasadniczo zmieniając sposób, w jaki organizacje podchodzą do optymalizacji i wdrażania modeli. To, co zaczęło się jako jasna okazja do destylacji drogich modeli czołowych w tańsze, wydajniejsze alternatywy, rozwinęło się w złożony ekosystem, w którym uczenie przez wzmacnianie, otwartoźródłowe modele oraz innowacyjne techniki dostrajania stały się kluczowe dla strategii AI. W tym artykule omawiamy historię firmy OpenPipe, założonej w celu rozwiązania problemu wysokiego kosztu wnioskowania AI, i analizujemy szersze trendy, które ukształtowały branżę dostrajania. Dzięki spostrzeżeniom Kyle’a Corbitta, współzałożyciela i CEO OpenPipe (niedawno przejętej przez CoreWeave), zrozumiemy, dlaczego ostatecznie uczenie przez wzmacnianie i dostrajanie zwyciężyły jako dominujące podejście do optymalizacji modeli AI oraz co to oznacza dla przyszłości infrastruktury AI.

Podstawą rewolucji w dostrajaniu jest zrozumienie fundamentalnej ekonomii wdrażania modeli AI. Gdy GPT-4 pojawił się na początku 2023 roku, stanowił bezprecedensowy skok możliwości, ale wiązał się z równie wysokim wzrostem kosztów. Organizacje prowadzące produkcyjne obciążenia stanęły przed twardą rzeczywistością: korzystanie z modeli czołowych, takich jak GPT-4, do każdego wnioskowania było ekonomicznie nieopłacalne — niektóre firmy wydawały setki tysięcy dolarów miesięcznie na zapytania do OpenAI. Powstała wyraźna luka rynkowa, która wymagała rozwiązania. Kluczowe spostrzeżenie było eleganckie, lecz potężne: jeśli uda się uchwycić konkretne wzorce i zachowania GPT-4 dla własnych zastosowań, można zdestylować tę wiedzę do mniejszego, tańszego modelu, który działałby niemal tak samo dobrze w określonych przepływach pracy, przy ułamku kosztów. Nie chodziło o całkowite zastąpienie GPT-4, lecz o optymalizację stosunku kosztu do jakości w produkcyjnych systemach, gdzie każda decyzja wnioskowania miała znaczenie ekonomiczne.

Wyzwanie polegało jednak na tym, że dostępne wówczas modele otwartoźródłowe nie były na tyle zaawansowane, by można je było używać jako zamienniki GPT-4. Modele takie jak Llama 2, choć imponujące jak na swoje czasy, miały znaczące braki jakościowe względem modeli czołowych. Powstała sytuacja trzystronna: modele czołowe były zbyt drogie, otwartoźródłowe zbyt słabe, a nie było jasnej ścieżki umożliwiającej organizacjom efektywne zniwelowanie tej luki. Rynek potrzebował rozwiązania, które pozwoliłoby przejąć możliwości modeli czołowych i systematycznie przenieść je do mniejszych, otwartoźródłowych modeli w sposób technicznie poprawny i operacyjnie prosty do wdrożenia przez deweloperów.

Pojawienie się dostrajania jako nowej kategorii usług oznaczało fundamentalną zmianę w podejściu organizacji do optymalizacji modeli AI. Podejście OpenPipe zostało zaprojektowane tak, aby było maksymalnie bezproblemowe dla deweloperów. Firma stworzyła SDK będące zamiennikiem SDK OpenAI, dzięki czemu deweloperzy mogli nadal używać GPT-4 w produkcji bez żadnych zmian w kodzie. W tle OpenPipe przechwytywał każde żądanie i odpowiedź, budując zbiór realnych przykładów pokazujących, jak GPT-4 zachowuje się przy konkretnych zadaniach organizacji. Było to kluczowe spostrzeżenie: najlepsze dane do dostrajania to nie dane syntetyczne czy ogólne, ale właśnie produkcyjne zapytania i odpowiedzi odzwierciedlające pożądane zachowanie. Po zgromadzeniu odpowiedniej liczby przykładów, organizacja mogła uruchomić proces dostrajania, który trenował mniejszy model do replikowania zachowań GPT-4 w wybranych przypadkach użycia. Efektem był punkt końcowy API będący bezpośrednim zamiennikiem — deweloper zmieniał tylko adres URL inferencji i aplikacja kontynuowała działanie z nowym, tańszym modelem.

To podejście okazało się niezwykle skuteczne na rynku. OpenPipe uruchomił produkt w sierpniu 2023 roku i w ciągu miesiąca zdobył pierwszych trzech klientów. Oferta była na tyle przekonująca, że firma szybko osiągnęła znaczące przychody, zdobywając milion dolarów rocznego powtarzalnego przychodu (ARR) w ok. osiem miesięcy od startu. Tak szybkie tempo pokazało, że problem rynku był realny, a organizacje rozpaczliwie szukały sposobów na obniżenie kosztów infrastruktury AI. Pierwsi klienci to zwykle firmy z największymi problemami: prowadzące duże produkcyjne obciążenia i generujące ogromne rachunki za API. Dla nich możliwość obniżenia kosztów nawet 10-krotnie przy zachowaniu jakości była rewolucyjna. Kategoria usług dostrajania znalazła swoje miejsce na rynku, a organizacje były gotowe na nowy sposób optymalizacji modeli AI.

Na rozwój działalności OpenPipe istotny wpływ miało pojawienie się wysokiej jakości modeli otwartoźródłowych, szczególnie Mistral i Mixtral. Modele te stanowiły przełom w branży dostrajania, ponieważ były wiarygodnymi alternatywami dla zamkniętych modeli o wysokiej wydajności. Mistral był wręcz objawieniem — przewyższał Llama 2 i był dostępny na otwartej licencji Apache 2.0, co w tamtym czasie było dużą zaletą dla organizacji dbających o kwestie licencyjne i własność intelektualną. Pojawienie się takich modeli stworzyło “złoty okres” dla startupów zajmujących się dostrajaniem, bo nagle istniała otwartoźródłowa baza, którą można było dostroić i wdrożyć w produkcji z pełnym zaufaniem do jej jakości i aspektów prawnych.

W tym okresie kluczową techniką stała się Low-Rank Adaptation (LoRA), która zasadniczo zmieniła ekonomię dostrajania i wnioskowania. LoRA to metoda radykalnie ograniczająca liczbę uczących się parametrów podczas dostrajania, co niesie za sobą szereg konsekwencji. Po pierwsze, obniża wymagania pamięciowe podczas treningu, umożliwiając dostrajanie większych modeli na mniejszych GPU. Po drugie, skraca czas treningu, co pozwala organizacjom na szybszą iterację workflow dostrajania. Najważniejsza korzyść LoRA ujawnia się jednak podczas wnioskowania: wdrażając model z adapterem LoRA, można uruchamiać wiele różnych adapterów LoRA na tej samej karcie GPU. Oznacza to, że zamiast potrzebować osobnych zasobów GPU dla każdej dostrojonej wersji, można na jednym wdrożeniu uruchomić dziesiątki, a nawet setki różnych adapterów LoRA. Ta architektoniczna przewaga umożliwiła zupełnie nowy model rozliczania — zamiast opłat za godzinę GPU (co zachęca do trzymania GPU stale zajętych), firmy mogły rozliczać się za tokeny, przekazując efektywność bezpośrednio klientom. To przejście z rozliczeń za GPU na rozliczenia za token było dużą innowacją w sposobie monetyzacji i wdrażania inferencji AI.

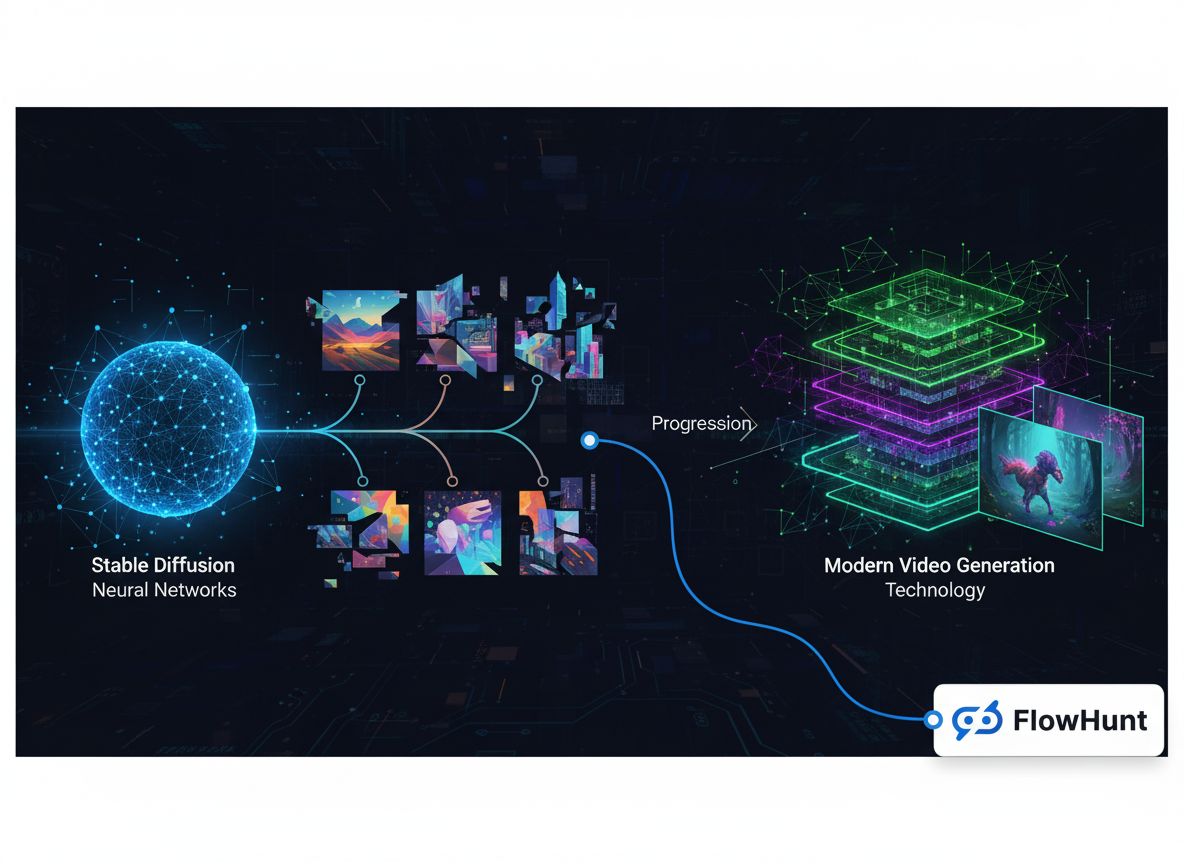

Wraz z ewolucją rynku dostrajania, coraz bardziej widoczna stała się potrzeba zaawansowanej automatyzacji przepływów pracy. Organizacje zarządzające wieloma eksperymentami dostrajania, porównujące architektury modeli i optymalizujące hiperparametry, potrzebowały narzędzi, które potrafią efektywnie orkiestracją te złożone procesy. Tu kluczowe stają się platformy takie jak FlowHunt — zapewniają one infrastrukturę do automatyzacji całego pipeline’u dostrajania: od przygotowania danych, przez trening modelu, po ewaluację i wdrożenie. FlowHunt umożliwia tworzenie zaawansowanych workflow, które automatycznie przechwytują dane produkcyjne, uruchamiają zadania dostrajania po spełnieniu określonych warunków, oceniają wydajność modeli względem bazowych wyników i wdrażają nowe modele do produkcji przy minimalnej ręcznej ingerencji. Automatyzując te procesy, organizacje mogą szybciej iterować strategie dostrajania, eksperymentować z różnymi podejściami i stale ulepszać modele bez konieczności ciągłego nadzoru. Możliwość integracji platformy z różnymi dostawcami infrastruktury AI i repozytoriami modeli pozwala budować end-to-endową automatyzację obejmującą cały cykl rozwoju AI.

Mimo silnego początkowego zainteresowania i realnej szansy rynkowej, OpenPipe i inne firmy dostrajające modele stanęły w obliczu coraz trudniejszego otoczenia konkurencyjnego. Główną presję wywierały laboratoria czołowych modeli, takie jak OpenAI, Anthropic i inni, które systematycznie wypuszczały coraz lepsze modele po niższych cenach. To powodowało nieustanny spadek atrakcyjności usług dostrajania: wraz ze spadkiem cen modeli czołowych, oszczędności z dostrajania mniejszych modeli malały. Model, który pozwalał zaoszczędzić 10x przy drogim GPT-4, stawał się mniej atrakcyjny, gdy ceny GPT-4 spadały o 5x lub więcej. Dodatkowo, dostawcy GPU i chmur zaczęli integrować możliwości dostrajania bezpośrednio w swoich ofertach, widząc, że dostrajanie zwiększa lojalność klientów i zużycie infrastruktury. Jednak te oferty często były słabe pod względem doświadczenia deweloperskiego — trudne w użyciu, słabo udokumentowane i nieintegrowane z rzeczywistymi workflow deweloperów. Oznaczało to, że zagrożenie konkurencyjne istniało teoretycznie, ale nie materializowało się tak mocno w praktyce, bo rozwiązania dostawców GPU zwyczajnie nie były wystarczająco dobre produktowo.

Jednak najistotniejsza presja konkurencyjna płynęła z ciągłej poprawy modeli otwartoźródłowych. Wraz z rozwojem modeli takich jak Llama 2, Mistral, a później Llama 3, różnice jakościowe między otwartymi a czołowymi modelami malały. Oznaczało to, że organizacje mogły coraz częściej korzystać z modeli otwartych bezpośrednio, bez potrzeby ich dostrajania lub mogły dostrajać je samodzielnie, bez zewnętrznej usługi. Dynamika rynku przesunęła się z „musimy destylować GPT-4, bo jest za drogi” do „możemy po prostu użyć otwartoźródłowego modelu bezpośrednio”. Ta fundamentalna zmiana sprawiła, że wartość samodzielnych firm dostrajających zaczęła zanikać, bo ich kluczowa propozycja — łączenie drogich modeli czołowych ze słabymi otwartymi — przestała być aktualna. Okno możliwości dla niezależnych firm dostrajających zamykało się wraz z konsolidacją rynku wokół większych dostawców infrastruktury, którzy mogli oferować kompleksowe rozwiązania obejmujące trening, dostrajanie i inferencję modeli.

Tytuł „Dlaczego RL zwyciężyło” odzwierciedla głębszą prawdę o ewolucji optymalizacji modeli AI: uczenie przez wzmacnianie i techniki dostrajania stały się dominującym paradygmatem adaptowania modeli do konkretnych zastosowań. To zwycięstwo nie było oczywiste — wyrosło z połączenia innowacji technicznej, sił rynkowych i ograniczeń alternatywnych metod. Uczenie przez wzmacnianie, szczególnie w kontekście dostrajania, pozwala optymalizować modele nie tylko pod kątem dokładności na określonym zadaniu, ale także pod rzeczywiste cele biznesowe. Zamiast wyłącznie replikować zachowanie modelu czołowego, uczenie przez wzmacnianie pozwala trenować modele pod konkretne metryki — takie jak satysfakcja użytkownika, wskaźnik realizacji zadania czy wyniki biznesowe. To znacznie bardziej zaawansowane podejście do optymalizacji niż klasyczne nadzorowane dostrajanie.

Zwycięstwo RL i dostrajania odzwierciedla również fakt, że uniwersalne modele — niezależnie od ich możliwości — nigdy nie będą optymalne dla każdego zastosowania. Organizacje mają własne wymagania, rozkłady danych i cele wydajnościowe. Model dostrojony na twoich danych i zoptymalizowany pod twoje cele zawsze przewyższy ogólny model czołowy na twoich zadaniach. Ta zasada sprawdza się od dekad w uczeniu maszynowym i pozostaje aktualna w erze dużych modeli językowych. Pojawienie się takich technik, jak LoRA, uczyniło dostrajanie ekonomicznie opłacalnym nawet dla mniejszych firm, demokratyzując dostęp do optymalizacji modeli. Dostępność wysokiej jakości modeli otwartoźródłowych stworzyła bazę do dostrajania bez potrzeby korzystania z drogich API modeli czołowych. Rozwój lepszych technik treningowych i infrastruktury sprawił, że sam proces dostrajania jest szybszy i bardziej niezawodny. Te czynniki wspólnie stworzyły środowisko, w którym dostrajanie i uczenie przez wzmacnianie stały się naturalnym wyborem dla organizacji optymalizujących modele AI do własnych zastosowań.

Przejęcie OpenPipe przez CoreWeave to ważny kamień milowy w konsolidacji rynku infrastruktury AI. CoreWeave, czołowy dostawca infrastruktury GPU i mocy obliczeniowej dla AI, zrozumiał, że możliwości dostrajania są kluczowe dla ich wartości rynkowej. Przejmując OpenPipe, CoreWeave zyskał nie tylko technologię i know-how, ale także zespół doskonale rozumiejący workflow dostrajania oraz potrzeby organizacji optymalizujących modele AI. To przejęcie odzwierciedla szerszy trend: konsolidację usług specjalistycznych w zintegrowane platformy. Zamiast osobnych firm od treningu, dostrajania, inferencji i monitoringu, rynek zmierza ku platformom obsługującym cały cykl życia AI. Konsolidacja ma sens z wielu powodów: ogranicza tarcia dla klientów, którzy nie muszą integrować wielu usług, buduje efekty sieciowe poprzez ścisłą integrację komponentów i pozwala oferować bardziej konkurencyjne ceny dzięki optymalizacji całego stosu.

Przejęcie potwierdza też, że rynek samodzielnych usług dostrajania — choć realny — okazał się zbyt wąski, by utrzymać wiele niezależnych firm. Rynek był ściskany z kilku stron: modele czołowe taniały, otwarte poprawiały się, a dostawcy GPU integrowali dostrajanie. W takich warunkach najrozsądniejszą drogą dla firmy dostrajającej było dołączenie do większej platformy infrastrukturalnej oferującej kompleksowe rozwiązania. Przejęcie OpenPipe przez CoreWeave umożliwia oferowanie kompletnych rozwiązań dla organizacji: dostęp do GPU, możliwości dostrajania i wdrażania modeli, wszystko w jednej platformie. To naturalna ewolucja rynku w stronę dojrzałości i konsolidacji wokół większych, kompleksowych platform.

Przez całą drogę OpenPipe i szerzej — ewolucję rynku dostrajania — jeden motyw przewija się stale: doświadczenie deweloperskie ma fundamentalne znaczenie. Dostawcy GPU oferowali usługi dostrajania, ale były one trudne w obsłudze i słabo zintegrowane z workflow deweloperów. Początkowy sukces OpenPipe wynikał nie z zupełnie innej technologii, lecz z radykalnie lepszego doświadczenia deweloperskiego. Zamiennik SDK, automatyczne zbieranie danych, proste zarządzane workflow — wszystko to miało na celu uczynienie dostrajania łatwym i bezproblemowym dla deweloperów. Ta obserwacja okazała się prorocza. Pojawianie się nowych modeli i możliwości AI jest często napędzane nie tyle przewagą techniczną, co właśnie lepszym doświadczeniem deweloperskim. Gdy Anthropic uruchomił Claude z dobrze zaprojektowanym API i świetną dokumentacją, deweloperzy szybko to przyjęli. Gdy OpenAI wypuściło GPT-4 z intuicyjnym interfejsem, został on wyborem domyślnym dla wielu organizacji. Wniosek jest jasny: w infrastrukturze AI doświadczenie deweloperskie nie jest dodatkiem — to kluczowa przewaga konkurencyjna.

Zasada ta rozszerza się na cały ekosystem narzędzi i platform AI. FlowHunt, na przykład, odnosi sukcesy, oferując lepsze doświadczenie deweloperskie w budowaniu i automatyzacji workflow AI. Zamiast wymagać pisania skryptów czy ręcznego zarządzania infrastrukturą, FlowHunt proponuje interfejs wizualny i proste abstrakcje, które ułatwiają tworzenie zaawansowanych przepływów pracy. To skupienie na doświadczeniu dewelopera pozwala platformom zdobywać użytkowników i budować efekty sieciowe. Im więcej deweloperów korzysta z platformy, tym więcej powstaje integracji, szablonów i wartości dla wszystkich. Ta pozytywna spirala — lepsze doświadczenie → większa adopcja — jest kluczowym motorem sukcesu na rynku infrastruktury AI.

{{ cta-dark-panel heading=“Przyspiesz swoje workflow z FlowHunt” description=“Sprawdź, jak FlowHunt automatyzuje tworzenie treści AI i workflow SEO — od badań, generowania treści po publikację i analitykę — wszystko w jednym miejscu.” ctaPrimaryText=“Umów się na demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Wypróbuj FlowHunt za darmo” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Patrząc w przyszłość, krajobraz dostrajania będzie nadal ewoluował pod wpływem kilku kluczowych trendów. Po pierwsze, wraz z poprawą i tanieniem modeli czołowych, wartość dostrajania przesunie się z „obniż koszt drogich modeli” na „optymalizuj modele pod konkretne zastosowania i cele”. To bardziej zaawansowana oferta wymagająca lepszych narzędzi do oceny, kiedy dostrajanie ma sens, jak mierzyć jego wpływ i jak stale poprawiać dostrojone modele. Po drugie, integracja dostrajania z większymi platformami infrastruktury AI będzie postępować — firmy takie jak CoreWeave będą oferować kompleksowe rozwiązania obejmujące compute, trening, dostrajanie i inferencję. Konsolidacja ułatwi organizacjom wdrażanie dostrajania jako elementu strategii AI, ale ograniczy liczbę niezależnych firm na rynku. Po trzecie, techniki takie jak LoRA i inne efektywne metody dostrajania parametrów będą coraz ważniejsze, gdy organizacje będą zarządzać złożonością wdrażania wielu wariantów modeli. Możliwość uruchamiania różnych dostrojonych modeli na wspólnej infrastrukturze stanie się kluczową przewagą.

Wreszcie, pojawienie się nowych możliwości AI i architektur modeli stworzy nowe szanse dla dostrajania i optymalizacji. Wraz ze wzrostem możliwości i specjalizacji modeli, potrzeba ich dostrajania do konkretnych zastosowań będzie tylko rosła. Firmy i platformy, które potrafią uczynić dostrajanie łatwiejszym, szybszym i skuteczniejszym, będą zwycięzcami w tym zmieniającym się krajobrazie. Historia OpenPipe i rynku dostrajania pokazuje, że w AI często wygrywają ci, którzy łączą innowacyjność techniczną z doskonałym doświadczeniem deweloperskim i głębokim zrozumieniem potrzeb klientów. W miarę dojrzewania rynku te zasady pozostaną kluczowe dla sukcesu.

Droga OpenPipe — od startupu rozwiązującego problem wysokich kosztów modeli czołowych do przejęcia przez CoreWeave — pokazuje dynamiczny charakter rynku infrastruktury AI. Sukces firmy, która osiągnęła milion dolarów ARR w osiem miesięcy od startu, dowiódł realnego zapotrzebowania na rozwiązania do dostrajania, lecz późniejsza konsolidacja pokazała, że samodzielne usługi dostrajania napotykają strukturalne wyzwania w sytuacji spadających cen modeli czołowych i rosnącej jakości alternatyw otwartoźródłowych. Zwycięstwo uczenia przez wzmacnianie i dostrajania jako dominującego paradygmatu wynika nie z jednego przełomu technologicznego, lecz z konwergencji wielu czynników: dostępności wysokiej jakości modeli otwartoźródłowych, rozwoju efektywnych technik jak LoRA, nowych narzędzi i infrastruktury oraz podstawowej zasady, że modele wyspecjalizowane przewyższają ogólne. Przejęcie OpenPipe przez CoreWeave to naturalna ewolucja rynku ku platformom oferującym kompleksowe rozwiązania w całym cyklu życia AI. Wraz z dojrzewaniem rynku, sukces będzie coraz bardziej zależeć od doskonałego doświadczenia deweloperskiego, głębokiej integracji w całym stosie AI i umiejętności pomagania organizacjom w optymalizacji modeli pod własne zastosowania i cele biznesowe.

Dostrajanie modelu to proces adaptowania już wytrenowanego modelu AI do konkretnych zadań poprzez uczenie na danych domenowych. Jest to ważne, ponieważ pozwala organizacjom wykorzystać możliwości dużych modeli językowych, jednocześnie optymalizując je pod konkretne zastosowania, co obniża koszty i poprawia efektywność w wybranych przepływach pracy.

LoRA (Low-Rank Adaptation) zmniejsza liczbę uczących się parametrów podczas dostrajania, co redukuje wymagania pamięciowe i skraca czas treningu. Co ważniejsze, podczas wnioskowania LoRA umożliwia uruchamianie wielu dostrojonych modeli na tej samej karcie GPU przez multipleksację, co pozwala na rozliczanie za token zamiast za godzinę GPU oraz zapewnia większą elastyczność wdrożeń.

Otwartoźródłowe modele takie jak Mistral stanowiły wiarygodną alternatywę dla zamkniętych modeli dzięki wysokiej jakości oraz liberalnym licencjom (Apache 2.0). Wypełniły lukę między drogimi modelami czołowymi a słabszymi otwartymi opcjami, czyniąc je idealnymi kandydatami do dostrajania i destylacji.

Szybki spadek cen tokenów modeli czołowych, pojawienie się coraz lepszych modeli otwartoźródłowych oraz integracja możliwości dostrajania przez dostawców GPU zwiększyły presję konkurencyjną. Dodatkowo, korzyści z samodzielnych usług dostrajania malały, gdy różnice cenowe między modelami czołowymi a otwartymi się zmniejszały, prowadząc do konsolidacji rynku.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Automatyzuj procesy dostrajania i optymalizacji modeli dzięki inteligentnej automatyzacji przepływów pracy.

Poznaj przełomowe osiągnięcia AI z 11 grudnia, w tym premierę GPT 5.2 od OpenAI, wydania open-source, przejście MCP pod egidę Linux Foundation oraz krajobraz ko...

OpenAI wprowadza usługi konsultingowe AI z minimalnym progiem 10 mln dolarów, naśladując strategię Forward Deployed Engineer firmy Palantir. Dowiedz się, jak au...

Poznaj techniczną ewolucję platform mediów generatywnych – od wczesnych modeli obrazowych po nowoczesne generowanie wideo – oraz jak specjalistyczna optymalizac...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.