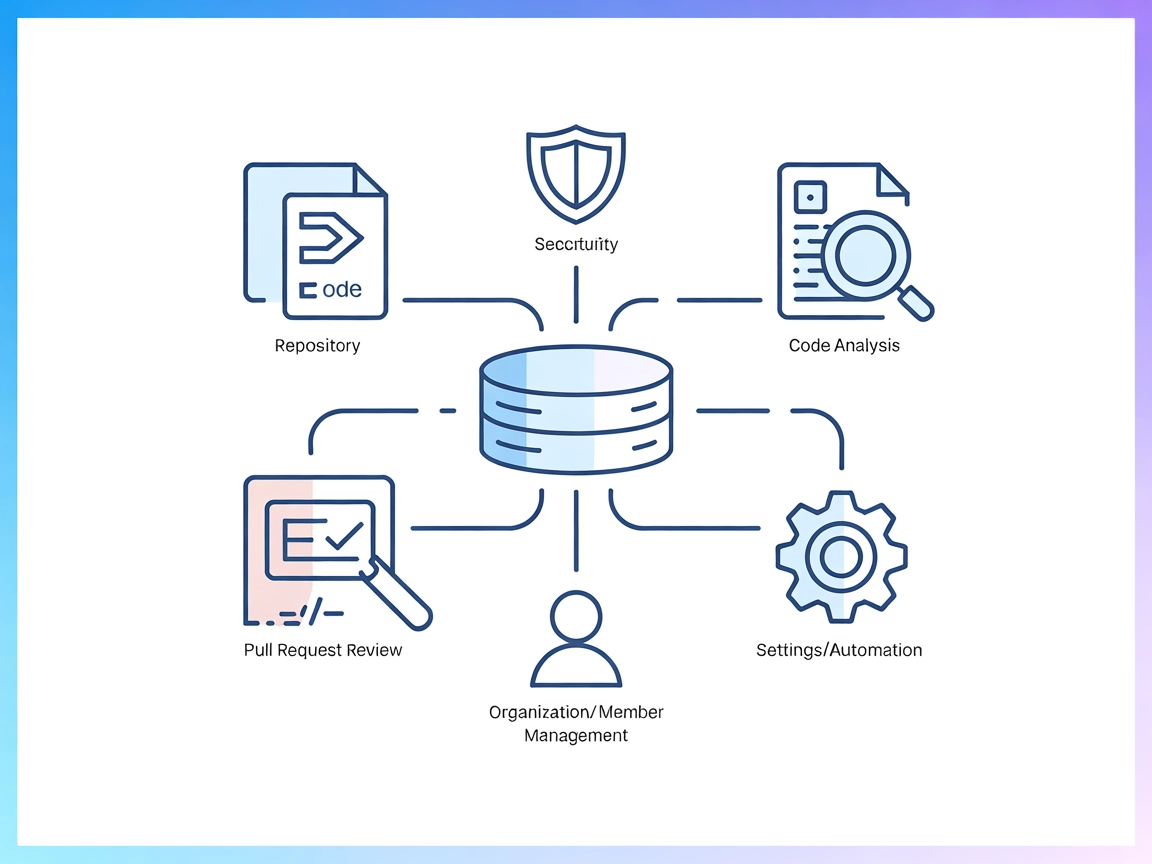

Integracja serwera Codacy MCP

Serwer Codacy MCP łączy asystentów AI z platformą Codacy, umożliwiając automatyczną kontrolę jakości kodu, analizę bezpieczeństwa, zarządzanie repozytoriami ora...

Uruchamiaj kod Python, instaluj zależności i zarządzaj izolowanymi środowiskami bezpośrednio w swoich przepływach FlowHunt dzięki MCP Code Executor MCP Server.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

MCP Code Executor to serwer MCP (Model Context Protocol), który umożliwia modelom językowym (LLM) wykonywanie kodu Python w wyznaczonym środowisku Python, takim jak Conda, virtualenv lub UV virtualenv. Łącząc asystentów AI z rzeczywistymi, wykonywalnymi środowiskami Python, pozwala im realizować szeroki zakres zadań deweloperskich wymagających wykonania kodu, zarządzania bibliotekami oraz dynamicznego przygotowania środowiska. Serwer obsługuje inkrementalne generowanie kodu, by obejść ograniczenia tokenów, pozwala na instalację zależności w locie, a także ułatwia konfigurowanie środowiska uruchomieniowego. Programiści mogą wykorzystać to narzędzie do automatycznej oceny kodu, eksperymentowania z nowymi pakietami oraz zarządzania obliczeniami w kontrolowanym i bezpiecznym środowisku.

Brak explicite zdefiniowanych szablonów promptów w repozytorium lub dokumentacji.

Brak szczegółowo opisanych zasobów w repozytorium lub dokumentacji.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Uwaga: Możesz także użyć Dockera. Dostarczony Dockerfile został przetestowany dla środowiska

venv-uv:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Używanie MCP w FlowHunt

Aby zintegrować serwery MCP z workflow FlowHunt, rozpocznij od dodania komponentu MCP do swojego przepływu i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemu MCP wstaw dane serwera MCP w tym formacie JSON:

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może już korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, by zamienić “mcp-code-executor” na faktyczną nazwę swojego serwera MCP i wstawić swój własny adres URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Nie znaleziono szablonów promptów |

| Lista zasobów | ⛔ | Brak opisanych zasobów |

| Lista narzędzi | ✅ | execute_code, install_dependencies, check_installed_packages |

| Zabezpieczanie kluczy API | ✅ | Przykład z inputami env |

| Sampling Support (mniej istotne w ewaluacji) | ⛔ | Nie określono |

Ten serwer MCP oferuje kluczową i solidną funkcjonalność wykonywania kodu z integracją LLM, wraz z jasnymi instrukcjami konfiguracji i narzędziami. Brakuje jednak szablonów promptów, explicitnie opisanych zasobów oraz informacji o roots czy sampling support. Jak na MCP skupiony na wykonywaniu kodu jest bardzo mocny, wysoko oceniany za praktyczną użyteczność i łatwość integracji, ale traci punkty za brak zaawansowanych funkcji MCP i kompletności dokumentacji.

| Czy posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Czy ma przynajmniej jedno narzędzie | ✅ |

| Liczba Forków | 25 |

| Liczba Gwiazdek | 144 |

To serwer Model Context Protocol (MCP), który umożliwia modelom językowym wykonywanie kodu Python w bezpiecznych, izolowanych środowiskach (takich jak Conda lub venv), zarządzanie zależnościami i konfigurację środowiska uruchomieniowego. Idealny do oceny kodu, data science, automatycznych workflow oraz dynamicznego przygotowania środowisk z FlowHunt.

Udostępnia narzędzia do wykonywania kodu Python (`execute_code`), instalowania zależności na żądanie (`install_dependencies`) oraz sprawdzania zainstalowanych pakietów (`check_installed_packages`).

Dodaj MCP Code Executor jako komponent MCP w swoim przepływie, a następnie skonfiguruj go z adresem URL serwera i metodą transportu. Dzięki temu Twoje agenty AI mogą korzystać z wykonania kodu i zarządzania środowiskiem w FlowHunt.

Tak, serwer obsługuje uruchamianie kodu w izolowanych środowiskach Conda lub virtualenv, co zapewnia powtarzalność i zapobiega konfliktom zależności.

Tak, serwer potrafi wykonywać kod inkrementalnie, co przydaje się przy obsłudze kodu przekraczającego limity tokenów LLM.

Tak, możesz użyć dostarczonego pliku Dockerfile i skonfigurować serwer MCP do uruchamiania w kontenerze Docker dla dodatkowej izolacji.

Wzmocnij swoje przepływy bezpiecznym, automatycznym wykonywaniem kodu Python. Zintegruj MCP Code Executor MCP Server i odblokuj dynamiczne workflow dla data science, automatyzacji i nie tylko.

Serwer Codacy MCP łączy asystentów AI z platformą Codacy, umożliwiając automatyczną kontrolę jakości kodu, analizę bezpieczeństwa, zarządzanie repozytoriami ora...

Serwer Coda MCP zapewnia ustandaryzowany sposób interakcji asystentów AI z platformą Coda, umożliwiając zapytania do dokumentów, automatyzację workflow oraz zgo...

Serwer CodeLogic MCP łączy FlowHunt i asystentów programowania AI ze szczegółowymi danymi o zależnościach oprogramowania CodeLogic, umożliwiając zaawansowaną an...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.