OpenAPI Schema Explorer MCP Server

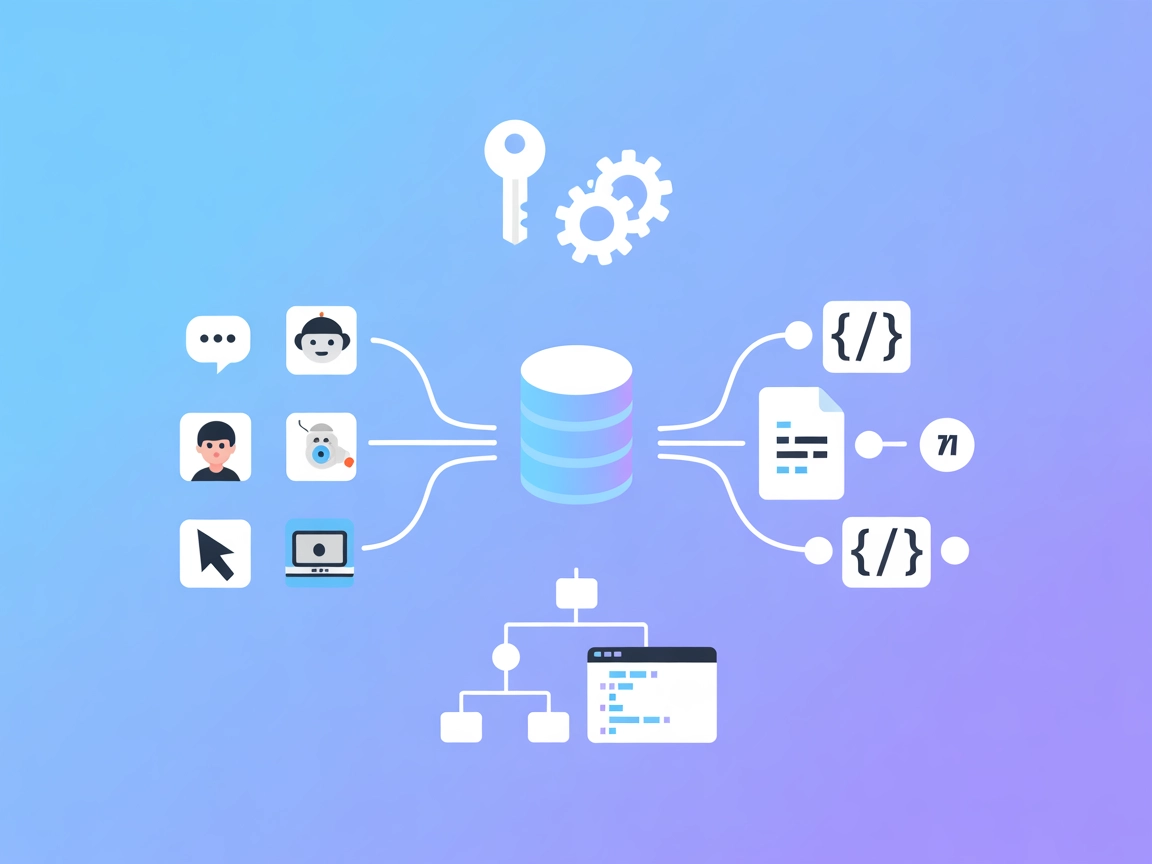

Serwer OpenAPI Schema Explorer MCP umożliwia wydajny, strukturalny dostęp do specyfikacji OpenAPI/Swagger jako zasobów MCP, łącząc asystentów AI i deweloperów z...

Umożliwiaj asystentom AI semantyczne wykrywanie, odczytywanie i interakcję z dowolnym API zgodnym z OpenAPI. Idealne do dynamicznej integracji prywatnych API w FlowHunt.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

“Dowolny serwer MCP OpenAPI” to narzędzie zaprojektowane do łączenia asystentów AI — takich jak Claude — z dowolnym zewnętrznym API udostępniającym specyfikację OpenAPI (Swagger). Umożliwia semantyczne przeszukiwanie rozbudowanych dokumentacji OpenAPI, inteligentnie dzieląc endpointy na fragmenty, co pozwala na ich szybkie wykrywanie i interakcję. Dzięki temu klienci AI mogą znajdować istotne endpointy API poprzez zapytania w języku naturalnym (np. “wylistuj produkty”), natychmiast pobierać pełną dokumentację endpointów i wykonywać zapytania API bezpośrednio z serwera. Serwer ten idealnie nadaje się do integracji prywatnych lub dużych API z przepływami pracy opartymi na AI, usprawniając operacje, takie jak zapytania do baz danych czy niestandardowe integracje API, bez konieczności częstych ręcznych aktualizacji.

Brak konkretnych szablonów promptów wymienionych w dostępnej dokumentacji lub kodzie.

W dostępnej dokumentacji lub kodzie nie opisano ani nie wymieniono jawnych zasobów MCP.

@any-openapi/mcp-server@latest do obiektu mcpServers.OPENAPI_JSON_DOCS_URL).Przykładowy JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

Zabezpieczanie kluczy API:

{

"env": {

"API_KEY": "${ANY_OPENAPI_API_KEY}"

},

"inputs": {

"apiKey": "${ANY_OPENAPI_API_KEY}"

}

}

Przykładowy JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

@any-openapi/mcp-server@latest.Przykładowy JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

@any-openapi/mcp-server@latest.Przykładowy JSON:

{

"mcpServers": {

"any-openapi": {

"command": "npx",

"args": ["@any-openapi/mcp-server@latest"],

"env": {

"OPENAPI_JSON_DOCS_URL": "https://yourapi.com/openapi.json"

}

}

}

}

Zabezpieczanie kluczy API:

Używaj zmiennych środowiskowych jak powyżej, by nie ujawniać wrażliwych danych.

Używanie MCP w FlowHunt

Aby zintegrować serwery MCP z przepływem pracy w FlowHunt, rozpocznij od dodania komponentu MCP do swojego przepływu i połącz go z agentem AI:

Kliknij komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wstaw szczegóły swojego serwera MCP w tym formacie JSON:

{

"any-openapi": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia z dostępem do wszystkich jego funkcji i możliwości. Pamiętaj, by zmienić “any-openapi” na faktyczną nazwę Twojego serwera MCP i podać poprawny adres URL.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Przegląd | ✅ | |

| Lista promptów | ⛔ | Brak znalezionych |

| Lista zasobów | ⛔ | Brak znalezionych |

| Lista narzędzi | ✅ | Dwa narzędzia: wykrywanie & wykonanie |

| Zabezpieczanie kluczy API | ✅ | Poprzez zmienne środowiskowe |

| Wsparcie próbkowania (mało istotne przy ocenie) | ⛔ | Nie wspomniano |

Wsparcie dla roots: Nie określono w dostępnej dokumentacji lub kodzie.

Na podstawie dostarczonej dokumentacji i powyższego zestawienia, ten serwer MCP jest wyspecjalizowany, funkcjonalny i dobrze dostosowany do integracji API oraz dynamicznego wykrywania endpointów, choć nie posiada jawnych przykładowych promptów/zasobów ani dokumentacji dotyczącej próbkowania czy obsługi roots. Jego konfiguracja i praktyki bezpieczeństwa są czytelne i standardowe.

Ten serwer MCP jest bardzo praktyczny dla programistów potrzebujących integracji rozbudowanych lub prywatnych API z asystentami AI, szczególnie z Claude’em. Jego użyteczność jest wysoka pod kątem semantycznego wykrywania endpointów i bezpośredniego wykonywania zapytań API, choć przydałaby się pełniejsza dokumentacja i definicja zasobów. Ogólnie to solidny, wyspecjalizowany serwer, choć nie w pełni kompleksowy przykład wszystkich możliwości MCP.

Ocena: 7/10

| Posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Ma przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 12 |

| Liczba gwiazdek | 52 |

Pozwala asystentom AI, takim jak Claude, łączyć się z dowolnym zewnętrznym API udostępniającym specyfikację OpenAPI (Swagger). Umożliwia inteligentne, semantyczne wykrywanie endpointów i bezpośrednie wykonywanie zapytań API, dzięki czemu integracja prywatnych lub rozbudowanych API jest bezproblemowa.

Serwer jest zaprojektowany dla Claude'a, ale działa z dowolnym klientem AI obsługującym serwery MCP, w tym Windsurf, Cursor i Cline.

Wykorzystuje wyszukiwanie semantyczne w pamięci (FAISS z MiniLM-L3), aby znaleźć odpowiednie endpointy w dokumentach OpenAPI na podstawie zapytań w języku naturalnym.

Tak. Zawsze używaj zmiennych środowiskowych do kluczy API i innych wrażliwych danych, jak pokazano w przykładach konfiguracji.

Tak. Po wykryciu odpowiedniego endpointu serwer umożliwia AI wykonywanie zapytań API, pobierając na żywo dane lub wykonując operacje za pomocą API.

Integracja prywatnych API, automatyzacja przepływów takich jak wystawianie produktów lub zarządzanie użytkownikami oraz szybkie wykrywanie i wykorzystanie endpointów w dużych API.

Zwiększ możliwości swoich przepływów AI, łącząc Claude'a lub innych asystentów z dowolnym API opartym na OpenAPI. Doświadcz bezproblemowych, bezpiecznych i dynamicznych integracji API!

Serwer OpenAPI Schema Explorer MCP umożliwia wydajny, strukturalny dostęp do specyfikacji OpenAPI/Swagger jako zasobów MCP, łącząc asystentów AI i deweloperów z...

OpenAPI MCP Server łączy asystentów AI z możliwością eksploracji i zrozumienia specyfikacji OpenAPI, oferując szczegółowy kontekst API, podsumowania i informacj...

Serwer OpenSearch MCP umożliwia bezproblemową integrację OpenSearch z FlowHunt i innymi agentami AI, pozwalając na programistyczny dostęp do funkcji wyszukiwani...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.