Hugging Face Transformers

Hugging Face Transformers je popredná open-source knižnica v jazyku Python, ktorá uľahčuje implementáciu Transformer modelov pre úlohy strojového učenia v oblas...

Komplexný sprievodca modernými stratégiami predtrénovania jazykových modelov, technikami kurácie dát a optimalizačnými metódami používanými HuggingFace na vytváranie efektívnych, vysoko výkonných open-source modelov.

Vývoj jazykových modelov prešiel v posledných rokoch zásadnou premenou. Zatiaľ čo veľké technologické firmy stále posúvajú hranice veľkosti modelov, open-source komunita zistila, že špičkový výkon nevyžaduje modely s biliónmi parametrov. Tento komplexný sprievodca skúma najmodernejšie techniky a stratégie, ktoré výskumníci z HuggingFace využívajú na tvorbu efektívnych, výkonných jazykových modelov prostredníctvom dôsledných metodík predtrénovania. Pozrieme sa, ako SmolLM 3, FineWeb a FinePDF predstavujú novú paradigmu vo vývoji modelov — zameranú na maximalizáciu výkonu v rámci praktických výpočtových obmedzení so zachovaním vedeckej dôslednosti a reprodukovateľnosti. Zistenia tu prezentované sú výsledkom mesiacov výskumu a experimentovania a ponúkajú majstrovský pohľad na to, ako pristupovať k predtrénovaniu modelov v modernej dobe.

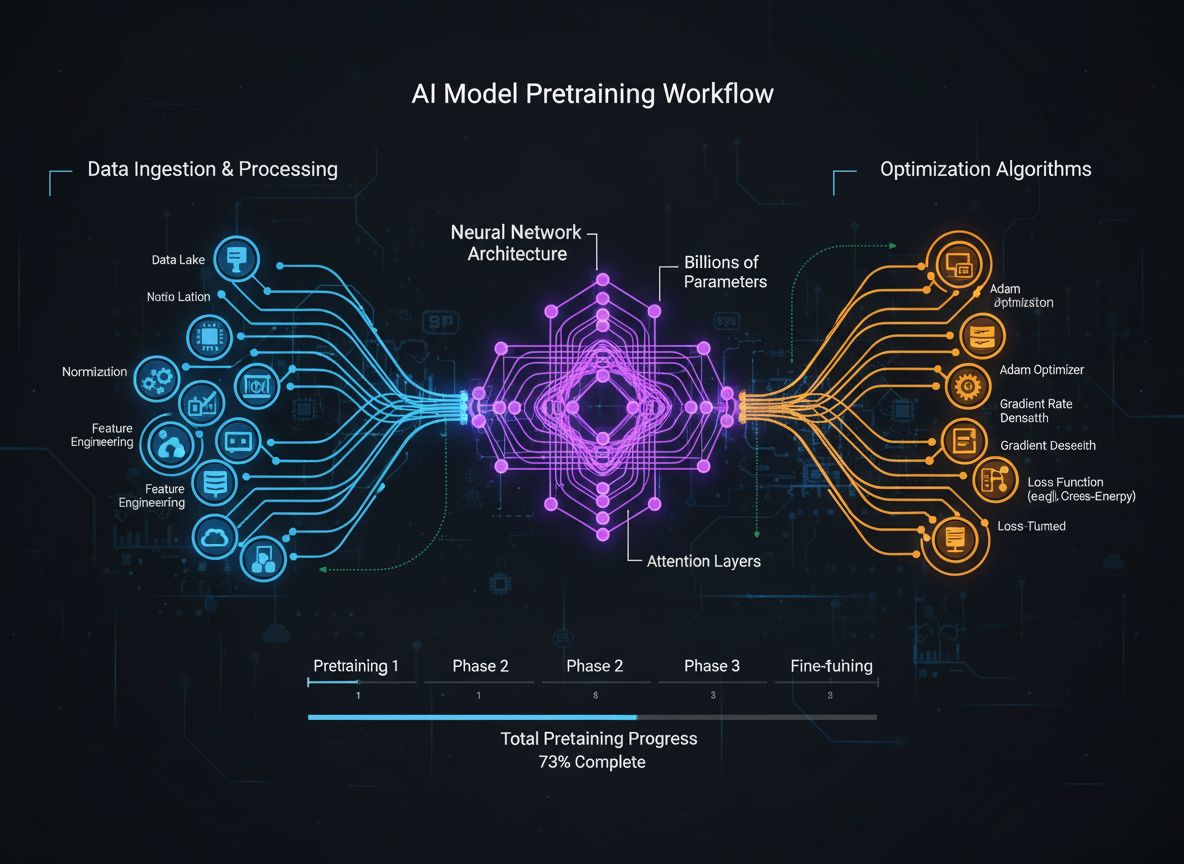

Predtrénovanie jazykových modelov sa vyvinulo z pomerne jednoduchého procesu kŕmenia surových textových dát do neurónových sietí na sofistikovanú disciplínu s viacerými prepojenými optimalizačnými cieľmi. V jadre ide o vystavenie modelu obrovskému množstvu textových dát, čím sa učí štatistické vzory jazyka pomocou samo-dohliadaného učenia. Moderný prístup však uznáva, že len škálovanie dát a výpočtov nestačí. Výskumníci musia dôsledne orchestrálne riadiť viacero aspektov tréningu — od výberu a kurácie dát cez architektonické rozhodnutia až po optimalizačné algoritmy. Odbor dozrel natoľko, že porozumenie týmto nuansám oddeľuje špičkové modely od priemerných. Tento vývoj odráža hlbšie pochopenie, že výkon modelu nie je určený jedným faktorom, ale starostlivou orchestráciou viacerých, čiastočne ortogonálnych cieľov, ktoré je možné optimalizovať paralelne. Výskumná komunita čoraz viac uznáva, že “tajná prísada” úspešného vývoja modelu nespočíva v hrubom škálovaní, ale v inteligentných rozhodnutiach naprieč celým tréningovým pipeline-om.

Jednou z najdôležitejších lekcií nedávneho výskumu je, že kvalita a rozmanitosť trénovacích dát zásadne ovplyvňuje výkon modelu viac než samotné množstvo. Tento princíp, často zhrnutý ako “garbage in, garbage out” („čo vložíš, to dostaneš“), je čoraz viac potvrdzovaný empirickým výskumom aj praxou. Modely trénované na zle kurátorských, duplikovaných či nekvalitných dátach sa učia falošné vzory a nedokážu efektívne generalizovať na nové úlohy. Naopak, starostlivo vybrané, deduplikované a filtrované datasety umožňujú modelom učiť sa efektívnejšie a dosahovať lepšie výsledky s menším počtom trénovacích krokov. Dôsledky tohto poznania sú zásadné: znamená to, že organizácie a výskumníci by mali investovať hlavne do kurácie dát a zabezpečenia ich kvality, namiesto len hromadenia ďalších surových dát. Tento posun v prístupe viedol k vzniku špecializovaných tímov a nástrojov zameraných výlučne na tvorbu a zdokonaľovanie datasetov. Dataset FineWeb, ktorý obsahuje viac ako 18,5 bilióna tokenov čistených a deduplikovaných anglických webových dát, je príkladom tohto prístupu. Namiesto použitia surových dát CommonCrawl tím FineWeb implementoval sofistikované filtrovanie, deduplikáciu a hodnotenie kvality, čím vytvoril dataset, ktorý konzistentne prekonáva väčšie, nespracované alternatívy. To predstavuje zásadné poznanie v odbore: cesta k lepším modelom vedie cez lepšie dáta, nie nevyhnutne cez viac dát.

Moderné predtrénovanie modelov možno pochopiť cez päť prepojených, no čiastočne ortogonálnych cieľov, ktoré musia výskumníci optimalizovať súčasne. Porozumenie týmto pilierom poskytuje rámec na premýšľanie o celom tréningovom procese a identifikáciu možností zlepšenia. Prvým pilierom je maximalizácia relevantnosti a kvality surových informácií v trénovacích dátach. To zahŕňa kvalitu jednotlivých dátových bodov aj rozmanitosť datasetu ako celku. Model trénovaný na kvalitných, rozmanitých dátach sa naučí všeobecnejšie vzory než model trénovaný na úzkom alebo nekvalitnom datasete, bez ohľadu na ďalšie optimalizácie. Druhý pilier sa zameriava na návrh architektúry modelu, ktorá určuje, ako efektívne model spracúva informácie a akým výpočtovým obmedzeniam musí čeliť. Architektonické voľby ovplyvňujú rýchlosť inferencie, pamäťové nároky, požiadavky na KV cache a schopnosť modelu bežať na konkrétnych hardvérových konfiguráciách. Tretí pilier zahŕňa maximalizáciu informácií extrahovaných z tréningových dát v každom kroku. Patria sem techniky ako destilácia znalostí, pri ktorej sa menšie modely učia od väčších, a predikcia viacerých tokenov, kde modely predpovedajú naraz viacero budúcich tokenov. Štvrtý pilier sa venuje kvalite gradientov a dynamike optimalizácie — výber optimalizéra, plánovanie learning rate či techniky na udržiavanie stability tréningu. Piaty pilier predstavuje ladenie hyperparametrov a stratégie škálovania, ktoré zaisťujú stabilitu tréningu pri rastúcich modeloch a predchádzajú problémom, ako je explózia gradientov alebo divergencia aktivačných funkcií. Týchto päť pilierov nie je nezávislých — navzájom sa ovplyvňujú — ale uvažovanie o nich oddelene pomáha výskumníkom určiť, ktoré oblasti si vyžadujú pozornosť a kde možno dosiahnuť najväčšie zlepšenia.

FineWeb predstavuje prelomový moment v tvorbe datasetov pre predtrénovanie jazykových modelov. Namiesto prijatia surových výstupov crawlera ako CommonCrawl tím HuggingFace vytvoril komplexný pipeline na čistenie, filtrovanie a deduplikáciu webových dát vo veľkom meradle. Výsledný dataset obsahuje viac ako 18,5 bilióna tokenov kvalitného anglického textu, čo z neho robí jeden z najväčších kurátorských datasetov dostupných open-source komunite. Tvorba FineWeb zahŕňala viacero štádií spracovania, pričom každé bolo navrhnuté na odstránenie nekvalitného obsahu a zároveň zachovanie cenných informácií. Tím implementoval sofistikované deduplikačné algoritmy na odstránenie redundantného obsahu, kvalitné filtre na odstránenie spamu a nekvalitných stránok a detekciu jazyka, aby dataset obsahoval prevažne anglický text. Hodnota FineWeb nespočíva len v jeho veľkosti, ale v empirickom overení, že prináša lepší výkon modelov než väčšie, nespracované alternatívy. Pri zmiešaní s inými datasetmi FineWeb konzistentne prekonáva oveľa väčšie surové datasety, čo dokazuje, že kvalita skutočne prevažuje nad kvantitou. Výkonnostné krivky ukazujú, že modely trénované na FineWeb dosahujú lepšie výsledky na štandardných benchmarkoch v porovnaní s modelmi trénovanými na datasetoch podobnej veľkosti z iných zdrojov. Tento úspech inšpiroval širšiu výskumnú komunitu k väčším investíciám do kurácie dát, keďže práve tu je možné dosiahnuť významné prírastky výkonu. Dataset FineWeb je voľne dostupný výskumníkom, čím demokratizuje prístup ku kvalitným trénovacím dátam a umožňuje menším organizáciám a akademickým tímom trénovať konkurencieschopné modely.

Kým FineWeb sa sústredil na webové dáta, tím HuggingFace si uvedomil, že ďalším obrovským a doteraz nevyužitým zdrojom kvalitného textu sú PDF dokumenty. PDF obsahujú veľké množstvo štruktúrovaných, kvalitných informácií — vedecké články, technickú dokumentáciu, knihy či odborné správy. Extrakcia textu z PDF je však technicky náročná a doterajšie prístupy tento zdroj vo veľkom systematicky nevyužívali. FinePDF predstavuje prvú komplexnú snahu o extrakciu, čistenie a kuráciu PDF dát pre predtrénovanie jazykových modelov. Tím implementoval sofistikovaný pipeline riešiaci špecifiká PDF spracovania — zvládanie zložitých rozložení stránky, presná extrakcia textu z viacstĺpcových dokumentov, spracovanie vložených obrázkov a tabuliek. Jedným z inovatívnych krokov pipeline-u FinePDF je fáza „refetch from internet“, ktorá rieši zásadný problém: PDF uložené v CommonCrawl sú často nekvalitne extrahované alebo zastarané. Opätovným stiahnutím PDF z pôvodných zdrojov tím zabezpečuje prístup k najkvalitnejším verziám dokumentov. Výsledky sú pôsobivé — po zmiešaní s inými datasetmi FinePDF dosahuje veľmi silný výkon v porovnaní s aktuálnymi baseline-mi ako NeoTron B2. Dataset poskytuje nový zdroj kvalitných trénovacích dát, ktorý dopĺňa webové dáta a umožňuje modelom učiť sa z rozmanitejších, štruktúrovaných informácií. Táto práca otvára nové možnosti v tvorbe datasetov a naznačuje, že aj iné doteraz neprebádané zdroje môžu priniesť podobné benefity. Pipeline FinePDF je detailne dokumentovaný prostredníctvom blogov a technickej dokumentácie, aby aj ďalší výskumníci mohli stavať na tejto práci a aplikovať podobné techniky na iné dátové zdroje.

SmolLM 3 je vyvrcholením uplatnenia týchto techník kurácie dát a optimalizácie tréningu na vytvorenie vysoko efektívneho jazykového modelu. S 3 miliardami parametrov je SmolLM 3 výrazne menší než mnohé súčasné modely, no vďaka starostlivej optimalizácii naprieč všetkými piatimi piliermi tréningu dosahuje konkurenčný výkon. Model podporuje dvojrežimové uvažovanie, viacjazyčnosť v šiestich jazykoch a porozumenie dlhému kontextu, čím je pozoruhodne univerzálny napriek svojej skromnej veľkosti. Vývoj SmolLM 3 zahŕňal premyslené architektonické rozhodnutia s cieľom maximalizovať efektivitu. Tím zvolil transformer architektúru, ktorá vyvažuje výpočtovú efektivitu a modelovaciu kapacitu, pričom implementoval techniky ako grouped query attention na zníženie pamäťových nárokov a latencie inferencie. Model bol trénovaný v troch fázach, ktoré postupne posilňovali výkon v rôznych doménach, čím tím optimalizoval špecifické schopnosti v každej fáze. Význam SmolLM 3 spočíva najmä v tom, že demonštruje schopnosť open-source komunity vytvárať modely, ktoré v mnohých úlohách konkurujú oveľa väčším proprietárnym modelom. To spochybňuje predpoklad, že väčšie je vždy lepšie, a naznačuje, že odbor možno dosiahol určitý strop v prínose čistého škálovania. Pozornosť sa preto presúva na efektivitu, interpretovateľnosť a praktické možnosti nasadenia. SmolLM 3 dokáže bežať na bežnom hardvéri, edge zariadeniach či v prostrediach s obmedzenými zdrojmi, čím sprístupňuje pokročilé AI širšiemu publiku. Viacjazyčné a long-context schopnosti modelu dokazujú, že efektivita nemusí znamenať kompromis v dôležitých funkciách.

Destilácia znalostí je silná technika, ktorá umožňuje menším modelom profitovať zo znalostí naučených väčšími modelmi. Namiesto trénovania malého modelu od nuly na surových dátach spočíva destilácia v učení malého modelu napodobniť výstupy väčšieho, schopnejšieho modelu. Tento prístup je obzvlášť cenný pri predtrénovaní, pretože umožňuje menšiemu modelu naučiť sa vzory, ktoré už väčší model objavil, zrýchliť učenie a zlepšiť výsledný výkon. Mechanizmus destilácie zahŕňa trénovanie študentského modelu (menšieho), aby jeho pravdepodobnostné rozdelenie výstupov čo najviac kopírovalo rozdelenie učiteľského modelu (väčšieho). Typicky sa to dosahuje minimalizáciou divergencie medzi výstupmi študenta a učiteľa, často pomocou techník ako KL divergencia. Parameter teploty riadi, nakoľko „mäkké“ sú pravdepodobnostné rozdelenia — vyššia teplota spôsobuje hladšie rozdelenia, poskytujúce viac informácií o relatívnej istote rôznych predikcií. Destilácia znalostí sa ukázala ako mimoriadne efektívna pri predtrénovaní jazykových modelov, keďže umožňuje preniesť znalosti veľkých modelov do menších, efektívnejších modelov. To je obzvlášť cenné pre organizácie, ktoré chcú nasadzovať modely na edge zariadeniach alebo v prostrediach s obmedzenými zdrojmi, ale zároveň chcú využiť schopnosti väčších modelov. Technika sa stáva čoraz sofistikovanejšou, pričom výskumníci skúmajú napríklad attention transfer (študent kopíruje i pozornosť učiteľa) či destiláciu založenú na vlastnostiach (porovnávanie vnútorných reprezentácií).

Tradičný tréning jazykových modelov sa sústreďuje na predikciu nasledujúceho tokenu — model sa učí predpovedať ďalší token na základe všetkých predchádzajúcich. Novší výskum však ukazuje, že tréning modelov na predpovedanie viacerých budúcich tokenov naraz môže výrazne zlepšiť výkon, najmä pri kódovacích úlohách a komplexnom uvažovaní. Predikcia viacerých tokenov núti model učiť sa dlhodobejšie závislosti a hlbšie chápať vzory v dátach. Prístup spočíva v pridaní viacerých „prediction heads“ do modelu, pričom každý predpovedá token o niekoľko pozícií vpred. Počas tréningu model prijíma straty zo všetkých týchto „heads“ naraz, čo ho motivuje naučiť sa reprezentácie užitočné na predpovedanie viacerých krokov do budúcnosti. Je to náročnejšie než predikcia len ďalšieho tokenu, ale prináša lepšie naučené reprezentácie. Výhody predikcie viacerých tokenov presahujú len zlepšenie tréningového cieľa — modely trénované týmto spôsobom často vykazujú lepší výkon na downstream úlohách, lepšiu generalizáciu a uvažovacie schopnosti. Technika je obzvlášť účinná pri generovaní kódu, kde je dôležité chápať dlhodobejšie závislosti pre syntakticky aj semanticky správny výstup. Výskumy ukazujú, že predikcia viacerých tokenov môže zlepšiť výkon modelu o 5–15 % na rôznych benchmarkoch, čo z nej robí jednu z najvplyvnejších techník posledných rokov. Prístup je relatívne jednoduchý na implementáciu, no vyžaduje starostlivé ladenie počtu „prediction heads“ a váženia ich strát.

Roky bol AdamW štandardnou voľbou na tréning veľkých jazykových modelov. Kombinuje aktualizácie gradientov založené na momentume s weight decay a poskytuje stabilné učenie a dobrú konvergenciu. Novší výskum však ukazuje, že AdamW nemusí byť optimálny pre všetky scenáre, najmä pri škálovaní na veľmi veľké modely. Nové optimalizéry ako Muon a King K2 skúmajú alternatívne prístupy, ktoré môžu zabezpečiť lepšiu tréningovú dynamiku a vyšší výkon. Kľúčovým poznatkom týchto optimalizérov je, že Hessianova matica — zachytávajúca zakrivenie loss landscape — môže byť lepšie aproximovaná metódami ako Newton-Schulz. Pri lepšej aproximácii Hessianu poskytujú optimalizéry informatívnejšie aktualizácie gradientu, čo vedie k rýchlejšej konvergencii a lepšiemu výslednému výkonu. Muon napríklad používa Newton-Schulz iteráciu na ortogonalizovanie gradientovej matice, čo rozkladá učenie do viacerých dimenzií oproti tradičnému momentu. To prináša stabilnejší tréning a podporuje model v objavovaní nových oblastí parameter space namiesto nasledovania stále tej istej trajektórie ako AdamW. King K2 na to ide inak — sleduje napríklad maximum logu na head a na základe toho adaptívne upravuje learning rate a gradient clipping. Inovácie v oblasti optimalizérov majú veľký význam. Mnoho odborníkov stále používa AdamW s hyperparametrami, ktoré boli optimalizované pre oveľa menšie modely, aj keď trénujú modely s rádovo väčším počtom parametrov. To naznačuje, že významné zlepšenia možno dosiahnuť už len aktualizáciou optimalizérov a hyperparametrov pre moderné veľké modely. Výskumná komunita si čoraz viac uvedomuje, že výber optimalizéra nie je vyriešený problém a že ďalšie inovácie tu môžu priniesť podstatné zlepšenia efektivity a výsledného výkonu.

Udržiavanie vysokej kvality gradientov počas tréningu je zásadné pre dosiahnutie dobrého výkonu modelu. S rastom modelov na miliardy či bilióny parametrov sa tréning stáva čoraz nestabilnejší — gradienty môžu explodovať alebo miznúť. Riešenie týchto problémov si vyžaduje dôkladnú pozornosť kvalite gradientov a implementáciu techník na zachovanie stability v priebehu celého tréningu. Jedným z prístupov je použitie gradient clippingu, ktorý bráni tomu, aby gradienty narástli príliš a destabilizovali tréning. Príliš jednoduchý clipping však môže zahodiť cenné informácie. Sofistikovanejšie prístupy normalizujú gradienty spôsobmi, ktoré zachovávajú informáciu a zároveň zabraňujú nestabilite. Dôležitá je aj voľba aktivačných funkcií a normalizácie vrstiev. Rôzne aktivačné funkcie majú odlišné vlastnosti z hľadiska toku gradientu a ich výber môže výrazne ovplyvniť stabilitu tréningu. Layer normalization, ktorá normalizuje aktivácie naprieč dimenziou znakov, sa stala štandardom v transformeroch, pretože poskytuje lepšie vlastnosti toku gradientov než batch normalization. Plánovanie learning rate tiež hrá kľúčovú úlohu pri udržiavaní kvality gradientov. Príliš vysoký learning rate môže spôsobiť explóziu gradientov, príliš nízky vedie k pomalej konvergencii alebo uviaznutiu v lokálnych minimách. Moderný tréning často používa plány s warm-up fázou (postupné zvyšovanie learning rate), čo modelu umožní usadiť sa v dobrom regióne parametrov a následne fázu klesania learning rate počas ďalšieho tréningu. Pochopenie a optimalizácia týchto aspektov je kľúčová pre úspešný tréning veľkých modelov a zostáva predmetom intenzívneho výskumu.

Zložitosť moderného predtrénovania modelov — s viacerými optimalizačnými cieľmi, sofistikovanými pipeline-mi na spracovanie dát a starostlivým ladením hyperparametrov — vytvára značné výzvy pre tímy snažiace sa tieto techniky implementovať. FlowHunt tieto výzvy rieši poskytovaním platformy na automatizáciu a orchestráciu zložitých workflowov tréningu modelov. Namiesto ručného riadenia spracovania dát, tréningu modelov a ich vyhodnocovania môžu tímy v FlowHunt definovať workflowy, ktoré tieto úlohy vykonávajú automaticky, čím sa znižuje chybovosť a zlepšuje reprodukovateľnosť. Automatizačné schopnosti FlowHunt sú obzvlášť užitočné pri kurácii a spracovaní dát, ktoré sú pre výkon modelu také kritické. Platforma dokáže automaticky implementovať pipeline-y podobné tým z FineWeb a FinePDF — deduplikáciu, filtrovanie kvality, prevod formátov — takže tímy sa môžu sústrediť na rozhodnutia o tom, aké dáta zahrnúť a ako ich spracovať, namiesto riešenia implementačných detailov. Okrem toho FlowHunt pomáha tímom spravovať ladenie hyperparametrov a experimentovanie potrebné na optimalizáciu tréningu modelov. Automatizovaním spúšťania viacerých tréningových experimentov s rôznymi hyperparametrami a zbieraním výsledkov umožňuje FlowHunt efektívnejšie preskúmať parameter space a rýchlejšie nájsť optimálne konfigurácie. Platforma zároveň poskytuje nástroje na monitoring priebehu tréningu, detekciu problémov ako explózia gradientov či divergencia a automatické prispôsobovanie parametrov na udržanie stability. Pre organizácie budujúce vlastné jazykové modely alebo dolaďujúce existujúce modely môže FlowHunt výrazne skrátiť čas a úsilie potrebné na dosiahnutie kvalitných výsledkov.

Jedným z najnáročnejších aspektov tréningu modelov je pochopenie, ako škálovať z malých modelov na veľké pri zachovaní stability tréningu a výkonu. Vzťah medzi veľkosťou modelu a optimálnymi hyperparametrami nie je priamočiary — hyperparametre, ktoré fungujú dobre pre malé modely, často treba pri väčších modeloch upraviť. Platí to najmä pre learning rate, ktorý zvyčajne treba znižovať pri rastúcom modeli. Porozumenie scaling laws je kľúčové na predpovedanie výkonu modelov pri rôznych veľkostiach a pre rozhodovanie o rozdelení zdrojov. Výskum ukazuje, že výkon modelu sleduje predvídateľné scaling laws, kde výkon rastie ako mocninná funkcia veľkosti modelu, datasetu a výpočtového rozpočtu. Tieto scaling laws umožňujú výskumníkom predpovedať, aké zlepšenie možno očakávať pri zväčšovaní modelu či datasetu, čo vedie k informovanejším rozhodnutiam o investíciách. Scaling laws však nie sú univerzálne — závisia od konkrétnej architektúry, postupu tréningu a datasetu. Znamená to, že tímy musia realizovať vlastné škálovacie experimenty, aby pochopili, ako sa ich konfigurácia škáluje. Proces škálovania vyžaduje aj dôraz na stabilitu tréningu — väčšie modely sú náchylnejšie na nestability ako explózia alebo divergencia gradientov. Riešenie týchto problémov si vyžaduje techniky ako gradient clipping, opatrné plánovanie learning rate a prípadne zmeny v architektúre či optimalizéri. Výskumná komunita si čoraz viac uvedomuje, že škálovanie nie je len o zväčšovaní modelov, ale o dôslednom riadení tréningového procesu, aby bolo možné trénovať väčšie modely efektívne.

Učenie vlastností (feature learning) označuje proces, ktorým sa modely učia extrahovať užitočné vlastnosti zo surových dát počas tréningu. V kontexte predtrénovania jazykových modelov ide o učenie reprezentácií jazykových konceptov, sémantických vzťahov a syntaktických vzorov v interných reprezentáciách modelu. Maximalizovanie učenia vlastností — teda zaistenie, že model extrahuje z tréningových dát v každom kroku čo najviac užitočných informácií — je jedným z kľúčových cieľov moderného tréningu modelov. Jedným z pohľadov na učenie vlastností je sledovanie toho, ako veľmi sa reprezentácie modelu menia v reakcii na aktualizácie gradientov. Ak sa model učí efektívne, každá aktualizácia gradientu by mala viesť k zmysluplným zmenám v reprezentáciách, ktoré zlepšujú schopnosť modelu predpovedať budúce tokeny. Ak sa model neučí efektívne, gradienty spôsobujú len malé alebo irelevantné zmeny. Techniky na zlepšenie učenia vlastností zahŕňajú starostlivú inicializáciu váh modelu, ktorá môže výrazne ovplyvniť rýchlosť učenia užitočných vlastností na začiatku tréningu. Ďalšou dôležitou technikou je použitie plánov learning rate, ktoré umožňujú modelu učiť sa rýchlo v počiatočných fázach (keď sa učia základné vlastnosti) a spomaliť učenie v neskorších fázach, keď model dolaďuje jemnejšie vzory. Koncept učenia vlastností úzko súvisí s fenoménom „feature collapse”, keď modely ignorujú niektoré vlastnosti alebo rozmery vstupu. Stáva sa to, keď model nájde skratku, ktorá mu umožní dosiahnuť dobrý výkon bez učenia všetkých potrebných vlastností. Techniky ako regularizácia a starostlivý návrh loss funkcie môžu pomôcť predchádzať feature collapse a zabezpečiť, že modely sa naučia rozmanité a užitočné vlastnosti.

{{ cta-dark-panel heading=“Zrýchlite svoj workflow s FlowHunt” description=“Vyskúšajte, ako FlowHunt automatizuje vaše AI a SEO workflowy — od výskumu a generovania obsahu cez publikovanie až po analytiku — všetko na jednom mieste.” ctaPrimaryText=“Objednať demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Vyskúšať FlowHunt zadarmo” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Niekoľko rokov v AI výskume prevládal naratív, že väčšie modely sú lepšie modely. To viedlo k pretekom o tvorbu čoraz väčších modelov, pričom firmy súťažili v počte param

SmolLM 3 je model s 3 miliardami parametrov navrhnutý na maximalizáciu efektivity pri zachovaní vysokej výkonnosti v rôznych jazykoch a úlohách s dlhým kontextom. Na rozdiel od väčších modelov sa SmolLM 3 sústreďuje na optimálny výkon v rámci výpočtových obmedzení, vďaka čomu je ideálny pre nasadenie na edge zariadeniach a v prostrediach s obmedzenými zdrojmi.

Princíp 'čo vložíš, to dostaneš' je základom strojového učenia. Vysokokvalitné a rôznorodé dáta majú na výkon modelu väčší vplyv ako len samotné množstvo. FineWeb a FinePDF ukazujú, že starostlivá kurácia, deduplikácia a filtrovanie trénovacích dát prináša výrazne lepšie výsledky než surové, nespracované dataset-y.

Destilácia znalostí je technika, pri ktorej sa menší model učí od väčšieho a schopnejšieho modelu. Počas predtrénovania tento prístup umožňuje menším modelom získať maximum informácií z trénovacích dát učením sa vzorov, ktoré už väčšie modely objavili, čo vedie k lepšiemu výkonu s menším počtom parametrov.

Predikcia viacerých tokenov učí modely predpovedať viacero budúcich tokenov naraz namiesto iba jedného ďalšieho tokenu. Tento prístup je obzvlášť účinný pri kódovacích úlohách a zlepšuje schopnosť modelu chápať dlhodobejšie závislosti, čo vedie k lepším výsledkom pri komplexnom uvažovaní.

Moderné optimalizéry ako Muon idú ďalej než tradičný AdamW použitím metód ako Newton-Schulz na lepšie aproximovanie Hessianovej matice. To vedie k stabilnejšiemu tréningu, lepšej kvalite gradientov a vylepšenej dynamike učenia, najmä pri škálovaní modelov na väčší počet parametrov.

Arshia je inžinierka AI workflowov v spoločnosti FlowHunt. S pozadím v informatike a vášňou pre umelú inteligenciu sa špecializuje na tvorbu efektívnych workflowov, ktoré integrujú AI nástroje do každodenných úloh, čím zvyšuje produktivitu a kreativitu.

FlowHunt pomáha tímom zjednodušiť predtrénovanie modelov, spracovanie dát a optimalizačné pipeline vďaka inteligentnej automatizácii.

Hugging Face Transformers je popredná open-source knižnica v jazyku Python, ktorá uľahčuje implementáciu Transformer modelov pre úlohy strojového učenia v oblas...

Objavte, ako výskumníci z MIT posúvajú veľké jazykové modely (LLM) vpred vďaka novým poznatkom o ľudských presvedčeniach, inovatívnym nástrojom na detekciu anom...

Preskúmajte najlepšie veľké jazykové modely (LLM) na programovanie v júni 2025. Tento kompletný vzdelávací sprievodca prináša prehľad, porovnania a praktické ti...