Ako transformovať tvorbu obsahu s Wan 2.2 & 2.5 generovaním videí?

FlowHunt teraz podporuje modely na generovanie videí Wan 2.2 a 2.5 pre text-na-video, obrázok-na-video, výmenu postáv a animáciu. Transformujte svoju tvorbu obs...

Wan 2.1 je výkonný otvorený AI model na generovanie videí od spoločnosti Alibaba, ktorý dokáže vytvárať štúdiové videá z textu alebo obrázkov a je voľne dostupný každému na lokálne použitie.

Wan 2.1 (označovaný aj ako WanX 2.1) predstavuje revolučný, plne otvorený AI model na generovanie videí vyvinutý Tongyi Lab spoločnosti Alibaba. Na rozdiel od mnohých vlastníckych systémov na generovanie videí, ktoré vyžadujú drahé predplatné alebo API prístup, Wan 2.1 prináša porovnateľnú alebo lepšiu kvalitu a zároveň je úplne zadarmo a dostupný pre vývojárov, výskumníkov aj kreatívnych profesionálov.

To, čo robí Wan 2.1 výnimočným, je kombinácia dostupnosti a výkonu. Menší variant T2V-1.3B vyžaduje len približne 8,2 GB pamäte GPU, takže je kompatibilný s väčšinou moderných spotrebiteľských GPU. Väčšia verzia s 14 miliardami parametrov poskytuje špičkový výkon, ktorý v benchmarkoch prekonáva open-source alternatívy aj mnohé komerčné modely.

Wan 2.1 nie je obmedzený len na generovanie text-na-video. Jeho univerzálna architektúra podporuje:

Táto flexibilita znamená, že môžete začať s textovým podnetom, statickým obrázkom alebo dokonca existujúcim videom a pretvoriť ho podľa svojej kreatívnej vízie.

Ako prvý video model, ktorý dokáže generovať čitateľný anglický a čínsky text priamo vo videách, otvára Wan 2.1 nové možnosti pre tvorcov medzinárodného obsahu. Táto funkcia je obzvlášť užitočná na titulky alebo scénický text v viacjazyčných videách.

Srdcom efektivity Wan 2.1 je jeho 3D kauzálny Video Variational Autoencoder. Táto technologická inovácia efektívne komprimuje špatiotemporálne informácie, čo modelu umožňuje:

Menší model s 1,3 miliardou parametrov potrebuje iba 8,19 GB VRAM a dokáže vygenerovať 5-sekundové 480p video približne za 4 minúty na RTX 4090. Napriek tejto efektivite je jeho kvalita porovnateľná alebo lepšia ako pri oveľa väčších modeloch, čo z neho robí ideálnu voľbu medzi rýchlosťou a vizuálnou kvalitou.

V nezávislých hodnoteniach dosiahol Wan 14B najvyššie skóre v testoch Wan-Bench, kde prekonal konkurenciu v oblastiach:

Na rozdiel od uzavretých systémov, ako sú Sora od OpenAI alebo Gen-2 od Runway, je Wan 2.1 voľne dostupný na lokálne spustenie. Väčšinou prekonáva skoršie open-source modely (napríklad CogVideo, MAKE-A-VIDEO a Pika) a dokonca aj mnohé komerčné riešenia v kvalitných benchmarkoch.

Prieskum v odvetví nedávno uviedol, že „spomedzi mnohých AI video modelov vynikajú Wan 2.1 a Sora“ – Wan 2.1 svojou otvorenosťou a efektivitou, Sora inováciami vo vlastníctve. Komunitné testy ukazujú, že funkcia obraz-na-video u Wan 2.1 prekonáva konkurenciu v ostrosti aj filmovom dojme.

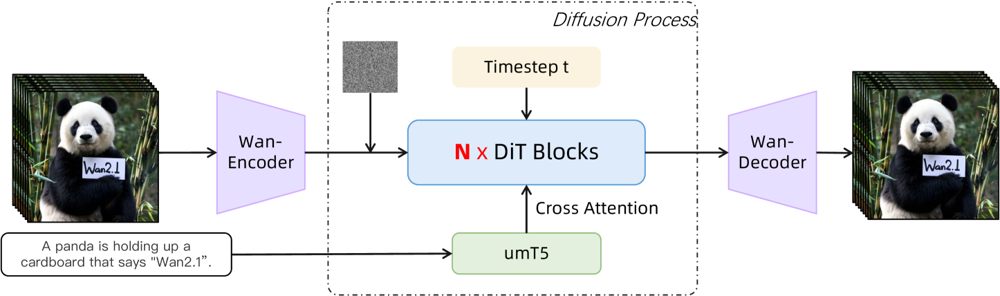

Wan 2.1 stavia na jadre diffusion-transformer s novým špatiotemporálnym VAE. Funguje nasledovne:

Obrázok: Vysoká úroveň architektúry Wan 2.1 (prípad text-na-video). Video (alebo obrázok) je najprv zakódované Wan-VAE enkodérom do latentného priestoru. Tento latent následne prechádza N diffusion transformer blokmi, ktoré používajú cross-attention na textové embeddingy (z umT5). Nakoniec Wan-VAE dekodér rekonštruuje video snímky. Tento dizajn – „3D kauzálny VAE enkodér/dekodér obklopujúci diffusion transformer“ (ar5iv.org ) – umožňuje efektívnu kompresiu špatiotemporálnych dát a podporuje výstup videí vo vysokej kvalite.

Táto inovatívna architektúra — „3D kauzálny VAE enkodér/dekodér obklopujúci diffusion transformer“ — umožňuje efektívnu kompresiu špatiotemporálnych dát a podporuje vysokokvalitný video výstup.

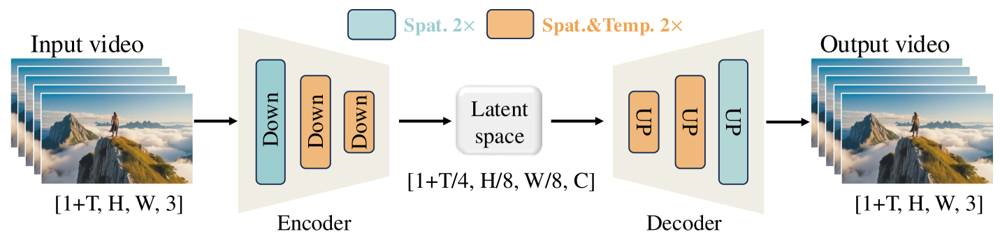

Wan-VAE je špeciálne navrhnutý pre videá. Vstup komprimuje pôsobivým pomerom (časovo 4× a priestorovo 8×) do kompaktného latentu, ktorý je potom dekódovaný späť na plné video. Použitie 3D konvolúcií a kauzálnych (čas zachovávajúcich) vrstiev zabezpečuje konzistentný pohyb v celom generovanom obsahu.

Obrázok: Wan-VAE framework (enkodér-dekodér) vo Wan 2.1. Wan-VAE enkodér (vľavo) aplikuje sériu down-sampling vrstiev („Down“) na vstupné video (tvar [1+T, H, W, 3] snímky), až kým nedosiahne kompaktný latent ([1+T/4, H/8, W/8, C]). Wan-VAE dekodér (vpravo) tento latent symetricky upsampluje („UP“) späť na pôvodné video snímky. Modré bloky znamenajú priestorovú kompresiu, oranžové kombinovanú priestorovo-časovú kompresiu (ar5iv.org

). Komprimovaním videa 256× (v špatiotemporálnom objeme) umožňuje Wan-VAE zvládnuteľné modelovanie vysokého rozlíšenia pre následný diffusion model.

Chcete si Wan 2.1 vyskúšať? Tu je postup:

Klonujte repozitár a nainštalujte závislosti:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Stiahnite váhy modelu:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Vygenerujte svoje prvé video:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "Futuristická mestská panoráma pri západe slnka, ponad ktorú letia lietajúce autá."

--offload_model True --t5_cpu na presunutie časti modelu na CPU--size ovládajte pomer strán (napr. 832*480 pre 16:9 480p)Pre predstavu, RTX 4090 vygeneruje 5-sekundové 480p video za približne 4 minúty. Pre veľké nasadenie sú podporované aj multi-GPU konfigurácie a rôzne optimalizácie výkonu (FSDP, kvantizácia atď.).

Ako open-source gigant, ktorý vyzýva lídrov v AI generovaní videa, Wan 2.1 predstavuje zásadný posun v dostupnosti tejto technológie. Jeho bezplatnosť a otvorenosť znamená, že ktokoľvek s primeranou GPU môže objavovať špičkové generovanie videí bez poplatkov či API nákladov.

Pre vývojárov open-source licencia umožňuje prispôsobiť a vylepšovať model. Výskumníci môžu rozširovať jeho schopnosti a kreatívci rýchlo a efektívne prototypovať video obsah.

V dobe, keď sú vlastnícke AI modely čoraz viac zamknuté za platbami, Wan 2.1 dokazuje, že špičkový výkon môže byť demokratizovaný a zdieľaný so širokou komunitou.

Wan 2.1 je plne otvorený AI model na generovanie videí vyvinutý Tongyi Lab spoločnosti Alibaba, ktorý dokáže vytvárať videá vo vysokej kvalite z textových podnetov, obrázkov alebo existujúcich videí. Je bezplatný, podporuje viacero úloh a beží efektívne na bežných GPU.

Wan 2.1 podporuje multitaskingové generovanie videa (text-na-video, obrázok-na-video, editáciu videa, atď.), viacjazyčné renderovanie textu vo videách, vysokú efektivitu vďaka 3D kauzálnemu Video VAE a v benchmarkoch prekonáva mnohé komerčné aj open-source modely.

Potrebujete Python 3.8+, PyTorch 2.4.0+ s podporou CUDA a NVIDIA GPU (8GB+ VRAM pre menší model, 16-24GB pre veľký model). Naklonujte GitHub repozitár, nainštalujte závislosti, stiahnite váhy modelu a pomocou dodaných skriptov generujte videá lokálne.

Wan 2.1 demokratizuje prístup k špičkovému generovaniu videa tým, že je open-source a zdarma, takže vývojári, výskumníci a kreatívci môžu experimentovať a inovovať bez poplatkov alebo vlastníckych obmedzení.

Na rozdiel od uzavretých alternatív ako Sora alebo Runway Gen-2 je Wan 2.1 plne open-source a dá sa spustiť lokálne. Zvyčajne prekonáva staršie open-source modely a v kvalitatívnych benchmarkoch sa vyrovná alebo prekonáva mnohé komerčné riešenia.

Arshia je inžinierka AI workflowov v spoločnosti FlowHunt. S pozadím v informatike a vášňou pre umelú inteligenciu sa špecializuje na tvorbu efektívnych workflowov, ktoré integrujú AI nástroje do každodenných úloh, čím zvyšuje produktivitu a kreativitu.

Začnite vytvárať vlastné AI nástroje a video generátory s FlowHunt alebo si rezervujte demo a uvidíte platformu v akcii.

FlowHunt teraz podporuje modely na generovanie videí Wan 2.2 a 2.5 pre text-na-video, obrázok-na-video, výmenu postáv a animáciu. Transformujte svoju tvorbu obs...

Objavte prelomové schopnosti Sora 2 v oblasti AI generovania videí – od realistickej rekreácie postáv po simuláciu fyziky – a zistite, ako táto technológia mení...

Preskúmajte prelomové možnosti Sora 2 v oblasti AI generovania videa – od realistickej replikácie postáv až po simuláciu fyziky – a objavte, ako táto technológi...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.