Llama 3.3 70B Versatile 128k'in Zihnine Yolculuk: Bir AI Ajanı Olarak

Llama 3.3 70B Versatile 128k'in bir AI Ajanı olarak gelişmiş yeteneklerini keşfedin. Bu derinlemesine inceleme, modelin akıl yürütme, problem çözme ve yaratıcı ...

AI21’in Jamba 3B’sinin, dönüştürücü dikkatini durum uzay modelleriyle nasıl birleştirerek uç cihazlarda benzeri görülmemiş verimlilik ve uzun-bağlam yetenekleri elde ettiğini, büyük dil modellerinin geleceğini nasıl yeniden şekillendirdiğini keşfedin.

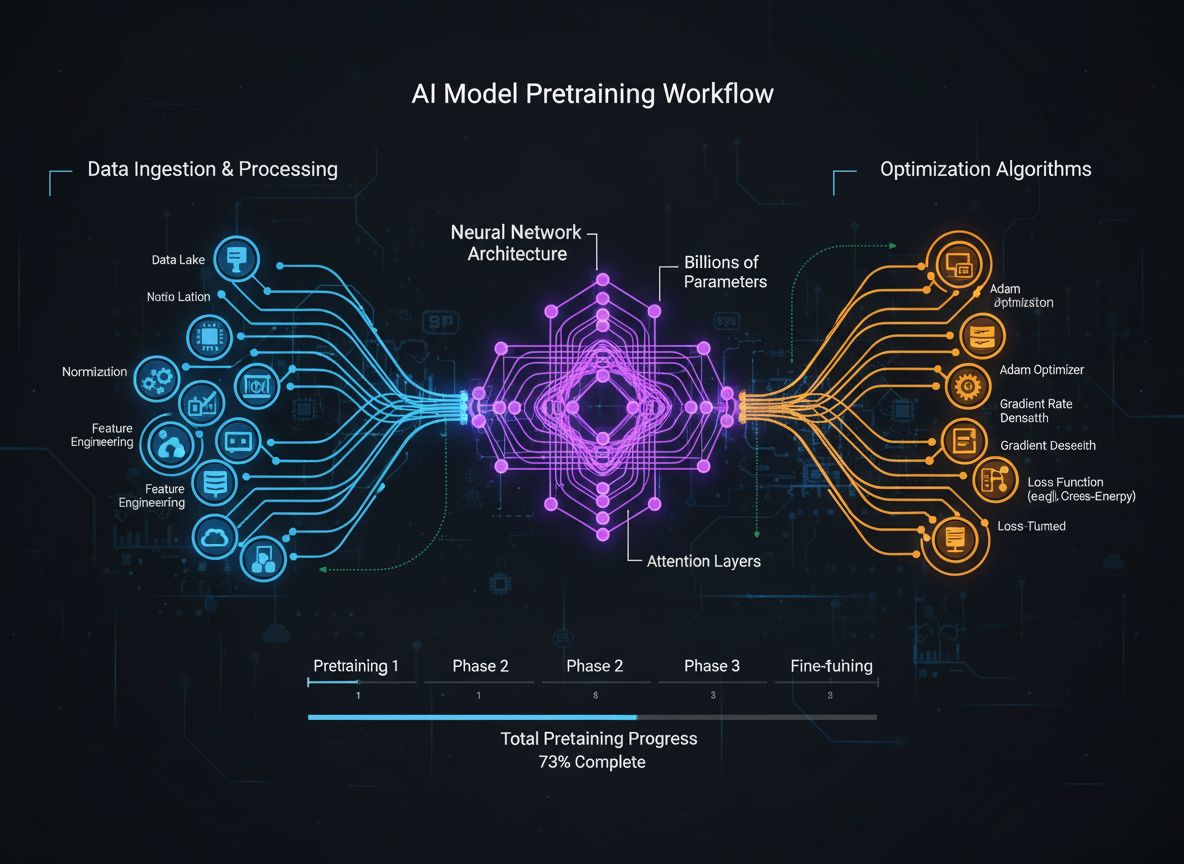

Büyük dil modellerinin dünyası, son yıllarda dramatik bir dönüşüm geçirdi; araştırmacılar ve şirketler, performanstan ödün vermeden verimliliği artırmanın yollarını sürekli olarak arıyor. AI21’in Jamba 3B’yi tanıtması, bu evrimde önemli bir dönüm noktasıdır—dönüştürücü dikkat mekanizmalarının gücünü durum uzay modelleriyle birleştiren hibrit bir model ile benzeri görülmemiş verimlilik kazanımları elde edilmiştir. Bu atılım, büyük dil modellerinin eğitimi ve dağıtımındaki hesaplama gereksinimlerinin dünya çapında kuruluşlar için ciddi bir darboğaza dönüştüğü kritik bir anda gelmiştir. Bu kapsamlı rehberde, Jamba 3B’nin arkasındaki teknik yenilikleri inceleyecek, hibrit mimarilerin neden dil modellerinin geleceğini temsil ettiğini anlayacak ve bu yaklaşımın çeşitli bilgi işlem ortamlarında yapay zekâ dağıtım olanaklarını nasıl yeniden şekillendirdiğine göz atacağız.

AI21, yedi yıl önce Ori Levy, Yoav Shoham ve Amnon Shashua tarafından, tüm sonraki çalışmalarına rehberlik edecek vizyoner bir öncül ile kuruldu: Derin öğrenme, inanılmaz derecede güçlü ve faydalı olsa da tek başına yeterli değildir. Şirketin kuruluş felsefesi, klasik yapay zekâ ile modern derin öğrenme yaklaşımlarını birleştirerek her iki paradigmanın da avantajlarından yararlanabilecek sistemler oluşturma üzerine odaklanıyordu. Bu misyon ileri görüşlüydü; çünkü şirket, GPT-3’ün piyasaya sürülmesinden hemen önce çalışmalarına başlamış ve tüm yapay zekâ endüstrisini yeniden şekillendiren devrimsel değişimlere katılma ve gözlemleme fırsatı yakalamıştı. AI21, 2018’deki ilk günlerinden itibaren, modellerini eğitirken hem bilimsel titizliğe hem de pratik uygulamalara eşit derecede odaklanmaya kendini adamıştı. Bu dengeli yaklaşım, şirketin çalışmalarında ayırt edici bir özellik haline geldi ve genellikle ya saf araştırmayı ya da anlık ticarileştirmeyi önceleyen rakiplerinden ayrışmalarını sağladı.

AI21, tarihi boyunca, yenilikçi araştırmaları gerçek dünya uygulamalarıyla birleştirme taahhüdünü sürdürdü. Şirket, pazar çekişi sağlayan ve dil modeli araştırmaları için bir test alanı işlevi gören Wordtune uygulamasını geliştirdi. GPT-3 ortaya çıktığında, AI21 kendi modellerini (Jurassic-1) eğiterek OpenAI’nin modeline benzer veya biraz daha iyi performans metrikleri elde etti. Bu erken başarı, AI21’i büyük dil modeli alanında ciddi bir oyuncu olarak konumlandırdı; ancak şirketin hedefleri mevcut modellerle eşleşmenin ötesine geçiyordu. Ekip, yapay zekânın geleceği için sadece daha büyük modellerin değil, daha akıllı mimarilerin de gerektiğinin farkındaydı—daha yüksek verimlilikle daha iyi performans sunan yapılar. Bu sezgi, sonunda, dil modellerinin nasıl inşa edilmesi gerektiğine dair geleneksel görüşlere meydan okuyan, çığır açıcı hibrit model serisi Jamba’nın geliştirilmesine yol açacaktı.

Hibrit dil modelleri, GPT-2 ve ardından gelen modellerden bu yana alanı domine eden saf dönüştürücü mimarisinden temel bir sapmayı temsil eder. Geleneksel dönüştürücü tabanlı dil modelleri tamamen dikkat mekanizmalarına dayanır; bir dizideki her bir token, diğer tüm tokenlara dikkat edebilir. Bu yaklaşım, dil anlama ve üretiminde oldukça etkili olsa da önemli bir hesaplama maliyetiyle gelir: Dikkat mekanizmasının karmaşıklığı bağlam uzunluğu ile kare orantılıdır, yani bağlam penceresini iki katına çıkarmak, hesaplama gereksinimlerini dört katına çıkarır. Ayrıca, dikkat için gerekli olan anahtar-değer önbelleği bağlam uzunluğu ile doğrusal olarak büyür ve bu da bağlam pencereleri genişledikçe giderek daha problemli hale gelen bellek darboğazları yaratır. Bu sınırlamalar, özellikle uzun-bağlam işleme, kişiselleştirme, hafıza tutma ve ajansik akıl yürütme gibi yetenekler gerektiren modern uygulamalar için kritik kısıtlar haline gelmiştir.

Hibrit modeller, dönüştürücü dikkati, bağlam uzunluğuna göre doğrusal karmaşıklık sunan Mamba gibi durum uzay modelleriyle birleştirerek bu sınırlamaların üstesinden gelir. Dikkati tamamen ortadan kaldırmak—dönüştürücülerin etkili olmasını sağlayan akıl yürütme yeteneklerinden vazgeçmek olurdu—yerine, hibrit mimariler dikkati seçici olarak, tipik olarak 1:8 oranında (her sekiz katmanın sadece birinde tam dikkat, kalanlarda ise daha verimli durum uzay modeli yaklaşımı) kullanır. Bu stratejik birleşim, modelin, dikkatin sağladığı küresel bağlam farkındalığı gerektiren karmaşık akıl yürütme görevlerini yerine getirme yeteneğini korurken, modelin işlemesinin büyük bölümünde hesaplama ve bellek gereksinimlerini dramatik biçimde azaltır. Sonuçta, model çoğu benchmarkta performanstan ödün vermeden hem eğitimde hem de çıkarımda çok daha az hesaplama kaynağı tüketir. Bu verimlilik artışı, yalnızca marjinal bir iyileşme değil—yapay zekâ dağıtımında nelerin mümkün olabileceğinde köklü bir değişimi temsil eder ve modellerin uç cihazlarda, bellek kısıtlı ortamlarda ve daha önce pratik olmayan ölçeklerde çalışmasını mümkün kılar.

Jamba’nın hibrit mimarisine giden yol önceden belirlenmiş değildi; dikkatli deneyler ve alışılmadık yaklaşımları keşfetmeye gönüllülükle ortaya çıktı. AI21 ekibi başlangıçta Jurassic model serisinin üçüncü versiyonu olan J3 üzerinde çalışıyordu ve bir uzman karışımı (MoE) mimarisi uygulamayı planlıyordu. MoE’nin temel motivasyonu açıktı: Hesaplamayı birden çok uzman ağa dağıtarak eğitim maliyetlerini önemli ölçüde azaltacak ve eğitim bütçesini daha yönetilebilir kılacaktı. Ancak ekip, modelin çıkarım sırasında da verimli şekilde dağıtılabilmesini sağlamak istedi; bu nedenle J3’ü, tek bir 80 GB belleğe sahip GPU’ya (ör. A100 veya H100) sığacak ve daha büyük bir sürümünün tek bir pod içinde çalışacağı şekilde birden fazla versiyonda tasarladı. İlk baştan çıkarım verimliliğine odaklanmak, nihai atılımlarında belirleyici olacaktı.

Model geliştirme sürecinde yapılan ablation çalışmaları sırasında, AI21’in CTO’su Barak Lenz, ekibindeki birçok kişinin tavsiyesiyle Mamba makalesiyle karşılaştı. Önceki durum uzay modeli makaleleri sınırlı umut vaat ederken, Mamba makalesi karşılaştırma ve değerlendirmede gösterdiği titizlikle öne çıktı. Eski karşılaştırmalar yerine, yazarlar Mamba’yı doğrudan Llama’nın getirdiği en yeni dikkat mimarilerine karşı kıyasladı; Llama, katman normalizasyonu, aktivasyon fonksiyonları ve eğitim kararsızlıklarını önleyen diğer mimari detaylarda önemli optimizasyonlar yapmıştı. Mamba makalesi, bu son teknoloji temellere karşı adil şekilde karşılaştırmalar yapmakla kalmadı, aynı zamanda pratik uygulama için özel çekirdekler ve kod da yayınladı. Bu titizlikten etkilenen Lenz, mühendislik ekibini Mamba’yı denemeye ve mevcut değerlendirme panolarında (o dönemde yüzlerce farklı görev ve benchmark içeren) nasıl performans gösterdiğini görmeye teşvik etti.

İlk sonuçlar umut vericiydi ancak önemli sınırlamaları da ortaya koydu. Mamba, dikkat tabanlı modellerle kıyaslanabilir şekilde perplexity metriklerinde ve çoğu görevde rekabetçiydi; fakat özellikle yeni kalıplara hızlı uyum gerektiren birkaç denemeli öğrenme görevlerinde geride kalıyordu. Ekip, bu eksikliklerin Mamba’nın dikkat mekanizması eksikliğinden kaynaklandığı sonucuna vardı—bazı akıl yürütme ve örüntü tanıma görevleri, dikkatin sağladığı küresel bağlam farkındalığına gereksinim duyar. Bu sınırlamayı kabul etmek yerine, ekip hibrit mimarilerle denemeler yapmaya başladı; dikkat katmanlarını Mamba katmanlarıyla sırayla kullanarak her iki yaklaşımın avantajlarını yakalayıp yakalayamayacaklarını test ettiler. Sonuçlar beklentilerini aştı: Hibrit yaklaşım, saf Mamba modellerinde görülen performans düşüşünü tamamen ortadan kaldırmakla kalmadı, aynı zamanda sade dönüştürücü mimarilerine göre genel olarak daha iyi sonuçlar verdi. Bu keşif, Jamba’nın geliştirilmesine yol açan katalizör oldu.

Jamba’nın geliştirilmesi, daha önce bu ölçekte hiç ele alınmamış birçok teknik zorluğun çözülmesini gerektirdi. AI21, hibrit serisinin ilk modeli olan Jamba Mini’yi eğitmeye başladığında, Mamba daha önce 3 milyar parametreden büyük ölçeklenmemişti. Oysa ekibin hibrit modeli, uzman karışımı bileşenleri de hesaba katıldığında yaklaşık 52 milyar toplam parametreyle 13 milyar aktif parametreye ulaşacaktı. Bu büyük bir ölçeklendirme zorluğuydu ve ekibin, model mimarisini daha önce hiç denenmemiş şekillerde hata ayıklayıp optimize etmesini gerektirdi. Optimizasyon süreci başlı başına ilgi çekici bir mühendislik mücadelesiydi—ekip modelin davranışını dikkatlice analiz etti, darboğazları belirledi ve hibrit mimarinin bu benzersiz ölçekte verimli şekilde eğitilebilmesini sağlayacak çözümler geliştirdi.

Jamba mimarisindeki en kritik kararlardan biri, dikkat ve durum uzay katmanlarının oranının ve konumunun belirlenmesiydi. AI21, kapsamlı ablation çalışmalarıyla, her sekiz katmandan birinin dikkate, kalan yedisinin ise Mamba’ya ayrıldığı 1:8 oranının performans ve verimlilik arasında en iyi dengeyi sağladığını keşfetti. Dikkat katmanlarının konumu da önemliydi; başta, ortada ve sonda farklı yerleştirmeler test edildiğinde, ortada konumlandırmanın uçlara koymaktan çok daha iyi sonuçlar verdiği görüldü. Daha agresif oranlar (örneğin 1:6) az miktarda iyileşme gösterse de, bu kazançlar sonuçların standart sapması içindeydi ve uzun-bağlam işlemede her ek dönüştürücü katmanın anahtar-değer önbelleğine kare maliyet eklediği göz önünde bulundurulduğunda, ilave dikkat katmanlarının ek hesaplama maliyetini haklı çıkarmıyordu.

Bu mimarinin sağladığı verimlilik kazanımları hem kapsamlı hem çok yönlüdür. Eğitim sırasında, hibrit yaklaşım saf dönüştürücü modellere kıyasla hesaplama gereksinimlerini azaltarak büyük ölçekli modellerin eğitilmesini daha uygun maliyetli hale getirir. Çıkarım sırasında ise, özellikle uzun-bağlam uygulamalarında faydaları daha da belirgindir. Mamba, kısa diziler için sabit maliyeti daha yüksek olsa da, dizi uzunluğu arttıkça bu dezavantaj ortadan kalkar ve tersine döner. Uzun bağlam gerektiren uygulamalarda—ajansik kullanım senaryoları, kurumsal bilgi alma ile zenginleştirilmiş üretim sistemleri, hafızalı kişiselleştirme ve daha birçok yeni uygulama dahil—hibrit mimari çok daha iyi performans özellikleri sunar. Mamba’nın doğrusal bellek ölçeklenmesi, bağlam penceresini iki katına çıkarmanın bellek gereksinimini iki katına çıkardığı anlamına gelirken, saf dikkatle bu oran dört katına çıkar. Bu temel fark, uzun bağlam gerektiren uygulamalarda giderek daha önemli hale gelmektedir.

Kurumlar, Jamba 3B gibi gelişmiş dil modellerini giderek daha fazla benimsedikçe, bu modellerin üretim iş akışlarına entegrasyonu kritik bir zorluk haline geliyor. FlowHunt, model seçimi ve testinden dağıtım ve izlemeye kadar yapay zekâ iş akışlarının otomasyonunu sağlayan kapsamlı bir platform sunarak bu zorluğu çözüyor. Jamba 3B gibi hibrit modellerle elde edilen verimlilik kazanımları, ancak bu modellerin üretim ortamlarında nasıl dağıtıldığını, test edildiğini ve izlendiğini optimize edebilen akıllı iş akışı otomasyonu ile tam anlamıyla hayata geçebilir. FlowHunt, ekiplerin Jamba 3B gibi modellerden yararlanan sofistike yapay zekâ sistemleri oluşturmalarını, aynı zamanda tüm sürecin kontrolünü ve görünürlüğünü korumalarını sağlar. Model dağıtımının ve izlemenin rutin yönlerini otomatikleştirerek, FlowHunt ekiplerin yapay zekâ entegrasyonunun stratejik yönlerine odaklanmasını mümkün kılar ve gelişmiş mimarilerden elde edilen hesaplama verimliliği kazançlarının gerçek iş değerine dönüşmesini sağlar.

Verimli modeller ile akıllı iş akışı otomasyonunun birleşimi güçlü bir sinerji yaratır. Ekipler, Jamba 3B’yi uç cihazlarda veya bellek kısıtlı ortamlarda güvenle dağıtabilir, FlowHunt’un izleme ve optimizasyon araçlarının sürekli performansı sağlayacağından emin olabilir. Uzun-bağlam işleme, kişiselleştirme ve ajansik akıl yürütme gerektiren kurumsal yapay zekâ sistemleri için FlowHunt, bu karmaşık iş akışlarını verimli şekilde yönetmek için gerekli altyapıyı sunar. Platformun test, dağıtım ve izlemeyi otomatikleştirme yeteneği sayesinde, kurumlar manuel iş yükü olmadan farklı model yapılandırmaları ve dağıtım stratejileriyle hızlıca denemeler yapabilir. Özellikle hibrit modellerin olanaklarını keşfeden kurumlar için bu çok değerlidir; çünkü farklı mimari ve yapılandırmaları benchmark ederek kendi özel kullanım senaryoları için en iyi dengeyi bulmalarına olanak tanır.

Jamba 3B’nin piyasaya sürülmesi, gelişmiş yapay zekâ yeteneklerinin daha geniş bir uygulama ve dağıtım senaryosu yelpazesine açılmasında önemli bir dönüm noktasıdır. Jamba serisinin önceki modelleri en yüksek performans için daha büyük ölçeklere göre tasarlanırken, Jamba 3B özellikle uç cihazlar ve bellek kısıtlı ortamlar için optimize edilmiştir. “3B” ifadesi modelin yaklaşık 3 milyar parametre büyüklüğünü belirtir; bu da onu tüketici düzeyindeki donanımda çalışabilecek kadar küçük, aynı zamanda hibrit mimarinin verimlilik avantajlarını koruyacak kadar büyük yapar. Bu çok önemli bir gelişmedir, çünkü gelişmiş dil modeli yeteneklerine erişimi demokratikleştirir ve daha önce hesaplama kısıtlamaları nedeniyle imkânsız olan uygulamaları mümkün kılar. Geliştiriciler artık modern dil modellerinin değerli kılan akıl yürütme ve uzun-bağlam işleme yeteneklerinden ödün vermeden, gelişmiş dil modellerini mobil cihazlarda, IoT aygıtlarında, gömülü sistemlerde ve diğer uç bilişim platformlarında dağıtabilir.

Jamba 3B’nin en öne çıkan özelliği, uzun bağlam pencerelerini işleyebilme yeteneğini uç cihazlarda dağıtılabilir şekilde korumasıdır. Bu kombinasyon, saf dönüştürücü mimarilerle daha önce mümkün değildi—dikkatin kare karmaşıklığı, uç cihazlarda bağlam penceresini uzatmanın kullanılabilir belleği hızla tüketeceği anlamına geliyordu. Jamba 3B’nin hibrit mimarisi bu denklemi kökten değiştiriyor. Mamba katmanlarının doğrusal karmaşıklığı, bağlamın, saf dikkatli modellerde görülen üstel bellek büyümesi olmadan genişletilebilmesini sağlar. Kişiselleştirme, hafıza tutma, bilgi alma ile zenginleştirilmiş üretim ve ajansik akıl yürütme gerektiren uygulamalar için bu yetenek dönüştürücüdür. Jamba 3B çalıştıran bir uç cihaz, uzun etkileşimlerde tutarlı bağlamı koruyabilir ve daha önce yalnızca bulut tabanlı modellerle mümkün olan gelişmiş uygulamaları mümkün kılar. Bu değişim, gizlilik, gecikme ve maliyet açısından derin etkiler yaratır—uygulamalar artık hassas verileri bulut sunucularına göndermeden yerel olarak işleyebilir, kullanıcı sorgularına minimum gecikmeyle yanıt verebilir ve bulut bilişim maliyetlerine katlanmaz.

Piyasadaki mini modeller manzarası incelendiğinde, Jamba 3B, kendi büyüklük kategorisinde tek hibrit model olarak öne çıkar. Mevcut mini modellerin çoğu, saf dönüştürücü mimarilere dayanır; bu da büyük modellerdekiyle aynı verimlilik kısıtlamalarına sahip oldukları anlamına gelir. Jamba 3B’nin hibrit yaklaşımı, uzun-bağlam yetenekleri ve hesaplama verimliliği açısından ona önemli bir avantaj sağlar. Model bu ayrıcalığı, yetenekten ödün veren mimari tavizlerle değil, hibrit yaklaşımın temel verimlilik kazanımlarıyla elde eder. Bu, Jamba 3B’yi model büyüklüğüyle yeteneği dengelemek isteyen, özellikle de uç cihazlarda uzun-bağlam işleme gerektiren uygulamalar için ideal bir seçenek haline getirir.

Hibrit modellerin açık avantajlarına rağmen, yaygın şekilde benimsenmelerinin önünde önemli engeller bulunmaktadır. Yapay zekâ endüstrisi, yıllardır özel olarak dönüştürücü dikkat mekanizmaları için donanım ve yazılımı optimize etmektedir. NVIDIA GPU’lardan özelleşmiş yapay zekâ hızlandırıcılarına kadar tüm büyük donanım platformlarında, dikkat işlemleri için özel çekirdekler ve optimizasyonlar geliştirilmiştir. Bu optimizasyonlar, yıllarca süren mühendislik çabasının ürünüdür ve dikkati belirli donanımlarda mümkün olduğunca verimli hale getirmiştir. Buna karşın, Mamba gibi durum uzay modelleri nispeten yenidir ve özel çekirdeklere sahip olsalar da, bu optimizasyonlar henüz olgunlaşmamış ve farklı donanım platformlarında yaygın şekilde uygulanmamıştır. Bu, Barak Lenz’in “donanım piyangosu” olarak adlandırdığı durumu yaratır—hibrit modellerin verimlilik avantajları, donanım platformu durum uzay modeli işlemleri için optimize edilmemişse önemli ölçüde azalabilir.

Bu donanım optimizasyonu açığı, benimseme için gerçek bir engel teşkil etse de, aşılması imkânsız değildir ve zamanla azalacaktır. Daha fazla şirket hibrit modellerin ve durum uzay mimarilerinin değerini fark ettikçe, donanım üreticileri de bu işlemler için optimizasyona yatırım yapmaya daha teşvikli olacaktır. NVIDIA hibrit modelleri piyasaya sürmeye başladı ve diğer şirketler de onu izledi; bu da sektörün bu mimarilerin uzun vadeli önemini fark ettiğine işaret ediyor. Ayrıca, hibrit modellerin verimlilik avantajları o kadar büyüktür ki, mükemmel donanım optimizasyonu olmasa bile genellikle saf dikkatli modellerden daha iyi performans gösterirler. Dikkatin kare karmaşıklığı, o kadar temel bir sınırlamadır ki, yıllarca süren optimizasyona rağmen, uzun-bağlam uygulamalarında durum uzay modellerinin doğrusal karmaşıklığıyla boy ölçüşemez. Uygulamalar daha fazla bağlam talep ettikçe (ki bu kaçınılmaz bir trendtir), hibrit modellerin avantajları giderek inkâr edilemez hale gelecektir.

AI21’in hibrit modelleri üzerindeki çalışmasının ötesinde, sektörde dikkatin her katmanda kullanılmasının gereksiz ve israf olduğunu kabul eden daha geniş bir eğilim ortaya çıkıyor. Tam hibrit mimariler uygulamayan şirketler bile, tam dikkatin her katmanda gereksiz olduğunu fark ediyor. Birçok yeni model, her token’ın yalnızca çevresindeki sınırlı bir pencereye dikkat edebildiği kayar pencere dikkati kullanıyor. Bu yaklaşım, pencere boyutuna göre dikkatin karmaşıklığını kareden doğrusal hale indirir; yine de durum uzay modellerinden daha fazla hesaplama gerektirir. Noam Shazir gibi araştırmacıların da yerel ve küresel dikkat için 1:8 oranının optimal olduğuna dair benzer sonuçlara bağımsız olarak ulaşması, bunun tesadüfi değil, dil modellerinin nasıl yapılandırılması gerektiğine dair temel bir özellik olduğunu gösteriyor.

Farklı araştırma grupları ve şirketler arasında bu bulguların örtüşmesi, sektörün optimal model mimarisi hakkında yeni bir fikir birliğine doğru ilerlediğini gösteriyor. GPT-2’den bu yana hakim olan saf dönüştürücü yaklaşımı yerine, gelecekte büyük olasılıkla dikkat mekanizmasını seçici kullanan modeller göreceğiz—bu ister Jamba gibi hibrit mimarilerle ister kayar pencere dikkati gibi diğer yaklaşımlarla olsun. Spesifik uygulama detayları değişebilir, ancak temel ilke aynıdır: Her katmanda tam dikkat verimsiz ve gereksizdir. Bu değişim, alanın olgunlaşmasının bir göstergesidir; dönüştürücülerin ilk başarısının ötesine geçerek, dikkatin ne zaman ve nerede gerçekten gerekli olduğuna dair daha incelikli bir anlayışa ulaşılmıştır. Yapay zekâ sistemleri inşa eden uygulayıcılar ve kurumlar için bu değişim önemli sonuçlar doğurur—gelecekte inşa edip dağıtacakları modellerin, mevcut yaklaşımlardan daha verimli olması muhtemeldir ve bu da şu anda hesaplama kısıtları nedeniyle pratik olmayan yeni uygulamalara ve kullanım senaryolarına olanak sağlar.

FlowHunt ile araştırmadan içerik üretimine, yayınlamadan analizlere kadar tüm yapay zekâ içerik ve SEO iş akışlarınızı otomatikleştirin—hepsi tek bir platformda.

Tekil modellerin ötesinde, AI21, yalnızca dil modeli çıkarımının ötesine geçen yapay zekâ sistemlerinin geliştirilmesinde öncülük ediyor. Şirket, dil modeli yeteneklerini artırmak için araçlar ve harici kaynaklar kullanan erken dönem bir yapay zekâ sistemi olan Jarvis’i piyasaya sürdü. Bu çalışma, dil modellerinde araç kullanımının yaygınlaşmasından önce gerçekleşmiş ve LangChain gibi sonraki çerçevelere ilham vermiştir. Yapay zekâ sistemlerinin temel sezgisi, tek başına dil modellerinin, güçlü olsalar da, birçok gerçek dünya uygulaması için yeterli olmadığıdır. Derin öğrenmeyle klasik yapay zekâ arasındaki boşluğu kapatmak için, sistemlerin harici araçları çağırabilmeleri, veritabanlarına erişebilmeleri, kod çalıştırabilmeleri ve saf sinir ağı çıkarımından daha fazla titizlik ve deterministlik gerektiren işlemleri gerçekleştirebilmeleri gerekir.

AI21’in kurumsal ürünü Maestro, bu düşüncenin üretime hazır bir sisteme evrilmiş halini temsil eder. Maestro, yalnızca bir dil modeli dağıtıp faydalı çıktılar üretmesini ummak yerine, dil modeli yeteneklerini araç kullanımı, bilgi alma ve diğer klasik yapay zekâ teknikleriyle birleştirerek karmaşık görevleri güvenilir şekilde yerine getirebilen yapay zekâ sistemleri inşa etmek için bir çerçeve sunar. Bu yaklaşım, güvenilirlik, doğruluk ve denetlenebilirliğin kritik gereksinimler olduğu kurumsal uygulamalarda özellikle önemlidir. Bir dil modeli, kulağa makul gelen ancak hatalı bilgiler üretebilirken, çıktısını harici veri kaynaklarıyla doğrulayabilen ve belirli görevleri yerine getirmek için araç kullanabilen bir yapay zekâ sistemi çok daha yüksek güvenilirlik sağlayabilir. Kurumsal ortamda yapay zekâ sistemlerinin benimsenmesi, bazı tahminlerin aksine yavaş ilerlese de, kurumlar iş akışlarını ve karar alma süreçlerini otomatikleştirmede yapay zekânın değerini fark ettikçe bu durum değişmektedir.

Bu kaymanın zamanlaması önemlidir. Üretken yapay zekâ ana akım teknoloji haline ilk geldiğinde, birçok kuruluş içerik üretimi ve müşteri hizmeti sohbet botları gibi basit uygulamalara odaklanmıştı. Bu uygulamalar, genellikle minimal ek altyapı ile bir dil modeli ile yeterince hizmet alabiliyordu. Ancak kurumlar yapay zekâ ile deneyim kazanıp daha sofistike kullanım senaryoları belirledikçe, saf dil modellerinin sınırları görünür hale geldi. Uzun-bağlam işleme, kişiselleştirme, hafıza tutma ve ajansik akıl yürütme gerektiren uygulamalar, yapay zekâ sistemlerinin sağladığı yapılandırılmış yaklaşımın avantajını hisseder. Ayrıca, Jamba 3B gibi modellerle elde edilen verimlilik artışları, gelişmiş yapay zekâ sistemlerini uç cihazlarda ve kaynakları sınırlı ortamlarda dağıtmayı giderek daha pratik hale getiriyor. Daha verimli modeller ve daha sofistike sistem mimarilerinin birleşimi, kurumsal yapay zekâ dağıtımında yeni olanaklar yaratıyor.

Uygulamalarında gelişmiş dil modellerinden nasıl yararlanabileceklerini değerlendiren geliştiriciler ve kuruluşlar için, Jamba 3B’nin ve hibrit mimarilerin ortaya çıkışı birkaç önemli sonucu beraberinde getiriyor. Birincisi, saf dönüştürücü modellerin çağı, en azından yeni geliştirmeler için, sona yaklaşıyor olabilir. Mevcut dönüştürücü modeller kullanılmaya ve iyileştirilmeye devam edecek olsa da, yeni modeller giderek hibrit mimariler ya da seçici dikkat mekanizmalarını içerecek. Bu da geliştiricilerin, bu yeni mimarilerle aşina olmaya ve bunların özelliklerini, avantajlarını ve sınırlamalarını anlamaya başlamaları gerektiği anlamına gelir. İkincisi, hibrit modellerle elde edilen verimlilik kazanımları, daha önce mümkün olmayan senaryolarda—uç cihazlarda, mobil uygulamalarda ve kaynakları sınırlı ortamlarda—sofistike dil modellerinin dağıtılmasını pratik hale getiriyor. Bu da, verilerin yerel olarak işlenebildiği, gizliliğin korunduğu ve minimum gecikmeyle yanıt alınabilen yeni uygulama olanakları açıyor.

Üçüncüsü, Jamba 3B gibi modellerin uzun-bağlam yetenekleri, daha önce pratik olmayan yeni uygulama kalıplarını mümkün kılıyor. Artık uygulamalar, uzun etkileşimlerde tutarlı bağlamı koruyabiliyor; bu da daha sofistike kişiselleştirme, hafıza tutma ve ajansik akıl yürütme için yol açıyor. Özellikle çoklu etkileşimlerde bağlamın korunmasının ve harici sistemlerle entegrasyonun kritik olduğu kurumsal uygulamalar için bu çok değerli. Dördüncüsü, verimli modeller ile FlowHunt gibi akıllı iş akışı otomasyon platformlarının birleşimi hızlı yineleme ve deneme için yeni olanaklar sunar. Kurumlar, farklı model yapılandırmalarını, dağıtım stratejilerini ve sistem mimarilerini, büyük hesaplama maliyetlerine katlanmadan test edebilir. Bu yapay zekâ denemelerinin demokratikleşmesi, inovasyonu hızlandıracak ve henüz hayal etmediğimiz yeni uygulama ve kullanım senaryolarına yol açacaktır.

Kanıtlar giderek, hibrit modellerin geçici bir trend olmadığını, dil modeli geliştirmesinin gelecekteki yönünü temsil ettiğini gösteriyor. Verimlilik avantajları göz ardı edilemeyecek kadar büyüktür ve performans özellikleri çoğu benchmarkta saf dönüştürücü modellerle rekabetçi veya daha iyidir. Donanım üreticileri, durum uzay modelleri ve diğer verimli mimariler için optimizasyona yatırım yaptıkça, hibrit modellerin pratik avantajları daha da artacaktır. Ayrıca, hibrit mimariler, kayar pencere dikkati veya diğer yöntemlerle seçici dikkat eğilimi, alanın model mimarisi hakkında temel bir değişime gittiğine işaret ediyor. Son birkaç yıla hakim olan saf dönüştürücü yaklaşımı, farklı amaçlar için farklı mekanizmalar kullanan daha incelikli mimarilere yerini bırakıyor.

Yapay zekâ sistemleri inşa eden kurumlar için bu değişim önemli stratejik sonuçlara sahiptir. Hibrit modelleri anlamaya ve onlarla çalışmaya bugünden yatırım yapmak, sundukları verimlilik ve yetenek kazanımlarından yararlanmak için kurumları avantajlı konuma getirir. Jamba 3B gibi verimli modellerin, sofistike yapay zekâ

Hibrit bir LLM, dönüştürücü dikkat mekanizmalarını Mamba gibi durum uzay modelleriyle birleştirir. Tamamen dikkate dayalı (kare hesaplama karmaşıklığına sahip) geleneksel dönüştürücü modellerin aksine, hibrit modeller dikkati seçici olarak—genellikle 1:8 oranında—kullanır ve katmanların çoğunda doğrusal karmaşıklığa sahip durum uzay modellerinden yararlanır. Bu yaklaşım, performans kalitesini korurken hesaplama ve bellek gereksinimlerini önemli ölçüde azaltır.

Jamba 3B, uzun-bağlam işleme yeteneklerine sahipken, bellek kısıtlı ortamlarda çalışacak kadar küçük bir ayak izine sahip olacak şekilde optimize edilmiştir. Hibrit mimarinin verimliliği sayesinde model, tek bir GPU'da veya uç cihazlarda geniş bağlam pencerelerini işleyebilme yetisini kaybetmeden çalışabilir, bu da onu cihaz üzerinde yapay zekâ uygulamaları için ideal kılar.

AI21'in kapsamlı ablation çalışmaları sonucunda, her 8 katmanda yalnızca 1'inde dikkat kullanmanın (kalan 7'sinde Mamba ile) performans ve verimlilik arasında en iyi dengeyi sağladığı tespit edilmiştir. Dikkat katmanları, modelin başında ya da sonunda değil, ortasında stratejik olarak konumlandırılmıştır ve bu yerleşim deneysel olarak daha iyi sonuçlar vermiştir. Bu oran, dikkatin kare maliyetini minimize ederken modelin karmaşık akıl yürütme görevlerini yerine getirebilme yetisini korur.

Hibrit modellerin başlıca avantajları şunlardır: Azaltılmış hesaplama gereksinimleri sayesinde çok daha düşük eğitim maliyetleri, uzun-bağlam uygulamalarında daha yüksek verimlilik, kare yerine doğrusal bellek ölçeklenmesi ve çoğu benchmarkta korunan veya iyileştirilen performans. Ayrıca, büyük dil modellerinin değerli kılan akıl yürütme yeteneklerini koruyarak, uç cihazlarda ve bellek kısıtlı ortamlarda dağıtımı mümkün kılarlar.

Arshia, FlowHunt'ta bir Yapay Zeka İş Akışı Mühendisidir. Bilgisayar bilimi geçmişi ve yapay zekaya olan tutkusu ile, yapay zeka araçlarını günlük görevlere entegre eden verimli iş akışları oluşturmada uzmanlaşmıştır ve bu sayede verimlilik ile yaratıcılığı artırır.

FlowHunt'un akıllı otomasyon platformu ile yapay zekâ model dağıtımınızı, testlerinizi ve optimizasyonunuzu kolaylaştırın.

Llama 3.3 70B Versatile 128k'in bir AI Ajanı olarak gelişmiş yeteneklerini keşfedin. Bu derinlemesine inceleme, modelin akıl yürütme, problem çözme ve yaratıcı ...

Büyük Dil Modeli (LLM), insan dilini anlamak, üretmek ve üzerinde işlem yapmak için geniş metin verileriyle eğitilmiş bir yapay zeka türüdür. LLM'ler, metin üre...

HuggingFace tarafından kullanılan modern dil modeli ön-eğitim stratejileri, veri kürasyonu teknikleri ve optimizasyon yöntemlerine dair kapsamlı bir rehber. Ver...

Çerez Onayı

Göz atma deneyiminizi geliştirmek ve trafiğimizi analiz etmek için çerezleri kullanıyoruz. See our privacy policy.