MCP Sunucu Örnekleri: AI Ajanları için Akıllı Entegrasyonlar Oluşturma

Kapsamlı MCP sunucu örneklerini keşfedin ve Model Context Protocol sunucularını oluşturarak, dağıtarak ve entegre ederek kurumsal sistemlerde AI ajanlarının yet...

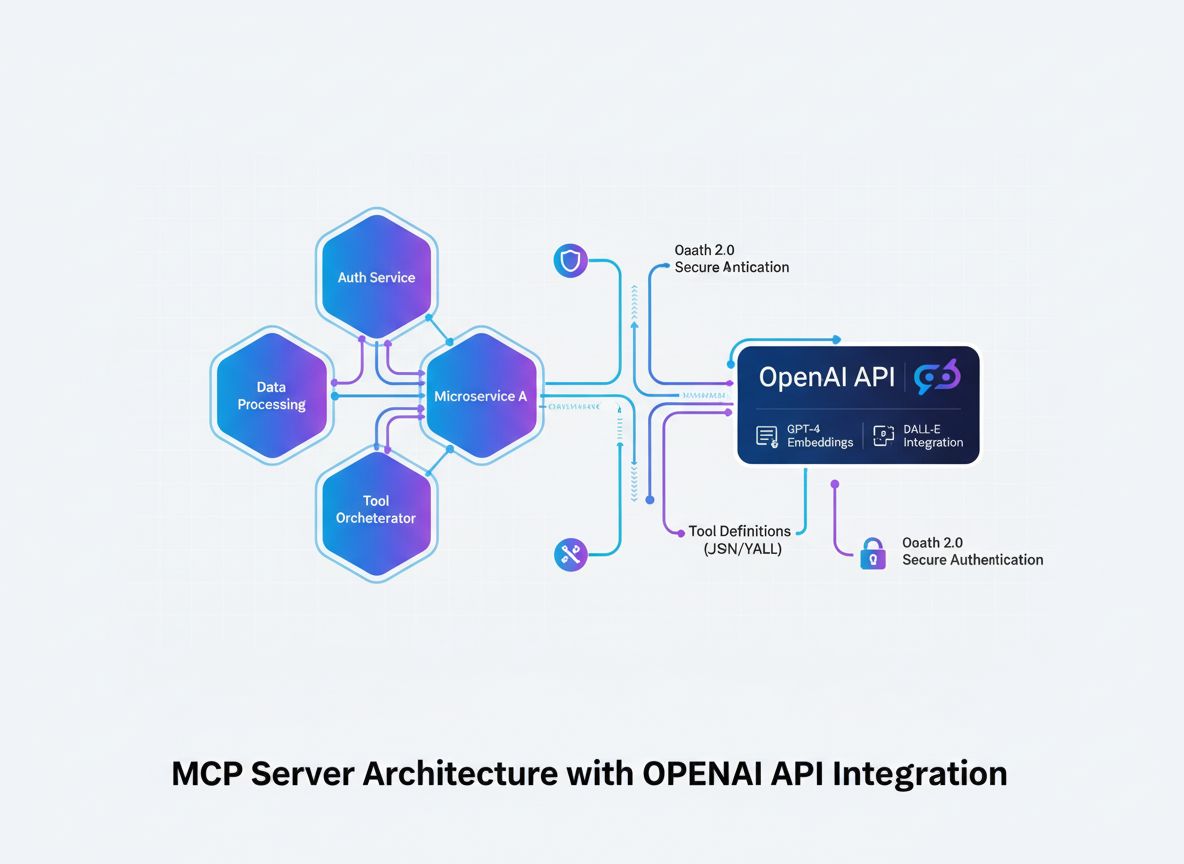

Model Context Protocol (MCP) sunucusunun, OpenAI’nin API’siyle sorunsuz şekilde entegre olarak güçlü yapay zeka destekli araç çalıştırma ve akıllı otomasyon sağlamasını nasıl geliştireceğinizi öğrenin.

Model Context Protocol (MCP), yapay zeka sistemlerinin harici araçlarla ve veri kaynaklarıyla nasıl etkileşime girdiğine dair bir paradigma değişimini temsil eder. OpenAI’nin güçlü dil modelleriyle birleştirildiğinde, bir MCP sunucusu akıllı otomasyona açılan bir kapı haline gelir; yapay zeka sistemlerinin karmaşık işlemleri gerçekleştirmesini, gerçek zamanlı veri almasını ve mevcut altyapınızla sorunsuz entegre olmasını sağlar. Bu kapsamlı rehber, OpenAI’ye bağlanan bir MCP sunucusunun geliştirilmesi sürecini temel kavramlardan üretim ortamı uygulamasına kadar adım adım anlatır.

İster bir müşteri hizmetleri otomasyon platformu, ister akıllı veri işleme sistemi, ister gelişmiş bir iş zekâsı aracı oluşturun; bir MCP sunucusunun mimarisini ve uygulamasını bilmek modern yapay zeka geliştirme için gereklidir. MCP sunucuları ile OpenAI’nin entegrasyonu, yapay zeka modellerinin sorunlar üzerinde akıl yürütmesini, hangi araçların kullanılacağına karar vermesini ve bu araçları hassasiyetle çalıştırmasını sağlayan güçlü bir ekosistem oluşturur—tüm bunları güvenlik, güvenilirlik ve ölçeklenebilirlikten ödün vermeden gerçekleştirir.

Model Context Protocol, yapay zeka modellerinin harici araçları, servisleri ve veri kaynaklarını keşfetmesini ve onlarla etkileşime geçmesini tanımlayan açık bir standarttır. Tüm işlevlerin doğrudan bir yapay zeka modeline gömülmesi yerine, MCP geliştiricilerin standart bir arayüz üzerinden yetenekler sunan özel sunucular oluşturmasına olanak tanır. Bu sorumlulukların ayrılması, yapay zeka uygulamalarında daha iyi modülerlik, güvenlik ve ölçeklenebilirlik sağlar.

MCP’nin temelinde basit bir ilke yatar: Yapay zeka modeli (bu durumda OpenAI’nin GPT’si), kullanılabilir araçların neler olduğunu anlayabilen, ne zaman kullanılacağına karar verebilen ve sonuçlarını yorumlayabilen akıllı bir orkestratör gibi hareket eder. MCP sunucusu ise bu araçların sağlayıcısı olarak davranır ve araçları yapay zeka modelinin keşfedip kullanabileceği iyi tanımlanmış bir API üzerinden sunar. Böylece yapay zeka sistemi ile özel iş mantığınız arasında net bir sözleşme oluşur.

MCP’nin güzelliği esnekliğindedir. Sunucunuz, veritabanı sorguları, üçüncü taraf servislere API çağrıları, dosya işleme, hesaplamalar hatta karmaşık iş akışlarının tetiklenmesi gibi her türlü araçları sunabilir. Yapay zeka modeli ise bu yetenekleri öğrenir ve sohbetler sırasında bunları akıllıca kullanır; kullanıcının isteğine ve konuşmanın bağlamına göre hangi aracı çağıracağına karar verir.

MCP sunucularının OpenAI ile entegrasyonu, büyük dil modellerinin temel bir sınırlamasını ortadan kaldırır: bilgi kesilme noktaları vardır ve gerçek zamanlı sistemler veya özel verilere doğrudan erişemezler. Bir MCP sunucusu uygulayarak, OpenAI’nin modellerinin yeteneklerini temel eğitimlerinin çok ötesine taşıyabilir; güncel bilgilere erişmesini, iş mantığını çalıştırmasını ve mevcut sistemlerinizle entegre olmasını sağlayabilirsiniz.

MCP sunucularının paha biçilmez olduğu bazı pratik senaryolar şunlardır:

Bu mimari aynı zamanda geliştirme ekipleri için büyük avantajlar sağlar. Birden fazla ekip kendi MCP sunucularını bağımsız olarak geliştirip yönetebilir ve bunlar bir araya getirilerek gelişmiş yapay zeka uygulamaları oluşturulabilir. Bu modüler yaklaşım, organizasyonunuz büyüdükçe ve yapay zeka yetenekleriniz karmaşıklaştıkça kolayca ölçeklenir.

Uygulama ayrıntılarına geçmeden önce, bir MCP sunucusunun OpenAI ile nasıl entegre olduğunun mimari akışını anlamak kritik önem taşır. Süreçte birkaç temel bileşen birlikte çalışır:

Yapay Zeka Modeli (OpenAI) sohbetleri başlatır ve hangi araçların çağrılacağına karar verir. Model, bir araç çağrısı gerektiğine karar verdiğinde araç adını ve parametreleri içeren yapılandırılmış bir istek üretir.

MCP İstemcisi, tercüman ve aracı görevi görür. OpenAI’den gelen araç çağrı isteklerini alır, bunları MCP sunucunuzun beklediği formata çevirir, uygun sunucuya gönderir ve sonuçları OpenAI’ye modelin beklediği formatta geri döndürür.

MCP Sunucusu, araçlarınızı ve yeteneklerinizi sunan özel uygulamanızdır. MCP istemcisinden gelen istekleri alır, istenen işlemleri (veritabanı sorguları, API çağrıları veya karmaşık hesaplamalar olabilir) gerçekleştirir ve yapılandırılmış sonuçları döner.

Araç Tanımları, hangi araçların mevcut olduğunu, hangi parametreleri kabul ettiklerini ve neler döndürdüklerini tanımlayan sözleşmelerdir. Bu tanımlar MCP istemcisi tarafından keşfedilir ve OpenAI’ye kaydedilir, böylece model mevcut olanı bilir.

Bu mimari, sorumlulukların net şekilde ayrılmasını sağlar: OpenAI akıl yürütme ve karar verme işlevini üstlenir, MCP sunucunuz alanınıza özgü mantık ve veri erişimini yönetir, MCP istemcisi ise aradaki iletişim protokolünü yürütür.

Başarılı bir MCP sunucusunun temeli, sunmak istediğiniz araçların net bir şekilde tanımlanmasıdır. Bu sadece teknik bir egzersiz değil; yapay zeka sisteminizin hedeflerine ulaşmak için hangi yeteneklere ihtiyaç duyduğuna dair stratejik bir karardır.

Yapay zeka sisteminizin çözmesi gereken somut problemleri belirleyerek başlayın. Sipariş bilgisi sorgulayabilen bir müşteri hizmetleri sohbet botu mu geliştiriyorsunuz? Veritabanlarını sorgulayabilen bir veri analiz asistanı mı? Şirketinizin bilgi tabanına erişen bir içerik üretim aracı mı? Her kullanım senaryosunun farklı araç gereksinimleri olacaktır.

Her araç için şunları tanımlayın:

get_customer_order_history, search_knowledge_base, execute_sql_query)İşte iyi tanımlanmış araç spesifikasyonlarına örnek:

| Araç Adı | Amacı | Girdi Parametreleri | Çıktı Formatı | Kullanım Senaryosu |

|---|---|---|---|---|

get_customer_info | Müşteri detaylarını getirir | customer_id (string) | Ad, e-posta, hesap_durumu içeren JSON nesnesi | Müşteri hizmetleri sorguları |

search_orders | Kriterlere uyan siparişleri bulur | customer_id, date_range, status | Sipariş nesneleri dizisi | Sipariş sorgulama ve geçmiş |

create_support_ticket | Yeni destek kaydı açar | customer_id, issue_description, priority | ID ve onay içeren Ticket nesnesi | Sorun yükseltme |

check_inventory | Ürün stok durumu sorgular | product_id, warehouse_location | Stok miktarı ve lokasyon bilgisi | Stok sorgulamaları |

process_refund | İade işlemi başlatır | order_id, amount, reason | Referans numarası ile işlem onayı | İade işlemleri |

Bu tablo tabanlı yaklaşım, kod yazmaya başlamadan önce tüm araç ekosisteminizi düşünmenizi sağlar. Tanımlarınızda tutarlılık, netlik ve bütünlük sağlar.

Bir MCP sunucusu oluşturmak için sağlam bir geliştirme altyapısı gerekir. MCP sunucuları birçok dilde yazılabilse de, en popüler yaklaşımlar olan TypeScript/Node.js ve Python’a odaklanacağız; çünkü bu diller MCP kütüphaneleri ve topluluk desteği açısından en olgun olanlardır.

TypeScript/Node.js Geliştirme için:

Yeni bir Node.js projesi oluşturup gerekli bağımlılıkları yükleyin:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

TypeScript’i yapılandırmak için bir tsconfig.json dosyası oluşturun:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Python Geliştirme için:

Sanal ortam oluşturup bağımlılıkları yükleyin:

python -m venv venv

source venv/bin/activate # Windows için: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Dil tercihiniz ne olursa olsun ihtiyacınız olacaklar:

.env dosyası oluşturunMCP sunucunuzun çekirdeği, araçlarınızı MCP protokolü üzerinden sunan sunucu uygulamasıdır. Bu, araç keşfi ve araç çalıştırma için uç noktaların oluşturulmasını içerir.

TypeScript/Node.js Uygulaması:

Temel bir MCP sunucu yapısı oluşturun:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Araçlarınızı tanımlayın

const tools = [

{

name: "get_customer_info",

description: "ID ile müşteri bilgisini getirir",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Benzersiz müşteri kimliği",

},

},

required: ["customer_id"],

},

},

// Diğer araçları burada ekleyin

];

// Araç listeleme isteklerini yönetin

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Araç çalıştırma isteklerini yönetin

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Araç mantığını burada uygulayın

const customerId = args.customer_id;

// Veritabanı veya API'nizi sorgulayın

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Bilinmeyen araç: ${name}` }],

isError: true,

};

});

// Sunucuyu başlatın

const transport = new StdioServerTransport();

server.connect(transport);

Python Uygulaması:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Araçlarınızı tanımlayın

TOOLS = [

Tool(

name="get_customer_info",

description="ID ile müşteri bilgisini getirir",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Benzersiz müşteri kimliği"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Araç mantığını burada uygulayın

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Bilinmeyen araç: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

MCP sunucunuzun asıl gücü, araçlarınızın gerçek uygulamasından gelir. Burada veritabanlarına bağlanır, harici API’leri çağırır, verileri işler ve iş mantığını yürütürsünüz.

Veritabanı Entegrasyonu Örneği:

import { Pool } from "pg"; // PostgreSQL örneği

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Müşteri bulunamadı",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Veritabanı sorgusu başarısız oldu",

details: error.message,

status: 500,

};

}

}

Harici API Entegrasyonu Örneği:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Harici API çağrısı başarısız oldu",

details: error.message,

};

}

}

Hata Yönetimi ve Doğrulama:

Üretim MCP sunucuları için sağlam hata yönetimi şarttır. Kapsamlı doğrulama ve hata yönetimi uygulayın:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Gerekli alanları doğrula

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Gerekli parametre eksik: ${required}` };

}

}

// Alan tiplerini doğrula

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Parametre ${key} şu tipte olmalı: ${expectedType}`,

};

}

}

}

return { valid: true };

}

MCP istemcisi, OpenAI ile MCP sunucunuz arasındaki köprüdür. OpenAI’nin fonksiyon çağırma formatı ile MCP sunucunuzun protokolü arasındaki çeviriyi yürütür.

TypeScript/Node.js MCP İstemcisi:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// MCP sunucusuna bağlan

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Kullanılabilir araçları keşfet

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// MCP araçlarını OpenAI fonksiyon formatına dönüştür

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Araç çağrılarını döngüde işle

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// MCP sunucusunda aracı çalıştır

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Sonucu mesajlara ekle

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// OpenAI'den sonraki cevabı al

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Kullanım

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Müşteri 12345'in sipariş geçmişi nedir?"

);

console.log(result);

Duyarlı veriler ve harici API’lerle etkileşime giren MCP sunucuları oluştururken güvenlik en üst düzeyde önemlidir. Birden fazla güvenlik katmanı uygulayın:

API Anahtar Yönetimi:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Geçerli API anahtarlarını ortamdan veya güvenli depodan yükle

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

İstek İmzalama ve Doğrulama:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Hız Sınırlama:

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 dakika

max: 100, // Her IP için 100 istek sınırı

message: "Bu IP'den çok fazla istek geldi, lütfen daha sonra tekrar deneyin.",

});

app.use("/api/", limiter);

Girdi Temizleme:

function sanitizeInput(input: string): string {

// Potansiyel olarak tehlikeli karakterleri temizle

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Uzunluk sınırı

}

function validateCustomerId(customerId: string): boolean {

// Sadece alfanumerik ve tire izin ver

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Kapsamlı testler, MCP sunucunuzun düzgün çalışmasını ve sınır durumları zarifçe yönetmesini sağlar.

Birim Testi Örneği (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Müşteri Araçları", () => {

test("Geçerli ID ile müşteri bilgisi döndürmeli", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("Geçersiz ID için hata döndürmeli", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("Veritabanı hatalarını düzgün yönetmeli", async () => {

// Veritabanı hatası örneği

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Entegrasyon Testleri:

describe("MCP Sunucu Entegrasyonu", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Sunucuyu başlat

});

test("Tüm mevcut araçları listelemeli", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("Aracı çalıştırıp sonuç döndürmeli", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt, MCP sunucu geliştirme, test ve dağıtımının tüm yaşam döngüsünü otomatikleştirmek için kapsamlı bir platform sunar. MCP sunucu iş akışınızın her adımını manuel olarak yönetmek yerine, FlowHunt tekrar eden görevleri yöneten ve geliştirme süreçlerinizde tutarlılık sağlayan akıllı otomasyon akışları oluşturmanıza olanak tanır.

Otomatik Test ve Doğrulama:

FlowHunt, kodunuzu her gönderdiğinizde birim testlerini, entegrasyon testlerini ve uçtan uca testleri otomatik olarak çalıştırabilir. Böylece MCP sunucu araçlarınızın üretime alınmadan önce daima doğru çalıştığından emin olursunuz.

Sürekli Entegrasyon ve Dağıtım:

FlowHunt iş akışlarını, MCP sunucunuzda bir değişiklik yapıldığında otomatik olarak derleme, test etme ve dağıtım yapacak şekilde ayarlayabilirsiniz. Bu, manuel dağıtım adımlarını ortadan kaldırır ve insan hatası riskini azaltır.

İzleme ve Bildirim:

FlowHunt, MCP sunucunuzun sağlığını izleyebilir, API yanıt sürelerini takip edebilir ve herhangi bir sorun olduğunda sizi uyarabilir. Bir araç çalışmamaya başlarsa veya performans düşerse, hemen haberdar edilir ve müdahale edebilirsiniz.

Dokümantasyon Oluşturma:

MCP sunucu araçlarınız için API dokümantasyonunu otomatik olarak üretebilir ve bunu gerçek uygulamanızla senkron tutabilirsiniz. Geliştiriciler böylece daima güncel ve doğru arayüz bilgilerine sahip olur.

Performans Optimizasyonu:

FlowHunt analizleri, araç yürütmelerindeki darboğazları tespit etmenizi sağlar. Hangi araçların en sık çağrıldığını, hangilerinin en yüksek gecikmeye sahip olduğunu görebilir ve optimizasyon çabalarınızı en çok etki edecek yerlere yönlendirebilirsiniz.

Bir MCP sunucusunu üretime almak dikkatli planlama ve uygulama gerektirir. Şu dağıtım stratejilerini göz önünde bulundurun:

Docker Konteynerleştirme:

MCP sunucunuz için bir Dockerfile oluşturun:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Konteyneri oluşturup registry’ye gönderin:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Kubernetes Dağıtımı:

Konteynerleştirilmiş MCP sunucunuzu Kubernetes’e dağıtın:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Çevre Konfigürasyonu:

Tüm yapılandırmalar için ortam değişkenleri kullanın:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

MCP sunucunuz karmaşıklaştıkça, aşağıdaki ileri düzey desenleri göz önünde bulundurun:

Araç Bileşimi:

Birden fazla alt aracı birleştiren üst seviye araçlar oluşturun:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Müşteri bilgisi al

const customer = await getCustomerInfo(customerId);

// Sipariş detayını al

const order = await getOrderDetails(orderId);

// Sipariş müşteriye mi ait kontrol et

if (order.customerId !== customerId) {

throw new Error("Sipariş müşteriye ait değil");

}

// İade işlemini başlat

const refund = await createRefund(orderId, amount);

// Bildirim gönder

await sendNotification(customer.email, `₺${amount} tutarında iade işlendi`);

return refund;

}

Önbellekleme Stratejisi:

Gecikmeyi ve API çağrılarını azaltmak için önbellekleme uygulayın:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // 10 dakika TTL

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Önce önbelleği kontrol et

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Veritabanından getir

const customer = await getCustomerInfo(customerId);

// Önbelleğe al

cache.set(cacheKey, customer);

return customer;

}

Asenkron İşlem Kuyruğu:

Uzun süren işlemler için asenkron iş kuyruğu uygulayın:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

Model Context Protocol, OpenAI'nin GPT'si gibi yapay zeka modellerinin, harici sunucular tarafından sağlanan araçları ve fonksiyonları keşfetmesini, anlamasını ve çalıştırmasını sağlayan standartlaştırılmış bir çerçevedir. Yapay zeka modelleri ile özel iş mantığı arasında bir köprü görevi görür.

Uygun izinlere sahip geçerli bir OpenAI API anahtarına ihtiyacınız var. MCP sunucusunun kendisi OpenAI'den özel bir izin gerektirmez—standart API çağrıları üzerinden iletişim kurar. Ancak, MCP sunucunuzda uygun kimlik doğrulama ve yetkilendirme uygulamanız gerekir.

MCP sunucuları, HTTP/REST API'leri veya WebSocket bağlantılarını destekleyen herhangi bir dilde oluşturulabilir. Popüler seçenekler Python, TypeScript/Node.js, Java, C#/.NET ve Go'dur. Dil seçimi mevcut altyapınıza ve ekip uzmanlığınıza bağlıdır.

Hız sınırlamasını MCP sunucusu tarafında uygulayın, sıkça istenen sonuçları önbelleğe alın, yeniden denemeler için üssel geri çekilme kullanın ve OpenAI API kullanımınızı izleyin. Yükü yönetmek için araç istekleri için bir kuyruk sistemi oluşturmayı da düşünebilirsiniz.

Arshia, FlowHunt'ta bir Yapay Zeka İş Akışı Mühendisidir. Bilgisayar bilimi geçmişi ve yapay zekaya olan tutkusu ile, yapay zeka araçlarını günlük görevlere entegre eden verimli iş akışları oluşturmada uzmanlaşmıştır ve bu sayede verimlilik ile yaratıcılığı artırır.

FlowHunt'ın akıllı otomasyon platformu ile MCP sunucu geliştirme, test etme ve dağıtım süreçlerinizi kolaylaştırın.

Kapsamlı MCP sunucu örneklerini keşfedin ve Model Context Protocol sunucularını oluşturarak, dağıtarak ve entegre ederek kurumsal sistemlerde AI ajanlarının yet...

MCP (Model Context Protocol) sunucularının ne olduğunu, nasıl çalıştığını ve neden yapay zeka entegrasyonunda devrim yarattığını öğrenin. MCP'nin AI ajanlarını ...

Yapay Zekâ (YZ) modellerini harici araçlar ve veri kaynaklarıyla bağlamak için bir Model Context Protocol (MCP) sunucusunun nasıl inşa edileceğini ve dağıtılaca...

Çerez Onayı

Göz atma deneyiminizi geliştirmek ve trafiğimizi analiz etmek için çerezleri kullanıyoruz. See our privacy policy.