Hugging Face Transformers

Hugging Face Transformers, makine öğrenimi görevleri için NLP, bilgisayarla görme ve ses işleme alanlarında Transformer modellerinin kolayca uygulanmasını sağla...

HuggingFace tarafından kullanılan modern dil modeli ön-eğitim stratejileri, veri kürasyonu teknikleri ve optimizasyon yöntemlerine dair kapsamlı bir rehber. Verimli, yüksek performanslı açık kaynak modeller nasıl inşa edilir?

Dil modeli geliştirme alanı son yıllarda köklü bir değişim geçirdi. Büyük teknoloji şirketleri model ölçeğinin sınırlarını zorlamaya devam ederken, açık kaynak topluluğu olağanüstü başarının trilyon parametreli modellere gerek olmadığını keşfetti. Bu kapsamlı rehber, HuggingFace araştırmacılarının verimli ve yüksek performanslı dil modelleri inşa etmek için uyguladığı öncü teknikleri ve stratejileri inceliyor. SmolLM 3, FineWeb ve FinePDF’in pratik hesaplama kısıtları içinde, bilimsel titizlik ve tekrarlanabilirliği koruyarak performansı en üst seviyeye çıkaran yeni bir model geliştirme paradigmasını nasıl temsil ettiğini tartışacağız. Buradaki içgörüler, aylar süren araştırma ve deneylerin sonucudur ve modern çağda model ön-eğitiminin nasıl ele alınacağına dair bir ustalık sınıfı sunar.

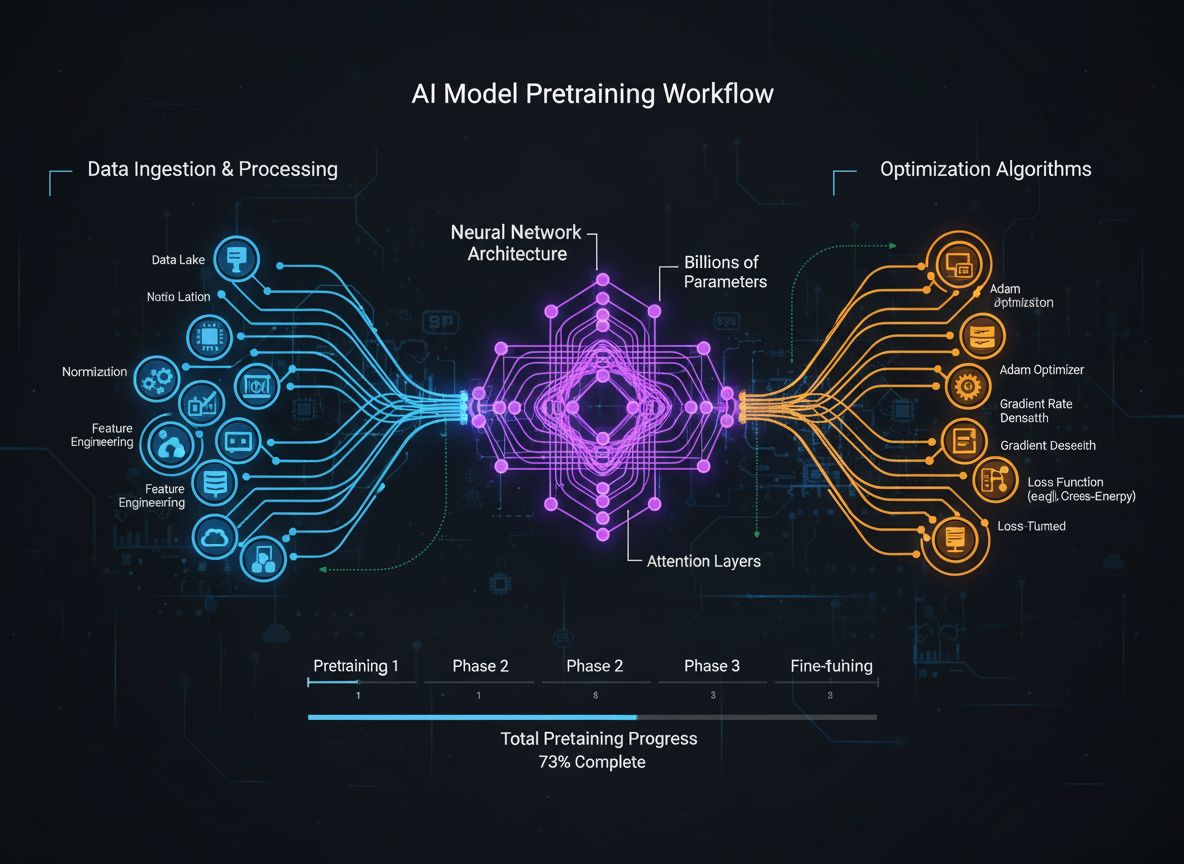

Dil modeli ön-eğitimi, ham metin verisinin sinir ağlarına beslenmesiyle başlayan nispeten basit bir süreçten, birbirine bağlı çoklu optimizasyon hedeflerini içeren karmaşık bir disipline dönüştü. Temelde, ön-eğitim bir modelin çok büyük miktarda metin verisine maruz bırakılması, böylece dil hakkında istatistiksel kalıpları kendi kendine gözetimli bir şekilde öğrenmesini sağlar. Ancak modern yaklaşım, yalnızca veri ve hesaplama ölçeğini artırmanın yeterli olmadığını kabul eder. Araştırmacıların eğitim sürecinin birçok boyutunu—veri seçimi ve kürasyonundan mimari tercihlere ve optimizasyon algoritmalarına kadar—dikkatlice kurgulaması gerekir. Alan o kadar olgunlaştı ki, bu nüansların anlaşılması, en ileri düzey modeller ile vasat modeller arasındaki farkı ortaya koyar. Bu evrim, model performansının tek bir faktörden değil, birbirinden kısmen bağımsız olarak aynı anda optimize edilebilecek çoklu hedeflerin özenli orkestrasyonundan kaynaklandığını daha iyi anladığımızı gösteriyor. Araştırma topluluğu, başarılı model geliştirmenin “gizli sosunun” kaba kuvvetli ölçeklendirmede değil, eğitim hattının her katmanında akıllıca yapılan tasarım tercihlerinde yattığını giderek daha çok kabul ediyor.

Son araştırmalardan çıkarılan en önemli derslerden biri, eğitim verisinin kalitesi ve çeşitliliğinin, veri miktarının kendisinden çok daha belirleyici olduğudur. Sıklıkla “çöp girerse, çöp çıkar” şeklinde özetlenen bu ilke, hem deneysel araştırmalarla hem de pratik deneyimle sürekli olarak doğrulanmıştır. Modeller, yetersiz küratörlü, kopyalanmış veya düşük kaliteli verilerle eğitildiğinde, yanlış kalıpları öğrenir ve yeni görevlere etkin şekilde genelleme yapamaz. Buna karşılık, özenle seçilmiş, çoğaltması kaldırılmış ve filtrelenmiş veri kümeleri, modellerin daha verimli öğrenmesini ve daha az eğitim adımıyla daha yüksek performans elde etmesini sağlar. Bu içgörünün sonuçları derindir: Kurumlar ve araştırmacılar, yalnızca daha fazla ham veri toplamaktansa, veri kürasyonu ve kalite güvencesine ciddi yatırım yapmalıdır. Bu bakış açısındaki değişim, tamamen veri kümesi oluşturma ve iyileştirmeye odaklanan uzman ekiplerin ve araçların ortaya çıkmasına yol açtı. 18,5 trilyondan fazla temizlenmiş ve çoğaltması kaldırılmış İngilizce web verisi içeren FineWeb veri kümesi bu yaklaşımın en iyi örneklerinden biridir. FineWeb ekibi, ham CommonCrawl verisi kullanmak yerine gelişmiş filtreleme, çoğaltma kaldırma ve kalite değerlendirme teknikleri uygulayarak, sürekli olarak daha büyük ve işlenmemiş alternatiflerden daha iyi sonuç veren bir veri kümesi oluşturdu. Bu, alanda temel bir farkındalığı temsil eder: Daha iyi modellere giden yol, daha fazla veriyle değil, daha iyi veriyle geçer.

Modern model ön-eğitimi, aynı anda optimize edilmesi gereken beş birbirine bağlı fakat kısmen bağımsız hedeften oluşan bir çerçeveyle anlaşılabilir. Bu ayakların anlaşılması, tüm eğitim sürecini kavramak ve geliştirme yapılacak noktaları belirlemek için bir temel sunar. Birinci ayak, eğitim verisindeki ham bilginin alaka düzeyini ve kalitesini en üst düzeye çıkarmaktır. Bu, hem tekil veri noktalarının kalitesini hem de veri kümesinin genel çeşitliliğini kapsar. Yüksek kaliteli ve çeşitli verilerle eğitilen bir model, diğer optimizasyonlardan bağımsız olarak, dar veya düşük kaliteli verilerle eğitilenden daha genelleştirilebilir kalıplar öğrenir. İkinci ayak, bir modelin bilgiyi ne kadar verimli işleyebileceğini ve hangi hesaplama kısıtları içinde çalışacağını belirleyen mimari tasarımdır. Mimari seçimler çıkarım hızı, bellek kullanımı, KV önbellek gereksinimleri ve modelin belirli donanım yapılandırmalarına sığabilme yeteneğini etkiler. Üçüncü ayak, her adımda eğitim verisinden çıkarılan bilginin en üst düzeye çıkarılmasıdır. Buna daha küçük modellerin daha büyük modellerden öğrendiği bilgi damıtımı gibi teknikler ile aynı anda birden fazla gelecek token tahmini yapılan çoklu-token tahmini teknikleri dahildir. Dördüncü ayak, gradyan kalitesi ve optimizasyon dinamiklerini kapsar; burada optimize edici seçimi, öğrenme oranı takvimleri ve eğitim stabilitesini sürdürmeye yönelik teknikler yer alır. Beşinci ayak ise, modeller büyüdükçe eğitimin stabil kalmasını ve gradyan patlaması ya da aktivasyon sapması gibi sorunları önleyecek hiperparametre ayarlama ve ölçekleme stratejileridir. Bu beş ayak bağımsız değildir—karmaşık şekillerde etkileşirler—ancak onları ayrı ayrı düşünmek, araştırmacıların hangi alanların ilgiye ihtiyaç duyduğunu ve en etkili geliştirmelerin nerede yapılabileceğini belirlemesine yardımcı olur.

FineWeb, dil modeli ön-eğitimi için veri kümesi oluşturma alanında bir dönüm noktasıdır. HuggingFace ekibi, CommonCrawl gibi web tarayıcılarının ham çıktısını kabul etmek yerine, devasa ölçekte web verisini temizleme, filtreleme ve çoğaltmasını kaldırma için kapsamlı bir işlem hattı uyguladı. Ortaya çıkan veri kümesi, açık kaynak topluluğuna sunulan en büyük küratörlü veri kümelerinden biri olan 18,5 trilyonun üzerinde yüksek kaliteli İngilizce metin içeriyor. FineWeb’in oluşturulması, değersiz içeriği kaldırırken değerli bilgiyi korumak üzere tasarlanmış birçok işlem aşamasını içeriyordu. Ekip, yinelenen içeriği ortadan kaldırmak için gelişmiş çoğaltma kaldırma algoritmaları, spam ve düşük kaliteli sayfaları ortadan kaldırmak için kalite filtreleri ve veri kümesinin çoğunlukla İngilizce metinden oluşmasını sağlamak için dil tespiti uyguladı. FineWeb’i özellikle değerli kılan yalnızca boyutu değil, aynı zamanda daha büyük ve işlenmemiş alternatiflerden daha iyi model performansı sunduğunun ampirik olarak doğrulanmasıdır. Diğer veri kümeleriyle karıştırıldığında, FineWeb sürekli olarak çok daha büyük ham veri kümelerinden daha iyi sonuçlar veriyor ve kalitenin miktardan üstün olduğunu gösteriyor. Performans eğrileri, FineWeb ile eğitilen modellerin, diğer kaynaklardan benzer boyuttaki veri kümeleriyle eğitilen modellere göre standart testlerde daha iyi sonuçlar elde ettiğini ortaya koyuyor. Bu başarı, daha geniş araştırma topluluğunu veri kürasyonuna daha fazla yatırım yapmaya teşvik etti; çünkü asıl büyük performans kazanımlarının burada elde edilebileceği anlaşıldı. FineWeb veri kümesi araştırmacılara ücretsiz olarak sunuluyor, yüksek kaliteli eğitim verisine erişimi demokratikleştiriyor ve küçük kuruluşlar ile akademik ekiplerin rekabetçi modeller eğitmesini mümkün kılıyor.

FineWeb web verisine odaklanırken, HuggingFace ekibi büyük ölçüde gözden kaçmış başka bir yüksek kaliteli metin kaynağı olduğunu fark etti: PDF belgeleri. PDF’ler, akademik makaleler, teknik dokümantasyon, kitaplar ve profesyonel raporlar dahil olmak üzere çok miktarda yapılandırılmış ve kaliteli bilgi içerir. Ancak PDF’lerden metin çıkarmak teknik olarak zordur ve önceki yaklaşımlar bu veri kaynağını ölçekli şekilde sistematik olarak keşfetmemiştir. FinePDF, model ön-eğitimi için PDF verisini çıkarmak, temizlemek ve küratörlüğünü yapmak adına ilk kapsamlı çabayı temsil eder. Ekip, PDF işlemenin benzersiz zorluklarını ele alan gelişmiş bir işlem hattı geliştirdi; bu, karmaşık düzenlerle başa çıkmayı, çok sütunlu belgelerden metni doğru şekilde çıkarmayı ve gömülü görseller ve tablolarla baş etmeyi içerir. FinePDF işlem hattının özellikle yenilikçi bir yönü, CommonCrawl’da saklanan PDF’lerin genellikle yanlış veya eski çıkarıldığı kritik bir sorunu çözen “internetten yeniden getirme” adımıdır. PDF’leri doğrudan internet üzerindeki orijinal kaynaklarından yeniden getirerek, ekip belgelerin en yüksek kaliteli versiyonlarına erişimi garanti altına aldı. Performans sonuçları etkileyici—diğer veri kümeleriyle karıştırıldığında FinePDF, NeoTron B2 gibi yeni taban çizgilerine kıyasla çok güçlü performans gösteriyor. Veri kümesi, web verisini tamamlayan ve modellerin daha çeşitli, yapılandırılmış bilgiden öğrenmesini sağlayan yeni bir yüksek kaliteli eğitim verisi kaynağı sunar. Bu çalışma, veri kümesi oluşturma için yeni imkanlar açıyor ve başka az keşfedilmiş veri kaynaklarının da benzer faydalar sağlayabileceğini gösteriyor. FinePDF işlem hattı, diğer araştırmacıların bu çalışmanın üzerine inşa edebilmesi ve benzer teknikleri başka veri kaynaklarına uygulayabilmesi için ayrıntılı şekilde blog yazıları ve teknik dokümantasyon ile belgelendiriliyor.

SmolLM 3, bu veri kürasyonu ve eğitim optimizasyonu tekniklerinin uygulanmasının sonucunda, son derece verimli bir dil modeli olarak ortaya çıktı. 3 milyar parametreyle, SmolLM 3, çağdaş birçok modelden önemli ölçüde daha küçüktür, fakat model eğitiminin beş temel ayağında yapılan dikkatli optimizasyonlar sayesinde rekabetçi performans sağlar. Model, çift modlu akıl yürütme, altı dilde çok dillilik ve uzun bağlam anlama gibi özellikleriyle, mütevazı boyutuna rağmen dikkat çekici derecede çok yönlüdür. SmolLM 3’ün geliştirilmesinde, verimliliği en üst düzeye çıkaracak özel mimari tercihler yapıldı. Ekip, hesaplama verimliliği ile modelleme kapasitesi arasında denge kuran bir transformer mimarisi seçti; bellek kullanımı ve çıkarım gecikmesini azaltmak için grouped query attention gibi teknikler uygulandı. Model, farklı alanlarda performansı kademeli olarak artıran üç aşamalı bir ön-eğitim yaklaşımı ile eğitildi ve ekip, her aşamada belirli yeteneklere göre optimizasyon yapabildi. SmolLM 3’ü özellikle önemli kılan şey, açık kaynak topluluğunun artık birçok görevde çok daha büyük tescilli modellere rakip olabilecek modeller üretebildiğini göstermesidir. Bu, daha büyük modellerin her zaman daha iyi olduğu varsayımına meydan okuyor ve saf ölçekten elde edilebilecek faydaların bir platoya ulaşmış olabileceğini düşündürüyor. Bunun yerine odak, verimlilik, yorumlanabilirlik ve pratik dağıtım yeteneklerine kayıyor. SmolLM 3, tüketici donanımında, uç cihazlarda ve kaynak kısıtlı ortamlarda çalışabiliyor ve böylece gelişmiş yapay zeka yeteneklerini çok daha geniş bir kitleye erişilebilir kılıyor. Modelin çok dilli ve uzun bağlam yetenekleri, verimliliğin önemli özelliklerden ödün vermek anlamına gelmediğini gösteriyor.

Bilgi damıtımı, küçük modellerin büyük modellerin öğrendiği bilgiden faydalanmasını sağlayan güçlü bir tekniktir. Küçük bir modeli sıfırdan ham veriyle eğitmek yerine, bilgi damıtımı, küçük modelin daha büyük ve daha yetenekli bir modelin çıktısını taklit edecek şekilde eğitilmesini içerir. Bu yaklaşım, özellikle ön-eğitim sırasında değerlidir; çünkü küçük model, büyük modelin zaten keşfettiği kalıpları öğrenerek daha hızlı öğrenir ve nihai performansı artırır. Bilgi damıtımının mekanizması, öğrenci modelin (küçük olan) öğretmen modelin (büyük olan) ürettiği olasılık dağılımlarını eşleyecek şekilde eğitilmesini içerir. Bu genellikle, öğrencinin çıktı dağılımı ile öğretmenin çıktı dağılımı arasındaki farkı (genellikle KL sapması gibi tekniklerle) en aza indirerek yapılır. Sıcaklık parametresi, olasılık dağılımlarının ne kadar “yumuşak” olduğunu kontrol eder—yüksek sıcaklıklar dağılımları yumuşatır ve farklı tahminler arasındaki göreli güven hakkında daha fazla bilgi sağlar. Bilgi damıtımı, dil modeli ön-eğitimi bağlamında, büyük modellerle öğrenilen bilginin daha küçük ve verimli modellere aktarılmasını sağladığı için özellikle etkilidir. Bu teknik, modellerini uç cihazlarda veya kaynak kısıtlı ortamlarda dağıtmak isteyen ama yine de büyük modellerin yeteneklerinden faydalanmak isteyen kuruluşlar için çok değerlidir. Teknik giderek daha karmaşık hale geliyor; araştırmacılar, öğrenci modelin öğretmen modelin dikkat kalıplarını da eşlemesini sağlayan dikkat aktarımı ve ara katman temsillerinin eşleştirildiği özellik tabanlı damıtım gibi yöntemler üzerinde çalışıyorlar.

Geleneksel dil modeli eğitimi, modelin önceki tüm tokenlara bakarak bir sonraki tokenı tahmin etmesine odaklanır. Ancak son araştırmalar, modellerin aynı anda birden fazla gelecekteki tokenı tahmin edecek şekilde eğitilmesinin, özellikle kodlama görevlerinde ve karmaşık akıl yürütme problemlerinde, performansı önemli ölçüde artırdığını gösterdi. Çoklu-token tahmini, modelin daha uzun vadeli bağıntıları öğrenmesini ve altta yatan kalıpları daha derinlemesine kavramasını zorunlu kılar. Yaklaşım, modele birden fazla tahmin başlığı eklemeyi içerir; her başlık, birkaç adım ilerideki bir tokenı tahmin etmekten sorumludur. Eğitim sırasında model, bu başlıkların her birinden aynı anda kayıp sinyalleri alır ve böylece gelecekteki birden fazla adımı doğru tahmin etmek için faydalı temsiller öğrenmeye teşvik edilir. Bu, sıradaki token tahmininden daha zordur; fakat daha iyi öğrenilmiş temsillerle sonuçlanır. Çoklu-token tahmini avantajları, yalnızca eğitim hedefindeki gelişmeyle sınırlı değildir. Bu teknikle eğitilen modeller genellikle aşağı akış görevlerinde daha iyi performans gösterir, yeni alanlara daha iyi genelleme yapar ve daha gelişmiş akıl yürütme yeteneklerine sahip olur. Özellikle kod üretimi görevlerinde etkilidir; çünkü daha uzun vadeli bağıntıların kavranması, sentaktik ve semantik açıdan doğru kod üretimi için kritiktir. Araştırmalar, çoklu-token tahmininin çeşitli testlerde model performansını %5-15 oranında artırabildiğini ve son yıllarda keşfedilen en etkili eğitim tekniklerinden biri olduğunu göstermektedir. Yöntem uygulaması nispeten basittir; fakat tahmin başlığı sayısının ve farklı başlıklardan gelen kayıpların ağırlıklandırılmasının dikkatlice ayarlanması gerekir.

Yıllarca, AdamW optimize edicisi büyük dil modellerini eğitmek için varsayılan seçim oldu. AdamW, momentum tabanlı gradyan güncellemeleriyle ağırlık azaltmayı birleştirerek stabil eğitim ve iyi yakınsama özellikleri sunar. Ancak son araştırmalar, AdamW’nin özellikle çok büyük modellere ölçeklenirken tüm eğitim senaryoları için optimal olmayabileceğini göstermiştir. Muon ve King K2 gibi yeni optimize ediciler, daha iyi eğitim dinamikleri ve gelişmiş performans sağlayabilen alternatif yaklaşımlar araştırıyor. Bu yeni optimize edicilerin temel içgörüsü, kayıp manzarasının eğriliği hakkında bilgi veren Hessian matrisinin Newton-Schulz yöntemleri gibi tekniklerle daha iyi yaklaşıklanabileceğidir. Hessian’ı daha iyi yaklaşıklayarak, bu optimize ediciler, daha hızlı yakınsama ve daha iyi nihai performans sağlayan daha bilgilendirici gradyan güncellemeleri sunar. Örneğin Muon, Newton-Schulz yinelemesi adı verilen bir teknik kullanır ve böylece gradyan matrisini ortogonalleştirir; bu da öğrenmeyi geleneksel momentum tabanlı yaklaşımlara göre daha fazla boyuta yayar. Sonuçta eğitim daha stabil olur ve modelin AdamW ile aynı optimizasyon yolunu takip etmek yerine parametre uzayında yeni bölgeleri keşfetmesi teşvik edilir. King K2 ise maksimum log başı gibi nicelikleri izleyerek öğrenme oranlarını ve gradyan kırpmayı adaptif olarak ayarlayan farklı bir yaklaşım izler. Optimize edici inovasyonunun etkileri büyüktür. Pek çok uygulayıcı, çok daha küçük modeller için optimize edilmiş AdamW hiperparametrelerini, parametre sayısı kat kat fazla olan modelleri eğitirken de kullanmaya devam ediyor. Bu da, sadece optimize edici tercihini ve hiperparametreleri modern, büyük ölçekli modeller için güncelleyerek önemli performans kazanımları elde edilebileceğini gösteriyor. Araştırma topluluğu, optimize edici seçiminin hâlâ çözülmemiş bir problem olduğunu ve bu alanda süren inovasyonun model eğitimi verimliliği ile nihai performansta önemli iyileşmeler getirebileceğini giderek daha çok kabul ediyor.

Eğitim boyunca yüksek kaliteli gradyanları korumak, iyi model performansı elde etmek için gereklidir. Modeller milyar veya trilyon parametreye ölçeklendiğinde, eğitim giderek kararsız hale gelir ve gradyanlar patlamaya veya yok olmaya eğilimli olur. Bu sorunları çözmek, gradyan kalitesine dikkat etmeyi ve tüm eğitim sürecinde eğitim stabilitesini koruyan teknikleri uygulamayı gerektirir. Gradyan kalitesini artırmak için kullanılan yöntemlerden biri, gradyanların çok büyüyüp eğitimi kararsızlaştırmasını önleyen gradyan kırpmadır. Ancak, saf gradyan kırpma değerli bilgiyi de atabilir. Daha gelişmiş yaklaşımlar, bilgiyi korurken kararsızlığı önleyecek şekilde gradyanları normalleştirir. Bir diğer önemli nokta ise aktivasyon fonksiyonları ve katman normalizasyonu tekniklerinin seçilmesidir. Farklı aktivasyon fonksiyonlarının gradyan akışı üzerinde farklı etkileri vardır ve dikkatli seçim eğitim stabilitesini ciddi şekilde etkileyebilir. Katman normalizasyonu, aktivasyonları özellik boyutunda normalleştirir ve transformer modellerde standart haline gelmiştir; çünkü batch normalization’a göre daha iyi gradyan akışı sağlar. Öğrenme oranı takvimi de gradyan kalitesini korumada önemli rol oynar. Çok yüksek öğrenme oranı gradyan patlamasına, çok düşük oran ise yavaş yakınsamaya veya yerel minimumda sıkışmaya yol açabilir. Modern eğitimde genellikle bir ısınma (warm-up) aşaması ile başlayan, modelin parametre uzayında iyi bir bölgeye yerleşmesini sağlayan ve ardından eğitim ilerledikçe öğrenme oranını azaltan bir takvim kullanılır. Bu yönlerin anlaşılması ve optimize edilmesi, büyük modellerin başarılı şekilde eğitilmesi için çok önemlidir ve hâlâ aktif araştırma alanıdır.

Modern model ön-eğitiminin çoklu optimizasyon hedefleri, karmaşık veri işleme hatları ve dikkatli hiperparametre ayarlamaları, bu teknikleri uygulamaya çalışan ekipler için ciddi zorluklar yaratır. FlowHunt, bu zorlukları karmaşık model eğitim iş akışlarının otomasyonu ve orkestrasyonu için bir platform sunarak çözer. Ekipler, veri işleme, model eğitimi ve değerlendirmeyi manuel olarak yönetmek yerine, FlowHunt ile bu görevleri otomatik olarak yürüten iş akışları tanımlayabilir, böylece hataları azaltır ve tekrarlanabilirliği artırır. FlowHunt’ın otomasyon yetenekleri, model performansı için kritik olan veri kürasyonu ve işleme adımları için özellikle değerlidir. Platform, FineWeb ve FinePDF’teki gibi gelişmiş veri işleme hatlarını—çoğaltma kaldırma, kalite filtreleme ve format dönüştürme dâhil—otomatik olarak uygulayabilir. Bu, ekiplerin hangi verinin dahil edileceği ve nasıl işleneceği gibi yüksek seviye kararlara odaklanmasını, uygulama detaylarında boğulmadan sağlar. Ayrıca, FlowHunt, model eğitimi optimizasyonu için gerekli olan hiperparametre ayarlama ve deney yönetimine de yardımcı olabilir. Farklı hiperparametrelerle birden çok eğitim denemesini otomatik olarak yürüterek ve sonuçları toplayarak, FlowHunt ekiplerin parametre uzayını daha verimli keşfetmesini ve optimal konfigürasyonları daha hızlı bulmasını sağlar. Platform ayrıca eğitim ilerlemesini izleme, gradyan patlaması veya sapması gibi sorunları tespit etme ve eğitim parametrelerini otomatik olarak ayarlayarak stabiliteyi sürdürme araçları sunar. Kendi dil modellerini geliştiren veya mevcut modelleri ince ayar yapan kuruluşlar için FlowHunt, gereken zamanı ve çabayı önemli ölçüde azaltırken sonuçların kalitesini artırabilir.

Model eğitiminin en zorlu yönlerinden biri, küçük modellerden büyük modellere ölçeklerken eğitim stabilitesi ve performansın nasıl korunacağını anlamaktır. Model boyutu ile optimal hiperparametreler arasındaki ilişki doğrudan değildir—küçük modellerde iyi çalışan hiperparametreler, genellikle daha büyük modellerde ayarlanmalıdır. Bu durum özellikle öğrenme oranları için geçerlidir; çünkü model boyutu büyüdükçe genellikle azaltılmaları gerekir. Ölçekleme yasalarını anlamak, modellerin farklı ölçeklerde nasıl performans göstereceğini öngörmek ve kaynak tahsisi kararları almak için çok önemlidir. Araştırmalar, model performansının model boyutu, veri kümesi boyutu ve hesaplama bütçesinin bir güç yasası fonksiyonu olarak öngörülebilir şekilde arttığını göstermiştir. Bu ölçekleme yasaları, araştırmacıların model veya veri kümesi boyutunu artırarak ne kadar performans artışı bekleyebileceğini tahmin etmesini ve kaynaklarını daha bilinçli şekilde yatırmasını sağlar. Ancak ölçekleme yasaları evrensel değildir—kullanılan mimari, eğitim prosedürü ve veri kümesine bağlıdır. Bu da, ekiplerin kendi ölçekleme deneylerini yapmaları gerektiği anlamına gelir. Küçük modellerden büyük modellere ölçekleme süreci, aynı zamanda eğitim stabilitesine dikkat etmeyi gerektirir. Modeller büyüdükçe, gradyan patlaması veya sapması gibi eğitim kararsızlıklarına daha yatkın hale gelirler. Bu sorunları çözmek, gradyan kırpma, dikkatli öğrenme oranı planlaması ve gerekirse model mimarisi veya optimize edicide değişiklikler yapmayı gerektirir. Araştırma topluluğu, ölçeklemenin sadece modelleri büyütmekten ibaret olmadığını, aynı zamanda eğitim sürecinin dikkatlice yönetilmesini gerektirdiğini giderek daha çok kabul ediyor.

Özellik öğrenimi, modellerin eğitim sırasında ham veriden faydalı özellikleri çıkarma sürecidir. Dil modeli ön-eğitimi bağlamında, özellik öğrenimi; modelin iç temsillerinde dilsel kavramları, anlamsal ilişkileri ve sözdizimsel kalıpları temsil etmeyi öğrenmesini ifade eder. Özellik öğrenimini maksimize etmek—modelin her adımda eğitim verisinden mümkün olduğunca fazla faydalı bilgi çıkarmasını sağlamak—modern model eğitiminde temel hedeflerden biridir. Özellik öğrenimini, modelin temsillerinin gradyan güncellemelerine ne kadar tepki gösterdiği şeklinde düşünebiliriz. Model etkili şekilde öğreniyorsa, her gradyan güncellemesi, gelecekteki tokenları daha iyi tahmin etmeyi sağlayacak anlamlı temsillerde değişikliklere yol açmalıdır. Model etkili öğrenmiyorsa, gradyan güncellemeleri çok az değişikliğe veya performansa katkı sağlamayan değişimlere neden olabilir. Özellik öğrenimini geliştirmek için kullanılan teknikler arasında model ağırlıklarının dikkatli başlatılması yer alır; bu, modelin eğitim başında faydalı özellikleri ne kadar hızlı öğrendiğini önemli ölçüde etkileyebilir. Bir diğer önemli teknik de, model temel özellikleri hızla öğrenirken eğitimin başında hızlı, ilerledikçe daha yavaş öğrenmeyi sağlayan öğrenme oranı takvimleridir. Özellik öğrenimi kavramı, modellerin bazı özellikleri ya da girişin bazı boyutlarını görmezden gelmeyi öğrendiği “özellik çökmesi” fikriyle yakından ilişkilidir. Model, iyi performans sağlayan bir kestirme yol bulduğunda tüm öğrenmesi gereken özellikleri öğrenmeyebilir. Doğru düzenleme ve dikkatli kayıp fonksiyonu tasarımı, özellik çökmesini önlemeye ve modellerin çeşitli, faydalı özellikler öğrenmesini sağlamaya yardımcı olur.

{{ cta-dark-panel heading=“FlowHunt ile İş Akışınızı Güçlendirin” description=“FlowHunt’ın araştırmadan içerik üretimine, yayımlamadan analitiğe kadar AI içerik ve SEO iş akışlarını nasıl otomatikleştirdiğini tek platformda deneyimleyin.” ctaPrimaryText=“Demo Talep Et” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“FlowHunt’ı Ücretsiz Dene” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Yapay zeka araştırmalarında yıllarca egemen anlatı, “büyük model, iyi modeldir” şeklindeydi. Bu da, şirketlerin daha fazla parametreye sahip modelleri duyurmak için yarıştığı bir boyut yarışına yol açtı. Ancak son gelişmeler, bu anlatının değişmekte olabileceğini gösteriyor. SmolLM 3 ve diğer verimli modellerin başarısı, olağanüstü performansın, en büyük modellerden kat kat küçük modellerle de elde edilebileceğini gösteriyor. Bu değişim, model performansının yalnızca parametre sayısı değil, çok sayıda başka faktör tarafından belirlendiğine dair daha derin bir anlayışı yansıtıyor. Yüksek kaliteli verilerle ve gelişmiş optimizasyon teknikleriyle eğitilen 3 milyar parametreli bir model, daha düşük kaliteli verilerle ve özenli optimizasyon olmadan eğitilmiş çok daha büyük bir modeli geride bırakabilir. Bu farkındalık, alan için derin etkiler doğuruyor. En etkili araştırmaların, daha büyük modeller inşa etmek yerine veri kalitesini artırmakta, daha iyi eğitim teknikleri geliştirmekte ve daha verimli mimariler yaratmakta olabileceğini gösteriyor. Aynı zamanda, devasa hesaplama kaynaklarına erişimi olmayan küçük kuruluşlar ve akademik ekiplerin de rekabetçi modeller geliştirmesini mümkün kılarak yapay zeka geliştirmeyi demokratikleştiriyor. Saf ölçekten uzaklaşmak, dağıtım açısından da pratik sonuçlar doğuruyor. Daha küçük modeller, uç cihazlarda, kaynak kısıtlı ortamlarda ve daha düşük gecikme ve enerjiyle çalışabiliyor. Bu da gelişmiş yapay zeka yeteneklerini çok daha geniş uygulama ve kullanıcı kitlesine erişilebilir kılıyor. Araştırma topluluğu, yapay zeka geliştirme geleceğinin, farklı kullanım senaryoları ve dağıtım ihtiyaçları için optimize edilmiş farklı ölçeklerde bir model portföyünü içereceğini, yalnızca en büyük modeli inşa etmeye odaklanmanın yeterli olmayacağını giderek daha çok kabul ediyor.

Hiperparametre ayarı, öğrenme oranı, batch boyutu ve ağırlık azaltma gibi eğitim sürecini denetleyen parametrelerin değerlerinin seçilme sürecidir. Bu parametreler model performansını önemli derecede etkiler ve optimal değerlerin bulunması iyi sonuçlar için kritiktir. Ancak hiperparametre ayarı genellikle bir bilimden çok sanat olarak ele alınır; uygulayıcılar sistematik yaklaşımlar yerine sezgi ve deneme-yanılmaya güvenir. Modern hiperparametre ayarı yaklaşımları, hiperparametre uzayının daha sistematik olarak keşfedilmesini içerir. Bayesian optimizasyon gibi teknikler, olası hiperparametre değerleri uzayını verimli şekilde tarayabilir, umut vadeden bölgeleri belirleyip aramayı oralara yoğunlaştırabilir. Grid search ve random search ise daha basit alternatiflerdir ve paralel hesaplama ile birden çok konfigürasyonun aynı anda değerlendirilmesiyle etkili olabilir. Son araştırmalardan önemli bir içgörü, optimal hiperparametrelerin kullanılan modele, veri kümesine ve eğitim kurulumuna bağlı olduğudur. Yani, bir modelde iyi çalışan hiperparametreler, boyut ve mimari olarak benzer olsa bile başka bir modelde iyi çalışmayabilir. Bu nedenle, her yeni model veya veri kümesi için hiperparametre taramaları yapmak yaygınlaştı—bu hesaplama açısından maliyetli olabilir ama genellikle optimal performans için gereklidir. Hiperparametreler ile model performansı arasındaki ilişkin

SmolLM 3, çoklu dil ve uzun bağlam akıl yürütme görevlerinde güçlü performans gösterirken verimliliği en üst düzeye çıkarmak için tasarlanmış 3 milyar parametreli bir modeldir. Daha büyük modellere kıyasla, SmolLM 3 hesaplama kısıtları içinde optimal performansa odaklanır ve bu da onu uç cihazlar ve kaynak kısıtlı ortamlar için ideal kılar.

'Çöp girerse, çöp çıkar' ilkesi makine öğreniminin temelindedir. Yüksek kaliteli ve çeşitli veri, yalnızca daha fazla veri toplamaktan çok daha fazla model performansını etkiler. FineWeb ve FinePDF, eğitim verisinin özenli kürasyonu, çoğaltma kaldırma ve filtrelemesinin, ham ve işlenmemiş veri kümelerinden çok daha iyi sonuçlar verdiğini gösterir.

Bilgi damıtımı, daha küçük bir modelin daha büyük ve yetenekli bir modelden öğrenmesini sağlayan bir tekniktir. Ön-eğitim sırasında bu yaklaşım, küçük modellerin eğitim verisinden maksimum bilgiyi çıkarmasını sağlar; çünkü daha büyük modellerin zaten öğrendiği kalıpları öğrenirler ve bu sayede daha az parametreyle daha iyi performans elde edilir.

Çoklu-token tahmini, modelleri yalnızca bir sonraki tokenı değil, aynı anda birden fazla gelecekteki tokenı tahmin edecek şekilde eğitir. Bu yaklaşım özellikle kodlama görevlerinde etkilidir ve modelin daha uzun vadeli bağıntıları anlamasını geliştirerek karmaşık akıl yürütme görevlerinde daha iyi performans sağlar.

Modern optimize ediciler, Muon örneğinde olduğu gibi geleneksel AdamW'nin ötesine geçerek Newton-Schulz gibi teknikler kullanır ve Hessian matrisini daha iyi yaklaşıklar. Bu da daha stabil eğitim, daha kaliteli gradyanlar ve özellikle büyük parametreli modellerde daha iyi öğrenme dinamikleri sağlar.

Arshia, FlowHunt'ta bir Yapay Zeka İş Akışı Mühendisidir. Bilgisayar bilimi geçmişi ve yapay zekaya olan tutkusu ile, yapay zeka araçlarını günlük görevlere entegre eden verimli iş akışları oluşturmada uzmanlaşmıştır ve bu sayede verimlilik ile yaratıcılığı artırır.

FlowHunt, ekiplerin model ön-eğitimi, veri işleme ve optimizasyon süreçlerini akıllı otomasyon ile kolaylaştırmasına yardımcı olur.

Hugging Face Transformers, makine öğrenimi görevleri için NLP, bilgisayarla görme ve ses işleme alanlarında Transformer modellerinin kolayca uygulanmasını sağla...

Büyük Dil Modeli (LLM), insan dilini anlamak, üretmek ve üzerinde işlem yapmak için geniş metin verileriyle eğitilmiş bir yapay zeka türüdür. LLM'ler, metin üre...

Büyük Dil Modelleri (LLM'ler) için temel GPU gereksinimlerini keşfedin: eğitim ve çıkarım ihtiyaçları, donanım özellikleri ve etkili LLM performansı için doğru ...

Çerez Onayı

Göz atma deneyiminizi geliştirmek ve trafiğimizi analiz etmek için çerezleri kullanıyoruz. See our privacy policy.