UnifAI MCP 服务器

UnifAI MCP 服务器将 AI 助手与外部数据源、API 和服务连接起来,实现 FlowHunt 生态系统内的高级自动化和工作流编排。尽管这一理念很有前景,但目前公开的文档和资源非常有限。...

FlowHunt在您的内部系统和AI工具之间提供额外的安全层,让您能够精细控制从MCP服务器可访问哪些工具。托管在我们基础设施中的MCP服务器可以与FlowHunt的聊天机器人以及ChatGPT、Claude和各种AI编辑器等热门AI平台无缝集成。

dify MCP(模型上下文协议)服务器作为桥梁,将 AI 助手与 Dify 工作流连接起来,使其能够与外部数据源、API 和服务交互。通过 MCP 接口暴露 Dify 工作流工具,服务器使 AI Agent 能以编程方式触发和管理 Dify 工作流。这提升了开发流程,允许 AI 系统用 Dify 作为后端,查询数据库、管理文件或对接 API。服务器支持通过环境变量或 YAML 文件进行配置,适用于云端和本地部署场景。

仓库中未提供关于提示模板的信息。

仓库或 README 未明确记录资源信息。

仓库或 README 未找到明确的工具清单,仅提及 “MCP 的工具”,但未给出具体名称或描述。

确保已安装 Node.js 和 uvx/uv 等前置条件。

通过环境变量或 YAML 文件准备配置。

在你的配置中添加 Dify MCP 服务器:

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

保存并重启 Windsurf。

验证服务器已运行且可访问相关工作流。

安装 uvx 或 uv,并设置环境变量或配置文件。

在 Claude MCP 客户端中添加以下配置:

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

保存、重启并验证配置效果。

确保已安装 uvx/uv 且环境变量已设置或准备好 config.yaml。

在 Cursor 的 MCP 配置中插入服务器配置:

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

保存并重启 Cursor。

确认服务器运行状态。

安装 uvx/uv 并设置环境变量或提供 config.yaml。

在 MCP 配置中添加 Dify MCP 服务器:

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

保存并重启 Cline。

检查 Dify 工作流是否可访问。

请始终使用环境变量存储诸如 API 密钥等敏感数据。示例配置:

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "${DIFY_APP_SKS}" // 使用系统环境变量

}

}

}

}

在 FlowHunt 中使用 MCP

要将 MCP 服务器集成到 FlowHunt 工作流中,首先添加 MCP 组件,并将其连接到你的 AI Agent:

点击 MCP 组件,打开配置面板。在系统 MCP 配置区域,使用如下 JSON 格式填写你的 MCP 服务器信息:

{

"dify-mcp-server": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

配置完成后,AI Agent 即可将该 MCP 作为工具,访问其全部功能。请记得将 “dify-mcp-server” 替换为你实际的 MCP 服务器名称,并将 URL 替换为你自己的 MCP 服务器地址。

| 部分 | 可用性 | 详情备注 |

|---|---|---|

| 概览 | ✅ | |

| 提示模板列表 | ⛔ | 未找到任何提示/模板信息 |

| 资源列表 | ⛔ | 未记录明确资源 |

| 工具列表 | ⛔ | 未列出明确工具 |

| API 密钥安全存储 | ✅ | 支持环境变量 & config.yaml |

| 采样支持(评估时较次要) | ⛔ | 未提及 |

根据现有信息,该 MCP 服务器为 Dify 工作流集成到兼容 MCP 的平台提供了基础且可靠的能力。但关于提示、资源和工具的文档缺失,降低了其在高级或标准化 LLM 场景下的可用性。

MCP 评分:4/10。

dify-mcp-server 上手简单,支持良好的云端/本地配置,但缺乏提示、资源和工具能力的文档,限制了其更广泛的 MCP 应用价值。

| 是否有 LICENSE 文件 | ⛔(未检测到 LICENSE 文件) |

|---|---|

| 至少有一个工具 | ⛔ |

| Fork 数 | 31 |

| Star 数 | 238 |

Dify MCP 服务器作为 AI 助手与 Dify 工作流之间的网关,通过 MCP 协议实现外部 API 调用、文件管理和工作流执行的自动化与编排。

主要用于工作流编排、API 集成、云端工作流访问,以及通过单一 MCP 服务器实例集中管理多个 Dify 工作流。

请始终通过环境变量存储诸如 API 密钥等敏感信息。你可以在服务器配置中引用这些变量,以确保凭据安全。

当前文档未提供提示模板或工具清单,因而可能限制高级 LLM 的使用场景。

在 FlowHunt 流程中添加 MCP 组件,并配置你的 Dify MCP 服务器信息,即可让 AI Agent 访问服务器所暴露的全部工作流功能。

UnifAI MCP 服务器将 AI 助手与外部数据源、API 和服务连接起来,实现 FlowHunt 生态系统内的高级自动化和工作流编排。尽管这一理念很有前景,但目前公开的文档和资源非常有限。...

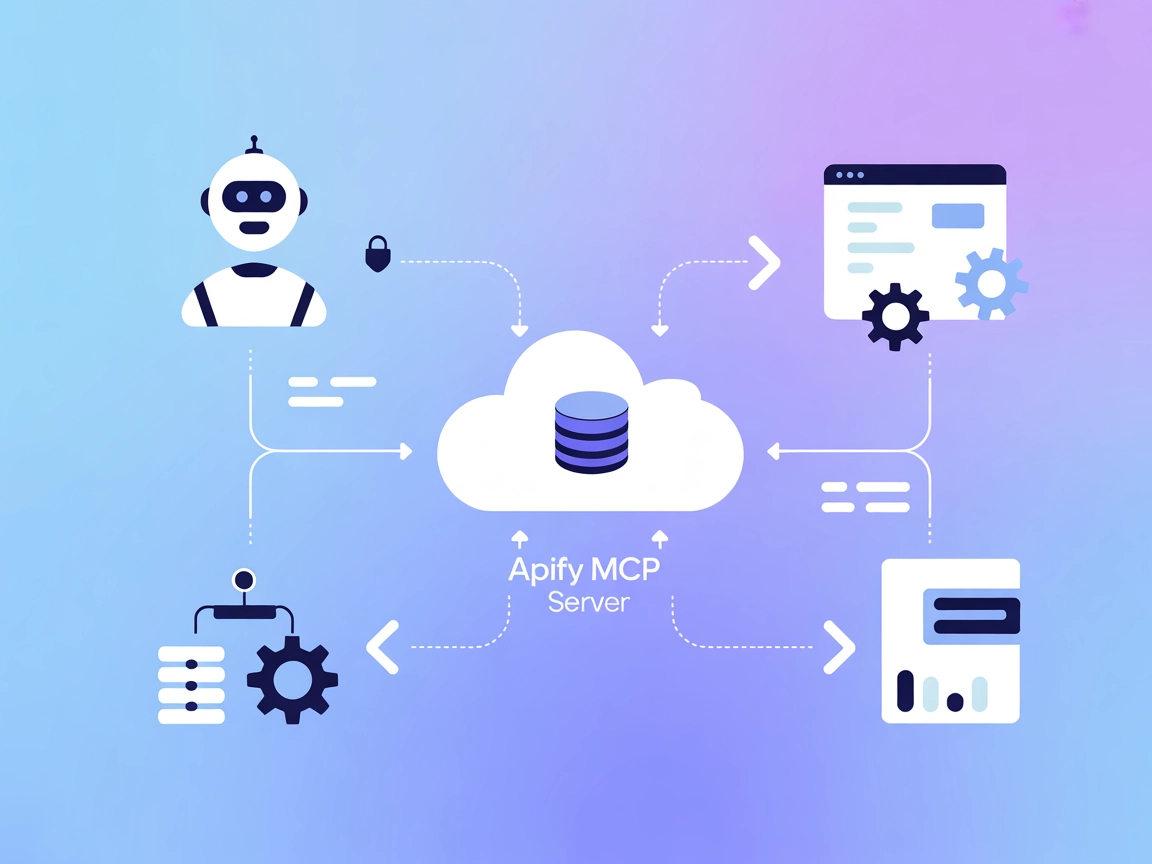

Apify MCP 服务器将 AI 助手与 Apify 平台连接,实现通过标准化 MCP 工具的无缝自动化、数据提取和工作流编排。通过安全灵活的桥梁,触发、管理并获取 Apify Actors 的结果。...

Make MCP 服务器将 FlowHunt AI 代理与 Make 的自动化平台连接起来,使 Make 场景能够作为可调用工具无缝调用。为您的 AI 工作流赋能,实现动态自动化、结构化数据处理以及与 Make 的安全连接。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.