OpenAPI MCP 服务器

OpenAPI MCP 服务器让 AI 助手能够探索和理解 OpenAPI 规范,为开发者和大模型提供详细的 API 上下文、摘要和端点信息,无需直接执行端点。...

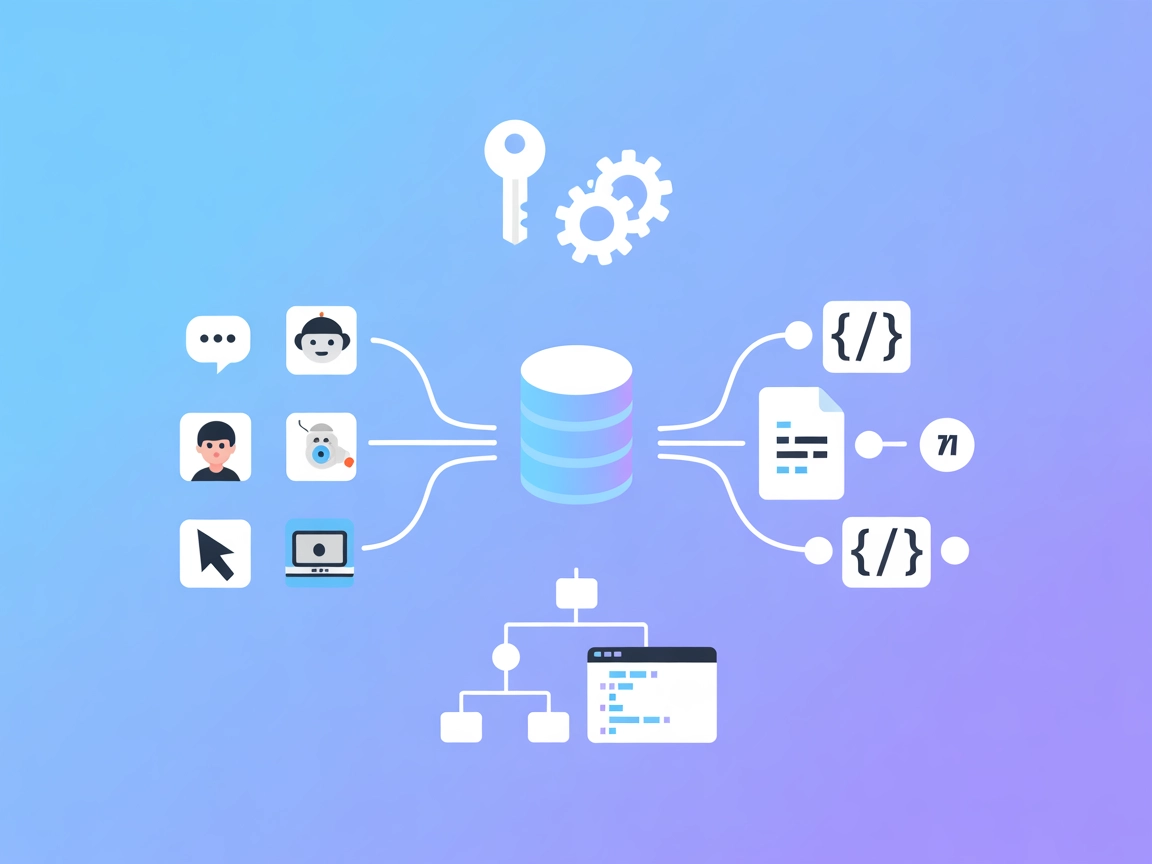

FlowHunt在您的内部系统和AI工具之间提供额外的安全层,让您能够精细控制从MCP服务器可访问哪些工具。托管在我们基础设施中的MCP服务器可以与FlowHunt的聊天机器人以及ChatGPT、Claude和各种AI编辑器等热门AI平台无缝集成。

oatpp-mcp MCP 服务器是 Anthropic 模型上下文协议(MCP)在 Oat++ Web 框架下的实现。它作为 AI 助手和外部 API 或服务间的桥梁,实现无缝集成与交互。通过 MCP 协议暴露 Oat++ API 控制器和资源,oatpp-mcp 允许 AI 代理执行如 API 查询、文件管理和使用服务器端工具等任务。这让开发者能够让大语言模型(LLM)及客户端访问和操作后端数据,实现自动化操作,并通过可复用的提示模板和工作流标准化交互。该服务器支持 STDIO 或 HTTP SSE 运行方式,适应不同部署环境。

(文档中未明确列出其他资源。)

(文档中未明确列出其他工具。)

settings.json)。mcpServers 对象下添加 oatpp-mcp 服务器:{

"mcpServers": {

"oatpp-mcp": {

"command": "oatpp-mcp",

"args": []

}

}

}

API 密钥安全配置

{

"mcpServers": {

"oatpp-mcp": {

"command": "oatpp-mcp",

"env": {

"API_KEY": "env:OATPP_API_KEY"

},

"inputs": {

"api_key": "${API_KEY}"

}

}

}

}

{

"mcpServers": {

"oatpp-mcp": {

"command": "oatpp-mcp",

"args": []

}

}

}

API 密钥安全配置

请参照 Windsurf 的方式。

{

"mcpServers": {

"oatpp-mcp": {

"command": "oatpp-mcp",

"args": []

}

}

}

API 密钥安全配置

同上。

{

"mcpServers": {

"oatpp-mcp": {

"command": "oatpp-mcp",

"args": []

}

}

}

API 密钥安全配置

同上。

在 FlowHunt 中集成 MCP

要将 MCP 服务器集成进您的 FlowHunt 工作流,请先在流程中添加 MCP 组件并将其连接到您的 AI 代理:

点击 MCP 组件以打开配置面板。在系统 MCP 配置部分,使用如下 JSON 格式填写您的 MCP 服务器信息:

{

"oatpp-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

配置完成后,AI 代理即可作为工具使用该 MCP,获得其全部功能和能力。请记得将 “oatpp-mcp” 替换为实际 MCP 服务器名称,并将 URL 替换为您的 MCP 服务器地址。

| 部分 | 是否具备 | 细节/备注 |

|---|---|---|

| 概览 | ✅ | |

| 提示模板列表 | ✅ | 仅明确提及 “CodeReview” |

| 资源列表 | ✅ | 仅明确提及 “File” 资源 |

| 工具列表 | ✅ | 仅明确提及 “Logger” 工具 |

| API 密钥安全配置 | ✅ | 提供了通过环境变量保护 API 密钥的示例 |

| 采样支持(评估时较次要) | ⛔ | 未提及 |

根据文档,oatpp-mcp 提供了一个简约但功能完善的 MCP 服务器实现,覆盖了协议的基本内容(提示、资源、工具和搭建方法),但未见采样、roots 等高级特性的相关说明。文档清晰,涵盖基础内容,但在深度和细节上有限。

| 是否有 LICENSE | ✅ (Apache-2.0) |

|---|---|

| 是否有至少一个工具 | ✅ |

| Fork 数量 | 3 |

| Star 数量 | 41 |

我们的观点:

oatpp-mcp 为 Oat++ 用户提供了一个简洁、合规的 MCP 实现。它覆盖了协议基础(至少有一个工具、一个提示和一个资源),但功能不丰富,缺乏 roots、采样或更多原语的文档或证据。它非常适合作为 Oat++ 用户的起点,但如需更高级的工作流,可能还需自行扩展。

评分:

6/10 —— 基础扎实,协议合规,功能和可扩展性受限于现有文档。

oatpp-mcp 是 Oat++ 的 Anthropic 模型上下文协议(MCP)实现,通过 MCP 协议向 AI 代理开放 API 控制器、文件系统访问和如日志记录等工具。这使得 AI 驱动系统能够无缝进行后端自动化、文件管理和标准化工作流集成。

oatpp-mcp 默认包含用于代码分析的 CodeReview 提示模板、用于文件系统操作的 File 资源,以及用于事件日志记录的 Logger 工具。这些为代码审查、文件管理和工作流监控提供了基础。

将 oatpp-mcp 服务器添加到平台的 MCP 配置中,按照文档指定命令和参数。通过环境变量保护 API 密钥,并确保服务器可访问。配置完成后,FlowHunt 代理即可在自动化流程中使用所暴露的资源和工具。

oatpp-mcp 支持代码审查自动化、直接 API 查询、文件管理操作、工作流日志记录,以及为 AI 驱动后端任务创建标准化 LLM 工作流等场景。

oatpp-mcp 提供了一个简约、合规的 MCP 实现,但缺乏如采样、roots 或丰富工具资源等高级功能。如需更复杂的工作流,可能需要自行扩展其功能。

OpenAPI MCP 服务器让 AI 助手能够探索和理解 OpenAPI 规范,为开发者和大模型提供详细的 API 上下文、摘要和端点信息,无需直接执行端点。...

模型上下文协议(MCP)服务器将 AI 助手与外部数据源、API 和服务连接起来,实现复杂工作流的无缝集成,并在 FlowHunt 中安全管理开发任务。...

any-chat-completions-mcp MCP 服务器将 FlowHunt 和其他工具连接到任何兼容 OpenAI SDK 的 Chat Completion API。它通过统一、简单的界面中转聊天型查询,实现了对多个 LLM 提供商(如 OpenAI、Perplexity、Groq、xAI 和 PyroPr...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.