Inženýrství kontextu pro AI agenty: Jak správně předávat LLM správné informace

Naučte se, jak navrhovat kontext pro AI agenty správou zpětné vazby nástrojů, optimalizací využití tokenů a implementací strategií jako offloading, komprese a i...

Zjistěte, jak inženýrství kontextu optimalizuje výkon AI agentů strategickým řízením tokenů, eliminací nadbytečného kontextu a zaváděním pokročilých technik jako offloading, redukce, retrieval a izolace.

Inženýrství kontextu se stalo jednou z nejzásadnějších disciplín při budování efektivních AI agentů. Jak se jazykové modely zdokonalují a agenti zvládají stále složitější, vícekrokové úkoly, výzvou už není jen mít schopný model – jde o to, jak strategicky řídit, jaké informace modelu předáváte. Každý token má význam. V tomto komplexním průvodci prozkoumáme, co je inženýrství kontextu, proč je klíčové pro výkon AI agentů a konkrétní techniky, které využívají přední AI výzkumné organizace a platformy k tvorbě optimálních agentů. Ať už stavíte zákaznické chatovací roboty, datové analytické agenty nebo autonomní workflow, pochopení inženýrství kontextu zásadně zlepší výkon vašich AI systémů.

Inženýrství kontextu představuje zásadní posun v přemýšlení o stavbě systémů s velkými jazykovými modely. Místo toho, abychom na LLM nahlíželi jako na černou skříňku, které stačí dát správné instrukce, vnímá inženýrství kontextu model jako systém s omezenými kognitivními zdroji, jež je třeba důkladně řídit. Jeho jádrem je praxe vědět, jaký přesně kontext AI agentovi poskytnout – promyšleně řídit každý jednotlivý token, který prochází každým voláním LLM, abychom vytvořili optimální podmínky pro úspěch agenta.

Tento koncept zpopularizoval například Andrej Karpathy a nabývá na významu, jakmile se AI agenti vyvinuli ze základních chatbotů na sofistikované systémy schopné autonomního uvažování a akcí. Zásadním poznatkem je, že LLM, jako lidé, mají omezenou pracovní paměť a pozornost. Stejně jako člověk zvládne v jednu chvíli vnímat jen omezené množství informací, než ztratí přehled, i jazykové modely ztrácejí schopnost správně uvažovat při příliš velkém množství kontextu. To znamená, že kvalita kontextu je mnohem důležitější než jeho kvantita.

Inženýrství kontextu jde mnohem dál než tradiční prompt engineering, který se zaměřoval hlavně na tvorbu dokonalých systémových promptů či instrukcí. Zahrnuje totiž celý ekosystém informací dostupných agentovi v průběhu více interakcí – včetně systémových promptů, definic nástrojů, příkladů, historie zpráv, získaných dat i dynamicky načítaných informací. Cílem je udržovat štíhlé, vysoce relevantní kontextové okno, které agentovi dává přesně to, co potřebuje k dobrým rozhodnutím, aniž by byl zahlcen irelevantními informacemi.

Význam inženýrství kontextu nelze při stavbě produkčních AI agentů podcenit. Výzkumy opakovaně ukazují, že LLM trpí tzv. „context rot“ – měřitelným úpadkem výkonu s rostoucí délkou kontextového okna. Studie pomocí „needle-in-a-haystack“ benchmarků prokázaly, že s rostoucím počtem tokenů v kontextu klesá schopnost modelu si informace správně vybavit a uvažovat nad nimi. Nejde o zanedbatelný jev; je to základní architektonické omezení fungování transformerových jazykových modelů.

Důvodem této degradace je samotná architektura transformerů. Každý token v transformeru může interagovat s každým jiným tokenem v kontextu, což znamená n² kombinací pro n tokenů. S rostoucí délkou kontextu je mechanizmus pozornosti modelu čím dál rozptýlenější a musí udržovat vztahy napříč stále větším prostorem. Navíc jsou jazykové modely většinou trénované na kratších sekvencích, takže mají méně zkušeností i specializovaných parametrů pro práci se skutečně dlouhými závislostmi. Vzniká tak napětí mezi velikostí kontextu a schopností uvažování – modely sice zvládají delší kontexty, ale jejich přesnost při vyhledávání informací a dlouhodobém uvažování je nižší než u kratších vstupů.

Kromě architektonických omezení je zde i praktická stránka: LLM mají „attention budget“, který se s každým dalším tokenem snižuje. Každá další informace v kontextu tento rozpočet čerpá a zvyšuje kognitivní zátěž modelu. Proto je promyšlené inženýrství kontextu zásadní. Pečlivým výběrem informací, které se k modelu dostanou, nejen optimalizujete efektivitu, ale přímo zvyšujete kvalitu uvažování a rozhodování agenta. Agent s štíhlým, dobře organizovaným kontextovým oknem bude dělat lepší rozhodnutí, lépe se zotaví z chyb a udrží konzistentní výkon i při delších sekvencích interakcí než agent topící se v nerelevantních informacích.

Ačkoli spolu inženýrství kontextu a prompt engineering souvisejí, představují různé úrovně abstrakce při stavbě aplikací s jazykovými modely. Prompt engineering, který dominoval ranému rozvoji aplikací s LLM, se soustředí hlavně na to, jak napsat efektivní prompt a instrukce systému. Jde o tvorbu správných slov a vět, které vyvolají od modelu požadované chování u konkrétního úkolu. To funguje dobře u jednoúčelových úloh, jako je klasifikace, sumarizace nebo jednorázová generace textu.

Inženýrství kontextu je přirozeným vývojem prompt engineeringu pro éru vícekrokových autonomních agentů. Zatímco prompt engineering se ptá „Jak napsat dokonalou instrukci?“, inženýrství kontextu klade širší otázku: „Jaká je optimální konfigurace všech dostupných informací, která vygeneruje požadované chování?“ Zahrnuje nejen systémový prompt, ale také nástroje dostupné agentovi, poskytnuté příklady, historii zpráv z předchozích kol, získaná data i metadata, která agentovi pomáhají chápat jeho prostředí.

Přechod od prompt engineeringu k inženýrství kontextu odráží zásadní změnu ve stavbě AI aplikací. V počátcích byly většinou úlohy mimo běžný chat realizovány pomocí promptů optimalizovaných pro jednorázové použití. Dnes se pole posouvá směrem ke schopnějším agentům, kteří fungují ve více krocích a delších časových horizontech. Tito agenti generují stále více dat, která by mohla být relevantní pro budoucí rozhodnutí, a tato data je třeba cyklicky zpracovávat a vybírat. Inženýrství kontextu je disciplínou správy tohoto neustále se vyvíjejícího ekosystému informací, aby měl agent v každém kroku svého uvažování k dispozici přesně ty správné informace pro správná rozhodnutí.

Přední AI výzkumné organizace a platformy se shodují na čtyřech klíčových technikách efektivního inženýrství kontextu. Každá řeší jiný aspekt správy omezeného kontextového okna při zachování výkonu agenta. Pochopení těchto technik a jejich správné použití je zásadní pro tvorbu agentů připravených do produkce.

Offloading je praxe sumarizace informací a ukládání plných dat do externích referencí, což umožňuje agentovi přistupovat k detailním informacím jen tehdy, když je skutečně potřebuje. Když AI agent provede volání nástroje – například dotaz na databázi nebo API – dostane odpověď, která může být velmi rozsáhlá. Místo toho, abyste do kontextového okna vkládali celou odpověď, offloading spočívá ve shrnutí klíčových informací a poskytnutí reference, pomocí které si agent může v případě potřeby plná data vyžádat.

Praktickým příkladem je přístup organizace Manus AI, která pracuje na pokročilých AI agentech. Když jejich agent provede volání nástroje a obdrží odpověď, nezařazují celou odpověď do kontextu. Místo toho vytvoří stručné shrnutí a plný výsledek uloží do souboru nebo databáze s referenčním ukazatelem. Pokud agent později zjistí, že potřebuje detailnější informace, může na uložená data odkázat, aniž by zatěžoval hlavní konverzaci dalšími tokeny. Je to podobné jako u lidí – nememorujeme každý detail všech rozhovorů, ale vedeme si poznámky a reference, které v případě potřeby konzultujeme.

Cognition, další přední AI výzkumná organizace, implementovala podobný přístup, ale s vlastním systémem sumarizace. Místo univerzálních shrnutí používají specializovanou logiku sumarizace, která extrahuje nejrelevantnější informace pro jejich konkrétní případy použití. To ukazuje důležité pravidlo: nejlepší strategie offloadingu je často specifická pro daný úkol. Co je užitečné shrnutí, záleží na tom, co má agent za úkol. Přizpůsobením sumarizace konkrétní doméně a úkolu udržíte vysokou informační hodnotu kontextu a zároveň dramaticky snížíte spotřebu tokenů.

Redukce je technika zhušťování a kondenzace kontextu za účelem snížení celkového počtu tokenů při zachování zásadních informací. Jak agent funguje v několika kolech, roste historie konverzace. Bez aktivního řízení může tato historie rychle zaplnit celé kontextové okno, takže nezbývá místo pro nové informace či uvažování. Redukce tento problém řeší pravidelným zhušťováním konverzace do stručnější podoby.

Anthropic tuto techniku využívá prostřednictvím tzv. „kompaktování“ konverzace. Místo uchovávání celé historie každé zprávy ji pravidelně shrnují nebo komprimují do úspornější formy. To je důležité, protože výzkumy ukazují, že dlouhý kontext ve skutečnosti ztěžuje AI agentovi správné uvažování. Nadměrný kontext může vést k jevu zvanému „context poisoning“ – tedy tomu, že proces uvažování agenta je narušen irelevantními informacemi, což jej odvádí od optimálního postupu.

Redukční technika vychází z poznání, jak jazykové modely fungují: neplatí, že s větším množstvím informací budou lépe uvažovat. Často je pravda opak. Štíhlý, dobře organizovaný kontext obsahující pouze nejrelevantnější informace obvykle vede k lepšímu uvažování a spolehlivějšímu chování agenta. Proto mnoho organizací aktivně usiluje o zmenšování kontextu v čase, i když by teoreticky mohlo být k dispozici více informací. Zaměřením kontextového okna na důležité údaje udržují schopnost agenta jasně uvažovat a dobře se rozhodovat.

Retrieval-Augmented Generation, zkráceně RAG, je technika, kdy jsou relevantní informace dynamicky získávány a načítány do kontextu v reálném čase, místo aby byly předem nahrány. Tento přístup je stále populárnější, jak jsou agenti sofistikovanější. Místo snahy předem načíst veškeré možné informace, které agent může potřebovat, umožňují RAG systémy agentům aktivně vyhledávat a načítat informace podle vlastní potřeby.

Výhody tohoto přístupu jsou významné. Za prvé, dramaticky snižuje počáteční zátěž kontextu – agent začíná s úsporným kontextovým oknem a informace si přidává pouze podle potřeby. Za druhé, umožňuje postupné odhalování informací, kdy agent postupně objevuje relevantní kontext během svého „průzkumu“. Každá interakce přinese nové informace pro další rozhodnutí. Například agent může začít vyhledáním relevantních souborů, zjistit, že určité soubory jsou důležitější podle názvů či časových značek, a pak získat právě ty pro detailní analýzu. Tento vrstvený přístup je mnohem efektivnější než snaha načíst vše předem.

Claude Code od Anthropic je vynikajícím příkladem RAG v praxi. Místo načítání celého kódu do kontextu si udržuje lehké identifikátory jako cesty k souborům a používá nástroje jako grep a glob pro dynamické získávání relevantních souborů podle potřeby. Agent může psát cílené dotazy, ukládat výsledky a používat command-line nástroje pro analýzu velkých objemů dat bez načítání celých objektů do kontextu. Tento přístup kopíruje lidské myšlení – nememorujeme celé korpusy, ale vyvinuli jsme externí organizační systémy jako souborové systémy a vyhledávací nástroje, které nám umožňují informace získat na vyžádání.

Izolace je praxe využívání sub-agentů ke zpracování specifických úkolů, díky čemuž různí agenti pracují na oddělených problémech bez překrývání kontextu. Tato technika vychází z poznání, že někdy je nejlepší řídit kontext rozdělením složitých problémů na menší, soustředěnější podproblémy, z nichž každý řeší specializovaný agent s vlastním kontextovým oknem.

Existují dva hlavní přístupy k izolaci. Cognition, přední AI výzkumná organizace, používá sub-agenty jen tehdy, pokud jsou úkoly zcela oddělené bez překryvu. Jejich filozofie je, že sub-agenti přidávají složitost a potenciální body selhání a měli by být použiti jen při nezbytnosti. Jinak ovšem například Cloud Code staví architekturu na sub-agentech. V Cloud Code můžete vytvářet sub-agenty pro různé aspekty většího úkolu, přičemž manažerský agent koordinuje jejich práci.

Klíčové poznání u izolace je, že jde o kompromis. Na jedné straně sub-agenti usnadňují správu kontextu rozdělením problémového prostoru – každý agent má fokusované okno relevantní jeho úkolu. Na straně druhé přidávají režii koordinace a potenciální body selhání při předávání informací mezi agenty. Správný přístup záleží na konkrétním use-case. Pro velmi složité úlohy s jasně oddělenými podproblémy je izolace velmi efektivní. Pro úlohy, kde jsou aspekty těsně propojené, může být vhodnější jeden agent s dobře řízeným kontextem.

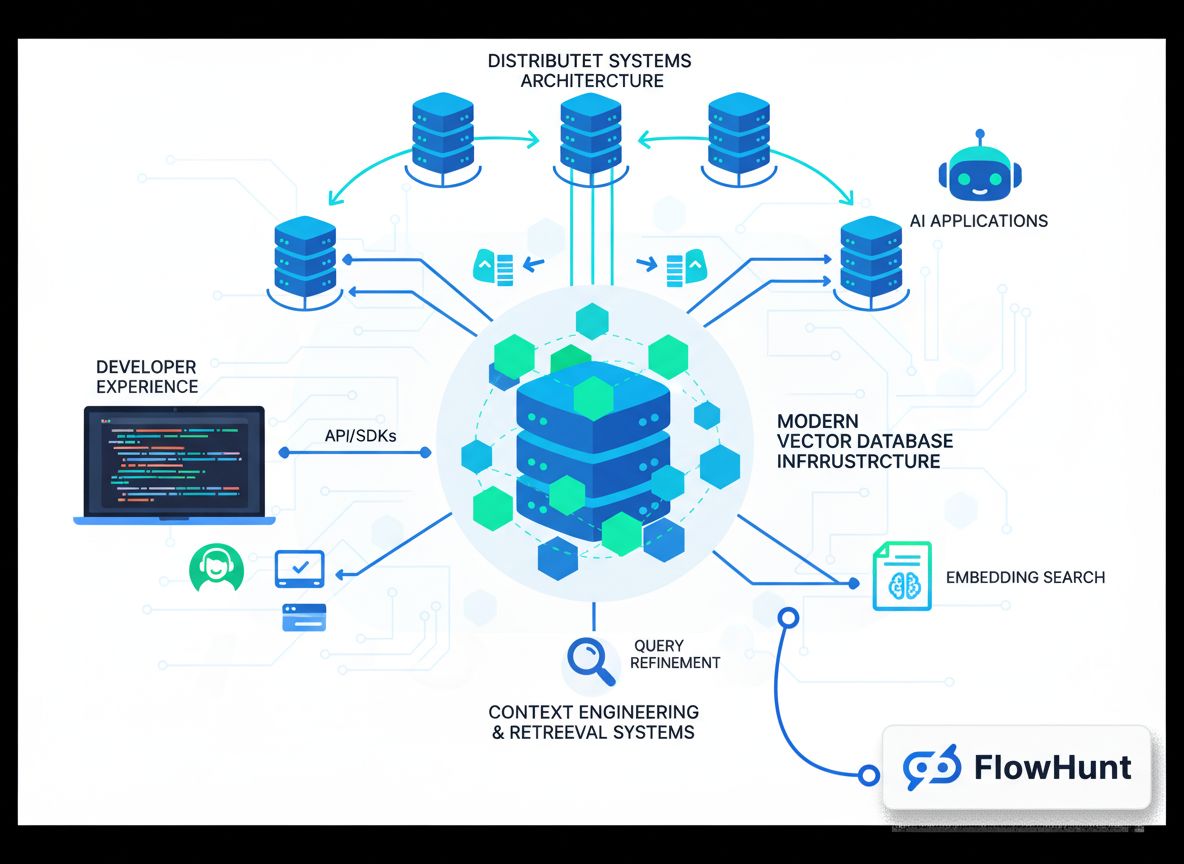

FlowHunt poskytuje komplexní platformu bez nutnosti programování pro implementaci všech těchto technik inženýrství kontextu. Místo toho, abyste museli vyvíjet vlastní řešení, umožňuje FlowHunt týmům zavádět sofistikované strategie správy kontextu přes intuitivní vizuální rozhraní. To demokratizuje inženýrství kontextu a zpřístupňuje jej týmům bez hlubokých znalostí machine learningu.

Ve FlowHunt můžete izolaci realizovat prostřednictvím self-management týmů. Self-management tým tvoří více AI agentů s manažerským agentem, který mezi nimi koordinuje. Manažerský agent přijímá úvodní úkol, rozděluje jej na sub-úkoly a deleguje je specializovaným agentům. Každý agent si udržuje vlastní fokusované kontextové okno relevantní jeho úkolu. Po dokončení sub-agentů manažerský agent výstupy syntetizuje. Díky tomu lze řešit složité problémy rozdělením na zvládnutelné části, z nichž každá má optimalizovaný kontext.

FlowHunt podporuje i sekvenční workflow úkolů, kdy více agentů pracuje na problému postupně a výstup jednoho je vstupem dalšího. To je užitečné pro workflow s jasnými návaznostmi. Například v procesu tvorby obsahu může jeden agent provádět rešerši tématu, druhý tvořit osnovu a třetí psát finální text. Každý agent má fokusované kontextové okno pouze pro svou fázi.

Dále FlowHunt umožňuje do vašich toků přímo stavět inteligentní retrieval systémy. Místo načítání všech informací předem můžete agenty nakonfigurovat tak, aby si podle potřeby dynamicky získávali potřebná data – například dotazováním na databáze, prohledáváním znalostních bází či načítáním souborů podle vlastního úsudku. Kombinací těchto možností umožňuje FlowHunt implementovat enterprise-grade inženýrství kontextu bez jediné řádky kódu.

Nad rámec čtyř základních technik využívají přední organizace i několik pokročilých strategií, které posouvají možnosti inženýrství kontextu. Tyto přístupy často kombinují více technik a vyžadují pečlivé ladění pro konkrétní use-casy.

Jednou z pokročilých strategií je hybridní správa kontextu, kdy organizace kombinují předem nahraný kontext s just-in-time retrievalem. Místo volby mezi načtením všeho předem a dynamickým získáváním načítají některé klíčové informace předem pro rychlost a spolehlivost a zároveň si zachovávají schopnost získávat další údaje podle potřeby. Claude Code používá právě tento hybridní přístup – soubory CLAUDE.md jsou většinou malé a obsahují důležité konfigurační informace, proto se načítají hned, zatímco větší soubory a data se získávají on-demand nástroji jako grep a glob.

Další pokročilou strategií je výběr kontextu řízený metadaty. Místo zaměření pouze na obsah informací používají sofistikované systémy metadata jako názvy souborů, časová razítka, strukturu složek a další organizační signály pro inteligentní rozhodování o relevanci informací. Agent operující v souborovém systému například může z názvu test_utils.py v adresáři tests vyvodit jiné závěry než u stejného souboru ve složce src/core_logic/. Tyto signály agentovi pomáhají rozhodnout, jak a kdy informace využít, aniž by musel načítat a analyzovat celý obsah.

Další zásadní strategií je mitigace context poisoningu. Jak jsme zmínili, context poisoning nastává, když irelevantní informace v kontextu způsobí, že agentovo uvažování se odchýlí od optimálního postupu. Pokročilé systémy aktivně hledají a odstraňují potenciálně škodlivý kontext. To může zahrnovat analýzu řetězce uvažování agenta za účelem identifikace místa, kde se „ztratil“, a následné odstranění nebo přeformulování problematického kontextu. Opakováním tohoto procesu se kvalita kontextu průběžně zlepšuje.

S tím, jak se AI agenti stávají stále sofistikovanějšími a jsou nasazováni v komplexnějších reálných scénářích, význam inženýrství kontextu dále poroste. Obor se rychle rozvíjí a pravidelně přináší nové techniky a osvědčené postupy. Několik trendů pravděpodobně ovlivní budoucnost inženýrství kontextu.

Za prvé, pravděpodobně uvidíme sofistikovanější automatizované systémy pro kurátorství kontextu. Namísto ručního rozhodování o tom, co do kontextu zahrnout, budou budoucí systémy využívat strojové učení k automatickému určení optimálního kontextu pro každého agenta a každý úkol. Tyto systémy se mohou učit z výstupů agenta, které části kontextu jsou nejhodnotnější a které naopak mohou způsobovat „otravu“.

Za druhé, inženýrství kontextu bude stále více integrováno s návrhem architektury agentů. Místo toho, aby byla správa kontextu až druhotnou záležitostí, budou budoucí agentní systémy od začátku navrhovány s ohledem na efektivitu kontextu. To může zahrnovat nové architektury agentů, které jsou z principu lepší ve správě omezených kontextových oken, nebo nové způsoby reprezentace informací, které jsou úspornější na tokeny.

Za třetí, pravděpodobně vznikne inženýrství kontextu jako samostatná profesionální disciplína se specializovanými nástroji, frameworky a best practices. Podobně jako se prompt engineering vyvinul z nahodilé praxe na uznávanou disciplínu s osvědčenými technikami, sleduje inženýrství kontextu podobnou trajektorii. Organizace budou investovat do budování specializovaných týmů a nástrojů zaměřených právě na optimalizaci kontextu.

{{ cta-dark-panel heading=“Zrychlete svůj workflow s FlowHunt” description=“Vyzkoušejte, jak FlowHunt automatizuje váš AI obsahový i SEO workflow – od rešerše a tvorby obsahu po publikaci a analytiku – vše na jednom místě.” ctaPrimaryText=“Rezervovat demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Vyzkoušet FlowHunt zdarma” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Abychom vám pomohli začít s inženýrstvím kontextu, projdeme si praktický příklad stavby agenta pro běžné použití: rešerši a generování obsahu. Tento příklad ukazuje, jak v reálné situaci využít diskutované techniky.

Začněte tím, že jasně definujete hlavní odpovědnost svého agenta. V tomto případě má agent za úkol provést rešerši tématu a vygenerovat komplexní článek. Místo toho, abyste vše řešili jedním agentem s obřím kontextovým oknem, použijete izolaci a vytvoříte systém více agentů. Prvním agentem je výzkumník, který sbírá informace o tématu. Druhým agentem je pisatel, který na základě rešerše sestaví článek. Manažerský agent mezi nimi koordinuje.

U výzkumníka implementujte retrieval-based správu kontextu. Místo načtení všech dostupných informací o tématu předem by měl mít výzkumník nástroje pro vyhledávání v databázích, dotazování API a získávání relevantních dokumentů. Jakmile informace objeví, klíčové poznatky shrne a uloží reference na plné zdroje. Tím zůstává kontextové okno výzkumníka štíhlé, ale zároveň má přístup ke všem datům, která potřebuje.

U pisatele implementujte offloading. Výzkumník předá pisateli shrnutí poznatků a reference na plné zdroje. Kontext pisatele obsahuje shrnutí a možnost v případě potřeby načíst plné zdrojové materiály. Pisatel tak může pracovat efektivně, aniž by byl zahlcen hrubými daty z rešerše.

Po celou dobu sledujte, zda nedochází ke context poisoningu. Pokud si všimnete, že agent činí špatná rozhodnutí nebo se „ztrácí“, analyzujte jeho uvažování a zjistěte, které části kontextu mohou být příčinou. Tyto části odstraňte nebo přeformulujte a testujte znovu. Postupem času získáte cit, jaký kontext je pro váš use-case nejlepší.

Efektivní inženýrství kontextu vyžaduje měření a průběžnou optimalizaci. Je třeba nastavit metriky, které vám umožní zjistit, zda vaše úsilí skutečně zlepšuje výkon agentů. Existuje několik klíčových metrik, které stojí za sledování.

Za prvé měřte efektivitu tokenů – poměr užitečného výstupu k počtu spotřebovaných tokenů. Agent, který dosahuje kvalitních výsledků s menší spotřebou tokenů, je efektivnější. Sledujte tuto metriku v čase při zavádění technik inženýrství kontextu. Měli byste vidět zlepšení s implementací offloadingu, redukce a retrievalu.

Za druhé sledujte kvalitu uvažování. Může jít o rozbor argumentačních řetězců agenta, zda jsou koherentní a logické, nebo porovnání výstupů agenta s etalonem. Lepší inženýrství kontextu by mělo vést ke zlepšení kvality uvažování, protože agent není rozptylován irelevantními informacemi.

Za třetí sledujte zotavení z chyb. Jak dobře se agent zotaví, když udělá chybu? Lepší inženýrství kontextu by mělo zlepšit zotavení, protože agent má jasnější informace o tom, co se pokazilo a jak pokračovat.

Za čtvrté sledujte latenci a náklady. I když je hlavním cílem inženýrství kontextu zlepšení kvality, přináší i efektivitu. Agenti s lépe řízeným kontextem mají obvykle nižší latenci (zpracovávají méně tokenů) a nižší náklady (spotřebují méně tokenů). Sledujte tyto metriky, abyste porozuměli celkovému dopadu svých snah.

Při implementaci inženýrství kontextu se týmy často setkávají s několika běžnými chybami. Uvědomění si těchto pastí vám pomůže vyhnout se nákladným omylům.

První chybou je přehnaná optimalizace. Je lákavé snažit se vytěsnit z kontextového okna každý token, ale to může vést ke kontextu, který je příliš štíhlý, aby byl užitečný. Pamatujte, že cílem je najít optimální rovnováhu – dostatek informací pro efektivní uvažování agenta, ale ne tolik, aby byl zmatený. Začněte s rozumným množstvím kontextu a redukujte jej, pouze pokud zjistíte, že agent funguje dobře.

Druhou chybou je ignorování požadavků konkrétního úkolu. Inženýrství kontextu není univerzální. Co funguje pro zákaznického agenta, nemusí fungovat pro datového analytika. Udělejte si čas na pochopení svého konkrétního use-case a přizpůsobte podle něj svůj přístup.

Třetí chybou je opomenutí monitorování a iterace. Inženýrství kontextu není jednorázová činnost. Jak agent narazí na nové situace a mění se vaše požadavky, musíte průběžně sledovat výkon a upravovat strategii. Zahrňte monitoring a iterace do svého vývoje od začátku.

Čtvrtou chybou je podcenění významu metadat. Mnoho týmů se soustředí na obsah kontextu, ale zanedbává metadata, která agentům pomáhají chápat, jak obsah použít. Názvy souborů, časová razítka, struktura složek a další organizační signály jsou často cennější, než si myslíte. Věnujte pozornost tomu, jak informace organizujete a označujete.

Inženýrství kontextu představuje zásadní posun v přístupu ke stavbě AI agentů – od zaměření na psaní dokonalých promptů k promyšlené správě všech dostupných informací s cílem optimalizovat výkon agenta. Porozum

Inženýrství kontextu je praxe strategického vytváření a správy tokenů poskytovaných AI agentovi nebo jazykovému modelu za účelem optimalizace výkonu. Zahrnuje promyšlené řízení každého tokenu, který prochází voláním LLM, abychom vytvořili co nejlepší kontext pro efektivní rozhodování a činnost agenta.

Prompt engineering se zaměřuje na psaní efektivních promptů a systémových instrukcí pro jednorázové úkoly. Inženýrství kontextu je širší a více iterativní – spravuje celý stav kontextu napříč několika kroky inference, včetně systémových instrukcí, nástrojů, externích dat, historie zpráv i dynamicky získaných informací.

Context rot označuje zhoršení schopnosti LLM přesně si vybavit a zpracovávat informace s rostoucím rozsahem kontextového okna. Děje se tak proto, že LLM mají omezený 'attention budget' a s rostoucím počtem tokenů klesá návratnost, což činí pečlivou správu kontextu zásadní.

Čtyři hlavní techniky jsou: (1) Offloading – sumarizace odpovědí nástrojů a ukládání plných dat jako reference; (2) Redukce – zhuštění konverzace za účelem snížení počtu tokenů; (3) Retrieval (RAG) – dynamické získávání relevantních informací v reálném čase; a (4) Izolace – využití sub-agentů ke zpracování specifických úkolů bez překrývání kontextu.

FlowHunt poskytuje platformu bez programování pro implementaci všech technik inženýrství kontextu. Můžete vytvářet self-management týmy s manažerskými agenty, používat sekvenční workflow úkolů, implementovat sub-agenty pro izolaci a stavět inteligentní retrieval systémy – to vše bez nutnosti programování.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

Vytvářejte chytřejší a efektivnější AI agenty s možnostmi inženýrství kontextu od FlowHunt. Inteligentně spravujte tokeny a škálujte své automatizační workflow.

Naučte se, jak navrhovat kontext pro AI agenty správou zpětné vazby nástrojů, optimalizací využití tokenů a implementací strategií jako offloading, komprese a i...

Prozkoumejte, jak kontextové inženýrství mění vývoj AI, evoluci od RAG k produkčně připraveným systémům a proč jsou moderní vektorové databáze jako Chroma klíčo...

Komplexní průvodce kontextovým inženýrstvím, další metou v návrhu AI systémů. Naučte se základní strategie, pochopte problém 'kontextového rozkladu' a objevte o...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.