Dekódování AI agentních modelů: Nejlepší srovnávací analýza

Prozkoumejte svět AI agentních modelů v rámci komplexní analýzy 20 špičkových systémů. Objevte, jak přemýšlejí, uvažují a podávají výkony v různých úlohách, a p...

Hloubková analýza modelu pro uvažování EXAONE Deep 32B od LG testovaného proti DeepSeek R1 a Alibaba QwQ, zkoumající tvrzení o vyšším výkonu a skutečné schopnosti uvažování.

Oblast modelů pro uvažování v umělé inteligenci je stále konkurenčnější, přičemž více organizací deklaruje průlomový výkon při řešení komplexních matematických a logických úloh. Nedávné uvedení modelu EXAONE Deep od LG, modelu pro uvažování s 32 miliardami parametrů, vzbudilo pozornost tvrzeními o překonání zavedených konkurentů, jako je DeepSeek R1. Skutečné testování však ukazuje realističtější obraz, než jaký prezentují marketingová sdělení. Tento článek nabízí hlubokou analýzu skutečného výkonu EXAONE Deep ve srovnání s dalšími předními modely pro uvažování a zkoumá rozdíl mezi udávanými benchmarky a praktickou funkčností. Prostřednictvím praktických testů a detailního porovnání prozkoumáme, co tyto modely skutečně dokáží, jak zvládají složité úlohy vyžadující uvažování a co to znamená pro organizace, které zvažují jejich nasazení v praxi.

Vznik modelů pro uvažování představuje zásadní změnu v tom, jak umělá inteligence řeší složité problémy. Na rozdíl od tradičních jazykových modelů, které generují odpovědi v jednom průchodu, modely pro uvažování využívají techniku zvanou test-time decoding, kdy během inferencí alokují výrazné výpočetní zdroje, aby krok za krokem promýšlely úlohu. Tento přístup připomíná lidské myšlení, kdy musíme k řešení často procházet více úhlů pohledu. Koncept získal na významu s modelem o1 od OpenAI a od té doby jej převzalo více organizací včetně DeepSeek, Alibaby a nyní LG. Tyto modely generují tzv. “thinking” nebo “reasoning” tokeny, které uživatel obvykle nevidí ve finálním výstupu, ale představují vnitřní proces uvažování modelu. Myšlenkové tokeny jsou důležité, protože umožňují modelu zkoumat různé cesty řešení, zachytit chyby a upřesnit svůj přístup dříve, než se rozhodne pro konečnou odpověď. To je zvláště cenné u matematických úloh, logických problémů a složitých vícekrokových scénářů, kde jeden průchod může opomenout důležité detaily nebo vést ke špatným závěrům.

Pro organizace, které implementují AI systémy, znamenají modely pro uvažování výrazný posun v oblasti spolehlivosti a přesnosti při řešení složitých úloh. Tradiční jazykové modely často selhávají na vícekrokových matematických úlohách, logické dedukci a scénářích, které vyžadují pečlivou analýzu podmínek a omezení. Modely pro uvažování tyto limity řeší tím, že explicitně ukazují svůj postup, což zároveň poskytuje transparentnost, jak model došel k závěru. Tato transparentnost je klíčová zejména v podnikových prostředích, kde musí být rozhodnutí založená na doporučeních AI auditovatelná a vysvětlitelná. Nevýhodou jsou však vyšší výpočetní nároky a delší odezva. Protože modely pro uvažování generují před konečnou odpovědí rozsáhlé myšlenkové tokeny, vyžadují více výpočetního výkonu a odpovídají pomaleji než standardní jazykové modely. Výběr modelu je proto zásadní – organizace musí rozumět nejen benchmarkovým výsledkům, ale i skutečnému výkonu v reálných případech použití. Rozmach modelů od různých dodavatelů, z nichž každý slibuje lepší výkon, činí nezávislé testování a porovnávání klíčovým pro informované rozhodování o nasazení.

Vstup LG na pole modelů uvažování s EXAONE Deep vzbudil značný zájem, a to zejména díky výzkumnému zázemí firmy a poměrně skromné velikosti modelu (32 miliard parametrů). Marketingové materiály LG prezentovaly působivé benchmarky: EXAONE Deep měl dosáhnout 90 % přesnosti v soutěži AIME (American Invitational Mathematics Examination) s pouhými 64 pokusy a 95 % na úlohách MATH-500. Pokud by tato čísla byla pravdivá, jednalo by se o výkon srovnatelný nebo lepší než u modelů DeepSeek R1 a QwQ od Alibaby. Firma také uvedla různé velikosti modelu včetně 2,4miliardové verze určené jako návrhový model pro tzv. speculative decoding – techniku, kdy menší model předpovídá tokeny, které vygeneruje větší model, což může zrychlit inferenci. Při praktickém testování na standardních úlohách pro uvažování však EXAONE Deep vykazoval znepokojivé chování odporující těmto benchmarkům. Model měl tendenci vstupovat do dlouhých smyček myšlení bez dosažení logických závěrů, generoval tisíce tokenů, které byly spíše opakující se nebo nesmyslné než produktivní. Toto chování naznačuje možné problémy v trénování modelu, v metodice vyhodnocení nebo ve způsobu, jak model zpracovává určité typy promptů.

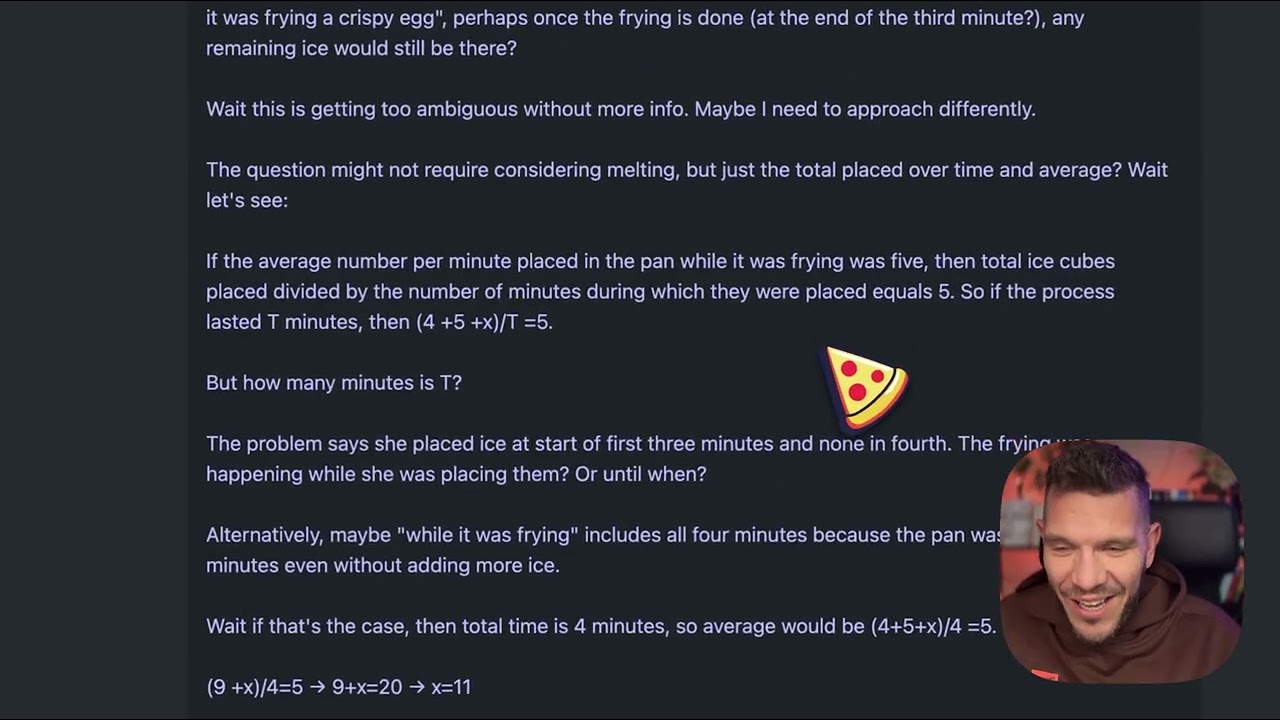

Pro pochopení praktických rozdílů mezi modely pro uvažování si představme zdánlivě jednoduchou úlohu, která se stala standardem pro testování kvality uvažování: “Beth dá několik celých kostek ledu do pánve. Po jedné minutě je v pánvi 20 kostek, po dvou minutách 10 kostek, po třech minutách 0 kostek. Kolik celých kostek ledu bude v pánvi na konci třetí minuty?” Správná odpověď je nula, protože otázka se výslovně ptá na celé kostky ledu na konci třetí minuty a v zadání je uvedeno, že tehdy jsou nula. Tato úloha je však navržena tak, aby zmátla modely, které ji příliš analyzují nebo se nechají zmást narativem o tání ledu. Některé modely mohou začít počítat rychlost tání a místo přímé odpovědi se zamotají. Při testování EXAONE Deep na tento problém model vygeneroval asi 5 000 tokenů myšlení bez dosažení smysluplného závěru. Proces uvažování modelu se rozpadl, text byl stále nesourodější a model neprokázal logické řešení problému. Tokeny zahrnovaly útržky, které netvořily ucelené myšlenky, a model nikdy jasně neartikuloval postup nebo konečnou odpověď. Tento výkon ostře kontrastuje s tím, jak by měl model pro uvažování úlohu řešit – rozpoznat chyták, jasně projít logiku a efektivně dojít ke správné odpovědi.

Když byl tentýž problém s kostkami ledu zadán modelům DeepSeek R1 a QwQ od Alibaby, oba předvedly výrazně lepší výkon. DeepSeek R1 generoval jasný myšlenkový proces, postupoval systematicky a došel ke správné odpovědi nula. Jeho uvažování bylo transparentní a logické – ukázal, jak úlohu analyzoval, rozpoznal chyták a určil správnou odpověď. QwQ také ukázal silný výkon, i když vygeneroval rovněž rozšířený myšlenkový proces. Zajímavé bylo, že QwQ nejprve zvažoval, zda kostky ledu mohou tát a zda otázka směřuje na fyziku či matematiku, ale nakonec dospěl ke správné odpovědi. Klíčový rozdíl byl ve srozumitelnosti uvažování – oba modely dokázaly rozpoznat, kdy mají dost informací k odpovědi, a rozhodnout se pro závěr. EXAONE Deep tohoto bodu nikdy nedosáhl. Model stále generoval tokeny bez jasného smyslu, nikdy se nerozhodl pro odpověď ani neukázal logický postup. To naznačuje zásadní problémy s tím, jak model zvládá úlohy vyžadující uvažování navzdory působivým benchmarkům.

Zajímavým technickým aspektem uvolnění EXAONE Deep je přítomnost více velikostí modelu navržených pro spolupráci pomocí speculative decoding. Verze s 2,4 miliardami parametrů může sloužit jako návrhový model, který předpovídá tokeny, jež by vygeneroval větší 32miliardový model. Když se předpovědi návrhového modelu shodují s generováním hlavního modelu, systém může přeskočit výpočet hlavního modelu a použít návrh, čímž efektivně zrychlí inferenci. Jde o sofistikovanou optimalizaci, která může výrazně snížit latenci a výpočetní požadavky. V testech implementace speculative decoding ukazovala zelené tokeny signalizující úspěšné návrhové předpovědi, což naznačuje, že technika fungovala. Tato optimalizace však neřeší základní problém kvality uvažování hlavního modelu. Rychlejší inference špatného uvažování je stále špatné uvažování. Přítomnost této optimalizace také vyvolává otázky, zda výsledky benchmarků LG nebyly dosaženy s konfiguracemi nebo technikami, které se v reálném použití neprojeví.

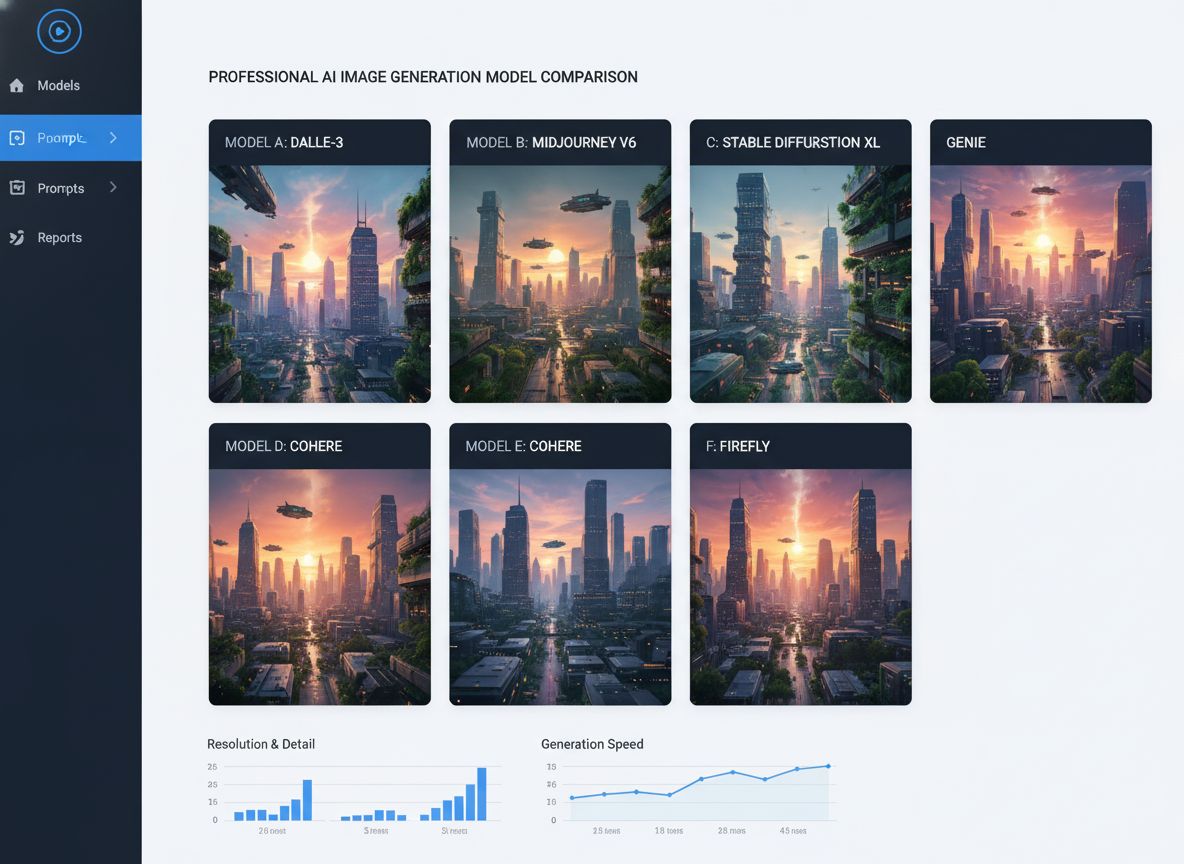

Pro organizace, které se snaží hodnotit a porovnat více AI modelů, nabízí FlowHunt komplexní automatizační platformu pro testování a benchmarking. Namísto manuálního testování různých modelů a porovnávání výsledků umožňuje FlowHunt týmům nastavovat automatizované workflow, které systematicky hodnotí výkon modelu v několika dimenzích. To je zvláště cenné při porovnávání modelů pro uvažování, kde se výkon může výrazně lišit podle typu úlohy, složitosti a konkrétní formulace promptu. Automatizace ve FlowHunt umožňuje testovat modely na standardizovaných sadách úloh, sledovat metriky výkonu v čase a generovat přehledné porovnávací reporty. Platforma se integruje s více poskytovateli modelů a API, takže lze hodnotit modely od různých dodavatelů v rámci jednoho workflow. Pro týmy zvažující nasazení modelů jako EXAONE Deep, DeepSeek R1 nebo QwQ poskytuje FlowHunt infrastrukturu pro datově podložená rozhodnutí na základě skutečného výkonu, ne pouze firemních tvrzení. Schopnost automatizovat opakované testy navíc šetří inženýrské zdroje, které lze věnovat integraci a optimalizaci místo ručního benchmarkingu.

Rozdíl mezi deklarovaným výkonem EXAONE Deep a jeho skutečným chováním v testech ukazuje důležité poučení pro adopci AI: benchmarky od dodavatelů je nutné vždy ověřovat nezávislým testováním. Výsledky benchmarků mohou ovlivnit různé faktory: konkrétní testovací sada, metodika vyhodnocení, hardwarová konfigurace či parametry inferencí. Model může excelovat v jednom benchmarku, ale mít potíže s jinými typy úloh nebo v reálných scénářích. Proto hrají organizace jako Weights & Biases a nezávislí výzkumníci klíčovou roli v AI ekosystému – poskytují nezávislé testování a analýzy, které pomáhají komunitě pochopit, co modely skutečně dokáží. Při hodnocení modelů pro nasazení v produkci by organizace měly provádět vlastní testy na reprezentativních úlohách ze svého oboru. Model, který vyniká v matematickém uvažování, může selhat v logické dedukci nebo generování kódu. Problém s kostkami ledu, ač jednoduchý, je užitečným diagnostickým testem – ukazuje, zda model zvládne chytáky a vyhne se přemýšlení nad rámec. Modely, které v takových úlohách selžou, pravděpodobně neobstojí ani v komplexnějších scénářích.

Dlouhé smyčky myšlení pozorované při testování EXAONE Deep mohou mít více příčin. Jednou možností je, že tréninkový proces modelu nedostatečně naučil, kdy má model ukončit myšlení a přejít k odpovědi. Modely pro uvažování vyžadují pečlivou kalibraci během tréninku, aby se vyvážila výhoda rozšířeného myšlení s rizikem přemýšlení nad rámec a generování neproduktivních tokenů. Pokud trénink nezahrnoval dostatek příkladů ukončení, může model generovat tokeny až do dosažení maximálního limitu. Další možností je problém se zpracováním promptů, konkrétně s tím, jak model interpretuje určité otázky nebo instrukce. Některé modely jsou citlivé na konkrétní formulace promptu a mohou se podle toho chovat odlišně. Skutečnost, že EXAONE Deep generoval nesourodé sekvence tokenů, naznačuje, že model mohl vstoupit do stavu, kdy generoval tokeny bez významného obsahu, což může znamenat problémy s mechanismy pozornosti nebo logikou predikce tokenů. Třetí možností je, že metodika vyhodnocení benchmarků využívala jiné konfigurace nebo strategie než reálné testování, což vede k podstatnému rozdílu mezi deklarovaným a skutečným výkonem.

Problémy s výkonem EXAONE Deep mají širší důsledky pro trh modelů pro uvažování. S tím, jak více organizací uvádí tyto modely, hrozí přehlcení trhu modely s působivými benchmarky, ale pochybným výkonem v praxi. To vytváří obtížné prostředí pro organizace, které vybírají modely pro produkční použití. Řešením je větší důraz na nezávislé testování, standardizované metodiky hodnocení a transparentnost ohledně omezení modelů. Oblast modelů pro uvažování by těžila z oborových standardů pro hodnocení a porovnávání, podobně jako se vyvíjely jiné AI benchmarky. Organizace by měly být také obezřetné vůči modelům, které slibují výrazně lepší výkon než zavedení konkurenti, zejména pokud nesrovnalosti neodpovídají architektuře nebo tréninkovému přístupu. DeepSeek R1 a QwQ prokázaly konzistentní výkon v různých scénářích, což vzbuzuje důvěru v jejich schopnosti. Nekonzistentní výkon EXAONE Deep – vynikající benchmarky, ale slabé výsledky v praxi – naznačuje buď problém v modelu samotném, nebo v provedení benchmarků.

Vyzkoušejte, jak FlowHunt automatizuje vaše AI a SEO workflow – od výzkumu a generování obsahu po publikaci a analytiku – vše na jednom místě.

Organizace, které zvažují nasazení modelů pro uvažování, by měly dodržet strukturovaný proces hodnocení. Nejprve stanovte reprezentativní testovací sadu, která zahrnuje úlohy z vašeho konkrétního oboru nebo použití. Obecné benchmarky nemusí odrážet, jak si model povede na vašich skutečných problémech. Zadruhé testujte více modelů na stejných úlohách pro přímé porovnání – to vyžaduje standardizované prostředí včetně hardwaru, parametrů inferencí a formulace promptů. Zatřetí hodnoťte nejen přesnost, ale i efektivitu, například latenci a počet generovaných tokenů. Model, který sice odpoví správně, ale potřebuje k tomu 10 000 myšlenkových tokenů, nemusí být v praxi použitelný tam, kde je vyžadována rychlá odezva. Začtvrté sledujte proces uvažování modelu, nejen konečnou odpověď – model, který dosáhne správné odpovědi chybným uvažováním, může selhat na podobných úlohách s drobnou obměnou. Zapáté testujte i hraniční a záludné případy, abyste poznali, jak model zvládne úlohy navržené k jeho zmatení. Nakonec zvažte celkové náklady na vlastnictví – nejen cenu licence či API, ale i výpočetní náročnost inferencí a inženýrskou práci na integraci.

EXAONE Deep má 32 miliard parametrů, což je výrazně méně než některé konkurenční modely pro uvažování, což vyvolává otázku, zda jeho problémy pramení z nedostatečné kapacity. Velikost modelu však sama o sobě neurčuje schopnosti uvažování. QwQ, který operuje v podobném rozsahu parametrů, předvádí silné výsledky v uvažování. To naznačuje, že problémy EXAONE Deep pravděpodobně souvisejí spíše s metodikou tréninku, návrhem architektury nebo konfigurací inferencí než s limity velikosti modelu. Přítomnost návrhového modelu s 2,4 miliardami parametrů v release EXAONE Deep ukazuje, že LG myslí na efektivitu, což je chvályhodné. Efektivita má však smysl jen tehdy, když základní model produkuje správné výsledky – rychlá špatná odpověď je v praxi horší než pomalá správná. Trh s modely pro uvažování bude pravděpodobně dále klást důraz na efektivitu, protože organizace chtějí tyto modely nasazovat ve velkém, ale tato optimalizace nesmí být na úkor kvality uvažování.

Oblast modelů pro uvažování je stále v rané fázi a lze očekávat významný vývoj v příštích měsících a letech. S tím, jak více organizací uvádí své modely a přibývá nezávislého testování, se trh pravděpodobně stabilizuje kolem modelů s konzistentním a spolehlivým výkonem. Organizace jako DeepSeek a Alibaba si vybudovaly důvěryhodnost díky konzistentním výsledkům, zatímco noví hráči jako LG budou muset vyřešit pozorované problémy, aby získali přijetí na trhu. Můžeme také očekávat další inovace v trénování a hodnocení modelů pro uvažování. Současný přístup generování rozsáhlých myšlenkových tokenů je účinný, ale výpočetně náročný. V budoucnu mohou vzniknout efektivnější mechanismy uvažování, které dosáhnou srovnatelné přesnosti s méně tokeny. Pravděpodobně se také zvýší specializace, kdy budou modely pro uvažování optimalizovány pro konkrétní domény, např. matematiku, generování kódu nebo logickou dedukci. Integrace modelů pro uvažování s dalšími AI technikami, jako je retrieval-augmented generation či práce s nástroji, rozšíří jejich možnosti a použitelnost.

LG EXAONE Deep představuje ambiciózní vstup na trh modelů pro uvažování, ale testy v reálném světě odhalují výrazné rozdíly mezi deklarovaným výkonem a skutečnými schopnostmi. Přestože benchmarky modelu naznačují konkurenceschopný výkon s DeepSeek R1 a QwQ od Alibaby, praktické testy na standardních úlohách ukazují, že EXAONE Deep selhává i na základních úlohách a generuje nadměrné množství tokenů bez dosažení smysluplného závěru. DeepSeek R1 i QwQ oba prokázaly lepší výkon na stejných úlohách a došly ke správným odpovědím jasným, logickým uvažováním. Pro organizace hodnotící modely pro uvažování pro nasazení do produkce tato analýza podtrhuje zásadní význam nezávislého testování a ověření. Benchmarky od dodavatelů by měly být pouze výchozím bodem, nikoliv definitivním měřítkem schopností modelu. Trh s modely pro uvažování bude těžit z větší transparentnosti, standardizovaných metodik hodnocení a pokračujícího nezávislého testování výzkumnou komunitou. S dalším zráním této technologie budou mít organizace, které investují do důkladného hodnocení a porovnávání modelů, lepší pozici pro výběr a nasazení modelů pro uvažování, které přinesou skutečnou hodnotu pro jejich konkrétní použití.

EXAONE Deep je model pro uvažování s 32 miliardami parametrů vyvinutý společností LG, který využívá test-time decoding k řešení složitých problémů. Na rozdíl od běžných jazykových modelů rozděluje výpočetní zdroje během inferencí, aby krok za krokem promýšlel problémy podobně jako modely DeepSeek R1 a QwQ od Alibaby.

V praktických testech na úlohách uvažování, jako je problém s kostkami ledu, vykazoval EXAONE Deep zásadní potíže s přemýšlením nad rámec a generoval nadměrné množství tokenů bez dosažení logických závěrů. DeepSeek R1 i QwQ si vedly lépe a efektivněji došly ke správným odpovědím.

Test-time decoding je technika, při níž AI modely během inferencí věnují více výpočetních zdrojů, aby dokázaly promyslet složité úlohy. Díky tomu modely ukazují svůj myšlenkový postup a dosahují přesnějších odpovědí, ovšem vyžaduje to pečlivé nastavení, aby nedocházelo k přemýšlení nad rámec.

FlowHunt automatizuje workflow testování, porovnávání a vyhodnocování více AI modelů. Týmům umožňuje systematicky porovnávat výkon, sledovat metriky a dělat datová rozhodnutí o tom, které modely nasadit pro konkrétní použití.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

Využijte FlowHunt ke zjednodušení procesů testování, porovnávání a sledování výkonu AI modelů pomocí inteligentní automatizace.

Prozkoumejte svět AI agentních modelů v rámci komplexní analýzy 20 špičkových systémů. Objevte, jak přemýšlejí, uvažují a podávají výkony v různých úlohách, a p...

Porovnejte OpenAI O3 Mini a DeepSeek v úlohách vyžadujících uvažování, šachové strategie a agentické využívání nástrojů. Zjistěte, který AI model vyniká v přesn...

Komplexní srovnání předních AI modelů pro generování obrázků včetně Qwen ImageEdit Plus, Nano Banana, GPT Image 1 a Seadream. Zjistěte, který model vyniká v růz...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.