Inženýrství kontextu pro AI agenty: Mistrovství v optimalizaci tokenů a výkonu agentů

Zjistěte, jak inženýrství kontextu optimalizuje výkon AI agentů strategickým řízením tokenů, eliminací nadbytečného kontextu a zaváděním pokročilých technik jak...

Prozkoumejte, jak kontextové inženýrství mění vývoj AI, evoluci od RAG k produkčně připraveným systémům a proč jsou moderní vektorové databáze jako Chroma klíčové pro spolehlivé AI aplikace ve velkém měřítku.

Cesta od vytvoření funkčního AI prototypu po nasazení produkčně připraveného systému byla vždy jednou z nejnáročnějších částí vývoje umělé inteligence. Co se v demech často jeví jako přímočarý proces – vyhledávání relevantních informací, rozšíření promptů a generování odpovědí – se při škálování do produkčního prostředí stává exponenciálně složitějším. Tato složitost vedla k tomu, že mnoho lidí v oboru popisuje tento proces spíše jako „alchymii“ než inženýrství: záhadný postup, kdy vývojáři ladí konfigurace, upravují parametry a doufají, že jejich systémy budou dál spolehlivě fungovat. Vznik kontextového inženýrství jako disciplíny představuje zásadní posun v přístupu ke stavbě AI systémů – od metody pokus-omyl směrem k systematickému, inženýrskému řešení. V tomto podrobném rozboru se podíváme, jak moderní vektorové databáze a principy kontextového inženýrství proměňují vývoj AI aplikací a umožňují týmům stavět systémy, které nejsou jen funkční, ale opravdu spolehlivé a udržitelné ve velkém měřítku.

Kontextové inženýrství se stalo jednou z nejdůležitějších disciplín moderního AI vývoje, a přesto zůstává pro mnoho vývojářů ve vstupní fázi oboru málo pochopené. V jádru je kontextové inženýrství praxí systematické správy, organizace a optimalizace kontextových informací, které AI systémy používají pro rozhodování a generování výstupů. Na rozdíl od tradičního Retrieval-Augmented Generation (RAG), který se úzce soustředí na vyhledání relevantních dokumentů pro rozšíření promptu před jeho odesláním jazykovému modelu, zaujímá kontextové inženýrství mnohem širší pohled na celý pipeline. Zahrnuje tok dat systémem, způsob ukládání a indexace informací, jak probíhá retrieval, jak jsou výsledky řazeny a filtrovány a nakonec, jak je tento kontext předkládán modelu. Tento holistický pohled uznává, že kvalita výstupu AI systému je zásadně omezena kvalitou a relevancí kontextu, který obdrží. Pokud je kontext špatně spravován – pokud se vyhledávají irelevantní informace, podstatné detaily se ztrácejí nebo se stejné informace zpracovávají opakovaně – celý systém degraduje. Kontextové inženýrství tyto výzvy řeší tím, že správu kontextu povyšuje na plnohodnotný inženýrský problém, na který je třeba uplatnit stejnou důslednost jako na jiné klíčové části infrastruktury.

Důležitost kontextového inženýrství je patrná okamžitě, když si uvědomíme měřítko, v jakém moderní AI systémy fungují. Jazykový model může být požádán o zpracování stovek tisíc dokumentů, syntézu informací z vícero zdrojů a generování koherentních odpovědí na základě tohoto souhrnu. Bez správného kontextového inženýrství se tento proces mění v chaos. Kontextové okno zaplní irelevantní dokumenty, důležité informace se ztratí v šumu a výkonnost modelu klesá. Navíc, jak se AI systémy stávají sofistikovanějšími a jsou nasazovány v kritických aplikacích – od zákaznické podpory přes lékařskou diagnostiku až po finanční analýzy – roste i riziko špatně zvládnutého kontextu. Systém, který občas vrací irelevantní informace, může být přijatelný pro zábavu, ale nikoliv tam, kde rozhoduje o životech a majetku. Kontextové inženýrství zajišťuje, že informace proudící systémem jsou nejen hojné, ale i skutečně relevantní, správně organizované a optimalizované pro konkrétní úlohu.

Jednou z nejtrvalejších výzev ve vývoji AI je to, co veteráni oboru nazývají „mezera mezi demem a produkcí“. Sestavit prototyp, který demonstruje schopnosti AI, je relativně jednoduché. Vývojář může rychle propojit jazykový model s jednoduchým retrieval systémem a vytvořit něco, co v kontrolovaném prostředí vypadá působivě. Jakmile však má systém zvládat reálná data ve velkém měřítku, udržet spolehlivost a přizpůsobit se měnícím se požadavkům, vše se dramaticky komplikuje. Tuto mezeru tradičně přemosťovala právě ona „alchymie“ – záhadná směs ladění konfigurací, úpravy parametrů a empirického pokusu-omylu, která nějakým způsobem vede k funkčnímu systému. Problém tohoto přístupu je, že není replikovatelný, škálovatelný ani udržitelný. Když se v produkci něco rozbije, často není jasné proč a oprava opět vyžaduje stejný záhadný postup.

Kořen tohoto problému spočívá v tom, že většina AI infrastruktury nebyla navržena s ohledem na produkční systémy. První vektorové databáze a retrieval systémy byly tvořeny hlavně za účelem demonstrovat proveditelnost sémantického vyhledávání a vyhledávání pomocí embeddingů. Fungovaly dobře v kontrolovaných prostředích s malými datovými sadami a předvídatelnými dotazy. Při škálování na miliony dokumentů, tisíce souběžných uživatelů a nepředvídatelné dotazy však často selhávají. Objevují se problémy s konzistencí dat, klesá výkon dotazů, systém je obtížné ladit a monitorovat. Vývojáři se tak ocitají v situaci, kdy nespravují inženýrsky navržený systém, ale komplexní, křehký artefakt, který funguje jen díky štěstí a neustálému zásahu. Právě zde přichází ke slovu moderní kontextové inženýrství a specializovaná infrastruktura. Pokud k přechodu od dema k produkci přistoupíme jako k legitimnímu inženýrskému úkolu a vybudujeme systémy navržené pro produkční zátěž, proměníme tuto záhadnou alchymii ve skutečnou inženýrskou praxi.

Tradiční vyhledávací infrastruktura, která pohání Google a další vyhledávače, byla navržena s konkrétními předpoklady o využívání vyhledávání. Systémy byly stavěny pro dotazy na klíčová slova od lidských uživatelů, kteří sami vybírají, na který odkaz kliknout. Infrastruktura byla optimalizovaná pro tento scénář: rychlé párování klíčových slov, algoritmy řazení podle lidského vnímání relevance a prezentace výsledků ve formě „deseti modrých odkazů“, které člověk snadno přečte a vyhodnotí. AI systémy však mají zásadně jiné požadavky. Když jazykový model konzumuje výsledky vyhledávání, nedívá se na deset odkazů – dokáže zpracovat řádově více informací. Model nevyžaduje výsledky formátované pro člověka, potřebuje strukturovaná data, nad kterými může rozumově pracovat. Dotazy nejsou na klíčová slova, ale sémantické, založené na embeddingu a vektorové podobnosti. Tyto rozdíly znamenají, že tradiční vyhledávače nejsou pro AI aplikace vhodné.

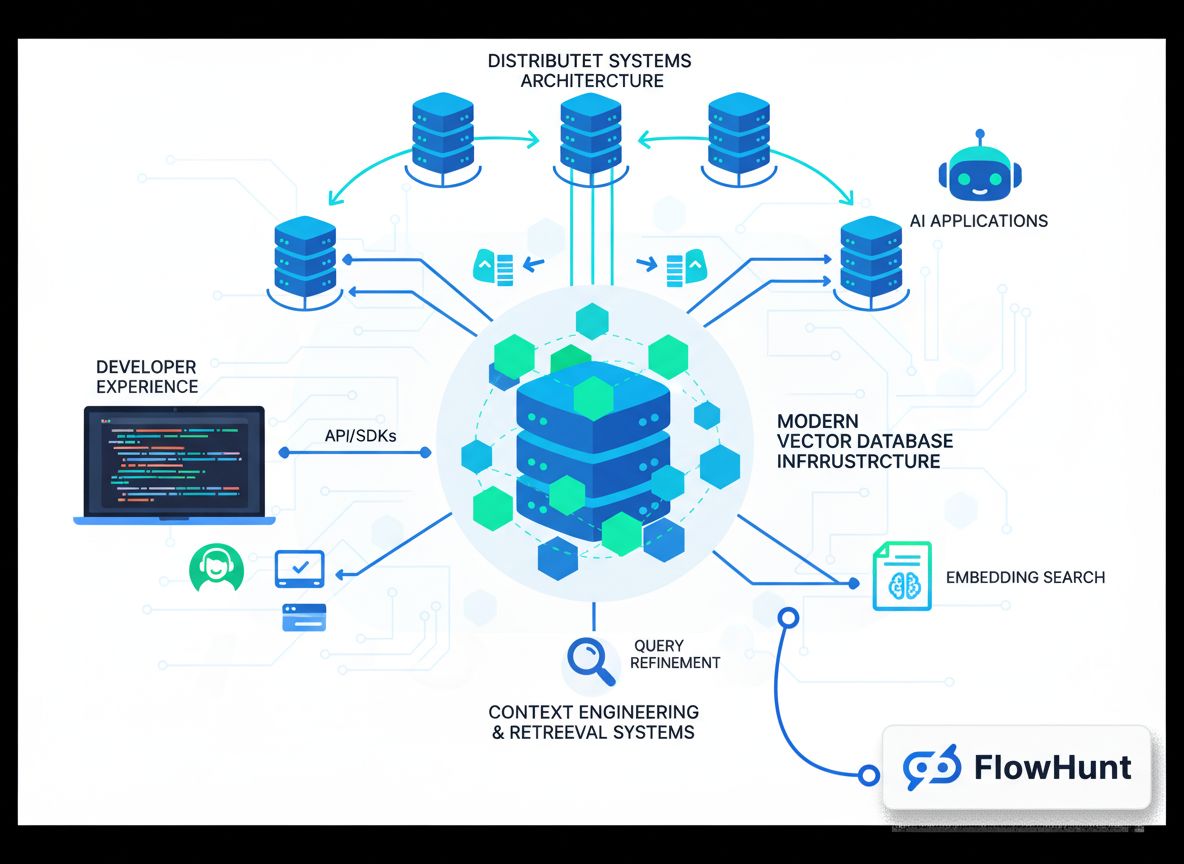

Moderní vyhledávací infrastruktura pro AI tyto rozdíly řeší několika klíčovými způsoby. Zaprvé, použité nástroje a technologie jsou zásadně jiné – místo indexů klíčových slov a algoritmů pro lidskou relevanci využívají vektorové embeddingy a sémantickou podobnost. Místo explicitních klíčových slov rozumějí významu a záměru dotazu. Zadruhé, vzory zátěže jsou jiné. Tradiční vyhledávače řeší jednoduché dotazy s malým počtem výsledků. AI systémy často potřebují získat velké množství dokumentů a složitě je zpracovat. Zatřetí, vývojáři těchto systémů mají jiné potřeby – potřebují jednoduchou integraci, dobrou uživatelskou zkušenost a nechtějí být experty na search infrastrukturu. A konečně, konzumenty výsledků jsou stroje – jazykové modely, které zvládnou zpracovat mnohem více informací než člověk. Tento posun mění vše na úrovni návrhu infrastruktury.

Jak organizace stále více uznávají důležitost kontextového inženýrství a moderní vyhledávací infrastruktury, stává se výzvou integrace těchto schopností do stávajících workflow a vývojových procesů. Zde přichází na řadu platformy jako FlowHunt, které poskytují jednotné prostředí pro tvorbu, testování a nasazení AI aplikací závislých na pokročilé správě a retrievalu kontextu. FlowHunt chápe, že kontextové inženýrství není jen o databázi, ale o správných nástrojích a workflow napříč celým AI vývojovým cyklem. Od ingestu dat a indexace, přes retrieval a řazení, až po inference modelu a generování výstupů – každý krok musí být pečlivě orchestrální a monitorován. FlowHunt nabízí automatizaci, která tuto orchestraci zjednodušuje, takže se vývojáři mohou soustředit na samotné AI aplikace místo infrastruktury.

Přístup platformy k automatizaci kontextového inženýrství je cenný zejména pro týmy, které staví více AI aplikací nebo potřebují spravovat komplexní, vícestupňové retrieval pipeline. Namísto tvorby vlastní infrastruktury pro každou aplikaci mohou využít předpřipravené komponenty a workflow FlowHunt pro zrychlení vývoje. Platforma řeší rutinní činnosti jako ingest dat, generování embeddingů, správu indexů i orchestraci retrievalu, čímž vývojářům uvolňuje ruce pro unikátní logiku aplikací. Navíc FlowHunt poskytuje monitoring a vizualizaci průchodu kontextu systémem, identifikaci úzkých míst a optimalizaci výkonu. Kombinace automatizace a viditelnosti mění kontextové inženýrství z alchymie v systematickou, měřitelnou disciplínu.

Postavit vektorovou databázi, která funguje v demu, je jedna věc; postavit takovou, která spolehlivě zvládá produkční zátěž, je věc druhá. Produkčně připravené vektorové databáze musí zvládnout více souběžných uživatelů, zajistit konzistenci dat, poskytovat spolehlivou persistenci a škálovat s rostoucím objemem dat. Musí být laditelné a monitorovatelné při potížích a udržovatelné při dalším vývoji. Tyto požadavky vedly k vývoji moderních architektur vektorových databází, které přebírají principy z distribuovaných systémů ověřených v praxi.

Jedním z nejdůležitějších principů je oddělení úložiště a výpočetního výkonu. V tradičních monolitických databázích jsou storage i compute úzce spojeny – stejný server ukládá data a zpracovává dotazy. Toto spojení je při škálování problematické: když potřebujete více výpočetního výkonu, musíte přidat i storage a naopak. To vede k neefektivnímu využití zdrojů a vyšším nákladům. Oddělením úložiště a výpočtů mohou moderní vektorové databáze škálovat každou část samostatně. Úložiště lze spravovat přes levné objektové storage (např. Amazon S3), výpočetní zdroje škálovat dle zátěže. Dalším klíčovým principem je multi-tenancy, kdy jediná instance databáze bezpečně obslouží více aplikací nebo týmů. Je třeba důsledně zajistit izolaci, ale pokud je implementace správná, výrazně to šetří zdroje a zjednodušuje provoz.

Moderní vektorové databáze přejímají i další principy z distribuovaných systémů poslední dekády – oddělení čtení a zápisu, asynchronní replikaci pro trvanlivost dat i při vysokém write výkonu a distribuované konsensuální mechanismy pro konzistenci mezi uzly. V kombinaci s moderními jazyky jako Rust, které nabízí výkon i bezpečnost, dosahují požadované spolehlivosti a výkonu pro produkci. Výsledkem je infrastruktura, která už není alchymií, ale poctivým inženýrstvím.

Když byla Chroma založena, tým měl jasnou tezi: mezera mezi demem a produkcí připomíná spíš alchymii než inženýrství, a je třeba ji překlenout. Tým se zaměřil na zkušenost vývojářů. Místo maximalizace funkcí či škálovatelnosti od začátku kladli důraz na maximální jednoduchost startu – například možnost instalace jediným příkazem pip a okamžitého použití bez složité konfigurace. Tato jednoduchost byla ve světě vektorových databází revoluční; většina databází vyžaduje dlouhé nastavování, než vůbec spustíte základní dotaz. Chroma tuto bariéru odstranila a umožnila vývojářům experimentovat s vektorovými databázemi během minut, ne hodin či dnů.

Závazek ke kvalitnímu vývojářskému zážitku šel i za hranici prvotního nastavení. Tým Chromy investoval značné úsilí, aby systém fungoval spolehlivě na různých architekturách a v rozličných provozních prostředích. Uživatelé Chromu rozchodili i na Arduinu nebo PowerPC, a místo aby tyto případy zamítli, tým udělal maximum pro jejich podporu. Tato univerzální spolehlivost a kompatibilita si získala důvěru komunity a přispěla k rychlému rozšíření Chromy. Vývojáři vědí, že zkušenost není jen o jednoduchosti, ale i o spolehlivosti a předvídatelnosti napříč prostředími.

Jak Chroma rostla a tým vyvíjel Chroma Cloud, stáli před zásadní volbou. Mohli rychle vydat hostovanou verzi single-node produktu a těžit z poptávky po managed službě, jako mnoho jiných firem. Chroma se však rozhodla jinak. Uvědomili si, že hostovaná single-node verze nesplní jejich nároky na zkušenost vývojářů. Skvělý cloud produkt musí být od základu navržen jako cloud-native: stejně jednoduchý a spolehlivý jako single-node, ale s potřebnou škálovatelností a spolehlivostí pro produkci. Tato volba znamenala delší vývoj, ale výsledkem je produkt, který naplňuje vizi – kontextové inženýrství jako opravdové inženýrství, ne alchymie.

Je důležité si uvědomit, že „AI“ má v kontextu moderní vyhledávací infrastruktury různé významy. Existují čtyři základní rozměry, ve kterých se tato infrastruktura liší od tradičních search systémů – a jejich pochopení je klíčové pro efektivní AI aplikace. Prvním rozměrem je technologie – místo inverzních indexů a párování klíčových slov používají moderní systémy vektorové embeddingy a sémantickou podobnost, místo TF-IDF rankingů používají neuronové sítě a naučené funkce řazení. Tyto rozdíly odrážejí jinou povahu řešených úloh i schopností AI.

Druhým rozměrem jsou vzory zátěže. Tradiční search systémy zvládají jednoduché, bezstavové dotazy s malým počtem výsledků. Moderní AI systémy potřebují zvládat komplexní, vícestupňové retrieval pipeline s řazením, filtrováním a re-rankingem na více úrovních – často s tisíci dokumenty. To klade jiné požadavky na infrastrukturu. Třetím rozměrem je vývojář. Tradiční search systémy tvořili specialisté na IR a search, moderní AI vývojáři jsou často generalisté, kteří potřebují výkonné retrieval schopnosti bez hlubokých znalostí search infrastruktury – proto je důležitá použitelnost.

Čtvrtým a nejdůležitějším rozměrem je konzument výsledků. V tradičním search je to člověk – zvládne prohlédnout pár odkazů a rozhodnout, co je relevantní. V moderním AI systému je konzumentem jazykový model, který zvládne stovky až tisíce dokumentů. Tato změna znamená, že řazení lze optimalizovat pro stroj, prezentaci výsledků pro strojové zpracování a celý pipeline navrhovat s vědomím, že finální rozhodnutí dělá AI.

Rok 2023 byl pro trh vektorových databází extrémně rušný – firmy získávaly obrovské investice, předháněly se v množství funkcí a snažily se být vším pro všechny. Chroma se rozhodla jít jinou cestou: udržet fokus na jádru vize, stavět retrieval engine pro AI aplikace s výjimečnou zkušeností vývojářů a opravdu překlenout mezeru mezi demem a produkcí. To vyžadovalo disciplínu a přesvědčení, zvlášť když ostatní firmy ohlašovaly větší investice a rychlejší růst.

Klíčem k udržení této vize byla jasná a nekonvenční teze o tom, na čem záleží. Tým Chromy věřil, že rozhodující není počet funkcí nebo výše investic, ale kvalita vývojářské zkušenosti a spolehlivost systému. Věřili, že když zvládnou jednu věc na světové úrovni (retrieval engine), získají právo dělat další věci později. Toto zaměření na jednu klíčovou kompetenci je v dnešním startupovém světě vzácné. Tým Chromy se této filozofie držel, i když to znamenalo delší uvedení Chroma Cloud na trh a možné ztráty krátkodobých příležitostí.

Udržení vize vyžaduje i pečlivý hiring a budování týmu. Najatí lidé formují kulturu a kultura určuje, co a jak firma staví. Chroma najímala pomalu a velmi selektivně – raději menší tým s naprostým souladem s vizí, důrazem na kvalitu a samostatnost. Tým tak rostl pomaleji, ale každý člen byl skutečně oddán misi a dokázal ji významně posouvat. Tato kulturní soudržnost je ve startupech těžko dosažitelná, ale pro dlouhodobou vizi nezbytná.

Jedním z nejvýraznějších aspektů přístupu Chromy je důraz na řemeslo a kvalitu. V infrastruktuře je snadné podlehnout iluzi, že víc funkcí, výkonu nebo škálování je vždy lepší. Chroma však pochopila, že zásadní je spolehlivost, použitelnost a skutečné řešení problémů vývojářů. Tento důraz je vidět v rozhodnutí psát Chroma v Rustu kvůli výkonu a bezpečnosti, v závazku podporovat různé architektury i v rozhodnutí věnovat více času kvalitnímu vývoji cloud produktu místo rychlého uvedení na trh.

Důraz na kvalitu se projevuje i v přístupu k problému samotnému. Kontextové inženýrství není jen technický problém pro chytré algoritmy, ale širší výzva zahrnující zkušenost vývojářů, spolehlivost, škálování a udržitelnost. Holistický pohled vede k lepším řešením, protože systém je jen tak silný, jak jeho nejslabší článek. I ten nejsofistikovanější retrieval algoritmus je k ničemu, pokud je systém složitý k použití nebo nespolehlivý v produkci. Důsledné zaměření na kvalitu ve všech oblastech umožnilo Chromě skutečně překlenout mezeru mezi demem a produkcí.

Pro týmy vyvíjející AI aplikace má přístup Chromy několik praktických dopadů. Zaprvé je nutné si uvědomit, že kontextové inženýrství není vedlejší úkol – je to jádro úspěchu. Kvalita AI systému je zásadně dána kvalitou kontextu, který dostane, takže investice do správné infrastruktury není volitelná. Zadruhé je dobré být skeptický k systémům, které slibují vše – nejspolehlivější jsou často ty, které dělají jednu věc opravdu dobře. Pokud vybíráte vektorovou databázi nebo retrieval systém, hledejte jasný fokus a závazek ke špičkové kvalitě v jednom jádru.

Zatřetí, zkušenost vývojáře je klíčová. Systém, který je teoreticky silnější, ale špatně se používá, přinese méně hodnoty než systém o něco slabší, ale snadno použitelný – protože vývojáři skutečně pracují s tím, co jim šetří čas. Začtvrté, spolehlivost a konzistence jsou důležitější, než se zdá. V počátcích vývoje je lákavé upřednostnit funkce a výkon, ale s přechodem do produkce je spolehlivost zásadní. Systém s 95% spolehlivostí znamená při milionech dotazů stovky tisíc selhání – investujte do spolehlivosti hned. Nakonec je důležité myslet na dlouhodobou trajektorii: infrastruktura, kterou zvolíte dnes, určuje, co zvládnete stavět zítra. Zvolte technologii navrženou pro produkci, která škáluje a umožňuje monitoring a dohled – vyplatí se to.

{{ cta-dark-panel heading=“Turbo pro váš workflow s FlowHunt” description=“Vyzkoušejte, jak FlowHunt automatizuje vaše AI a SEO workflow — od výzkumu a generování obsahu až po publikování a analytiku — vše na jednom místě.” ctaPrimaryText=“Objednat demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Vyzkoušejte FlowHunt zdarma” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Jedním z nejdůležitějších rozhodnutí Chromy bylo open-source jádra produktu. Toto rozhodnutí mělo několik důsledků. Zaprvé, budovalo důvěru vývojářské komunity – když mohou vidět kód, pochopit fungování systému a přispívat vylepšeními, roste důvěra a adopce. Open source také vytváří pozitivní cyklus: příspěvky komunity vylepšují produkt, tím přitahují další uživatele, což vede k dalším příspěvkům. Zadruhé, open sourcing vytvořil kolem Chromy silnou komunitu – uživatelé jsou investovaní do úspěchu produktu, přispívají, dávají zpětnou vazbu i doporučují dále. Tato komunita je cenným aktivem, které konkurence těžko replikuje.

Třetím aspektem je přirozená cesta k monetizaci pomocí hostovaných služeb. Díky open source jádru si vývojáři mohou Chromu provozovat sami zdarma, ale mnoho z nich upřednostní managed verzi, která řeší provoz, škálování a údržbu – což je právě model Chroma Cloud. Nabídnout špičkový hosted zážitek a přitom nechat jádro open source je udržitelnější a více v souladu s preferencemi vývojářů než uzavřený proprietární přístup.

Při hodnocení úspěchu infrastruktury jako Chroma je důležité zaměřit se na metriky, které odrážejí skutečnou hodnotu. Chroma dosáhla impozantních čísel: přes 21 000 hvězdiček na GitHubu, přes 5 milionů měsíčních stažení a celkem 60–70 milionů stažení. Tyto údaje ukazují široké přijetí projektem vývojářů. Ještě důležitější je ale to, zda produkt řeší problémy, které vývojáři mají – usnadňuje stavbu AI aplikací, zkracuje cestu od dema do produkce a umožňuje stavět spolehlivější systémy? Podle zpětné vazby a rychlého rozšíření komunity je odpověď ano.

Další klíčovou metrikou je kvalita komunity a charakter příspěvků. Chroma přitáhla vývojáře napříč průmyslem, včetně integrací s populárními frameworky jako LangChain a Llama Index. Široká adopce a integrace s ekosystémem svědčí o tom, že Chroma řeší reálné problémy a přináší skutečnou hodnotu. To, že je Chroma ve frameworkách často defaultní volbou pro vektorové databáze, je důkazem kvality produktu i síly komunity. Tyto kvalitativní metriky – adopce, integrace, pozitivní zpětná vazba – jsou často důležitější než samotná čísla stažení.

Jak budou AI systémy sofistikovanější a rozšířenější, bude důležitost kontextového inženýrství jen růst. Systémy, které dnes stavíme, jsou jen začátek. Do budoucna lze čekat ještě propracovanější přístupy ke správě kontextu – systémy, které dynamicky upravují kontext podle úlohy, učí se z feedbacku, či zvládnou více modalit dat (text, obrázky, zvuk, video) bez problémů. Infrastruktura pro podporu těchto pokročilých systémů bude muset být ještě vyspělejší, ale základní principy zůstanou: důraz na zkušenost vývojářů, závazek ke kvalitě a spolehlivosti a jasná vize.

Role platforem jako FlowHunt bude stále důležitější. Jak se kontextové inženýrství stává jádrem AI vývoje, budou týmy potřebovat nástroje pro snadnou stavbu, testování i nasazení pokročilých pipeline pro správu kontextu. Přístup FlowHunt, který nabízí automatizaci a monitoring napříč celým AI cyklem, je dobře připraven tuto potřebu pokrýt. Abstrakcí složitosti infrastruktury a poskytováním vysoce úrovňových nástrojů pro AI aplikace umožňuje FlowHunt vývojářům soustředit se na vlastní řešení, nikoli na infrastrukturu.

Kontextové inženýrství představuje zásadní posun v přístupu ke stavbě AI systémů – od pokusů a alchymie k systematické, inženýrské disciplíně. Moderní vektorové databáze jako Chroma, založené na principu oddělení storage a compute, multi-tenancy a distribuované architektuře, tvoří základ pro tento posun. Kombinace těchto infrastrukturních inovací se zaměřením na zkušenost vývojáře, spolehlivost a řemeslo umožňuje stavět AI systémy, které skutečně fungují v produkci a škálují s rostoucími požadavky. Postřehy z přístupu Chromy – důsledné držení vize, hiring podle kultury, důraz na kvalitu před funkcemi a budování komunity skrze open source – jsou návodem pro další infrastrukturní projekty i AI týmy. Jak bude AI dále zrát, bude správně zvládnuté kontextové inženýrství ještě důležitější

Kontextové inženýrství představuje evoluci nad rámec tradičního Retrieval-Augmented Generation (RAG). Zatímco RAG se zaměřuje na vyhledávání relevantních dokumentů pro rozšíření promptu, kontextové inženýrství zahrnuje celý proces správy, organizace a optimalizace kontextových informací, které AI systémy využívají pro rozhodování. Jde o komplexnější přístup, který zohledňuje tok kontextu napříč celým AI řetězcem – od ingestu dat až po inference modelu.

Oddělení úložiště a výpočetního výkonu umožňuje vektorovým databázím škálovat se nezávisle. Úložiště může být spravováno pomocí cenově efektivních objektových storage řešení, zatímco výpočetní zdroje lze škálovat podle aktuální poptávky po dotazech. Tato architektura umožňuje lepší využití zdrojů, snižuje náklady a poskytuje flexibilitu v možnostech nasazení – ať už on-premise, v cloudu nebo v hybridním prostředí.

Chroma dosahuje produkční spolehlivosti díky několika mechanismům: je napsaná v jazyce Rust pro výkon a bezpečnost, implementuje multi-tenancy pro izolaci, využívá objektové úložiště pro perzistentní datovou vrstvu a řídí se principy moderních distribuovaných systémů. Platforma prošla rozsáhlým vývojem, aby rozdíl mezi demem a produkčním systémem připomínal inženýrství, nikoli alchymii.

Moderní vyhledávací infrastruktura pro AI se liší ve čtyřech klíčových bodech: používané nástroje a technologie jsou optimalizované pro AI workloady, vzory zátěže jsou jiné (práce s embeddingy a sémantickým vyhledáváním), vývojáři těchto systémů mají odlišné potřeby a očekávání a konzumenty výsledků vyhledávání jsou jazykové modely místo lidí, což umožňuje zpracovat řádově více výsledků.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

Automatizujte celý svůj AI obsahový řetězec pomocí inteligentního kontextového inženýrství a retrieval systémů navržených pro produkci.

Zjistěte, jak inženýrství kontextu optimalizuje výkon AI agentů strategickým řízením tokenů, eliminací nadbytečného kontextu a zaváděním pokročilých technik jak...

Naučte se, jak navrhovat kontext pro AI agenty správou zpětné vazby nástrojů, optimalizací využití tokenů a implementací strategií jako offloading, komprese a i...

Komplexní průvodce kontextovým inženýrstvím, další metou v návrhu AI systémů. Naučte se základní strategie, pochopte problém 'kontextového rozkladu' a objevte o...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.