Hugging Face Transformers

Hugging Face Transformers je přední open-source Python knihovna, která usnadňuje implementaci Transformer modelů pro strojové učení v oblasti NLP, počítačového ...

Komplexní průvodce moderními strategiemi pretrénování jazykových modelů, technikami kurace dat a optimalizačními metodami používanými v HuggingFace pro tvorbu efektivních a výkonných open-source modelů.

Vývoj jazykových modelů v posledních letech prošel zásadní změnou. Zatímco velké technologické společnosti stále posouvají hranice velikosti modelů, open-source komunita zjistila, že špičkového výkonu lze dosáhnout i bez modelů s triliony parametrů. Tento komplexní průvodce zkoumá nejmodernější techniky a strategie používané výzkumníky HuggingFace pro tvorbu efektivních a výkonných jazykových modelů pomocí důsledných metod pretrénování. Podíváme se, jak SmolLM 3, FineWeb a FinePDF představují nový přístup k vývoji modelů — zaměřený na maximalizaci výkonu v rámci praktických výpočetních omezení při zachování vědecké přísnosti a reprodukovatelnosti. Sdílené poznatky zde jsou výsledkem měsíců výzkumu a experimentování a nabízejí masterclass o tom, jak přistupovat k pretrénování modelů v moderní éře.

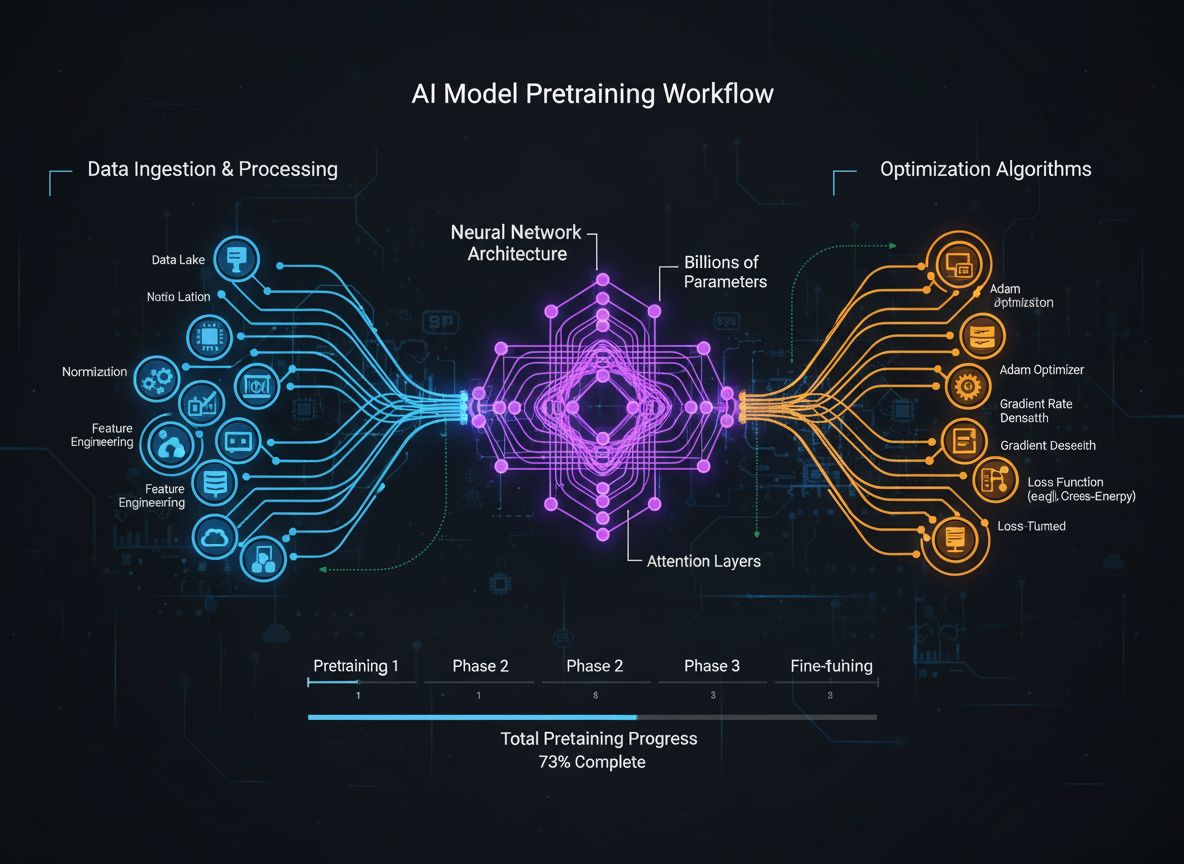

Pretrénování jazykových modelů se vyvinulo z poměrně přímočarého procesu krmení surových textových dat do neuronových sítí do sofistikované disciplíny zahrnující několik propojených optimalizačních cílů. Základem pretrénování je vystavení modelu obrovskému množství textových dat, díky čemuž se učí statistické vzory v jazyce pomocí samořízeného učení. Moderní přístup však uznává, že samotné škálování dat a výpočetního výkonu nestačí. Výzkumníci musí pečlivě sladit více dimenzí trénovacího procesu – od výběru a kurace dat po architektonické volby a optimalizační algoritmy. Oblast dospěla natolik, že pochopení těchto nuancí odděluje špičkové modely od průměrných. Tento vývoj odráží hlubší pochopení, že výkon modelu neurčuje jediný faktor, ale pečlivá koordinace několika, částečně ortogonálních cílů, které lze optimalizovat paralelně. Výzkumná komunita si čím dál více uvědomuje, že „tajná ingredience“ úspěšného vývoje modelu neleží v hrubé síle škálování, ale v inteligentních rozhodnutích v každé vrstvě trénovací pipeline.

Jedním z nejdůležitějších poznatků posledních výzkumů je, že kvalita a rozmanitost trénovacích dat zásadně určují výkon modelu více než pouhé množství dat. Tento princip, často shrnovaný jako „odpad dovnitř, odpad ven“, je stále více potvrzován empirickým výzkumem i praxí. Pokud jsou modely trénovány na špatně kurátovaných, duplicitních nebo nekvalitních datech, učí se nesprávné vzorce a nedokážou dobře zobecnit na nové úlohy. Naopak pečlivě vybrané, deduplikované a filtrované datasety umožňují modelům učit se efektivněji a dosahovat lepších výsledků s menším počtem trénovacích kroků. Důsledky tohoto poznatku jsou zásadní: znamená to, že organizace i výzkumníci by měli investovat hlavně do kurace dat a zajištění jejich kvality, místo aby pouze hromadili další surová data. Tento posun vedl ke vzniku specializovaných týmů a nástrojů zaměřených jen na tvorbu a zdokonalování datasetů. Dataset FineWeb, který obsahuje přes 18,5 bilionu tokenů očištěných a deduplikovaných anglických webových dat, je příkladem tohoto přístupu. Místo použití surových dat CommonCrawl tým FineWeb implementoval sofistikované techniky filtrování, deduplikace a hodnocení kvality, aby vytvořil dataset, který soustavně překonává větší, neopracované alternativy. To představuje zásadní poznání v oboru: cesta k lepším modelům vede přes lepší data, nikoli nutně přes větší množství dat.

Moderní pretrénování modelů lze pochopit skrze pět vzájemně propojených, ale částečně ortogonálních cílů, které musí výzkumníci optimalizovat současně. Pochopení těchto pilířů poskytuje rámec pro promyšlení celého trénovacího procesu a identifikaci oblastí pro zlepšení. První pilíř spočívá v maximalizaci relevance a kvality surových informací v trénovacích datech. Zahrnuje jak kvalitu jednotlivých datových bodů, tak rozmanitost datasetu jako celku. Model natrénovaný na kvalitních, různorodých datech se naučí zobecnit více než model trénovaný na úzkých či nekvalitních datech, bez ohledu na další optimalizace. Druhý pilíř se zaměřuje na návrh architektury modelu, která určuje, jak efektivně model zpracovává informace a v jakých výpočetních omezeních funguje. Volby architektury ovlivňují rychlost inferencí, spotřebu paměti, požadavky na KV cache i to, na jakém hardwaru lze model provozovat. Třetí pilíř zahrnuje maximalizaci informací vytěžených z trénovacích dat v každém kroku. Patří sem techniky jako destilace znalostí, kdy se menší model učí od většího, a predikce více tokenů, kdy model předpovídá více budoucích tokenů najednou. Čtvrtý pilíř se týká kvality gradientů a dynamiky optimalizace, včetně volby optimalizátoru, plánů učení a technik pro udržení stability trénování. Pátý pilíř zahrnuje ladění hyperparametrů a strategie škálování, které zajišťují stabilní trénování při zvětšování modelů a předcházejí problémům jako exploze gradientu nebo divergence aktivací. Tyto pilíře nejsou nezávislé – vzájemně se ovlivňují – ale jejich oddělené promýšlení pomáhá výzkumníkům určit, kde je třeba zasáhnout a kde lze dosáhnout největších zlepšení.

FineWeb představuje přelom v tvorbě datasetů pro pretrénování jazykových modelů. Místo přijímání surového výstupu webových crawlerů typu CommonCrawl tým HuggingFace implementoval komplexní pipeline pro čištění, filtrování a deduplikaci webových dat ve velkém měřítku. Výsledný dataset obsahuje přes 18,5 bilionu tokenů kvalitního anglického textu a je jedním z největších kurátorovaných datasetů dostupných open-source komunitě. Vytvoření FineWeb zahrnovalo několik fází zpracování, z nichž každá byla navržena k odstranění nekvalitního obsahu při zachování hodnotných informací. Tým použil sofistikované deduplikační algoritmy k odstranění redundantního obsahu, filtry kvality k odstranění spamu a nekvalitních stránek a detekci jazyka k zajištění převážně anglického obsahu. Hodnota FineWeb nespočívá jen v jeho velikosti, ale především v empirickém potvrzení, že poskytuje lepší výkon modelů než větší, neopracované alternativy. Při smíchání s jinými datasety FineWeb soustavně překonává mnohem větší surové datasety, což dokazuje, že kvalita skutečně vítězí nad kvantitou. Výkonnostní křivky ukazují, že modely trénované na FineWeb dosahují lepších výsledků v běžných benchmarcích než modely trénované na podobně velkých datasetech jiného původu. Tento úspěch inspiroval širší výzkumnou komunitu k větším investicím do kurace dat, protože právě zde lze dosáhnout výrazných zlepšení výkonu. Dataset FineWeb je volně dostupný výzkumníkům a demokratizuje přístup ke kvalitním trénovacím datům, což umožňuje menším organizacím a akademickým týmům trénovat konkurenceschopné modely.

Zatímco FineWeb se zaměřil na webová data, tým HuggingFace si uvědomil, že další obrovský zdroj kvalitního textu byl z velké části opomíjen: PDF dokumenty. PDF obsahují obrovské množství strukturovaných, hodnotných informací včetně vědeckých článků, technické dokumentace, knih i odborných zpráv. Extrakce textu z PDF je však technicky náročná a předchozí přístupy tuto datovou oblast ve velkém systematicky neprozkoumaly. FinePDF představuje první komplexní snahu extrahovat, čistit a kurátorovat PDF data pro pretrénování jazykových modelů. Tým implementoval sofistikovanou pipeline řešící jedinečné výzvy zpracování PDF, včetně práce s komplexními rozvrženími, přesné extrakce textu z vícesloupcových dokumentů a zpracování vložených obrázků a tabulek. Inovativní součástí pipeline FinePDF je krok „opětovného stažení z internetu“, který řeší zásadní problém: PDF uložené v CommonCrawl jsou často špatně extrahované nebo zastaralé. Opětovné stažení PDF z jejich původních zdrojů na internetu zajišťuje přístup k nejkvalitnějším verzím dokumentů. Výsledky jsou působivé — při smíchání s jinými datasety FinePDF vykazuje velmi silný výkon oproti nedávným baseline modelům jako NeoTron B2. Dataset představuje nový zdroj kvalitních trénovacích dat, která doplňují webová data a umožňují modelům učit se z různorodějších, strukturovaných informací. Tato práce otevírá nové možnosti pro tvorbu datasetů a naznačuje, že i další dosud opomíjené datové zdroje mohou přinést podobné výhody. Pipeline FinePDF je detailně dokumentována v blogpostech a technické dokumentaci, takže na ni mohou navazovat i další výzkumníci a aplikovat podobné techniky na jiné datové oblasti.

SmolLM 3 představuje vyvrcholení aplikace těchto technik kurace dat a optimalizace trénování při tvorbě mimořádně efektivního jazykového modelu. S 3 miliardami parametrů je SmolLM 3 výrazně menší než mnoho současných modelů, přesto díky pečlivé optimalizaci napříč všemi pěti pilíři trénování dosahuje konkurenceschopného výkonu. Model podporuje dvourežimové uvažování, vícejazyčné schopnosti v šesti jazycích a pochopení dlouhého kontextu, což z něj činí mimořádně univerzální model navzdory skromné velikosti. Vývoj SmolLM 3 zahrnoval pečlivé architektonické volby zaměřené na maximalizaci efektivity. Tým zvolil transformerovou architekturu, která balancuje výpočetní efektivitu s modelovací kapacitou, a aplikoval techniky jako grouped query attention pro snížení spotřeby paměti a latence inferencí. Model byl trénován ve třech fázích pretrénování, které progresivně zvyšují výkon v různých doménách a umožňují optimalizaci specifických schopností v každé fázi. Význam SmolLM 3 spočívá především v tom, že dokazuje, že open-source komunita dnes dokáže produkovat modely, které v mnoha úlohách konkurují mnohem větším proprietárním modelům. To zpochybňuje představu, že větší je vždy lepší, a naznačuje, že přínosy pouhého škálování velikosti modelů mohou být již vyčerpány. Pozornost se přesouvá k efektivitě, interpretovatelnosti a praktickým možnostem nasazení. SmolLM 3 lze provozovat na běžném hardwaru, edge zařízeních i v prostředích s omezenými zdroji, což zpřístupňuje pokročilé AI schopnosti mnohem širšímu publiku. Vícejazyčné a dlouhokontextové schopnosti modelu ukazují, že efektivita nemusí znamenat kompromis v důležitých funkcích.

Destilace znalostí je silná technika, která umožňuje menším modelům těžit ze znalostí, které získaly větší modely. Místo trénování malého modelu od začátku na surových datech spočívá destilace znalostí v trénování malého modelu tak, aby napodobil výstupy většího a schopnějšího modelu. Tento přístup je obzvlášť cenný při pretrénování, protože umožňuje menšímu modelu naučit se vzorce, které již větší model objevil, což urychluje učení a zlepšuje výsledky. Princip destilace spočívá v tom, že studentský model (menší) je trénován tak, aby kopíroval pravděpodobnostní rozdělení vytvářená tzv. učitelským modelem (větším). To se obvykle provádí minimalizací divergence mezi výstupním rozdělením studenta a učitele, často pomocí technik jako KL-divergence. Parametr teploty určuje, jak jsou rozdělení „hladká“ – vyšší teplota rozostřuje rozdělení a poskytuje více informací o relativní jistotě různých predikcí. Destilace znalostí je mimořádně efektivní právě při pretrénování jazykových modelů, protože umožňuje přenést znalosti z velkých modelů do menších, efektivnějších modelů. To je zvlášť cenné pro organizace, které chtějí nasazovat modely na edge zařízeních nebo v prostředích s omezenými zdroji, ale chtějí využít schopností větších modelů. Technika se stále zdokonaluje, například díky metodám jako attention transfer (student se učí i vzory pozornosti učitelského modelu) nebo feature-based distillation (slaďování mezivrstvových reprezentací).

Tradiční trénování jazykových modelů se zaměřuje na predikci dalšího tokenu – model se učí předpovídat následující token na základě předchozích. Nedávný výzkum však ukázal, že trénování modelů na predikci více budoucích tokenů současně může výrazně zlepšit výkon, zejména v programovacích a složitých logických úlohách. Predikce více tokenů nutí model naučit se delší závislosti a hlubší pochopení vzorců v datech. Přístup spočívá v přidání více predikčních hlav do modelu, z nichž každá předpovídá token několik pozic dopředu. Během trénování model dostává signály ztráty ze všech těchto hlav najednou, což jej motivuje učit se reprezentace užitečné pro predikci více kroků do budoucna. Je to náročnější než predikce pouze dalšího tokenu, ale vede k lepším naučeným reprezentacím. Výhody predikce více tokenů sahají za rámec lepšího výkonu na trénovacím cíli. Modely trénované tímto způsobem často lépe generalizují na nové úlohy, domény a vykazují lepší schopnosti logického uvažování. Technika je mimořádně efektivní pro generování kódu, kde je porozumění dlouhodobým závislostem zásadní pro syntakticky i sémanticky správný kód. Výzkum ukázal, že predikce více tokenů může zvýšit výkon modelu o 5–15 % na různých benchmarcích, a jedná se tak o jednu z nejúčinnějších trénovacích technik posledních let. Implementace je relativně jednoduchá, ale vyžaduje pečlivé ladění počtu hlaviček a vážení ztrát z různých hlav.

AdamW byl po léta výchozí volbou pro trénování velkých jazykových modelů. Kombinuje aktualizace gradientů s momentem a váhový útlum, čímž poskytuje stabilní trénování a dobré konvergenční vlastnosti. Nedávné výzkumy ale ukazují, že AdamW nemusí být optimální pro všechny scénáře, zejména při škálování na velmi velké modely. Nové optimalizátory jako Muon a King K2 zkoumají alternativní přístupy, jež mohou nabídnout lepší trénovací dynamiku i výsledný výkon. Klíčovou myšlenkou těchto optimalizátorů je lepší aproximace Hessovy matice – která zachycuje informace o zakřivení loss landscape – například Newton-Schulzovými metodami. Díky lepší aproximaci Hessovy matice mohou optimalizátory poskytovat informativnější aktualizace gradientů vedoucí k rychlejší konvergenci a lepším výsledkům. Muon například využívá Newton-Schulzovu iteraci k ortogonalizaci matice gradientů, což umožňuje rozprostření učení do více dimenzí než tradiční přístupy. Výsledkem je stabilnější trénování a motivace modelu prozkoumávat nové oblasti parametrického prostoru místo následování stále stejné trajektorie jako u AdamW. King K2 používá jiný přístup – sleduje například maximální logaritmus na hlavu a tuto informaci využívá pro adaptivní úpravu learning rate a gradient clippingu. Důsledky inovací v oblasti optimalizátorů jsou významné. Mnoho praktiků stále používá AdamW s hyperparametry optimalizovanými pro mnohem menší modely, i když trénují modely o několik řádů větší. To naznačuje, že pouhou aktualizací výběru optimalizátoru a hyperparametrů pro moderní modely lze získat významné zlepšení výkonu. Výzkumná komunita si stále více uvědomuje, že volba optimalizátoru není vyřešený problém a že inovace v této oblasti mohou výrazně zlepšit efektivitu i výsledky trénování.

Udržení kvalitních gradientů během trénování je zásadní pro dosažení dobrého výkonu modelu. S rostoucí velikostí modelů na miliardy či biliony parametrů je trénování stále nestabilnější a gradienty mají tendenci explodovat nebo mizet. Řešení těchto problémů vyžaduje pečlivou pozornost ke kvalitě gradientů a zavedení technik, které zajistí stabilitu trénování v celém průběhu. Jedním z přístupů ke zlepšení kvality gradientů je použití technik jako gradient clipping, které zabraňují příliš velkým gradientům a destabilizaci trénování. Naivní gradient clipping však může odstraňovat i užitečné informace. Sofistikovanější přístupy gradienty normalizují tak, aby zachovaly informace a zároveň zabránily nestabilitě. Dalším důležitým faktorem je volba aktivačních funkcí a normalizačních technik. Různé aktivační funkce mají odlišné vlastnosti, které ovlivňují tok gradientů, a jejich správný výběr výrazně ovlivňuje stabilitu trénování. Layer normalization, která normalizuje aktivace napříč feature dimenzí, se stala standardem v transformerových modelech, protože poskytuje lepší vlastnosti pro tok gradientů než batch normalization. Plán učení (learning rate schedule) je také klíčový pro kvalitu gradientů. Příliš vysoké learning rate mohou způsobit explozi gradientů, příliš nízké vedou k pomalé konvergenci nebo zaseknutí v lokálním minimu. Moderní trénování často využívá learning rate schedule s warm-up fází (postupné zvyšování learning rate pro stabilizaci počáteční fáze) a následným snižováním během trénování. Pochopení a optimalizace těchto aspektů je klíčová pro úspěšné trénování velkých modelů a stále je předmětem intenzivního výzkumu.

Složitost moderního pretrénování modelů – s jeho několika optimalizačními cíli, sofistikovanými datovými pipeliny a pečlivým laděním hyperparametrů – představuje velkou výzvu pro týmy, které chtějí tyto techniky implementovat. FlowHunt tyto výzvy řeší tím, že poskytuje platformu pro automatizaci a orchestraci komplexních workflow trénování modelů. Místo ručního řízení zpracování dat, trénování a vyhodnocování modelů mohou týmy pomocí FlowHunt definovat workflow, které tyto úkoly automaticky zajišťují, čímž se snižuje chybovost a zlepšuje reprodukovatelnost. Automatizační možnosti FlowHunt jsou zvlášť cenné pro kroky kurace a zpracování dat, které jsou pro výkon modelu klíčové. Platforma umožňuje automaticky implementovat sofistikované datové pipeline, jaké byly použity ve FineWeb nebo FinePDF, včetně deduplikace, filtrování kvality a konverze formátů. Týmy se tak mohou soustředit na rozhodování o tom, jaká data použít a jak je zpracovat, místo aby řešily detailní implementaci. FlowHunt navíc pomáhá týmům řídit ladění hyperparametrů a experimentování nezbytné pro optimalizaci trénování. Díky automatizaci spouštění více experimentů s různými hyperparametry a sběru výsledků mohou týmy efektivněji prozkoumat parametrický prostor a rychleji najít optimální konfigurace. Platforma také poskytuje nástroje pro sledování průběhu trénování, detekci problémů jako exploze gradientů či divergence a automatickou úpravu trénovacích parametrů pro udržení stability. Pro organizace budující vlastní jazykové modely nebo dolaďující existující modely může FlowHunt významně zkrátit čas i úsilí potřebné k dosažení kvalitních výsledků.

Jedním z nejnáročnějších aspektů trénování modelů je pochopení, jak škálovat od malých k velkým modelům při zachování stability a výkonu. Vztah mezi velikostí modelu a optimálními hyperparametry není přímočarý — parametry, které fungují pro malé modely, je často třeba upravit pro větší modely. To platí zejména pro learning rate, které je obvykle nutné při škálování modelu snižovat. Pochopení škálovacích zákonitostí je klíčové pro předpověď výkonu modelů při různých velikostech a pro rozhodování o alokaci zdrojů. Výzkum ukázal, že výkon modelu sleduje předvídatelné škálovací zákony, kdy se výkon zlepšuje podle mocninných funkcí velikosti modelu, datasetu a výpočetního rozpočtu. Tyto zákony umožňují výzkumníkům předpovědět, jaké zlepšení výkonu lze očekávat při zvětšení modelu či datasetu, a tím informovaně rozhodovat, kam investovat zdroje. Škálovací zákony ale nejsou univerzální — závisí na konkrétní architektuře, trénovacím postupu a datasetu. Týmy proto musí provádět vlastní škálovací experimenty, aby pochopily, jak jejich konkrétní nastavení škáluje. Proces škálování od malých k velkým modelům také znamená pečlivou pozornost ke stabilitě trénování. S růstem modelů roste náchylnost k nestabilitám jako exploze gradientů či divergence. Řešení těchto problémů zahrnuje gradient clipping, pečlivé plánování learning rate a případně i změny architektury nebo optimalizátoru. Výzkumná komunita si stále více uvědomuje, že škálování není jen o zvětšování modelů, ale o řízení celého trénovacího procesu tak, aby bylo možné větší modely efektivně trénovat.

Učení reprezentací (feature learning) je proces, při kterém se modely během trénování učí extrahovat užitečné rysy ze surových dat. V kontextu pretrénování jazykových modelů to znamená, že se model učí reprezentovat jazykové koncepty, sémantické vztahy i syntaktické vzory ve svých interních reprezentacích. Maximalizace učení reprezentací — tedy zajištění, že model při každém kroku vytěží z trénovacích dat maximum informací — je jedním z klíčových cílů moderního trénování modelů. Jedním ze způsobů, jak o učení reprezentací uvažovat, je sledovat, jak moc se vnitřní reprezentace modelu mění v reakci na gradientní aktualizace. Pokud se model efektivně učí, každá aktualizace gradientu vede k významným změnám reprezentací, které zlepšují schopnost modelu predikovat budoucí tokeny. Pokud se model neučí efektivně, mohou gradientní aktualizace vést jen k malým nebo irelevantním změnám. Techniky pro zlepšení učení reprezentací zahrnují pečlivou inicializaci vah modelu, která může významně ovlivnit rychlost učení užitečných rysů v počátečních fázích trénování. Důležitá je také volba plánování learning rate, které modelu umožní rychle se učit v raných fázích (kdy se učí základní rysy), a později zpomalit tempo učení při dolaďování jemnějších vzorů. Koncept učení reprezentací úzce souvisí s jevem „feature collapse“, kdy se model naučí ignorovat určité rysy nebo dimenze vstupu. K tomu dochází, pokud model najde jednoduchou zkratku, která mu umožní dosáhnout dobrého výkonu, aniž by se naučil všechny potřebné rysy. Techniky jako regularizace a pečlivý návrh loss funkce pomáhají předcházet kolapsu reprezentací a zajistit, že modely se učí různorodé a užitečné rysy.

{{ cta-dark-panel heading=“Zrychlete svůj workflow s FlowHunt” description=“Vyzkoušejte, jak FlowHunt automatizuje vaše AI a SEO workflow — od výzkumu a generování obsahu až po publikaci a analytiku — vše na jednom místě.” ctaPrimaryText=“Objednat demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Vyzkoušet FlowHunt zdarma” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Několik let v AI výzkumu převládal narativ, že větší modely jsou lepší. To vedlo ke „závodu ve zbrojení“ – kdo postaví větší model s více parametry. Nový vývoj však naznačuje, že tento narativ se mění. Úspěch SmolLM 3 a dalších efektivních modelů dokazuje, že špičkového výkonu lze dosáhnout s modely o řády menšími než největší modely. Tento posun je odrazem hlubšího pochopení, že výkon modelů je určován mnoha faktory nad rámec počtu parametrů. Model o 3 miliardách parametrů, trénovaný na kvalitních datech a se sofistikovanými optimalizačními technikami, může překonat mnohem větší model trénovaný na méně kvalitních datech a méně důsledně optimalizovaný. Toto poznání má zásadní důsledky pro celý obor. Naznačuje, že největší dopady výzkumu nemusí spočívat v budování větších modelů, ale v zlepšování kvality dat, vývoji lepších trénovacích technik a vytváření efektivnějších architektur. AI vývoj se tak demokratizuje — umožňuje menším organizacím a akademickým týmům budovat konkurenceschopné modely bez nutnosti masivních výpočetních zdrojů potřebných pro modely s triliony parametrů. Odklon od čistého škálování má i praktické dopady při nasazení: menší modely lze provozovat na edge zařízeních, v prostředích s omezenými zdroji, s nižší latencí a spotřebou energie. To

SmolLM 3 je model o 3 miliardách parametrů navržený pro maximální efektivitu při zachování vysokého výkonu napříč více jazyky a úlohami s dlouhým kontextem. Na rozdíl od větších modelů se SmolLM 3 zaměřuje na optimální výkon v rámci výpočetních omezení, což jej činí ideálním pro nasazení na zařízení s omezenými zdroji a edge zařízení.

Princip 'odpad dovnitř, odpad ven' je základní pro strojové učení. Kvalitní, různorodá data mají na výkon modelu větší vliv než pouze velké množství dat. FineWeb a FinePDF ukazují, že pečlivá kurace, deduplikace a filtrování trénovacích dat vede k výrazně lepším výsledkům než neopracované datasety.

Destilace znalostí je technika, při které se menší model učí od většího, schopnějšího modelu. Během pretrénování tento přístup umožňuje menším modelům získat maximum informací z trénovacích dat díky vzorcům, které již větší model objevil, což vede k lepším výsledkům s menším počtem parametrů.

Predikce více tokenů trénuje modely na předvídání několika budoucích tokenů současně místo pouze následujícího tokenu. Tento přístup je obzvlášť efektivní pro programovací úlohy a zlepšuje schopnost modelu chápat dlouhodobější závislosti, což vede k lepším výsledkům v komplexních úlohách vyžadujících logické uvažování.

Moderní optimalizátory jako Muon jdou nad rámec tradičního AdamW využitím technik jako Newton-Schulzovy metody pro lepší aproximaci Hessovy matice. Výsledkem je stabilnější trénink, kvalitnější gradienty a lepší dynamika učení, zejména při škálování modelů na větší počty parametrů.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

FlowHunt pomáhá týmům zefektivnit pretrénování modelů, zpracování dat a optimalizační pipeline díky inteligentní automatizaci.

Hugging Face Transformers je přední open-source Python knihovna, která usnadňuje implementaci Transformer modelů pro strojové učení v oblasti NLP, počítačového ...

Objevte, jak Jamba 3B od AI21 kombinuje transformer attention s modely state space, aby dosáhla bezprecedentní efektivity a dlouhého kontextu na edge zařízeních...

Detekce jazyka ve velkých jazykových modelech (LLM) je proces, při kterém tyto modely identifikují jazyk vstupního textu, což umožňuje přesné zpracování pro víc...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.