Human-in-the-Loop – Průvodce odpovědnou AI pro byznys lídry

Praktický průvodce pro byznys lídry k zavádění Human-in-the-Loop (HITL) rámců pro odpovědnou správu AI, snížení rizik, soulad s předpisy a budování důvěry v pod...

Průvodce řízením rizik a kontrol AI od KPMG poskytuje organizacím strukturovaný a etický přístup k řízení rizik AI, podporuje odpovědné nasazení a soulad s globálními standardy.

Tato první statistika může pocházet z loňska, ale dnes je aktuálnější než kdy jindy. Podle KPMG’s 2024 U.S. CEO Outlook označilo ohromujících 68 % CEO AI jako investiční prioritu číslo jedna. Spoléhají na ni při zvyšování efektivity, rozvoji dovedností zaměstnanců a podpoře inovací napříč organizací.

To je velký projev důvěry v AI – ale zároveň to vyvolává zásadní otázku: když je toho tolik v sázce, jak mohou organizace zajistit, že budou AI využívat odpovědně a eticky?

Právě zde přichází ke slovu Průvodce řízením rizik a kontrol AI od KPMG. Nabízí jasný, praktický rámec, který firmám pomáhá využít potenciál AI při současném řízení reálných rizik. V dnešním prostředí není budování důvěryhodné AI jen dobrou praxí – je to podnikatelská nezbytnost.

Umělá inteligence (AI) mění průmyslová odvětví, otevírá nové úrovně efektivity, inovací a konkurenceschopnosti. S touto transformací však přichází také specifická rizika a etické výzvy, které musí organizace pečlivě řídit, aby udržely důvěru a zajistily odpovědné využití. Průvodce řízením rizik a kontrol AI od KPMG je navržen tak, aby organizacím pomohl v těchto komplexitách, poskytl praktický, strukturovaný a hodnotově orientovaný přístup ke správě AI.

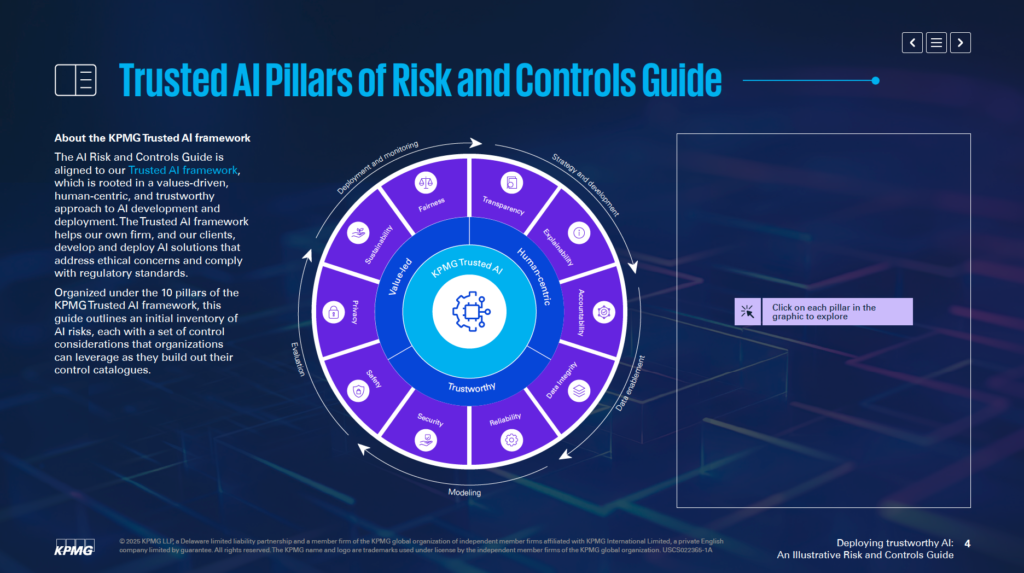

V souladu s Důvěryhodným AI Frameworkem KPMG pomáhá tento průvodce firmám vyvíjet a nasazovat AI řešení, která jsou etická, zaměřená na člověka a v souladu s globálními regulačními standardy. Je uspořádán kolem 10 základních pilířů, z nichž každý se věnuje jednomu zásadnímu aspektu řízení rizik AI:

Zaměřením na tyto pilíře mohou organizace začlenit etické principy do každé fáze životního cyklu AI – od strategie a vývoje přes nasazení až po monitoring. Tento průvodce nejen posiluje odolnost vůči rizikům, ale také podporuje inovace, které jsou udržitelné, důvěryhodné a v souladu se společenskými očekáváními.

Ať už jste odborník na rizika, vrcholový manažer, datový vědec nebo právní poradce, tento průvodce vám poskytne klíčové nástroje a poznatky pro odpovědné využití síly AI.

Průvodce řízením rizik a kontrol AI od KPMG slouží jako specializovaný zdroj pro řízení konkrétních rizik spojených s umělou inteligencí (AI). Uvědomuje si, že navzdory značnému potenciálu AI její komplexnost a etické otázky vyžadují cílený přístup k řízení rizik. Průvodce nabízí strukturovaný rámec, jak těmto výzvám čelit odpovědně a efektivně.

Cílem průvodce není nahrazovat současné systémy, ale doplnit stávající procesy řízení rizik. Hlavním cílem je začlenit AI-specifické aspekty do governance organizace a zajistit hladké sladění s aktuálními provozními postupy. Tento přístup umožňuje posílit schopnosti řízení rizik bez nutnosti kompletního přepracování rámců.

Průvodce vychází z Důvěryhodného AI Frameworku KPMG, který podporuje hodnotově řízený a na člověka zaměřený přístup k AI. Integruje principy z široce uznávaných standardů, včetně ISO 42001, NIST AI Risk Management Framework a EU AI Act. Díky tomu je průvodce praktický a zároveň v souladu s globálními osvědčenými postupy i regulatorními požadavky na řízení AI.

Průvodce nabízí konkrétní doporučení a praktické příklady zaměřené na rizika spojená s AI. Povzbuzuje organizace, aby tyto příklady přizpůsobovaly svému kontextu, s ohledem na to, zda AI systémy vyvíjejí interně nebo nakupují, i podle typů dat a použitých technik. Tato flexibilita zajišťuje relevanci průvodce pro různá odvětví a aplikace AI.

Průvodce klade důraz na to, aby organizace nasazovaly AI technologie bezpečně, eticky a transparentně. Řešením technických, provozních i etických aspektů rizik AI pomáhá budovat důvěru zúčastněných stran a zároveň využívat transformační potenciál AI.

Průvodce slouží jako zdroj, který zajistí, aby AI systémy byly v souladu s obchodními cíli a zároveň minimalizovaly potenciální rizika. Podporuje inovace způsobem, který upřednostňuje odpovědnost a zodpovědnost.

Průvodce řízením AI governance od KPMG je určen pro profesionály, kteří zodpovídají za implementaci AI a zajištění jejího bezpečného, etického a efektivního nasazení. Je relevantní pro týmy napříč organizací, například:

Vrcholoví manažeři a lídři (CEO, CIO, CTO) najdou v průvodci oporu pro řízení AI jako strategické priority. Podle KPMG’s 2024 US CEO Outlook považuje 68 % CEO AI za klíčovou oblast investic. Průvodce umožňuje sladit AI strategie s cíli organizace a zároveň řídit s tím spojená rizika.

Softwaroví inženýři, datoví vědci a další odpovědní za tvorbu a nasazení AI mohou využít průvodce k začlenění etických principů a robustních kontrol přímo do svých systémů. Zaměřuje se na přizpůsobení řízení rizik podle konkrétní architektury a datových toků AI modelů.

Průvodce je adaptabilní pro firmy vyvíjející AI interně, využívající AI od dodavatelů či pracující s vlastními daty. Je zvlášť relevantní pro odvětví jako finance, zdravotnictví a technologie, kde pokročilé AI aplikace a citlivá data hrají klíčovou roli.

Nasazení AI bez jasného governance rámce může vést k finančním, regulatorním i reputačním rizikům. Průvodce KPMG doplňuje stávající procesy o strukturovaný, etický postup řízení AI. Podporuje odpovědnost, transparentnost a etické jednání, což organizacím umožňuje využívat AI odpovědně a bezpečně.

Organizace by měly začít propojením rizik specifických pro AI se svou současnou taxonomií rizik. Taxonomie rizik je strukturovaný rámec pro identifikaci, organizaci a řešení zranitelností. Jelikož AI přináší nová specifika, je třeba tradiční taxonomii rozšířit o AI faktory – například přesnost datových toků, logiku algoritmů či spolehlivost datových zdrojů. Tím se rizika AI stanou součástí širšího řízení rizik, nikoli izolovanou oblastí.

Průvodce zdůrazňuje potřebu hodnotit celý životní cyklus AI systémů. Klíčové je sledovat původ dat, jejich pohyb procesy a základní logiku AI modelu. Tento široký pohled pomáhá odhalit, kde mohou vznikat zranitelnosti během vývoje a provozu AI.

AI systémy se liší svým účelem, metodami vývoje i typem používaných dat. Zda je model vyvinut interně nebo pořízen od externího dodavatele, výrazně ovlivňuje rizika. Stejně tak povaha dat – vlastní, veřejná, citlivá – a využité techniky vyžadují různou strategii řízení rizik.

Průvodce doporučuje přizpůsobit kontrolní opatření konkrétním potřebám AI systémů. Například při využívání vlastních dat je nutné zavést přísnější přístupová pravidla, zatímco při využití AI od dodavatele je klíčové důkladné posouzení třetích stran. Takto přizpůsobené kontroly umožňují efektivněji řešit konkrétní výzvy vašich AI systémů.

Průvodce doporučuje začlenit řízení rizik do všech fází životního cyklu AI. To zahrnuje plánování rizik již při návrhu, nastavení silného monitoringu při nasazení a pravidelné aktualizace hodnocení rizik během vývoje a provozu. Řešení rizik v každém kroku pomáhá snižovat zranitelnosti a zajišťuje, že AI systémy budou etické i spolehlivé.

Již samotné sladění rizik AI s existující taxonomií a přizpůsobení kontrol podle vašich potřeb vytváří pevný základ pro důvěryhodnou AI. Tyto kroky organizacím umožňují systematicky identifikovat, hodnotit a spravovat rizika a budovat robustní rámec pro governance AI.

Důvěryhodný AI Framework KPMG stojí na deseti klíčových pilířích, které řeší etické, technické i provozní výzvy umělé inteligence. Tyto pilíře vedou organizace při návrhu, vývoji i nasazení AI systémů tak, aby byly důvěryhodné a odpovědné v celém životním cyklu.

Lidský dohled a odpovědnost musí být součástí každé fáze životního cyklu AI. To znamená jasně definovat, kdo je za rizika AI zodpovědný, zajistit soulad s legislativou a mít možnost zasáhnout, přepsat či zvrátit rozhodnutí AI v případě potřeby.

AI systémy by měly snižovat nebo eliminovat zaujatost, která by mohla negativně ovlivnit jednotlivce, komunity či skupiny. To zahrnuje pečlivou analýzu dat, aby reprezentovala různorodé populace, uplatňování principů spravedlnosti ve vývoji a kontinuální monitoring výsledků pro podporu rovného zacházení.

Transparentnost znamená otevřeně sdílet, jak AI systémy fungují a proč přijímají konkrétní rozhodnutí. Patří sem dokumentace omezení systému, výsledků a testovacích metod. Uživatelé musí být informováni, když jsou jejich data sbírána, AI generovaný obsah musí být jasně označen a citlivé aplikace (např. biometrika) musí poskytovat jasné informace uživatelům.

AI systémy musí poskytovat srozumitelná vysvětlení svých rozhodnutí. Organizace by měly podrobně dokumentovat datové sady, algoritmy i metriky výkonu, což umožní stakeholderům analyzovat a reprodukovat výsledky.

Kvalita a spolehlivost dat během celého životního cyklu – od sběru, označení, uložení až po analýzu – jsou zásadní. Opatření by měla minimalizovat rizika jako je poškození nebo zkreslení dat. Pravidelná kontrola kvality a regresní testy při aktualizacích systému pomáhají udržet přesnost a spolehlivost AI.

AI řešení musí respektovat zákony o ochraně soukromí a dat. Organizace musí správně vyřizovat žádosti subjektů údajů, provádět posouzení dopadu na soukromí a využívat pokročilé techniky jako diferenciální soukromí pro vyvážení využitelnosti dat a ochrany jednotlivců.

AI systémy by měly stabilně plnit svůj účel s požadovanou přesností. To vyžaduje důkladné testování, detekci anomálií a kontinuální zpětnovazebné smyčky pro ověřování výstupů systému.

Bezpečnostní opatření chrání AI systémy před tím, aby způsobily škodu lidem, firmám nebo majetku. Patří sem návrh fail-safe mechanismů, monitoring problémů jako je poisoning dat nebo útoky prompt injection, a zajištění souladu s etickými i provozními standardy.

Silné bezpečnostní postupy jsou nutné k ochraně AI systémů před hrozbami a škodlivou činností. Organizace by měly pravidelně provádět audity, hodnotit zranitelnosti a šifrovat citlivá data.

AI systémy by měly být navrhovány tak, aby minimalizovaly spotřebu energie a podporovaly environmentální cíle. Udržitelnost by měla být součástí návrhu od začátku, s průběžným monitoringem spotřeby energie, efektivity a emisí během celého životního cyklu AI.

Dodržováním těchto deseti pilířů mohou organizace vytvářet AI systémy, které jsou etické, důvěryhodné a v souladu se společenskými očekáváními. Tento rámec poskytuje jasnou strukturu pro řízení výzev AI a podporuje odpovědnou inovaci.

Integrita dat je klíčová pro zajištění přesnosti, spravedlnosti a spolehlivosti AI systémů. Nekvalitní správa dat může vést k rizikům jako je zkreslení, nepřesnost či nespolehlivé výsledky. Tyto problémy mohou narušit důvěru ve výstupy AI a způsobit zásadní provozní i reputační škody. Důvěryhodný AI framework KPMG zdůrazňuje potřebu udržovat vysokou kvalitu dat v celém životním cyklu pro efektivní fungování AI a splnění etických standardů.

Bez silného řízení dat mohou AI systémy produkovat chybné výsledky. Problémy jako neúplná, nepřesná či nerelevantní data vedou k zaujatým nebo nespolehlivým výstupům a zvyšují rizika napříč AI aplikacemi.

Data často prochází mezi systémy během tréninku, testování nebo provozu. Pokud nejsou tyto přenosy správně zajištěny, může dojít k poškození, ztrátě či degradaci dat, což ovlivní výkon AI systému.

Pro zlepšení governance dat mohou organizace:

Pro minimalizaci rizik při přenosech dat by organizace měly:

Použití systémů pro kontinuální monitoring podporuje integritu dat v celém životním cyklu AI. Tyto systémy dokážou odhalit problémy, jako jsou nečekané změny v kvalitě dat nebo nekonzistence v jejich zpracování, což umožňuje rychlou nápravu.

Udržení integrity dat je zásadní pro důvěryhodné nasazení AI systémů. Organizace mohou rizika snížit zavedením robustních rámců správy dat, ochranou datových interakcí a trvalými validačními procesy. Tato opatření zvyšují spolehlivost výstupů AI a zároveň podporují etické i provozní standardy, čímž posilují důvěru v AI technologie.

Řízení požadavků na přístup subjektů údajů je zásadní výzvou v oblasti soukromí AI. Organizace musí zajistit, aby jednotlivci mohli uplatnit svá práva na přístup, opravu nebo výmaz osobních údajů dle předpisů jako GDPR a CCPA. Špatné vyřizování těchto požadavků může vést k porušení regulací, ztrátě důvěry spotřebitelů a poškození reputace organizace.

Pro snížení tohoto rizika by firmy měly vytvářet vzdělávací programy pro jednotlivce o jejich právech při interakci s AI. Systémy musí být nastaveny tak, aby požadavky byly zpracovány rychle a transparentně. Organizace by také měly vést podrobné záznamy o vyřizování těchto žádostí pro doložení compliance během auditů.

AI systémy často zpracovávají citlivé osobní informace, což z nich činí atraktivní cíl kyberútoků. V případě úniku dat může dojít k vysokým regulatorním pokutám, poškození pověsti firmy a ztrátě důvěry zákazníků.

KPMG Trusted AI framework doporučuje provádět etické posouzení AI systémů zpracovávajících osobní data, aby byl zajištěn soulad s předpisy o ochraně soukromí. Důležité jsou také pravidelné audity ochrany dat a posouzení dopadu na soukromí (PIA), zejména při používání citlivých dat pro trénink AI. Navíc techniky jako diferenciální soukromí, které do dat vnáší statistický šum, mohou pomoci anonymizovat informace a zároveň umožnit jejich analýzu.

AI systémy, které nezahrnují ochranu soukromí již od návrhu, mohou způsobit vážné problémy. Bez uplatnění principů privacy-by-design riskují organizace únik citlivých dat nebo nesplnění legislativních požadavků.

Firmy by měly začlenit ochranu soukromí do vývoje AI systémů. To znamená řídit se zákony o ochraně údajů, aplikovat silné postupy správy dat a jasně dokumentovat, jak jsou data sbírána, používána a ukládána. Organizace musí také získat explicitní souhlas uživatelů se sběrem a zpracováním dat, zejména v citlivých oblastech jako biometrika.

Pokud AI systémy uživatelům jasně nevysvětlí, jak je s jejich daty nakládáno, vede to k nedůvěře i právním problémům. Uživatelé musí vědět, kdy jsou jejich data sbírána a jak jsou využívána

Průvodce řízením rizik a kontrol AI od KPMG je praktický rámec navržený tak, aby organizacím pomohl řídit jedinečná rizika AI a zajistil odpovědné, etické a v souladu s předpisy provedené nasazení AI napříč odvětvími.

Průvodce stojí na deseti klíčových pilířích: Odpovědnost, Spravedlnost, Transparentnost, Vysvětlitelnost, Integrita dat, Spolehlivost, Bezpečnost, Bezpečí, Soukromí a Udržitelnost – každý se zaměřuje na zásadní aspekt řízení rizik AI.

Průvodce je určen pro odborníky na rizika, týmy pro compliance, specialisty kybernetické bezpečnosti, právní poradce, manažery, vývojáře AI, inženýry i organizace všech velikostí, které chtějí řídit AI odpovědně.

Je v souladu s globálními standardy jako ISO 42001, NIST AI Risk Management Framework a EU AI Act a pomáhá organizacím začlenit AI-specifické kontroly do stávajících procesů governance a splnit regulatorní požadavky.

Průvodce navrhuje opatření jako robustní správu dat, privacy-by-design, kontinuální monitoring, transparentnost AI rozhodnutí, detekci anomálií, zpětnovazebné smyčky a cíle udržitelnosti pro snížení rizik spojených s AI.

Zjistěte, jak může Průvodce řízením rizik a kontrol AI od KPMG pomoci vaší organizaci využít inovací AI a zároveň zajistit etické, bezpečné a v souladu s předpisy provedené nasazení.

Praktický průvodce pro byznys lídry k zavádění Human-in-the-Loop (HITL) rámců pro odpovědnou správu AI, snížení rizik, soulad s předpisy a budování důvěry v pod...

Zjistěte, proč je vedení v oblasti AI klíčové pro úspěch organizace, jak silní lídři pohánějí AI transformaci a jak AI Leadership Workshop od FlowHunt připravuj...

Míry adopce AI udávají procento organizací, které začlenily umělou inteligenci do svých operací. Tyto míry se liší napříč odvětvími, regiony a velikostí společn...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.