Kdo vlastní chatbot AI?

Zjistěte, kdo vlastní hlavní AI chatboty v roce 2025. Seznamte se s OpenAI, Google, Microsoftem, Meta, Amazonem, Applem a s tím, jak vám FlowHunt umožňuje vytvá...

Prozkoumejte skrytou infrastrukturu za AI systémy. Zjistěte, jak datacentra fungují, jaké mají nároky na energii, chladicí systémy, časovou náročnost výstavby a jak obrovské investice mění globální infrastrukturu.

Když otevřete ChatGPT, napíšete dotaz a stisknete enter, nepřipojujete se jen do nějakého záhadného cloudu. Za touto jednoduchou interakcí stojí jedna z nejsložitějších, nejdražších a energeticky nejnáročnějších infrastruktur, které kdy lidstvo vytvořilo. Každá AI odpověď, kterou obdržíte, je poháněna obřími datacentry — miliardovými objekty chlazenými vzduchem a vodou, které spotřebují tolik elektřiny, že by mohly napájet celá města. Nejde o abstraktní pojmy někde v kyberprostoru, ale o fyzické budovy naplněné specializovaným hardwarem, sofistikovanými chladicími systémy a zabezpečením na úrovni pevnosti. Porozumění tomu, co se nachází uvnitř těchto datacenter, je klíčem k pochopení, jak moderní AI skutečně funguje a proč do jejich výstavby investují firmy jako OpenAI, Google, Microsoft a Meta biliony dolarů. Tento článek vám přiblíží skryté zázemí AI revoluce — od základní architektury datacenter přes inženýrské výzvy, kterým čelí, ohromující spotřebu elektřiny až po globální závod o vybudování infrastruktury, která pohání další generaci umělé inteligence.

{{ < youtubevideo videoID=“WNt_1bSODIo” title=“What’s Inside an AI Data Center?” class=“rounded-lg shadow-md” > }}

Datacentra jsou v podstatě továrny na výpočty. Zatímco termín „cloud“ se stal všudypřítomným v technologickém marketingu, jde o zavádějící označení — žádný cloud neexistuje. Ve skutečnosti jde o obří fyzické budovy naplněné specializovaným výpočetním vybavením, síťovou infrastrukturou, energetickými systémy a chladicími mechanismy. Datacentrum si můžete představit jako obrovsky zvětšenou verzi osobního počítače. Stejně jako váš notebook obsahuje CPU, GPU, paměť, úložiště a napájecí zdroj, hyperscale datacentrum obsahuje tyto komponenty v miliardových násobcích. Objekt spravuje a poskytuje data prostřednictvím propojených systémů serverů, AI akcelerátorů, diskových polí a síťových zařízení. Tyto budovy fungují jako malá města s vlastní výrobou a distribucí elektřiny, záložními generátory, bezpečnostní infrastrukturou a environmentálními kontrolami. Základní účel zůstává stejný, ať už datacentrum hostí CPU pro obecné výpočetní úlohy, nebo GPU pro AI zátěže — zpracovává, ukládá a doručuje data ve velkém měřítku. Nicméně konkrétní návrh, architektura a provozní požadavky AI datacenter se dnes výrazně liší od tradičních datacenter a vyžadují zcela nové přístupy k řízení energie, chlazení a plánování infrastruktury.

Nástup generativní AI zásadně proměnil odvětví datacenter způsobem, který dalece překračuje pouhé škálování stávající infrastruktury. Před koncem roku 2022, kdy byl světu představen ChatGPT, se datacentra zaměřovala hlavně na obecné výpočetní úlohy — hostování webů, správu databází, provoz podnikových aplikací a poskytování cloudových služeb. Výpočetní nároky byly poměrně předvídatelné a zvládnutelné. Explozivní růst velkých jazykových modelů a generativních AI systémů však vytvořil zcela novou kategorii výpočetní zátěže fungující za naprosto odlišných podmínek. Tyto AI systémy spoléhají na maticové násobení — matematicky jednoduchou operaci, kterou je třeba provádět miliardkrát za sekundu. Tento požadavek posunul celé odvětví k specializovanému GPU hardwaru, zejména k pokročilým čipům Nvidia, které jsou pro tyto operace optimalizovány. Změna je natolik dramatická, že vedla k reálnému nedostatku GPU kapacit; firmy nejsou schopny získat dostatek hardwaru pro pokrytí poptávky. Výsledkem je technologický závod ve zbrojení, kdy každá velká technologická firma investuje stovky miliard dolarů do zajištění GPU a budování AI-optimalizovaných datacenter. Rozsah této výstavby je bezprecedentní — samotný projekt Stargate firem OpenAI, Oracle a SoftBank plánuje investovat v USA biliony dolarů do AI infrastruktury. Nejde tedy o postupný upgrade stávajících systémů, ale o zásadní restrukturalizaci globální výpočetní infrastruktury pro podporu nové technologické éry.

Nejzásadnější omezení dalšího rozvoje AI datacenter představuje elektřina. Zatímco tradiční datacentra mohou spotřebovávat 10–15 kW na rack, moderní AI datacentra se dnes dostávají na 80–120 kW na rack, přičemž další generace systémů Nvidia (Ruben era) počítá s hodnotami až 600 kW na rack v tomto desetiletí. To znamená pětinásobný až desetinásobný nárůst hustoty výkonu a přináší bezprecedentní výzvy v oblasti výroby, distribuce a řízení elektřiny. Pro představu: Ministerstvo energetiky USA odhaduje, že v roce 2023 spotřebovala datacentra 4,4 % veškeré elektřiny a tento podíl má do roku 2028 vzrůst na 7–12 %. ERCOT (Electric Reliability Council of Texas) a další správci sítí předpovídají do roku 2030 nárůst špičkové spotřeby elektřiny o cca 30 gigawattů, z velké části kvůli expanzi datacenter. Pro kontext: 30 GW odpovídá spotřebě 25–30 milionů domácností, nebo výkonu asi 30 velkých jaderných elektráren. To představuje obrovskou výzvu pro energetické firmy a regionální sítě, které byly navrženy pro zcela jinou epochu spotřeby elektřiny. Problém zhoršuje i to, že spotřeba AI datacenter není rozložena rovnoměrně v čase ani prostoru. Tyto objekty vyžadují stálé, vysokohustotní odběry koncentrované u konkrétních rozvoden, což vytváří lokální přetížení infrastruktury. Firmy jako Google, Microsoft a OpenAI dnes musí rozhodovat o umístění datacenter především podle dostupnosti elektřiny, ne jen podle ceny pozemků či blízkosti uživatelů. To vedlo ke geografické koncentraci výstavby v oblastech s dostatkem zdrojů — například na horním Středozápadě USA, v severských zemích, nebo v regionech s významnou hydroelektrickou či jadernou produkcí. Nedostatek elektřiny se stal natolik zásadním, že je dnes hlavním limitem expanze AI infrastruktury — důležitějším než pozemky, pracovní síla nebo i dostupnost GPU.

Moderní AI datacentrum je organizováno do několika propojených systémů, z nichž každý plní klíčovou funkci. Základem jsou racky — kovové stojany, v nichž jsou umístěny GPU a specializované AI akcelerátory zajišťující samotné výpočty. Racky jsou propojeny vysokorychlostními síťovými přepínači, které umožňují vzájemnou komunikaci s extrémní šířkou pásma. Datacentrum dále obsahuje disková pole s petabajty dat — trénovacími daty, váhami modelů a uživatelskými daty, která AI systémy potřebují. Kromě výpočetního hardwaru je nezbytná také pokročilá energetická infrastruktura — transformátory, rozvodné panely, UPS a záložní generátory. Energetický systém musí být navržen tak, aby zvládl nejen průměrné, ale i špičkové zatížení při plném výkonu všech systémů. Neméně důležité je chladicí zařízení, které je dnes jedním z nejkritičtějších a nejsložitějších aspektů návrhu datacenter. Chladicí systémy musí odvádět teplo generované výpočetní technikou a udržovat optimální provozní teploty hardwaru. To zahrnuje kombinaci vzduchotechnických jednotek, kapalinových okruhů, systémů s chlazenou vodou a někdy i přímé kapalinové chlazení, kdy chladicí médium proudí přímo přes čipy. Objekt rovněž vyžaduje rozsáhlá bezpečnostní opatření — fyzické bariéry, přístupové systémy, kamery a kyberbezpečnostní technologie chránící před fyzickým i digitálním napadením. Konečně je nutná redundance klíčových systémů — záložní energie, chlazení i síť — aby bylo minimalizováno riziko výpadků a zařízení mohlo pokračovat v provozu i při selhání některých komponent.

Ačkoliv se FlowHunt specializuje na automatizaci AI obsahových workflow a nikoli na správu fyzické infrastruktury, principy efektivity a optimalizace, které stojí za konstrukcí datacenter, lze přímo aplikovat i na zefektivnění AI operací organizací. Stejně jako datacentra optimalizují spotřebu elektřiny, účinnost chlazení a propustnost výpočtů, i firmy využívající AI nástroje musí optimalizovat své workflow, aby maximalizovaly užitek z AI systémů a minimalizovaly plýtvání zdroji. FlowHunt automatizuje výzkum, generování obsahu i publikační workflow, které by jinak vyžadovaly mnoho manuální práce a koordinace. Díky této automatizaci mohou organizace snížit výpočetní režii svých obsahových operací, podobně jako datacentra optimalizují svou infrastrukturu. Platforma umožňuje týmům sledovat a vyhodnocovat efektivitu AI workflow, poskytuje přehled o využití zdrojů — obdobně jako operátoři datacenter monitorují spotřebu elektřiny a účinnost chlazení. Pro firmy budující AI produkty nebo služby je znalost infrastruktury a omezení datacenter klíčová pro rozhodování o nasazení, škálování a řízení nákladů. Automatizační schopnosti FlowHunt pomáhají týmům pracovat efektivněji v rámci těchto limitů, což jim umožňuje generovat více obsahu, provádět více výzkumu a publikovat častěji, aniž by úměrně rostly jejich výpočetní požadavky nebo provozní zátěž.

Jedním z nejméně doceněných aspektů provozu AI datacenter je chlazení. Extrémní hustota výpočtů v moderních AI datacentrech generuje obrovská množství tepla, které je nutné z čipů odvádět, aby nedošlo k jejich poškození a zachovala se optimální výkonnost. Bez účinného chlazení by se křemík doslova roztavil a celý objekt by musel být odstaven. Tato výzva vedla k zásadní změně filozofie návrhu datacenter: od tradičního vzduchového chlazení směrem k sofistikovaným kapalinovým systémům. Vzduchové chlazení, kdy ventilátory ženou chladný vzduch přes zařízení, je tradiční přístup používaný ve většině datacenter. Vzduch má však oproti kapalinám nízkou tepelnou vodivost, takže je méně účinný při odvádění tepla z hustě zaplněného hardwaru. S rostoucí hustotou výkonu je vzduchové chlazení stále méně dostačující. Kapalinové systémy, kdy voda nebo speciální chladicí médium proudí přímo přes či v blízkosti čipů, jsou při odvádění tepla mnohem účinnější. Existuje několik přístupů ke kapalinovému chlazení: uzavřené okruhy, kde chladivo cirkuluje mezi zařízením a chladičem bez kontaktu s okolím, a otevřené okruhy, kde může chladivo přijít do styku s prostředím. Uzavřené systémy šetří vodu, ale mohou vyžadovat více elektřiny na chlazení. Otevřené systémy jsou efektivnější z hlediska elektřiny, ale spotřebují více vody. Volba mezi těmito variantami závisí na místní dostupnosti vody, ceně elektřiny, podnebí a ekologických regulacích. Ukazatel efektivity využití vody (WUE) je klíčovou metrikou efektivity datacentra, počítá se jako litry vody na kilowatthodinu výkonu IT zařízení. V průměru je WUE kolem 1,9 l/kWh, ale datacentra s plně uzavřenými systémy se blíží nulové spotřebě vody. Například datacentrum Google v Council Bluffs (Iowa) spotřebovalo v roce 2023 přibližně miliardu galonů vody, což dokládá obrovské nároky velkokapacitních AI zařízení. Některá inovativní datacentra zkouší alternativní přístupy, včetně využití odpadního tepla pro dálkové vytápění (Meta v Dánsku exportuje 100–165 GWh tepla ročně do lokálních sítí), využití volného chlazení venkovním vzduchem v chladném klimatu či dokonce vodíkové chladicí technologie. Chladicí infrastruktura představuje významnou část investic do datacentra a často je nejsložitější inženýrskou výzvou při návrhu.

Výstavba hyperscale AI datacentra je mimořádně náročný projekt vyžadující pečlivé plánování, obrovské kapitálové investice a spolupráci s mnoha subjekty. Typická doba od úvodního konceptu po plný provoz trvá 18–30 měsíců a zahrnuje několik fází. První fází je plánování a posouzení proveditelnosti (3–6 měsíců). V této fázi firmy identifikují vhodné lokality, posuzují dostupnost elektřiny, hodnotí vodní zdroje, zkoumají místní regulace a komunikují s komunitou. Najít vhodný pozemek není triviální — objekt potřebuje dostatek elektřiny, rychlé optické linky, dostatek vody na chlazení a podporu místní správy. Druhou fází je návrh a inženýring (6–12 měsíců), kdy architekti a inženýři připravují detailní plány objektu — rozložení racků, energetický rozvod, chlazení, bezpečnostní systémy i vše ostatní. V této fázi se provádí rozsáhlé modelování a simulace pro optimalizaci efektivity. Třetí fází jsou povolovací procesy (6–18 měsíců), které často probíhají souběžně s návrhem. Zahrnují stavební povolení, ekologická schválení, smlouvy s dodavateli energií a další regulace na úrovni města, státu či federace. Tato fáze může být velmi časově náročná v oblastech s přísnými ekologickými pravidly nebo odporem komunity. Čtvrtou fází je vlastní výstavba (1–2 roky): budování konstrukce, instalace vybavení, rozvody elektřiny a chlazení, instalace bezpečnostních systémů. Poslední fází je testování a zprovozňování (3–6 měsíců), kdy se všechny systémy ověřují, nastavuje software a objekt se postupně uvádí do provozu. Nejznámější výjimkou z této časové osy je projekt Colossus od XAI, dokončený za pouhých 122 dní — což vyžadovalo mimořádnou koordinaci a přípravu. Většina projektů ale probíhá standardním 18–30měsíčním tempem. Kapitálové investice jsou ohromné. Například kampus Fairwater od Microsoftu zabírá stovky hektarů, vyžaduje kilometry základů a instalaci tisíců GPU s kapalinovým chlazením. Celková investice u takových projektů se běžně pohybuje v řádu desítek miliard dolarů. Tento objem odráží strategický význam AI infrastruktury i konkurenční tlak na rychlé rozšiřování GPU kapacit.

Po dokončení jsou AI datacentra provozována s bezpečností na úrovni pevností a sofistikovanými provozními postupy. Tato zařízení ukrývají hardware v hodnotě miliard dolarů a provozují systémy, které jsou kritické pro fungování největších technologických firem. Fyzická bezpečnost je klíčová. Areály jsou obehnány ploty a bariérami proti vjezdu, vstupy jsou přísně kontrolovány pomocí badge čteček, biometriky a strážní služby. Návštěvy jsou vzácné a povoleny jen po schválení; serverovny jsou přístupné pouze s doprovodem. Kamery sledují všechny prostory. Bezpečnostní infrastruktura chrání před krádežemi i sabotáží. Stejně důležitá je kyberbezpečnost. Systémy v těchto datacentrech obsahují cenné duševní vlastnictví, uživatelská data i trénované modely, které představují roky vývoje a miliardové investice. Kyberbezpečnostní opatření patří mezi nejpokročilejší — segmentace sítí, detekce průniků, šifrování, stálý monitoring podezřelé aktivity. Každý rack bývá uzamčen v kleci, přístup ke kritickým systémům mají jen oprávněné osoby. Provozní složitost těchto zařízení je obrovská. Operátoři musí nepřetržitě sledovat spotřebu energie, účinnost chlazení, stav vybavení, výkon sítě i bezpečnost. Musí plánovat rozložení zátěže v rámci objektu, aby nedocházelo k přetížení, koordinovat údržbu a minimalizovat výpadky. Musí řešit poruchy zařízení a provádět opravy. Velké zařízení může zaměstnávat desítky až stovky lidí v různých rolích, avšak při vysoké míře automatizace může být tým velmi malý. Provozní postupy jsou silně standardizované a dokumentované s jasnými protokoly pro běžné i mimořádné situace.

Umístění AI datacenter se stalo strategickým rozhodnutím velkých technologických firem, které je dnes řízeno především dostupností elektřiny, ale ovlivňují jej i vodní zdroje, klima, optická konektivita, místní regulace a vztahy s komunitou. Severní Virginie je dnes největším datacentrovým trhem na světě s téměř nulovou volnou kapacitou a gigawatty nové výstavby. Okres Loudoun ve Virginii je natolik závislý na příjmech z datacenter, že tvoří přibližně 38 % jeho rozpočtu. Díky tomu mohl okres snížit daně obyvatelům, což ukazuje na významný ekonomický přínos datacenter pro místní komunity. Další regiony se však stávají atraktivními alternativami: Phoenix, Chicago, Oregon či Ohio zažívají investice díky kombinaci dostupných pozemků, kapacit energetiky a vodních zdrojů. Horní Středozápad, zejména v blízkosti vodních elektráren či jaderných bloků, je zvlášť atraktivní díky dostatku čisté energie. Severské země, zejména Island a Norsko, se staly datacentrovými uzly díky levné hydroelektrické energii a chladnému klimatu snižujícímu náklady na chlazení. Ekonomický dopad výstavby datacenter je složitý. V období výstavby vznikají pracovní místa — pro stavebníky, inženýry i manažery. Po uvedení do provozu je však zaměstnanost výrazně nižší: velké datacentrum může zaměstnávat jen několik desítek lidí, výrazně méně než po dobu stavby. To je důležité pro místní samosprávy při posuzování projektů. Daňové příjmy mohou být značné, jak dokládá zkušenost Loudoun County, ale přímý dopad na zaměstnanost je omezený. Navíc mohou datacentra vyvolávat environmentální obavy ohledně spotřeby vody, elektřiny a produkce tepla. Nejlepší projekty jsou transparentní ohledně svého dopadu, spolupracují s dodavateli energií na zajištění kapacit, implementují úsporné technologie a snaží se být součástí komunity, nikoli izolovanými objekty.

Energetická infrastruktura, která podporuje AI datacentra, je stejně složitá jako ta výpočetní. Datacentra potřebují nejen dostatečný přísun elektřiny, ale hlavně spolehlivé, stabilní napájení zvládající i špičkové odběry bez výpadků. Většina velkých datacenter je připojena na regionální síť, ale zároveň udržuje záložní zdroje pro případ selhání sítě. Prakticky všechna velká americká datacentra mají masivní dieselgenerátory jako nouzové záložní napájení. Tyto generátory dokážou zajistit provoz objektu i při dlouhodobém výpadku sítě. Ačkoliv jsou používány zřídka, při spuštění produkují emise. Tento environmentální dopad motivuje provozovatele k hledání alternativních záložních zdrojů — některá datacentra testují bateriové systémy pro ukládání energie, jiná plynové turbíny jako čistší alternativu k dieselu, některá dokonce vodíkové palivové články. V budoucnu se uvažuje i o vlastních jaderných zdrojích, to je však zatím spíše teoretické. Vztah mezi datacentry a energetickými firmami je klíčový. Datacentra představují obrovskou a stálou zátěž pro síť, a tak musí energetici plánovat výrobu a rozvod tak, aby tuto poptávku pokryli. Firmy jako Google, Microsoft a OpenAI často uzavírají dlouhodobé smlouvy na nákup elektřiny za garantované ceny. Některé investují do vlastních obnovitelných zdrojů — solárních, větrných či vodních elektráren — aby snížily závislost na síti. Rozhodnutí datacentrových operátorů o napájení mají dopady na celou regionální síť i energetickou politiku na státní a národní úrovni.

Směr dalšího rozvoje AI datacenter je jasný: výstavba bude pokračovat zrychlujícím tempem, poháněna explozí AI aplikací a konkurenčním bojem technologických firem o výpočetní kapacity. Spotřeba elektřiny dál poroste, což bude klást nové nároky na výrobu a distribuci. Nároky na chlazení povedou k dalším inovacím v oblasti termálního managementu. Požadavky na bezpečnost budou dál růst s hodnotou systémů a dat, které tyto objekty chrání. Vývoj infrastruktury AI datacenter bude ovlivňovat několik trendů: pokračující geografická diverzifikace (výstavba v nových regionech s dostatkem elektřiny, vody a konektivity); další inovace v chlazení (kapalinové systémy se stanou standardem, zkoumají se i imerzní a dvoufázové technologie); rostoucí důraz na udržitelnost (minimalizace spotřeby vody, snižování emisí, integrace obnovitelných zdrojů); konsolidace a specializace (některá centra optimalizovaná na trénink, jiná na inference); a větší automatizace provozu (využití AI pro optimalizaci spotřeby energie, chlazení a využití vybavení). Rozsah investic je bezprecedentní a odráží strategický význam AI pro globální ekonomiku. Tato zařízení jsou fyzickým ztělesněním AI revoluce — skrytým zázemím, které umožňuje všechny AI aplikace měnící průmysl i společnost.

{{ < cta-dark-panel heading=“Zrychlete své workflow s FlowHunt” description=“Vyzkoušejte, jak FlowHunt automatizuje vaše AI obsahová a SEO workflow — od výzkumu a tvorby obsahu po publikaci a analytiku — vše na jednom místě.” ctaPrimaryText=“Rezervovat demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Vyzkoušejte FlowHunt zdarma” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Finanční rozsah investic do AI datacenter je ohromující a odráží obrovskou hodnotu, kterou firmy očekávají od AI schopností. Projekt Stargate firem OpenAI, Oracle a SoftBank plánuje investovat biliony dolarů do výstavby AI infrastruktury v USA. Nvidia přislíbila přispět 100 miliardami dolarů. Google, Microsoft, Meta a další technologičtí giganti investují každý stovky miliard do rozšiřování svých datacenter. Tyto investice se realizují navzdory značné nejistotě ohledně návratnosti — podtrhují však strategický význam AI a konkurenční tlak na zajištění výpočetní kapacity. Ekonomika provozu datacenter je složitá: kapitálové náklady jsou obrovské — desítky miliard dolarů na jeden objekt. Provozní náklady jsou také značné, především kvůli spotřebě elektřiny. Velké AI datacentrum může spotřebovat 100–300 MW nepřetržitě, což při obvyklých cenách 50–100 $/MWh znamená roční náklady na elektřinu 50–300 milionů dolarů. K tomu je třeba přičíst náklady na chlazení, údržbu, bezpečnost a personál — celkové roční provozní náklady tak mohou u velkých objektů přesáhnout 500 milionů dolarů. Tyto náklady musí být pokryty příjmy — buď prodejem výpočetní kapacity zákazníkům, nebo interním využitím pro generování AI služeb. Ceny GPU výpočetní kapacity jsou konkurenční a odráží náklady plus marži. S rostoucí nabídkou může docházet k tlaku na ceny a nižší marže, což ztěžuje návratnost investic. Zatím však poptávka po AI kapacitě roste rychleji než nabídka, takže ceny pravděpodobně zůstanou vysoké. Návratnost investic závisí na schopnosti udržet plné využití objektu, efektivně řídit náklady a udržet cenovou sílu v konkurenčním prostředí. Firmy, které vlastní datacentra a využívají je pro své AI služby, mohou mít odlišnou ekonomiku než poskytovatelé datacenter jako služby pro zákazníky.

Environmentální dopad rozšiřování AI datacenter je významný a komplexní. Nejviditelnějším dopadem je spotřeba elektřiny — s rostoucím podílem na celkové výrobě roste i tlak na emise uhlíku (pokud není energie z obnovitelných či jaderných zdrojů) a zátěž elektrických sítí. Významná je i spotřeba vody, zejména u zařízení s vodním chlazením. Teplo produkované datacentry je někdy znovu využíváno (například v zařízení Meta v Dánsku), ale často je pouze vypouštěno do okolí. Tyto dopady vedou k rostoucímu zaměření na udržitelnost. Mnoho operátorů se zavazuje k uhlíkové neutralitě či snížení emisí a investuje do obnovitelných zdrojů energie. Někteří zavádějí úspory vody — uzavřené chladicí okruhy, suché chlazení. Jiní hledají způsoby, jak znovu využít odpadní teplo. Environmentální dopady rozvoje datacenter jsou také stále

AI datacentra jsou speciálně optimalizována pro operace maticového násobení, které vyžadují modely strojového učení. Oproti tradičním datacentrům, která zpracovávají obecné výpočetní úlohy s nižšími nároky na energii (10–15 kW na rack), mají AI datacentra vyšší hustotu výkonu (až 600 kW na rack), pokročilé kapalinové chladicí systémy a specializovanou GPU infrastrukturu.

V roce 2023 spotřebovala datacentra 4,4 % celkové elektřiny v USA, s projekcemi 7–12 % do roku 2028. Jeden dotaz ChatGPT spotřebuje přibližně 2,9 watthodiny, přičemž generativní AI systémy spotřebují 10–30krát více elektřiny než úzce zaměřená AI. V USA se do roku 2030 očekává nárůst špičkové poptávky po elektřině o 30 gigawattů, převážně kvůli datacentrům.

Moderní AI datacentra využívají jak vzduchové, tak kapalinové chladicí systémy. Přímé kapalinové chlazení je účinnější a šetří elektřinu, ale spotřebovává vodu. Uzavřené kapalinové systémy minimalizují spotřebu vody při zachování efektivity. Ukazatel efektivity využití vody (WUE) se obvykle pohybuje kolem 1,9 litru na kilowatthodinu, přičemž plně uzavřené systémy se blíží nulové spotřebě vody.

Standardní výstavba hyperscale datacentra trvá 18–30 měsíců od konceptu po zprovoznění, včetně plánování (3–6 měsíců), návrhu a inženýringu (6–12 měsíců), povolení a schvalování (6–18 měsíců), výstavby (1–2 roky) a testování (3–6 měsíců). Nejrychlejším projektem v historii byla hala Colossus od XAI, dokončená za pouhých 122 dní.

Arshia je inženýr AI pracovních postupů ve FlowHunt. Sxa0vzděláním vxa0oboru informatiky a vášní pro umělou inteligenci se specializuje na vytváření efektivních workflow, které integrují AI nástroje do každodenních úkolů a zvyšují tak produktivitu i kreativitu.

Objevte, jak FlowHunt zefektivňuje generování AI obsahu, výzkum a publikaci — a využívá stejné principy infrastruktury, které pohání moderní datacentra.

Zjistěte, kdo vlastní hlavní AI chatboty v roce 2025. Seznamte se s OpenAI, Google, Microsoftem, Meta, Amazonem, Applem a s tím, jak vám FlowHunt umožňuje vytvá...

Zjistěte, co je AI chatbot GPT, jak funguje a proč je ChatGPT přední generativní AI řešení. Objevte architekturu transformerů, metody tréninku a reálné aplikace...

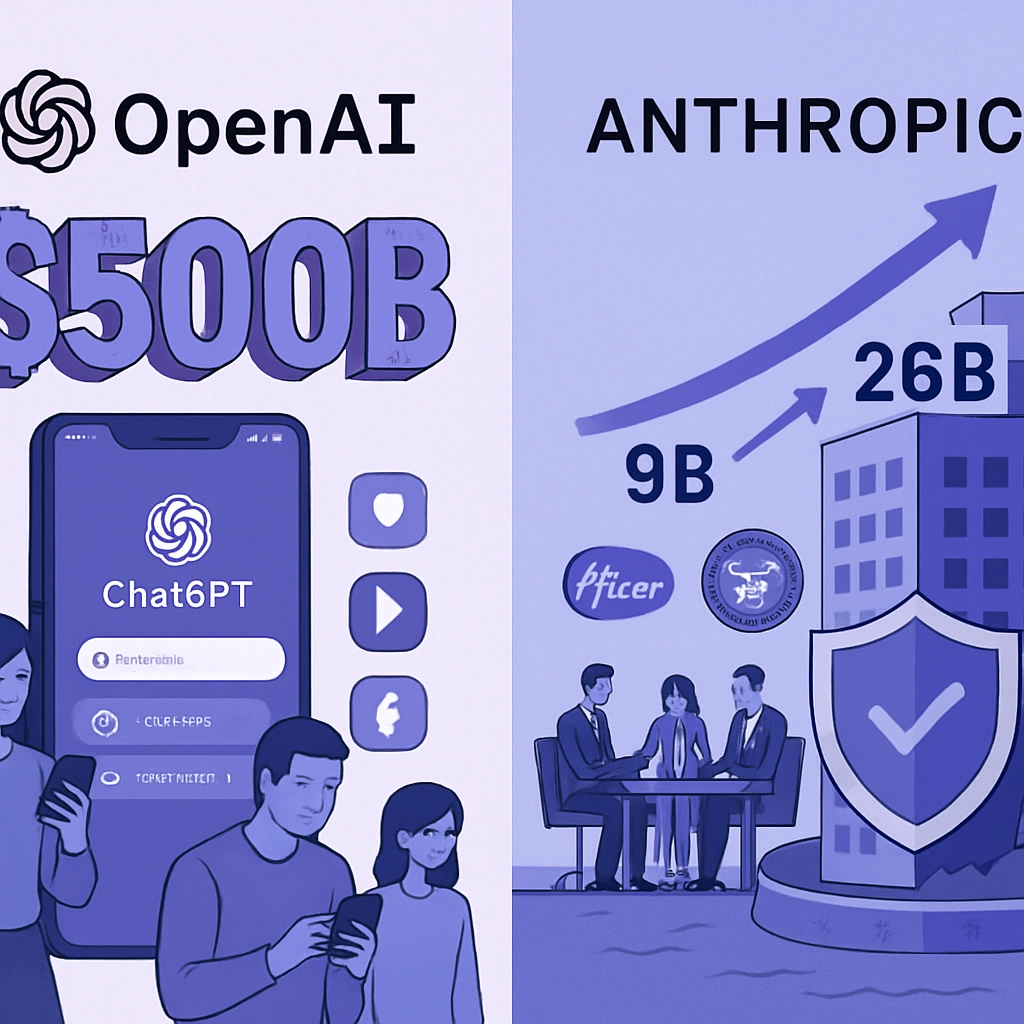

Valuace OpenAI ve výši 500 miliard dolarů čelí zpochybnění, protože komoditizované AI modely a open-source alternativy srovnávají podmínky na trhu. Objevte, pro...

Souhlas s cookies

Používáme cookies ke zlepšení vašeho prohlížení a analýze naší návštěvnosti. See our privacy policy.