Úvod

Oblast umělé inteligence prošla za poslední dva roky dramatickou proměnou, která zásadně změnila přístup organizací k optimalizaci a nasazování modelů. To, co začalo jako jasná příležitost destilovat drahé špičkové modely do levnějších a efektivnějších alternativ, se vyvinulo v komplexní ekosystém, v němž se posilované učení, open-source modely a inovativní postupy doladění staly stěžejními pro AI strategii. Tento článek mapuje cestu společnosti OpenPipe, která vznikla, aby řešila klíčový problém nákladného AI inference, a analyzuje širší trendy, které ovlivnily celý průmysl doladění. Díky postřehům Kylea Corbitta, spoluzakladatele a CEO OpenPipe (nedávno koupené CoreWeave), pochopíme, proč nakonec zvítězilo posilované učení a doladění jako dominantní přístup k optimalizaci AI modelů a co to znamená pro budoucnost AI infrastruktury.

Ekonomika nasazování AI modelů

Základ revoluce v doladění spočívá v pochopení ekonomických principů nasazování AI modelů. Když byl počátkem roku 2023 uveden GPT-4, znamenal bezprecedentní skok ve schopnostech, ale i v ceně. Organizace, které provozovaly produkční služby, čelily tvrdé realitě: používat špičkové modely typu GPT-4 pro každý inference bylo ekonomicky neudržitelné – některé firmy platily měsíčně stovky tisíc dolarů za API volání do OpenAI. To vytvořilo jasnou tržní neefektivitu, která vyžadovala řešení. Klíčové zjištění bylo jednoduché, ale silné: pokud dokážete zachytit konkrétní vzory a chování GPT-4 na vlastních use-casech, můžete tyto znalosti destilovat do menšího, levnějšího modelu, který bude pro vaše workflow fungovat téměř stejně dobře, ale s výrazně nižšími náklady. Nešlo o úplnou náhradu GPT-4, nýbrž o optimalizaci poměru cena/výkon v produkčních systémech, kde každé inference znamená náklady.

Problém však byl, že open-source modely dostupné v té době nebyly dostatečně kvalitní, aby mohly GPT-4 jednoduše nahradit. Modely jako Llama 2 byly sice na svou dobu působivé, ale stále měly výrazné kvalitativní mezery oproti špičkovým modelům. Vznikl tak trojitý tlak: špičkové modely byly příliš drahé, open-source příliš slabé a neexistovala jasná cesta, jak tuto mezeru efektivně překlenout. Trh potřeboval řešení, které by dokázalo schopnosti špičkových modelů systematicky převést do menších open-source modelů způsobem, který je technicky správný a zároveň jednoduše použitelný pro vývojáře.

Připraveni rozšířit své podnikání?

Začněte svou bezplatnou zkušební verzi ještě dnes a viďte výsledky během několika dní.

Vzestup destilace modelů a doladění jako služby

Objev doladění jako služby znamenal zásadní posun v přístupu organizací k optimalizaci AI modelů. Přístup OpenPipe byl záměrně navržen co nejjednodušeji pro vývojáře. Společnost vytvořila SDK, které fungovalo jako náhrada OpenAI SDK, takže vývojáři mohli v produkci dále používat GPT-4 bez nutnosti měnit kód. Na pozadí OpenPipe zachytával všechny požadavky a odpovědi, čímž vytvářel dataset reálných příkladů přesně vystihujících chování GPT-4 u konkrétních úloh dané organizace. Klíčovým poznatkem bylo, že nejlepší trénovací data pro doladění nejsou syntetická či obecná, ale právě reálné produkční dotazy a odpovědi reprezentující žádoucí chování. Po nasbírání dostatečného počtu příkladů mohly firmy spustit proces doladění, který naučil menší model napodobit chování GPT-4 na jejich specifických úlohách. Výsledkem byl API endpoint, který byl přímou náhradou – stačilo změnit inference URL a aplikace pokračovala s novým, levnějším modelem.

Tento přístup se na trhu rychle osvědčil. OpenPipe spustil produkt v srpnu 2023 a do měsíce získal první tři zákazníky. Hodnota řešení byla natolik přesvědčivá, že firma rychle dosáhla významných příjmů, přičemž během zhruba osmi měsíců od spuštění dosáhla ročního obratu milion dolarů. Rychlé přijetí ukázalo, že bolest trhu byla skutečná a firmy zoufale hledaly cesty ke snížení nákladů na AI infrastrukturu. První zákazníci byli typicky ti s největší bolestí – společnosti provozující rozsáhlé produkční služby s obrovskými API účty. Pro tyto firmy byla možnost snížit náklady 10× a více při zachování kvality naprosto zásadní. Kategorie doladění jako služby našla product-market fit a trh byl připraven tento přístup masově přijmout.

Zlatý věk open-source modelů a LoRA

Směřování podnikání OpenPipe významně ovlivnil nástup kvalitních open-source modelů, zejména Mistral a Mixtral. Tyto modely znamenaly přelom pro obor doladění, protože nabídly důvěryhodné alternativy k uzavřeným modelům s vynikajícími výkonnostními parametry. Zejména Mistral byl zjevením – překonal Llama 2 a nabízel plně otevřenou licenci Apache 2.0, což bylo v té době zásadní pro firmy dbající na licenční omezení a otázky IP. Dostupnost těchto modelů znamenala “zlaté období” startupů zaměřených na doladění, protože najednou existoval open-source základ dostatečně kvalitní pro doladění a nasazení do produkce. Organizace tak mohly vzít Mistral, doladit jej na své konkrétní úlohy a nasadit s jistotou, že mají schopný a právně nezatížený model.

V tomto období se objevila Low-Rank Adaptation (LoRA), která zásadně změnila ekonomiku doladění i inference. LoRA je metoda, která dramaticky snižuje počet trénovatelných parametrů během doladění, což přináší několik zásadních výhod. Jednak snižuje nároky na paměť během trénování, takže je možné doladit větší modely na menších GPU. Dále zrychluje trénink, což umožňuje rychlejší iterace doladění. Nejzásadnější benefit LoRA se však projeví při inference: při nasazení LoRA-adaptovaného modelu lze na jedné GPU multiplexovat mnoho různých LoRA adaptérů. Není tedy nutné mít samostatné GPU zdroje pro každý doladěný variant, ale je možné současně provozovat desítky až stovky LoRA adaptérů na jednom GPU. Tato architektonická výhoda umožnila zásadně jiný cenový model – místo účtování za GPU-hodinu (které motivuje vytěžování GPU nezávisle na skutečném využití) lze účtovat za tokeny a efektivitu přímo přenášet na zákazníky. Tento přechod z GPU-hodinového účtování na účtování za token znamenal zásadní inovaci v monetizaci a provozu AI inference.

Přihlaste se k odběru newsletteru

Získejte nejnovější tipy, trendy a nabídky zdarma.

FlowHunt a automatizace workflow doladění

S vývojem trhu doladění se stále více ukazovala potřeba sofistikované automatizace workflow. Organizace, které spravují více experimentů doladění, porovnávají různé architektury modelů a optimalizují hyperparametry, potřebují nástroje pro efektivní orchestraci těchto komplexních procesů. Právě zde nabývají na významu platformy jako FlowHunt – poskytují infrastrukturu pro automatizaci celého pipeline doladění, od přípravy dat a tréninku modelu po vyhodnocení a nasazení. FlowHunt umožňuje týmům vytvářet propracované workflow, které automaticky zachytává produkční data, spouští doladění při splnění určitých podmínek, vyhodnocuje výkon modelů vůči základním liniím a nasazuje nové modely do produkce s minimální ruční intervencí. Díky automatizaci těchto procesů mohou organizace rychleji iterovat své strategie doladění, experimentovat s různými postupy a kontinuálně zlepšovat modely bez nutnosti neustálého ručního dohledu. Možnost integrace platformy s různými poskytovateli AI infrastruktury a repozitáři modelů umožňuje budovat end-to-end automatizaci napříč celým životním cyklem AI vývoje.

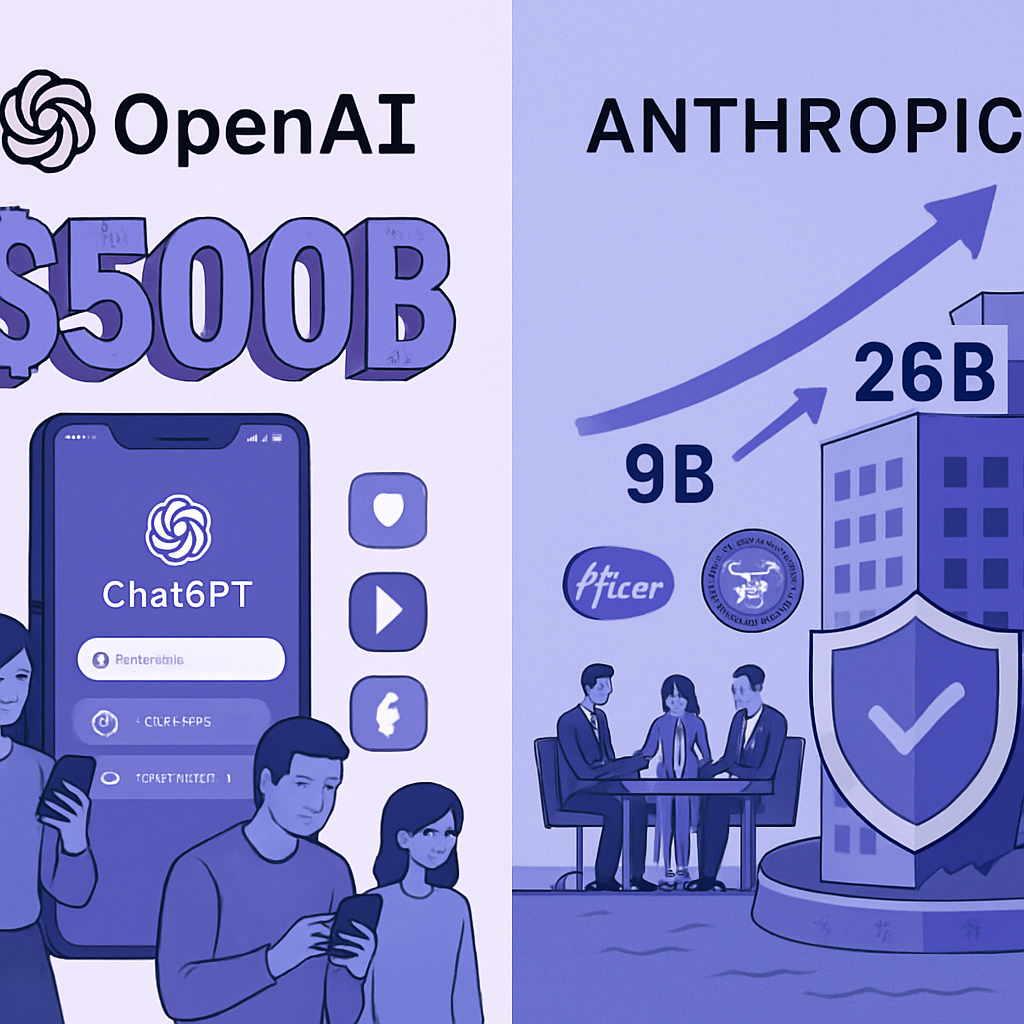

Konkurenční tlak a tržní konsolidace

Navzdory silnému startu a jasné tržní příležitosti čelily OpenPipe i další doladěcí firmy stále náročnějšímu konkurenčnímu prostředí. Hlavní tlak přicházel od špičkových laboratoří typu OpenAI, Anthropic a dalších, které průběžně uváděly stále schopnější modely za nižší ceny. To vytvořilo neustálý tlak na hodnotu služeb doladění – jakmile špičkové modely zlevňovaly a zlepšovaly se, úspory dosažené doladěním menšího modelu byly méně zajímavé. Model, který dříve dokázal ušetřit 10× nákladů, byl méně lákavý v době, kdy GPT-4 zlevnil pětinásobně. Navíc poskytovatelé GPU a cloudové infrastruktury začali nabízet funkce pro doladění přímo ve svých službách, protože doladění zvyšovalo loajalitu zákazníků a celkovou spotřebu infrastruktury. Tyto nabídky však často trpěly nedostatečnou uživatelskou přívětivostí – byly složité, špatně zdokumentované a neintegrované do workflow vývojářů. Proto hrozba konkurence v praxi nebyla tak silná, protože doladění od poskytovatelů GPU prostě z pohledu produktu nebylo dostatečně kvalitní.

Nejvýznamnější tlak však přišel díky neustálému zlepšování open-source modelů. Jak modely jako Llama 2, Mistral a později Llama 3 zvyšovaly svou kvalitu, zmenšovala se propast mezi open-source a špičkovými modely. Organizace tak stále častěji mohly využít open-source modely přímo bez potřeby doladění, případně si je doladit samy bez nutnosti specializované služby. Trh se posunul z “musíme destilovat GPT-4, protože je příliš drahý” k “můžeme rovnou použít open-source model”. Tento zásadní posun způsobil, že základní hodnota samostatných doladěcích služeb – tedy překlenutí propasti mezi drahými špičkovými a slabými open-source modely – postupně ztrácela význam. Okno příležitosti pro nezávislé firmy zaměřené na doladění se uzavíralo, protože trh se konsolidoval kolem větších poskytovatelů infrastruktury schopných nabídnout komplexní řešení od tréninku přes doladění až po inference.

Proč nakonec zvítězilo posilované učení

Název “Proč zvítězilo RL” odráží hlubší pravdu o vývoji optimalizace AI modelů: posilované učení a postupy doladění se staly dominantním paradigmata pro přizpůsobení AI modelů konkrétním úlohám. Toto vítězství nebylo nevyhnutelné – vzešlo z kombinace technických inovací, tržních sil i fundamentálních omezení alternativních přístupů. Posilované učení, zejména v kontextu doladění, umožňuje modely optimalizovat nejen na přesnost konkrétní úlohy, ale i na skutečné cíle důležité pro podnikání. Místo pouhého napodobování chování špičkového modelu umožňuje RL trénovat modely přímo na metriky, které mají význam – ať už jde o spokojenost uživatelů, úspěšnost dokončení úlohy či obchodní výsledky. Jde tak o sofistikovanější optimalizaci než prosté řízené doladění.

Vítězství RL a doladění zároveň odráží realitu, že univerzální modely, jakkoliv schopné, nikdy nebudou optimální pro všechny případy užití. Každá organizace má specifické požadavky, datové rozložení i výkonnostní cíle. Model doladěný na vašich datech, optimalizovaný na vaše cíle, překoná univerzální špičkový model u vašich úloh. Tento princip platí ve strojovém učení dekády a platí i v éře velkých jazykových modelů. Nástup metod jako LoRA umožnil ekonomicky výhodné doladění i menším organizacím a demokratizoval optimalizaci modelů. Dostupnost kvalitních open-source modelů poskytla základnu pro doladění bez nutnosti drahých API. Vývoj lepších trénovacích technik a infrastruktury zase učinil celý proces doladění rychlejší a spolehlivější. Tyto faktory společně vytvořily prostředí, v němž doladění a posilované učení byly přirozenou volbou pro organizace, které chtěly optimalizovat AI modely pro své konkrétní potřeby.

Akvizice a trend konsolidace

Akvizice OpenPipe společností CoreWeave představuje významný milník v konsolidaci prostoru AI infrastruktury. CoreWeave, přední poskytovatel GPU infrastruktury a AI výpočetní síly, si uvědomil, že doladění je klíčové pro jeho hodnotovou nabídku. Získáním OpenPipe získal nejen technologii a know-how, ale i tým s hlubokým porozuměním workflow doladění a potřeb organizací optimalizujících své AI modely. Tato akvizice odráží širší trend konsolidace specializovaných služeb do integrovaných platforem. Místo několika firem na modelový trénink, doladění, inference a monitoring směřuje trh k platformám zvládajícím celý AI lifecycle. Konsolidace dává smysl z více stran: snižuje tření pro zákazníky (už nemusí integrovat více služeb), vytváří síťové efekty díky těsné integraci komponent a umožňuje nabídnout konkurenceschopnější ceny díky optimalizaci napříč celým stackem.

Akvizice zároveň odráží skutečnost, že trh samostatných služeb doladění, ač reálný, byl nakonec příliš úzký na uživení více nezávislých firem. Trh byl tlačen z více směrů: špičkové modely zlevňovaly, open-source modely se zlepšovaly a poskytovatelé GPU integrovali doladění do svých nabídek. V tomto prostředí byla pro doladěcí firmu nejživotaschopnější cesta stát se součástí větší platformy, která nabídne komplexní řešení. Akvizice OpenPipe společností CoreWeave firmu staví do pozice nabídnout organizacím kompletní službu: GPU infrastrukturu, možnosti doladění i inference deployment – vše v rámci jedné platformy. Jde o přirozený vývoj trhu směrem k integrovaným platformám nabízejícím komplexní řešení napříč AI životním cyklem.

Imperativ vývojářské zkušenosti

Na celé cestě OpenPipe i v širším vývoji trhu s doladěním se stále opakuje jedno téma: vývojářská zkušenost je naprosto zásadní. Poskytovatelé GPU měli služby doladění, ale ty byly těžkopádné a špatně integrované do vývojářských workflow. OpenPipe uspěl zpočátku ne proto, že měl zcela unikátní technologii, ale proto, že nabídl radikálně lepší vývojářskou zkušenost. SDK jako drop-in náhrada, automatický sběr dat, jednoduché řízené workflow – vše bylo o zpřístupnění doladění a odstranění překážek pro vývojáře. Tento postřeh se ukázal jako mimořádně platný i s vývojem trhu. Nástup nových AI modelů a funkcí často nevyhrává díky čistě technické převaze, ale díky lepší vývojářské zkušenosti. Když Anthropic spustil Claude s povedeným API a dokumentací, vývojáři k němu přešli. Když OpenAI uvedlo GPT-4 s intuitivním rozhraním, stal se volbou číslo jedna ve firmách. Závěr je zřejmý: v AI infrastruktuře je vývojářská zkušenost základní konkurenční výhodou.

Tento princip platí i v širším ekosystému AI nástrojů a platforem. FlowHunt například uspívá díky nadstandardní vývojářské zkušenosti při tvorbě a automatizaci AI workflow. Místo nutnosti psát složité skripty či spravovat infrastrukturu přímo nabízí FlowHunt vizuální rozhraní a jednoduché abstrakce pro snadnou tvorbu pokročilých workflow. Právě důraz na vývojářský komfort umožňuje platformám získávat uživatele a vytvářet síťové efekty. S rostoucím počtem vývojářů vzniká více integrací, šablon a platforma se stává hodnotnější pro všechny. Tento pozitivní cyklus zlepšování vývojářské zkušenosti vedoucí k většímu přijetí je klíčovým motorem úspěchu v oblasti AI infrastruktury.

{{ cta-dark-panel

heading=“Zrychlete své workflow s FlowHunt”

description=“Vyzkoušejte, jak FlowHunt automatizuje obsahové a SEO workflow v AI – od výzkumu a generování obsahu až po publikaci a analytiku – vše na jednom místě.”

ctaPrimaryText=“Rezervovat demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Vyzkoušet FlowHunt zdarma”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Budoucnost doladění a optimalizace modelů

Při pohledu dopředu bude trh s doladěním dále reagovat na několik klíčových trendů. Zaprvé, jak se špičkové modely budou nadále zlepšovat a zlevňovat, hodnota doladění se posune od “zlevnění drahých modelů” k “optimalizaci modelů pro konkrétní úlohy a cíle”. To je sofistikovanější návrh hodnoty, který vyžaduje lepší nástroje pro pochopení, kdy je doladění přínosné, jak měřit jeho dopad a jak doladěné modely dlouhodobě zlepšovat. Zadruhé, integrace doladění do větších platforem AI infrastruktury bude pokračovat – firmy jako CoreWeave budou nabízet end-to-end řešení pokrývající výpočet, trénink, doladění i inference. Tato konsolidace usnadní firmám přijmout doladění jako součást AI strategie, ale zároveň sníží počet nezávislých firem v oboru. Zatřetí, techniky jako LoRA a další parametricky efektivní metody doladění nabudou na významu, protože organizace budou potřebovat spravovat komplexitu nasazení více doladěných variant. Schopnost provozovat mnoho různých doladěných modelů na sdílené infrastruktuře bude klíčovou konkurenční výhodou.

Nakonec nástup nových AI schopností a architektur modelů přinese další příležitosti pro doladění a optimalizaci. Jak budou modely stále schopnější a specializovanější, poroste potřeba doladění pro jejich přizpůsobení konkrétním úlohám. Vítězi na tomto proměnlivém trhu budou firmy a platformy, které dokáží učinit doladění jednodušším, rychlejším a efektivnějším. Příběh OpenPipe i širší trh s doladěním ukazuje, že v AI často vítězí ti, kdo dokáží spojit technickou inovaci s výjimečnou vývojářskou zkušeností a hlubokým pochopením potřeb zákazníků. Jak se trh bude dále vyvíjet, tyto principy zůstanou klíčem k úspěchu.

Závěr

Cesta OpenPipe od startupu řešícího vysoké náklady špičkových modelů až k akvizici pod CoreWeave ilustruje dynamiku trhu AI infrastruktury. Úspěch firmy, která dosáhla milionového ročního obratu za osm měsíců od spuštění, ukázal skutečnou poptávku po řešeních pro doladění modelů, avšak následná konsolidace odráží realitu, že samostatné služby doladění čelí strukturálním výzvám, jakmile špičkové modely zlevňují a open-source alternativy se zlepšují. Vítězství posilovaného učení a doladění jako dominantního paradigmatu optimalizace modelů nevychází z jediné technologické inovace, ale ze souhry více faktorů: dostupnosti kvalitních open-source modelů, vývoje efektivních technik doladění jako LoRA, nástupu lepší infrastruktury a nástrojů a základního principu, že specializované modely překonají univerzální. Akvizice OpenPipe firmou CoreWeave představuje přirozený vývoj směrem k integrovaným platformám schopným nabídnout komplexní řešení napříč AI životním cyklem. S dalším zráním trhu bude úspěch stále více záviset na nadstandardní vývojářské zkušenosti, hluboké integraci napříč AI stackem a schopnosti pomoci organizacím optimalizovat modely pro jejich konkrétní případy užití a obchodní cíle.