Introduktion

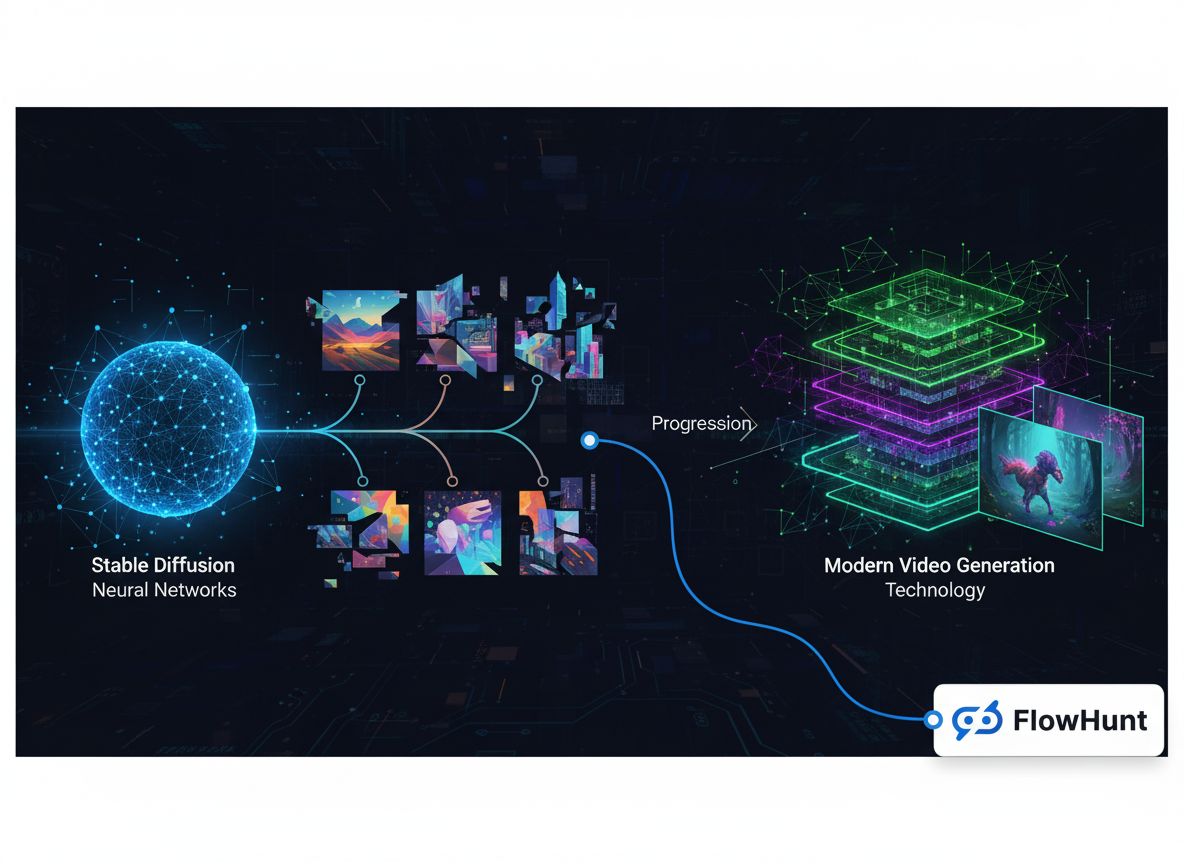

Landskabet for generative medier har gennemgået en bemærkelsesværdig forvandling de seneste år og er gået fra eksperimentelle forskningsprojekter til et milliardmarked inden for infrastruktur. Det, der begyndte som specialiserede billedgenereringsmodeller, er udvidet til et omfattende økosystem, der omfatter billedsyntese, videoproduktion, lydgenerering og avancerede redigeringsmuligheder. Denne tekniske historie udforsker, hvordan virksomheder som FAL byggede en forretning med over $100M i omsætning ved at identificere et kritisk hul i markedet: Udviklere havde brug for optimeret, skalerbar inferensinfrastruktur, der var designet specifikt til generative mediemodeller – ikke generisk GPU-orkestrering eller hosting af sprogmodeller. Rejsen fra Stable Diffusion 1.5 til moderne videomodeller som Veo3 afslører vigtige læringer om markedspositionering, teknisk specialisering og de infrastrukturkrav, der gør det muligt for AI-applikationer at skalere fra forskningsprototyper til produktionssystemer, der betjener millioner af udviklere.

Hvad er generative medier, og hvorfor er det vigtigt?

Generative medier repræsenterer en fundamentalt anderledes kategori af kunstig intelligens sammenlignet med de store sprogmodeller, der har domineret de seneste nyheder. Hvor sprogmodeller behandler tekst og genererer svar baseret på indlærte mønstre, skaber generative mediesystemer visuelt og lydmæssigt indhold—billeder, videoer, musik og lydeffekter—ud fra tekstbeskrivelser, eksisterende billeder eller andre inputmodaliteter. Denne forskel er mere end semantisk; den afspejler dybtgående forskelle i tekniske krav, markedsdynamik og forretningsmuligheder. Generative mediemodeller opererer under andre beregningsmæssige begrænsninger, kræver specialiserede optimeringsteknikker og understøtter anvendelser, som traditionel sprogmodelinfrastruktur ikke effektivt kan håndtere. Fremkomsten af generative medier har skabt en helt ny kategori af infrastrukturselskaber, der fokuserer specifikt på at optimere inferens for disse modeller, så udviklere kan integrere avancerede billed- og videogenereringsmuligheder i deres applikationer uden at skulle håndtere komplekse GPU-udrulninger eller ineffektiv ressourceudnyttelse.

De tekniske krav til inferens for generative medier adskiller sig markant fra dem for sprogmodeller. Billedgenereringsmodeller som Stable Diffusion og Flux arbejder via iterative diffusionsprocesser, der kræver omhyggelig hukommelsesstyring, præcis timingoptimering og effektiv batchbehandling. Videogenerering tilføjer et yderligere lag af kompleksitet, da det kræver tidsmæssig konsistens, lydsynkronisering og væsentligt højere beregningsressourcer. Disse krav kan ikke imødekommes effektivt af generiske GPU-orkestreringsplatforme eller inferensservices til sprogmodeller. I stedet kræver de specialiseret infrastruktur, der er opbygget fra bunden til at håndtere de unikke egenskaber ved diffusionsmodeller, autoregressiv billedgenerering og videosyntese. Virksomheder, der tidligt identificerede dette hul—og investerede i at bygge skræddersyet infrastruktur—positionerede sig til at vinde betydelige markedsandele i takt med, at generative medier blev mere udbredt på tværs af brancher.

Klar til at vokse din virksomhed?

Start din gratis prøveperiode i dag og se resultater inden for få dage.

Forretningscasen for specialisering: Hvorfor generative medier frem for sprogmodeller

Beslutningen om at specialisere sig i generative medier i stedet for at forfølge den tilsyneladende mere oplagte vej med hosting af sprogmodeller repræsenterer et af de mest betydningsfulde strategiske valg i den nyere AI-infrastrukturhistorie. Da FAL’s grundlæggere vurderede deres muligheder omkring 2022-2023, stod de over for et afgørende valg: Skulle de udvide deres Python-runtime til en generel inferensplatform for sprogmodeller, eller skulle de satse på det spirende marked for generative medier? Svaret afslører vigtige indsigter om markedsdynamik, konkurrencepositionering og betydningen af at vælge kampe, hvor man kan vinde. Hosting af sprogmodeller virkede attraktivt på grund af den enorme opmærksomhed og finansiering, der tilflød store sprogmodeller, men det præsenterede et umuligt konkurrencebillede. OpenAI havde allerede etableret GPT som den dominerende model med en massiv brugerbase og indtægtsstrøm. Anthropic var i gang med at bygge Claude med betydelig opbakning og teknisk talent. Google, Microsoft og andre teknologigiganter investerede milliarder i deres egne sprogmodelinfrastrukturer. For en startup ville det betyde direkte konkurrence med virksomheder med langt større ressourcer, etablerede markedspositioner og evnen til at tilbyde adgang til sprogmodeller til kostpris eller endda med tab, hvis det tjente deres strategiske interesser.

Markedet for generative medier præsenterede derimod en fundamentalt anderledes konkurrencesituation. Da Stable Diffusion 1.5 blev udgivet i 2022, opstod der straks behov for optimeret inferensinfrastruktur, men ingen klar markedsleder var dukket op. Modellen var open source, hvilket betød, at alle kunne downloade og køre den, men de fleste udviklere manglede ekspertise og ressourcer til effektiv optimering. Dette skabte en perfekt mulighed for et specialiseret infrastrukturselskab. FAL indså, at udviklere ønskede at bruge modellerne uden at håndtere kompleks GPU-udrulning, modeloptimering og skalering. Ved at fokusere udelukkende på generative medier kunne FAL blive eksperten på dette område, opbygge dybe relationer til modeludviklere og positionere sig som den foretrukne platform for inferens af generative medier. Denne specialiseringsstrategi viste sig yderst effektiv, og FAL voksede fra et vendepunkt til en virksomhed, der betjener 2 millioner udviklere og hoster over 350 modeller, med en årlig omsætning på over $100 millioner.

Forståelse af generativ medieinfrastruktur og optimering

Det tekniske fundament for moderne generative medieplatforme hviler på avanceret inferensoptimering, der rækker langt ud over blot at køre modeller på GPU’er. Da udviklere først begyndte at bruge Stable Diffusion 1.5, forsøgte mange at udrulle den selv på generisk cloud-infrastruktur eller lokale GPU’er. Denne tilgang afslørede kritiske ineffektiviteter: Modellerne var ikke optimeret til den specifikke hardware, de kørte på, hukommelse blev spildt via ineffektiv batching, og udnyttelsesgraden var lav, fordi hver brugers arbejdsbyrde var isoleret. En udvikler kunne udnytte kun 20-30% af GPU-kapaciteten, men betale for 100%. Dette spild skabte en mulighed for en platform, der kunne aggregere efterspørgslen på tværs af brugere, optimere inferens til specifikke hardwarekonfigurationer og opnå langt højere udnyttelsesgrad gennem intelligent batching og planlægning. FAL’s tilgang bestod i at bygge brugerdefinerede CUDA-kerner—lavniveaukode til GPU’er, optimeret til specifikke operationer i generative modeller—der kunne forbedre ydeevnen markant sammenlignet med generiske implementeringer.

Infrastrukturudfordringen rækker ud over simpel ydelsesoptimering. Generative mediemodeller har unikke egenskaber, der kræver specialiseret håndtering. Diffusionsmodeller, der driver de fleste billedgenereringssystemer, fungerer gennem en iterativ proces, hvor modellen gradvist forfiner tilfældig støj til sammenhængende billeder over mange trin. Hvert trin kræver omhyggelig hukommelsesstyring for at undgå at løbe tør for GPU-hukommelse, og processen skal være hurtig nok til at give acceptabel latenstid for interaktive applikationer. Videogenerering tilføjer tidsdimensioner, hvor modeller skal opretholde konsistens på tværs af billeder, mens der genereres indhold i høj kvalitet med 24 eller 30 billeder pr. sekund. Lydmodeller har deres egne krav, herunder realtidsbehandling for nogle applikationer og højfidelitetsoutput for andre. En platform, der understøtter alle disse modaliteter, skal opbygge dyb ekspertise på hvert område og forstå de specifikke optimeringsmuligheder og begrænsninger for hver modeltype. Denne specialisering gør infrastrukturselskaber for generative medier værdifulde – de akkumulerer viden og optimeringsteknikker, som individuelle udviklere ikke let kan kopiere.

Tilmeld dig vores nyhedsbrev

Få de seneste tips, trends og tilbud gratis.

Udviklingen af billedgenereringsmodeller: Fra Stable Diffusion til Flux

Historien om generative medier kan spores gennem udviklingen af billedgenereringsmodeller, hvor hver model markerer et væsentligt vendepunkt i markedets udvikling. Stable Diffusion 1.5, udgivet i 2022, var katalysatoren, der forvandlede generative medier fra en akademisk nysgerrighed til et praktisk værktøj, udviklere faktisk kunne bruge. Modellen var open source, relativt effektiv sammenlignet med tidligere diffusionsmodeller og producerede billeder i rimelig kvalitet til mange brugsscenarier. For FAL repræsenterede Stable Diffusion 1.5 det øjeblik, hvor de genkendte muligheden for at pivotere hele virksomheden. De begyndte at tilbyde en optimeret, API-klar version af modellen, som udviklere kunne kalde uden at skulle styre egen GPU-infrastruktur. Responsen var overvældende – udviklere så straks værdien i ikke at håndtere udrulningskompleksitet, og Stable Diffusion 1.5 blev FAL’s første store indtægtskilde. Udover basismodellen eksploderede økosystemet for finjustering omkring Stable Diffusion 1.5. Udviklere skabte LoRAs (Low-Rank Adaptations)—lette modelmodifikationer, der kunne tilpasse basismodellen til specifikke brugsscenarier, f.eks. særlige kunststile, bestemte ansigter eller unikke objekter. Dette økosystem skabte en positiv spiral, hvor flere finjusteringsmuligheder gjorde platformen mere værdifuld, tiltrak flere udviklere og skabte flere muligheder for finjustering.

Stable Diffusion 2.1, udgivet som opfølger, blev et advarende eksempel på vigtigheden af modelkvalitet i markedet for generative medier. På trods af at være teknisk mere avanceret på nogle områder blev SD 2.1 bredt opfattet som et tilbageskridt i billedkvalitet, især for menneskelige ansigter og komplekse scener. Modellen fik aldrig rigtig fodfæste, og mange udviklere fortsatte med at bruge den ældre 1.5-version. Denne erfaring lærte markedet, at kvalitet betyder mere end teknisk sofistikering. Brugerne er optaget af det output, de kan skabe, ikke den bagvedliggende arkitektur eller træningsmetode. Stable Diffusion XL (SDXL), udgivet i 2023, var et reelt spring fremad i kvalitet og kapabilitet. SDXL kunne generere billeder i højere opløsning med bedre detaljegrad og mere nøjagtig tekstrendering. For FAL var SDXL transformerende – det var den første model, der genererede $1 million i omsætning for platformen. Modellens succes accelererede også økosystemet for finjustering, da udviklere skabte tusindvis af LoRAs for at tilpasse SDXL til specifikke formål. SDXL’s succes demonstrerede, at der var betydelig kommerciel efterspørgsel efter billedgenerering i høj kvalitet, og det bekræftede FAL’s beslutning om at specialisere sig i dette marked.

Lanceringen af Flux-modeller fra Black Forest Labs i 2024 markerede et andet vigtigt vendepunkt. Flux repræsenterede den første generation af modeller, der med rette kunne kaldes “kommercielt brugbare” og “enterprise-klar”. Kvaliteten var væsentligt højere end tidligere modeller, genereringshastigheden var tilstrækkelig til produktionsbrug, og resultaterne var konsistente nok til, at virksomheder kunne bygge produkter omkring dem. For FAL var Flux transformerende: Platformens omsætning steg fra $2 millioner til $10 millioner i den første måned efter Flux’ lancering, og derefter til $20 millioner måneden efter. Denne eksplosive vækst afspejlede den opsparede efterspørgsel efter billedgenerering i høj kvalitet, der pålideligt kunne bruges kommercielt. Flux kom i flere versioner—Schnell (en hurtig, destilleret version), Dev (en version af højere kvalitet med ikke-kommerciel licens) og Pro (der krævede samarbejde om hosting)—hver med forskellige brugsscenarier og prispunkter. Succesen med Flux viste også, at markedet for generative medier var blevet så modent, at virksomheder var parate til at investere betydeligt i billedgenerering, ikke kun eksperimentere med teknologien.

Skiftet til video: Et nyt markedssegment

Mens billedgenerering tiltrak betydelig opmærksomhed og omsætning, repræsenterede fremkomsten af praktiske videogenereringsmodeller en helt ny markedsmulighed. Tidlige tekst-til-video-modeller, herunder OpenAI’s Sora, viste, hvad der var teoretisk muligt, men var enten ikke bredt tilgængelige eller leverede resultater, der var interessante forskningsmæssigt, men ikke praktisk anvendelige for de fleste. Videoerne var ofte uden lyd, havde tidsmæssige uoverensstemmelser og manglede den finish, der kræves til professionelt brug. Dette ændrede sig markant med lanceringen af modeller som Veo3 fra Google DeepMind, der repræsenterede et reelt gennembrud i videogenereringskvalitet. Veo3 kunne generere videoer med synkroniseret lyd, korrekt timing og pacing, præcis lip-sync til talende ansigter og visuel kvalitet, der nærmede sig professionelle standarder. Modellen var dyr at køre—væsentligt mere ressourcekrævende end billedgenerering—men kvaliteten retfærdiggjorde omkostningen for mange.

Indvirkningen af videogenerering i høj kvalitet på FAL’s forretning var betydelig. Videogenerering skabte en helt ny indtægtskilde og tiltrak en anden type kunder. Hvor billedgenerering primært blev brugt af individuelle udviklere, designere og små kreative teams, tiltrak videogenerering større virksomheder, der ønskede at skabe reklameindhold, markedsføringsvideoer og andre professionelle applikationer. FAL indgik partnerskaber med flere videomodelleverandører, herunder Alibaba’s One, Kuaishou’s Kling og andre, for at tilbyde et komplet udvalg af videogenereringsmuligheder. Platformens omsætningsvækst accelererede yderligere, efterhånden som video blev en voksende del af det samlede forbrug. De tekniske udfordringer ved videogenerering drev også innovation i FAL’s infrastruktur – videomodeller krævede andre optimeringsstrategier end billedmodeller, hvilket nødvendiggjorde nye brugerdefinerede kerner og arkitekturer. Successen med videogenerering bekræftede også FAL’s strategi om at bygge en platform, der kunne understøtte flere modaliteter. I stedet for kun at specialisere sig i billedgenerering havde FAL opbygget en infrastruktur, der var fleksibel nok til også at rumme video- og lydmodeller og positionerede sig dermed som den samlede platform for generative medier.

FlowHunts tilgang til generative mediearbejdsgange

Da generative medier er blevet stadig mere centrale for indholdsskabelse og applikationsudvikling, er platforme som FlowHunt opstået for at hjælpe udviklere og teams med at håndtere kompleksiteten i at integrere disse muligheder i deres arbejdsgange. FlowHunt erkender, at selvom platforme som FAL har løst infrastrukturopgaven med effektiv drift af generative mediemodeller, står udviklere stadig over for udfordringer med at orkestrere modellerne i større applikationsforløb. En typisk applikation kan omfatte flere trin: modtagelse af brugerforespørgsel, behandling og validering af input, kald til en eller flere generative modeller, efterbehandling af resultater, lagring af output og håndtering af analyse. FlowHunt tilbyder værktøjer, der automatiserer og optimerer disse processer, så udviklere kan fokusere på applikationslogik frem for infrastrukturhåndtering. Ved integration med platforme som FAL giver FlowHunt udviklere mulighed for at bygge avancerede generative medieapplikationer uden at håndtere den underliggende kompleksitet ved modeldrift, optimering og skalering.

FlowHunts tilgang til generative mediearbejdsgange lægger vægt på automatisering, pålidelighed og gennemsigtighed. Platformen gør det muligt for udviklere at definere arbejdsgange, der kæder flere generative medieoperationer sammen, håndterer fejl elegant og giver indsigt i processen på hvert trin. For eksempel kan en arbejdsgang til indholdsskabelse involvere generering af flere billedvariationer, udvælgelse af det bedste baseret på kvalitetsmålinger, anvendelse af efterbehandlingseffekter og derefter publicering af resultatet. FlowHunt gør det muligt at definere hele denne proces deklarativt, med automatisk retry-logik, fejlhåndtering og overvågning. Dette abstraktionslag er særligt værdifuldt for teams, der bygger produktionsapplikationer, som skal generere indhold pålideligt i stor skala. Ved at håndtere orkestrering og workflow-styring kan udviklere koncentrere sig om kreativ og forretningsmæssig logik, mens FlowHunt tager sig af den tekniske kompleksitet.

Den tekniske fordybelse: Brugerdefinerede kerner og ydelsesoptimering

Den bemærkelsesværdige vækst i FAL’s forretning og kvaliteten af deres service bygger på et fundament af avanceret teknisk optimering, som de fleste brugere aldrig ser. Platformen har udviklet over 100 brugerdefinerede CUDA-kerner—specialiseret GPU-kode skrevet i NVIDIA’s CUDA-sprog—som optimerer specifikke operationer i generative mediemodeller. Disse kerner repræsenterer tusindvis af ingeniørtimer fokuseret på at udnytte GPU-hardware optimalt. Motivation for denne grad af optimering er enkel: Hver millisekund, der spares på latenstid, forbedrer brugeroplevelsen og sænker infrastrukturudgifterne. En model, der kan generere et billede 20% hurtigere, betyder, at den samme GPU kan betjene 20% flere brugere, hvilket direkte gavner platformens økonomi. At skrive brugerdefinerede kerner er dog en betydelig udfordring. CUDA-programmering kræver dyb forståelse af GPU-arkitektur, hukommelseshierarkier og parallelle beregningsprincipper. Det er ikke noget, man hurtigt lærer eller kan anvende generisk – hver kerne skal fintunes til specifikke operationer og hardware.

Optimeringsprocessen starter med profilering – at forstå, hvor tiden faktisk bruges under modelkørsel. Mange udviklere antager, at de mest beregningstunge operationer er flaskehalsen, men profilering afslører ofte overraskelser. Nogle gange er det dataoverførslen mellem GPU-hukommelse og compute-enheder, der er flaskehalsen, ikke selve beregningen. Andre gange er det overhead ved at starte mange små GPU-operationer frem for at batch’e dem. FAL’s ingeniører profilerer modellerne grundigt, identificerer de reelle flaskehalse og skriver derefter brugerdefinerede kerner til at løse dem. For eksempel kan de skrive en kerne, der samler flere operationer, hvilket reducerer hukommelsestrafik og overhead. Eller de kan skrive en kerne, der er optimeret til de specifikke dimensioner og datatype, en model bruger. Denne grad af optimering kan kun betale sig økonomisk, hvis man betjener millioner af brugere – investeringen i kerneudvikling tjener sig hjem gennem forbedret effektivitet og lavere infrastrukturudgifter.

Ud over individuel kerneoptimering har FAL investeret i arkitektoniske forbedringer af modelserving. Platformen benytter teknikker som modelkvantisering (reducering af præcisionen af modelvægtninger for at bruge mindre hukommelse og beregning), dynamisk batching (gruppering af forespørgsler for at forbedre GPU-udnyttelsen) og anmodningsprioritering (så latenstidsfølsomme forespørgsler prioriteres over throughput-orienterede). Disse teknikker kræver omhyggelig implementering for at bevare kvaliteten og samtidig forbedre effektiviteten. Kvantisering kan f.eks. reducere modelstørrelse og forbedre hastighed, men hvis det gøres forkert, går det ud over outputkvaliteten. FAL’s ingeniører har udviklet avancerede kvantiseringsstrategier, der bevarer kvaliteten, mens de opnår store effektivitetsgevinster. Dynamisk batching kræver forudsigelse af, hvor lang tid hver forespørgsel tager, og gruppering af dem for at maksimere GPU-udnyttelsen uden at øge latenstiden for meget. Disse arkitektoniske forbedringer, kombineret med brugerdefineret kerneoptimering, gør det muligt for FAL at opnå ydelse, der ikke er mulig med generisk infrastruktur.

Markedsdynamik og konkurrencesituationen

Markedet for generative medier har udviklet sig hurtigt, med nye modeller og muligheder, der konstant dukker op. Forståelse af konkurrencesituationen og markedets struktur er afgørende for at værdsætte, hvorfor specialiserede platforme som FAL er blevet så værdifulde. Markedet kan groft opdeles i flere segmenter: billedgenerering, videogenerering, lydgenerering og redigerings-/manipulationsværktøjer. Inden for hvert segment konkurrerer flere modeller på kvalitet, hastighed, pris og specifikke egenskaber. For billedgenerering omfatter markedet varianter af Stable Diffusion, Flux-modeller, Googles Gemini Image-modeller og diverse specialiserede modeller til fx logogenerering eller ansigtsgenerering. For videogenerering inkluderer landskabet Veo3, Alibaba’s One, Kuaishou’s Kling og andre. Denne modeldiversitet skaber både muligheder og udfordringer for infrastruktursplatforme. Muligheden er, at ingen enkelt model dominerer alle brugsscenarier – forskellige modeller er bedst til forskellige ting, så en platform, der kan betjene flere modeller, bliver mere værdifuld. Udfordringen er, at understøttelse af mange modeller kræver betydelige ingeniørressourcer for at optimere hver enkelt.

FAL’s strategi har været at udvælge et sortiment af modeller, der tilsammen dækker de vigtigste brugsscenarier og samtidig opretholder høj kvalitet. I stedet for at tilføje enhver model, der lanceres, evaluerer FAL nye modeller nøje og tilføjer kun dem, der tilfører unikke muligheder eller markant bedre kvalitet end eksisterende alternativer. Denne kuraterede tilgang har flere fordele. For det første sikrer den, at platformens modeludvalg er af høj kvalitet og anvendeligt, i stedet for at oversvømme brugerne med for mange middelmådige alternativer. For det andet gør den det muligt for FAL at fokusere optimeringsindsatsen på modeller, der faktisk bliver brugt, frem for at sprede ressourcerne for tyndt. For det tredje skaber det en positiv spiral, hvor platformens ry for kvalitet tiltrækker både brugere og modelskabere. Modelskabere vil have deres modeller på FAL, fordi de ved, at platformens brugere går op i kvalitet. Brugere vil bruge FAL, fordi de ved, at de tilgængelige modeller er nøje udvalgt og veloptimerede. Denne feedback-loop har været afgørende for FAL’s succes.

Konkurrencesituationen inkluderer også andre infrastruktursplatforme for generative medier samt direkte konkurrence fra modelskabere, der tilbyder deres egen hosting. Nogle modelskabere, som Stability AI, har tilbudt deres egne inferens-API’er. Andre, som Black Forest Labs med Flux, har indgået samarbejde med platforme som FAL frem for at bygge egen infrastruktur. Valget mellem samarbejde og egen hosting er strategisk – det kræver betydelige ressourcer og driftsekspertise at bygge egen infrastruktur, mens samarbejde gør det muligt at fokusere på modeludvikling. For de fleste modelskabere giver samarbejde med specialiserede platforme som FAL mere mening end selv at bygge infrastruktur. Denne dynamik har skabt et sundt økosystem, hvor modelskabere fokuserer på forskning og udvikling, mens infrastruktursplatforme fokuserer på optimering og skalering.

Omsætningsmodel og forretningsmålinger

Forståelsen af FAL’s forretningsmodel og nøgletal giver indsigt i, hvordan infrastrukturselskaber for generative medier skaber værdi og vokser. FAL opererer med en forbrugsbaseret prismodel, hvor kunder betaler efter antal API-kald og de beregningsressourcer, de bruger. Denne model giver gode incitamenter – kunder betaler mere, når de bruger mere, og FAL’s omsætning vokser, efterhånden som platformen bliver mere værdifuld og udbredt. Platformens væksttal er imponerende: 2 millioner udviklere på platformen, 350+ modeller tilgængelige og over $100 millioner i årlig omsætning. Disse tal afspejler betydelig skala, men også at markedet for generative medier stadig er i sin tidlige fase. Markedspenetrationen blandt potentielle brugere er stadig lav, og mange brugsscenarier er endnu ikke udforsket. Omsætningsvæksten er accelereret, især med lanceringen af videogenerering. Platformens omsætning sprang fra $2 millioner til $10 millioner i den første måned efter Flux’ lancering, hvilket viser effekten af modeller i høj kvalitet på indtægten.

Forretningsmålingerne afslører også vigtige indsigter om markedsdynamikken. At FAL har opnået over $100M i årlig omsætning med 2 millioner udviklere antyder, at den gennemsnitlige omsætning pr. bruger er relativt lav—måske $50-100 om året. Det afspejler, at mange brugere eksperimenterer eller bruger generative medier i lille skala. Men fordelingen er sandsynligvis meget skæv, hvor et lille antal stormbrugere genererer en stor del af omsætningen. Disse stormbrugere er typisk virksomheder, der bygger generative mediefunktioner ind i deres produkter eller services. Efterhånden som markedet modnes, og flere virksomheder integrerer generative medier i deres kerneforretning, vil den gennemsnitlige omsætning pr. bruger sandsynligvis stige betydeligt. Platformens vækstkurve antyder, at generativ medieinfrastruktur stadig er i de tidlige stadier af en langsigtet vækstkurve, med betydelige muligheder forude.

Avanceret indsigt: Finjustering og tilpasningens rolle

En af de vigtigste udviklinger på markedet for generative medier har været fremkomsten af finjustering og tilpasning, der gør det muligt for brugere at tilpasse modeller til specifikke formål. Finjustering indebærer, at man tager en fortrænet model og træner den yderligere på domænespecifik data for at forbedre ydelsen på bestemte opgaver. For billedgenerering har dette især taget form af LoRAs (Low-Rank Adaptations), som er lette modelmodifikationer, der kan tilpasse basismodellen uden fuld gen-træning. En designer kan fx lave en LoRA, der lærer modellen at generere billeder i en bestemt kunststil. En fotograf kan lave en LoRA, der fanger deres særlige æstetik. En virksomhed kan lave en LoRA, der genererer billeder af deres produkter i specifikke sammenhænge. LoRA-økosystemet er blevet en afgørende del af markedet for generative medier, med tusindvis af LoRAs tilgængelige for populære modeller som Stable Diffusion og SDXL.

Fremkomsten af finjustering har væsentlige implikationer for infrastruktursplatforme som FAL. Understøttelse af finjustering kræver yderligere funktioner ud over blot at betjene basismodeller. Platformen skal tilbyde værktøjer til brugerne til at oprette og administrere LoRAs, lagre dem effektivt og betjene dem sammen med basismodeller. Den skal også håndtere de tekniske udfordringer ved at kombinere basismodeller med LoRAs under inferens, så kombinationen giver høj kvalitet uden unødig latenstid. FAL har investeret betydeligt i disse funktioner og anerkender, at finjustering er en væsentlig del af værdien for mange brugere. Platformens støtte til finjustering har været en væsentlig faktor i succesen og gør det muligt for brugere at tilpasse modeller til deres behov, samtidig med at de drager fordel af platformens optimering og skalering. Efterhånden som markedet modnes, vil finjustering og tilpasning sandsynligvis blive endnu vigtigere, idet virksomheder investerer i skræddersyede modeller til deres særlige formål.

Fremtiden for generativ medieinfrastruktur

Fremadrettet vil markedet for generativ medieinfrastruktur sandsynligvis fortsætte den hurtige udvikling. Flere trends vil forme fremtiden. For det første vil modeller fortsætte med at forbedres i kvalitet og kapabilitet, hvilket muliggør nye anvendelser og tiltrækker nye brugere. Videogenerering er stadig i sin tidlige fase, og efterhånden som modellerne forbedres, vil videogenerering sandsynligvis blive lige så udbredt som billedgenerering. Lydgenerering og musikskabelse er nye områder under udvikling, hvor modeller som PlayHD og andre viser lovende takter. For det andet vil markedet sandsynligvis konsolidere sig omkring færre dominerende modeller og platforme, ligesom billedgenerering er blevet centreret om varianter af Stable Diffusion og Flux. Denne konsolidering vil skabe muligheder for specialiserede platforme, der optimerer for