Introduktion

Kontekst-engineering er blevet en af de mest afgørende discipliner i opbygningen af effektive AI-agenter. Efterhånden som sprogmodeller bliver mere kraftfulde og agenter skal løse stadigt mere komplekse, flertrinsopgaver, handler udfordringen ikke kun om at have en dygtig model – det handler om strategisk at styre, hvilken information du fodrer modellen med. Hver token tæller. I denne omfattende guide udforsker vi, hvad kontekst-engineering er, hvorfor det er essentielt for AI-agenter, og de konkrete teknikker, som førende AI-forskningsorganisationer og platforme bruger til at bygge optimale agenter. Uanset om du bygger kundeservicebots, dataanalyseagenter eller autonome workflows, vil forståelsen af kontekst-engineering fundamentalt forbedre, hvordan dine AI-systemer præsterer.

Hvad er kontekst-engineering?

Kontekst-engineering repræsenterer et grundlæggende skift i, hvordan vi tænker omkring opbygning med store sprogmodeller. I stedet for at se LLM’en som en black box, der blot skal have gode instruktioner, behandler kontekst-engineering modellen som et system med begrænsede kognitive ressourcer, der skal styres omhyggeligt. I sin kerne er kontekst-engineering praksissen med at vide præcis, hvilken kontekst der skal gives til en AI-agent – at overveje bevidst hver eneste token, der flyder gennem hvert LLM-kald for at skabe de optimale betingelser for, at agenten kan få succes.

Dette koncept er blevet populært gennem forskere som Andrej Karpathy og er blevet stadigt vigtigere, efterhånden som AI-agenter er udviklet fra simple chatbots til sofistikerede systemer, der kan ræsonnere og handle autonomt. Den grundlæggende indsigt er, at LLM’er – ligesom mennesker – har begrænset arbejdshukommelse og opmærksomhedskapacitet. Ligesom et menneske kun kan fokusere på en vis mængde information ad gangen, før det bliver forvirret eller mister vigtige detaljer, oplever sprogmodeller forringelse i deres ræsonnementsevner, når de præsenteres for for meget kontekst. Det betyder, at kontekstkvalitet er langt vigtigere end kvantitet.

Kontekst-engineering går videre end traditionel prompt engineering, som primært handlede om at udforme den perfekte systemprompt eller instruktioner. I stedet omfatter det hele økosystemet af information, der er tilgængeligt for en agent på tværs af flere interaktioner – inklusive systemprompts, værktøjsdefinitioner, eksempler, beskedhistorik, hentede data og dynamisk indlæst information. Målet er at opretholde et slankt, signalstærkt kontekstvindue, der giver agenten præcis det, den har brug for til at træffe gode beslutninger uden at overvælde den med irrelevant information.

Klar til at vokse din virksomhed?

Start din gratis prøveperiode i dag og se resultater inden for få dage.

Hvorfor kontekst-engineering er vigtig for at bygge kompetente AI-agenter

Vigtigheden af kontekst-engineering kan ikke overvurderes, når man bygger produktionsklare AI-agenter. Forskning har konsekvent vist, at LLM’er oplever det, der kaldes “context rot” – en målbar forringelse af ydeevnen, efterhånden som kontekstvinduet vokser. Studier med “needle-in-a-haystack”-benchmarking har demonstreret, at efterhånden som antallet af tokens i konteksten øges, falder modellens evne til præcist at huske og ræsonnere over denne information. Dette er ikke en lille effekt; det er en grundlæggende arkitektonisk begrænsning i, hvordan transformerbaserede sprogmodeller fungerer.

Årsagen til denne forringelse ligger i selve transformer-arkitekturen. I transformers kan hver token have opmærksomhed på alle andre tokens i konteksten, hvilket skaber n² parvise relationer for n tokens. Efterhånden som kontekstlængden øges, bliver modellens opmærksomhedsmekanisme presset til det yderste for at opretholde disse relationer over et stadigt større rum. Derudover er sprogmodeller primært trænet på kortere sekvenser og har derfor mindre erfaring med og færre specialiserede parametre til at håndtere meget langtrækkende afhængigheder. Dette skaber en naturlig spænding mellem kontekststørrelse og ræsonnementsevne – modeller forbliver funktionelle ved længere kontekster, men viser nedsat præcision i informationshentning og langtrækkende ræsonnement sammenlignet med deres præstation på kortere kontekster.

Ud over de arkitektoniske begrænsninger er der en praktisk realitet: LLM’er har et “opmærksomhedsbudget”, der udtømmes med hver ny token, der tilføjes. Hver informationsbid du lægger til konteksten, bruger noget af dette budget og øger modellens kognitive belastning. Dette er grunden til, at omhyggelig kontekst-engineering er essentielt. Ved nøje at udvælge, hvilken information der når frem til modellen, optimerer du ikke kun for effektivitet – du forbedrer direkte kvaliteten af agentens ræsonnement og beslutningstagning. En agent med et slankt, velorganiseret kontekstvindue vil træffe bedre beslutninger, rette fejl mere effektivt og opretholde konsistent ydeevne over længere interaktionssekvenser end en agent, der drukner i irrelevant information.

Forståelsen af kontekst-engineering vs. prompt engineering

Selvom kontekst-engineering og prompt engineering er beslægtede begreber, repræsenterer de forskellige abstraktionsniveauer i arbejdet med sprogmodeller. Prompt engineering, som dominerede den tidlige æra for LLM-applikationer, fokuserer specifikt på, hvordan man skriver effektive prompts og systeminstruktioner. Det primære fokus er at udforme de rigtige ord og vendinger for at fremkalde den ønskede adfærd fra modellen på en bestemt opgave. Denne tilgang fungerer godt til diskrete, enkeltstående opgaver som klassifikation, opsummering eller en gang tekstgenerering.

Kontekst-engineering, derimod, er den naturlige udvikling af prompt engineering til en æra med flersidede, autonome agenter. Hvor prompt engineering spørger “Hvordan skriver jeg den perfekte instruktion?”, spørger kontekst-engineering det bredere spørgsmål: “Hvad er den optimale konfiguration af al tilgængelig information, der vil generere den ønskede adfærd?” Dette omfatter ikke kun systemprompten, men også de værktøjer agenten har til rådighed, de eksempler der gives, beskedhistorikken fra tidligere omgange, eventuelt hentede data og metadata, der hjælper agenten med at forstå sit miljø.

Skiftet fra prompt engineering til kontekst-engineering afspejler et grundlæggende skift i, hvordan AI-applikationer bliver bygget. I de tidlige dage krævede de fleste brugsscenarier uden for almindelig chat prompts optimeret til one-shot-opgaver. I dag bevæger feltet sig mod mere kompetente agenter, der arbejder over flere inference-omgange og længere tidshorisonter. Disse agenter genererer stadig mere data, der potentielt kan være relevant for fremtidige beslutninger, og denne information skal løbende raffineres og udvælges. Kontekst-engineering er disciplinen at styre dette hele, udviklende informationsøkosystem og sikre, at agenten ved hvert trin i ræsonnementet har adgang til præcis den rigtige information for at træffe gode beslutninger.

Tilmeld dig vores nyhedsbrev

Få de seneste tips, trends og tilbud gratis.

De fire kerne-teknikker i kontekst-engineering

Førende AI-forskningsorganisationer og platforme er nået frem til fire primære teknikker til effektiv kontekst-engineering. Hver teknik adresserer et forskelligt aspekt af udfordringen med at styre begrænsede kontekstvinduer og samtidig opretholde agentens ydeevne. At forstå disse teknikker og hvordan de anvendes er essentielt for at bygge produktionsklare AI-agenter.

Teknik 1: Offloading – Opsummering og referencestyring

Offloading er praksissen med at opsummere information og gemme fulde data i eksterne referencer, så agenten kun får adgang til detaljeret information, når det er nødvendigt. Når en AI-agent foretager et værktøjsopkald – f.eks. forespørger en database eller kalder et eksternt API – får den et svar, der kan være meget stort. I stedet for at fylde hele kontekstvinduet med svaret, handler offloading om at opsummere hovedpunkterne og give en reference, som agenten kan bruge til at hente de fulde data, hvis det bliver nødvendigt.

Et praktisk eksempel på denne tilgang kommer fra Manus AI, en forskningsorganisation, der arbejder med avancerede AI-agenter. Når deres agent foretager et værktøjsopkald og modtager et svar, inkluderer de ikke hele svaret i konteksten. I stedet giver de et kortfattet resumé af svaret og gemmer det fulde værktøjsopkaldsresultat i en fil eller database med en referencepointer. Hvis agenten senere vurderer, at den har brug for mere detaljeret information fra værktøjsopkaldet, kan den referere til de lagrede data uden at bruge ekstra tokens i hovedsamtalen. Denne tilgang spejler, hvordan mennesker arbejder – vi husker ikke alle detaljer fra hver samtale, men vi fører noter og referencer, vi kan slå op i ved behov.

Cognition, en anden førende AI-forskningsorganisation, har implementeret en lignende tilgang, men med deres eget tilpassede opsummeringssystem. I stedet for at stole på generiske opsummeringer har de bygget specialiseret opsummeringslogik, der udtrækker den mest relevante information til deres specifikke brugstilfælde. Dette demonstrerer et vigtigt princip: Den bedste offloading-strategi er ofte opgaveafhængig. Hvad der udgør et brugbart resumé afhænger af, hvad agenten prøver at opnå. Ved at tilpasse opsummeringen til det specifikke domæne og opgave kan du opretholde en signalstærk kontekst og samtidig reducere token-forbruget markant.

Teknik 2: Reduktion – Komprimering af kontekst over tid

Reduktion er teknikken til at komprimere og kondensere kontekst for at reducere det samlede antal tokens, samtidig med at den væsentlige information bevares. Når en agent arbejder over flere omgange, vokser samtalehistorikken. Uden aktiv styring kan denne historik hurtigt fylde hele kontekstvinduet og efterlade lidt plads til ny information eller ræsonnement. Reduktion adresserer dette ved periodisk at komprimere samtalen til en mere kortfattet form.

Anthropic har implementeret dette gennem en teknik, de kalder “komprimering” af samtalen. I stedet for at gemme hele historikken af hver beskedudveksling, opsummerer eller komprimerer de med jævne mellemrum samtalehistorikken til en mere kondenseret form. Dette er særligt vigtigt, fordi forskning har vist, at lang kontekst faktisk gør det sværere for AI-agenter at ræsonnere effektivt. Tilstedeværelsen af for meget kontekst kan føre til det, der kaldes “kontekstforgiftning” – et fænomen, hvor agentens ræsonnement forstyrres af irrelevant information i konteksten, hvilket får den til at afvige fra den optimale ræsonnementsti.

Reduktionsteknikken bygger på en grundlæggende indsigt om, hvordan sprogmodeller fungerer: De ræsonnerer ikke nødvendigvis bedre med mere information. Faktisk er det modsatte ofte tilfældet. En slank, velorganiseret kontekst, der kun indeholder den mest relevante information, fører typisk til bedre ræsonnement og mere pålidelig agentadfærd. Derfor arbejder mange førende organisationer aktivt for at reducere kontekststørrelsen over tid, selv når mere information teoretisk set kunne være tilgængelig. Ved at holde kontekstvinduet fokuseret og håndterbart opretholder de agentens evne til at ræsonnere klart og træffe gode beslutninger.

Teknik 3: Retrieval (RAG) – Dynamisk kontekstindlæsning

Retrieval-Augmented Generation, eller RAG, er en teknik, hvor relevant information dynamisk hentes og indlæses i konteksten under kørsel i stedet for at blive forudindlæst. Denne tilgang er blevet mere og mere populær efterhånden som agenter er blevet mere sofistikerede. I stedet for at forsøge at forudse al den information, en agent kan få brug for, og indlæse det hele fra start, gør RAG-systemer det muligt for agenter at søge efter og hente information, efterhånden som de vurderer, at det er nødvendigt.

Fordelen ved denne tilgang er betydelig. For det første reducerer det den indledende kontekstbelastning markant – agenten starter med et slankt kontekstvindue og henter kun information, når det er nødvendigt. For det andet muliggør det “progressiv afsløring”, hvor agenten gradvist opdager relevant kontekst gennem udforskning. Hver interaktion giver ny information, der informerer næste beslutning. For eksempel kan en agent starte med at søge efter relevante filer, opdage at visse filer er vigtigere baseret på deres navne eller tidsstempler, og derefter hente disse specifikke filer til detaljeret analyse. Denne lagdelte tilgang til kontekstopdagelse er langt mere effektiv end at forsøge at indlæse alt fra starten.

Anthropics Claude Code er et fremragende eksempel på RAG i praksis. I stedet for at indlæse hele kodebasen i konteksten, holder Claude Code letvægtsidentifikatorer som filstier og bruger værktøjer som grep og glob til dynamisk at hente relevante filer efter behov. Agenten kan skrive målrettede forespørgsler, gemme resultater og bruge kommandolinjeværktøjer til at analysere store datamængder uden nogensinde at indlæse de fulde dataobjekter i konteksten. Denne tilgang spejler menneskets kognition – vi husker ikke hele informationsmængder, men vi har udviklet eksterne organisationssystemer som filsystemer og søgeværktøjer, der giver os mulighed for at hente relevant information efter behov.

Teknik 4: Isolation – Sub-agenter og opgavesepation

Isolation er praksissen med at bruge sub-agenter til at håndtere specifikke opgaver, og derved sikre, at forskellige agenter arbejder på separate problemer uden kontekstoverlap. Denne teknik anerkender, at den bedste måde at styre kontekst på nogle gange er at opdele komplekse problemer i mindre, mere fokuserede delproblemer, som hver håndteres af en dedikeret agent med sit eget kontekstvindue.

Der er to hovedparadigmer for isolation. Cognition, en førende AI-forskningsorganisation, fraråder faktisk brugen af sub-agenter, medmindre opgaverne er helt adskilte uden overlap. Deres filosofi er, at sub-agenter tilføjer kompleksitet og potentielle fejlpunkter og kun bør bruges, når det er absolut nødvendigt. Andre organisationer som Cloud Code har dog taget sub-agenter til sig som en kerne i deres arkitektur. I Cloud Code kan du oprette sub-agenter til forskellige aspekter af en større opgave, med en manager-agent, der koordinerer mellem dem.

Den afgørende indsigt ved isolation er, at det er et trade-off. På den ene side kan brugen af sub-agenter hjælpe med at styre kontekst ved at opdele problemområdet – hver agent har et fokuseret kontekstvindue, der er relevant for dens specifikke opgave. På den anden side introducerer sub-agenter koordinationsomkostninger og potentielle fejlpunkter, hvor information skal overføres mellem agenter. Den rigtige tilgang afhænger af dit specifikke brugstilfælde. For meget komplekse opgaver med klare delproblemer kan isolation være særdeles effektivt. For opgaver, hvor forskellige aspekter er tæt forbundet, kan en enkelt agent med velstyret kontekst være mere hensigtsmæssig.

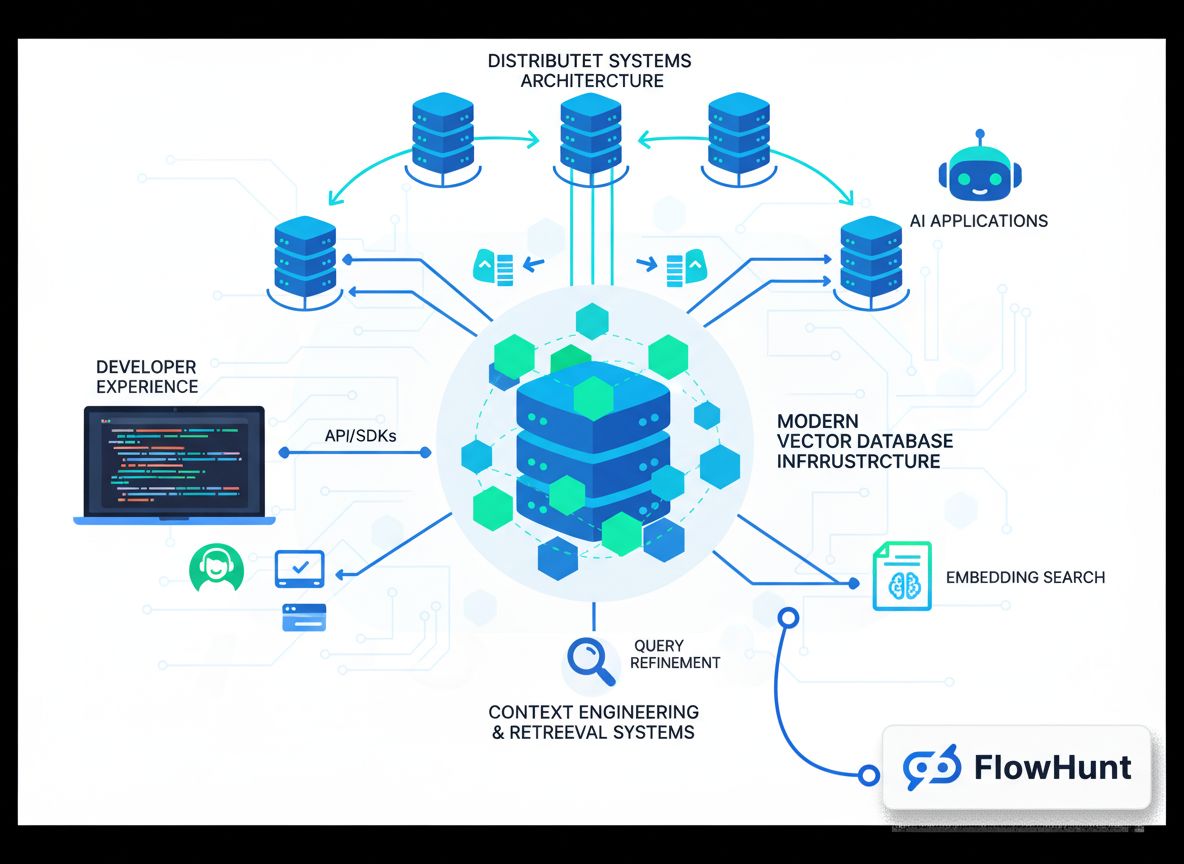

Implementering af kontekst-engineering i FlowHunt

FlowHunt tilbyder en omfattende no-code platform til at implementere alle disse kontekst-engineering-teknikker. I stedet for at kræve, at udviklere bygger specialløsninger, gør FlowHunt det muligt for teams at implementere sofistikerede kontekststyringsstrategier via en intuitiv visuel grænseflade. Dette demokratiserer kontekst-engineering og gør det tilgængeligt for teams uden dyb maskinlæringsviden.

I FlowHunt kan du implementere isolation via selvstyrende crews. Et selvstyrende crew består af flere AI-agenter med en manager-agent, der koordinerer mellem dem. Manager-agenten modtager den indledende opgave, opdeler den i delopgaver og videregiver dem til specialiserede agenter. Hver agent opretholder sit eget fokuserede kontekstvindue, der er relevant for dens specifikke ansvar. Når sub-agenterne har udført deres arbejde, sammenfatter manager-agenten resultaterne. Denne tilgang gør det muligt at tackle komplekse problemer ved at opdele dem i håndterbare stykker, hver med sin egen optimerede kontekst.

FlowHunt understøtter også sekventielle task flows, hvor flere agenter arbejder på et problem i rækkefølge, og hver agents output bliver input for den næste. Dette er særligt nyttigt for workflows, hvor opgaver har klare afhængigheder. For eksempel i et indholdsgenereringsflow kan én agent researche et emne, en anden agent kan lave en disposition, og en tredje agent kan skrive den endelige tekst. Hver agent har et fokuseret kontekstvindue, der kun indeholder information, der er relevant for det pågældende trin.

Derudover gør FlowHunt det muligt at bygge intelligente retrieval-systemer direkte ind i dine flows. I stedet for at indlæse al information på forhånd, kan du konfigurere agenter til dynamisk at hente relevante data efter behov. Dette kan indebære forespørgsler til databaser, søgning i vidensbaser eller hentning af filer baseret på agentens ræsonnement om, hvilken information der er nødvendig. Ved at kombinere disse muligheder gør FlowHunt det muligt at implementere enterprise-grade kontekst-engineering uden at skrive en eneste linje kode.

Avancerede kontekst-engineering-strategier og virkelige anvendelser

Ud over de fire kerne-teknikker er der flere avancerede strategier, som førende organisationer bruger til at udvide mulighederne for kontekst-engineering. Disse tilgange kombinerer ofte flere teknikker og kræver omhyggelig tuning til specifikke brugstilfælde.

En avanceret strategi er hybrid kontekststyring, hvor organisationer bruger en kombination af forudindlæst kontekst og retrieval efter behov. I stedet for at vælge mellem at indlæse alt på forhånd eller hente alt dynamisk, indlæser hybridtilgange nogle kritiske informationer på forhånd for hastighed og pålidelighed, mens de bibeholder evnen til at hente ekstra information efter behov. Claude Code bruger denne hybridtilgang – CLAUDE.md-filer smides naivt i konteksten fra starten, fordi de typisk er små og indeholder vigtig konfigurationsinformation, mens større filer og data hentes efter behov med værktøjer som grep og glob.

En anden avanceret strategi involverer metadata-drevet kontekstudvælgelse. I stedet for kun at kigge på indholdet af information bruger sofistikerede systemer metadata som filnavne, tidsstempler, mappehierarkier og andre organisatoriske signaler til at træffe intelligente beslutninger om, hvilken information der er relevant. En agent, der arbejder i et filsystem, kan f.eks. udlede meget ud fra tilstedeværelsen af en fil ved navn test_utils.py i en tests-mappe sammenlignet med samme fil i src/core_logic/. Disse metadata-signaler hjælper agenter med at forstå, hvordan og hvornår de skal bruge information, og mindsker behovet for at indlæse og parse hele indholdet.

Bekæmpelse af kontekstforgiftning er en anden vigtig avanceret strategi. Som tidligere nævnt opstår kontekstforgiftning, når irrelevant information i konteksten får agentens ræsonnement til at afvige fra den optimale sti. Avancerede systemer arbejder aktivt på at identificere og fjerne potentielt giftig kontekst. Dette kan involvere analyse af agentens ræsonnementskæde for at identificere, hvor det gik galt, og derefter fjerne eller omformulere den kontekst, der førte til afvigelsen. Over tid skaber dette et feedback-loop, der kontinuerligt forbedrer kontekstkvaliteten.

Fremtiden for kontekst-engineering og AI-agentudvikling

Efterhånden som AI-agenter bliver mere sofistikerede og implementeres i stadigt mere komplekse virkelige scenarier, vil kontekst-engineering kun blive vigtigere. Feltet udvikler sig hurtigt, og nye teknikker og best practices opstår løbende. Flere tendenser vil sandsynligvis præge fremtiden for kontekst-engineering.

For det første vil vi sandsynligvis se mere sofistikerede automatiserede kontekstkurationssystemer. I stedet for manuelt at beslutte, hvilken kontekst der skal inkluderes, vil fremtidige systemer bruge maskinlæring til automatisk at bestemme den optimale kontekst for hver agent og opgave. Disse systemer kan lære af agentens ydeevnedata at identificere, hvilke dele af konteksten der er mest værdifulde, og hvilke der sandsynligvis vil forårsage forgiftning.

For det andet vil kontekst-engineering blive mere integreret med agentarkitektur-design. I stedet for at betragte kontekststyring som en eftertanke, vil fremtidige agentsystemer blive designet fra bunden med kontekst-effektivitet for øje. Dette kan indebære nye agentarkitekturer, der er iboende bedre til at håndtere begrænsede kontekstvinduer, eller nye måder at repræsentere information på, der er mere token-effektive.

For det tredje vil vi sandsynligvis se fremkomsten af kontekst-engineering som en særskilt professionel disciplin med specialiserede værktøjer, frameworks og best practices. Ligesom prompt engineering gik fra at være en ad hoc-praksis til en anerkendt disciplin med etablerede teknikker, følger kontekst-engineering en lignende udvikling. Organisationer vil investere i at opbygge specialiserede teams og værktøjer med fokus specifikt på kontekstoptimering.

{{ cta-dark-panel

heading=“Supercharge dit workflow med FlowHunt”

description=“Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-workflows – fra research og indholdsgenerering til publicering og analyse – alt samlet ét sted.”

ctaPrimaryText=“Book en demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Prøv FlowHunt gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Praktisk implementering: Byg din første kontekst-engineerede agent

For at hjælpe dig i gang med kontekst-engineering, lad os gennemgå et praktisk eksempel på at bygge en kontekst-engineeret agent til et almindeligt brugsscenarie: research og indholdsgenerering. Dette eksempel viser, hvordan man anvender teknikkerne i praksis.

Start med at definere din agents kerneansvar klart. I dette tilfælde er agentens opgave at researche et emne og generere en omfattende artikel. I stedet for at forsøge at gøre alt i én agent med et kæmpestort kontekstvindue, bruger du isolation til at oprette et multi-agent-system. Den første agent er en researcher, der indsamler information om emnet. Den anden agent er en skribent, som bruger researchen til at skrive artiklen. En manager-agent koordinerer mellem dem.

For researcher-agenten implementeres retrieval-baseret kontekststyring. I stedet for at indlæse al tilgængelig information om emnet på forhånd, skal researcher-agenten have værktøjer til at søge i databaser, forespørge API’er og hente relevante dokumenter. Efterhånden som den opdager information, opsummerer den centrale fund og gemmer referencer til de fulde kilder. Dette holder researcherens kontekstvindue slankt, mens den sikrer adgang til al nødvendig information.

For skribent-agenten implementeres offloading. Researcheren giver et resumé af fundene til skribenten sammen med referencer til de fulde kilder. Skribentens kontekst inkluderer resuméet og muligheden for at hente fuldt kildemateriale om nødvendigt. Dette gør det muligt for skribenten at arbejde effektivt uden at blive overvældet af rå data.

Undervejs skal du overvåge for kontekstforgiftning. Hvis du bemærker, at agenten træffer dårlige beslutninger eller kommer på afveje, analyser dens ræsonnement for at identificere, hvilke dele af konteksten der kan forårsage problemet. Fjern eller omformulér den kontekst og test igen. Over tid udvikler du intuition for, hvilken kontekst der fungerer bedst for netop dit brugsscenarie.

Effektiv kontekst-engineering kræver måling og løbende optimering. Du skal opstille metrikker, der hjælper dig med at forstå, om dine kontekst-engineering-indsatser faktisk forbedrer agentens ydeevne. Flere nøglemetrikker er værd at følge.

Først måles token-effektivitet – forholdet mellem brugbart output og forbrugte tokens. En agent, der producerer resultater af høj kvalitet med færre tokens, er mere effektiv. Følg denne metrik over tid, mens du implementerer kontekst-engineering-teknikker. Du bør se forbedringer, når du anvender offloading, reduktion og retrieval-strategier.

For det andet måles ræsonnementskvalitet. Dette kan indebære analyse af agentens ræsonnementskæder for at se, om de er sammenhængende og logiske, eller måling af outputkvaliteten op mod en guldstandard. Efterhånden som du forbedrer kontekst-engineering, bør ræsonnementskvaliteten stige, fordi agenten har mindre irrelevant information til at distrahere sig.

For det tredje måles fejlretningsevne. Hvor godt genvinder agenten sig, når den begår fejl? Bedre kontekst-engineering bør føre til bedre fejlretning, fordi agenten har klarere information om, hvad der gik galt, og hvad der skal gøres.

For det fjerde måles latenstid og omkostninger. Selvom kontekst-engineering primært handler om at forbedre kvaliteten, har det også effektivitetsfordele. Agenter med bedre styrede kontekstvinduer har typisk lavere latenstid (fordi de behandler færre tokens) og lavere omkostninger (fordi de forbruger færre tokens). Følg disse metrikker for at forstå den fulde effekt af dine kontekst-engineering-indsatser.

Almindelige faldgruber og hvordan du undgår dem

Når du implementerer kontekst-engineering, er der flere almindelige faldgruber, teams støder på. At kende dem kan hjælpe dig med at undgå dyre fejl.

Den første faldgrube er overoptimering. Det kan være fristende at forsøge at presse hver eneste token ud af dit kontekstvindue, men dette kan føre til en kontekst, der er for slank til at være brugbar. Husk, at målet er at finde den optimale balance – nok information til at agenten kan ræsonnere effektivt, men ikke så meget, at den bliver forvirret. Start med en rimelig mængde kontekst, og reducer kun, hvis agenten klarer sig godt.

Den anden faldgrube er at ignorere opgavespecifikke krav. Kontekst-engineering er ikke one-size-fits-all. Hvad der virker for en kundeserviceagent, virker måske ikke for en dataanalyseagent. Brug tid på at forstå dit konkrete brugsscenarie og tilpas din kontekst-engineering-tilgang herefter.

Den tredje faldgrube er at undlade at overvåge og iterere. Kontekst-engineering er ikke en engangsaktivitet. Efterhånden som din agent møder nye situationer, og dine krav udvikler sig, skal du løbende overvåge performance og justere din kontekststrategi. Indbyg overvågning og iteration i din udviklingsproces fra starten.

Den fjerde faldgrube er at undervurdere vigtigheden af metadata. Mange teams fokuserer på indholdet af deres kontekst, men overser metadata, der hjælper agenten med at forstå, hvordan indholdet skal bruges. Filnavne, tidsstempler, mappestrukturer og andre organisatoriske signaler er ofte mere værdifulde, end du tror. Vær opmærksom på, hvordan du organiserer og navngiver information.

Konklusion

Kontekst-engineering repræsenterer et grundlæggende skift i måden, vi bygger AI-agenter på – fra fokus på perfekte prompts til strategisk styring af al tilgængelig information for at optimere agentperformance. Ved at forstå og implementere de fire kerne-teknikker – offloading, reduktion, retrieval og isolation – sammen med avancerede strategier som hybrid kontekststyring og metadata-drevet udvælgelse, kan du bygge agenter, der er mere kompetente, mere pålidelige og mere effektive. Platforme som FlowHunt gør disse avancerede teknikker tilgængelige via no-code interfaces og demokratiserer kontekst-engineering for teams i alle størrelser. Når du implementerer kontekst-engineering i dine egne projekter, skal du huske, at det er en iterativ proces, der kræver løbende måling og optimering. Start med fundamentet, mål dine resultater og inkorporér gradvist mere avancerede teknikker, efterhånden som du opbygger ekspertise. De organisationer, der mestrer kontekst-engineering, vil bygge de mest kompetente og pålidelige AI-agenter og opnå betydelige konkurrencefordele i en stadigt mere AI-drevet verden.