Kontekst-engineering for AI-agenter: Mestring af token-optimering og agentperformance

Lær, hvordan kontekst-engineering optimerer AI-agenters ydeevne ved strategisk håndtering af tokens, reducering af kontekstbloat og implementering af avancerede...

Lær hvordan du kontekst-engineerer AI-agenter ved at håndtere værktøjs-feedback, optimere tokenforbrug og implementere strategier som offloading, komprimering og isolation for at bygge produktionsklare agenter, der præsterer pålideligt i stor skala.

At bygge AI-agenter, der fungerer pålideligt i produktion, er grundlæggende anderledes end at bygge simple chatapplikationer. Hvor chatmodeller arbejder med et relativt statisk kontekstvindue—primært brugerens besked og systeminstruktioner—står agenter over for en langt mere kompleks udfordring. Agenter foretager værktøjskald i løkker, og hvert værktøjs output bliver en del af den kontekst, LLM’en skal behandle i næste trin. Denne dynamiske ophobning af kontekst skaber det, mange nu kalder “kontekst-engineering”-problemet. Efterhånden som flere teams begyndte at bygge agenter i 2024, opstod en fælles erkendelse: Håndtering af kontekst er ikke en triviel opgave. Det er uden tvivl den mest kritiske engineering-udfordring, når man bygger produktionsklare agenter. Denne artikel udforsker principper, strategier og praktiske teknikker til kontekst-engineering, der hjælper dig med at bygge agenter, der skalerer effektivt, bevarer ydeevnen og holder omkostningerne under kontrol.

Kontekst-engineering repræsenterer et grundlæggende skift i måden, vi tænker AI-systemer på. Begrebet blev populariseret af Andrej Karpathy, der beskrev det som “den fine kunst og videnskab at fylde kontekstvinduet med præcis den rette information til næste skridt.” Denne definition indkapsler noget essentielt: LLM’ens kontekstvindue er som RAM i en computer—det har begrænset kapacitet, og hvad du putter i, påvirker direkte ydeevnen. Ligesom et operativsystem nøje styrer, hvilke data der passer i CPU’ens RAM, skal ingeniører, der bygger agenter, omhyggeligt kuratere, hvilken information der flyder ind i LLM’ens kontekstvindue ved hvert trin i eksekveringen.

Konceptet udsprang af fælles erfaringer i AI-engineering-miljøet. Da udviklere først begyndte at bygge agenter for alvor, opdagede de, at den naive tilgang—simpelthen at føre alle værktøjs-outputs tilbage i beskedhistorikken—førte til katastrofale problemer. En udvikler, der byggede en dybdegående research-agent, kunne eksempelvis opleve, at et enkelt gennemløb brugte 500.000 tokens, hvilket kostede $1 til $2 pr. eksekvering. Det var ikke en begrænsning ved agentarkitekturen i sig selv; det var en fejl i kontekst-engineeringen. Problemet handler ikke kun om at ramme kontekstvinduets grænse, selvom det bestemt er en bekymring. Forskning fra Chroma og andre har dokumenteret det, man kalder “context rot”—et fænomen hvor LLM-ydeevnen faktisk forringes, efterhånden som konteksten bliver længere, selv når modellen teoretisk har plads til flere tokens. Det betyder, at det blindt at fylde mere information i kontekstvinduet ikke bare koster flere penge; det får faktisk din agent til at præstere dårligere.

Kontekst-engineering gælder på tværs af tre primære typer kontekst, som agenter arbejder med: instruktioner (system-prompter, hukommelser, få-skud-eksempler, værktøjsbeskrivelser), viden (fakta, historisk information, domæneekspertise) og værktøjer (feedback fra værktøjskald og deres resultater). Hver af disse kræver forskellige engineering-tilgange, og udfordringen ligger i at orkestrere alle tre effektivt, efterhånden som en agent udfører dusinvis eller endda hundredvis af trin.

Vigtigheden af kontekst-engineering kan ikke overvurderes for alle, der bygger agenter i stor skala. Overvej omfanget af moderne agentsystemer: Anthropic’s multi-agent research-system opererer med agenter, der foretager hundredvis af værktøjskald pr. opgave. Cognitions forskning i agentarkitektur viste, at typiske produktionsagenter fører samtaler over hundredvis af vendinger. Når du ganger antallet af værktøjskald med tokenprisen for hvert værktøjs output, forstår du hurtigt, hvorfor konteksthåndtering er hovedopgaven for ingeniører, der bygger AI-agenter. Uden ordentlig kontekst-engineering bliver din agent økonomisk uholdbar og teknisk upålidelig.

Det økonomiske argument er ligetil. Hvis hvert agentkald koster $1 til $2 pga. overdreven tokenforbrug, og du kører tusindvis af agenter dagligt, står du over for daglige omkostninger på mange tusinde dollars, som kunne elimineres med bedre konteksthåndtering. Men performance-argumentet er lige så overbevisende. Når konteksten vokser, oplever LLM’er flere fejlsituationer. Context poisoning opstår, når en hallucination eller fejl fra et tidligere trin kommer ind i konteksten og påvirker alle efterfølgende beslutninger. Context distraction sker, når informationsmængden overvælder modellens evne til at fokusere på opgaven. Context confusion opstår, når overflødig information påvirker svarene på uventede måder. Context clash opstår, når forskellige dele af konteksten modsiger hinanden, hvilket skaber tvivl om, hvad agenten skal gøre næste gang. Dette er ikke teoretiske problemer—det er dokumenterede fejlsituationer, som teams jævnligt oplever uden ordentlig kontekst-engineering.

Indsatsen er især høj for langvarige agenter. En agent, der skal researche et komplekst emne, skrive kode, fejlfinde og iterere, kan foretage 50 til 100 værktøjskald. Uden kontekst-engineering ville beskedhistorikken vokse til at inkludere alle mellemliggende resultater, al debug-output, alle fejlslagne forsøg. Agenten ville skulle træffe beslutninger, mens den drukner i irrelevant historisk information. Med ordentlig kontekst-engineering bevarer agenten kun den information, den har brug for i det aktuelle trin, hvilket forbedrer både ydeevne og omkostningseffektivitet dramatisk.

En almindelig kilde til forvirring er forholdet mellem prompt engineering og kontekst-engineering. Begreberne er beslægtede, men forskellige, og forståelsen af forskellen er afgørende for at bygge effektive agenter. Prompt engineering handler traditionelt om at udforme den indledende prompt—systembeskeden og brugermeddelelsen—som du sender til en sprogmodel. Når du arbejder med ChatGPT eller Claude i et chatinterface, bruger du tid på at optimere den første prompt for at få bedre resultater. Du kan forfine instruktionerne, tilføje eksempler, tydeliggøre det ønskede outputformat. Det er prompt engineering, og det er fortsat vigtigt.

Kontekst-engineering er et bredere begreb, der omfatter prompt engineering, men rækker langt videre. Kontekst-engineering gælder specifikt for agenter, hvor konteksten ikke er statisk—den er dynamisk og under konstant udvikling. Med en chatmodel er menneskets besked det primære input, og det meste engineering-arbejde bruges på at udforme denne besked. Med en agent er spillet fundamentalt anderledes. Agenten modtager kontekst ikke bare fra brugerens første anmodning, men også fra værktøjskald, der udføres undervejs i agentens forløb. Ved hvert trin i agentens eksekvering strømmer ny kontekst ind fra værktøjets output. Dette skaber et kaskadeproblem: Hvis du naivt inkluderer alt værktøjsoutput i beskedhistorikken, vokser dit kontekstvindue eksponentielt for hvert trin.

Tænk på det sådan: Prompt engineering handler om at optimere startbetingelserne. Kontekst-engineering handler om at styre hele informationsflowet gennem agentens livscyklus. Det inkluderer beslutninger om, hvilke værktøjsoutputs der skal medtages, hvordan de skal opsummeres, hvornår beskedhistorikken skal komprimeres, om information skal offloades til ekstern lagring, og hvordan agentens tilstand skal struktureres for at minimere irrelevant kontekst. Prompt engineering er et delmængde af kontekst-engineering. System- og bruger-instruktioner er stadig vigtige—de er en del af konteksten, der skal engineer’es. Men kontekst-engineering omfatter også alle strategierne til at håndtere den dynamiske kontekst, der akkumuleres undervejs.

Den mest praktiske ramme for kontekst-engineering brydes ned i fire komplementære strategier: write, select, compress og isolate. Disse strategier kan implementeres individuelt eller i kombination og udgør fundamentet for, hvordan produktionsagenter effektivt håndterer kontekst. At forstå hver strategi og vide, hvornår de skal anvendes, er afgørende for at bygge agenter, der kan skaleres.

Write-strategien handler om at gemme kontekst uden for kontekstvinduet, så den er tilgængelig for agenten, men ikke bruger tokens i beskedhistorikken. Dette er måske den mest kraftfulde teknik, fordi den direkte adresserer problemet med tokenophobning. I stedet for at inkludere alle værktøjsoutputs i beskedhistorikken, skrives de til et eksternt system, og kun en reference eller et resumé bevares i konteksten.

Scratchpads er én måde at implementere denne strategi på. Konceptet er lånt fra, hvordan mennesker løser komplekse problemer—vi tager noter, skriver mellemresultater ned og refererer til dem efter behov. Agenter kan gøre det samme. Anthropic’s multi-agent research-system er et tydeligt eksempel: LeadResearcher-agenten gemmer sin plan i hukommelsen fra begyndelsen af opgaven. Det er afgørende, fordi hvis kontekstvinduet overstiger 200.000 tokens, bliver det afkortet, og at miste planen ville være katastrofalt. Ved at skrive planen til et scratchpad sikrer agenten, at denne kritiske information bevares, selv hvis kontekstvinduet fyldes op. Scratchpads kan implementeres på flere måder: som et værktøjskald, der skriver til et filsystem, som et felt i agentens runtime state-objekt (som i LangGraph) eller som poster i en database. Det vigtige er, at informationen lagres eksternt og kan hentes efter behov.

Hukommelser udvider dette koncept på tværs af flere sessioner eller tråde. Hvor scratchpads hjælper en agent med at løse en enkelt opgave, hjælper hukommelser agenter med at lære og forbedre sig på tværs af mange opgaver. Reflexion-frameworket introducerede idéen om refleksion—efter hvert agent-trin genererer agenten et resumé af, hvad den har lært, og gemmer det som en hukommelse. Generative Agents tog dette videre og syntetiserede periodisk hukommelser fra samlinger af tidligere feedback. Disse koncepter har fundet vej til populære produkter som ChatGPT, Cursor og Windsurf, der alle auto-genererer langtidshukommelser, der bevares på tværs af sessioner. En agent kan lagre episodiske hukommelser (eksempler på ønsket adfærd), proceduremæssige hukommelser (instruktioner om hvordan man gør ting) og semantiske hukommelser (fakta og domæneviden). Ved at skrive disse hukommelser eksternt kan agenten opretholde en rig vidensbase uden at oppuste kontekstvinduet.

Udfordringen med write-strategien er at afgøre, hvad der skal gemmes, og hvordan det skal organiseres. Du ønsker ikke at gemme alt—det ville modarbejde formålet. Du vil skrive information, der er nyttig for fremtidige skridt, men ikke umiddelbart nødvendig. For en dybdegående research-agent kunne du skrive hele artikler til disk og kun bevare et resumé i konteksten. For en kode-agent kunne du skrive hele kodebasen til et filsystem og kun have den aktuelle fil, der redigeres, i konteksten. Nøglen er at være selektiv med, hvad der gemmes, og sikre, at det, der forbliver i konteksten, er tilstrækkeligt for agenten til at vide, hvad der er skrevet, og hvordan det hentes, hvis nødvendigt.

Select-strategien handler om at vælge, hvilken kontekst der skal inkluderes i beskedhistorikken ved hvert trin. Her beslutter agenten, hvilken information den faktisk har brug for til den aktuelle beslutning. Hvis du har skrevet kontekst til ekstern lagring, har du brug for en mekanisme til at hente det tilbage, når det er relevant. Det kan være så simpelt som, at agenten laver et værktøjskald for at læse en fil, eller mere avanceret, hvor der bruges embeddings eller knowledge graphs til at finde semantisk relevante informationer.

For scratchpads er udvælgelse ofte ligetil. Agenten kan læse scratchpaddet, når den skal referere til planen eller tidligere noter. For hukommelser er udvælgelse mere kompleks. Hvis en agent har samlet hundredvis af hukommelser på tværs af mange sessioner, kan den ikke inkludere dem alle i konteksten. I stedet skal de mest relevante udvælges. Her er embeddings nyttige. Du kan embedde hver hukommelse og bruge semantisk søgning til at finde de mest relevante for den aktuelle opgave. ChatGPT’s hukommelsessystem er et godt eksempel—det gemmer bruger-specifikke hukommelser og udvælger relevante til konteksten baseret på den aktuelle samtale.

Udfordringen ved udvælgelse er at sikre, at den rette information vælges. Hvis du udvælger for lidt, mangler agenten vigtig kontekst og træffer dårlige beslutninger. Udvælger du for meget, er du tilbage ved det oprindelige problem med oppustet kontekst. Nogle agenter bruger en simpel tommelfingerregel: altid inkludere visse filer eller hukommelser (fx en CLAUDE.md-fil i Claude Code eller en rules-fil i Cursor). Andre bruger mere avancerede udvælgelsesmekanismer baseret på semantisk lighed eller eksplicit agent-reasoning om, hvad der er relevant. Den bedste tilgang afhænger af dit konkrete use case, men princippet er klart: Vær bevidst om, hvilken kontekst du inkluderer ved hvert trin.

Compress-strategien handler om at reducere kontekstens størrelse, mens den information, agenten har brug for, bevares. Det er noget andet end bare at slette kontekst—komprimering betyder at opsummere, abstrahere eller omformatere information, så den bliver mere kompakt. Komprimering er især vigtig til håndtering af beskedhistorik, efterhånden som en agent udfører mange trin. Selv med offloading og udvælgelse kan beskedhistorikken vokse betydeligt. Komprimering hjælper med at holde den håndterbar.

En tilgang til komprimering er opsummering. Når en agent afslutter en arbejdsfase, kan du opsummere, hvad der skete, og erstatte detaljerede logs med et resumé. Hvis en agent fx brugte 10 trin på at researche et emne og foretog 10 værktøjskald, kunne du erstatte alt det med et enkelt resumé: “Researched emne X og fandt at Y er nøgleindsigten.” Dette bevarer den essentielle information og reducerer tokenforbruget markant. Udfordringen er at lave denne opsummering på en måde, der bevarer recall—agenten skal vide nok om det opsummerede til at afgøre, om den skal hente detaljerne.

Cognitions forskning i agentarkitektur understreger, at opsummering fortjener betydelig engineering-indsats. De bruger endda fin-tunede modeller specifikt til opsummering for at sikre, at alle relevante oplysninger fanges. Nøglen er at prompt-engineere opsummeringstrinnet omhyggeligt. Du vil instruere opsummeringsmodellen i at fange et udtømmende sæt bullet points om, hvad der er i den oprindelige kontekst, så agenten senere kan afgøre, om den skal hente detaljerne. Det er noget andet end afslappet opsummering—det er komprimering med høj recall.

En anden komprimeringsteknik er agentgrænser. I multi-agent-systemer kan du komprimere kontekst ved overgangen mellem agenter. Når én agent afleverer arbejdet til en anden, videregiver du ikke hele beskedhistorikken. I stedet gives et komprimeret resumé af, hvad der blev opnået, og hvad den næste agent skal vide. Her bliver forskellen mellem single-agent og multi-agent-systemer vigtig. Multi-agent-systemer skaber kompleksitet i kommunikationen, men giver også naturlige punkter for komprimering og kontekst-isolation.

Isolate-strategien handler om at bruge flere agenter med adskilte kontekster fremfor én agent med en monolitisk kontekst. Det er multi-agent-tilgangen og er særlig nyttig ved komplekse opgaver, der naturligt kan opdeles i delopgaver. Ved at isolere kontekst til specifikke agenter undgår du ubegrænset vækst i konteksten og tillader hver agent at fokusere på sin specifikke rolle.

Argumentet for multi-agent-systemer er overbevisende fra et kontekst-engineering-perspektiv. Hvis én agent håndterer research, skrivning og redigering, vil dens kontekstvindue inkludere information om alle tre opgaver. Men når agenten skriver, har den ikke brug for research-detaljer i konteksten—kun nøglefund. Når den redigerer, har den heller ikke brug for research-detaljer. Ved at bruge separate agenter til research, skrivning og redigering kan hver agents kontekst optimeres til den specifikke opgave. Research-agenten har research-værktøjer og -kontekst. Skrive-agenten har skriveværktøjer og research-fund. Redigeringsagenten har redigeringsværktøjer og det udkast, der skal redigeres. Hver agents kontekst er mindre og mere fokuseret.

Udfordringen ved multi-agent-systemer er kommunikationen. Når én agent afleverer til en anden, skal du sikre, at tilstrækkelig kontekst kommunikeres. Her er komprimeringsstrategien kritisk. Research-agenten skal komprimere sine fund til en form, skriveagenten kan bruge. Skriveagenten skal komprimere udkastet, så redigeringsagenten kan arbejde videre. Cognitions forskning fremhæver, at denne kommunikationsbelastning kan være betydelig, og at grundig engineering er nødvendig for at få multi-agent-systemer til at fungere godt. Men når det lykkes, kan multi-agent-systemer dramatisk reducere kontekstbloat og forbedre systemets samlede ydeevne.

FlowHunts workflow-automatisering er særligt velegnet til at implementere multi-agent-systemer med korrekt kontekst-isolation. Ved at definere klare workflows med distinkte agenter og eksplicitte overleveringspunkter kan du sikre, at konteksten håndteres effektivt på hvert trin. FlowHunt gør det muligt at definere state, der flyder mellem agenter, implementere komprimering ved overlevering og overvåge kontekstforbrug på tværs af agentsystemet.

At forstå de fire strategier er én ting; at implementere dem effektivt er en anden. Lad os tage et konkret eksempel: At bygge en dybdegående research-agent. En naiv implementering ville lade agenten foretage en række websøgninger, inkludere alle søgeresultater i beskedhistorikken og lade agenten syntetisere dem. Det bliver hurtigt dyrt og ineffektivt. En vel-engineered implementering ville bruge alle fire strategier.

Først ville agenten bruge write-strategien til at gemme hele artikler til disk, når de hentes. I stedet for at inkludere hele teksten i beskedhistorikken, bevares kun en reference eller et resumé. For det andet bruges select-strategien til kun at hente de mest relevante artikler ind, når fundene skal syntetiseres. For det tredje bruges compress-strategien til at opsummere research-fundene i nøglepunkter, før næste fase påbegyndes. For det fjerde, hvis opgaven er kompleks nok, kunne isolate-strategien bruges ved at have separate agenter til research, syntese og skrivning, hver med sin optimerede kontekst.

Implementeringsdetaljerne er vigtige. For write-strategien skal du beslutte, hvor artiklerne gemmes—et filsystem, en database eller en vektor-store. For select-strategien skal du afgøre, hvordan relevante artikler hentes—keyword-søgning, semantisk søgning eller eksplicit agent-reasoning. For compress-strategien skal du omhyggeligt prompt-engineere opsummeringstrinnet for at sikre høj recall. For isolate-strategien skal du definere klare agentgrænser og kommunikationsprotokoller.

En vigtig indsigt fra produktionserfaring er, at kontekst-engineering ikke er en engangsoptimering—det er en løbende proces. Efterhånden som din agent kører, bør du overvåge kontekstforbruget, identificere flaskehalse og løbende forbedre din kontekst-engineering. Værktøjer som LangGraph giver indsigt i agent-state og kontekstflow, hvilket gør det lettere at identificere, hvor kontekst ophobes unødvendigt. FlowHunt udvider dette ved at give workflow-niveau synlighed, så du kan se, hvordan kontekst flyder gennem hele dit agentsystem og identificere optimeringsmuligheder.

At bygge kontekst-engineerede agenter i produktion afslører udfordringer, der ikke er indlysende i teorien. En almindelig udfordring er “kontekst-udvælgelsesproblemet”—hvordan ved du, hvilken kontekst der faktisk er relevant? En agent kan have adgang til hundredvis af dokumenter, tusindvis af hukommelser eller enorme mængder historiske data. At udvælge det rette udsnit er ikke trivielt. Semantisk søgning med embeddings hjælper, men er ikke perfekt. Nogle gange er den mest relevante information noget, agenten ikke ville tænke på at søge efter. Nogle teams løser dette ved at lade agenter eksplicit ræsonnere over, hvilken kontekst de har brug for, og lave værktøjskald for at hente specifik information i stedet for at stole på automatisk udvælgelse. Andre bruger en kombination af semantisk søgning og eksplicit agent-reasoning.

En anden udfordring er “opsummeringskvalitets-problemet”—hvordan opsummerer du kontekst uden at miste kritisk information? En dårligt opsummeret kontekst kan vildlede agenten til at træffe forkerte beslutninger. Løsningen er at investere i opsummeringstrinnet. Prompt-engineer opsummeringsmodellen omhyggeligt. Test forskellige opsummeringsmetoder. Overvej at bruge en fin-tunet model, hvis du har nok data. Overvåg, om agenten træffer beslutninger, der tyder på, at den mangler vigtig information fra det opsummerede indhold.

En tredje udfordring er “multi-agent kommunikationsproblemet”—hvordan sikrer du, at kontekst kommunikeres effektivt mellem agenter? Her er eksplicitte protokoller afgørende. Definer præcist, hvilken information hver agent skal sende videre. Brug strukturerede formater (fx JSON) i stedet for fri tekst. Medtag metadata om, hvad konteksten indeholder, så modtageragenten ved, hvad den arbejder med. Test kommunikationsprotokollen med realistiske scenarier for at sikre, at den fungerer i praksis.

Effektiv kontekst-engineering kræver måling. Du skal forstå, hvor meget kontekst din agent bruger, hvor den ophobes, og hvordan det påvirker ydeevnen. Nøgle-metrics inkluderer totale tokens pr. kørsel, tokens pr. trin, udnyttelse af kontekstvindue og performancemetrics såsom succesrate og latenstid. Ved at spore disse metrics kan du identificere, hvornår kontekst-engineering virker, og hvornår den skal forbedres.

Tokenforbrug er den mest oplagte metric. Spor, hvor mange tokens din agent bruger pr. kørsel og pr. trin. Hvis forbruget vokser over tid, er det et tegn på, at kontekst ophobes. Hvis forbruget er højt i forhold til opgavens kompleksitet, er det et tegn på, at kontekst-engineering kan forbedres. Omkostning er også vigtig—hvis din agent er dyr at køre, er kontekst-engineering sandsynligvis synderen.

Performancemetrics er lige så vigtige. Spor, om agenten træffer bedre eller dårligere beslutninger, efterhånden som konteksten vokser. Hvis performance forringes med længere kontekst, er det tegn på context rot. Hvis performance forbedres med bedre kontekst-engineering, validerer det din tilgang. Succesrate, latenstid og fejlrater er alle nyttige metrics at følge.

FlowHunts analysefunktioner gør det lettere at overvåge disse metrics på tværs af dine agent-workflows. Ved at integrere kontekst-engineering-overvågning i din workflow-platform kan du nemt se, hvor godt din kontekst-engineering fungerer, og hvor der er optimeringsmuligheder.

Efterhånden som agentteknologien modnes, opstår mere sofistikerede mønstre. Ambient agents er fx agenter, der kører kontinuerligt i baggrunden, bevarer state og kontekst over mange interaktioner. Disse agenter står over for unikke kontekst-engineering-udfordringer, fordi de skal bevare relevant kontekst over lange perioder uden at skabe context bloat. Løsningen involverer avanceret hukommelsesstyring, periodisk komprimering og omhyggelig kontekst-isolation.

Et andet fremspirende mønster er kontinuerlig kontekststyring—i stedet for kun at kontekst-engineere ved begyndelsen af en agents eksekvering, forfiner og optimerer du konteksten løbende, mens agenten kører. Det kan indebære periodisk komprimering af beskedhistorik, fjernelse af irrelevant kontekst eller omstrukturering af kontekst for bedre performance. Dette kræver mere avancerede agentarkitekturer og bedre værktøjer, men kan dramatisk forbedre ydeevnen for langvarige agenter.

Disse avancerede mønstre er stadig under udforskning og forfinelse, men de repræsenterer fremtiden for agent-engineering. Efterhånden som agenter bliver mere kapable og implementeres i mere komplekse scenarier, vil kontekst-engineering blive stadig mere sofistikeret.

Oplev hvordan FlowHunt automatiserer dine AI- og SEO-workflows — fra research og indholdsgenerering til publicering og analyse — alt samlet ét sted.

Kontekst-engineering er stadig en relativt ny disciplin, men det er hurtigt ved at blive en kernekompetence for AI-ingeniører. Efterhånden som LLM’er bliver mere kapable og agenter mere komplekse, vil betydningen af kontekst-engineering kun vokse. Vi vil sandsynligvis se mere avancerede værktøjer og frameworks, der er designet specifikt til kontekst-engineering. Vi vil se mere forskning i optimale strategier for kontekststyring. Vi vil opleve best practices opstå og blive konsolideret.

En lovende retning er udviklingen af bedre abstraktioner for kontekststyring. I stedet for manuelt at implementere kontekst-engineering-strategier, vil udviklere måske bruge frameworks, der håndterer kontekst-engineering automatisk. LangGraph bevæger sig i denne retning ved at tilbyde bedre primitiver til styring af agent-state og kontekstflow. FlowHunt udvider dette med workflow-niveau abstraktioner, som gør det lettere at implementere kontekst-engineering-mønstre på tværs af komplekse agentsystemer.

En anden lovende retning er udviklingen af bedre metrics og overvågning for kontekst-engineering. Efterhånden som vi bliver bedre til at måle kontekstforbrug og dets indvirkning på performance, kan vi optimere mere effektivt. Maskinlæringsteknikker kan endda bruges til automatisk at optimere kontekst-engineering-strategier baseret på observeret ydeevne.

Feltet udvikler sig hurtigt, og best practices er stadig under udvikling. Men de grundlæggende principper er klare: Kontekst er en værdifuld ressource, den skal engineer’es omhyggeligt, og den indsats, der investeres i kontekst-engineering, betaler sig i performance, pålidelighed og omkostningseffektivitet.

Kontekst-engineering er kunsten og videnskaben i at styre informationsflowet gennem AI-agenter for at optimere ydeevne, pålidelighed og omkostninger. Ved at forstå og implementere de fire kerne-strategier—write, select, compress og isolate—kan du bygge agenter, der skalerer effektivt og bevarer ydeevnen, selv når de udfører dusinvis eller hundredvis af skridt. Nøglen er at indse, at konteksthåndtering ikke er en eftertanke eller mindre optimering; det er den primære engineering-udfordring, når man bygger produktionsklare agenter. Begynd med at måle dit nuværende kontekstforbrug, identificer hvor kontekst ophobes unødvendigt, og anvend de rette strategier til at optimere. Overvåg resultaterne og iterér. Med omhyggelig kontekst-engineering kan du bygge agenter, der både er kraftfulde og effektive.

Kontekst-engineering er kunsten og videnskaben i at fylde en LLM’s kontekstvindue med præcis den rette information ved hvert trin i en agents forløb. Det indebærer håndtering af instruktioner, viden og værktøjs-feedback for at optimere agentens ydeevne, samtidig med at tokenomkostninger og performanceforringelse minimeres.

Prompt engineering handler om at udforme de indledende system- og brugermeddelelser til chatmodeller. Kontekst-engineering er bredere og gælder specifikt for agenter, hvor kontekst løbende tilføres dynamisk fra værktøjskald under agentens eksekvering. Det omfatter håndtering af alle kontekstkilder gennem agentens livscyklus – ikke kun den første prompt.

De fire primære strategier er: Write (gemme kontekst eksternt via scratchpads og hukommelser), Select (hente relevant kontekst ind i vinduet), Compress (reducere kontekststørrelse uden at miste information) og Isolate (adskille kontekst mellem flere agenter for at undgå interferens og styre kompleksitet).

Agenter foretager flere værktøjskald i rækkefølge, og hvert værktøjs output føres tilbage i LLM’s kontekstvindue. Uden ordentlig konteksthåndtering kan denne ophobning af værktøjs-feedback hurtigt overskride kontekstvinduet, øge omkostningerne markant og forringe ydeevnen gennem context rot og andre fejlsituationer.

FlowHunt tilbyder workflow-automatiseringsværktøjer, der hjælper med at styre agenteksekvering, kontekstflow og tilstandshåndtering. Platformen gør det muligt at implementere kontekst-engineering-strategier som offloading, komprimering og isolation i dine agent-workflows, hvilket mindsker tokenomkostninger og forbedrer pålideligheden.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Byg smartere AI-agenter med intelligent kontekst-engineering. FlowHunt hjælper dig med at styre agent-workflows, optimere tokenforbrug og skalere produktionsagenter effektivt.

Lær, hvordan kontekst-engineering optimerer AI-agenters ydeevne ved strategisk håndtering af tokens, reducering af kontekstbloat og implementering af avancerede...

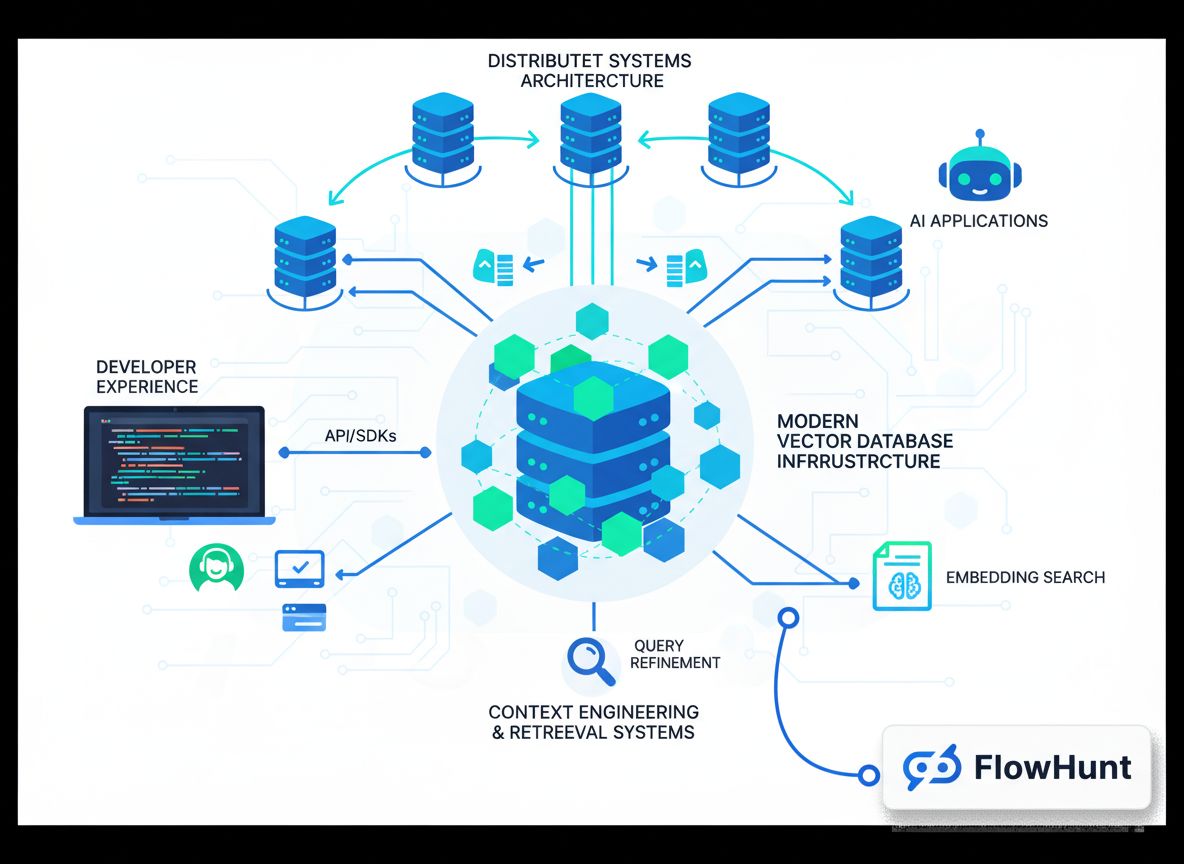

Udforsk hvordan kontekst engineering omformer AI-udvikling, udviklingen fra RAG til produktionsklare systemer, og hvorfor moderne vektordatabaser som Chroma er ...

Lær at bygge sofistikerede AI-agenter med adgang til filsystemet, implementere kontekst-offloading-strategier og optimere tokenforbrug gennem avancerede tilstan...