OpenAI O3 Mini AI Agent: En kompakt, men kraftfuld AI-model

Er OpenAI O3 Mini det rette AI-værktøj for dig? Vi sætter den på prøve med indholdsgenerering, beregninger og mere. Se, hvordan denne model balancerer ydeevne m...

Opdag hvordan en lille 7M-parameter-model overgår Gemini, DeepSeek og Claude ved hjælp af rekursiv ræsonnement og dyb supervision. Lær den revolutionerende tilgang, der udfordrer alt, vi ved om AI-skala.

Kunstig intelligens har længe fungeret ud fra en grundlæggende antagelse: større er bedre. Større modeller med flere parametre, mere træningsdata og flere computerressourcer præsterer konsekvent bedre end deres mindre modparter. Et banebrydende forskningspapir fra Samsung har dog udfordret denne konventionelle visdom på en måde, der kan ændre vores opfattelse af AI-modeldesign og effektivitet. Et lille neuralt netværk med kun 7 millioner parametre—en brøkdel af størrelsen på frontlinjemodeller som GPT-4, Gemini 2.5 Pro eller DeepSeek—opnår nu bedre resultater på nogle af de mest udfordrende ræsonnementsbenchmarks inden for kunstig intelligens. Denne bemærkelsesværdige præstation skyldes ikke bare øgning af træningsdata eller computerkraft. Det repræsenterer i stedet en grundlæggende nytænkning af, hvordan neurale netværk angriber komplekse problemløsningsopgaver, via en teknik kaldet rekursivt hierarkisk ræsonnement kombineret med dyb supervision. I denne omfattende guide vil vi udforske, hvordan denne lille model fungerer, hvorfor den er så effektiv, og hvad det betyder for fremtidens AI-udvikling og anvendelse.

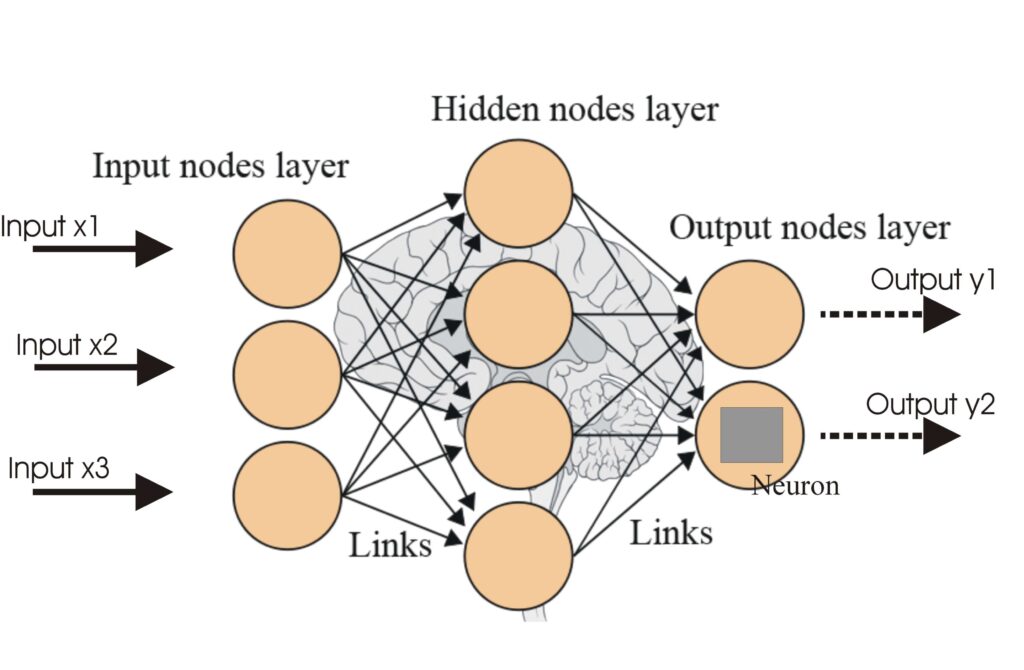

Inden vi kan værdsætte innovationen bag Tiny Recursive Model, må vi først forstå, hvorfor store sprogmodeller har svært ved komplekse ræsonnementsopgaver. Moderne store sprogmodeller som GPT-4, Claude og Gemini arbejder ud fra et princip: de forudsiger den næste token i en sekvens baseret på de forrige tokens. Denne autoregressive tilgang har vist sig meget effektiv til mange opgaver, fra oversættelse til opsummering og kreativ skrivning. Men når det gælder svære ræsonnementopgaver—særligt dem, der kræver flere trin af logisk deduktion, opfyldelse af betingelser eller abstrakt mønstergenkendelse—viser denne tilgang markante begrænsninger. Problemet er, at én forkert token-forudsigelse kan ugyldiggøre et helt svar. Forestil dig at løse en kompleks matematisk ligning: hvis modellen begår en fejl i første trin, bliver alle efterfølgende trin meningsløse. Dette fejlskred bliver eksponentielt værre, jo mere komplekse problemerne er. Derudover “resonerer” store sprogmodeller ikke som mennesker. De foretager sofistikeret mønstermatching ud fra træningsdata, ikke egentlig logisk inferens. Når de stilles overfor nye problemer, der kræver ræsonnement ud over deres træningsdistribution, fejler de ofte spektakulært. Dette er grunden til, at selv de mest avancerede modeller kæmper med benchmarks som ARC AGI (Abstraction and Reasoning Corpus), der specifikt tester evnen til at løse nye ræsonnementsopgaver, som kræver ægte abstrakt tænkning frem for mønstergenkendelse.

AI-forskningsmiljøet har udviklet flere teknikker for at imødegå de ræsonnementsbegrænsninger, der er i store sprogmodeller, hver med sine styrker og svagheder. Den mest fremtrædende er chain-of-thought prompting, en teknik der nu er udbredt i moderne AI-systemer. Chain-of-thought fungerer ved at opfordre modellen til at generere ræsonnement trin-for-trin, inden den giver sit endelige svar. I stedet for straks at hoppe til en konklusion, bliver modellen bedt om at “tænke sig om”, generere mellemtrin i ræsonnementet, som fører til det endelige svar. Denne tilgang har vist sig overordentlig effektiv, og studier viser, at chain-of-thought markant kan forbedre præstationen på ræsonnementsopgaver. Men chain-of-thought har også betydelige ulemper. For det første er det beregningsmæssigt dyrt—at generere flere ræsonnementstrin kræver mange ekstra tokens, hvilket øger inferenstiden og computeromkostninger. For det andet kræver det træningsdata af høj kvalitet, hvilket er dyrt og tidskrævende at skabe. Og måske vigtigst, så er chain-of-thought skrøbelig. Det genererede ræsonnement kan være forkert, og hvis ræsonnementet er fejlbehæftet, vil slutsvaret også være forkert. Modellen verificerer ikke sit ræsonnement; den genererer blot plausibelt lydende forklaringer, som kan være logisk forkerte. En anden populær teknik er pass-at-K sampling, hvor modellen genererer flere kandidatsvar og vælger det bedste. Hvis du spørger modellen “Hvad er 5 gange 5?”, kan den generere ti forskellige svar og vælge det mest korrekte. Selvom det kan forbedre nøjagtigheden, er det også beregningsmæssigt dyrt og adresserer ikke det grundlæggende problem: modellen resonerer stadig ikke; den genererer blot flere forudsigelser og håber, at et af dem er korrekt. Disse teknikker betegnes som “test-time compute scaling”—man bruger flere ressourcer ved inferens for at forbedre svarkvaliteten. Selvom de er effektive, er denne tilgang grundlæggende begrænset, fordi modellen stadig ikke udfører egentligt ræsonnement; den laver blot flere gæt og håber på bedre resultater.

For at forstå betydningen af Tiny Recursive Models præstationer, skal vi forstå det benchmark, modellen evalueres på: ARC AGI (Abstraction and Reasoning Corpus). ARC AGI-benchmarken blev skabt for at teste noget, som de fleste AI-benchmarks ikke gør: ægte abstrakt ræsonnementsevne. I modsætning til benchmarks, der tester viden eller mønstergenkendelse, præsenterer ARC AGI nye visuelle ræsonnementspuslespil, der kræver evnen til at identificere abstrakte mønstre og anvende dem i nye situationer. Benchmarken består af opgaver, hvor modellen vises eksempler på input-output-par og skal finde den underliggende regel eller transformation og derefter anvende den på nye inputs. Dette er ikke opgaver, der kan løses via memorering eller mønstermatching fra træningsdata; de kræver ægte ræsonnement og evnen til at generalisere abstrakte koncepter. Siden ARC AGI-benchmarken blev introduceret i 2019, har den været guldstandarden for vurdering af ræsonnementsevner i AI-systemer. På trods af seks års fremskridt i store sprogmodeller er menneskelig nøjagtighed på ARC AGI stadig ikke opnået. Det er en ydmygende påmindelse om, at selvom moderne AI-systemer er imponerende, kæmper de stadig med opgaver, som mennesker finder forholdsvis ligetil. Gemini 2.5 Pro, en af de mest avancerede modeller, opnår kun 4,9% nøjagtighed på ARC AGI 2 selv med betydelige computerressourcer. Den nyere ARC AGI 3 benchmark er endnu mere udfordrende, hvor topmodeller kæmper med at gøre meningsfulde fremskridt. Det er i denne kontekst, Tiny Recursive Models præstationer bliver virkelig bemærkelsesværdige. En model med 7 millioner parametre—mindre end 0,01% af parametrene i Gemini 2.5 Pro—opnår 45% nøjagtighed på ARC AGI 1 og 8% på ARC AGI 2, hvilket klart overgår disse massive frontlinjemodeller.

Den centrale innovation bag Tiny Recursive Model er en teknik kaldet rekursivt hierarkisk ræsonnement, som repræsenterer en fundamentalt anderledes tilgang til, hvordan neurale netværk løser komplekse problemer. For at forstå denne teknik kan du tænke på en analogi: Forestil dig, at du forsøger at løse en svær Sudoku. Du løser den ikke i ét hug, hvor du træffer alle beslutninger på én gang. I stedet gætter du, overvejer om gættet giver mening ift. reglerne, og hvis det ikke virker, reviderer du dit gæt og prøver igen. Du går måske gennem denne cyklus adskillige gange, hver gang du forfiner din løsning ud fra tidligere forsøg og ræsonnement om, hvorfor de fejlede. Denne iterative forfinelsesproces er i sin kerne det, rekursivt hierarkisk ræsonnement gør. Modellen opretholder to hovedinformationer: sit nuværende bedste gæt på løsningen og et spor af ræsonnementet, der førte til dette gæt. Ved hvert rekursions-trin opdaterer modellen begge informationer. Den ser på sit nuværende gæt, reflekterer over ræsonnementet, der førte til det, og genererer et forbedret gæt baseret på dette. Processen gentages, hvor det forbedrede gæt og opdaterede ræsonnement bruges som input til næste iteration. Den oprindelige hierarkiske ræsonnementsmodel (HRM), som inspirerede dette arbejde, brugte to separate neurale netværk, der arbejdede i forskellige hierarkier eller “hastigheder.” Den biologiske begrundelse var, at den menneskelige hjerne arbejder på forskellige tidsmæssige frekvenser—nogle processer er hurtige og reaktive, andre langsomme og overvejede. De to netværk i HRM skulle efterligne dette, med ét hurtigt og ét langsomt netværk, som arbejdede sammen i et loop. Samsung-forskerne bag Tiny Recursive Model satte dog spørgsmålstegn ved denne biologiske begrundelse. Selvom det er interessant at drage paralleller mellem kunstige neurale netværk og biologiske hjerner, forklarer sådanne analogier ikke nødvendigvis, hvorfor en given arkitektur er effektiv. Den oprindelige HRM-artikel støttede sig til biologiske argumenter og komplekse matematiske teoremer (fixed-point teoremer) for at retfærdiggøre designet, men leverede ikke klare ablation-studier, der viste, hvilke komponenter der faktisk bidrog til præstationsforbedringer. Forskerne stillede derfor et enkelt, men dybt spørgsmål: Hvorfor bruge to netværk? Hvorfor ikke ét? Hvorfor ikke tre eller fire? Og mere grundlæggende, hvorfor skal arkitektoniske valg retfærdiggøres ud fra biologi frem for empiriske resultater?

Svaret på disse spørgsmål førte til udviklingen af Tiny Recursive Model (TRM), der tager den centrale indsigt fra rekursivt ræsonnement, men fjerner kompleksiteten og de biologiske begrundelser. I stedet for at bruge to mellemstore netværk på forskellige hierarkier, bruger TRM ét lille netværk med blot to lag. Modellen er bemærkelsesværdigt simpel—pseudokoden for TRM kan være på én skærm. Denne enkelhed er ikke en begrænsning; det er et aktiv. Ved at eliminere unødig kompleksitet kunne forskerne fokusere på, hvad der virkelig betyder noget: selve den rekursive forfinelsesproces. Den vigtige indsigt er, at modellen skal opretholde to informationer: sit nuværende gæt og ræsonnementssporet, der førte til dette gæt. Det er ikke nødvendigvis forskellige hierarkier eller tidsfrekvenser; det er blot to typer information, modellen skal holde styr på. Ved hvert rekursionstrin tager modellen disse to informationer som input, behandler dem gennem sit lille tolagsnetværk og producerer opdaterede versioner af både gæt og ræsonnementsspor. Processen gentages flere gange, hvor hver iteration potentielt forbedrer løsningen. Skønheden ved denne tilgang er, at den giver det forskerne kalder “virtuel dybde.” Selvom netværket kun har to lag, får modellen gennem gentagen rekursion reelt meget større dybde. Det er som om modellen simulerer et meget dybere netværk gennem iteration snarere end flere lag. Dette er en vigtig indsigt, da det udfordrer den konventionelle visdom om, at dybere netværk altid er bedre. I traditionelt design øger vi antallet af lag for at give modellen kapacitet til at lære komplekse funktioner. Men Tiny Recursive Model viser, at man kan opnå lige så gode eller bedre resultater ved at holde netværket simpelt og øge antallet af rekursionstrin. Det er en fundamentalt ny måde at tænke modelarkitektur på.

Den anden centrale innovation i Tiny Recursive Model er en teknik kaldet dyb supervision. Mens rekursivt ræsonnement giver den iterative forfinelse, sikrer dyb supervision, at modellen lærer effektivt af hver iteration. I traditionel supervised learning laver modellen en forudsigelse og får kun feedback på det endelige output. Hvis det endelige svar er forkert, lærer modellen, at hele processen var forkert, men den får ikke specifik feedback om, hvilke mellemtrin der var problemet. Dyb supervision ændrer dette ved at give feedbacksignaler på flere mellemtrin under ræsonnementsprocessen. I stedet for kun at kontrollere, om det endelige svar er korrekt, får modellen feedback på hvert rekursionstrin. Det betyder, at modellen lærer ikke bare om dens endelige svar er rigtigt eller forkert, men om hvert trin i ræsonnementet bevæger sig i den rigtige retning. Effekten af dyb supervision på præstationen er dramatisk. I de indledende eksperimenter fordoblede brugen af dyb supervision nøjagtigheden sammenlignet med enkelttrins supervision, fra 19% til 39% på visse opgaver. Dette er en enorm forbedring fra blot én arkitektonisk ændring. Grunden til at dyb supervision er så effektiv er, at den giver meget rigere læringssignaler. Når en model kun får feedback på det endelige svar, skal den gennem backpropagation regne ud, hvilke mellemtrin der var ansvarlige for fejlen. Dette er et svært credit assignment-problem, især i dybe netværk. Ved at give direkte supervision på hvert trin får modellen klar feedback om, hvorvidt hvert mellemtrin er korrekt, hvilket gør det meget lettere at lære korrekt adfærd. Desuden hjælper dyb supervision med at undgå, at modellen sidder fast i lokale optima. Hvis modellen træffer en forkert beslutning tidligt i ræsonnementsprocessen, vil dyb supervision straks fange dette og give feedback til at korrigere det, i stedet for at fejlen først bliver opdaget flere trin senere.

De præstationsforbedringer, som Tiny Recursive Model opnår, er intet mindre end bemærkelsesværdige. På Sudoku Extreme benchmark steg modellens nøjagtighed fra 55% til 87%. På Maze Hard benchmark gik den fra 75% til 85%. På ARC AGI 1 opnåede den 45% nøjagtighed sammenlignet med 40% for den tidligere tilgang. På ARC AGI 2 opnåede den 8% mod 5% for tidligere metode. Selvom forbedringerne på ARC AGI 2 måske virker små—fra 5% til 8%—repræsenterer det en relativ forbedring på 60%, hvilket er betydeligt i et felt, hvor fremskridt ofte måles i enkeltcifrede procentpoint. Endnu vigtigere skal disse resultater ses i forhold til modelstørrelsen. Tiny Recursive Model har kun 7 millioner parametre. Til sammenligning har Gemini 2.5 Pro, DeepSeek R1 og Claude 3.7 hver hundreder af milliarder af parametre. Tiny Recursive Model opnår konkurrencedygtige eller bedre resultater på disse benchmarks, mens den bruger mindre end 0,01% af parametrene i disse frontlinjemodeller. Sammenligner man præstation i forhold til antallet af parametre, er Tiny Recursive Model flere størrelsesordener mere effektiv. Det har dybtgående implikationer for AI-udrulning. Mindre modeller er billigere at køre, kræver mindre computerinfrastruktur og kan implementeres på edge-enheder eller i ressourcetrængte miljøer. Hvis en 7M-parameter-model kan opnå samme eller bedre præstation end modeller med hundredvis af milliarder parametre, åbner det helt nye muligheder for AI-applikationer. Den eneste frontlinjemodel, der overgik Tiny Recursive Model på disse benchmarks, var Gro for Thinking, som opnåede markant bedre resultater. Gro for Thinking er dog en enorm model med over en billion parametre—mere end 140.000 gange større end TRM. Selv medregnet denne størrelsesforskel er Tiny Recursive Models effektivitet imponerende.

For at forstå, hvorfor rekursivt ræsonnement er så effektivt, må vi tænke over karakteren af komplekse ræsonnementsopgaver. Mange svære ræsonnementsopgaver har en bestemt struktur: de indebærer at finde en løsning, der opfylder flere betingelser, eller at finde et mønster, der forklarer et sæt observationer. Disse problemer kan ofte ikke løses i én forlæns gennemløb af et neuralt netværk. I stedet kræver de iterativ forfinelse, hvor man genererer et kandidatforslag, tester det mod betingelserne eller observationerne, identificerer hvor det fejler, og derefter forfiner det. Det er præcis det, rekursivt ræsonnement muliggør. Ved at opretholde både et aktuelt gæt og et ræsonnementsspor kan modellen udføre denne iterative forfinelsesproces. Ræsonnementssporet fungerer som en form for arbejdshukommelse, der gør det muligt for modellen at holde styr på, hvad den har forsøgt, hvad der virkede, og hvad der ikke gjorde. Dette er fundamentalt anderledes end, hvordan traditionelle neurale netværk fungerer. Et traditionelt netværk behandler input gennem en række lag og producerer et output. Der er ingen mekanisme til at genbesøge tidligere beslutninger eller opretholde et ræsonnementsspor. Netværket kan ikke sige “Jeg prøvede denne tilgang, og det virkede ikke, så jeg prøver noget andet.” Det bearbejder bare input og producerer et output. Rekursivt ræsonnement ændrer dette ved eksplicit at indbygge en mekanisme til iterativ forfinelse og opretholdelse af et ræsonnementsspor. Det gør modellen i stand til at udføre en form for ræsonnement, der minder langt mere om den måde, mennesker løser komplekse problemer på. Når mennesker løser et svært puslespil, tænker vi ikke bare én gang og giver et svar. Vi tænker, genererer et kandidatforslag, tjekker det, finder problemer og forfiner det, måske mange gange. Rekursivt ræsonnement gør det muligt for neurale netværk at gøre noget lignende. En anden vigtig indsigt er, at rekursivt ræsonnement giver en slags regularisering. Ved at tvinge modellen til at opretholde et ræsonnementsspor og forfine sit svar iterativt, bliver modellen tvunget til at lære løsninger, der er mere generaliserbare. En model, der kun kan give et svar i ét gennemløb, kan risikere at lære mønstre udenad fra træningsdata. En model, der skal forfine sit svar iterativt og opretholde et ræsonnementsspor, tvinges til at lære mere grundlæggende principper, der kan anvendes på nye problemer. Det hjælper til at forklare, hvorfor Tiny Recursive Model generaliserer så godt til nye problemer, selvom den er trænet på forholdsvis få data.

Tiny Recursive Models implikationer rækker ud over akademisk forskning og ind i praktiske anvendelser. Organisationer har i stigende grad behov for at automatisere komplekse ræsonnementsopgaver—fra dataanalyse og mønstergenkendelse til beslutningstagning og problemløsning. Traditionelt har disse opgaver krævet enten menneskelig ekspertise eller store, dyre AI-modeller. Tiny Recursive Model åbner nye muligheder for effektiv automatisering af disse opgaver. FlowHunt, en AI-workflow-automationsplatform, kan udnytte disse fremskridt i ræsonnementsmodeller til at skabe mere effektive og omkostningseffektive automationsløsninger. I stedet for at være afhængig af massive modeller, der kræver store ressourcer, kan FlowHunt integrere mindre, mere effektive modeller som Tiny Recursive Model i automatiserede workflows. Det gør det muligt for organisationer at bygge intelligente automationssystemer, der kan håndtere komplekse ræsonnementsopgaver uden omkostningerne ved at køre enorme modeller. Forestil dig f.eks. et workflow, der skal analysere kundedata, identificere mønstre og give anbefalinger. Ved brug af en traditionel stor sprogmodel ville dette workflow være dyrt at køre i stor skala. Ved brug af en lille rekursiv model integreret i et FlowHunt-workflow kunne samme opgave løses til en brøkdel af prisen. Modellen kunne iterativt forfine sin analyse, opretholde et ræsonnementsspor, der forklarer dens anbefalinger, og give transparens i, hvordan den nåede frem til sine konklusioner. Dette er især værdifuldt i domæner, hvor forklarbarhed er vigtig, såsom sundhed, finans eller juridiske anvendelser. Ræsonnementssporet fra den rekursive model giver et klart indblik i modellens tankeproces, hvilket gør det lettere at forstå og verificere modellens beslutninger. Derudover gør effektiviteten af små rekursive modeller det muligt at implementere ræsonnementsevner på edge-enheder eller ressourcebegrænsede apparater. En mobilapp kunne potentielt indeholde ræsonnementsevner, der tidligere ville kræve cloud-baseret behandling. Det åbner nye muligheder for intelligente applikationer, der kan fungere offline eller med minimal netværksforbindelse.

Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-workflows — fra research og indholdsgenerering til udgivelse og analyser — alt samlet ét sted.

Succesen med Tiny Recursive Model udfordrer en af de mest grundlæggende antagelser i moderne AI-udvikling: scaling laws, som har styret feltet det sidste årti. Scaling laws siger, at præstationen forudsigeligt forbedres, når modelstørrelse, træningsdata og computerressourcer øges. Større modeller er bedre. Mere data er bedre. Mere computerkraft er bedre. Denne antagelse har drevet udviklingen af stadig større modeller, hvor virksomheder investerer milliarder i træning af modeller med hundreder af milliarder eller endda billioner af parametre. Tiny Recursive Model antyder, at denne antagelse kan være ufuldstændig eller ligefrem vildledende i visse sammenhænge. Ved at bruge en anden arkitektonisk tilgang—rekursivt ræsonnement med dyb supervision—kan en lille model opnå præstation på niveau med eller bedre end massive modeller på bestemte opgaver. Det betyder ikke, at scaling laws er forkerte; det antyder snarere, at der er flere veje til høj præstation, og at skalering af modelstørrelse kun er én af dem. Det har dybtgående konsekvenser for fremtidens AI-udvikling. Hvis mindre modeller kan opnå tilsvarende præstation gennem kloge arkitektoniske innovationer, kan det føre til et skifte i, hvordan AI-systemer udvikles og udrulles. I stedet for udelukkende at fokusere på at bygge større og større modeller, kan feltet skifte mod at udvikle mere effektive arkitekturer, der kan opnå høj præstation med færre parametre. Det vil have store fordele for miljøet, for computer-effektivitet og for tilgængelighed. Træning og drift af enorme modeller kræver enorme mængder elektricitet og computerressourcer. Hvis vi kan opnå lignende præstation med modeller, der er flere størrelsesordener mindre, vil det reducere AI-udviklingens miljøpåvirkning og gøre AI mere tilgængelig for organisationer med begrænsede ressourcer. Tiny Recursive Model antyder også, at forholdet mellem modelstørrelse og generalisering kan være mere komplekst end hidtil antaget. Konventionel visdom siger, at større modeller generaliserer bedre, fordi de har mere kapacitet til at lære komplekse mønstre. Men Tiny Recursive Model viser, at mindre modeller kan generalisere bedre, hvis de designes med de rette induktive bias. Ved at indbygge mekanismer til iterativ forfinelse og opretholdelse af ræsonnementsspor bliver modellen tvunget til at lære mere generaliserbare løsninger. Det er et eksempel på, hvordan arkitektoniske innovationer nogle gange kan være vigtigere end ren modelstørrelse.

En af de mest slående ting ved Tiny Recursive Model er dens enkelhed. Modellen har kun to lag og opnår sin præstation gennem rekursiv forfinelse, ikke gennem kompleksitet. Denne enkelhed er ikke tilfældig; det er et bevidst designvalg baseret på empiriske fund. Forskerne fandt, at flere lag faktisk gav mindre generalisering pga. overfitting. Dette er kontraintuitivt og udfordrer klassisk visdom om neural netværksdesign. Normalt tænker vi, at dybere netværk er mere kraftfulde og kan lære mere komplekse funktioner. Men Tiny Recursive Model viser, at i ræsonnementopgaver er dybde gennem rekursion mere effektiv end dybde gennem flere lag. Hvorfor? En forklaring er, at flere lag øger modellens kapacitet til at memorere specifikke mønstre fra træningsdata, hvilket kan føre til overfitting. Ved at holde netværket lavt og i stedet øge antallet af rekursionstrin tvinges modellen til at lære mere generaliserbare løsninger. Hvert rekursionstrin må arbejde med samme tolagsnetværk, så netværket må lære at udføre nyttige beregninger, der kan anvendes gentagne gange. Denne begrænsning tvinger modellen til at lære mere grundlæggende principper fremfor at memorere. En anden forklaring relaterer sig til karakteren af ræsonnementopgaverne. Disse opgaver indebærer ofte iterativ forfinelse og opfyldelse af betingelser. Et lavt netværk, der anvendes rekursivt, egner sig godt til denne type problem, fordi det kan fokusere på trinvis forbedring af løsningen. Et dybt netværk vil i modsætning forsøge at løse hele problemet på én gang, hvilket er mindre effektivt for denne type opgaver. Enkelheden ved Tiny Recursive Model har også praktiske fordele. Simpelthen opbyggede modeller er lettere at forstå, fejlfinde og tilpasse. Vil du vide, hvorfor modellen traf en bestemt beslutning, kan du følge dens ræsonnement trin for trin. Vil du ændre modellen til at håndtere en ny type problem, kan du målrette ændringer i arkitektur eller træningsprocedure. Dette står i kontrast til massive modeller med milliarder af parametre, som reelt er black boxes, der er svære at forstå eller ændre. Princippet om, at “mindre er mere”, gælder ikke kun modelarkitekturen. Forskerne fandt også, at modellen ikke behøver komplekse matematiske teoremer eller biologiske argumenter for at virke effektivt. Den oprindelige hierarkiske ræsonnementsmodel baserede sig på fixed-point-teoremer og biologiske overvejelser om hjernen. Tiny Recursive Model virker uden disse teoretiske begrundelser. Det er simpelthen en model, der opretholder to informationer og forfiner dem iterativt. Det antyder, at den enkleste forklaring nogle gange er den bedste, og at vi ikke skal overkomplicere vores modeller med teoretiske begrundelser, der måske ikke er nødvendige.

Succesen med Tiny Recursive Model har væsentlig betydning for, hvordan AI-systemer vil blive udviklet og implementeret fremover. For det første antyder det, at effektivitet bør være et primært designmål, ikke en eftertanke. I stedet for at bygge enorme modeller og derefter forsøge at komprimere eller optimere dem til implementering, bør vi designe modeller med effektivitet for øje fra starten. Tiny Recursive Model viser, at man kan opnå høj præstation med en lille, effektiv model, hvis arkitekturen designes omhyggeligt. For det andet antyder det, at arkitektonisk innovation kan være vigtigere end skalering. Selvom feltet har fokuseret massivt på at gøre modeller større, viser Tiny Recursive Model, at kloge arkitektoniske innovationer nogle gange er mere effektive end bare at gøre modellerne større. Det kan føre til fornyet fokus på arkitekturdesign og et skifte væk fra “større er bedre”-mentaliteten. For det tredje antyder det, at ræsonnementsevner kan bygges ind i modeller via arkitektonisk design og ikke kun gennem skala. Tiny Recursive Model opnår stærk ræsonnementsevne ikke fordi den er massiv, men fordi den er designet med mekanismer til iterativ forfinelse og opretholdelse af ræsonnementsspor. Det kan føre til nye tilgange til at indbygge ræsonnement i AI-systemer. For det fjerde har det konsekvenser for, hvordan vi evaluerer og benchmarker AI-systemer. ARC AGI-benchmarken har vist sig værdifuld for vurdering af ræsonnementsevner, og Tiny Recursive Models succes på denne benchmark antyder, at vi bør fortsætte med at udvikle benchmarks, der tester ægte ræsonnement og ikke kun mønstergenkendelse eller videnshentning. Ser vi fremad, er der flere retninger, denne forskning kan udvides i. Én retning er at udforske, hvordan rekursivt ræsonnement kan kombineres med andre teknikker som chain-of-thought prompting eller retrieval-augmented generation. En anden retning er at undersøge, hvordan rekursivt ræsonnement kan anvendes på andre typer problemer end visuelle ræsonnementsopgaver. En tredje mulighed er at undersøge, hvordan man kan opskalere rekursivt ræsonnement til større modeller og se, om principperne fortsat gælder. En fjerde retning er at undersøge, hvordan ræsonnementsprocessen kan gøres mere fortolkelig og transparent, så brugerne kan forstå, hvordan modellen nåede sine konklusioner.

Tiny Recursive Model repræsenterer et markant gennembrud i kunstig intelligens og viser, at mindre, mere effektive modeller kan opnå overlegen præstation på komplekse ræsonnementsopgaver gennem kloge arkitektoniske

Tiny Recursive Model er et neuralt netværk med 7 millioner parametre, der bruger rekursivt hierarkisk ræsonnement og dyb supervision til at opnå overlegen præstation på komplekse ræsonnementsopgaver sammenlignet med langt større modeller som Gemini 2.5 Pro og DeepSeek.

TRM benytter en ny tilgang, der kombinerer rekursiv ræsonnement (gentagende forbedringstrin) og dyb supervision (overførsel af lærte egenskaber mellem trin). Dette gør den lille model i stand til at tænke iterativt igennem problemer, ligesom menneskelig ræsonnement, i stedet for at forudsige svar i et enkelt hug.

TRM opnår 45% nøjagtighed på ARC AGI 1 og 8% på ARC AGI 2, hvilket overgår Gemini 2.5 Pro (4,9%), DeepSeek R1 og Claude 3.7, samtidig med at den bruger mindre end 0,01% af deres parametre.

Rekursiv ræsonnement gør det muligt for modellen at forfine sit svar iterativt ved at opretholde to hovedinformationer: det nuværende gæt og ræsonnementets spor. Dette skaber et feedback-loop, hvor modellen kan kritisere sig selv og revidere svar flere gange, ligesom mennesker løser komplekse problemer gennem forsøg og forfinelse.

Dyb supervision forbedrer nøjagtigheden ved at give feedbacksignaler på flere trin under ræsonnementsprocessen. I stedet for kun at kontrollere det endelige svar, modtager modellen feedback på hvert mellemtrin, hvilket fordoblede nøjagtigheden fra 19% til 39% i de indledende eksperimenter.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Byg intelligente automationsflows, der udnytter banebrydende AI-modeller og ræsonnementsteknikker til effektivt at løse komplekse problemer.

Er OpenAI O3 Mini det rette AI-værktøj for dig? Vi sætter den på prøve med indholdsgenerering, beregninger og mere. Se, hvordan denne model balancerer ydeevne m...

Opdag hvorfor Googles Gemini 3 Flash revolutionerer AI med overlegen ydeevne, lavere omkostninger og hurtigere hastigheder—even outperforming Gemini 3 Pro på ko...

Et neuralt netværk, eller kunstigt neuralt netværk (ANN), er en beregningsmodel inspireret af den menneskelige hjerne, essentiel i AI og maskinlæring til opgave...