AI-agenter: Sådan tænker GPT 4o

Udforsk tankeprocesserne hos AI-agenter i denne omfattende evaluering af GPT-4o. Opdag, hvordan den præsterer på opgaver som indholdsgenerering, problemløsning ...

En dybdegående analyse af LG’s EXAONE Deep 32B reasoning-model testet mod DeepSeek R1 og Alibabas QwQ med fokus på påstande om overlegen ydeevne og faktiske reasoning-evner.

Landskabet for kunstig intelligens reasoning-modeller er blevet stadig mere konkurrencepræget, hvor flere organisationer hævder gennembrud i ydeevne på komplekse matematiske og logiske reasoning-opgaver. LG’s nylige lancering af EXAONE Deep, en reasoning-model med 32 milliarder parametre, tiltrak stor opmærksomhed med påstande om at overgå etablerede konkurrenter som DeepSeek R1. Virkelighedens test afslører dog et mere nuanceret billede end markedsføringen antyder. Denne artikel giver en grundig analyse af EXAONE Deep’s faktiske ydeevne sammenlignet med andre førende reasoning-modeller og undersøger kløften mellem påståede benchmarks og praktisk funktionalitet. Gennem hands-on test og detaljeret sammenligning udforsker vi, hvad disse modeller faktisk kan, hvordan de håndterer komplekse reasoning-opgaver, og hvad det betyder for organisationer, der overvejer disse værktøjer til produktionsbrug.

Fremkomsten af reasoning-modeller repræsenterer et fundamentalt skifte i, hvordan kunstig intelligens griber komplekse problemløsningsopgaver an. I modsætning til traditionelle sprogmodeller, der genererer svar i et enkelt fremadrettet trin, benytter reasoning-modeller en teknik kaldet test-tids dekodning, som tildeler betydelige beregningsressourcer under inferens for at tænke sig gennem problemerne trin for trin. Denne tilgang spejler menneskelig tænkning, hvor vi ofte må anskue et problem fra flere vinkler, før vi finder en løsning. Konceptet blev kendt med OpenAI’s o1-model og er siden blevet adopteret af flere organisationer, herunder DeepSeek, Alibaba og nu LG. Disse modeller genererer det, der kaldes en “tænke-” eller “reasoning”-token-sekvens, som brugeren typisk ikke ser i det endelige output, men som repræsenterer modellens interne overvejelser. Tænketokens er vigtige, fordi de giver modellen mulighed for at udforske forskellige løsningsveje, fange fejl og forfine sin tilgang, før den forpligter sig til et endeligt svar. Dette er især værdifuldt for matematiske problemer, logiske reasoning-opgaver og komplekse flerstegs-scenarier, hvor et enkelt gennemløb af problemet kan overse vigtige detaljer eller føre til forkerte konklusioner.

For organisationer, der implementerer AI-systemer, repræsenterer reasoning-modeller et markant fremskridt i pålidelighed og nøjagtighed på komplekse opgaver. Traditionelle sprogmodeller har ofte svært ved flerstegs-matematiske problemer, logisk deduktion og situationer, der kræver omhyggelig analyse af begrænsninger og betingelser. Reasoning-modeller adresserer disse begrænsninger ved eksplicit at vise deres arbejdsproces, hvilket også giver gennemsigtighed i, hvordan modellen nåede sin konklusion. Denne gennemsigtighed er særlig vigtig i virksomheder, hvor beslutninger baseret på AI-anbefalinger skal kunne revideres og forklares. Ulempen er dog øget beregningsomkostning og latenstid. Fordi reasoning-modeller genererer omfattende tænketokens, før de producerer et endeligt svar, kræver de mere processorkraft og tager længere tid sammenlignet med standard sprogmodeller. Derfor er modelvalg kritisk—organisationer skal forstå ikke kun benchmarkscores, men også reel ydeevne i deres specifikke brugsscenarier. Proliferationen af reasoning-modeller fra forskellige leverandører, alle med påstande om overlegen ydeevne, gør uafhængig test og sammenligning afgørende for informerede beslutninger om implementering.

LG’s indtræden på reasoning-modellernes marked med EXAONE Deep vakte betydelig interesse, især i kraft af virksomhedens store forskningskapacitet og modellens relativt beskedne størrelse på 32 milliarder parametre. LG’s markedsføring præsenterede imponerende benchmarkresultater og hævdede, at EXAONE Deep opnåede 90% nøjagtighed på AIME (American Invitational Mathematics Examination) med kun 64 forsøg og 95% på MATH-500-opgaver. Disse tal ville, hvis de er korrekte, placere modellen på niveau med eller over DeepSeek R1 og Alibabas QwQ-modeller. Virksomheden lancerede også flere versioner af modellen i forskellige størrelser, herunder en variant med 2,4 milliarder parametre designet til brug som udkastmodel i spekulativ dekodning—en teknik, hvor mindre modeller forudsiger tokens, som større modeller vil generere, hvilket potentielt kan accelerere inferensen. Ved praktisk test på standard reasoning-opgaver udviste EXAONE Deep dog bekymrende adfærd, der modsiger benchmarkpåstandene. Modellen havde en tendens til at gå ind i lange tænkesløjfer uden at nå logiske konklusioner og genererede tusindvis af tokens, der virkede gentagne eller meningsløse frem for produktive. Dette peger på mulige problemer med modellens træning, benchmark-evaluering eller måden, modellen håndterer visse prompttyper.

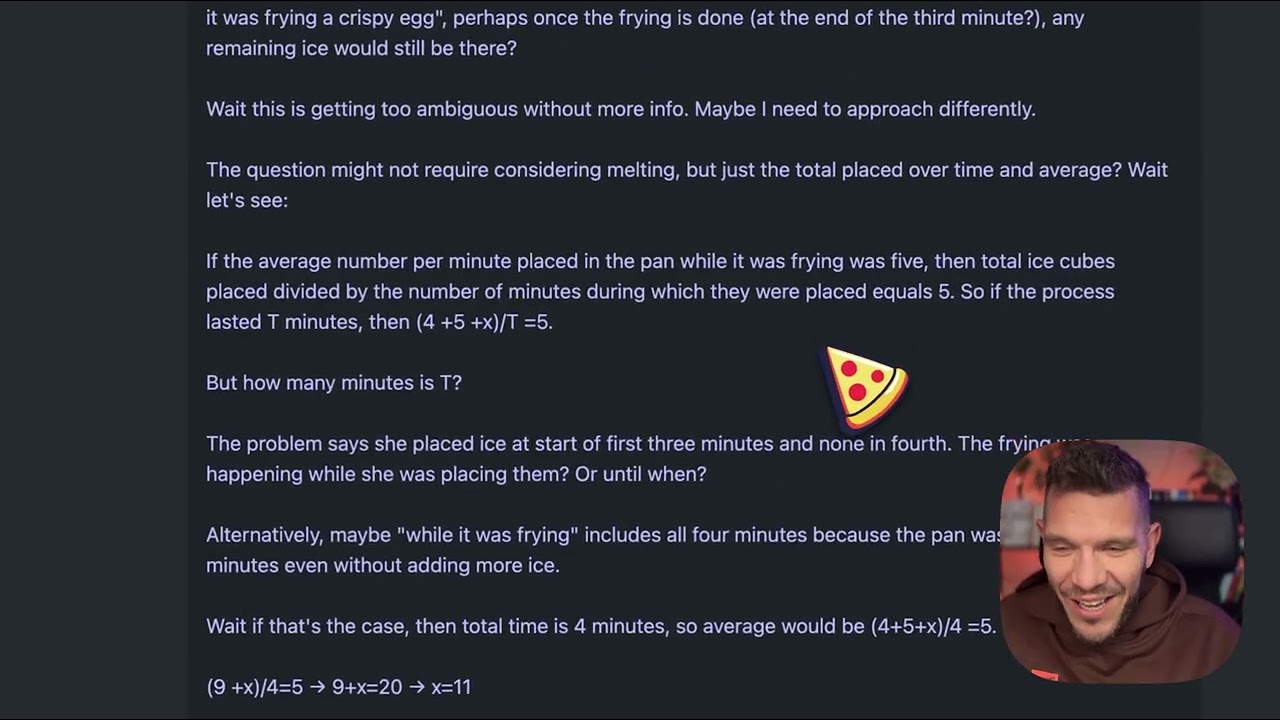

For at forstå de praktiske forskelle mellem reasoning-modeller, kan man se på et tilsyneladende simpelt problem, der er blevet standardtest for reasoning-modellernes kvalitet: “Beth lægger nogle hele isterninger i en pande. Efter et minut er der 20 isterninger. Efter to minutter er der 10 isterninger. Efter tre minutter er der 0 isterninger. Hvor mange hele isterninger findes der i panden ved slutningen af det tredje minut?” Det korrekte svar er nul, da spørgsmålet eksplicit spørger til hele isterninger efter tre minutter, og problemet siger, at der er nul på det tidspunkt. Problemet er dog designet til at forvirre modeller, der overtænker eller lader sig narre af fortællingen om smeltende is. Nogle modeller vil prøve at beregne smeltehastigheder og dermed komme væk fra det simple svar. Da EXAONE Deep blev testet på dette problem, genererede den omkring 5.000 tokens tænken uden at nå frem til en sammenhængende konklusion. Modellens reasoning-proces løb løbsk, og den genererede tekst blev mere og mere usammenhængende uden at demonstrere logisk problemløsning. Tokens bestod af fragmenter, som ikke udgjorde komplette tanker, og modellen formulerede aldrig klart en ræsonnementvej eller et endeligt svar. Denne performance står i skarp kontrast til, hvordan problemet bør håndteres—en reasoning-model bør genkende tricket, arbejde logisk gennem opgaven og nå svaret effektivt.

Da det samme isterning-problem blev testet på DeepSeek R1 og Alibabas QwQ-model, klarede begge sig væsentligt bedre. DeepSeek R1 viste en klar tankeproces, arbejdede metodisk gennem problemet og fandt korrekt frem til svaret nul. Modellens reasoning var gennemsigtig og logisk, og processen viste, hvordan den overvejede problemstillingen, genkendte tricket og kom frem til det rigtige svar. QwQ demonstrerede også stærk ydeevne, selvom den genererede en længere tænkeproces. Interessant nok overvejede QwQ indledningsvis, om isterningerne måske skulle bruge tid på at smelte, og om opgaven var fysik eller matematik, men kom alligevel frem til det rigtige svar. Den afgørende forskel var, at begge modeller udviste sammenhængende reasoning gennem hele processen, selv når de udforskede flere vinkler. De viste evnen til at genkende, hvornår de havde nok information til at svare og forpligte sig til et endeligt svar. EXAONE Deep, derimod, nåede aldrig til dette punkt. Modellen fortsatte med at generere tokens uden klart formål, uden at finde et svar eller vise en logisk progression. Det indikerer grundlæggende problemer med modellens håndtering af reasoning-opgaver, på trods af imponerende benchmarks.

Et interessant teknisk aspekt ved EXAONE Deep’s lancering er inkluderingen af flere modelstørrelser, der arbejder sammen via spekulativ dekodning. Versionen med 2,4 milliarder parametre kan fungere som en udkastmodel, der forudsiger tokens, som hovedmodellen på 32 milliarder parametre vil generere. Når udkastmodellens forudsigelser stemmer overens med hovedmodellens, kan systemet springe hovedmodellens beregning over og bruge udkastet, hvilket effektivt accelererer inferensen. Dette er en avanceret optimering, der kan reducere latenstid og beregningsbehov betydeligt. I test viste implementeringen grønne tokens, hvilket indikerer succesfulde udkastforudsigelser, så teknikken virkede efter hensigten. Denne optimering løser dog ikke det grundlæggende problem med hovedmodellens reasoning-kvalitet. Hurtigere inferens af dårlig reasoning er stadig dårlig reasoning. Tilstedeværelsen af denne optimeringsfunktion rejser også spørgsmål om, hvorvidt LG’s benchmarkresultater er opnået med konfigurationer eller teknikker, der ikke oversættes til reel brug.

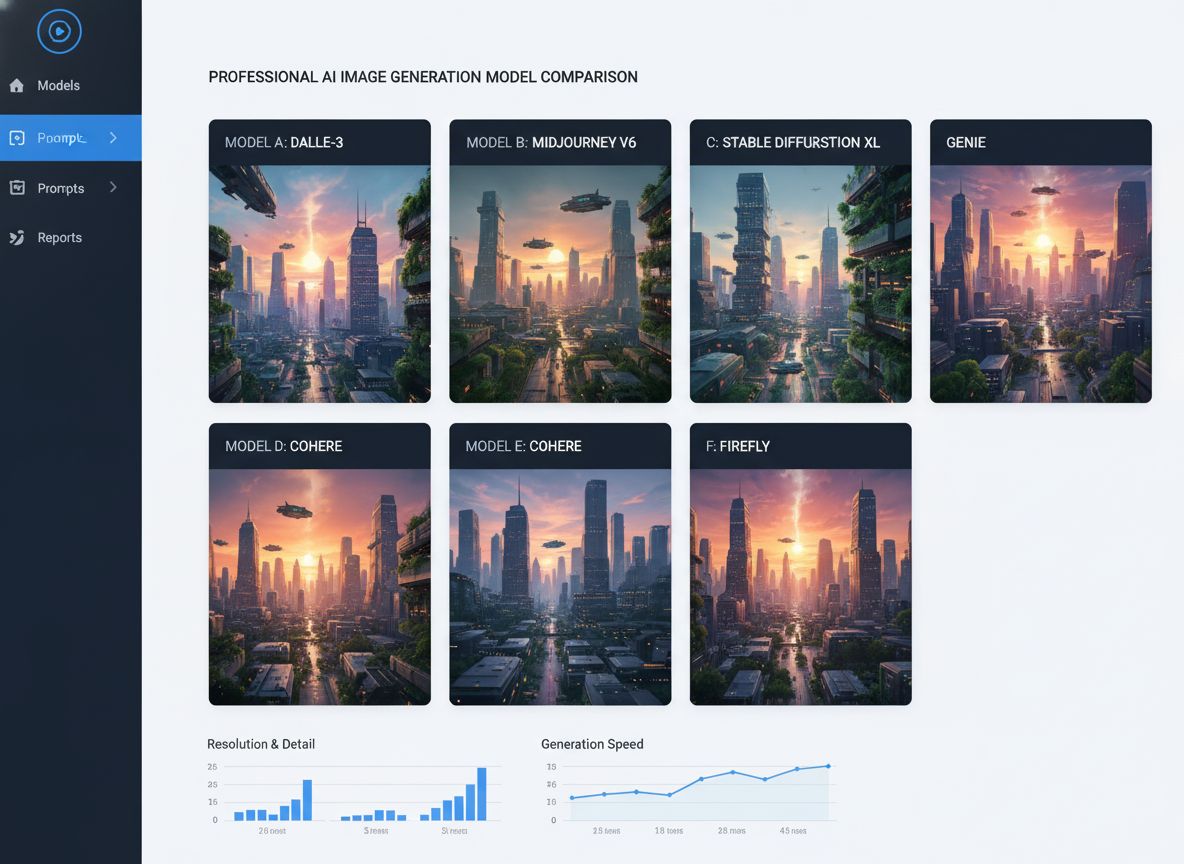

For organisationer, der kæmper med at evaluere og sammenligne flere AI-modeller, tilbyder FlowHunt en omfattende automatiseringsplatform, der strømline test- og benchmarkprocessen. I stedet for manuelt at teste forskellige modeller og sammenligne resultater gør FlowHunt det muligt for teams at opsætte automatiserede workflows, der systematisk evaluerer modelydeevne på tværs af flere dimensioner. Dette er særligt værdifuldt ved sammenligning af reasoning-modeller, hvor ydeevnen kan variere markant afhængigt af problemtype, kompleksitet og promptformulering. FlowHunts automatiseringsmuligheder gør det muligt for teams at teste modeller mod standardiserede opgavesæt, tracke performance over tid og generere omfattende sammenligningsrapporter. Platformen kan integrere med flere modeludbydere og API’er, så man kan evaluere modeller fra forskellige leverandører i ét samlet workflow. For teams, der overvejer reasoning-modeller som EXAONE Deep, DeepSeek R1 eller QwQ, giver FlowHunt infrastrukturen til at træffe datadrevne beslutninger baseret på faktisk ydeevne frem for leverandørpåstande. Platformens evne til at automatisere gentagne testopgaver frigør også ingeniørressourcer til integration og optimering frem for manuel benchmarking.

Kløften mellem EXAONE Deep’s påståede performance og dens faktiske adfærd i test understreger en vigtig lektie for AI-adoption: leverandørbenchmarks bør altid verificeres med uafhængig test. Benchmarkresultater kan påvirkes af mange faktorer, herunder det konkrete testdatasæt, evalueringsmetode, hardwarekonfiguration og modellens inferensparametre. En model kan klare sig godt på én benchmark, men kæmpe med andre problemtyper eller virkelighedsnære scenarier. Derfor spiller organisationer som Weights & Biases og uafhængige forskere en nøglerolle i AI-økosystemet—de leverer objektive tests og analyser, der hjælper branchen med at forstå modellernes reelle kapaciteter. Ved evaluering af reasoning-modeller til produktion bør organisationer lave egne tests på repræsentative opgaver fra deres domæne. En model, der er god til matematisk reasoning, kan være dårlig til logisk deduktion eller kodegenerering. Isterning-problemet, selv om det er simpelt, er en nyttig diagnose, fordi det afslører, om modellen kan håndtere trickspørgsmål og undgå overtænkning. Modeller, der fejler på sådanne opgaver, vil sandsynligvis også fejle på mere komplekse reasoning-opgaver.

De udvidede tænkesløjfer observeret i EXAONE Deep-testene kan skyldes flere mulige problemer. Én mulighed er, at modellens træningsproces ikke tilstrækkeligt lærte den, hvornår den skulle stoppe med at tænke og forpligte sig til et svar. Reasoning-modeller kræver omhyggelig kalibrering under træning for at balancere fordelene ved forlænget tænkning mod risikoen for overtænkning og uproduktive tokens. Hvis træningen ikke inkluderede nok eksempler på, hvornår man skal stoppe, kan modellen ende med at generere tokens, indtil den rammer en øvre grænse. En anden mulighed er, at modellen har problemer med prompthåndtering, især hvordan den fortolker visse spørgsmålstyper eller instruktioner. Nogle modeller er følsomme over for formuleringen af promts og opfører sig forskelligt afhængigt af spørgsmålets ordlyd. At EXAONE Deep genererede usammenhængende tokensekvenser antyder, at modellen kan gå ind i en tilstand, hvor den genererer tokens uden meningsfyldt indhold, hvilket kan tyde på problemer med opmærksomhedsmekanismer eller tokenforudsigelseslogik. En tredje mulighed er, at benchmark-evalueringen brugte andre konfigurationer eller promptstrategier end dem, der blev brugt i de praktiske tests, hvilket fører til en betydelig performancekløft mellem rapporterede og faktiske resultater.

De performanceproblemer, der observeres hos EXAONE Deep, har bredere implikationer for markedet for reasoning-modeller. Efterhånden som flere organisationer lancerer reasoning-modeller, er der risiko for, at markedet oversvømmes af modeller med imponerende benchmarkpåstande, men tvivlsom ydeevne i praksis. Det skaber udfordringer for organisationer, der skal vælge modeller til produktion. Løsningen er større fokus på uafhængig test, standardiserede evalueringsmetoder og transparens om modellernes begrænsninger. Reasoning-modellernes felt vil have gavn af industristandarder for evaluering og sammenligning, ligesom det er sket for andre AI-benchmarks. Organisationer bør også være varsomme over for modeller, der hævder at overgå etablerede konkurrenter betydeligt, især hvis performanceforskellen synes usandsynlig i forhold til modelarkitektur eller træning. DeepSeek R1 og QwQ har begge vist stabil performance på tværs af mange tests, hvilket giver tillid til deres evner. EXAONE Deeps inkonsistente performance—fremragende benchmarkpåstande men dårlig praktisk ydeevne—peger enten på problemer med selve modellen eller måden, benchmarks er udført på.

Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-workflows — fra research og indholdsgenerering til publicering og analyse — alt samlet ét sted.

Organisationer, der overvejer at implementere reasoning-modeller, bør følge en struktureret evalueringsproces. Først skal du etablere et repræsentativt testdatasæt med opgaver fra dit eget domæne eller brugsscenarie. Generiske benchmarks afspejler måske ikke modellens faktiske performance på dine problemer. Dernæst bør du teste flere modeller på de samme opgaver for at muliggøre direkte sammenligning. Det kræver standardisering af testmiljøet, herunder hardware, inferensparametre og promptformulering. Tredje trin er at vurdere ikke kun nøjagtighed, men også effektivitet såsom latenstid og tokenforbrug. En model, der giver rigtige svar, men kræver 10.000 tænketokens, er måske ikke praktisk, hvis du har brug for realtidsrespons. Fjerde trin er at undersøge modellens reasoning-proces, ikke kun det endelige svar. En model, der når frem til det korrekte svar gennem fejlbehæftet reasoning, risikerer at fejle på beslægtede problemer. Femte trin er at teste grænsetilfælde og trickspørgsmål for at forstå, hvordan modellen håndterer forvirrende scenarier. Til sidst bør du overveje de samlede ejeromkostninger, inklusiv modellicens eller API-omkostninger, de nødvendige beregningsressourcer og den tekniske integrationsindsats.

EXAONE Deeps størrelse på 32 milliarder parametre er markant mindre end visse konkurrerende reasoning-modeller, hvilket rejser spørgsmålet, om modellens problemer skyldes utilstrækkelig kapacitet. Alligevel er det ikke modelstørrelsen alene, der afgør reasoning-evnen. QwQ, der også opererer i et lignende parameterinterval, demonstrerer stærk reasoning-ydeevne. Det antyder, at EXAONE Deeps problemer snarere skyldes træningsmetodik, arkitekturdesign eller inferenskonfiguration end fundamentale begrænsninger ved størrelsen. Inkluderingen af en udkastmodel på 2,4 milliarder parametre i EXAONE Deep viser, at LG har fokus på effektivitet, hvilket er prisværdigt. Effektivitet er dog kun værdifuld, hvis modellen leverer korrekte resultater. Et hurtigt forkert svar er værre end et langsomt korrekt svar i de fleste produktionssammenhænge. Markedet for reasoning-modeller vil sandsynligvis fortsætte med at fokusere på effektivitet, men denne optimering må ikke ske på bekostning af reasoning-kvaliteten.

Markedet for reasoning-modeller er stadig i sin spæde begyndelse, og vi kan forvente betydelig udvikling de kommende måneder og år. Efterhånden som flere organisationer udgiver reasoning-modeller og uafhængige tests bliver flere, vil markedet sandsynligvis konsolidere sig omkring modeller, der viser stabil og pålidelig ydeevne. Organisationer som DeepSeek og Alibaba har opnået troværdighed gennem konsistent ydeevne, mens nyere aktører som LG skal adressere de observerede performanceproblemer for at opnå markedsaccept. Vi kan også forvente fortsat innovation i, hvordan reasoning-modeller trænes og evalueres. Den nuværende tilgang med at generere omfattende tænketokens er effektiv, men beregningstung. Fremtidige modeller vil muligvis udvikle mere effektive reasoning-mekanismer, der opnår samme nøjagtighed med færre tokens. Derudover vil vi sandsynligvis se øget specialisering, hvor reasoning-modeller optimeres til specifikke domæner som matematik, kodegenerering eller logisk reasoning. Integration af reasoning-modeller med andre AI-teknikker, såsom retrieval-augmented generation eller værktøjsbrug, vil også udvide deres muligheder og anvendelighed.

LG’s EXAONE Deep markerer en ambitiøs indtræden på markedet for reasoning-modeller, men virkelighedens test afslører betydelige kløfter mellem modellens påståede ydeevne og dens faktiske evner. Selvom modellens benchmarkresultater indikerer konkurrence med DeepSeek R1 og Alibabas QwQ, viser praktiske tests på standard reasoning-opgaver, at EXAONE Deep kæmper med simple opgaver og genererer for mange tokens uden at nå til en sammenhængende konklusion. DeepSeek R1 og QwQ klarede sig begge bedre på de samme problemer og fandt korrekte svar gennem klare, logiske reasoning-processer. For organisationer, der vurderer reasoning-modeller til produktion, understreger denne analyse vigtigheden af uafhængig test og verifikation. Leverandørbenchmarks bør bruges som udgangspunkt for evaluering, ikke som endegyldige mål for modelkapacitet. Markedet for reasoning-modeller vil have gavn af øget transparens, standardiserede evalueringsmetoder og fortsat uafhængig test fra forskningsmiljøet. Når teknologien modnes, vil organisationer, der investerer i grundig modelevaluering og -sammenligning, stå bedst til at vælge og implementere reasoning-modeller, der skaber reel værdi i deres specifikke anvendelser.

EXAONE Deep er en reasoning-model med 32 milliarder parametre udviklet af LG, der bruger test-tids dekodning til at løse komplekse problemer. I modsætning til standard sprogmodeller tildeler den beregningsressourcer under inferens til at tænke sig gennem problemer trin for trin, ligesom DeepSeek R1 og Alibabas QwQ-modeller.

I praktiske tests på reasoning-opgaver som isterning-problemet viste EXAONE Deep betydelige problemer med overtænkning og generering af for mange tokens uden at nå frem til logiske konklusioner. DeepSeek R1 og QwQ klarede sig begge bedre og fandt de rigtige svar mere effektivt.

Test-tids dekodning er en teknik, hvor AI-modeller bruger flere beregningsressourcer under inferens for at ræsonnere sig gennem komplekse problemer. Det gør det muligt for modellerne at vise deres tankeproces og nå mere præcise svar, selvom det kræver omhyggelig kalibrering for at undgå overtænkning.

FlowHunt automatiserer workflowet for test, sammenligning og evaluering af flere AI-modeller, så teams systematisk kan benchmarke performance, tracke metrics og træffe datadrevne beslutninger om, hvilke modeller der skal bruges til specifikke anvendelser.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Brug FlowHunt til at strømline dine AI-modeltest, sammenligninger og performance-tracking workflows med intelligent automatisering.

Udforsk tankeprocesserne hos AI-agenter i denne omfattende evaluering af GPT-4o. Opdag, hvordan den præsterer på opgaver som indholdsgenerering, problemløsning ...

Omfattende sammenligning af førende AI-billedgenereringsmodeller, herunder Qwen ImageEdit Plus, Nano Banana, GPT Image 1 og Seadream. Find ud af, hvilken model ...

Opdag hvorfor Googles Gemini 3 Flash revolutionerer AI med overlegen ydeevne, lavere omkostninger og hurtigere hastigheder—even outperforming Gemini 3 Pro på ko...