Hugging Face Transformers

Hugging Face Transformers er et førende open source Python-bibliotek, der gør det let at implementere Transformer-modeller til maskinlæringsopgaver inden for NL...

En omfattende guide til moderne pretraining-strategier for sprogsmodeller, datakurations-teknikker og optimeringsmetoder brugt af HuggingFace til at bygge effektive, højtydende open source-modeller.

Udviklingen af sprogsmodeller har gennemgået et fundamentalt skifte de seneste år. Mens store teknologivirksomheder fortsat skubber til grænserne for modelstørrelse, har open source-miljøet opdaget, at exceptionel performance ikke kræver billioner af parametre. Denne omfattende guide udforsker de nyeste teknikker og strategier brugt af HuggingFace-forskere til at bygge effektive, højtydende sprogsmodeller gennem grundig pretraining. Vi ser nærmere på, hvordan SmolLM 3, FineWeb og FinePDF repræsenterer et nyt paradigme for modeludvikling—med fokus på at maksimere ydeevne inden for praktiske beregningsgrænser og samtidig bevare videnskabelig stringens og reproducerbarhed. Indsigterne her bygger på måneders forskning og eksperimenter og giver en masterclass i, hvordan man bør tilgå pretraining af modeller i den moderne æra.

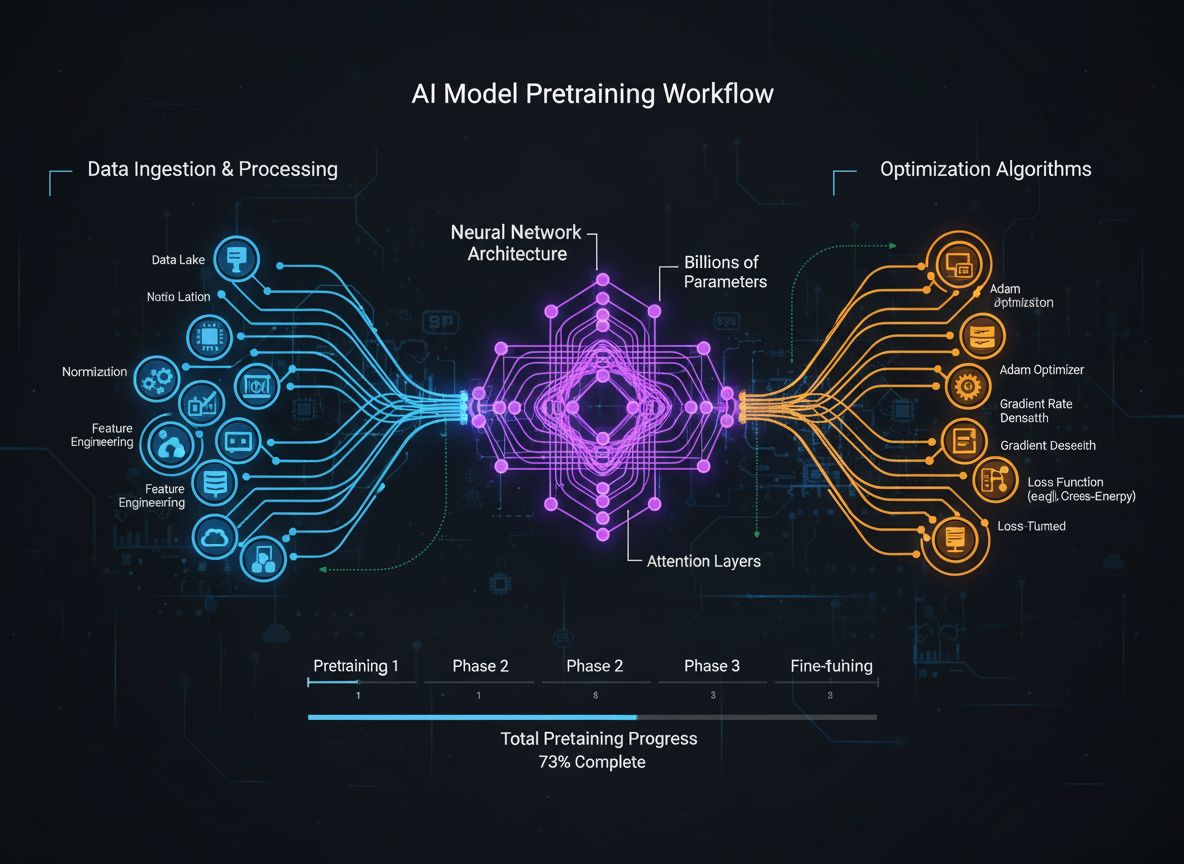

Pretraining af sprogsmodeller har udviklet sig fra en relativt simpel proces, hvor rå tekstdata fodres til neurale netværk, til en sofistikeret disciplin med flere sammenhængende optimeringsmål. Grundlæggende handler pretraining om at udsætte en model for store mængder tekstdata, så den gennem selv-superviseret læring kan lære statistiske sprogmønstre. Den moderne tilgang anerkender dog, at det ikke er nok blot at skalere data og beregningskraft. Forskere må nøje koordinere flere dimensioner af træningsprocessen—fra datavalg og kurering til arkitekturbeslutninger og optimeringsalgoritmer. Feltet er nu så modent, at forståelsen af disse nuancer adskiller topmodeller fra middelmådige. Denne udvikling afspejler en dybere indsigt i, at modellens performance ikke bestemmes af én enkelt faktor, men af koordinationen af flere, til dels uafhængige mål, der kan optimeres parallelt. Forskermiljøet har i stigende grad erkendt, at den “hemmelige ingrediens” til succesfuld modeludvikling ikke er rå skalering, men intelligente valg i alle led af træningspipelines.

En af de vigtigste læringer fra nyere forskning er, at kvaliteten og diversiteten af træningsdata fundamentalt bestemmer modellens ydeevne mere end mængden alene. Dette princip, ofte opsummeret som “garbage in, garbage out,” er i stigende grad blevet bekræftet empirisk. Modeller, der trænes på dårligt kurateret, dobbelt eller lavkvalitetsdata, lærer tilfældige mønstre og generaliserer dårligt til nye opgaver. Omvendt gør omhyggeligt udvalgte, deduplerede og filtrerede datasæt, at modeller lærer mere effektivt og opnår bedre resultater med færre træningssteps. Konsekvenserne er store: Organisationer og forskere bør investere massivt i datakurering og kvalitetssikring frem for blot at samle mere rådata. Dette skifte har ført til fremkomsten af specialiserede teams og værktøjer udelukkende til datasætskabelse og forfinelse. FineWeb-datasættet, der indeholder over 18,5 billioner tokens af renset og dedupleret engelsk webdata, eksemplificerer denne tilgang. I stedet for at bruge rå CommonCrawl-data har FineWeb-teamet implementeret avanceret filtrering, deduplikering og kvalitetsvurdering for at skabe et datasæt, der konsekvent overgår større, ubehandlede alternativer. Dette er en grundlæggende erkendelse: Vejen til bedre modeller går via bedre data, ikke nødvendigvis flere data.

Moderne pretraining af modeller kan anskues ud fra fem sammenhængende, men delvist uafhængige mål, forskere skal optimere samtidigt. Forståelse af disse søjler giver en ramme for at betragte hele træningsprocessen og identificere forbedringspotentiale. Den første søjle handler om at maksimere relevansen og kvaliteten af rådata. Det gælder både kvaliteten af enkelte datapunkter og datasættets samlede diversitet. En model trænet på høj kvalitet og varieret data vil lære mere generaliserbare mønstre end én på snævre eller lavkvalitetsdata, uanset andre optimeringer. Den anden søjle fokuserer på modellens arkitektur, der bestemmer, hvor effektivt modellen kan behandle information og hvilke beregningsmæssige begrænsninger, der gælder. Arkitekturvalg påvirker inferenshastighed, hukommelsesforbrug, KV cache-behov og modellens mulighed for at passe på specifik hardware. Den tredje søjle handler om at maksimere den information, modellen udtrækker fra data ved hvert trin. Dette inkluderer teknikker som knowledge distillation, hvor mindre modeller lærer af større, og multi-token prediction, hvor modellen forudsiger flere fremtidige tokens på én gang. Den fjerde søjle vedrører gradientkvalitet og optimeringsdynamik—valg af optimizer, læringsrate-skema og metoder til at sikre stabil træning. Den femte søjle handler om tuning af hyperparametre og skalering, så træningen forbliver stabil, når modeller vokser, og forhindrer problemer som gradienteksplosion eller aktiveringsdivergens. Søjlerne påvirker hinanden, men at tænke på dem separat hjælper forskere med at finde fokusområder og de mest effektfulde forbedringer.

FineWeb markerer et vendepunkt i datasætskabelse til pretraining af sprogsmodeller. I stedet for at acceptere outputtet fra webcrawlere som CommonCrawl har HuggingFace-teamet opbygget en omfattende pipeline til rensning, filtrering og deduplikering af webdata i stor skala. Det resulterende datasæt indeholder over 18,5 billioner tokens af høj kvalitet engelsk tekst og er et af de største kuraterede datasæt tilgængelige for open source-miljøet. Skabelsen af FineWeb involverede flere processer, der hver især fjernede lavkvalitetsindhold og bevarede værdifuld information. Teamet implementerede avancerede deduplikeringsalgoritmer, kvalitetsfiltre til at fjerne spam og dårlige sider samt sprogdetektion for at sikre, at datasættet primært er på engelsk. FineWebs værdi er ikke blot størrelsen, men den empiriske dokumentation for, at det giver bedre modelperformance end større, ubehandlede alternativer. Sammenblandet med andre datasæt overgår FineWeb konsekvent meget større rådatasæt og viser, at kvalitet virkelig slår kvantitet. Performancekurver viser, at modeller trænet på FineWeb klarer sig bedre på standardbenchmarks end modeller trænet på lignende datasæt fra andre kilder. Denne succes har inspireret forskningsmiljøet til at investere mere i datakurering—her ligger store gevinster. FineWeb er frit tilgængeligt for forskere og demokratiserer adgang til data af høj kvalitet, så mindre organisationer og akademiske teams kan træne konkurrencedygtige modeller.

Mens FineWeb fokuserede på webdata, indså HuggingFace-teamet, at en anden enorm kilde til kvalitetsdata var overset: PDF-dokumenter. PDF’er indeholder enorme mængder struktureret, kvalitetsrig information fra forskning, teknisk dokumentation, bøger og rapporter. Men udtræk af tekst fra PDF’er er teknisk udfordrende, og tidligere tilgange har ikke systematisk udforsket denne datakilde i stor skala. FinePDF er den første omfattende indsats for at udtrække, rense og kurere PDF-data til pretraining af sprogsmodeller. Teamet implementerede en avanceret pipeline til at håndtere PDF’ers unikke udfordringer såsom komplekse layouts, korrekt udtræk fra flerspaltede dokumenter og håndtering af indlejrede billeder og tabeller. En særlig nyskabelse i FinePDF-pipelinen er “refetch from internet”-trinet, der løser et vigtigt problem: PDF’er lagret i CommonCrawl er ofte dårligt udtrukket eller forældede. Ved at hente PDF’er fra de oprindelige kilder på internettet sikres adgang til de bedste versioner. Resultaterne er imponerende—blandet med andre datasæt leverer FinePDF meget stærk performance sammenlignet med nyere baselinemodeller som NeoTron B2. Datasættet giver en ny kilde til træningsdata af høj kvalitet, supplerer webdata og lader modeller lære fra mere varieret, struktureret information. Dette arbejde åbner for nye muligheder for datasætskabelse og antyder, at andre uudforskede datakilder kan give lignende gevinster. FinePDF-pipelinen dokumenteres nøje i blogindlæg og teknisk dokumentation, så andre forskere kan bygge videre og anvende teknikkerne på andre datakilder.

SmolLM 3 er kulminationen på at anvende disse datakurering- og træningsoptimeringsteknikker til at skabe en meget effektiv sprogsmodel. Med 3 milliarder parametre er SmolLM 3 betydeligt mindre end mange samtidige modeller, men opnår konkurrencedygtig ydeevne gennem omhyggelig optimering af alle fem søjler for modeltræning. Modellen understøtter dual-mode reasoning, understøtter seks sprog og har lang-kontextforståelse, hvilket gør den bemærkelsesværdigt alsidig trods sin beskedne størrelse. Udviklingen af SmolLM 3 involverede nøje arkitekturvalg med fokus på effektivitet. Teamet valgte en transformerarkitektur, der balancerer beregningsmæssig effektivitet og modelkapacitet, og implementerede teknikker som grouped query attention for at sænke hukommelsesforbruget og inferenslatensen. Modellen blev trænet gennem en tretrins pretraining-tilgang, der gradvist øger præcisionen på forskellige domæner og optimerer for specifikke evner i hvert trin. Det særlige ved SmolLM 3 er, at den viser, at open source-miljøet nu kan bygge modeller, der på mange opgaver matcher langt større proprietære modeller. Dette udfordrer antagelsen om, at større altid er bedre, og antyder, at feltet måske har nået et mætningspunkt for fordelene ved ren skalering. Fokus flytter sig nu mod effektivitet, fortolkelighed og praktisk anvendelse. SmolLM 3 kan køre på forbrugerhardware, edge-enheder og i ressourcemæssigt begrænsede miljøer, hvilket giver avanceret AI til langt flere. Modellens flersprogede og lang-kontext egenskaber viser, at effektivitet ikke kræver at gå på kompromis med vigtige funktioner.

Knowledge distillation er en kraftfuld teknik, hvor mindre modeller drager fordel af den viden, større modeller har lært. I stedet for at træne en lille model fra bunden på rådata, trænes den til at efterligne output fra en større, mere kapabel model. Dette er særligt værdifuldt under pretraining, da det lader den mindre model lære mønstre, den store allerede har fundet, hvilket accelererer læringen og forbedrer slutresultatet. Knowledge distillation foregår ved, at student-modellen (den lille) trænes til at matche sandsynlighedsfordelingerne fra teacher-modellen (den store). Typisk minimeres divergensen mellem studentens og teacherens output, ofte vha. teknikker som KL-divergens. Temperatur-parameteren styrer, hvor “bløde” sandsynlighedsfordelingerne er—højere temperatur giver mere information om de relative sandsynligheder. Knowledge distillation har vist sig særligt effektiv ved pretraining af sprogsmodeller, fordi forskere kan overføre viden fra store til mindre, effektive modeller. Det er især værdifuldt for organisationer, der vil bruge modeller på edge-enheder eller i ressourcemæssigt begrænsede miljøer, men stadig vil udnytte egenskaber fra store modeller. Teknikken er blevet mere avanceret med f.eks. attention transfer, hvor student-modellen også lærer at matche teacherens attention-mønstre, og feature-based distillation, hvor mellemlags-repræsentationer matches.

Traditionel modeltræning fokuserer på next-token prediction—modellen lærer at forudsige næste token ud fra alle foregående tokens. Nyere forskning har dog vist, at træning til at forudsige flere fremtidige tokens samtidigt markant kan forbedre performance, især på kodeopgaver og komplekse ræsonneringsproblemer. Multi-token prediction tvinger modellen til at lære længere afhængigheder og udvikle en dybere forståelse af dataens underliggende mønstre. Tilgangen tilføjer flere prediction heads til modellen, som hver især forudsiger et token flere positioner fremme. Under træning får modellen loss-signaler fra alle heads samtidigt, hvilket opfordrer til at lære repræsentationer, der er nyttige til forudsigelser flere trin frem. Det er mere udfordrende end next-token prediction, men giver bedre lærte repræsentationer. Fordelene rækker ud over blot bedre træningsperformance. Modeller trænet med multi-token prediction klarer sig ofte bedre på downstream-opgaver, generaliserer bedre og udviser forbedret ræsonnering. Teknikken er især effektiv til kodegenerering, hvor forståelse af lange afhængigheder er afgørende for syntaktisk og semantisk korrekt kode. Forskning har vist, at multi-token prediction kan forbedre performance med 5-15% på forskellige benchmarks—en af de mest effektfulde teknikker, der er fundet de senere år. Tilgangen er forholdsvis nem at implementere, men kræver omhyggelig tuning af antallet af prediction heads og vægtningen af losses fra de forskellige heads.

I årevis har AdamW været standardoptimizeren til træning af store sprogsmodeller. AdamW kombinerer momentum-baserede gradientopdateringer med vægtnedbrydning og giver stabil træning og god konvergens. Nyere forskning viser dog, at AdamW ikke altid er optimal, især når man skalerer til meget store modeller. Nye optimizere som Muon og King K2 udforsker alternative tilgange, der kan give bedre træningsdynamikker og ydeevne. Hovedideen bag disse optimeringsværktøjer er, at Hessian-matricen—der beskriver loss-landskabets krumning—kan estimeres bedre med teknikker som Newton-Schulz. Ved at vedligeholde en bedre Hessian-approksimation kan optimizerne give mere informerede gradientopdateringer, der fører til hurtigere konvergens og bedre slutresultater. Muon bruger f.eks. Newton-Schulz iteration til at ortogonalisere gradientmatricen, hvilket spreder læringen ud over flere dimensioner end traditionel momentum. Det giver mere stabil træning og får modellen til at udforske nye områder af parameter-rummet i stedet for blot at følge samme optimeringssti som AdamW. King K2 har en anden tilgang, hvor den tracker ting som maksimum log per head og bruger denne information til adaptivt at justere læringsrate og gradientklipning. Konsekvenserne af optimeringsinnovation er store. Mange fortsætter med at bruge AdamW med hyperparametre, der var optimale for langt mindre modeller, selv når de træner markant større modeller. Det tyder på, at store forbedringer kan opnås ved at opdatere optimizer-valg og hyperparametre til moderne modeller. Forskermiljøet erkender i stigende grad, at optimizer-valg ikke er løst, og at fortsat innovation her kan give markante gevinster i træningseffektivitet og slutperformance.

At opretholde høj gradientkvalitet under træningen er essentielt for god modelperformance. Når modeller skaleres til milliarder af parametre, bliver træningen mere ustabil, og gradients kan eksplodere eller forsvinde. At håndtere disse problemer kræver opmærksomhed på gradientkvaliteten og teknikker, der sikrer stabil træning hele vejen. En tilgang er gradientklipning, der forhindrer, at gradients bliver for store og destabiliserer træningen. Men naiv klipning kan også kassere værdifuld information. Mere avancerede metoder normaliserer gradients på måder, der bevarer information og forhindrer ustabilitet. Et andet vigtigt punkt er valg af aktiveringsfunktioner og lag-normalisering. Forskellige aktiveringer har forskellige egenskaber for gradient flow, og det rigtige valg kan have stor betydning for træningsstabiliteten. Layer normalization, som normaliserer aktiveringer over feature-dimensionen, er blevet standard i transformer-modeller, fordi det giver bedre gradient flow end batch normalization. Læringsrate-skemaet spiller også en nøglerolle for gradientkvaliteten. En for høj læringsrate kan få gradients til at eksplodere, mens en for lav kan give langsom konvergens eller fastlåsning i lokale minima. Moderne træning bruger ofte skemaer med warm-up, hvor læringsraten gradvist øges, efterfulgt af en nedtrapning, efterhånden som træningen skrider frem. Forståelse og optimering af disse aspekter er afgørende for succesfuld træning af store modeller, og det er et område, hvor der stadig forskes intensivt.

Den moderne pretraining-proces—med mange optimeringsmål, sofistikerede datapipelines og tuning af hyperparametre—udgør store udfordringer for teams, der vil implementere teknikkerne. FlowHunt adresserer disse udfordringer med en platform til at automatisere og orkestrere komplekse modeltrænings-workflows. I stedet for manuelt at håndtere databehandling, modeltræning og evaluering kan teams bruge FlowHunt til at definere workflows, der automatisk styrer disse opgaver, minimerer fejl og forbedrer reproducerbarhed. FlowHunts automatisering er især værdifuld for datakurering og -behandling, som er så afgørende for modellens performance. Platformen kan automatisk implementere de avancerede datapipelines, der bruges i FineWeb og FinePDF, herunder deduplikering, kvalitetsfiltrering og formatkonvertering. Det lader teams fokusere på de overordnede beslutninger om datainklusion og -behandling frem for implementeringsdetaljer. Derudover kan FlowHunt hjælpe med hyperparameter-tuning og eksperimenter, der optimerer modeltræning. Ved at automatisere kørsel af mange træningseksperimenter med forskellige hyperparametre og samle resultater, kan teams hurtigere finde optimale konfigurationer. Platformen tilbyder også værktøjer til at overvåge træningsforløb, opdage problemer som gradienteksplosion eller divergens og automatisk justere træningsparametre for at bevare stabilitet. For organisationer, der bygger egne sprogsmodeller eller finetuner eksisterende modeller, kan FlowHunt markant reducere tidsforbruget og forbedre kvaliteten af resultaterne.

En af de største udfordringer i modeltræning er at forstå, hvordan man skalerer fra små til store modeller uden at miste træningsstabilitet og performance. Forholdet mellem modelstørrelse og optimale hyperparametre er ikke ligetil—parametre, der fungerer for små modeller, skal ofte justeres for større modeller. Dette gælder især læringsrater, som typisk skal sænkes ved skalering. Forståelse af skaleringslove er afgørende for at forudsige modelperformance ved forskellige størrelser og for at træffe beslutninger om ressourceallokering. Forskning har vist, at performance følger forudsigelige skaleringslove, hvor performance forbedres som en potensfunktion af modelstørrelse, datasætstørrelse og beregningsbudget. Disse love lader forskere forudsige, hvor meget performanceforbedring, der kan forventes ved at øge model- eller datasætstørrelse, og dermed træffe bedre investeringsbeslutninger. Men skaleringslove er ikke universelle—de afhænger af arkitektur, træningsprocedure og datasæt. Teams må selv udføre skaleringsforsøg for at forstå deres eget setup. At skalere fra små til store modeller kræver også opmærksomhed på træningsstabilitet. Større modeller er mere tilbøjelige til ustabilitet som gradienteksplosion eller divergens. Løsninger inkluderer gradientklipning, omhyggelig læringsrate-planlægning og eventuelt ændringer i arkitektur eller optimizer. Forskermiljøet indser i stigende grad, at skalering ikke blot handler om at gøre modeller større, men om nøje at styre træningen, så store modeller kan trænes effektivt.

Feature learning betegner modellens evne til at udtrække nyttige træk fra rådata under træning. For sprogsmodeller handler det om at lære interne repræsentationer af sproglige koncepter, semantiske relationer og syntaktiske mønstre. Maksimering af feature learning—at sikre, at modellen udtrækker så meget nyttig information som muligt fra data ved hvert trin—er et hovedmål i moderne modeltræning. Man kan betragte feature learning som, hvor meget modellens interne repræsentationer ændrer sig som følge af gradientopdateringer. Hvis modellen lærer effektivt, vil hver opdatering give meningsfulde ændringer, der forbedrer evnen til at forudsige fremtidige tokens. Hvis ikke, kan opdateringerne være marginale eller ikke forbedre performance. Teknikker til bedre feature learning inkluderer omhyggelig initialisering af vægte, hvilket kan have stor betydning for, hvor hurtigt modellen lærer nyttige træk tidligt i træningen. En anden vigtig teknik er brug af læringsrate-skemaer, der tillader hurtig læring tidligt (hvor grundlæggende træk læres) og langsommere senere (hvor mere subtile mønstre forfines). Feature learning hænger tæt sammen med “feature collapse”, hvor modeller ignorerer visse træk eller dimensioner i inputtet. Det kan ske, hvis modellen finder genveje til god performance uden at lære alle relevante træk. Regularisering og omhyggelig design af loss-funktionen kan forhindre feature collapse og sikre, at modeller lærer forskellige og nyttige træk.

{{ cta-dark-panel heading=“Boost dit workflow med FlowHunt” description=“Oplev hvordan FlowHunt automatiserer dine AI-indholds- og SEO-workflows — fra research og indholdsgenerering til publicering og analyse — alt samlet ét sted.” ctaPrimaryText=“Book en demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Prøv FlowHunt gratis” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

I flere år har den dominerende fortælling i AI-forskning været, at større modeller er bedre modeller. Det har ført til et kapløb om at bygge stadigt større modeller med flere parametre. Men nyere udvikling indikerer et skifte. Succeserne med SmolLM 3 og andre effektive modeller viser, at exceptionel performance kan opnås med modeller, der er størrelsesmæssigt langt mindre end de største. Dette afspejler en dybere forståelse af, at modelperformance afgøres af flere faktorer end blot parameterantal. En model med 3 milliarder parametre, trænet på kvalitetsdata og med avancerede optimeringsteknikker, kan overgå en meget større model trænet på lavkvalitetsdata og mindre grundig optimering. Denne erkendelse har store implikationer for feltet. Den antyder, at det mest banebrydende forskning muligvis ikke ligger i at bygge større modeller, men i at forbedre datakvalitet, udvikle bedre træningsteknikker og skabe mere effektive arkitekturer. Det demokratiserer også AI-udvikling, så mindre organisationer og akademiske teams kan bygge konkurrencedygtige modeller uden adgang til de enorme ressourcer, milliard-parameter modeller kræver. Skiftet væk fra ren skalering har også praktiske konsekvenser: Mindre modeller kan køre på edge-enheder, i miljøer med få ressourcer og med lavere latenstid og energiforbrug. Det gør avanceret AI tilgængeligt for mange flere anvendelser og brugere. Forskermiljøet erkender i stigende grad, at fremtidens AI kan bestå af modeller i forskellige størrelser, hver optimeret til specifikke formål, i stedet for ét fokus på størst mulige modeller.

Hyperparametertuning er processen med at vælge værdier for de parametre, der styrer træningen, såsom læringsrate, batch-størrelse og vægtnedbrydning. Disse parametre har stor indflydelse på modellens ydeevne, og de optimale værdier er afgørende for gode resultater. Alligevel behandles tuning ofte som en kunst, hvor praktikere stoler på intuition og trial-and-error frem for systematiske metoder. Moderne tilgange til hyperparametertuning involverer mere systematisk udforskning af parameter-rummet. Teknikker som Bayesian optimization kan effektivt udforske mulige værdier og fokusere søgningen, hvor der er størst potentiale. Grid search og random search er enklere alternativer, der også kan være effektive, især med parallel computing. En vigtig indsigt fra nyere forskning er, at de optimale hyperparametre ofte afhænger af den konkrete model, datasæt og træningsopsætning. Det betyder, at parametre, der fungerer for én model, ikke nødvendigvis gør det for en anden—selv hvis de ligner hinanden. Derfor udføres hyperparameter-sweeps for hver ny model eller datasæt, hvilket kan være beregningstungt, men ofte er nødvendigt for optimal performance. Forståelse af sammenhængen mellem hyperparametre og performance er også vigtig til fejlfinding. Hvis træningen er ustabil eller langsom, skyldes det ofte suboptimale parametre frem for problemer med model eller data. Ved systematisk at udforske parameter-rummet kan praktikere ofte identificere og løse disse problemer.

Indsigterne fra moderne pretraining-forskning har store praktiske konsekvenser for organisationer, der bygger egne sprogsmodeller eller finetuner eksisterende. Først og fremmest bør organisationer investere massivt i datakurering og kvalitetssikring. Beviserne er klare: Højkvalitetsdata er mere værdifuldt end store mængder lavkvalitetsdata. Det indebærer avancerede datapipelines med deduplikering, kvalitetsfiltrering og standardisering af formater. Dernæst bør man nøje overveje optimeringsmålene og sikre, at man optimerer for de rigtige metrikker. Forskellige anvendelser kræver forskellige kompromiser mellem modelstørrelse, inferenshastighed og nøjagtighed. Ved at definere disse kompromiser på forhånd kan man træffe mere informerede valg om arkitektur og træningsprocedurer. Organisationer bør også holde sig opdateret om nye træningsteknikker og optimizere. Feltet udvikler sig hurtigt, og teknikker, der var banebrydende for et år siden, kan allerede være forældede. Regelmæssig gennemgang af nye forskningsartikler og eksperimenter med nye teknikker kan holde organisationen konkurrencedygtig. Dernæst bør man investere i værktøjer og infrastruktur, der gør det lettere at implementere avancerede træningsprocedurer. Det kan være platforme som FlowHunt til at automatisere data- og træningsworkflows eller specialbygget infrastruktur til effektiv eksperimentering og tuning. Endelig bør organisationer erkende, at modeludvikling ikke kun handler om træning—det kræver også grundig evaluering, debugging og iteration. Gode modeller kræver en systematisk tilgang med regelmæssig evaluering på forskellige benchmarks, analyse af fejltilfælde og løbende forbedringer baseret på læring undervejs.

Feltet for pretraining af modeller udvikler sig hurtigt, og nye teknikker og indsigter dukker løbende op. Flere tendenser peger på, hvor feltet er på vej hen. For det første vil der sandsynligvis fortsat være fokus på datakvalitet og kurering. Efterhånden som man erkender, at kvalitet er vigtigere end kvantitet, vil vi se mere avancerede datapipelines og mere forskning i, hvad der gør data “gode” til modeltræning. For det andet vil innovation i optimeringsværktøjer og træningsdynamik fortsætte. Succesen med nye optimizere som Muon og King K2 viser, at der stadig er stort forbedringspotentiale i træningsoptimering. For det tredje vil der være stigende fokus på effektivitet og praktisk anvendelse. Efterhånden som modeller bliver mere kapable, er der voksende interesse for at gøre dem mindre, hurtigere og mere energieffektive. Det inkluderer forskning i modelkomprimering, kvantisering og distillation. For det fjerde vil der komme mere forskning i forståelse og forbedring af modellernes fortolkelighed. Når modellerne bliver stærkere, bliver det vigtigere at forstå, hvordan de fungerer, og hvorfor de træffer deres valg. Endelig vil demokratiseringen af modeludvikling fortsætte, så flere værktøjer og teknikker gør det muligt for mindre organisationer og akademikere at bygge konkurrencedygtige modeller.

Den moderne tilgang til pretraining af sprogsmodeller er en markant udvikling fra tidligere, enklere metoder. I stedet for blot at skalere data og beregning kræver succesfuld modeludvikling nu nøje koordinering af flere optimeringsmål, avanceret datakurering og konstant innovation i træningsmetoder og optimizerdesign. SmolLM 3, FineWeb og FinePDF eksemplificerer dette nye paradigme og viser, at exceptionel modelperformance kan opnås gennem grundig fokus på datakvalitet, arkitektureffektivitet og træningsoptimering. Skiftet væk fra ren skalering mod effektivitet og kvalitet er et tegn på feltets modning og åbner nye muligheder for at demokratisere AI-udvikling. Organisationer, der forstår og implementerer disse principper, vil stå stærkere til at bygge konkurrencedygtige modeller—uanset om

SmolLM 3 er en model med 3 milliarder parametre, der er designet til at maksimere effektivitet og samtidig opretholde stærk performance på tværs af flere sprog og opgaver med lang kontekstforståelse. I modsætning til større modeller fokuserer SmolLM 3 på optimal ydeevne inden for beregningsmæssige begrænsninger, hvilket gør den ideel til brug på edge-enheder og i miljøer med begrænsede ressourcer.

Princippet om 'garbage in, garbage out' er grundlæggende for maskinlæring. Højkvalitets, varieret data har direkte større betydning for modellens performance end blot at have mere data. FineWeb og FinePDF viser, at grundig kurering, deduplikering og filtrering af træningsdata giver markant bedre resultater end rå og ubehandlede datasæt.

Knowledge distillation er en teknik, hvor en mindre model lærer fra en større, mere kapabel model. Under pretraining tillader denne tilgang mindre modeller at udvinde maksimal information fra træningsdata ved at lære mønstre, større modeller allerede har opdaget, hvilket resulterer i bedre resultater med færre parametre.

Multi-token prediction træner modeller til at forudsige flere fremtidige tokens samtidigt i stedet for blot det næste token. Denne tilgang er særligt effektiv til kodningsopgaver og forbedrer modellens evne til at forstå længere afhængigheder, hvilket giver bedre performance på komplekse ræsonneringsopgaver.

Moderne optimeringsværktøjer som Muon går videre end traditionel AdamW ved at bruge metoder som Newton-Schulz til bedre at approksimere Hessian-matricen. Det resulterer i mere stabil træning, bedre gradientkvalitet og forbedrede læringsdynamikker, især når modeller skaleres til et større antal parametre.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

FlowHunt hjælper teams med at strømline pretraining af modeller, databehandling og optimerings-pipelines med intelligent automatisering.

Hugging Face Transformers er et førende open source Python-bibliotek, der gør det let at implementere Transformer-modeller til maskinlæringsopgaver inden for NL...

Udforsk hvordan AI21's Jamba 3B kombinerer transformer attention med state space models for at opnå hidtil uset effektivitet og lang-kontekst-evner på edge-enhe...

Opdag hvordan MIT-forskere fremmer store sprogmodeller (LLM'er) med nye indsigter i menneskelige overbevisninger, nye værktøjer til anomali-detektion og strateg...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.