Intelligente agenter

En intelligent agent er en autonom enhed designet til at opfatte sit miljø via sensorer og handle på dette miljø ved hjælp af aktuatorer, udstyret med kunstig i...

Opdag de 12 faktorer for at bygge robuste, skalerbare AI-agenter: fra konvertering af naturligt sprog og prompt-ejerskab til menneskeligt samarbejde og stateless design. Byg produktionsklare AI-systemer, der leverer reel forretningsværdi.

Inden vi går i dybden med faktorerne, lad os afklare, hvad vi mener med “AI-agenter.” Grundlæggende er det systemer, der kan fortolke anmodninger i naturligt sprog, træffe beslutninger baseret på kontekst og udføre specifikke handlinger via værktøjer eller API’er – alt sammen mens de opretholder sammenhængende, løbende interaktioner.

De mest kraftfulde agenter kombinerer sprogmodellernes ræsonnement med deterministisk kodes pålidelighed. At ramme denne balance kræver omhyggelige designvalg, og det er netop det, disse faktorer adresserer.

Evnen til at omdanne anmodninger i naturligt sprog til strukturerede værktøjskald er kernen i agentens funktionalitet. Det er det, der gør det muligt for en agent at tage en simpel kommando som “opret et betalingslink på 750 kr. til Terri for AI Tinkerers meetup i februar” og konvertere det til et korrekt formateret API-kald.

{

"function": {

"name": "create_payment_link",

"parameters": {

"amount": 750,

"customer": "cust_128934ddasf9",

"product": "prod_8675309",

"price": "prc_09874329fds",

"quantity": 1,

"memo": "Hey Jeff - see below for the payment link for the February AI Tinkerers meetup"

}

}

}

Nøglen til at få dette til at fungere pålideligt er at bruge deterministisk kode til at håndtere det strukturerede output fra din sprogmodel. Validér altid API-payloads før udførelse for at forhindre fejl, og sørg for, at din LLM returnerer konsistente JSON-formater, der kan parses pålideligt.

Dine prompts er grænsefladen mellem din applikation og sprogmodellen – behandl dem som first-class kode. Frameworks, der abstraherer prompts, kan virke bekvemme, men de skjuler ofte, hvordan instruktioner videregives til LLM’en, hvilket gør finjustering svært eller umuligt.

I stedet bør du have direkte kontrol over dine prompts ved at skrive dem eksplicit:

function DetermineNextStep(thread: string) -> DoneForNow | ListGitTags | DeployBackend | DeployFrontend | RequestMoreInformation {

prompt #"

{{ _.role("system") }}

You are a helpful assistant that manages deployments for frontend and backend systems.

...

{{ _.role("user") }}

{{ thread }}

What should the next step be?

"#

}

Denne tilgang giver dig flere fordele:

Kontekstvinduet fungerer som LLM’ens input og omfatter prompts, samtalehistorik og eksterne data. Optimering af dette vindue forbedrer ydeevne og token-effektivitet.

Gå ud over standard meddelelsesbaserede formater og brug brugerdefinerede strukturer, der maksimerer informationsdensiteten:

<slack_message>

From: @alex

Channel: #deployments

Text: Can you deploy the backend?

</slack_message>

<list_git_tags>

intent: "list_git_tags"

</list_git_tags>

<list_git_tags_result>

tags:

- name: "v1.2.3"

commit: "abc123"

date: "2024-03-15T10:00:00Z"

</list_git_tags_result>

Denne tilgang giver flere fordele:

I sin kerne er værktøjer blot JSON-outputs fra LLM’en, der udløser deterministiske handlinger i din kode. Dette skaber en klar adskillelse mellem AI-beslutningstagning og udførselslogik.

Definér værktøjsskemaer tydeligt:

class CreateIssue {

intent: "create_issue";

issue: {

title: string;

description: string;

team_id: string;

assignee_id: string;

};

}

class SearchIssues {

intent: "search_issues";

query: string;

what_youre_looking_for: string;

}

Byg derefter pålidelig parsing af LLM JSON-outputs, brug deterministisk kode til at udføre handlingerne, og giv resultater tilbage til konteksten for iterative workflows.

Mange agent-frameworks adskiller eksekveringstilstand (fx nuværende trin i en proces) fra forretningstilstand (fx historik over værktøjskald og deres resultater). Denne adskillelse tilføjer unødvendig kompleksitet.

I stedet bør du gemme al tilstand direkte i kontekstvinduet og udlede eksekveringstilstand ud fra rækkefølgen af hændelser:

<deploy_backend>

intent: "deploy_backend"

tag: "v1.2.3"

environment: "production"

</deploy_backend>

<error>

error running deploy_backend: Failed to connect to deployment service

</error>

Denne forenede tilgang giver:

Produktionsklare agenter skal kunne integreres problemfrit med eksterne systemer, holde pause ved langvarige opgaver og genoptage, når de udløses af webhooks eller andre events.

Implementér API’er, der muliggør start, pause og genoptagelse af agenter, med robust tilstandslagring mellem operationer. Dette muliggør:

AI-agenter har ofte brug for menneskelig input til vigtige beslutninger eller uklare situationer. Ved at bruge strukturerede værktøjskald bliver denne interaktion problemfri:

class RequestHumanInput {

intent: "request_human_input";

question: string;

context: string;

options: {

urgency: "low" | "medium" | "high";

format: "free_text" | "yes_no" | "multiple_choice";

choices: string[];

};

}

Denne tilgang giver klar specificering af interaktionstype og hast, understøtter input fra flere brugere og kombineres godt med API’er til holdbare workflows.

Brugerdefineret kontrolflow giver dig mulighed for at holde pause for godkendelse fra mennesker, cache resultater eller implementere rate limiting – så agentens adfærd tilpasses dine behov:

async function handleNextStep(thread: Thread) {

while (true) {

const nextStep = await determineNextStep(threadToPrompt(thread));

if (nextStep.intent === 'request_clarification') {

await sendMessageToHuman(nextStep);

await db.saveThread(thread);

break;

} else if (nextStep.intent === 'fetch_open_issues') {

const issues = await linearClient.issues();

thread.events.push({ type: 'fetch_open_issues_result', data: issues });

continue;

}

}

}

Med denne tilgang får du:

Ved at inkludere fejl direkte i kontekstvinduet kan AI-agenter lære af fejl og tilpasse deres tilgang:

try {

const result = await handleNextStep(thread, nextStep);

thread.events.push({ type: `${nextStep.intent}_result`, data: result });

} catch (e) {

thread.events.push({ type: 'error', data: formatError(e) });

}

For at dette fungerer effektivt:

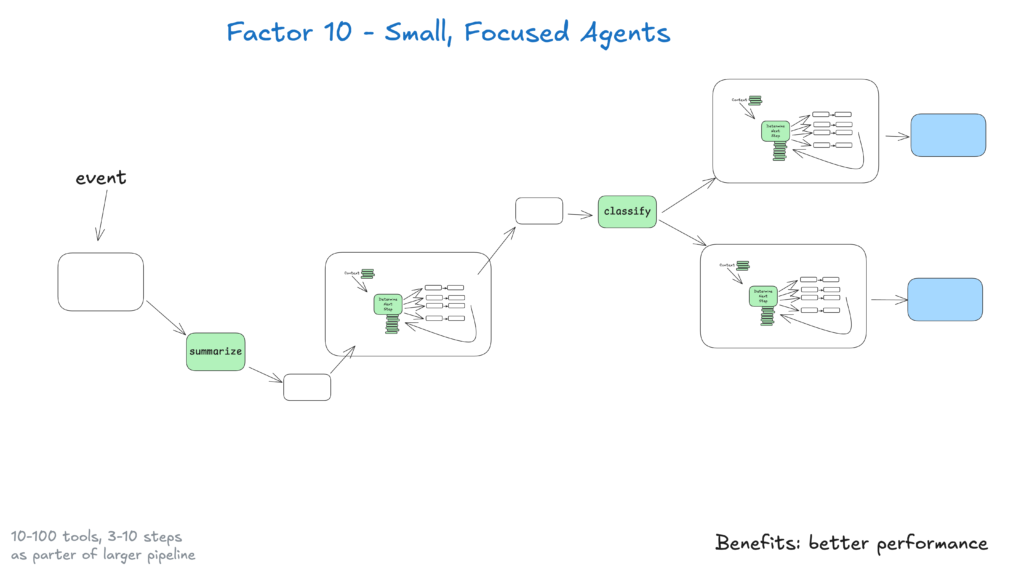

Små agenter, der håndterer 3–20 trin, holder kontekstvinduet overskueligt og forbedrer LLM-ydeevnen og pålideligheden. Denne tilgang giver:

Efterhånden som LLM’er bliver bedre, kan disse små agenter udvide deres scope og samtidig bevare kvaliteten og sikre langtidsskalérbarhed.

Gør dine agenter tilgængelige ved at tillade triggere fra Slack, e-mail eller event-systemer – mød brugerne, hvor de allerede arbejder.

Implementér API’er, der starter agenter fra forskellige kanaler og svarer via samme medie. Dette giver:

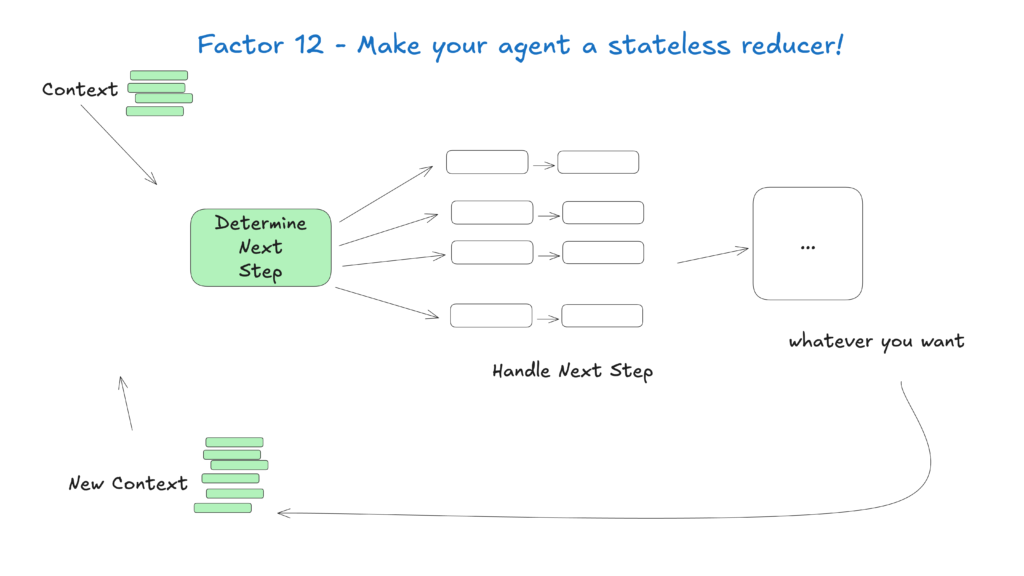

Behandl agenter som stateless funktioner, der omdanner input-kontekst til output-handlinger – det forenkler tilstandshåndtering og gør dem forudsigelige og nemme at fejlfinde.

Denne konceptuelle tilgang ser agenter som rene funktioner uden intern tilstand, hvilket giver:

Feltet for AI-agenter udvikler sig hurtigt, men disse kerneprincipper vil forblive relevante, selv når modellerne forbedres. Ved at starte med små, fokuserede agenter, der følger disse principper, kan du skabe systemer, der leverer værdi i dag og tilpasser sig fremtidens udvikling.

Husk, at de mest effektive AI-agenter kombinerer sprogmodellernes ræsonnement med deterministisk kodes pålidelighed – og disse 12 faktorer hjælper dig med at finde balancen.

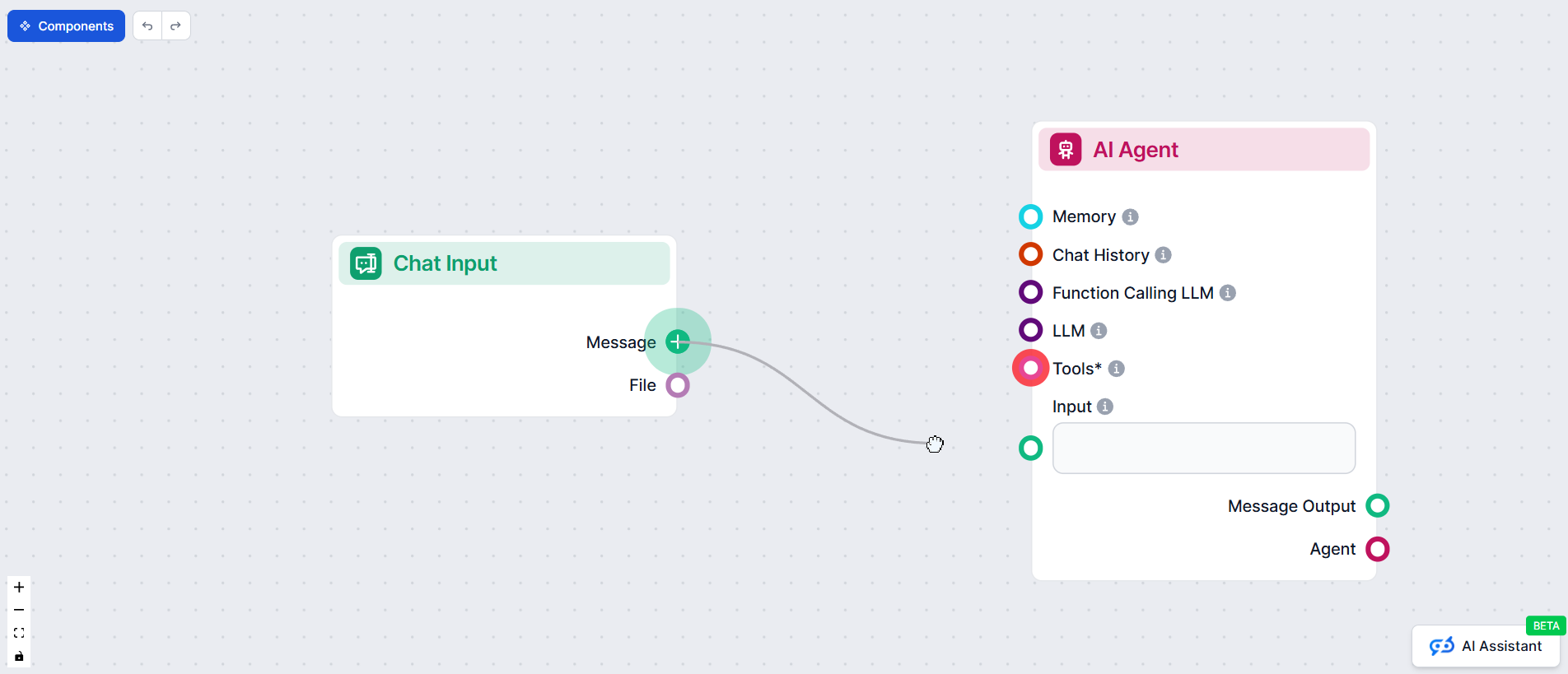

Hos FlowHunt har vi omsat disse principper til praksis ved at udvikle vores egen AI-agent, der automatisk skaber workflow-automatiseringer for vores kunder. Her er, hvordan vi brugte 12-faktor metoden til at bygge et pålideligt, produktionsklart system

12-faktor AI-agent metoden er et sæt best practices inspireret af 12-faktor app modellen, designet til at hjælpe udviklere med at bygge robuste, vedligeholdelsesvenlige og skalerbare AI-agenter, der performer pålideligt i produktionsmiljøer i den virkelige verden.

Kontekststyring sikrer, at AI-agenter bevarer relevant samtalehistorik, prompts og tilstand, optimerer ydeevnen, reducerer tokenforbrug og forbedrer beslutningsnøjagtigheden.

FlowHunt AI-agenter strukturerer værktøjskald til at anmode om menneskelig input, når det er nødvendigt, hvilket muliggør problemfrit samarbejde, godkendelser og holdbare workflows til komplekse eller vigtige scenarier.

Stateless AI-agenter er forudsigelige, nemmere at fejlfinde og lettere at skalere, fordi de omdanner input-kontekst til output-handlinger uden at opretholde skjult intern tilstand.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Klar til at skabe robuste, produktionsklare AI-agenter? Oplev FlowHunts værktøjer og se, hvordan 12-faktor metoden kan transformere din automatisering.

En intelligent agent er en autonom enhed designet til at opfatte sit miljø via sensorer og handle på dette miljø ved hjælp af aktuatorer, udstyret med kunstig i...

Lær at bygge sofistikerede AI-agenter med adgang til filsystemet, implementere kontekst-offloading-strategier og optimere tokenforbrug gennem avancerede tilstan...

Omfattende guide til de bedste platforme til opbygning af AI-agenter i 2025, med fokus på FlowHunt.io, OpenAI og Google Cloud. Få detaljerede anmeldelser, range...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.