Introduktion

Landskabet for kunstig intelligens oplever en hidtil uset acceleration, hvor banebrydende teknologier dukker op på flere områder samtidig. Fra bærbare AI-briller, der udvider menneskets sanser, til ræsonnementsmodeller, der overgår menneskets præstation i komplekse problemløsninger – denne sammensmeltning af innovationer omformer fundamentalt, hvordan vi interagerer med teknologi og automatiserer vores arbejdsgange. Denne omfattende gennemgang undersøger de mest betydningsfulde AI-udviklinger i 2025, herunder Metas avancerede Ray-Ban briller, OpenAI’s supermenneskelige ræsonnementsevner, revolutionerende 3D-verden-genereringsteknologi samt den fremvoksende infrastruktur, der gør det muligt for autonome agenter at samarbejde og handle med hinanden. At forstå disse udviklinger er afgørende for virksomheder og enkeltpersoner, der ønsker at udnytte AI’s transformerende potentiale i deres drift og strategiske planlægning.

Forstå den nuværende tilstand for AI-hardware og wearables

Udviklingen af kunstig intelligens har historisk været begrænset af de grænseflader, som mennesker bruger til at interagere med intelligente systemer. I årtier har vi benyttet tastaturer, mus og skærme til at kommunikere med computere, hvilket har skabt en grundlæggende adskillelse mellem vores naturlige sanseformer og de digitale værktøjer, vi bruger. Fremkomsten af bærbar AI udgør et paradigmeskifte i dette forhold, hvor beregning flyttes fra stationære enheder til formfaktorer, der integreres sømløst i vores dagligdag. Metas investering i Ray-Ban briller illustrerer denne overgang, bygget på årtiers forskning i augmented reality og virksomhedens omfattende erfaring med Oculus-platformen. Betydningen af dette skift kan ikke overvurderes – cirka en tredjedel af verdens befolkning bærer briller dagligt, hvilket repræsenterer et enormt potentielt marked for AI-forstærket øjenbeklædning. Ved at indlejre AI-funktioner direkte i en enhed, folk allerede bærer, placerer Meta sig i krydsfeltet mellem personlig computing og kunstig intelligens og skaber en platform, hvor AI kan observere, forstå og interagere med verden i realtid sammen med brugeren.

Klar til at vokse din virksomhed?

Start din gratis prøveperiode i dag og se resultater inden for få dage.

Hvorfor AI-drevne wearables er vigtige for fremtidens arbejde og interaktion

Konsekvenserne af AI-forstærkede wearables rækker langt ud over forbrugerbekvemmelighed og berører grundlæggende aspekter af, hvordan vi arbejder, lærer og kommunikerer. Når et AI-system kan se det, du ser, høre det, du hører og projicere information direkte ind i dit synsfelt, ændrer det fundamentalt karakteren af menneske-computer-interaktion. I stedet for at miste fokus for at tjekke en enhed strømmer information naturligt ind i dit synsfelt. I stedet for at skrive forespørgsler kan du blot tale til din AI-assistent, mens du forbliver engageret i dit fysiske miljø. For professionelle anvendelser repræsenterer dette en kæmpe produktivitetsforbedring – forestil dig en tekniker med AI-briller, der kan identificere udstyr, hente vedligeholdelsesvejledninger og guide reparationer i realtid, eller en kirurg hvis AI-assistent leverer anatomisk information og procedurevejledning under operationer. Batteriforbedringerne i den nyeste generation af Ray-Ban briller, med 42% øget kapacitet, der muliggør op til fem timers kontinuerlig brug, imødegår en af de primære barrierer for udbredelse. Efterhånden som disse enheder bliver mere praktiske og kapable, bliver de sandsynligvis lige så udbredte som smartphones og ændrer grundlæggende, hvordan vi får adgang til information og interagerer med AI-systemer i vores dagligdag.

Gennembruddet i AI-ræsonnement: Supermenneskelig præstation ved ICPC

En af de mest markante udviklinger inden for kunstig intelligens i 2025 er opnåelsen af supermenneskelig præstation i komplekse ræsonnementopgaver. International Collegiate Programming Contest (ICPC) World Finals repræsenterer højdepunkterne i konkurrenceprogrammering, hvor verdens bedste universitets-hold løser særdeles vanskelige algoritmiske problemer under tidspres. Disse opgaver kræver ikke kun kodefærdigheder, men dyb matematisk forståelse, kreativ problemløsning og evnen til at håndtere kanttilfælde og komplekse begrænsninger. OpenAI’s ræsonnementssystem opnåede en perfekt score på 12 ud af 12 problemer ved ICPC World Finals 2025, hvilket placerer det over alle menneskelige deltagere i samme konkurrence. Metoden, der blev anvendt, var særlig bemærkelsesværdig – systemet modtog opgaver i nøjagtig samme PDF-format som de menneskelige deltagere, havde samme fem timers tidsgrænse og indsendte løsninger uden specialiserede testmiljøer eller konkurrencespecifikke optimeringer. For elleve af de tolv opgaver var systemets første besvarelse korrekt, hvilket ikke bare demonstrerer problemløsningsevne, men også sikkerhedskalibrering og løsningverifikation. For den sværeste opgave var ni indsendelser nødvendige, før løsningen sad i skabet – stadig bedre end det bedste menneskelige hold, som løste elleve ud af tolv opgaver.

Den tekniske tilgang bag denne præstation involverede et ensemble af ræsonnementsmodeller, herunder GPT-5 og en eksperimentel ræsonnementsmodel, der arbejdede sammen om at generere og evaluere løsninger. Dette repræsenterer et fundamentalt skift i, hvordan AI-systemer angriber komplekse problemer – i stedet for at forsøge at løse alt i et enkelt gennemløb benytter disse systemer iterativ forfining, test-tids tilpasning og ensemblemetoder til gradvist at forbedre deres løsninger. Konsekvenserne er dybtgående: Hvis AI-systemer nu kan overgå verdens bedste menneskelige programmører i løsning af nye, komplekse algoritmiske problemer, antyder det, at mange vidensarbejdsopgaver, der tidligere krævede menneskelig ekspertise, kan automatiseres eller assisteres med AI. Præstationen er blevet valideret af brancheeksperter, herunder Scott Woo, CEO for Cognition og tidligere matematikkonkurrence-mester, som understregede den ekstraordinære sværhedsgrad. Mark Chen, Chief Research Officer hos OpenAI, satte præstationen i kontekst af AI’s bredere udvikling og bemærkede, at modellernes kerneintelligens nu er tilstrækkelig – det, der mangler, er at bygge stilladset og infrastrukturen til effektiv udrulning af disse evner.

Tilmeld dig vores nyhedsbrev

Få de seneste tips, trends og tilbud gratis.

Mens ræsonnementsevner repræsenterer én frontlinje for AI-udvikling, kræver den praktiske udrulning af AI-systemer robust infrastruktur til håndtering af information og kontekst. Retrieval Augmented Generation (RAG) har vist sig som en afgørende teknologi til at gøre det muligt for AI-systemer at få adgang til og udnytte eksterne vidensressourcer – uanset om det er virksomhedsdokumenter, forskningsartikler eller proprietære databaser. Traditionelle RAG-systemer står over for en grundlæggende udfordring: Når mængden af information, der kan hentes, vokser, stiger de beregningsmæssige omkostninger ved at søge og behandle disse data dramatisk. Metas Super Intelligence Labs har imødegået denne udfordring med ReRAG, en ny optimering, der forbedrer RAG-hastigheden med 30x og samtidig gør det muligt for systemet at arbejde med 16x længere kontekster uden at gå på kompromis med nøjagtigheden. Innovationen fungerer ved at udskifte de fleste hentede tokens med forudberegnede og genanvendelige chunk-embeddings, hvilket fundamentalt ændrer måden, information lagres og hentes på. I stedet for at behandle rå tekst hver gang en forespørgsel laves, udnytter systemet forudberegnede embeddings, der indkapsler den semantiske betydning af informationsstykker, hvilket muliggør hurtigere hentning og mere effektiv brug af modellens kontekstvindue.

Denne optimering har øjeblikkelige praktiske konsekvenser for virksomheds-AI-implementering. Virksomheder kan nu give deres AI-systemer adgang til langt større vidensbaser uden tilsvarende stigning i beregningsomkostninger eller ventetid. En kundeservice-AI kunne have adgang til millioner af sider dokumentation og stadig svare på forespørgsler på millisekunder. En forskningsassistent kunne gennemtrawle hele biblioteker af akademiske artikler og syntetisere resultater uden den beregningsmæssige byrde, der tidligere ville have gjort sådanne opgaver upraktiske. 30x hastighedsforbedringen er særligt betydningsfuld, fordi den gør RAG fra at være en specialiseret teknik i udvalgte anvendelser til et praktisk udgangspunkt for ethvert AI-system, der skal have adgang til eksterne informationer. Kombineret med forbedringer i kontekstlængde gør ReRAG det muligt for AI-systemer at opretholde sammenhængende forståelse på tværs af meget længere dokumenter og mere komplekse informationshierarkier – afgørende for anvendelser som juridisk dokumentanalyse, videnskabelig forskningssyntese og omfattende forretningsindsigt.

FlowHunt og orkestrering af AI-arbejdsgange

Sammenløbet af avancerede AI-evner – ræsonnementsmodeller, informationshentningssystemer og autonome agenter – skaber både muligheder og udfordringer for organisationer, der ønsker at udnytte disse teknologier. Den reelle værdi opstår ikke fra individuelle AI-evner isoleret, men fra deres orkestrering i sammenhængende arbejdsgange, der løser reelle forretningsproblemer. FlowHunt imødekommer dette behov ved at tilbyde en platform til at opbygge og administrere komplekse AI-automatiseringsflows, der forbinder flere værktøjer, datakilder og AI-modeller i samlede processer. Overvej et praktisk eksempel: at omdanne nyhedshistorier til formateret indhold til sociale medier. Denne tilsyneladende simple opgave kræver faktisk orkestrering af flere AI-evner og eksterne værktøjer. Arbejdsgangen begynder med at indfange en nyheds-URL og oprette poster i projektstyringssystemer, automatisk udløse parallelle behandlingsspor for forskellige sociale medieplatforme. For hver platform bruges AI til at generere platformspecifikke overskrifter, hente yderligere aktiver og information via web-scraping, generere tilpassede headerbilleder med tekstoverlays og til sidst udgive det formaterede indhold til planlægningsplatforme. Hvert trin i denne arbejdsgang involverer forskellige værktøjer og AI-modeller, der arbejder sammen, hvor outputtet fra ét trin føder ind i det næste.

Denne form for orkestrering bliver stadig mere nødvendig, efterhånden som AI-evner breder sig. I stedet for at bygge tilpassede integrationer til hver kombination af værktøjer og modeller tilbyder platforme som FlowHunt infrastrukturen til hurtig udvikling og udrulning af arbejdsgange. Platformens integration med over 8.000 værktøjer betyder, at praktisk talt enhver forretningsproces kan automatiseres ved at kombinere eksisterende værktøjer med AI-evner. Dette demokratiserer AI-automatisering og gør det muligt for organisationer uden specialiserede AI-udviklingsteams at bygge sofistikerede automatiserede arbejdsgange. Efterhånden som AI-agenter bliver mere kapable og selvstændige, bliver evnen til at orkestrere deres aktiviteter, håndtere deres interaktioner med eksterne systemer og sikre, at deres output opfylder forretningskrav, stadig mere kritisk. FlowHunts tilgang med visuelle arbejdsgangsbyggere kombineret med AI-orkestreringsfunktioner placerer det som et nøglelag i den fremvoksende AI-drevne økonomi.

Fremkomsten af infrastruktur til autonome agenter

Ud over individuelle AI-evner oplever vi i 2025 fremkomsten af infrastruktur, der specifikt er designet til at gøre det muligt for autonome agenter at interagere med hinanden og med eksterne systemer. Googles annoncering af Agent Payment Protocol (AP2) markerer en vigtig milepæl i denne udvikling. Bygget på den tidligere Agent-to-Agent-protokol, der gjorde det muligt for agenter at kommunikere, udvider AP2 denne kapacitet til også at omfatte finansielle transaktioner. Protokollen giver et fælles sprog til sikre og lovmedholdelige transaktioner mellem agenter og handlende, hvilket muliggør en ny type autonom økonomisk aktivitet. Forestil dig en AI-agent, der styrer dine forretningsoperationer og autonomt kan købe tjenester, forhandle kontrakter og håndtere leverandørforhold uden menneskelig indblanding. Eller forestil dig optimering af forsyningskæder, hvor flere AI-agenter, der repræsenterer forskellige virksomheder, kan handle med hinanden for at optimere lager, priser og leveringsplaner i realtid.

Protokollen har allerede tiltrukket store teknologiske og forretningsmæssige partnere, herunder Adobe, Accenture, OnePassword, Intuit, Red Hat, Salesforce og Okta. Denne grad af brancheopbakning antyder, at agent-til-agent-transaktioner ikke er en spekulativ fremtidsfunktion, men en spirende realitet, som virksomheder forbereder sig på at integrere i deres drift. Konsekvenserne rækker ud over simple transaktioner – AP2 muliggør dannelsen af agent-netværk, hvor autonome systemer kan samarbejde, konkurrere og koordinere for at opnå komplekse mål. En produktions-AI-agent kunne automatisk indkøbe råvarer fra leverandøragenter, koordinere med logistikagenter om levering og håndtere betalinger gennem protokollen – alt sammen uden menneskelig indblanding. Dette repræsenterer et grundlæggende skift i, hvordan forretningsprocesser organiseres, fra menneskestyrede arbejdsgange til agentkoordinerede økosystemer, hvor AI-systemer opererer med stigende autonomi inden for definerede rammer.

Avanceret AI-ræsonnement og konkurrencepræstation

Opnåelsen af supermenneskelige resultater i konkurrenceprogrammering er en del af et bredere mønster, hvor AI-systemer når eller overgår menneskeligt niveau i stadig mere komplekse domæner. ICPC-præstationen bygger på tidligere milepæle, herunder sjetteplads i International Olympiad in Informatics (IOI), en guldmedalje ved International Mathematical Olympiad (IMO) og andenplads i AtCoder Heuristic Contest. Denne fremgang viser, at AI’s ræsonnementsevner ikke er begrænset til snævre områder, men generaliserer på tværs af forskellige typer komplekse problemløsninger. Konsekvenserne for vidensarbejde er betydelige – hvis AI-systemer kan løse nye programmeringsopgaver, der kræver dyb algoritmisk forståelse, kan de sandsynligvis også assistere med eller automatisere mange andre vidensarbejdsopgaver, der involverer lignende ræsonnementsmønstre.

Det er dog vigtigt at sætte disse resultater i kontekst af AI-udviklingens bredere landskab. Som Mark Chen bemærkede, er modellernes kerneintelligens nu tilstrækkelig til mange opgaver – det, der mangler, er at bygge stilladset og infrastrukturen til effektiv implementering af disse evner. Dette stillads omfatter ikke kun teknisk infrastruktur som RAG-systemer og agentprotokoller, men også organisatoriske processer, sikkerhedsforanstaltninger og integrationsrammer, der gør det muligt at implementere AI ansvarligt og effektivt i eksisterende forretnings- og samfundsstrukturer. Den næste fase af AI-udviklingen vil sandsynligvis handle mindre om råkapabilitetsforbedringer og mere om praktisk implementering, integration og orkestrering af eksisterende evner.

Spatial intelligens og 3D-verden-generering

Mens ræsonnement og agent-infrastruktur repræsenterer én frontlinje for AI-udvikling, er spatial intelligens en anden. World Labs, grundlagt af Fei-Fei Li, er pionerer inden for udviklingen af Large World Models (LWMs), der kan generere og forstå tredimensionelle miljøer. Teknologien demonstreret af World Labs tager et enkelt billede og genererer en fuld interaktiv 3D-verden, som brugerne kan udforske og navigere i. Det er et grundlæggende fremskridt i, hvordan AI-systemer forstår og repræsenterer spatial information. I stedet for at betragte billeder som statiske 2D-data, konstruerer disse systemer sammenhængende 3D-modeller, der opretholder konsistens, når beskueren bevæger sig gennem rummet. De genererede verdener indeholder detaljerede miljøfunktioner, korrekt lys og skygger samt realistisk fysik, hvilket skaber immersive oplevelser, der føles naturlige og sammenhængende.

Anvendelsen af denne teknologi rækker langt ud over underholdning og visualisering. Inden for arkitektur og byplanlægning kunne designere generere komplette 3D-miljøer ud fra konceptskitser, så interessenter kan udforske og vurdere design, før byggeriet begynder. I undervisningen kunne elever udforske historiske steder, videnskabelige miljøer eller komplekse systemer i immersiv 3D. I træning og simulering kunne organisationer generere realistiske miljøer til træningsscenarier uden omkostningerne og kompleksiteten ved fysiske faciliteter. Teknologien har også betydning for robotteknologi og autonome systemer – kan AI generere sammenhængende 3D-modeller af omgivelser, kan den bedre forstå rumlige relationer og planlægge bevægelser gennem komplekse områder. Efterhånden som denne teknologi modnes og bliver mere tilgængelig, vil den sandsynligvis blive et standardværktøj til visualisering, design og simulering i mange brancher.

Open source AI-agenter og konkurrencemåling

Konkurrencen om AI-evner intensiveres, med flere organisationer, der udvikler avancerede ræsonnements- og agentsystemer. Alibabas Tongyi DeepResearch repræsenterer et betydeligt open source-bidrag til dette landskab og opnår state-of-the-art præstationer på flere benchmarks med kun 30 milliarder parametre, hvoraf kun 3 milliarder aktiveres under inferens. Denne effektivitet er bemærkelsesværdig – systemet opnår resultater, der matcher meget større proprietære modeller, mens det bruger en brøkdel af de beregningsmæssige ressourcer. Systemet scorer 32,9 på Humanity’s Last Exam, 45,3 på BrowseComp og 75 på XBench Deep Research-benchmarken, hvilket demonstrerer stærke resultater på tværs af forskellige ræsonnements- og forskningsopgaver.

Den open source-natur af Tongyi DeepResearch er særlig betydningsfuld, fordi den demokratiserer adgangen til avancerede AI-evner. I stedet for kun at være tilgængelig for organisationer med ressourcer til at træne massive proprietære modeller, kan forskere og udviklere nu arbejde med state-of-the-art ræsonnementssystemer. Den tekniske tilgang bag Tongyi DeepResearch involverer en ny automatiseret multi-stage data-strategi designet til at skabe store mængder agentisk træningsdata af høj kvalitet uden at skulle bruge dyr menneskelig annotering. Dette adresserer en af de grundlæggende udfordringer i AI-udvikling – behovet for store mængder træningsdata af høj kvalitet. Ved at automatisere datagenereringsprocessen demonstrerer Tongyi DeepResearch, at det er muligt at opnå state-of-the-art præstation uden de massive menneskelige annoteringsindsatser, der traditionelt har været nødvendige.

Investering i AI-infrastruktur og skalering

Den hurtige udvikling af AI-evner driver massive investeringer i AI-infrastruktur, særligt i datacenterkapacitet og specialiseret hardware. GRQ, en AI-chip-producent, har sikret 750 millioner dollars i ny finansiering og en værdisætning på 6,9 milliarder dollars efter investeringsrunden, med planer om at udvide datacenterkapaciteten, herunder nye placeringer i Asien og Stillehavsområdet. Denne investeringsrunde, ledet af Disruptive og med deltagelse af store investorer som BlackRock og Neuberger Berman, afspejler den intense konkurrence om inferenskapacitet og erkendelsen af, at AI-infrastruktur bliver en kritisk flaskehals i de kommende år. Den overvældende efterspørgsel på inferenskapacitet – de beregningsressourcer, der er nødvendige for at køre trænede AI-modeller – får virksomheder som Nvidia, GRQ og Cerebras til at udvide produktionen så hurtigt som muligt.

Denne opbygning af infrastruktur er afgørende for at realisere potentialet i avancerede AI-evner. Ræsonnementsmodeller, store sprogmodeller og autonome agenter kræver alle betydelige beregningsressourcer for at fungere. Efterhånden som disse systemer udrulles bredere, vil efterspørgslen efter inferenskapacitet kun vokse. Investeringen i infrastruktur er ikke spekulativ – den afspejler, at organisationer allerede udruller AI-systemer i stor skala og har brug for pålidelig, skalerbar infrastruktur til at understøtte disse udrulninger. Den geografiske udvidelse til Asien og Stillehavsområdet afspejler det globale aspekt af AI-implementering og erkendelsen af, at beregningsressourcer skal distribueres globalt for at give brugerne acceptabel svartid og overholde lokale krav til datalagring.

Nye trends i AI-modeludvikling

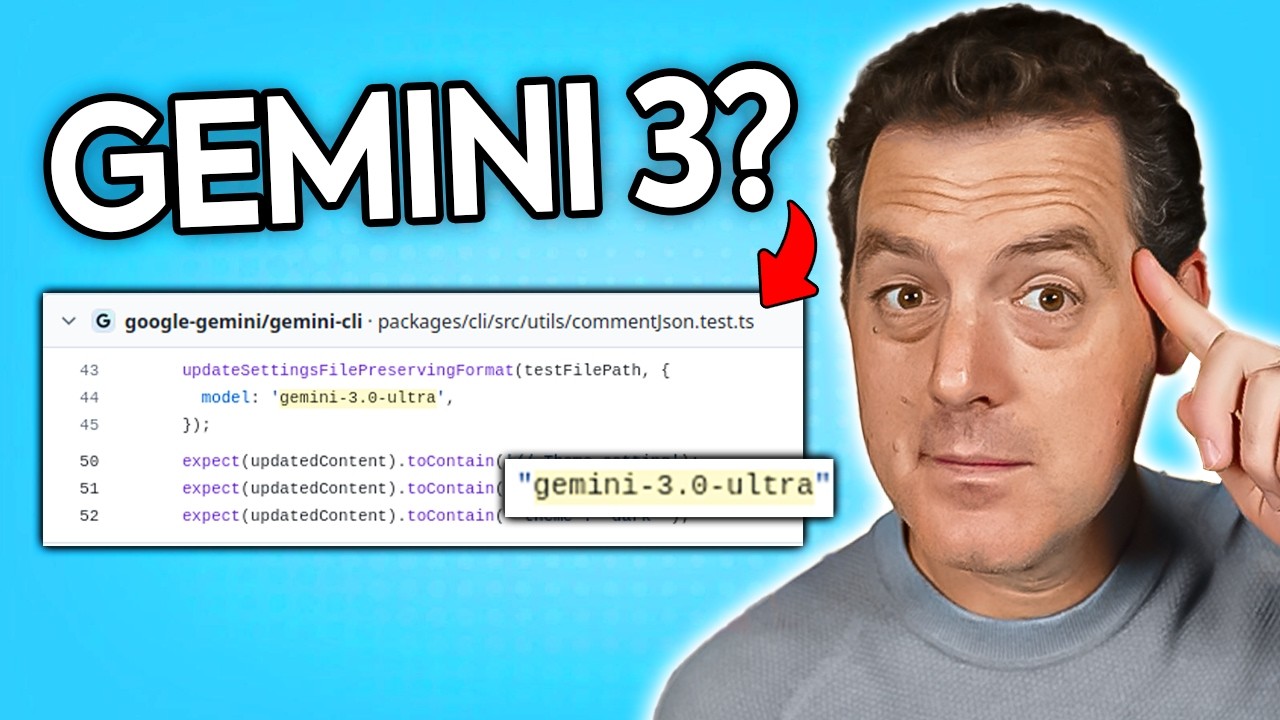

Det konkurrencemæssige landskab for AI-modeller udvikler sig hurtigt, med flere organisationer, der forfølger forskellige tilgange til at avancere AI-evner. Den rygtede udvikling af Gemini 3.0 Ultra, set i Googles Gemini CLI-repository, antyder, at Google forbereder at lancere en ny generation af deres flagskibs ræsonnementsmodel. Opdagelsen af referencer til Gemini 3.0 Ultra i kode, der blev committet få dage før nyheden kom frem, indikerer, at store modeludgivelser ofte går forud for infrastrukturændringer og forberedelsesarbejde. Mønstret for modelversionering og releases tyder på, at vi kan forvente regelmæssige opdateringer og forbedringer til større AI-systemer, hvor hver generation bringer inkrementelle eller nogle gange betydelige forbedringer i evner.

Elon Musks annoncering af, at Grok 5-træningen begynder om et par uger, viser, at xAI også udvikler sine ræsonnementsevner. Spørgsmålet om, hvad der udgør et stort versionsspring i AI-modeller – om det repræsenterer et nyt træningsforløb, betydelige arkitekturændringer eller kapabilitetstærskler – er stadig lidt uklart, men mønstret er tydeligt: Flere organisationer investerer massivt i at udvikle avancerede ræsonnementsmodeller, og vi kan forvente regelmæssige udgivelser af nye versioner med forbedrede evner. Denne konkurrencesituation er gavnlig for det bredere AI-økosystem, da konkurrence driver innovation og sikrer, at ingen enkelt organisation får monopol på avancerede AI-evner.

Autonome køretøjer og AI-implementering i den virkelige verden

Selvom meget af diskussionen omkring AI fokuserer på ræsonnementsmodeller og agentinfrastruktur, skrider implementeringen af AI-systemer hurtigt frem i områder som autonome køretøjer. Godkendelsen af Waymos pilotlicens til at drive autonome transporter ved San Francisco International Airport er en vigtig milepæl for kommercialiseringen af autonom køretøjsteknologi. Den trinvise udrulning, der begynder med lufthavnsdrift og gradvist udvides til større serviceområder, afspejler den omhyggelige tilgang, der er nødvendig for at implementere sikkerhedskritiske AI-systemer i virkelige miljøer. Konkurrencen fra andre virksomheder inden for autonome køretøjer som Zoox (ejet af Amazon) viser, at flere organisationer gør betydelige fremskridt på dette område.

Udrulningen af autonome køretøjer på store transportknudepunkter som SFO er betydningsfuld, fordi det markerer overgangen fra kontrollerede testmiljøer til reelle operationer med rigtige kunder. Lufthavnsmiljøet, selvom det stadig er relativt kontrolleret sammenlignet med bykørsel generelt, byder på reelle udfordringer som vejrsvingninger, komplekse trafikmønstre og behovet for at interagere med menneskelige chauffører og fodgængere. Succesfuld implementering i dette miljø viser, at autonom køretøjsteknologi nu er moden nok til at fungere pålideligt under virkelige forhold. Efterhånden som disse systemer opnår mere operationel erfaring og data, vil de sandsynligvis forbedres yderligere og til sidst muliggøre bredere udrulning i mere komplekse kørselsmiljøer.

Integration af AI-evner i forretningsprocesser

Sammenløbet af avancerede AI-evner, agentinfrastruktur og automatiseringsplatforme gør det muligt for organisationer at integrere AI i deres kerneforretningsprocesser på måder, der tidligere var umulige. Det praktiske eksempel med at omdanne nyhedshistorier til indhold til sociale medier, selvom det virker simpelt, illustrerer kompleksiteten i reel AI-automatisering. Arbejdsgangen kræver koordinering af flere AI-modeller (til overskriftsgenerering og billedskabelse), eksterne værktøjer (til web-scraping og publiceringsplanlægning) og forretningslogik (til platformspecifik formatering og timing). En vellykket implementering af sådanne arbejdsgange kræver ikke blot individuelle AI-evner, men også orkestreringsplatforme, der kan håndtere samspillet mellem de forskellige komponenter.

FlowHunts tilgang med visuelle arbejdsgangsbyggere kombineret med AI-orkestreringskapaciteter imødekommer dette behov. Ved at abstrahere den tekniske kompleksitet væk ved integration af forskellige værktøjer og modeller, gør disse platforme det muligt for forretningsbrugere at bygge sofistikerede automatiserede arbejdsgange uden at kræve specialiseret AI-udviklingsekspertise. Efterhånden som AI-evner bliver stærkere og mere udbredte, bliver evnen til at orkestrere disse evner til sammenhængende forretningsprocesser stadig mere værdifuld. Organisationer, der effektivt kan integrere AI i deres arbejdsgange, vil opnå betydelige konkurrencefordele gennem øget effektivitet, lavere omkostninger og hurtigere time-to-market for nye produkter og tjenester.

Fremtiden for AI-drevet automatisering

Udviklingen, der er diskuteret i denne artikel, peger mod en fremtid, hvor AI-systemer er dybt integreret i forretningsprocesser og dagligdag. I stedet for at AI er et specialiseret værktøj til bestemte opgaver, bliver det standardmetoden til at automatisere og optimere arbejdsgange. Autonome agenter koordinerer med hinanden for at styre komplekse forretningsprocesser. AI-systemer med avancerede ræsonnementsevner løser nye problemer og træffer strategiske beslutninger. Bærbar AI leverer realtidsinformation og -assistance hele dagen. Spatial intelligens muliggør nye former for visualisering og simulering. Denne fremtid er ikke spekulativ – teknologierne, der muliggør den, rulles allerede ud og forfines.

Platforme som FlowHunt får en stadig vigtigere rolle i denne sammenhæng. Efterhånden som AI-evner breder sig og bliver stærkere, bliver evnen til at orkestrere disse evner i sammenhængende arbejdsgange en kritisk konkurrencefordel. Organisationer, der kan integrere AI effektivt i deres drift, vil stå stærkere i en stadig mere AI-drevet økonomi. Infrastrukturinvesteringerne fra virksomheder som GRQ, open source-bidragene fra organisationer som Alibaba og de kommercielle platforme, der udvikles af virksomheder som FlowHunt, bidrager alle til at gøre avancerede AI-evner mere tilgængelige og praktiske for implementering i virkeligheden.

Konklusion

AI-landskabet i 2025 er præget af hurtig udvikling på tværs af flere dimensioner – fra bærbar hardware, der udvider menneskets sanser, til ræsonnementsmodeller, der overgår mennesket i komplekse problemløsninger, fra infrastruktur, der muliggør autonome agenttransaktioner, til spatial intelligence-systemer, der genererer immersive 3D-miljøer. Disse udviklinger er ikke isolerede bedrifter, men sammenhængende fremskridt, der samlet repræsenterer et fundamentalt skift i, hvordan AI implementeres og integreres i erhvervslivet og samfundet. Sammenløbet af disse evner, muliggjort af orkestreringsplatforme og understøttet af massive infrastrukturinvesteringer, skaber grundlaget for en AI-drevet fremtid, hvor autonome systemer håndterer stadig mere komplekse opgaver med minimal menneskelig indblanding. Organisationer og enkeltpersoner, der forstår disse udviklinger og positionerer sig til at udnytte disse evner, vil være bedst rustet til at trives i den fremvoksende AI-drevne økonomi.