De 18 bedste AI-platforme i 2025: Funktioner, brugsscenarier og hvordan du vælger

Opdag de 18 bedste AI-platforme i 2025, deres funktioner, brugsscenarier samt tips til at vælge den rette til din virksomheds behov. Hold dig foran i AI-landska...

KPMG’s AI-risiko- og kontrolguide giver organisationer en struktureret og etisk tilgang til håndtering af AI-risici, og støtter ansvarlig implementering samt overholdelse af globale standarder.

Denne første statistik kan stamme fra sidste år, men den kunne ikke være mere aktuel i dag. Ifølge KPMG’s 2024 U.S. CEO Outlook udpegede hele 68 % af CEO’erne AI som en topprioritet for investeringer. De satser på, at teknologien kan øge effektiviteten, opkvalificere deres arbejdsstyrke og fremme innovation i hele organisationen.

Det er et stort skulderklap til AI — men det rejser også et vigtigt spørgsmål: Når så meget er på spil, hvordan sikrer organisationer sig, at de bruger AI ansvarligt og etisk?

Det er her, KPMG’s AI-risiko- og kontrolguide kommer ind i billedet. Den tilbyder et klart, praktisk rammeværk, der hjælper virksomheder med at udnytte AI’s potentiale, samtidig med at de håndterer de reelle risici teknologien indebærer. I dagens landskab er opbygningen af tillidsvækkende AI ikke kun god praksis — det er en forretningsmæssig nødvendighed.

Kunstig intelligens (AI) revolutionerer industrier, frigør nye niveauer af effektivitet, innovation og konkurrenceevne. Men med denne transformation følger et særligt sæt risici og etiske udfordringer, som organisationer skal håndtere omhyggeligt for at bevare tillid og sikre ansvarlig anvendelse. KPMG’s AI-risiko- og kontrolguide er designet til at støtte organisationer i at navigere i denne kompleksitet og tilbyder en praktisk, struktureret og værdidrevet tilgang til AI-governance.

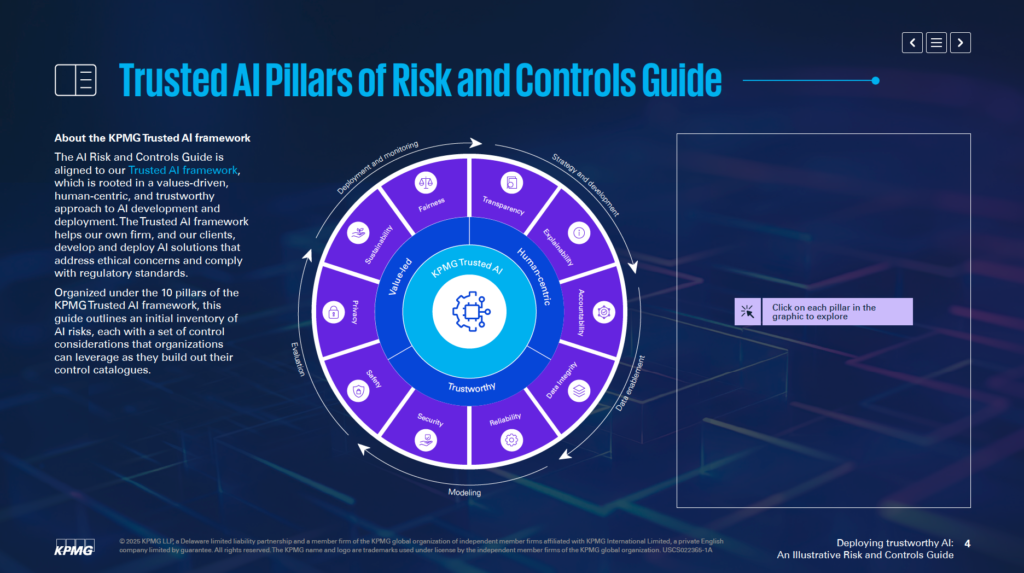

I tråd med KPMG’s Trusted AI Framework hjælper guiden virksomheder med at udvikle og implementere AI-løsninger, der er etiske, menneskecentrerede og compliant med globale regulativer. Guiden er organiseret omkring 10 grundlæggende søjler, der hver især adresserer et kritisk aspekt af AI-risikostyring:

Ved at fokusere på disse søjler kan organisationer integrere etiske principper i alle faser af AI-livscyklussen—fra strategi og udvikling til implementering og overvågning. Denne guide styrker ikke kun risikoresiliens, men fremmer også innovation, der er bæredygtig, tillidsvækkende og i tråd med samfundets forventninger.

Uanset om du er risikoprofessionel, leder, data scientist eller juridisk rådgiver, giver guiden essentielle værktøjer og indsigter til at udnytte AI’s kraft ansvarligt.

KPMG’s AI-risiko- og kontrolguide fungerer som en specialiseret ressource, der hjælper organisationer med at håndtere de særlige risici forbundet med kunstig intelligens (AI). Guiden anerkender, at AI rummer et betydeligt potentiale, men at kompleksiteten og de etiske problemstillinger kræver en fokuseret tilgang til risikostyring. Den giver et struktureret rammeværk til ansvarligt og effektivt at imødegå disse udfordringer.

Guiden er ikke tænkt som en erstatning for nuværende systemer, men er designet til at supplere eksisterende risikostyringsprocesser. Det primære mål er at integrere AI-specifikke hensyn i organisationens governance-strukturer, så der sikres en glidende tilpasning til de nuværende operationelle praksisser. Denne tilgang gør det muligt for organisationer at styrke deres risikostyring uden at skulle gentænke hele deres rammeværk.

Guiden bygger på KPMG’s Trusted AI Framework, der fremmer en værdidrevet og menneskecentreret tilgang til AI. Den integrerer principper fra bredt anerkendte standarder, herunder ISO 42001, NIST AI Risk Management Framework og EU AI Act. Det sikrer, at guiden både er praktisk og tilpasset globalt anerkendte best practices og regulatoriske krav for AI-governance.

Guiden indeholder konkrete indsigter og praktiske eksempler målrettet håndtering af AI-relaterede risici. Organisationer opfordres til at tilpasse disse eksempler til deres specifikke kontekst, herunder om AI-systemerne er udviklet internt eller leveret af eksterne parter, og hvilke datatyper og teknikker der anvendes. Denne fleksibilitet gør guiden relevant for mange brancher og AI-anvendelser.

Guiden har fokus på at gøre det muligt for organisationer at implementere AI-teknologier sikkert, etisk og transparent. Ved at adressere tekniske, operationelle og etiske aspekter af AI-risici hjælper den organisationer med at opbygge tillid hos interessenter, mens de udnytter AI’s transformative muligheder.

Guiden fungerer som en ressource, der sikrer, at AI-systemer understøtter forretningsmålene, samtidig med at potentielle risici afbødes. Den støtter innovation, hvor ansvarlighed og ansvar prioriteres.

KPMG’s AI Governance Guide er udviklet til professionelle, der håndterer AI-implementering og sikrer, at det sker sikkert, etisk og effektivt. Den gælder for teams på tværs af organisationen, herunder:

C-suite ledere og topledere som CEO, CIO og CTO vil finde guiden nyttig til at håndtere AI som en strategisk prioritet. Ifølge KPMG’s 2024 US CEO Outlook anser 68 % af CEO’erne AI som et vigtigt investeringsområde. Guiden gør det muligt for ledelsen at tilpasse AI-strategier til organisationens mål og samtidigt adressere de tilhørende risici.

Softwareudviklere, data scientists og andre med ansvar for at designe og implementere AI-løsninger kan bruge guiden til at indbygge etiske principper og stærke kontroller direkte i deres systemer. Fokus er på at tilpasse risikostyring til den specifikke arkitektur og dataflow for AI-modellerne.

Guiden er fleksibel for virksomheder, der udvikler AI-systemer internt, køber dem fra leverandører eller bruger proprietære datasæt. Den er især relevant for brancher som finans, sundhed og teknologi, hvor avancerede AI-applikationer og følsomme data er kritiske for driften.

Implementering af AI uden et klart governance-rammeværk kan føre til finansielle, regulatoriske og omdømmemæssige risici. KPMG-guiden arbejder sammen med eksisterende processer og giver en struktureret, etisk tilgang til AI-håndtering. Den fremmer ansvarlighed, transparens og etiske principper, så organisationer kan udnytte AI ansvarligt og samtidig frigøre potentialet.

Organisationer bør starte med at koble AI-specifikke risici til deres nuværende risikotaksonomi. En risikotaksonomi er et struktureret rammeværk, der bruges til at identificere, organisere og adressere potentielle sårbarheder. Da AI introducerer unikke udfordringer, skal traditionelle taksonomier udvides til at inkludere AI-specifikke forhold, f.eks. datakvalitet, algoritmelogik og datakildernes pålidelighed. På denne måde bliver AI-risici en integreret del af organisationens samlede risikostyringsarbejde og ikke behandlet isoleret.

Guiden understreger vigtigheden af at vurdere hele livscyklussen for AI-systemer. Centrale områder at undersøge er, hvor data stammer fra, hvordan det bevæger sig gennem processerne, og den grundlæggende logik i AI-modellen. Med dette brede perspektiv kan man identificere, hvor sårbarheder kan opstå under udvikling og brug af AI.

AI-systemer varierer afhængigt af formål, udviklingsmetode og datatyper. Om en model er udviklet internt eller leveret af en ekstern part, har stor betydning for de tilknyttede risici. Ligeledes kræver typen af data—proprietær, offentlig eller følsom—og de anvendte teknikker skræddersyede risikostyringsstrategier.

Guiden anbefaler at tilpasse kontrolforanstaltninger til de specifikke behov for dine AI-systemer. Hvis du for eksempel bruger proprietære data, kan det være nødvendigt med strengere adgangskontrol. Omvendt kan anvendelse af en AI-løsning fra en leverandør kræve grundige risikovurderinger af tredjepart. Ved at tilpasse kontrollerne kan du mere effektivt håndtere de konkrete udfordringer ved dine AI-systemer.

Guiden anbefaler at indarbejde risikostyring i alle faser af AI-livscyklussen. Det inkluderer at planlægge for risici i designfasen, etablere stærke monitoreringssystemer under drift og løbende opdatere risikovurderinger, efterhånden som AI-systemet udvikler sig. Ved at adressere risici i alle faser mindskes sårbarheder, og det sikres, at AI-systemerne både er etiske og pålidelige.

Det første skridt med at tilpasse AI-risici til din eksisterende risikotaksonomi og tilpasse kontroller baseret på dine behov lægger et solidt fundament for tillidsvækkende AI. Disse tiltag gør det muligt for organisationer systematisk at identificere, vurdere og håndtere risici og opbygge et stærkt rammeværk for AI-governance.

KPMG’s Trusted AI Framework bygger på ti centrale søjler, der adresserer de etiske, tekniske og operationelle udfordringer ved kunstig intelligens. Disse søjler guider organisationer i at designe, udvikle og implementere AI-systemer ansvarligt, så tillid og ansvarlighed gennemsyrer hele AI-livscyklussen.

Menneskelig overvågning og ansvar bør integreres i alle faser af AI-livscyklussen. Det betyder, at det skal defineres, hvem der har ansvar for at håndtere AI-risici, sikre overholdelse af love og regler, samt bevare muligheden for at gribe ind, tilsidesætte eller tilbagerulle AI-beslutninger ved behov.

AI-systemer bør have til formål at reducere eller eliminere bias, der kan påvirke personer, samfund eller grupper negativt. Dette indebærer nøje gennemgang af data for at sikre repræsentation af forskellige populationer, anvendelse af fairness-mekanismer under udvikling og løbende monitorering af resultater for at fremme ligebehandling.

Transparens kræver åbenhed om, hvordan AI-systemer fungerer, og hvorfor de træffer bestemte beslutninger. Det omfatter dokumentation af systembegrænsninger, performanceresultater og testmetoder. Brugere bør informeres, når deres data indsamles, AI-genereret indhold skal tydeligt mærkes, og følsomme anvendelser som biometrisk kategorisering skal give klar brugerinformation.

AI-systemer skal kunne give forståelige begrundelser for deres beslutninger. Organisationer bør derfor dokumentere datasæt, algoritmer og performancemålinger grundigt, så interessenter kan analysere og reproducere resultater effektivt.

Datakvalitet og pålidelighed gennem hele livscyklussen—indsamling, mærkning, lagring og analyse—er afgørende. Der bør etableres kontroller mod risici som datakorruption eller bias. Regelmæssig datakvalitetskontrol og regressionstests under systemopdateringer hjælper med at opretholde nøjagtighed og pålidelighed.

AI-løsninger skal overholde privatlivs- og databeskyttelseslovgivning. Organisationer skal håndtere anmodninger fra registrerede korrekt, udføre privacy impact assessments og bruge avancerede metoder som differential privacy for at balancere databrug med beskyttelse af individers privatliv.

AI-systemer skal levere konsistent performance i henhold til formål og nødvendige præcision. Det kræver grundig test, mekanismer til at opdage anomalier og løbende feedback loops til validering af output.

Tryghed handler om at beskytte AI-systemer mod at forårsage skade på personer, virksomheder eller ejendom. Det inkluderer design af fail-safe mekanismer, monitorering for problemer som datapoisening eller prompt injection-angreb og sikring af, at systemerne lever op til etiske og operationelle krav.

Stærke sikkerhedspraksisser er nødvendige for at beskytte AI-systemer mod trusler og ondsindede handlinger. Organisationer bør foretage regelmæssige audits, sårbarhedsvurderinger og bruge kryptering for at beskytte følsomme data.

AI-systemer bør designes til at minimere energiforbrug og understøtte miljømål. Bæredygtighed bør tænkes ind fra starten af designprocessen, og der skal løbende monitoreres energiforbrug, effektivitet og emissioner gennem hele AI-livscyklussen.

Ved at følge disse ti søjler kan organisationer udvikle AI-systemer, der er etiske, tillidsvækkende og i tråd med samfundets forventninger. Rammeværket giver en klar struktur for håndtering af AI-udfordringer og fremmer ansvarlig innovation.

Dataintegritet er afgørende for, at AI-systemer forbliver nøjagtige, retfærdige og pålidelige. Dårlig datastyring kan føre til risici som bias, unøjagtigheder og upålidelige resultater. Disse problemer kan underminere tilliden til AI-output og give store operationelle og omdømmemæssige udfordringer. KPMG’s Trusted AI Framework understreger vigtigheden af at opretholde høj datakvalitet gennem hele livscyklussen, så AI-systemer fungerer effektivt og lever op til etiske standarder.

Uden stærk datastyring kan AI-systemer give fejlbehæftede resultater. Problemer som ufuldstændige, unøjagtige eller irrelevante data kan føre til biased eller upålidelige output og øge risici på tværs af AI-applikationer.

Data bevæger sig ofte mellem systemer i forbindelse med træning, test eller drift. Hvis overførslerne ikke håndteres korrekt, kan data blive korrumperet, mistet eller forringet, hvilket kan påvirke AI-systemets ydelse.

For at styrke datastyringen kan organisationer:

For at minimere risici under dataoverførsler bør organisationer:

Brug af kontinuerlige monitoreringssystemer hjælper med at opretholde dataintegritet gennem hele AI-livscyklussen. Disse systemer kan opdage problemer som uventede ændringer i datasættets kvalitet eller inkonsistens i datahåndtering. Det gør det muligt hurtigt at iværksætte korrigerende handlinger.

Opretholdelse af dataintegritet er essentielt for at implementere tillidsvækkende AI-systemer. Organisationer kan reducere risici ved at etablere stærke governance-rammeværk, beskytte dataudvekslinger og opretholde løbende valideringsprocesser. Dette øger pålideligheden af AI-output og sikrer, at etiske og operationelle standarder overholdes, hvilket er med til at opbygge tillid til AI-teknologi.

Håndtering af anmodninger om adgang til personoplysninger er en væsentlig privatlivsudfordring i AI. Organisationer skal sikre, at enkeltpersoner kan udøve deres ret til at få adgang til, rette eller slette personlige oplysninger i henhold til lovgivning som GDPR og CCPA. Hvis disse anmodninger ikke behandles korrekt, kan det føre til overtrædelse af regler, tab af forbrugertillid og skade på organisationens omdømme.

For at reducere denne risiko bør virksomheder etablere programmer, der oplyser brugere om deres datarettigheder ved interaktion med AI. Systemer skal indrettes til hurtigt og transparent at behandle disse anmodninger. Organisationer bør desuden føre detaljerede registre over håndteringen af anmodninger for at dokumentere compliance ved audits.

AI-systemer håndterer ofte følsomme personoplysninger, hvilket gør dem attraktive for cyberangreb. Hvis et brud opstår, kan det føre til betydelige bøder, skade på virksomhedens omdømme og tab af kundetillid.

For at imødegå dette anbefaler KPMG’s Trusted AI Framework etiske reviews af AI-systemer, der bruger persondata, for at sikre, at de overholder privatlivslovgivning. Regelmæssige audits og privacy impact assessments (PIA’er) er nødvendige, især når følsomme data bruges til f.eks. AI-træning. Derudover kan metoder som differential privacy, der tilfører statistisk støj til data, hjælpe med at anonymisere information og samtidig muliggøre analyse.

AI-systemer, der ikke indeholder privatlivsbeskyttelse fra starten, kan skabe alvorlige problemer. Uden at anvende privacy-by-design-principper risikerer organisationer at eksponere følsomme data eller ikke at overholde lovkrav.

Virksomheder bør inkludere privatlivsforanstaltninger allerede under udviklingen af AI-systemer. Det indebærer overholdelse af privatlivs- og databeskyttelseslovgivning via stærk datastyring. Tydelig dokumentation af, hvordan data indsamles, anvendes og opbevares, er afgørende. Organisationer skal desuden indhente eksplicit samtykke fra brugere til dataindsamling og -behandling, især i følsomme områder som biometriske data.

Når AI-systemer ikke tydeligt forklarer, hvordan brugerdata håndteres, kan det føre til mistillid og juridisk granskning. Brugerne bør vide, hvornår deres data indsamles og hvordan de anvendes

KPMG's AI Risk and Controls Guide er et praktisk rammeværk designet til at hjælpe organisationer med at håndtere de unikke risici ved AI, og sikre ansvarlig, etisk og compliant AI-implementering på tværs af brancher.

Guiden bygger på ti centrale søjler: Ansvarlighed, Retfærdighed, Transparens, Forklarbarhed, Dataintegritet, Pålidelighed, Sikkerhed, Tryghed, Privatliv og Bæredygtighed—hver med fokus på afgørende aspekter af AI-risikostyring.

Guiden er tiltænkt risikoprofessionelle, compliance teams, cybersikkerhedsspecialister, juridiske rådgivere, ledere, AI-udviklere, ingeniører og organisationer i alle størrelser, der ønsker at håndtere AI ansvarligt.

Den er tilpasset globale standarder som ISO 42001, NIST AI Risk Management Framework og EU AI Act, og hjælper organisationer med at integrere AI-specifikke kontroller i eksisterende governance-processer og opfylde regulatoriske krav.

Den foreslår tiltag som stærk datastyring, privacy-by-design, løbende monitorering, transparens i AI-beslutninger, anomali-detektion, feedback loops og bæredygtighedsmål for at reducere AI-relaterede risici.

Oplev hvordan KPMG’s AI-risiko- og kontrolguide kan hjælpe din organisation med at omfavne AI-innovation, samtidig med at etisk, sikker og compliant implementering sikres.

Opdag de 18 bedste AI-platforme i 2025, deres funktioner, brugsscenarier samt tips til at vælge den rette til din virksomheds behov. Hold dig foran i AI-landska...

AI-adoptionsrater angiver procentdelen af organisationer, der har integreret kunstig intelligens i deres drift. Disse rater varierer på tværs af brancher, regio...

Udforsk resultaterne fra Anthropic AI-rapporten om, hvordan kunstig intelligens spreder sig hurtigere end elektricitet, pc'er og internettet, og hvad det betyde...