Ustrukturerede data

Find ud af, hvad ustrukturerede data er, og hvordan de adskiller sig fra strukturerede data. Lær om udfordringerne og værktøjerne, der bruges til ustrukturerede...

Lær, hvordan integration og governance af ustrukturerede data omdanner virksomhedsdata til AI-klare datasæt, som driver præcise RAG-systemer og intelligente agenter i stor skala.

Succes med moderne AI-agenter afhænger af en kritisk, men ofte overset faktor: kvaliteten og tilgængeligheden af de data, der driver dem. Mens organisationer investerer massivt i avancerede sprogmodeller og sofistikerede algoritmer, ligger den reelle flaskehals i, hvordan de håndterer virksomhedsdata. Over 90% af virksomhedsdata eksisterer i ustrukturerede formater—kontrakter, PDF’er, e-mails, transskriptioner, billeder, lyd og video—men under 1% af disse data finder faktisk vej til generative AI-projekter i dag. Det udgør både en enorm udfordring og en ekstraordinær mulighed. Forskellen på AI-systemer, der hallucinerer og giver upræcise svar, og dem, der leverer pålidelige, kontekstbevidste svar, afhænger ofte af, hvor godt organisationer kan integrere, styre og udnytte deres ustrukturerede data. I denne omfattende guide udforsker vi, hvordan integration og governance af ustrukturerede data arbejder sammen for at frigøre virksomhedens dataguldmine, så organisationer kan bygge AI-agenter og retrieval-augmented generation (RAG)-systemer, der ikke blot er intelligente, men også troværdige og compliant.

Det grundlæggende problem for virksomheder i dag er, at størstedelen af deres værdifulde data findes i formater, som traditionelle systemer aldrig var designet til at håndtere. I modsætning til strukturerede data i databaser—hvor information er organiseret i pæne rækker og kolonner—er ustrukturerede data spredt over flere systemer, inkonsistente i format og ofte indlejret med følsomme oplysninger. En kontrakt kan indeholde personhenførbare oplysninger (PII) blandet med kritiske forretningsbetingelser. En e-mailtråd kan gemme vigtige beslutninger blandt uformel samtale. Kundesupporttransskriptioner kan afsløre følelser og tilfredshedsniveauer skjult i naturligt sprog. Denne mangfoldighed og kompleksitet gør ustrukturerede data til virksomhedens både mest værdifulde og mest vanskelige aktiv at udnytte. Når data engineering-teams forsøger manuelt at behandle dette indhold, møder de uger med monotont arbejde: at gennemgå forskellige dokumenter, identificere og fjerne følsomme oplysninger og sammensætte specialskrevne scripts for at gøre data klar til AI-systemer. Denne manuelle tilgang er ikke kun tidskrævende, men også fejlbehæftet, hvilket skaber flaskehalse, der forhindrer organisationer i at skalere deres AI-initiativer. Udfordringen bliver endnu mere akut, når man tager compliance-krav i betragtning—organisationer skal sikre, at følsomme oplysninger håndteres korrekt, at dataenes oprindelse spores for revision, og at brugere og AI-agenter kun får adgang til information, de er autoriseret til at se.

De fleste organisationer antager, at fejl hos AI-agenter skyldes svage underliggende modeller eller utilstrækkelig computerkraft. I realiteten er hovedårsagen utilstrækkelig datainfrastruktur. En avanceret sprogmodel er kun så god som de informationer, den kan tilgå og ræsonnere over. Når en AI-agent mangler adgang til høj-kvalitets, velorganiserede virksomhedsdata, er den nødt til at stole på generel viden i sine træningsdata eller, endnu værre, at lave kvalificerede gæt, som ofte fører til hallucinationer. Offentlige data—information tilgængelig på internettet—er allerede indlejret i grundmodeller, så den reelle konkurrencefordel for virksomheder ligger i deres evne til at udnytte og aktivere proprietære, domænespecifikke data. Overvej en kundeservice AI-agent, der skal besvare spørgsmål om virksomhedspolitikker, produktspecifikationer eller kundehistorik. Uden adgang til velintegrerede og korrekt styrede interne dokumenter kan agenten ikke give præcise, kontekstuelle svar. Den kan generere plausible, men forkerte informationer og dermed skade kundetillid og brand. Tilsvarende har et AI-system, der skal identificere compliance-risici i kontrakter eller analysere driftsmønstre i feltrapporter, brug for adgang til rene, velorganiserede og korrekt klassificerede data. Kløften mellem at have data og at have brugbare data er der, hvor de fleste virksomheder kæmper. Det er her, integration og governance af ustrukturerede data ikke længere blot er attraktive funktioner, men essentielle elementer i enhver seriøs AI-strategi.

Vektordatabaser repræsenterer et fundamentalt skifte i, hvordan organisationer lagrer og henter information til AI-applikationer. I modsætning til traditionelle databaser, der baserer sig på præcis nøgleordssøgning, arbejder vektordatabaser med embeddings—højdimensionelle numeriske repræsentationer af tekst, billeder eller andet indhold, der indfanger semantisk betydning. Når et dokument konverteres til en embedding, bliver det til et punkt i et multidimensionelt rum, hvor lignende dokumenter samler sig. Det muliggør semantisk søgning: at finde information baseret på betydning i stedet for eksakte nøgleord. For eksempel kan en forespørgsel om “ansattegoder” hente dokumenter om “lønpakker” eller “sundhedsforsikringer”, fordi disse begreber er semantisk beslægtede, selvom de ikke deler de samme nøgleord. Vektordatabaser driver retrieval-augmented generation (RAG)-systemer, som er blevet guldstandarden for at bygge AI-agenter, der skal have adgang til virksomhedsviden. I et RAG-system, når en bruger stiller et spørgsmål, søger systemet først i vektordatabasen efter relevante dokumenter eller passager og giver så den fundne kontekst til en sprogmodel, som genererer et præcist, forankret svar. Denne to-trins-proces—hent, så generer—forbedrer nøjagtigheden dramatisk i forhold til blot at lade modellen svare ud fra sine træningsdata alene. Vektordatabasen fungerer som organisationens eksterne hukommelse, der gør det muligt for AI-agenter at tilgå og ræsonnere over aktuelle, proprietære informationer uden at genoptræne den underliggende model. Denne arkitektur har vist sig uvurderlig til at bygge domænespecifikke assistenter, kundesupportbots og interne videnssystemer, der skal følge med hurtigt skiftende information.

Integration af ustrukturerede data er processen, hvor rodet, råt, ustruktureret indhold omdannes til strukturerede, maskinlæsbare datasæt, der kan drive AI-systemer. Tænk på det som en udvidelse af de velkendte ETL-principper (Extract, Transform, Load), der længe har været rygraden i datavarehuse, til en ny modalitet: dokumenter, e-mails, chats, lyd og video. Ligesom traditionelle ETL-pipelines automatiserer indtagelse, bearbejdning og forberedelse af strukturerede data fra databaser og API’er, håndterer pipelines til ustrukturerede data kompleksiteten af forskellige indholdsformater i stor skala. Styrken ved denne tilgang ligger i automatisering og gentagelighed. Det, der tidligere krævede uger med specialskrevne scripts og manuel vedligeholdelse, kan nu klares på minutter via predefinerede connectorer og operators. Den typiske pipeline til integration af ustrukturerede data følger tre hovedfaser: indtagelse, transformation og indlæsning.

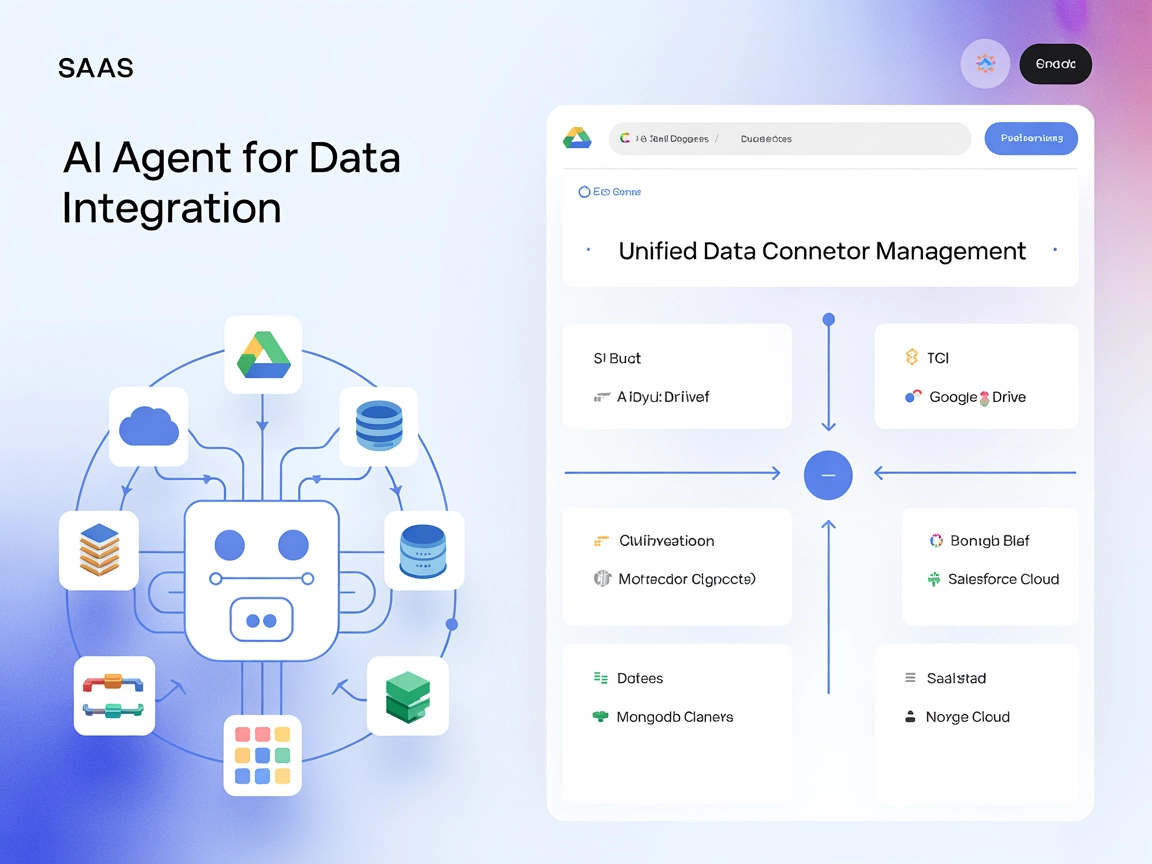

Indtagelse starter med at forbinde til de datakilder, hvor ustruktureret indhold findes. Moderne integrationsplatforme tilbyder predefinerede connectorer til virksomhedssystemer som SharePoint, Box, Slack, filsystemer, e-mailsystemer og flere. I stedet for at kræve specialkode til hver kilde håndterer disse connectorer automatisk autentificering, pagination og dataudtræk. Det betyder, at data engineers kan fokusere på forretningslogik i stedet for grundlæggende integration. Indtagsfasen løser også den indledende udfordring med at finde ud af, hvor ustrukturerede data befinder sig i virksomheden—et ikke trivielt problem i store organisationer, hvor dokumenter kan være spredt over mange systemer og arkiver.

Transformation er, hvor intelligensen kommer ind. Rå dokumenter behandles gennem en række predefinerede operators, der håndterer klassiske udfordringer med ustrukturerede data. Tekstekstraktion trækker læsbart indhold ud af PDF’er, billeder og andre formater. Deduplicering identificerer og fjerner dubletter, som kan forvride analyser eller spilde lagerplads. Sprogannotering identificerer indholdets sprog og muliggør flersproget support. Fjernelse af personhenførbare oplysninger (PII) fjerner følsomme detaljer som CPR-numre, kreditkortnumre og navne, så persondatalovgivning overholdes. Chunking opdeler store dokumenter i mindre, semantisk meningsfulde segmenter—et kritisk skridt, fordi AI-modeller har kontekstvinduer, og vektordatabaser fungerer bedst med passende størrelser. Endelig konverterer vektorisering disse segmenter til embeddings, som er de numeriske repræsentationer, vektordatabaser kræver. Alle disse transformationer sker automatisk, uden at data engineering-teamet behøver dyb maskinlæringsviden.

Indlæsning sender de behandlede embeddings til en vektordatabase, hvor de bliver tilgængelige for AI-agenter, RAG-systemer, dokumentklassificeringsmodeller, intelligente søgeapplikationer og andre AI-workloads. Resultatet er en fuldautomatisk pipeline, der kan behandle store mængder forskelligt indhold og gøre det straks tilgængeligt for AI-systemer.

En af de stærkeste funktioner ved moderne integration af ustrukturerede data er delta-processering. Når et dokument ændres, kræves det ikke, at hele pipeline’en køres forfra. Kun ændringerne (delta) opfanges og sendes videre. Det holder pipelines opdaterede i stor skala uden dyr genbehandling. For organisationer med store dokumentarkiver, der ofte ændrer sig, er denne effektivitet transformerende.

Sikkerhed og adgangskontrol er indbygget i integrationslaget. Oprindelige adgangskontrollister (ACL’er) bevarer dokumentniveau-tilladelser gennem hele pipeline’en, så brugere og AI-agenter kun ser det, de har tilladelse til. Det er kritisk for compliance i regulerede brancher og for at opretholde governance i organisationer med komplekse tilladelsesstrukturer. Når et dokument er begrænset til visse brugere i kildesystemet, følger disse restriktioner dokumentet gennem pipeline’en og ind i vektordatabasen, så tilladelser håndhæves konsekvent.

Mens integration gør data brugbare, gør governance dem troværdige. Governance af ustrukturerede data går videre end blot at levere data til AI-systemer; det sikrer, at data er findbare, velorganiserede, korrekt klassificerede og overholder organisatoriske politikker og regulatoriske krav. Som strukturerede data længe har nydt godt af governance-løsninger—datakataloger, sporing af dataoprindelse, kvalitetsmonitorering—kræver ustrukturerede data nu tilsvarende governance-infrastruktur tilpasset deres særlige karakteristika.

Et omfattende governance-system for ustrukturerede data indeholder typisk flere nøglekomponenter. Asset discovery og tilslutning starter med at identificere alle ustrukturerede aktiver i virksomheden via predefinerede connectorer til forskellige systemer. Det skaber en komplet oversigt over, hvor ustrukturerede data findes—et afgørende, men ofte svært første skridt. Entity extraction og berigelse omdanner rå filer til strukturerede, analyserbare data ved at identificere nøgleenheder som navne, datoer, emner og andre vigtige oplysninger. Berigelses-pipelines klassificerer derefter indholdet, vurderer kvaliteten og tilføjer kontekstuelle metadata. Dokumenter kan tagges med emner (fx “kontrakt”, “kundefeedback”, “produktspecifikation”), tilknyttede personer, sentimentanalyse eller andre relevante attributter. Disse metadata gør indholdet lettere at organisere, fortolke og finde.

Validering og kvalitetssikring sikrer nøjagtighed og troværdighed. Resultater vises i simple valideringstabeller med konfigurerbare regler og advarsler, der markerer metadata med lav sikkerhed. Hvis systemet er usikkert på en klassificering eller udtræk, vises usikkerheden for mennesker, så dårlige data ikke strømmer ind i AI-systemerne. Denne human-in-the-loop tilgang balancerer automatisering og nøjagtighed.

Workflow og katalogisering flytter validerede aktiver gennem workflows til et centralt katalog, som forbedrer organisering og findbarhed. Med tekniske og kontekstuelle metadata på plads kan brugere søge og filtrere intelligent på tværs af alle aktiver. En dataanalytiker, der leder efter kontrakter med en specifik leverandør, eller en compliance officer, der søger dokumenter om bestemte regulatoriske krav, kan nu hurtigt finde relevant information i stedet for manuelt at gennemgå tusindvis af filer.

Dataoprindelse og revisionsspor sporer, hvordan dokumenter bevæger sig fra kilde til mål og giver fuld indsigt i datatransformationer og -flytninger. Det er essentielt for compliance og gør det muligt at dokumentere korrekt håndtering og beskyttelse af følsomme oplysninger. I regulerede brancher kan dette revisionsspor være forskellen på at bestå eller dumpe en revision.

Sammen skaber disse governance-komponenter et fundament af tillid. Datateams kan levere pålidelige, strukturerede datasæt, der muliggør præcise AI-modeller og samtidig sikrer overholdelse af regler og interne politikker.

FlowHunt anerkender, at krydsfeltet mellem integration og governance af ustrukturerede data udgør en kritisk flaskehals for udbredelsen af enterprise AI. Ved at automatisere både de tekniske og governance-mæssige aspekter af ustruktureret datastyring muliggør FlowHunt, at organisationer kan bygge produktionsklare AI-systemer uden uger med manuel datapreparation, som traditionelt går forud for AI-projekter. FlowHunts tilgang kombinerer intelligent dataintegration med omfattende governance, så datateams kan fokusere på forretningsværdi frem for infrastruktur. Platformen tilbyder predefinerede connectorer til virksomhedssystemer, automatiske transformationsoperators og governance-workflows, der kan konfigureres uden dyb teknisk ekspertise. Denne demokratisering af håndtering af ustrukturerede data betyder, at organisationer i alle størrelser nu kan bruge deres virksomhedsdata til at drive AI-agenter og RAG-systemer. Ved at reducere tiden fra rå data til AI-klare datasæt fra uger til minutter hjælper FlowHunt organisationer med at accelerere deres AI-initiativer og gå fra prototyper til produktionsklare systemer hurtigere end nogensinde før.

Den sande styrke opstår, når integration og governance af ustrukturerede data arbejder sammen. Integration gør data brugbare; governance gør dem troværdige. Sammen lukker de det pålidelighedsgab, der historisk har plaget enterprise AI-systemer. Overvej et praktisk eksempel: En finansiel virksomhed vil bygge en AI-agent, der hjælper låneansvarlige med hurtigt at vurdere kreditrisiko ved at analysere kundedokumenter, regnskaber og historisk korrespondance. Uden korrekt integration og governance ville det kræve måneder med manuelt arbejde: at udtrække tekst fra PDF’er, identificere og fjerne følsomme oplysninger, organisere dokumenter efter kunde og dato og manuelt validere, at dataene er nøjagtige og komplette. Med integrerede pipelines til ustrukturerede data og governance bliver processen automatiseret. Dokumenter indtages fra flere kilder, transformeres for at fjerne PII, opdeles i meningsfulde segmenter og vektoriseres. Governance-laget sikrer, at dokumenter er korrekt klassificerede, at følsomme oplysninger er fjernet, og at kun autoriserede låneansvarlige kan tilgå specifikke kundeoplysninger. De resulterende embeddings indlæses i en vektordatabase, hvor AI-agenten straks kan hente relevant information. Når agenten modtager en forespørgsel om en bestemt kunde, søger den i vektordatabasen efter relevante dokumenter, henter de mest semantisk lignende passager og bruger den kontekst til at generere en præcis risikovurdering. Hele processen, der tidligere tog måneder, sker nu i realtid med fuld compliance og revisionsspor.

Denne arkitektur muliggør adskillige værdiskabende anvendelser ud over AI-agenter. Analyse- og rapporteringsteams kan analysere kundesamtaler for sentiment-tendenser uden manuelt at lytte til tusindvis af timer med lyd. Compliance-teams kan scanne kontrakter for at spore regulatoriske risici og identificere potentielle overtrædelser. Operationsteams kan analysere feltrapporter for at afsløre mønstre og ineffektivitet. Customer success-teams kan identificere udsatte kunder ved at analysere supportinteraktioner. Alle disse anvendelser bliver mulige, når ustrukturerede data er korrekt integreret og styret.

Overgangen fra manuel datapreparation til automatiserede pipelines for ustrukturerede data markerer et fundamentalt skifte i, hvordan virksomheder arbejder med AI. Historisk har AI-projekter fulgt et forudsigeligt mønster: Data scientists bygger imponerende prototyper, der fungerer godt i kontrollerede miljøer, men at skalere disse til produktion kræver massiv engineering-indsats for at håndtere kompleksitet, compliance og skala. Denne kløft mellem prototype og produktion har været en stor barriere for AI-udbredelse, hvor mange organisationer oplever, at omkostninger og kompleksitet ved at gå fra proof-of-concept til produktionsklare systemer overstiger den forventede værdi.

Automatiseret integration og governance af ustrukturerede data ændrer dette regnestykke. Ved automatisk at håndtere datainfrastrukturudfordringer gør disse platforme det muligt for organisationer at gå direkte fra prototype til produktion. Den pipeline, der driver en prototype, kan også drive et produktionssystem, blot skaleret op. Denne kontinuitet reducerer risiko, accelererer time-to-value og gør AI-projekter mere økonomisk forsvarlige. Organisationer kan nu retfærdiggøre AI-investeringer med hurtigere tilbagebetaling og lavere implementeringsomkostninger.

Konkurrencefordelen rækker ud over blot hastighed og omkostning. Organisationer, der formår at udnytte deres ustrukturerede data, får adgang til indsigter og funktioner, som konkurrenter uden ordentlig datainfrastruktur ikke kan matche. En AI-agent, der præcist kan besvare spørgsmål om virksomhedspolitikker, produkter og kundehistorik, bliver et stærkt værktøj til kundeservice, salgsstøtte og intern vidensdeling. Et compliance-system, der automatisk kan scanne kontrakter og identificere risici, bliver en styrkeforøger for juridiske og compliance-teams. Et analyseteam, der kan udtrække indsigter fra kundesamtaler, får en kilde til konkurrenceintelligens. Disse muligheder vokser over tid og skaber større kløfter mellem organisationer, der har investeret i datainfrastruktur, og dem, der ikke har.

En af de primære årsager til, at virksomheder har været tøvende med at bruge ustrukturerede data i AI-systemer, er risikoen for at afsløre følsomme oplysninger. En dårligt designet pipeline kan utilsigtet lække kundedata, afsløre forretningshemmeligheder eller bryde privatlivslovgivning. Derfor skal sikkerhed og compliance indbygges i datainfrastrukturen fra starten og ikke tilføjes som en eftertanke.

Moderne platforme til integration af ustrukturerede data imødegår disse bekymringer på flere måder. Fjernelse af PII identificerer og redigerer automatisk følsomme oplysninger som navne, CPR-numre, kreditkortnumre og andre personhenførbare data. Adgangskontrollister sikrer, at tilladelser bevares gennem hele pipeline’en, så dokumenter med begrænsninger i kildesystemet forbliver begrænsede i vektordatabasen. Sporing af dataoprindelse skaber et revisionsspor, der viser præcist, hvordan data er blevet behandlet og flyttet, hvilket gør det muligt for compliance-teams at dokumentere korrekt håndtering. Kryptering beskytter data både under overførsel og i hvile. Compliance-monitorering kan markere dokumenter eller transformationer, der kan bryde interne politikker eller lovkrav.

Disse sikkerheds- og compliancefunktioner er ikke blot gode at have; de er essentielle for virksomheder i regulerede brancher som finans, sundhed og det offentlige. De bliver også stadigt vigtigere for alle organisationer, der håndterer kundedata, da privatlivslovgivning som GDPR og CCPA stiller strenge krav til databehandling. Ved at bygge compliance ind i datainfrastrukturen kan organisationer trygt udnytte deres ustrukturerede data til AI uden frygt for lovovertrædelser eller databrud.

De praktiske anvendelser af velintegrerede og styrede ustrukturerede data er omfattende og spænder over stort set alle brancher og funktioner. Kundeservice- og supportteams kan bygge AI-agenter, der har øjeblikkelig adgang til produktdokumentation, kundehistorik og supporttickets og dermed levere hurtigere og mere præcise svar. Salgsteams kan bruge AI-agenter til hurtigt at tilgå konkurrenceintelligens, kundeinformation og tilbudsskabeloner og dermed accelerere salgsprocessen. Juridiske og compliance-teams kan bruge AI-systemer til at scanne kontrakter, identificere risici og sikre overholdelse af lovkrav. HR-teams kan analysere medarbejderfeedback, identificere tendenser og forbedre arbejdskulturen. Operationsteams kan analysere feltrapporter, finde ineffektiviteter og optimere processer. Forsknings- og udviklingsteams kan hurtigt søge i teknisk dokumentation, patenter og forskningsartikler for at identificere relevant forarbejde og undgå dobbeltarbejde.

I alle disse tilfælde kommer værdien ikke fra AI-modellen i sig selv, men fra kvaliteten og tilgængeligheden af de data, modellen kan tilgå. En avanceret sprogmodel med adgang til dårlige, ufuldstændige eller utilgængelige data vil give dårlige resultater. En enklere model med adgang til data af høj kvalitet, velorganiserede og korrekt styrede data vil levere værdifulde indsigter og funktioner.

Efterhånden som virksomheder fortsætter investeringerne i AI, vil de organisationer, der får succes, være dem, der indser, at AI-succes afhænger af datasucces. De mest avancerede modeller og algoritmer betyder intet uden adgang til data af høj kvalitet og troværdighed. Derfor er integration og governance af ustrukturerede data blevet kritiske kompetencer for enhver organisation, der tager AI alvorligt.

Vejen frem indebærer flere nøgletrin. Først skal organisationen vurdere sin nuværende situation: Hvor findes ustrukturerede data, hvilke formater er de i, og hvad er de nuværende barrierer for at udnytte dem? For det andet skal de investere i infrastruktur: Implementere platforme og værktøjer, der automatisk kan integrere og styre ustrukturerede data i stor skala. For det tredje skal de opbygge organisatoriske kompetencer: Uddanne datateams i at arbejde med disse nye værktøjer og etablere governance-praksisser, der sikrer datakvalitet og compliance. For det fjerde skal de starte med højværdianvendelser: Identificere konkrete AI-projekter, der giver klar forretningsværdi, og bruge dem som beviser for at retfærdiggøre bredere investeringer. Til sidst skal de iterere og skalere: Lære af de første projekter og gradvist udvide AI-indsatserne i takt med, at erfaring og kompetencer vokser.

Organisationer, der følger denne vej, vil opnå en betydelig konkurrencefordel. De kan bygge AI-systemer hurtigere, med lavere risiko og med større sikkerhed for nøjagtighed og compliance. De vil kunne udnytte indsigter fra deres data, som konkurrenter ikke kan få adgang til. De kan gå fra AI-prototyper til produktionsklare systemer på måneder i stedet for år. Og de kan gøre alt dette, mens de opretholder de sikkerheds-, compliance- og governance-standarder, som moderne virksomheder kræver.

Oplev, hvordan FlowHunt automatiserer din integration og governance af ustrukturerede data — fra indtagelse og transformation til indlæsning og compliance — så du kan bygge produktionsklare AI-agenter og RAG-systemer på minutter i stedet for uger.

Revolutionen inden for enterprise AI vil ikke blive vundet af organisationer med de mest avancerede modeller, men af dem med den bedste datainfrastruktur. Over 90% af virksomhedsdata eksisterer i ustrukturerede formater, men under 1% af disse data driver aktuelt AI-systemer. Det udgør både en enorm udfordring og en ekstraordinær mulighed. Ved at implementere automatiseret integration og governance af ustrukturerede data kan organisationer låse denne skjulte guldmine op og muliggøre AI-agenter og RAG-systemer, der ikke blot er intelligente, men også nøjagtige, troværdige og compliant. De organisationer, der hurtigt bygger denne datainfrastruktur, vil opnå markante konkurrencefordele, gå fra AI-prototyper til produktionsklare systemer hurtigere end konkurrenterne, få adgang til indsigter, andre ikke kan, og opbygge kompetencer, der vokser over tid. Fremtiden tilhører de virksomheder, der forstår, at succes med AI afhænger af succes med data og investerer derefter i den infrastruktur, de værktøjer og de praksisser, der skal til for at få deres ustrukturerede data til at arbejde for dem.

Ustrukturerede data omfatter dokumenter, e-mails, PDF'er, billeder, lyd og video—indhold, der ikke passer pænt ind i databaserækker. Over 90% af virksomhedsdata er ustrukturerede, men under 1% bruges i AI-projekter i dag. Det repræsenterer en enorm uudnyttet mulighed for organisationer til at opnå konkurrencefordele gennem AI-agenter og intelligente systemer.

RAG kombinerer søgning og generering ved først at søge i en vektordatabase efter relevant information baseret på semantisk lighed og derefter give denne kontekst til en AI-model for at generere præcise svar. Vektordatabaser gemmer embeddings—numeriske repræsentationer af tekst—som muliggør hurtige, intelligente søgninger, der forstår betydning frem for blot nøgleord.

Integration omdanner rå, rodede ustrukturerede data til maskinlæsbare datasæt gennem ETL-lignende pipelines, så data bliver brugbare for AI. Governance sikrer, at data er findbare, organiserede, troværdige og overholder regler ved at udtrække metadata, klassificere indhold og spore dataenes oprindelse. Sammen skaber de pålidelige, produktionsklare datapipelines.

Nøglen er at bygge intelligente datapipelines, der kombinerer integration og governance. Integration gør data brugbare; governance gør dem troværdige. Ved at automatisere omdannelsen af ustrukturerede data til datasæt af høj kvalitet kan virksomheder skalere AI-projekter fra proof-of-concept til pålidelige, compliant produktionssystemer.

Arshia er AI Workflow Engineer hos FlowHunt. Med en baggrund inden for datalogi og en passion for AI, specialiserer han sig i at skabe effektive workflows, der integrerer AI-værktøjer i daglige opgaver og øger produktivitet og kreativitet.

Opdag, hvordan FlowHunt automatiserer integration og governance af ustrukturerede data for at give præcise AI-agenter og RAG-systemer.

Find ud af, hvad ustrukturerede data er, og hvordan de adskiller sig fra strukturerede data. Lær om udfordringerne og værktøjerne, der bruges til ustrukturerede...

Integrér FlowHunt med Unstructured API MCP Server for at samle connectorhåndtering, automatisere workflows og give AI-agenter mulighed for at orkestrere dataope...

Indholdsberigelse med AI forbedrer råt, ustruktureret indhold ved at anvende kunstig intelligens til at udtrække meningsfuld information, struktur og indsigt—så...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.