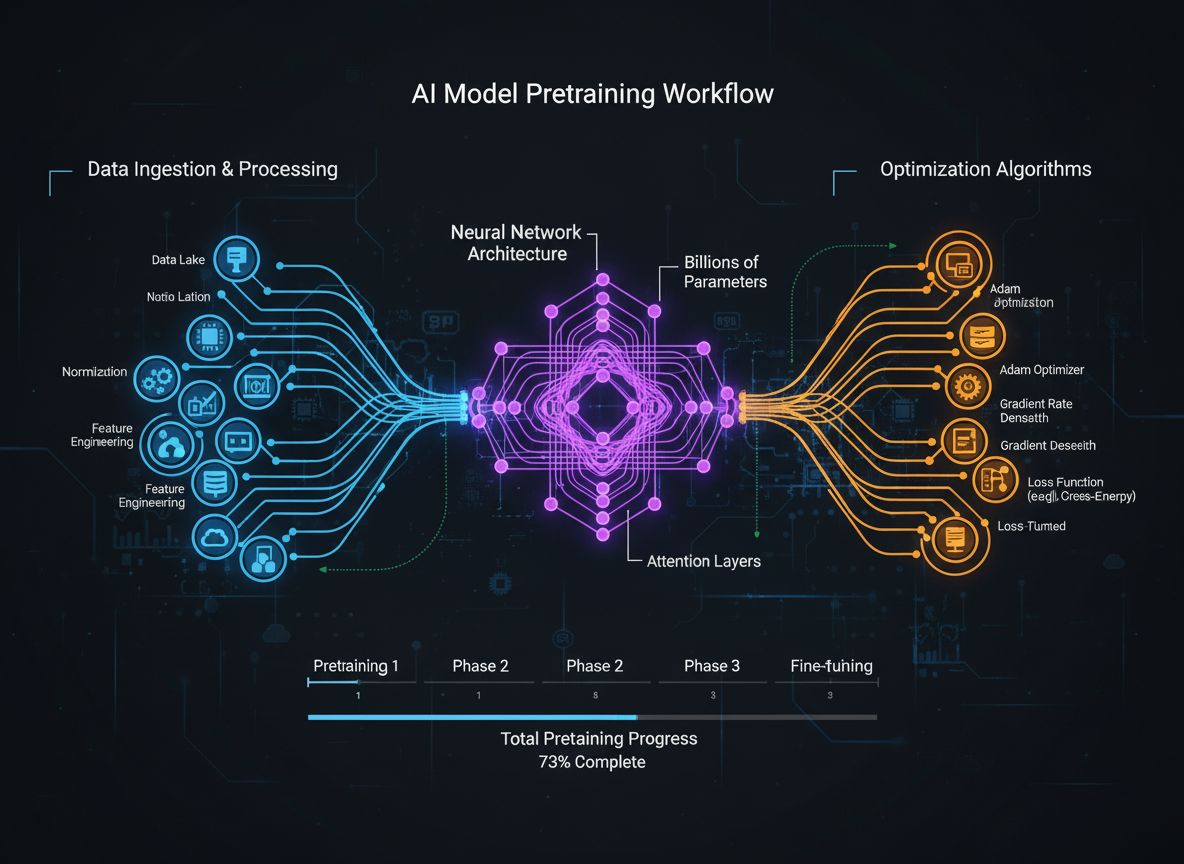

Open Model Pretraining Masterclass: Effiziente Sprachmodelle mit SmolLM 3, FineWeb und FinePDF entwickeln

Ein umfassender Leitfaden zu modernen Pretraining-Strategien für Sprachmodelle, Methoden zur Datenkuratierung und Optimierungsverfahren, die von HuggingFace zur...