KI-Zusammenfasser aus Eingabetext

Dieses Tool ist perfekt für Fachleute, Studierende und alle, die mit umfangreichen Informationen zu tun haben. Es hilft Ihnen, lange Texte in kurze Zusammenfass...

Textzusammenfassung in der KI verdichtet Dokumente unter Beibehaltung der wichtigsten Informationen, indem LLMs wie GPT-4 und BERT zur effizienten Verwaltung und zum Verständnis großer Datensätze eingesetzt werden.

Die Textzusammenfassung ist ein grundlegender Prozess im Bereich der künstlichen Intelligenz, der darauf abzielt, umfangreiche Dokumente in prägnante Zusammenfassungen zu verdichten und dabei entscheidende Informationen und Bedeutungen zu bewahren. Angesichts der explosionsartig ansteigenden digitalen Inhalte ermöglicht diese Fähigkeit es Einzelpersonen und Organisationen, große Datensätze effizient zu verwalten und zu verstehen, ohne sich durch lange Texte arbeiten zu müssen. Große Sprachmodelle (LLMs) wie GPT-4 und BERT haben dieses Feld durch den Einsatz fortschrittlicher Methoden der natürlichen Sprachverarbeitung (NLP) erheblich vorangebracht und erzeugen kohärente und präzise Zusammenfassungen.

Abstrakte Zusammenfassung:

Es werden neue Sätze generiert, die die Kernaussagen des Ausgangstextes zusammenfassen. Im Gegensatz zur extraktiven Zusammenfassung, die bestehende Textfragmente auswählt, interpretiert und formuliert die abstrakte Zusammenfassung die Inhalte neu und erzeugt Zusammenfassungen, die menschlichem Schreiben ähneln. So können z. B. Forschungsergebnisse zu neuen, prägnanten Aussagen verdichtet werden.

Extraktive Zusammenfassung:

Wichtige Sätze oder Phrasen werden aus dem Originaltext anhand von Metriken wie Häufigkeit oder Relevanz ausgewählt und kombiniert. Die ursprüngliche Struktur bleibt erhalten, allerdings fehlt es oft an Kreativität und Sprachfluss, wie sie menschliche Zusammenfassungen aufweisen. Diese Methode gewährleistet eine zuverlässige Wahrung der Fakten.

Hybride Zusammenfassung:

Vereint die Stärken der extraktiven und abstrakten Methoden, indem detaillierte Informationen bewahrt und Inhalte für Klarheit und Verständlichkeit neu formuliert werden.

LLM-Textzusammenfassung:

LLMs automatisieren die Zusammenfassung, bieten ein menschenähnliches Textverständnis und Textgenerierungsfähigkeiten und erstellen präzise sowie gut lesbare Zusammenfassungen.

Map-Reduce-Technik:

Der Text wird in handhabbare Abschnitte unterteilt, jeder Abschnitt einzeln zusammengefasst und schließlich zu einer Gesamtsynthese integriert. Besonders effektiv bei großen Dokumenten, die den Kontextbereich eines Modells überschreiten.

Refine-Technik:

Ein iterativer Ansatz, der mit einer ersten Zusammenfassung startet und diese durch weitere Daten aus nachfolgenden Abschnitten sukzessive verfeinert, um den Kontext beizubehalten.

Stuff-Technik:

Der gesamte Text wird zusammen mit einer Aufforderung eingegeben, um direkt eine Zusammenfassung zu erzeugen. Dies ist zwar unkompliziert, aber durch das Kontextfenster des LLM begrenzt und daher besser für kürzere Texte geeignet.

Wichtige Kriterien bei der Bewertung von Zusammenfassungen:

Komplexität natürlicher Sprache:

LLMs müssen Redewendungen, kulturelle Referenzen und Ironie verstehen, was zu Fehlinterpretationen führen kann.

Qualität und Genauigkeit:

Es ist essenziell, dass Zusammenfassungen den Originalinhalt korrekt widerspiegeln, insbesondere in Bereichen wie Recht oder Medizin.

Vielfalt der Quellen:

Unterschiedliche Textarten (z. B. technisch oder erzählerisch) erfordern oft angepasste Zusammenfassungsstrategien.

Skalierbarkeit:

Effiziente Verarbeitung großer Datensätze ohne Leistungseinbußen.

Datenschutz:

Einhaltung gesetzlicher Datenschutzbestimmungen bei der Verarbeitung sensibler Informationen.

Nachrichtenaggregation:

Automatische Verdichtung von Nachrichtenartikeln für eine schnelle Übersicht.

Juristische Dokumentenzusammenfassung:

Erleichtert die Durchsicht von juristischen Dokumenten und Fallakten.

Gesundheitswesen:

Fasst Patientenakten und medizinische Forschungsergebnisse zur Unterstützung von Diagnose und Therapieplanung zusammen.

Business Intelligence:

Analysiert große Mengen an Marktberichten und Finanzdaten für strategische Entscheidungen.

Die Textzusammenfassung mit großen Sprachmodellen (LLMs) ist ein sich rasch entwickelndes Forschungsfeld, das durch die riesigen Mengen digitaler Texte vorangetrieben wird. Die Forschung untersucht, wie LLMs sowohl extraktiv als auch abstrakt prägnante und kohärente Zusammenfassungen aus großen Textmengen erstellen können.

Textzusammenfassung in der KI bezeichnet den Prozess, umfangreiche Dokumente in kürzere Zusammenfassungen zu verdichten, wobei wesentliche Informationen und Bedeutungen erhalten bleiben. Dabei kommen Techniken wie abstrakte, extraktive und hybride Zusammenfassung mit großen Sprachmodellen (LLMs) wie GPT-4 und BERT zum Einsatz.

Die wichtigsten Techniken sind abstrakte Zusammenfassung (Erzeugung neuer Sätze, um Kernideen zu vermitteln), extraktive Zusammenfassung (Auswahl und Kombination wichtiger Sätze aus dem Originaltext) und hybride Methoden, die beide Ansätze vereinen.

Anwendungsbereiche sind zum Beispiel Nachrichtenaggregation, Prüfung juristischer Dokumente, Zusammenfassung von Krankenakten und Business Intelligence. So können Personen und Organisationen große Datensätze effizient verarbeiten und verstehen.

Zu den Herausforderungen zählen der Umgang mit der Komplexität natürlicher Sprache, die Sicherstellung von Genauigkeit und Konsistenz der Zusammenfassungen, die Anpassung an verschiedene Quelltypen, die Skalierbarkeit großer Datensätze und die Einhaltung von Datenschutzbestimmungen.

Beginne mit dem Aufbau eigener KI-Lösungen mit den fortschrittlichen Textzusammenfassungstools von FlowHunt. Verdichte und verstehe mühelos große Inhaltsmengen.

Dieses Tool ist perfekt für Fachleute, Studierende und alle, die mit umfangreichen Informationen zu tun haben. Es hilft Ihnen, lange Texte in kurze Zusammenfass...

Textgenerierung mit großen Sprachmodellen (LLMs) bezieht sich auf den fortschrittlichen Einsatz von Machine-Learning-Modellen zur Erstellung menschenähnlicher T...

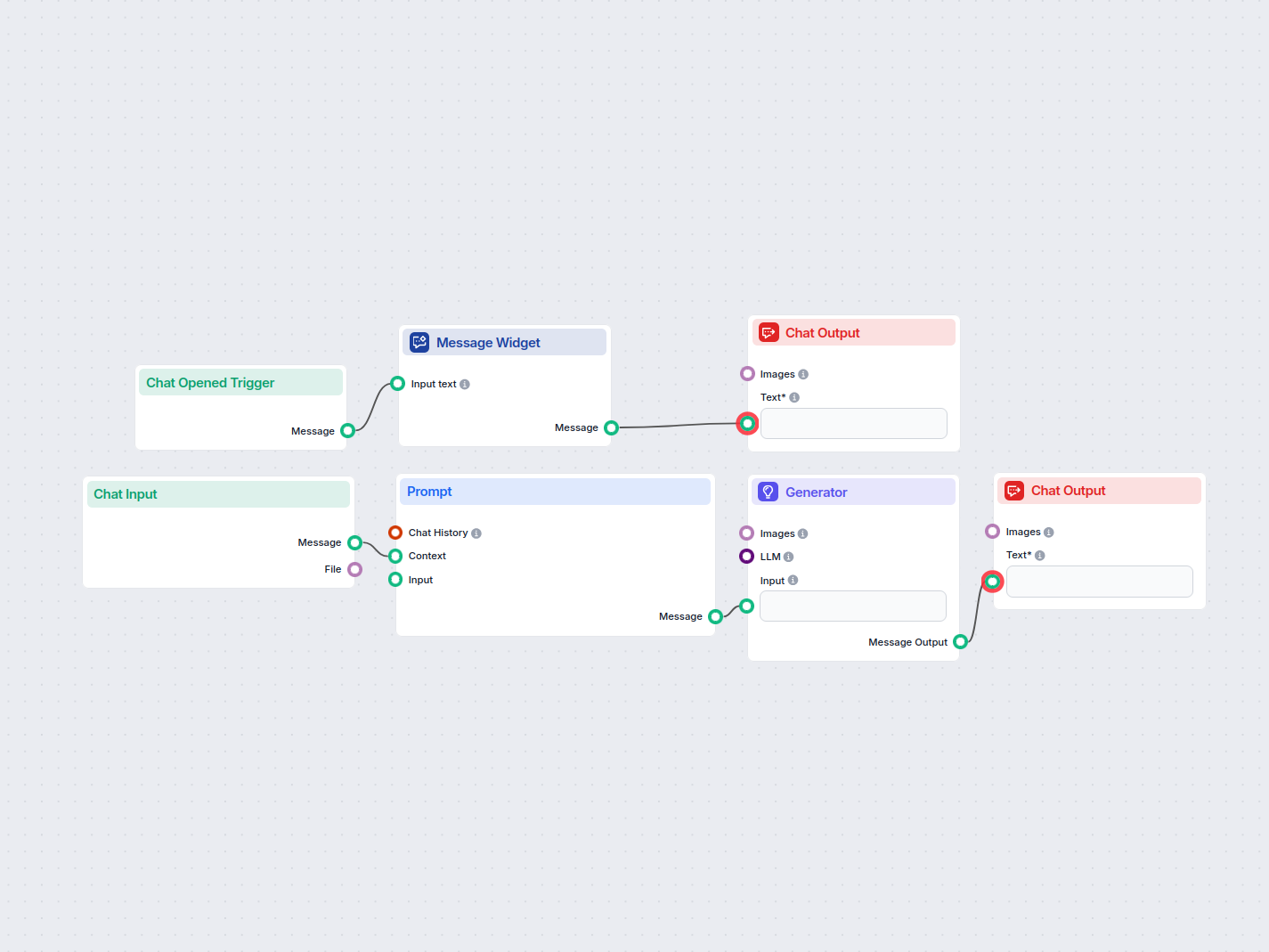

Fassen Sie beliebigen eingegebenen Text mithilfe von KI ganz einfach in prägnante Kernpunkte zusammen. Dieser Workflow nimmt Benutzereingaben entgegen, erstellt...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.