ChatGPT-5: Alles, was Sie über OpenAIs bahnbrechendes KI-Modell wissen müssen

Entdecken Sie ChatGPT-5s bahnbrechende Fortschritte, Anwendungsfälle, Benchmarks, Sicherheit, Preise und zukünftige Entwicklungen in diesem umfassenden FlowHunt...

OpenAI Whisper ist ein Open-Source-ASR-System, das Sprache in 99 Sprachen präzise in Text umwandelt und Transkription, Übersetzung sowie Sprachidentifikation für robuste KI-Automatisierung unterstützt.

OpenAI Whisper kann je nach Kontext sowohl als Modell als auch als System betrachtet werden.

Die Hauptfunktion von Whisper ist die Transkription von Sprache in Text. Es überzeugt durch:

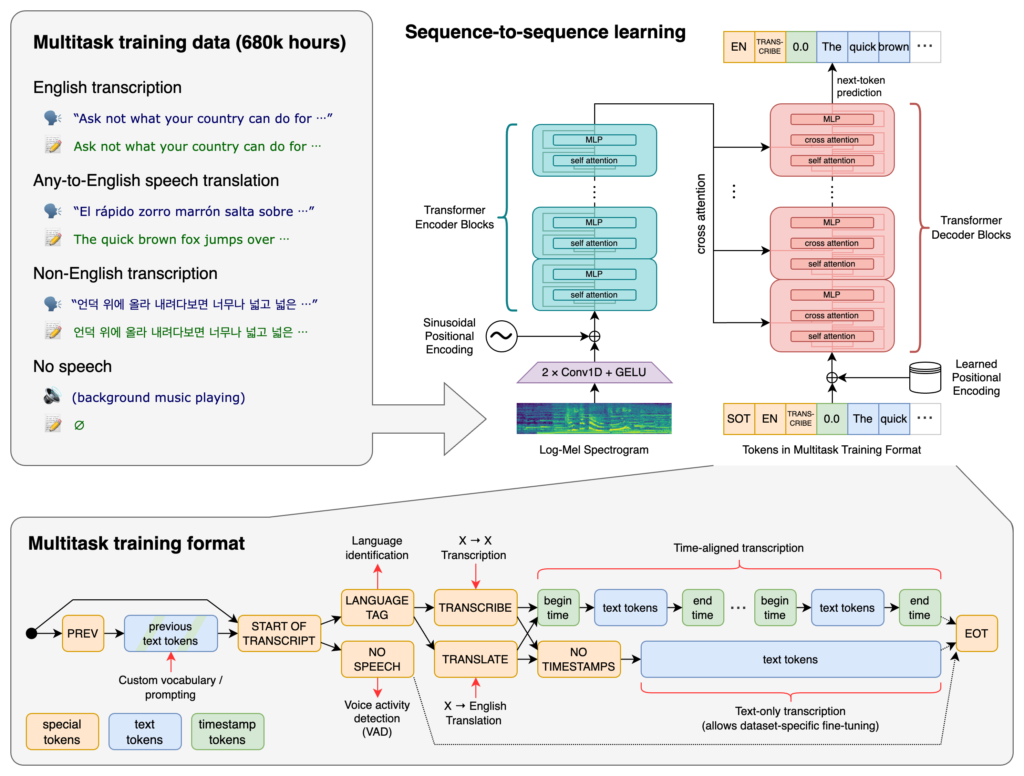

Im Kern von Whisper liegt die Transformer-Architektur, speziell ein Encoder-Decoder-Modell. Transformer sind neuronale Netze, die sich besonders für die Verarbeitung sequenzieller Daten und das Verstehen von Kontext über lange Abfolgen eignen. Vorgestellt im Paper “Attention is All You Need” (2017), sind Transformer heute grundlegend für viele NLP-Aufgaben.

Ablauf in Whisper:

Whisper wurde mit einem riesigen Datensatz von 680.000 Stunden überwachter Daten aus dem Internet trainiert. Dieser umfasst:

Mit der Unterstützung von 99 Sprachen hebt sich Whisper durch die Verarbeitung vielfältiger Sprachdaten hervor. Diese Mehrsprachigkeit macht es ideal für globale Anwendungen und Dienste mit internationalem Publikum.

Durch das Training mit umfangreichen überwachten Daten erreicht Whisper hohe Genauigkeitsraten bei Transkriptionen. Die Robustheit gegenüber Akzenten, Dialekten und Hintergrundgeräuschen macht es in vielen realen Szenarien zuverlässig.

Neben der Transkription kann Whisper:

Als Open-Source-Software veröffentlicht, ermöglicht Whisper Entwicklern:

Durch die Integration von Whisper in Chatbots und KI-Assistenten können Entwickler ermöglichen:

Whisper ist als Python-Bibliothek implementiert und lässt sich nahtlos in Python-basierte Projekte integrieren. Die Nutzung von Whisper in Python umfasst das Einrichten der Entwicklungsumgebung, die Installation aller erforderlichen Abhängigkeiten und die Verwendung der Bibliotheksfunktionen zur Transkription oder Übersetzung von Audiodateien.

Vor der Nutzung von Whisper muss die Entwicklungsumgebung mit Python, PyTorch, FFmpeg und der Whisper-Bibliothek eingerichtet werden.

Falls Python noch nicht installiert ist, laden Sie es von der offiziellen Website herunter. PyTorch installieren Sie mit pip:

pip install torch

Alternativ finden Sie auf der PyTorch-Website spezifische Installationsanweisungen je nach Betriebssystem und Python-Version.

Whisper benötigt FFmpeg zur Verarbeitung von Audiodateien. Installieren Sie FFmpeg mit dem passenden Paketmanager für Ihr Betriebssystem.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (mit Homebrew):

brew install ffmpeg

Windows (mit Chocolatey):

choco install ffmpeg

Installieren Sie das Whisper-Python-Paket mit pip:

pip install -U openai-whisper

Um die neueste Version direkt aus dem GitHub-Repository zu installieren:

pip install git+https://github.com/openai/whisper.git

Stellen Sie sicher, dass der Entwicklermodus aktiviert ist:

Whisper bietet verschiedene Modelle mit unterschiedlichen Größen und Fähigkeiten. Die Modelle reichen von tiny bis large und bieten jeweils unterschiedliche Balancen zwischen Geschwindigkeit und Genauigkeit.

| Größe | Parameter | Nur-Englisch-Modell | Mehrsprachiges Modell | Benötigter VRAM | Relative Geschwindigkeit |

|---|---|---|---|---|---|

| tiny | 39 Mio. | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 Mio. | base.en | base | ~1 GB | ~16x |

| small | 244 Mio. | small.en | small | ~2 GB | ~6x |

| medium | 769 Mio. | medium.en | medium | ~5 GB | ~2x |

| large | 1550 Mio. | N/A | large | ~10 GB | 1x |

.en): Für englische Transkriptionen optimiert, mit besserer Leistung bei englischem Audio.Nach Einrichtung der Umgebung und Installation der erforderlichen Komponenten können Sie Whisper in Ihren Python-Projekten einsetzen.

Importieren Sie die Whisper-Bibliothek und laden Sie ein Modell:

import whisper

# Gewünschtes Modell laden

model = whisper.load_model("base")

Ersetzen Sie "base" durch den Modellnamen, der zu Ihrer Anwendung passt.

Whisper bietet eine einfache transcribe-Funktion, um Audiodateien in Text umzuwandeln.

Beispiel: Englische Audiodatei transkribieren

# Audiodatei transkribieren

result = model.transcribe("path/to/english_audio.mp3")

# Transkription ausgeben

print(result["text"])

model.transcribe(): Verarbeitet die Audiodatei und gibt ein Dictionary mit Transkription und weiteren Metadaten zurück.result["text"]: Gibt den transkribierten Text aus dem Ergebnis aus.Whisper kann Audio aus verschiedenen Sprachen ins Englische übersetzen.

Beispiel: Spanisches Audio ins Englische übersetzen

# Spanisches Audio transkribieren und ins Englische übersetzen

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Übersetzten Text ausgeben

print(result["text"])

task="translate": Weist das Modell an, das Audio ins Englische zu übersetzen, statt es wortgetreu zu transkribieren.Obwohl Whisper die Sprache automatisch erkennen kann, verbessert eine explizite Angabe die Genauigkeit und Geschwindigkeit.

Beispiel: Französisches Audio transkribieren

# Französisches Audio mit Sprachangabe transkribieren

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Transkription ausgeben

print(result["text"])

Whisper kann die im Audio gesprochene Sprache mit der Methode detect_language identifizieren.

Beispiel: Spracherkennung

# Audio laden und vorverarbeiten

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# In Log-Mel-Spektrogramm umwandeln

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Sprache erkennen

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Erkannte Sprache: {language}")

whisper.load_audio(): Lädt die Audiodatei.whisper.pad_or_trim(): Passt die Audiolänge an die Modellanforderungen an.whisper.log_mel_spectrogram(): Wandelt das Audio in das vom Modell erwartete Format um.model.detect_language(): Gibt Wahrscheinlichkeiten für jede Sprache zurück und erkennt die wahrscheinlichste.Für mehr Kontrolle über den Transkriptionsprozess können Sie Low-Level-Funktionen nutzen und Dekodieroptionen anpassen.

decode verwendenMit der decode-Funktion können Sie Optionen wie Sprache, Aufgabe und Zeitstempel angeben.

Beispiel: Eigene Dekodieroptionen

# Dekodieroptionen setzen

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Audio dekodieren

result = whisper.decode(model, mel, options)

# Erkannten Text ausgeben

print(result.text)

Sie können Whisper integrieren, um Live-Audio von einem Mikrofon zu transkribieren.

Beispiel: Live-Mikrofoneingabe transkribieren

import whisper

import sounddevice as sd

# Modell laden

model = whisper.load_model("base")

# Audio vom Mikrofon aufnehmen

duration = 5 # Sekunden

fs = 16000 # Abtastrate

print("Aufnahme läuft...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper ist ein fortschrittliches automatisches Spracherkennungssystem (ASR), das von OpenAI entwickelt wurde, um gesprochene Sprache mithilfe von Deep Learning in geschriebenen Text zu transkribieren. Es unterstützt 99 Sprachen und zeichnet sich durch Transkription, Übersetzung und Sprachidentifikation aus.

Whisper verwendet eine auf Transformern basierende Encoder-Decoder-Architektur, verarbeitet Audio in Log-Mel-Spektrogramme und gibt Text über ein Sprachmodell aus. Es wurde mit 680.000 Stunden mehrsprachiger, multitask Daten für hohe Genauigkeit und Robustheit trainiert.

Whisper unterstützt mehrsprachige Spracherkennung, Sprachübersetzung, automatische Sprachidentifikation, Robustheit gegenüber Akzenten und Störgeräuschen und bietet Open-Source-Zugang für Anpassung und Integration.

Die Hardware-Anforderungen hängen von der Modellgröße ab: Kleinere Modelle wie 'tiny' benötigen ca. 1 GB VRAM, während das größte Modell ca. 10 GB benötigt. Whisper läuft schneller auf GPUs, kann aber auch auf CPUs mit längeren Verarbeitungszeiten genutzt werden.

Ja, Whisper ist als Python-Bibliothek implementiert und kann über pip installiert werden. So lässt es sich einfach in Python-Projekte für Sprachtranskription, Übersetzung und Echtzeit-Sprachanwendungen integrieren.

Typische Anwendungsfälle sind automatisierte Besprechungstranskription, sprachgesteuerte Chatbots, Live-Übersetzung, Barrierefreiheits-Tools (Untertitel und Hilfstechnologien), Callcenter-Automatisierung und sprachgesteuerte Automatisierungssysteme.

Ja, Alternativen sind Open-Source-Engines wie Mozilla DeepSpeech, Kaldi, Wav2vec sowie kommerzielle APIs wie Google Cloud Speech-to-Text, Microsoft Azure AI Speech und AWS Transcribe.

Ja, OpenAI Whisper ist Open Source, sodass Entwickler es anpassen, feinabstimmen und ohne Lizenzbeschränkungen in eigene Produkte und Dienstleistungen integrieren können.

Integrieren Sie fortschrittliche Sprache-zu-Text-Funktionen in Ihre Anwendungen, automatisieren Sie Workflows und verbessern Sie das Nutzererlebnis mit OpenAI Whisper und FlowHunt.

Entdecken Sie ChatGPT-5s bahnbrechende Fortschritte, Anwendungsfälle, Benchmarks, Sicherheit, Preise und zukünftige Entwicklungen in diesem umfassenden FlowHunt...

Large Language Model Meta AI (LLaMA) ist ein hochmodernes Modell zur Verarbeitung natürlicher Sprache, entwickelt von Meta. Mit bis zu 65 Milliarden Parametern ...

Textgenerierung mit großen Sprachmodellen (LLMs) bezieht sich auf den fortschrittlichen Einsatz von Machine-Learning-Modellen zur Erstellung menschenähnlicher T...