OpenAPI Schema Explorer MCP Server

Der OpenAPI Schema Explorer MCP Server ermöglicht effizienten, strukturierten Zugriff auf OpenAPI/Swagger-Spezifikationen als MCP-Ressourcen und schlägt damit e...

Stellen Sie OpenAPI-Schemas mit LLMs bereit und durchsuchen Sie sie. Endpunkte sofort auflisten, Schemas abrufen und API-Workflows mit dem OpenAPI Schema MCP Server optimieren.

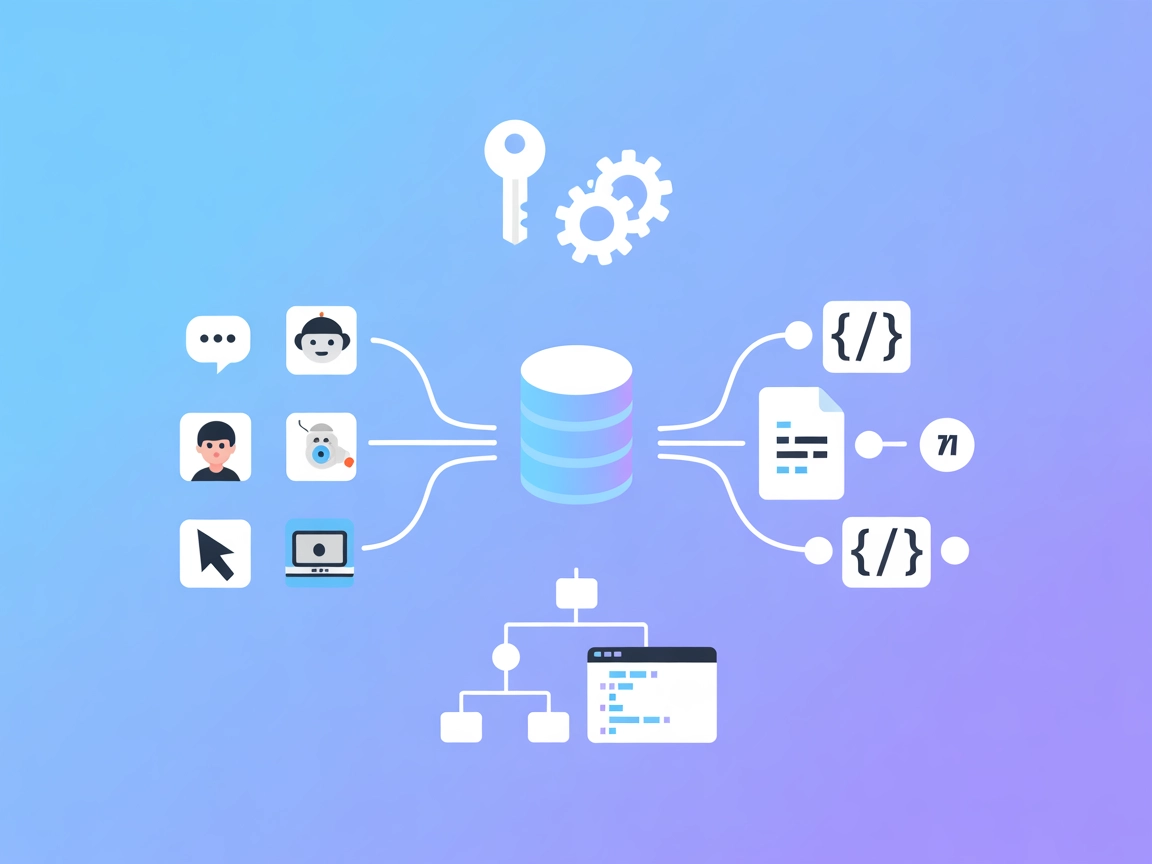

FlowHunt bietet eine zusätzliche Sicherheitsschicht zwischen Ihren internen Systemen und KI-Tools und gibt Ihnen granulare Kontrolle darüber, welche Tools von Ihren MCP-Servern aus zugänglich sind. In unserer Infrastruktur gehostete MCP-Server können nahtlos mit FlowHunts Chatbot sowie beliebten KI-Plattformen wie ChatGPT, Claude und verschiedenen KI-Editoren integriert werden.

Der OpenAPI Schema MCP Server ist ein Model Context Protocol (MCP) Server, der entwickelt wurde, um OpenAPI-Schemainformationen für Large Language Models (LLMs) wie Claude bereitzustellen. Durch den strukturierten Zugriff auf OpenAPI-Spezifikationen ermöglicht dieser Server KI-Assistenten, APIs zu erkunden und zu verstehen – einschließlich Endpunkte, Parameter, Anfrage- und Antwortschemas und mehr. So können Entwickler und KI-Tools API-Strukturen abfragen, in Spezifikationen suchen und detaillierte Schemadefinitionen abrufen, was Workflows rund um API-Integration, Dokumentation und Codegenerierung verbessert. Der Server unterstützt das Laden von OpenAPI-Dateien im JSON- oder YAML-Format und liefert Ergebnisse in YAML für ein besseres LLM-Verständnis.

Im Repository sind keine expliziten Prompt-Vorlagen dokumentiert.

Im Repository sind keine expliziten Ressourcen beschrieben.

Der OpenAPI Schema MCP Server stellt LLMs folgende Tools zur Verfügung:

Keine Setup-Anweisungen für Windsurf bereitgestellt.

npx installiert sind.~/Library/Application Support/Claude/claude_desktop_config.json$env:AppData\Claude\claude_desktop_config.jsonmcpServers hinzu:{

"mcpServers": {

"OpenAPI Schema": {

"command": "npx",

"args": ["-y", "mcp-openapi-schema", "/ABSOLUTE/PATH/TO/openapi.yaml"]

}

}

}

Keine Setup-Anweisungen für Cursor bereitgestellt.

npx installiert sind.claude mcp add openapi-schema npx -y mcp-openapi-schema

claude mcp add petstore-api npx -y mcp-openapi-schema ~/Projects/petstore.yaml

claude mcp list

claude mcp get openapi-schema

claude mcp remove openapi-schema

Keine Informationen zur Sicherung von API-Schlüsseln oder zur Verwendung von Umgebungsvariablen bereitgestellt.

MCP in FlowHunt verwenden

Um MCP-Server in Ihren FlowHunt-Workflow zu integrieren, fügen Sie zuerst die MCP-Komponente zu Ihrem Flow hinzu und verbinden Sie sie mit Ihrem KI-Agenten:

Klicken Sie auf die MCP-Komponente, um das Konfigurationspanel zu öffnen. Im Bereich der System-MCP-Konfiguration fügen Sie Ihre MCP-Serverdetails in diesem JSON-Format ein:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Nach der Konfiguration kann der KI-Agent diesen MCP nun als Tool mit Zugriff auf alle Funktionen und Fähigkeiten verwenden. Denken Sie daran, “MCP-name” durch den tatsächlichen Namen Ihres MCP-Servers zu ersetzen (z. B. “github-mcp”, “weather-api” usw.) und die URL entsprechend Ihrer MCP-Server-URL anzupassen.

| Abschnitt | Verfügbarkeit | Details/Anmerkungen |

|---|---|---|

| Übersicht | ✅ | |

| Liste der Prompts | ⛔ | Keine Prompt-Vorlagen dokumentiert |

| Liste der Ressourcen | ⛔ | Keine expliziten Ressourcen dokumentiert |

| Liste der Tools | ✅ | 10 dokumentierte Tools für OpenAPI-Schema-Zugriff |

| Sicherung von API-Schlüsseln | ⛔ | Nicht erwähnt |

| Sampling-Unterstützung (weniger wichtig) | ⛔ | Nicht erwähnt |

Basierend auf der verfügbaren Dokumentation ist der OpenAPI Schema MCP Server hoch spezialisiert auf die OpenAPI-Erkundung mit LLMs, bietet ein starkes Toolset, aber es fehlen Details zu Prompts, Ressourcen, API-Key-Handling und erweiterten MCP-Features. Für OpenAPI-Anwendungsfälle ist er robust; für breitere MCP-Funktionen ist er eingeschränkt.

| Hat eine LICENSE | ⛔ |

|---|---|

| Mindestens ein Tool | ✅ |

| Anzahl Forks | 9 |

| Anzahl Stars | 30 |

Bewertung:

Ich bewerte diesen MCP Server mit 6/10. Er ist gut definiert für die OpenAPI-Schema-Erkundung und bietet ein starkes Toolset, aber es fehlen Dokumentation zu MCP-Prompt-Vorlagen, explizite Ressourcendefinitionen, Sicherheits-Best-Practices und Hinweise zu Roots oder Sampling. Das Fehlen einer LICENSE ist ebenfalls eine wesentliche Einschränkung für offene Zusammenarbeit.

Es handelt sich um einen Model Context Protocol Server, der Large Language Models strukturierten Zugriff auf OpenAPI-Spezifikationen bietet und so fortschrittliche API-Erkundung, Dokumentation und Codegenerierung ermöglicht.

Er stellt Tools zur Verfügung, um Endpunkte aufzulisten, Endpunkt- und Komponentenschemas abzurufen, Anfrage- und Antwortschemas zu holen, Sicherheits-Schemes aufzulisten, Schemas zu durchsuchen und Beispiele abzurufen – alles programmatisch für LLMs zugänglich.

Anwendungsfälle sind API-Erkundung, automatisierte Codegenerierung, API-Dokumentation, Sicherheitsüberprüfung, Schemasuche und -analyse sowie Unterstützung von API-Testtools.

Ja, der Server kann OpenAPI-Dateien in beiden Formaten (JSON und YAML) laden und liefert Ergebnisse in YAML für ein besseres LLM-Verständnis.

Nein, die aktuelle Dokumentation enthält keine Prompt-Vorlagen oder explizite Ressourcendefinitionen.

Nein, die aktuelle Dokumentation behandelt weder die Sicherung von API-Schlüsseln noch die Verwendung von Umgebungsvariablen.

Es fehlen Prompt-Vorlagen, explizite Ressourcendokumentation, API-Key-Handling, Sampling-Unterstützung und eine Lizenzangabe – was die offene Zusammenarbeit einschränkt.

Ermöglichen Sie Ihren KI-Agenten, APIs programmgesteuert zu verstehen, zu dokumentieren und zu testen. Integrieren Sie den OpenAPI Schema MCP Server in Ihre Flows für nahtlosen API-Zugriff und Automatisierung.

Der OpenAPI Schema Explorer MCP Server ermöglicht effizienten, strukturierten Zugriff auf OpenAPI/Swagger-Spezifikationen als MCP-Ressourcen und schlägt damit e...

Der OpenAPI MCP Server verbindet KI-Assistenten mit der Fähigkeit, OpenAPI-Spezifikationen zu erkunden und zu verstehen, und bietet ausführlichen API-Kontext, Z...

Der GraphQL Schema MCP Server ermöglicht es KI-Assistenten und Entwicklern, GraphQL-Schemas programmatisch zu erkunden, zu analysieren und zu dokumentieren. Mit...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.