Redes Bayesianas

Una Red Bayesiana (BN) es un modelo gráfico probabilístico que representa variables y sus dependencias condicionales mediante un Gráfico Acíclico Dirigido (DAG)...

Naive Bayes es una familia de algoritmos de clasificación simple pero poderosa que aprovecha el Teorema de Bayes, comúnmente utilizada para tareas escalables como la detección de spam y la clasificación de textos.

Naive Bayes es una familia de algoritmos de clasificación simples y efectivos basados en el Teorema de Bayes, que asumen independencia condicional entre las características. Se utiliza ampliamente para la detección de spam, la clasificación de textos y más debido a su simplicidad y escalabilidad.

Naive Bayes es una familia de algoritmos de clasificación basados en el Teorema de Bayes, que aplica el principio de probabilidad condicional. El término “naive” (ingenuo) hace referencia a la suposición simplificada de que todas las características en un conjunto de datos son condicionalmente independientes entre sí dado la etiqueta de clase. A pesar de que esta suposición a menudo se viola en datos reales, los clasificadores Naive Bayes son reconocidos por su simplicidad y efectividad en diversas aplicaciones, como la clasificación de textos y la detección de spam.

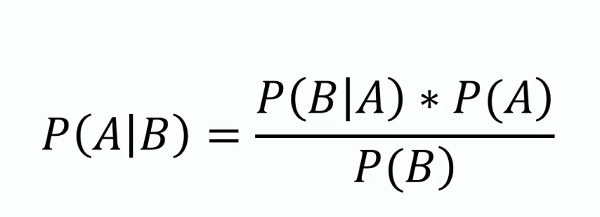

Teorema de Bayes

Este teorema forma la base de Naive Bayes, proporcionando un método para actualizar la estimación de probabilidad de una hipótesis a medida que se dispone de más evidencia o información. Matemáticamente, se expresa como:

donde ( P(A|B) ) es la probabilidad posterior, ( P(B|A) ) es la verosimilitud, ( P(A) ) es la probabilidad previa y ( P(B) ) es la evidencia.

Independencia condicional

La suposición ingenua de que cada característica es independiente de todas las demás características dado la etiqueta de clase. Esta suposición simplifica el cálculo y permite que el algoritmo escale bien con grandes conjuntos de datos.

Probabilidad posterior

La probabilidad de la etiqueta de clase dado los valores de las características, calculada usando el Teorema de Bayes. Este es el componente central para hacer predicciones con Naive Bayes.

Tipos de clasificadores Naive Bayes

Los clasificadores Naive Bayes funcionan calculando la probabilidad posterior para cada clase dado un conjunto de características y seleccionando la clase con la mayor probabilidad posterior. El proceso implica los siguientes pasos:

Los clasificadores Naive Bayes son particularmente efectivos en las siguientes aplicaciones:

Considere una aplicación de filtrado de spam usando Naive Bayes. Los datos de entrenamiento consisten en correos electrónicos etiquetados como “spam” o “no spam”. Cada correo se representa mediante un conjunto de características, como la presencia de palabras específicas. Durante el entrenamiento, el algoritmo calcula la probabilidad de cada palabra dada la etiqueta de clase. Para un nuevo correo electrónico, el algoritmo calcula la probabilidad posterior para “spam” y “no spam” y asigna la etiqueta con la mayor probabilidad.

Los clasificadores Naive Bayes pueden integrarse en sistemas de IA y chatbots para mejorar sus capacidades de procesamiento de lenguaje natural y potenciar la interacción humano-computadora. Por ejemplo, pueden utilizarse para detectar la intención de consultas de los usuarios, clasificar textos en categorías predefinidas o filtrar contenido inapropiado. Esta funcionalidad mejora la calidad y relevancia de las soluciones impulsadas por IA. Además, la eficiencia del algoritmo lo hace adecuado para aplicaciones en tiempo real, una consideración importante para la automatización con IA y sistemas de chatbots.

Naive Bayes es una familia de algoritmos probabilísticos simples pero potentes, basados en la aplicación del teorema de Bayes con fuertes suposiciones de independencia entre las características. Es ampliamente utilizado para tareas de clasificación debido a su simplicidad y efectividad. A continuación, algunos artículos científicos que abordan diversas aplicaciones y mejoras del clasificador Naive Bayes:

Improving spam filtering by combining Naive Bayes with simple k-nearest neighbor searches

Autor: Daniel Etzold

Publicado: 30 de noviembre de 2003

Este artículo explora el uso de Naive Bayes para la clasificación de correos electrónicos, destacando su facilidad de implementación y eficiencia. El estudio presenta resultados empíricos que muestran cómo la combinación de Naive Bayes con búsquedas de vecinos más cercanos puede mejorar la precisión del filtro de spam. La combinación proporcionó ligeras mejoras en la precisión con un gran número de características y mejoras significativas con menos características. Leer el artículo.

Locally Weighted Naive Bayes

Autores: Eibe Frank, Mark Hall, Bernhard Pfahringer

Publicado: 19 de octubre de 2012

Este artículo aborda la principal debilidad de Naive Bayes, que es su suposición de independencia de atributos. Presenta una versión ponderada localmente de Naive Bayes que aprende modelos locales en el momento de la predicción, relajando así la suposición de independencia. Los resultados experimentales demuestran que este enfoque rara vez reduce la precisión y a menudo la mejora significativamente. El método es elogiado por su simplicidad conceptual y computacional en comparación con otras técnicas. Leer el artículo.

Naive Bayes Entrapment Detection for Planetary Rovers

Autor: Dicong Qiu

Publicado: 31 de enero de 2018

En este estudio se analiza la aplicación de clasificadores Naive Bayes para la detección de atascos en rovers planetarios. Define los criterios para el atascamiento del rover y demuestra el uso de Naive Bayes para detectar dichos escenarios. El artículo detalla experimentos realizados con rovers AutoKrawler, proporcionando información sobre la efectividad de Naive Bayes para procedimientos autónomos de rescate. Leer el artículo.

Naive Bayes es una familia de algoritmos de clasificación basados en el Teorema de Bayes, que asume que todas las características son condicionalmente independientes dado la etiqueta de clase. Se utiliza ampliamente para la clasificación de textos, el filtrado de spam y el análisis de sentimientos.

Los principales tipos son Gaussian Naive Bayes (para características continuas), Multinomial Naive Bayes (para características discretas como el recuento de palabras) y Bernoulli Naive Bayes (para características binarias/booleanas).

Naive Bayes es sencillo de implementar, computacionalmente eficiente, escalable a grandes conjuntos de datos y maneja bien datos de alta dimensionalidad.

Su principal limitación es la suposición de independencia de características, que a menudo no se cumple en datos del mundo real. También puede asignar probabilidad cero a características no vistas, lo que puede mitigarse con técnicas como el suavizado de Laplace.

Naive Bayes se utiliza en sistemas de IA y chatbots para la detección de intenciones, la clasificación de textos, el filtrado de spam y el análisis de sentimientos, mejorando las capacidades de procesamiento de lenguaje natural y permitiendo la toma de decisiones en tiempo real.

Chatbots inteligentes y herramientas de IA bajo un mismo techo. Conecta bloques intuitivos para convertir tus ideas en Flujos automatizados.

Una Red Bayesiana (BN) es un modelo gráfico probabilístico que representa variables y sus dependencias condicionales mediante un Gráfico Acíclico Dirigido (DAG)...

Un clasificador de IA es un algoritmo de aprendizaje automático que asigna etiquetas de clase a datos de entrada, categorizando la información en clases predefi...

La clasificación de texto, también conocida como categorización o etiquetado de texto, es una tarea central de PLN que asigna categorías predefinidas a document...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.