Servidor DeepSeek MCP

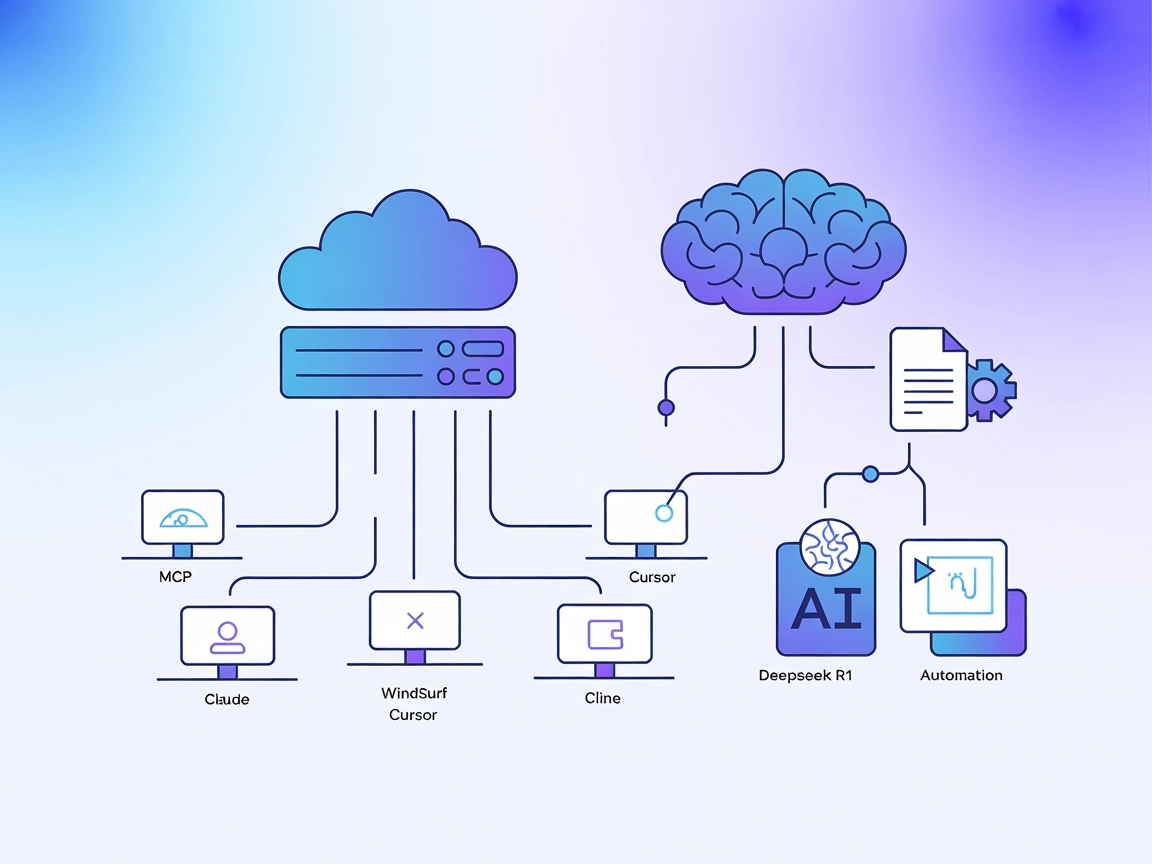

El Servidor DeepSeek MCP actúa como un proxy seguro, conectando los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP como Claude D...

Integra los modelos de alto contexto y optimizados para el razonamiento de DeepSeek en tus flujos de trabajo de IA con el servidor Deepseek R1 MCP para tareas avanzadas de lenguaje y automatización.

FlowHunt proporciona una capa de seguridad adicional entre tus sistemas internos y las herramientas de IA, dándote control granular sobre qué herramientas son accesibles desde tus servidores MCP. Los servidores MCP alojados en nuestra infraestructura pueden integrarse perfectamente con el chatbot de FlowHunt, así como con plataformas de IA populares como ChatGPT, Claude y varios editores de IA.

El servidor Deepseek R1 MCP es una implementación del Model Context Protocol (MCP) diseñada para conectar Claude Desktop con los avanzados modelos de lenguaje de DeepSeek, como Deepseek R1 y DeepSeek V3. Al actuar como puente entre asistentes de IA y los potentes modelos optimizados para razonamiento de DeepSeek (con una ventana de contexto de 8192 tokens), este servidor permite a los agentes de IA realizar tareas mejoradas de comprensión y generación de lenguaje natural. Los desarrolladores pueden aprovechar el servidor Deepseek R1 MCP para integrar estos modelos de manera fluida en sus flujos de trabajo, facilitando la generación avanzada de texto, el razonamiento y la interacción con fuentes de datos externas o APIs dentro de plataformas compatibles. La implementación se centra en ofrecer una integración estable, confiable y eficiente utilizando Node.js/TypeScript para máxima compatibilidad y seguridad de tipos.

No se documentan plantillas de prompt en el repositorio.

No se documentan recursos MCP explícitos en el repositorio.

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git

cd deepseek-r1-mcp

npm install

.env.exemple a .env y establece tu clave API de DeepSeek.{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Usa variables de entorno en tu configuración para mantener seguras las claves API:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Uso de MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo de FlowHunt, comienza agregando el componente MCP a tu flujo y conectándolo a tu agente IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración del sistema MCP, inserta los detalles de tu servidor MCP usando este formato JSON:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá utilizar este MCP como herramienta con acceso a todas sus funciones y capacidades. Recuerda cambiar “deepseek_r1” por el nombre real de tu servidor MCP y reemplazar la URL por la de tu propio servidor MCP.

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | |

| Lista de Prompts | ⛔ | No se documentan plantillas de prompt |

| Lista de Recursos | ⛔ | No se documentan recursos MCP explícitos |

| Lista de Herramientas | ✅ | Herramienta avanzada de generación de texto |

| Protección de Claves API | ✅ | Usa variables de entorno en la configuración |

| Soporte de muestreo (menos relevante) | ⛔ | No documentado |

| Soporta Roots | ⛔ | No documentado |

Según la documentación disponible, el servidor Deepseek R1 MCP ofrece una implementación limpia y enfocada que es fácil de configurar y usar, pero carece de documentación sobre prompts, recursos o características avanzadas de MCP como roots y sampling. Esto lo hace muy práctico para generación de texto, pero menos completo para flujos de trabajo complejos.

| Tiene LICENCIA | ✅ (MIT) |

|---|---|

| Tiene al menos una herramienta | ✅ |

| Número de Forks | 12 |

| Número de Stars | 58 |

Es un servidor Model Context Protocol (MCP) que actúa como puente entre Claude Desktop (u otras plataformas) y los avanzados modelos de lenguaje de DeepSeek (R1, V3), permitiendo una generación de texto, razonamiento y automatización mejorados en tus flujos de trabajo de IA.

El servidor soporta Deepseek R1 y DeepSeek V3—ambos optimizados para ventanas de contexto grandes y tareas de razonamiento complejas.

Los casos de uso incluyen generación avanzada de texto (larga, técnica o creativa), razonamiento lógico, mejora fluida de asistentes de IA en Claude Desktop y automatización de creación de contenido o gestión del conocimiento vía API.

Utiliza siempre variables de entorno en la configuración de tu servidor MCP para evitar la exposición accidental de tu clave API de DeepSeek.

No se documentan plantillas de prompt ni recursos MCP explícitos en el repositorio; el servidor está enfocado en el acceso e integración directa con el modelo.

DeepSeek R1 ofrece una ventana de contexto de 8192 tokens, permitiendo manejar tareas largas y complejas.

Sí, tiene licencia MIT y está disponible en GitHub.

Desbloquea generación avanzada de texto y razonamiento conectando FlowHunt o Claude Desktop a los potentes modelos de DeepSeek R1. Comienza a crear flujos de trabajo más inteligentes hoy.

El Servidor DeepSeek MCP actúa como un proxy seguro, conectando los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP como Claude D...

El servidor DeepSeek MCP integra los avanzados modelos de lenguaje de DeepSeek con aplicaciones compatibles con MCP, proporcionando acceso API seguro y anonimiz...

El Servidor Deepseek Thinker MCP integra el razonamiento del modelo Deepseek en clientes de IA habilitados para MCP como Claude Desktop, proporcionando salidas ...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.