Servidor Vega-Lite

Integra FlowHunt con el Servidor Vega-Lite para desbloquear capacidades avanzadas de visualización de datos en tus flujos de trabajo de IA. Genera y representa ...

Permite que tus agentes y asistentes de IA visualicen y gestionen datos con Vega-Lite, integrando de manera fluida funciones avanzadas de gráficos y exploración de datos en tus flujos de trabajo.

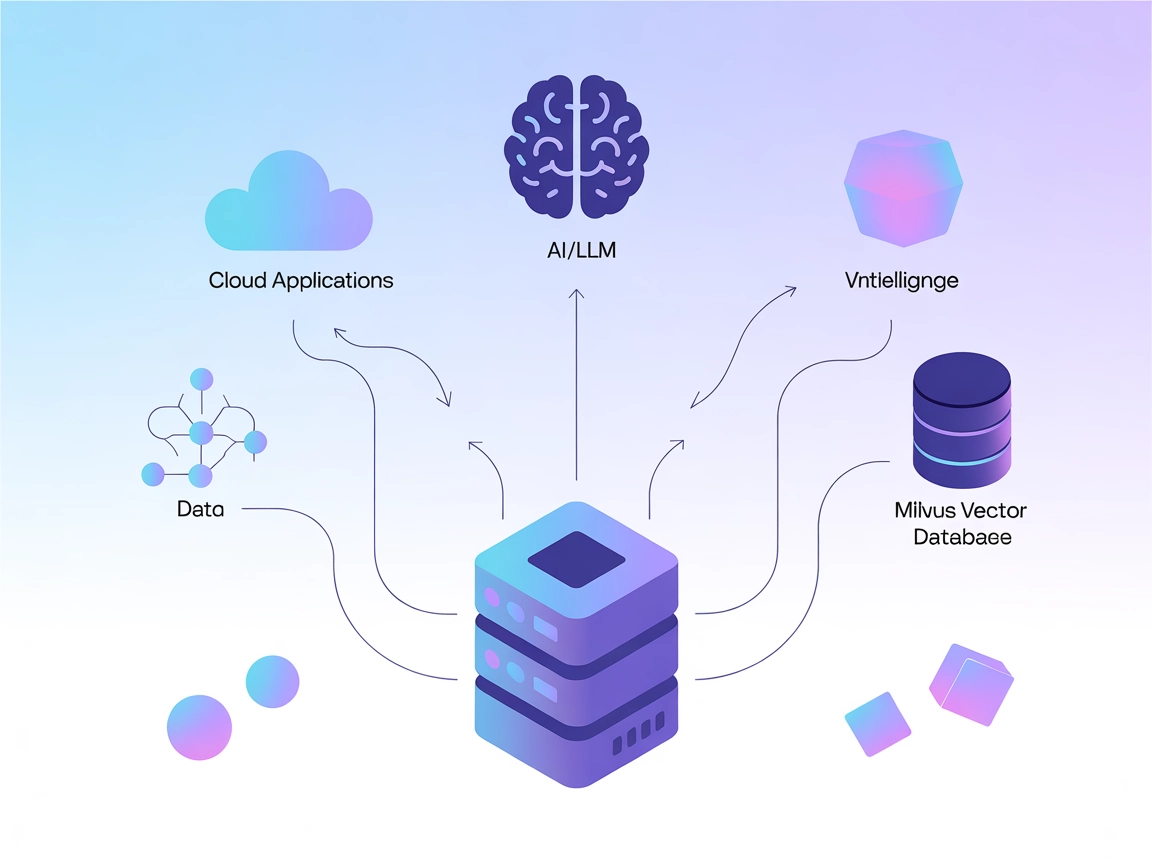

FlowHunt proporciona una capa de seguridad adicional entre tus sistemas internos y las herramientas de IA, dándote control granular sobre qué herramientas son accesibles desde tus servidores MCP. Los servidores MCP alojados en nuestra infraestructura pueden integrarse perfectamente con el chatbot de FlowHunt, así como con plataformas de IA populares como ChatGPT, Claude y varios editores de IA.

El Servidor MCP VegaLite es una implementación del Protocolo de Contexto de Modelo (MCP) que proporciona a los modelos de lenguaje grande (LLM) una interfaz para visualizar datos usando la sintaxis de Vega-Lite. Al conectarse a este servidor, los asistentes de IA y las aplicaciones pueden delegar tareas como guardar datos tabulares y generar visualizaciones (gráficos, diagramas, etc.) definidas en la especificación Vega-Lite. Esto mejora los flujos de trabajo de los desarrolladores al permitir la visualización programática de datos sin interrupciones, permitiendo que los LLM gestionen conjuntos de datos y produzcan salidas visuales personalizadas, esenciales para el análisis de datos, reportes e investigación. El servidor soporta la devolución de la especificación Vega-Lite completa con los datos adjuntos (en modo texto) o una imagen PNG codificada en base64 de la visualización (en modo imagen), lo que lo hace flexible para varios escenarios de integración.

No hay plantillas de prompts listadas en el repositorio.

No se documentan recursos MCP explícitos en el repositorio.

name (string): Nombre de la tabla de datos a guardar.data (array): Array de objetos que representan la tabla de datos.data_name (string): Nombre de la tabla de datos a visualizar.vegalite_specification (string): Cadena JSON que representa la especificación Vega-Lite.--output_type está en text, devuelve la especificación Vega-Lite completa con los datos; si está en png, devuelve una imagen PNG codificada en base64.No hay instrucciones de configuración para Windsurf listadas en el repositorio.

claude_desktop_config.json.mcpServers.{

"mcpServers": {

"datavis": {

"command": "uv",

"args": [

"--directory",

"/absolute/path/to/mcp-datavis-server",

"run",

"mcp_server_datavis",

"--output_type",

"png" // o "text"

]

}

}

}

No se proporcionan instrucciones ni ejemplos específicos para la protección de claves API en el repositorio.

No hay instrucciones de configuración para Cursor listadas en el repositorio.

No hay instrucciones de configuración para Cline listadas en el repositorio.

Uso del MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo de FlowHunt, comienza agregando el componente MCP a tu flujo y conectándolo a tu agente de IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración del sistema MCP, inserta los detalles de tu servidor MCP usando este formato JSON:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá usar este MCP como una herramienta con acceso a todas sus funciones y capacidades. Recuerda cambiar “MCP-name” por el nombre real de tu servidor MCP (por ejemplo, “vegalite”, “data-vis”, etc.) y reemplazar la URL por la de tu propio servidor MCP.

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | Resumen claro en el README |

| Lista de Prompts | ⛔ | No hay plantillas de prompts listadas |

| Lista de Recursos | ⛔ | No hay recursos explícitos listados |

| Lista de Herramientas | ✅ | save_data, visualize_data documentadas |

| Protección de claves API | ⛔ | Sin información sobre protección o paso de claves API |

| Soporte de Muestreo (menos relevante) | ⛔ | No se menciona |

Con base en las tablas anteriores, el Servidor MCP VegaLite está enfocado y bien documentado en cuanto a herramientas y resumen, pero carece de información sobre prompts, recursos y configuración de seguridad, lo que limita su puntaje de integración listo para usar.

El servidor MCP VegaLite es sencillo, con una interfaz clara para la visualización de datos vía LLM. Sin embargo, la ausencia de plantillas de prompts, recursos y pautas de seguridad reduce su usabilidad para escenarios más avanzados o de producción. Su principal valor radica en sus herramientas funcionales para guardar y visualizar datos, pero su completitud y extensibilidad generales son limitadas.

Puntuación: 5/10

| Tiene LICENSE | ⛔ |

|---|---|

| Tiene al menos una herramienta | ✅ |

| Número de Forks | 18 |

| Número de Stars | 72 |

Proporciona una interfaz para que los modelos de lenguaje grande visualicen datos usando la sintaxis de Vega-Lite, permitiéndoles gestionar conjuntos de datos y producir salidas visuales personalizadas como gráficos o diagramas para análisis de datos, reportes y uso educativo.

Ofrece dos herramientas principales: `save_data` para guardar una tabla de agregaciones de datos para su visualización, y `visualize_data` para generar visualizaciones usando especificaciones Vega-Lite, devolviendo una especificación completa con datos (texto) o una imagen PNG.

Agrega el componente MCP a tu flujo, abre la configuración e inserta los detalles de tu servidor MCP en el formato JSON proporcionado en la documentación, reemplazando el nombre y la URL según corresponda.

Es ideal para análisis y visualización de datos programáticos, reportes automatizados, exploración de datos interactiva y herramientas educativas donde los usuarios o agentes de IA necesitan visualizar conjuntos de datos y aprender sobre principios de visualización de datos de forma interactiva.

No se proporcionan instrucciones ni ejemplos específicos para la protección de claves API en el repositorio.

Mejora tus proyectos basados en datos con visualización en tiempo real potenciada por IA usando el Servidor MCP VegaLite en FlowHunt.

Integra FlowHunt con el Servidor Vega-Lite para desbloquear capacidades avanzadas de visualización de datos en tus flujos de trabajo de IA. Genera y representa ...

El Servidor Milvus MCP conecta asistentes de IA y aplicaciones potenciadas por LLM con la base de datos vectorial Milvus, permitiendo búsquedas vectoriales avan...

El Servidor Vertica MCP permite una integración fluida entre asistentes de IA y bases de datos OpenText Vertica, soportando operaciones SQL seguras, carga masiv...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.