Qu'est-ce qu'un serveur MCP ? Guide complet du Model Context Protocol

Découvrez ce que sont les serveurs MCP (Model Context Protocol), comment ils fonctionnent et pourquoi ils révolutionnent l'intégration de l'IA. Découvrez commen...

Découvrez comment développer un serveur Model Context Protocol (MCP) qui s’intègre parfaitement à l’API d’OpenAI, permettant l’exécution d’outils pilotés par l’IA et l’automatisation intelligente.

Le Model Context Protocol (MCP) représente un changement de paradigme dans la façon dont les systèmes d’intelligence artificielle interagissent avec les outils et sources de données externes. Lorsqu’il est combiné avec les puissants modèles linguistiques d’OpenAI, un serveur MCP devient une passerelle vers l’automatisation intelligente, permettant aux systèmes d’IA d’exécuter des opérations complexes, de récupérer des données en temps réel et de s’intégrer parfaitement à votre infrastructure existante. Ce guide complet vous accompagne de A à Z dans le développement d’un serveur MCP connecté à OpenAI, des concepts fondamentaux jusqu’à la mise en production.

Que vous construisiez une plateforme d’automatisation du service client, un système intelligent de traitement de données ou un outil sophistiqué de business intelligence, comprendre comment architecturer et implémenter un serveur MCP est essentiel pour le développement IA moderne. L’intégration entre serveurs MCP et OpenAI crée un écosystème puissant où les modèles d’IA peuvent raisonner sur des problématiques, décider quels outils utiliser et les exécuter avec précision—tout en maintenant sécurité, fiabilité et scalabilité.

Le Model Context Protocol est une norme ouverte qui définit comment les modèles d’IA peuvent découvrir et interagir avec des outils, services et sources de données externes. Plutôt que d’intégrer toutes les fonctionnalités directement dans un modèle d’IA, MCP permet aux développeurs de créer des serveurs spécialisés qui exposent des capacités via une interface standardisée. Cette séparation des responsabilités favorise la modularité, la sécurité et la montée en charge des applications IA.

Au cœur du protocole, MCP fonctionne sur un principe simple : le modèle d’IA (ici, GPT d’OpenAI) agit comme un orchestrateur intelligent capable de comprendre quels outils sont disponibles, de déterminer quand les utiliser et d’interpréter leurs résultats. Le serveur MCP agit comme fournisseur de ces outils, les exposant à travers une API bien définie que le modèle d’IA peut découvrir et invoquer. Cela crée un contrat clair entre le système d’IA et votre logique métier personnalisée.

La force du MCP réside dans sa flexibilité. Votre serveur peut exposer des outils pour tout type de besoin—requêtes base de données, appels API à des services tiers, traitement de fichiers, calculs ou même déclenchement de workflows complexes. Le modèle d’IA apprend ces capacités et les utilise intelligemment dans les conversations, prenant des décisions sur les outils à invoquer selon la demande de l’utilisateur et le contexte.

L’intégration des serveurs MCP avec OpenAI répond à une limitation fondamentale des grands modèles linguistiques : ils ont une limite de connaissance et ne peuvent pas interagir directement avec des systèmes temps réel ou des données propriétaires. En mettant en œuvre un serveur MCP, vous étendez les capacités des modèles d’OpenAI bien au-delà de leur base d’entraînement, leur permettant d’accéder à des informations actualisées, d’exécuter de la logique métier et de s’intégrer à vos systèmes existants.

Voici quelques scénarios pratiques où les serveurs MCP sont précieux :

Cette architecture offre également de grands avantages aux équipes de développement. Plusieurs équipes peuvent développer et maintenir indépendamment leurs propres serveurs MCP, qui seront ensuite composés ensemble pour créer des applications IA sophistiquées. Cette approche modulaire s’adapte à la croissance de votre organisation et à la complexification de vos besoins IA.

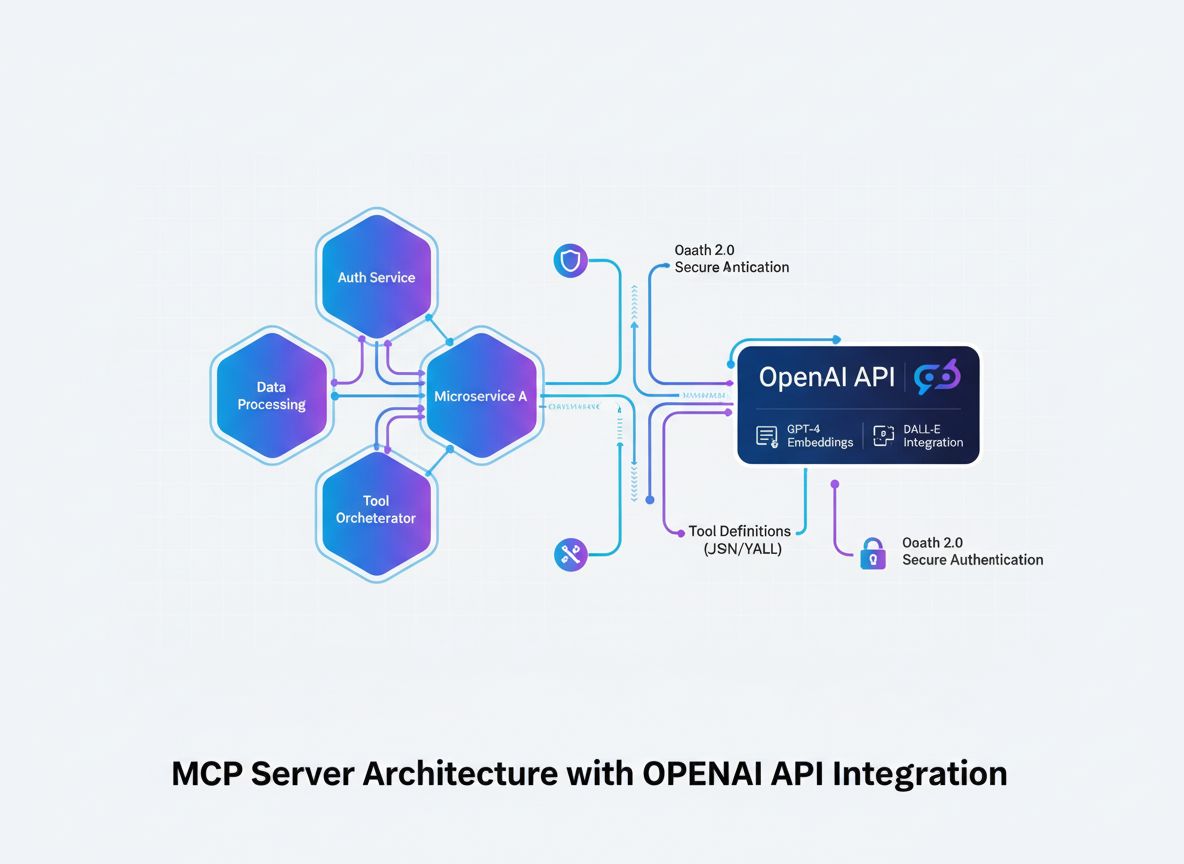

Avant d’entrer dans le détail de l’implémentation, il est essentiel de comprendre le flux architectural d’intégration d’un serveur MCP avec OpenAI. Le processus implique plusieurs composants clés fonctionnant de concert :

Le modèle d’IA (OpenAI) initie des conversations et décide quels outils invoquer. Lorsqu’il estime qu’un appel d’outil est nécessaire, il génère une requête structurée avec le nom de l’outil et les paramètres.

Le client MCP agit comme traducteur et intermédiaire. Il reçoit les requêtes d’invocation d’outils d’OpenAI, les traduit au format attendu par votre serveur MCP, envoie la requête au serveur approprié et retourne les résultats à OpenAI dans le format attendu.

Le serveur MCP est votre application personnalisée qui expose des outils et des capacités. Il reçoit les requêtes du client MCP, exécute les opérations demandées (requêtes bases de données, appels API, calculs complexes, etc.) et retourne des résultats structurés.

Les définitions d’outils sont les contrats qui définissent les outils disponibles, leurs paramètres d’entrée et ce qu’ils retournent. Ces définitions sont découvertes par le client MCP et enregistrées auprès d’OpenAI pour informer le modèle de ce qui est disponible.

Cette architecture crée une séparation claire des responsabilités : OpenAI gère le raisonnement et la prise de décision, votre serveur MCP gère la logique métier et l’accès aux données, et le client MCP gère la communication protocolaire entre eux.

La base de tout serveur MCP réussi est une définition claire des outils à exposer. Ce n’est pas qu’un exercice technique—c’est une décision stratégique sur les capacités nécessaires à votre système IA.

Commencez par identifier les problématiques que votre système IA doit résoudre. Développez-vous un chatbot service client qui doit rechercher des informations de commande ? Un assistant d’analyse de données qui doit interroger des bases ? Un outil de création de contenu qui doit accéder à la base de connaissances de votre entreprise ? Chaque cas d’usage implique des besoins d’outils différents.

Pour chaque outil, définissez :

get_customer_order_history, search_knowledge_base, execute_sql_query)Exemple de spécifications d’outils bien définies :

| Nom de l’outil | Objectif | Paramètres d’entrée | Format de sortie | Cas d’usage |

|---|---|---|---|---|

get_customer_info | Récupérer les infos client | customer_id (string) | Objet JSON : nom, email, statut | Requêtes service client |

search_orders | Trouver des commandes | customer_id, date_range, status | Tableau d’objets commande | Recherche historique |

create_support_ticket | Ouvrir un ticket support | customer_id, issue_description, priority | Objet ticket avec ID et confirmation | Escalade d’incident |

check_inventory | Vérifier disponibilité | product_id, warehouse_location | Stock et localisation | Demande de stock |

process_refund | Traiter un remboursement | order_id, amount, reason | Confirmation avec référence | Remboursement |

Cette approche tabulaire vous aide à concevoir l’écosystème d’outils complet avant d’écrire la moindre ligne de code, assurant cohérence, clarté et exhaustivité.

Créer un serveur MCP nécessite une base de développement solide. Bien que les serveurs MCP puissent être développés dans plusieurs langages, nous nous concentrerons sur les approches les plus populaires : TypeScript/Node.js et Python, qui disposent de bibliothèques MCP matures et d’un large support communautaire.

Pour le développement TypeScript/Node.js :

Créez un nouveau projet Node.js et installez les dépendances nécessaires :

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Créez un fichier tsconfig.json pour configurer TypeScript :

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Pour le développement Python :

Créez un environnement virtuel et installez les dépendances :

python -m venv venv

source venv/bin/activate # Sous Windows : venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Quel que soit le langage, vous aurez besoin de :

.env pour stocker vos identifiants sensiblesLe cœur de votre serveur MCP est l’application qui expose vos outils via le protocole MCP. Cela implique de créer des endpoints pour la découverte et l’exécution d’outils.

Implémentation TypeScript/Node.js :

Créez une structure de serveur MCP basique :

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Définissez vos outils

const tools = [

{

name: "get_customer_info",

description: "Récupère les informations du client à partir de son identifiant",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Identifiant unique du client",

},

},

required: ["customer_id"],

},

},

// Ajoutez d'autres outils ici

];

// Gestion de la requête de listing des outils

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Gestion de l'exécution des outils

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implémentez la logique de votre outil ici

const customerId = args.customer_id;

// Requête à votre base ou API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Outil inconnu : ${name}` }],

isError: true,

};

});

// Démarrage du serveur

const transport = new StdioServerTransport();

server.connect(transport);

Implémentation Python :

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Définissez vos outils

TOOLS = [

Tool(

name="get_customer_info",

description="Récupère les informations du client à partir de son identifiant",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Identifiant unique du client"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implémentez la logique de l'outil

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Outil inconnu : {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

La vraie puissance de votre serveur MCP se trouve dans l’implémentation concrète de vos outils. C’est là que vous connectez des bases de données, appelez des API externes, traitez des données et exécutez la logique métier.

Exemple d’intégration base de données :

import { Pool } from "pg"; // Exemple PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Client non trouvé",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Échec de la requête base de données",

details: error.message,

status: 500,

};

}

}

Exemple d’intégration API externe :

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Échec de l'appel API externe",

details: error.message,

};

}

}

Gestion des erreurs et validation :

Une gestion robuste des erreurs est cruciale en production. Implémentez une validation et une gestion des erreurs étendues :

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Validation des champs requis

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Paramètre requis manquant : ${required}` };

}

}

// Validation des types de champ

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `Le paramètre ${key} doit être de type ${expectedType}`,

};

}

}

}

return { valid: true };

}

Le client MCP fait le lien entre OpenAI et votre serveur MCP. Il traduit le format d’appel de fonction d’OpenAI vers le protocole de votre serveur MCP.

Client MCP TypeScript/Node.js :

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Connexion au serveur MCP

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Découverte des outils disponibles

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Conversion des outils MCP au format fonction OpenAI

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Gestion des appels d'outil en boucle

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Exécution de l'outil sur le serveur MCP

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Ajout du résultat aux messages

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Prochaine réponse d'OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Utilisation

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"Quel est l'historique de commande du client 12345 ?"

);

console.log(result);

La sécurité est primordiale pour les serveurs MCP manipulant des données sensibles et des API externes. Mettez en place plusieurs couches de sécurité :

Gestion des clés API :

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Chargez les clés API valides depuis l'environnement ou un stockage sécurisé

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Signature et vérification de requêtes :

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Limitation de débit :

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minutes

max: 100, // limite de 100 requêtes par fenêtre et par IP

message: "Trop de requêtes depuis cette IP, veuillez réessayer plus tard.",

});

app.use("/api/", limiter);

Sanitisation des entrées :

function sanitizeInput(input: string): string {

// Retirer les caractères potentiellement dangereux

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limite la longueur

}

function validateCustomerId(customerId: string): boolean {

// Autorise uniquement alphanumérique et tirets

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Des tests complets garantissent le bon fonctionnement de votre serveur MCP et une gestion élégante des cas limites.

Exemple de tests unitaires (Jest) :

import { getCustomerInfo } from "../tools/customer";

describe("Outils client", () => {

test("doit retourner les infos client pour un ID valide", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("doit retourner une erreur pour un ID invalide", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("doit gérer proprement les erreurs de base de données", async () => {

// Simulation d'erreur base de données

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Tests d’intégration :

describe("Intégration du serveur MCP", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Initialisation du serveur

});

test("doit lister tous les outils disponibles", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("doit exécuter un outil et retourner un résultat", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt propose une plateforme complète pour automatiser tout le cycle de vie du développement, des tests et du déploiement de serveurs MCP. Plutôt que de gérer manuellement chaque étape, FlowHunt vous permet de créer des flux d’automatisation intelligents assurant la cohérence et la reproductibilité de vos process IA.

Tests et validation automatisés :

FlowHunt orchestre votre pipeline de tests (unitaires, intégration, end-to-end) à chaque commit, assurant que vos outils MCP fonctionnent toujours avant déploiement.

Intégration et déploiement continus :

Configurez des workflows FlowHunt pour automatiquement construire, tester et déployer votre serveur MCP à chaque mise à jour. Vous éliminez ainsi les déploiements manuels et réduisez les risques d’erreur humaine.

Supervision et alerting :

FlowHunt surveille la santé de votre serveur MCP, suit les temps de réponse API et vous alerte sur toute anomalie. Si un outil échoue ou si les performances baissent, vous êtes informé instantanément.

Génération de documentation :

Générez automatiquement la documentation API de vos outils MCP, maintenant vos docs toujours à jour et synchronisées.

Optimisation des performances :

Les analytics FlowHunt vous aident à identifier les goulets d’étranglement dans l’exécution de vos outils. Vous visualisez les outils les plus utilisés, ceux avec la latence la plus élevée, et pouvez cibler vos efforts d’optimisation.

Le déploiement en production exige une planification attentive. Voici quelques stratégies :

Conteneurisation Docker :

Créez un Dockerfile pour votre serveur MCP :

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Construisez et poussez vers un registry :

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Déploiement Kubernetes :

Déployez votre conteneur sur Kubernetes :

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Configuration d’environnement :

Utilisez les variables d’environnement pour toute la configuration :

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

À mesure que votre serveur MCP se complexifie, adoptez ces modèles avancés :

Composition d’outils :

Créez des outils de haut niveau qui composent plusieurs outils bas niveau :

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Récupérer les infos client

const customer = await getCustomerInfo(customerId);

// Récupérer les détails de commande

const order = await getOrderDetails(orderId);

// Vérifier l'appartenance de la commande

if (order.customerId !== customerId) {

throw new Error("La commande n'appartient pas au client");

}

// Traiter le remboursement

const refund = await createRefund(orderId, amount);

// Envoyer la notification

await sendNotification(customer.email, `Remboursement de ${amount} € traité`);

return refund;

}

Stratégie de cache :

Mettez en place du cache pour réduire la latence et les appels API :

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // TTL 10 min

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Vérifier dans le cache

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Récupérer depuis la base

const customer = await getCustomerInfo(customerId);

// Mettre en cache

cache.set(cacheKey, customer);

return customer;

}

Traitement de jobs asynchrones :

Pour les opérations longues, implémentez du traitement asynchrone :

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Exécution de l'outil

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Les serveurs MCP de production doivent être surveillés et loggés en continu :

Logs structurés :

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Outil exécuté", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Collecte de métriques :

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Durée d'exécution des outils en ms",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Nombre total d'exécutions d'outils",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Construire un serveur MCP connecté à OpenAI représente un progrès considérable pour créer des applications IA intelligentes et intégrées. En suivant les modèles d’architecture, stratégies d’implémentation et bonnes pratiques de ce guide, vous pouvez réaliser des serveurs MCP robustes et scalables qui étendent les capacités d’OpenAI bien au-delà de leur base d’entraînement.

Le succès repose sur une planification attentive des définitions d’outils, la mise en œuvre rigoureuse de la sécurité, des tests complets et une supervision continue en production. Commencez par un ensemble simple d’outils, validez leur fonctionnement avec OpenAI, puis enrichissez progressivement votre serveur à mesure que vous gagnez en confiance et expérience.

Gardez à l’esprit que votre serveur MCP n’est pas un artefact statique—c’est un système vivant qui évoluera avec vos besoins métiers et vos découvertes de nouveaux usages IA. Construisez-le de façon modulaire et extensible, documentez soigneusement vos outils, et maintenez une séparation claire entre logique métier et implémentation MCP.

La combinaison des serveurs MCP et des puissants modèles d’OpenAI ouvre des opportunités inédites en automatisation, intelligence et intégration. En maîtrisant cette technologie, vous placez votre organisation à l’avant-garde de l’innovation pilotée par l’IA.

Automate your MCP server development, testing, and deployment workflows. From continuous integration to production monitoring, FlowHunt streamlines every step of your AI development lifecycle.

Le Model Context Protocol est un cadre standardisé qui permet aux modèles d'IA comme GPT d'OpenAI de découvrir, comprendre et exécuter des outils et fonctions fournis par des serveurs externes. Il sert de passerelle entre les modèles d'IA et la logique métier personnalisée.

Vous devez disposer d'une clé API OpenAI valide avec les autorisations appropriées. Le serveur MCP lui-même ne nécessite pas d'autorisation spéciale de la part d'OpenAI—il communique via des appels API standards. Cependant, vous devez mettre en place une authentification et une autorisation adéquates sur votre serveur MCP.

Les serveurs MCP peuvent être conçus dans n'importe quel langage prenant en charge les API HTTP/REST ou les connexions WebSocket. Les choix populaires incluent Python, TypeScript/Node.js, Java, C#/.NET et Go. Le choix du langage dépend de votre infrastructure existante et des compétences de votre équipe.

Mettez en œuvre la limitation de débit côté serveur MCP, mettez en cache les résultats fréquemment demandés, utilisez la stratégie d'attente exponentielle pour les nouvelles tentatives et surveillez l'utilisation de votre API OpenAI. Envisagez aussi de mettre en place un système de file d'attente pour les requêtes afin de gérer efficacement la charge.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

Simplifiez le développement, le test et le déploiement de votre serveur MCP grâce à la plateforme d'automatisation intelligente de FlowHunt.

Découvrez ce que sont les serveurs MCP (Model Context Protocol), comment ils fonctionnent et pourquoi ils révolutionnent l'intégration de l'IA. Découvrez commen...

Découvrez des exemples complets de serveurs MCP et apprenez à créer, déployer et intégrer des serveurs Model Context Protocol pour renforcer les capacités des a...

Apprenez à construire et déployer un serveur Model Context Protocol (MCP) pour connecter des modèles d'IA à des outils externes et des sources de données. Guide...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.