Webflow

Intégrez FlowHunt avec Webflow MCP pour automatiser la gestion de votre site et de votre CMS, mettre à jour le contenu et orchestrer des workflows intelligents ...

Un guide complet pour intégrer l’intelligence artificielle avec des applications externes via API et webhooks, incluant l’authentification, la communication en temps réel et des stratégies d’implémentation pratiques.

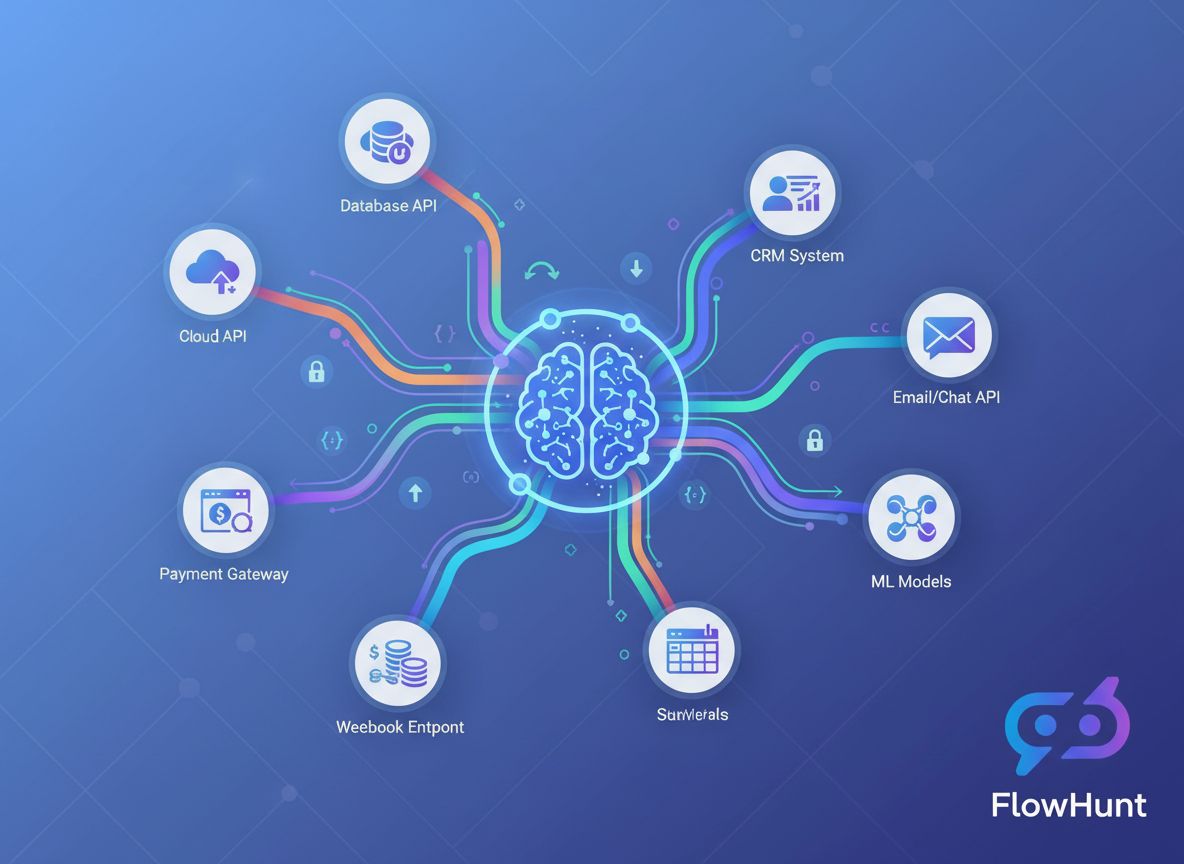

La convergence de l’intelligence artificielle et des applications externes a profondément transformé le fonctionnement des entreprises. Les organisations actuelles n’utilisent plus des systèmes d’IA isolés : elles orchestrent désormais des intégrations sophistiquées connectant les modèles d’IA avec des plateformes CRM, des passerelles de paiement, des outils de communication et bien d’autres services. Ce guide complet explore les approches techniques et stratégiques pour intégrer l’IA avec des outils externes via les API et les webhooks, afin de vous donner les clés pour construire des workflows robustes, évolutifs et sécurisés, pilotés par l’IA.

Que vous soyez développeur en quête de votre première intégration IA ou architecte d’entreprise concevant des systèmes automatisés complexes, comprendre les subtilités de l’intégration basée sur API et webhooks est essentiel. Cet article vous guide du concept fondamental aux schémas d’implémentation avancés, pour que vous puissiez connecter les capacités de l’IA à votre stack technologique existante en toute confiance.

Avant d’aborder les stratégies d’intégration, il est crucial de comprendre la différence fondamentale entre ces deux modes de communication. Une API (Interface de Programmation d’Application) est un ensemble de protocoles et d’outils permettant à différentes applications logicielles de communiquer entre elles. Les APIs fonctionnent selon un modèle pull : votre application sollicite activement des données ou des services auprès d’un système externe. Lorsque vous avez besoin d’information, vous initiez la demande, attendez la réponse et traitez les données retournées.

À l’inverse, un webhook fonctionne sur un modèle push. Plutôt que de demander des mises à jour en continu, les webhooks permettent aux systèmes externes d’envoyer proactivement des données à votre application lorsqu’un événement spécifique se produit. C’est comme la différence entre vérifier sa boîte aux lettres plusieurs fois par jour, et recevoir un colis directement à sa porte dès qu’il arrive.

Les APIs sont généralement utilisées pour des opérations à la demande : récupérer des informations utilisateurs, traiter des paiements, générer des prédictions IA ou obtenir des données en temps réel. Les webhooks excellent pour les scénarios déclenchés par événements, où une notification immédiate est requise : paiement reçu, formulaire soumis, fichier téléchargé ou action utilisateur spécifique.

Le choix entre API et webhook dépend souvent du cas d’usage. Beaucoup d’intégrations avancées utilisent les deux : les APIs pour interroger les données et les webhooks pour recevoir les notifications en temps réel. Cette approche hybride apporte la flexibilité et la réactivité qu’exigent les applications modernes.

L’intérêt métier de l’intégration de l’IA avec des outils externes est à la fois convaincant et multiple. Les organisations qui réussissent ces intégrations bénéficient d’un avantage compétitif significatif sur plusieurs axes.

Efficacité opérationnelle et réduction des coûts : Isoler les systèmes d’IA des outils existants crée des silos de données et des points de transfert manuels. L’intégration directe de l’IA à votre CRM, plateforme email, outils de gestion de projet et autres applications élimine ces frictions. Au lieu de copier manuellement des données entre systèmes, l’IA peut traiter automatiquement l’information, générer des insights et déclencher des actions sur l’ensemble de votre écosystème technologique. Cette automatisation réduit les coûts, minimise les erreurs humaines et libère vos équipes pour des tâches à plus forte valeur ajoutée.

Décision en temps réel : Les webhooks permettent à l’IA de réagir instantanément aux événements métiers. Lorsqu’un client soumet un ticket, l’IA peut immédiatement analyser le sentiment et le router vers la bonne équipe. Quand les ventes évoluent, l’IA peut recalculer les prévisions instantanément. Si le stock passe sous un seuil, l’IA peut générer des commandes d’achat automatiquement. Cette réactivité transforme la capacité de l’organisation à s’adapter aux besoins du marché et des clients.

Expérience client enrichie : Des systèmes IA intégrés offrent une expérience fluide et personnalisée. Un chatbot IA relié au CRM peut accéder à l’historique client et répondre de façon contextualisée. Un moteur de recommandation intégré à votre plateforme e-commerce peut proposer des suggestions personnalisées. Un assistant IA de planification relié à votre agenda peut trouver automatiquement des créneaux de rendez-vous. Ces intégrations favorisent des expériences sans friction qui fidélisent les clients.

Insights à grande échelle : En connectant l’IA à plusieurs sources de données via API, les organisations bâtissent des systèmes analytiques capables de traiter l’information de l’ensemble de l’entreprise. Cette vision unifiée permet des prédictions plus précises, une meilleure détection de tendances et des analyses impossibles avec des données cloisonnées.

Retenez ces bénéfices clés :

Les APIs sont la colonne vertébrale de la plupart des intégrations IA. Pour connecter efficacement l’IA à des outils externes, il faut comprendre leur fonctionnement et savoir comment les solliciter de manière programmatique.

Les APIs modernes existent sous plusieurs formes, chacune avec ses spécificités. Les API REST (Representational State Transfer) sont les plus répandues. Elles utilisent les méthodes HTTP standards (GET, POST, PUT, DELETE) pour opérer sur des ressources identifiées par des URLs. Les APIs REST sont dites stateless, chaque requête contenant toutes les informations nécessaires à son traitement, ce qui les rend simples à comprendre et implémenter.

Les API GraphQL offrent une alternative plus flexible, permettant de demander exactement les données souhaitées plutôt que de recevoir des structures de réponse figées. Cette approche est plus efficace pour les requêtes complexes mais nécessite des clients plus sophistiqués.

Les API SOAP (Simple Object Access Protocol), plus anciennes et basées sur XML, sont encore utilisées dans certains environnements d’entreprise. Plus complexes que REST, elles proposent des fonctionnalités robustes pour l’intégration à grande échelle.

Les API RPC (Remote Procedure Call) permettent d’appeler des fonctions sur des serveurs distants comme si elles étaient locales. Certaines APIs blockchain ou crypto utilisent ce schéma.

Pour la majorité des intégrations IA, vous serez amené à utiliser des APIs REST, qui offrent un excellent compromis entre simplicité et puissance.

Chaque interaction avec une API nécessite une authentification pour vérifier que votre application est autorisée à accéder au service. Comprendre les mécanismes d’authentification est essentiel pour une intégration IA sécurisée.

Les clés API sont la méthode la plus simple. Vous recevez une clé unique lors de l’inscription au service, à inclure dans vos requêtes. Facile à mettre en œuvre, mais limitée : elles n’expirent pas automatiquement et donnent un accès total sans granularité. Adaptées au développement et aux opérations peu sensibles, elles ne suffisent pas seules pour la production.

OAuth 2.0 est la norme pour l’autorisation déléguée. Plutôt que de partager vos identifiants, OAuth permet aux utilisateurs d’autoriser votre application à accéder à leurs données. C’est ce que vous voyez quand une application demande à “accéder à votre compte Google” ou “se connecter à Slack”. Plus complexe à intégrer, mais sécurité et contrôle utilisateur supérieurs.

Bearer Tokens et JWT (JSON Web Tokens) allient la simplicité des clés API à des garanties de sécurité accrues. Les JWT sont signés cryptographiquement et embarquent des claims sur l’utilisateur ou l’application, avec date d’expiration, permissions, etc. Parfaits pour les microservices et systèmes distribués.

TLS mutuel (mTLS) repose sur des certificats côté client et serveur pour une authentification forte. Fréquent dans les environnements d’entreprise et les opérations sensibles.

Interagir avec une API consiste à construire des requêtes HTTP avec les bons headers, paramètres et contenus. Voici un exemple concret d’appel à une API IA :

import requests

import json

# Préparer l’authentification

headers = {

'Authorization': 'Bearer VOTRE_CLE_API',

'Content-Type': 'application/json',

}

# Préparer les données à envoyer

data = {

'model': 'gpt-4',

'messages': [

{

'role': 'user',

'content': 'Analyse ce retour client pour le sentiment'

}

],

'temperature': 0.7,

'max_tokens': 500,

}

# Effectuer l’appel API

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=data

)

# Traiter la réponse

if response.status_code == 200:

result = response.json()

ai_response = result['choices'][0]['message']['content']

print(f"Analyse IA : {ai_response}")

else:

print(f"Erreur : {response.status_code} - {response.text}")

Cet exemple illustre le schéma de base : authentification, construction de la requête, envoi à l’endpoint API, traitement de la réponse. La plupart des intégrations IA suivent ce modèle, même si les paramètres et formats de réponse varient selon le service.

Si les APIs permettent de récupérer les données à la demande, les webhooks assurent une communication push en temps réel. Comprendre l’architecture des webhooks est essentiel pour bâtir des systèmes IA réactifs.

Un webhook est en fait un mécanisme de callback. Vous enregistrez une URL auprès d’un service externe et, lors d’un événement déterminé, ce service envoie une requête HTTP POST à votre URL avec les données de l’événement. Votre application reçoit ces données, les traite et agit en conséquence.

Le flux type est le suivant :

Créer un récepteur de webhook consiste à mettre à disposition un endpoint HTTP capable d’accepter les requêtes POST. Voici un exemple concret avec Flask :

from flask import Flask, request, jsonify

import hmac

import hashlib

import json

app = Flask(__name__)

WEBHOOK_SECRET = 'votre_cle_secrete_webhook'

def verify_webhook_signature(payload, signature):

"""Vérifie que le webhook provient de la bonne source"""

expected_signature = hmac.new(

WEBHOOK_SECRET.encode(),

payload,

hashlib.sha256

).hexdigest()

return hmac.compare_digest(signature, expected_signature)

@app.route('/webhook/payment', methods=['POST'])

def handle_payment_webhook():

# Récupérer la charge brute pour vérifier la signature

payload = request.get_data()

signature = request.headers.get('X-Signature')

# Vérifier l’authenticité du webhook

if not verify_webhook_signature(payload, signature):

return jsonify({'error': 'Signature invalide'}), 401

# Parser les données JSON

data = request.json

# Traiter l’événement du webhook

try:

if data['event_type'] == 'payment.completed':

# Lancer l’analyse IA de la transaction

analyze_transaction(data['transaction_id'], data['amount'])

# Mettre à jour la base

update_payment_status(data['transaction_id'], 'completed')

# Envoyer une confirmation

send_confirmation_email(data['customer_email'])

# Toujours renvoyer 200 pour accuser réception

return jsonify({'status': 'received'}), 200

except Exception as e:

# Logger l’erreur mais renvoyer 200 pour éviter les retries

log_error(f"Erreur traitement webhook : {str(e)}")

return jsonify({'status': 'received'}), 200

if __name__ == '__main__':

app.run(port=5000)

Cet exemple montre plusieurs bonnes pratiques : vérification de signature, gestion correcte des erreurs et réponse systématique de succès pour éviter les relances du fournisseur.

Les webhooks introduisent des risques spécifiques puisque des services externes envoient des données à votre application. Plusieurs mesures de sécurité sont essentielles :

Vérification de signature : La plupart des fournisseurs intègrent une signature dans les headers, calculée avec un secret partagé. Vérifiez toujours cette signature pour garantir l’authenticité et l’intégrité du webhook.

HTTPS obligatoire : Utilisez toujours HTTPS pour vos endpoints webhooks. Cela chiffre les données en transit et empêche les attaques de type man-in-the-middle.

Whitelisting d’IP : Si possible, limitez les adresses IP autorisées à envoyer des requêtes sur votre endpoint.

Limitation de débit : Implementez un rate limiting pour éviter tout abus ou flood involontaire.

Idempotence : Vos gestionnaires de webhook doivent être idempotents : traiter plusieurs fois le même webhook doit donner le même résultat. Les fournisseurs peuvent relancer la livraison en cas d’échec.

Maintenant que les fondamentaux sont posés, voyons comment intégrer concrètement les modèles IA à des services externes. C’est ici que la puissance de l’intégration IA prend tout son sens.

Le paysage IA regorge d’options, chacune avec ses capacités, modèles de tarification et modalités d’intégration. L’API d’OpenAI permet d’accéder à GPT-4, GPT-3.5 et d’autres modèles pour le traitement du langage, la génération de code, la logique. Google Cloud AI propose Vertex AI, Document AI, Vision AI. AWS fournit SageMaker et divers services IA préconstruits. Claude API d’Anthropic mise sur la sécurité et l’interprétabilité. Hugging Face propose des modèles open source et un hub de modèles.

Votre choix dépendra des capacités IA nécessaires, du budget, de la latence, de la confidentialité des données et de votre préférence entre service managé ou auto-hébergé.

Un pipeline d’intégration IA type comprend : collecte de données via API, prétraitement, inférence par le modèle IA, traitement des résultats et déclenchement d’actions. Voici un exemple concret :

import requests

import json

from datetime import datetime

import logging

class AIIntegrationPipeline:

def __init__(self, ai_api_key, crm_api_key):

self.ai_api_key = ai_api_key

self.crm_api_key = crm_api_key

self.logger = logging.getLogger(__name__)

def fetch_customer_data(self, customer_id):

"""Récupère les données client via l’API CRM"""

headers = {'Authorization': f'Bearer {self.crm_api_key}'}

response = requests.get(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers

)

return response.json()

def analyze_with_ai(self, text_content):

"""Envoie un contenu à l’API IA pour analyse"""

headers = {

'Authorization': f'Bearer {self.ai_api_key}',

'Content-Type': 'application/json'

}

payload = {

'model': 'gpt-4',

'messages': [

{

'role': 'system',

'content': 'Vous êtes un analyste du service client. Analysez l’interaction suivante et fournissez des insights.'

},

{

'role': 'user',

'content': text_content

}

],

'temperature': 0.5,

'max_tokens': 1000

}

response = requests.post(

'https://api.openai.com/v1/chat/completions',

headers=headers,

json=payload

)

if response.status_code == 200:

return response.json()['choices'][0]['message']['content']

else:

self.logger.error(f"Erreur API IA : {response.status_code}")

raise Exception("Échec de l’analyse IA")

def update_crm_with_insights(self, customer_id, insights):

"""Met à jour le CRM avec les insights IA"""

headers = {

'Authorization': f'Bearer {self.crm_api_key}',

'Content-Type': 'application/json'

}

payload = {

'ai_insights': insights,

'last_analyzed': datetime.now().isoformat(),

'analysis_status': 'completed'

}

response = requests.put(

f'https://api.crm.example.com/customers/{customer_id}',

headers=headers,

json=payload

)

return response.status_code == 200

def process_customer(self, customer_id):

"""Pipeline complet : récupération, analyse, mise à jour"""

try:

# Récupérer les données client

customer_data = self.fetch_customer_data(customer_id)

# Préparer le contenu pour l’analyse IA

content_to_analyze = f"""

Client : {customer_data['name']}

Interactions récentes : {customer_data['recent_interactions']}

Historique d’achats : {customer_data['purchase_history']}

"""

# Obtenir l’analyse IA

insights = self.analyze_with_ai(content_to_analyze)

# Mettre à jour le CRM avec les insights

success = self.update_crm_with_insights(customer_id, insights)

if success:

self.logger.info(f"Client {customer_id} traité avec succès")

return {'status': 'success', 'insights': insights}

else:

self.logger.error(f"Échec de la mise à jour CRM pour le client {customer_id}")

return {'status': 'error', 'message': 'Échec de la mise à jour CRM'}

except Exception as e:

self.logger.error(f"Erreur pipeline : {str(e)}")

return {'status': 'error', 'message': str(e)}

Cet exemple montre un pipeline complet qui extrait des données d’un CRM, les envoie à un modèle IA pour analyse, puis met à jour le CRM avec les résultats. Ce schéma est adaptable à de nombreux scénarios métier.

Selon le scénario, il existe différentes architectures d’intégration. Comprendre leurs avantages et inconvénients aide à choisir la bonne stratégie.

| Approche | Idéal pour | Avantages | Inconvénients | Latence |

|---|---|---|---|---|

| Appels API synchrones | Opérations temps réel, interfaces utilisateur | Simple, retour immédiat, facile à déboguer | Plus lent si le modèle IA est lent, bloque l’exécution | Basse à moyenne |

| Asynchrone avec webhooks | Workflows événementiels, traitement volumique | Non bloquant, scalable, réactif | Plus complexe, cohérence éventuelle | Moyenne à élevée |

| Queues de messages | Systèmes découplés, batch | Livraison fiable, équilibrage de charge, retries | Infrastructure additionnelle, cohérence éventuelle | Moyenne à élevée |

| Tâches planifiées | Analyses périodiques, batch | Simple, usage prévisible des ressources | Pas temps réel, délais sur événements urgents | Élevée |

| Intégration streaming | Données temps réel, analyse continue | Insights immédiats, gestion gros volume | Infrastructure complexe, outils spécialisés | Très basse |

Chaque approche a sa place. Un support client utilisera des appels synchrones pour le chatbot, mais du traitement asynchrone pour l’analyse de sentiment approfondie. Une plateforme e-commerce déclenchera des webhooks sur commande, mais analysera les stocks la nuit via des jobs planifiés.

Gérer à la main de multiples APIs et webhooks devient vite complexe à mesure que votre système grandit. C’est là que FlowHunt révolutionne votre stratégie d’intégration.

FlowHunt est une plateforme complète d’automatisation des workflows pensée pour les intégrations alimentées par l’IA. Plutôt que de développer et maintenir du code d’intégration personnalisé, FlowHunt offre une interface visuelle pour connecter modèles IA, outils externes, gérer l’authentification, les erreurs et surveiller les performances.

Constructeur de workflow visuel : Concevez des workflows complexes sans coder. Connectez modèles IA, APIs et webhooks via une interface glisser-déposer intuitive. FlowHunt gère les requêtes HTTP, l’authentification et la transformation des données.

Connecteurs préconstruits : FlowHunt inclut des connecteurs vers les principaux services IA (OpenAI, Google Cloud AI, Anthropic) et des centaines d’outils externes (Salesforce, HubSpot, Slack, Stripe…). Ils gèrent l’authentification et les spécificités API pour vous concentrer sur la logique métier.

Gestion des webhooks : FlowHunt simplifie l’enregistrement et la gestion des webhooks. Recevez des événements, déclenchez l’analyse IA, tout depuis l’interface FlowHunt. Plus besoin de maintenir de récepteurs maison.

Gestion des erreurs et retries : Retry automatique des appels API échoués avec backoff exponentiel. Notifications d’erreur et workflows de secours. FlowHunt garantit la résilience des intégrations.

Transformation des données : Convertissez les données entre formats/structures. Mappez les champs CRM vers les entrées IA, adaptez les sorties IA au format attendu par vos outils.

Supervision et logs : Suivez chaque appel API, événement webhook, exécution de workflow. Identifiez les goulots d’étranglement, déboguez, optimisez grâce à des logs et analytics complets.

Gestion du taux de requêtes : FlowHunt gère automatiquement les limites de débit, en file d’attente et distribuant les appels API pour rester dans les quotas.

Imaginons que vous souhaitiez analyser automatiquement les retours clients de votre support, catégoriser le sentiment et mettre à jour votre CRM. Dans FlowHunt, ce workflow ressemblerait à :

Un tel workflow nécessiterait des dizaines de lignes de code et de la gestion d’erreurs dans une solution sur mesure, mais devient visuel et modifiable à volonté dans FlowHunt.

À mesure que vos besoins IA se complexifient, quelques bonnes pratiques et patterns avancés deviennent essentiels.

La plupart des APIs limitent le nombre de requêtes par minute/heure. Depasser ces limites entraîne erreurs et suspension de service. Une bonne gestion des quotas est vitale.

Implémentez un backoff exponentiel : en cas de dépassement, attendez avant de réessayer, en augmentant progressivement l’intervalle. Les réponses API contiennent généralement les infos de limite dans les headers.

import time

import requests

def call_api_with_backoff(url, headers, data, max_retries=5):

"""Appeler une API avec backoff exponentiel pour la limitation de débit"""

for attempt in range(max_retries):

try:

response = requests.post(url, headers=headers, json=data)

# Vérifier si on a été limité

if response.status_code == 429:

# Extraire le header retry-after si dispo

retry_after = int(response.headers.get('Retry-After', 2 ** attempt))

print(f"Limite atteinte. Attente de {retry_after} secondes...")

time.sleep(retry_after)

continue

# Vérifier autres erreurs

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if attempt == max_retries - 1:

raise

wait_time = 2 ** attempt

print(f"Échec de la requête : {e}. Nouvelle tentative dans {wait_time} secondes...")

time.sleep(wait_time)

raise Exception("Nombre maximal de tentatives dépassé")

Certaines opérations IA sont longues. Plutôt que de bloquer l’application, adoptez un schéma asynchrone où le service IA retourne un ID de tâche, à interroger ou à notifier via webhook quand le traitement est terminé.

def submit_async_ai_job(content):

"""Soumettre du contenu pour un traitement IA asynchrone"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.post(

'https://api.ai.example.com/async-analyze',

headers=headers,

json={'content': content}

)

job_data = response.json()

return job_data['job_id']

def check_job_status(job_id):

"""Vérifier le statut d’une tâche asynchrone"""

headers = {'Authorization': f'Bearer {AI_API_KEY}'}

response = requests.get(

f'https://api.ai.example.com/jobs/{job_id}',

headers=headers

)

job_data = response.json()

if job_data['status'] == 'completed':

return {'status': 'completed', 'result': job_data['result']}

elif job_data['status'] == 'failed':

return {'status': 'failed', 'error': job_data['error']}

else:

return {'status': 'processing'}

Appeler les APIs IA plusieurs fois pour les mêmes entrées gaspille des ressources et coûte cher. Implémentez un cache pour stocker les résultats des requêtes fréquentes.

import hashlib

import json

from functools import wraps

import redis

# Connexion au cache Redis

cache = redis.Redis(host='localhost', port=6379, db=0)

def cache_ai_result(ttl=3600):

"""Décorateur pour cacher les résultats IA"""

def decorator(func):

@wraps(func)

def wrapper(content, *args, **kwargs):

# Clé cache via hash du contenu

content_hash = hashlib.md5(content.encode()).hexdigest()

cache_key = f"ai_result:{content_hash}"

# Vérifier le cache

cached_result = cache.get(cache_key)

if cached_result:

return json.loads(cached_result)

# Appeler l’API IA

result = func(content, *args, **kwargs)

# Stocker dans le cache

cache.setex(cache_key, ttl, json.dumps(result))

return result

return wrapper

return decorator

@cache_ai_result(ttl=86400) # Cache 24h

def analyze_sentiment(text):

"""Analyse de sentiment avec cache"""

# Appel API IA ici

pass

Une intégration en production exige une supervision complète. Suivez les temps de réponse, taux d’erreur, succès des livraisons webhook. Déclenchez des alertes en cas d’anomalie.

import logging

from datetime import datetime

import json

class IntegrationMonitor:

def __init__(self, log_file='integration.log'):

self.logger = logging.getLogger(__name__)

handler = logging.FileHandler(log_file)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

handler.setFormatter(formatter)

self.logger.addHandler(handler)

def log_api_call(self, service, endpoint, status_code, response_time, error=None):

"""Logguer les métriques d’appel API"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'service': service,

'endpoint': endpoint,

'status_code': status_code,

'response_time_ms': response_time,

'error': error

}

self.logger.info(json.dumps(log_entry))

def log_webhook_event(self, event_type, source, success, processing_time):

"""Logguer un événement webhook"""

log_entry = {

'timestamp': datetime.now().isoformat(),

'event_type': event_type,

'source': source,

'success': success,

'processing_time_ms': processing_time

}

self.logger.info(json.dumps(log_entry))

Voyons un cas concret d’application de ces concepts en entreprise.

Le défi : Une société e-commerce souhaitait améliorer l’expérience client par la personnalisation des recommandations, la catégorisation automatique des avis et la détection de fraudes. Elle disposait d’une boutique Shopify, d’une plateforme d’avis maison, d’un processeur de paiement et d’une base client. Ces systèmes ne communiquaient pas efficacement, et l’analyse manuelle était chronophage.

La solution : Ils ont bâti un système IA intégré via APIs et webhooks :

Résultats : Hausse de 23 % du panier moyen grâce aux recommandations, réduction de 85 % du temps d’analyse d’avis, baisse de 67 % des fraudes. Le système traite des milliers d’événements/jour avec 99,9 % de disponibilité.

Technologies clés : API Shopify, webhooks personnalisés, API OpenAI pour le NLP, modèle anti-fraude sur AWS, Redis pour le cache, logs détaillés pour la supervision.

Ce cas montre comment une intégration IA bien pensée via API et webhook crée une vraie valeur business.

Intégrer l’IA avec des outils externes via API et webhooks n’est plus un luxe mais une nécessité pour rester compétitif. Connecter les capacités IA à vos systèmes, automatiser les workflows et réagir en temps réel révolutionne l’organisation.

La réussite passe par la compréhension des fondamentaux : fonctionnement des APIs, communication en temps réel via webhooks, sécurité de l’authentification, gestion élégante des erreurs. Au-delà, les schémas avancés comme l’asynchrone, le caching, la supervision garantissent fiabilité et performance à l’échelle.

Que vous en soyez à votre première intégration IA ou à l’architecture de systèmes complexes, les principes de ce guide vous offrent une base solide. Partez d’un besoin clair, choisissez les bons patterns, implémentez une gestion d’erreurs robuste, monitorer tout. À mesure que vos besoins grandissent, des plateformes comme FlowHunt vous aident à gérer la complexité sans sacrifier la flexibilité.

L’avenir appartient aux organisations capables de fusionner l’intelligence de l’IA à leurs systèmes opérationnels. En maîtrisant l’intégration API et webhook, vous préparez votre entreprise à exploiter tout le potentiel transformateur de l’IA sans compromettre fiabilité ni sécurité.

Experience how FlowHunt automates your AI integrations with external tools — from API management and webhook handling to error recovery and monitoring — all in one unified platform.

Les APIs sont des systèmes basés sur le modèle pull où vous demandez des données à un service externe, tandis que les webhooks sont des systèmes push où les services externes envoient des données à votre application lorsque des événements spécifiques se produisent. Les APIs sont idéales pour la récupération de données à la demande, alors que les webhooks excellent pour les notifications d’événements en temps réel.

Stockez les clés API dans des variables d’environnement, utilisez des outils de gestion de secrets dédiés comme HashiCorp Vault ou AWS Secrets Manager, ne commettez jamais les clés dans le contrôle de version, faites une rotation régulière des clés et appliquez le principe du moindre privilège en limitant les permissions des clés aux opérations strictement nécessaires.

Les méthodes d’authentification courantes incluent les clés API (basées sur un simple jeton), OAuth 2.0 (autorisation déléguée), les Bearer tokens (basés sur JWT) et le TLS mutuel (basé sur certificat). Le choix dépend des exigences de sécurité du fournisseur d’API et des besoins de votre application.

Implémentez des stratégies de retry avec backoff exponentiel, surveillez les en-têtes de limitation de débit dans les réponses API, utilisez des systèmes de files d’attente de requêtes, mettez en cache les réponses quand c’est possible et envisagez de passer à des plans API plus élevés si vous atteignez souvent la limite. De nombreuses bibliothèques proposent des mécanismes de retry intégrés.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

FlowHunt simplifie l’intégration de l’IA avec des outils externes, en automatisant les appels API, la gestion des webhooks et le traitement des données sur une seule plateforme unifiée.

Intégrez FlowHunt avec Webflow MCP pour automatiser la gestion de votre site et de votre CMS, mettre à jour le contenu et orchestrer des workflows intelligents ...

Découvrez comment intégrer le logiciel de comptabilité Bexio avec Claude AI en utilisant le serveur MCP de FlowHunt. Automatisez la gestion des contacts, la cré...

Intégrez WayStation de FlowHunt à vos outils de productivité préférés et aux principaux clients IA pour une automatisation fluide, sécurisée et sans code. Conne...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.