Agents IA : Comprendre la logique de Llama 3.2 3B

Découvrez les capacités avancées de l’agent IA Llama 3.2 3B. Cette analyse approfondie révèle comment il va au-delà de la génération de texte, en mettant en ava...

Une analyse approfondie du modèle de raisonnement EXAONE Deep 32B de LG, testé face à DeepSeek R1 et QwQ d’Alibaba, examinant les affirmations de performance supérieure et les capacités réelles de raisonnement.

Le paysage des modèles d’intelligence artificielle pour le raisonnement est devenu de plus en plus concurrentiel, plusieurs organisations revendiquant des percées sur des tâches complexes de raisonnement mathématique et logique. La sortie récente par LG d’EXAONE Deep, un modèle de raisonnement de 32 milliards de paramètres, a attiré l’attention avec des affirmations de surperformance face à des concurrents établis comme DeepSeek R1. Pourtant, des tests en conditions réelles révèlent une réalité plus nuancée que celle suggérée par le marketing. Cet article propose une analyse approfondie des performances réelles d’EXAONE Deep par rapport à d’autres modèles de raisonnement leaders, en examinant l’écart entre les benchmarks annoncés et le fonctionnement pratique. À travers des tests concrets et une comparaison détaillée, nous explorerons ce que ces modèles peuvent réellement accomplir, comment ils gèrent des tâches de raisonnement complexes, et ce que cela implique pour les organisations envisageant d’utiliser ces outils en production.

L’émergence des modèles de raisonnement représente un changement fondamental dans la manière dont l’IA aborde la résolution de problèmes complexes. Contrairement aux modèles de langage traditionnels qui génèrent des réponses en un seul passage, les modèles de raisonnement utilisent une technique appelée décodage à l’inférence, allouant d’importantes ressources informatiques pour réfléchir étape par étape. Cette approche mime le raisonnement humain, où nous devons souvent examiner un problème sous plusieurs angles avant d’arriver à une solution. Le concept a gagné en importance avec le modèle o1 d’OpenAI et a été adopté depuis par plusieurs organisations, dont DeepSeek, Alibaba, et désormais LG. Ces modèles produisent ce qu’on appelle une séquence de tokens de « réflexion » ou de « raisonnement » que l’utilisateur ne voit généralement pas dans la sortie finale, mais qui représentent le processus de délibération interne du modèle. Ces tokens de réflexion sont cruciaux car ils permettent au modèle d’explorer différentes pistes, de corriger des erreurs et d’affiner son approche avant de s’engager sur une réponse finale. Cela s’avère particulièrement utile pour les problèmes mathématiques, les tâches de raisonnement logique et les scénarios complexes à étapes multiples, où un seul passage risque de manquer des détails importants ou de conduire à des conclusions erronées.

Pour les organisations qui mettent en œuvre des systèmes IA, les modèles de raisonnement représentent une avancée majeure en fiabilité et précision pour les tâches complexes. Les modèles de langage traditionnels ont souvent des difficultés avec les problèmes mathématiques à étapes multiples, la déduction logique, et les scénarios nécessitant une analyse rigoureuse des contraintes et conditions. Les modèles de raisonnement répondent à ces limites en explicitant leur démarche, ce qui apporte également la transparence nécessaire pour comprendre comment le modèle est arrivé à sa conclusion. Cette transparence est particulièrement importante en entreprise, où les décisions basées sur les recommandations IA doivent être auditables et explicables. Le revers de la médaille, cependant, est le coût computationnel et la latence. Parce que les modèles de raisonnement génèrent de nombreux tokens de réflexion avant de produire une réponse finale, ils requièrent plus de puissance de calcul et répondent plus lentement que les modèles de langage classiques. Cela rend le choix du modèle crucial : les organisations doivent comprendre non seulement les scores de benchmark mais aussi les performances réelles sur leurs cas d’usage. La prolifération de modèles de raisonnement de différents fournisseurs, chacun revendiquant la supériorité, rend les tests et comparaisons indépendants essentiels pour prendre des décisions éclairées.

L’arrivée de LG sur le marché des modèles de raisonnement avec EXAONE Deep a suscité un vif intérêt, compte tenu des capacités de recherche de l’entreprise et de la taille relativement modeste du modèle (32 milliards de paramètres). Les supports marketing de LG présentent des résultats impressionnants, affirmant qu’EXAONE Deep atteint 90 % de précision sur la compétition AIME (American Invitational Mathematics Examination) avec seulement 64 essais, et 95 % sur les problèmes MATH-500. Si ces chiffres sont avérés, ils placeraient EXAONE Deep au niveau des performances de DeepSeek R1 et QwQ d’Alibaba. La société a également publié plusieurs versions du modèle, dont une variante de 2,4 milliards de paramètres conçue pour servir de modèle ébauche en décodage spéculatif — une technique où des modèles plus petits prédisent les tokens que le modèle principal générera, accélérant potentiellement l’inférence. Cependant, soumis à des tests pratiques sur des problèmes de raisonnement standards, EXAONE Deep a montré des comportements préoccupants qui contredisent les benchmarks annoncés. Le modèle avait tendance à entrer dans des boucles de réflexion prolongée sans parvenir à des conclusions logiques, générant des milliers de tokens répétitifs ou incohérents plutôt qu’un raisonnement productif. Ce comportement suggère des problèmes potentiels dans l’entraînement du modèle, la méthodologie d’évaluation, ou la gestion de certains types de prompts.

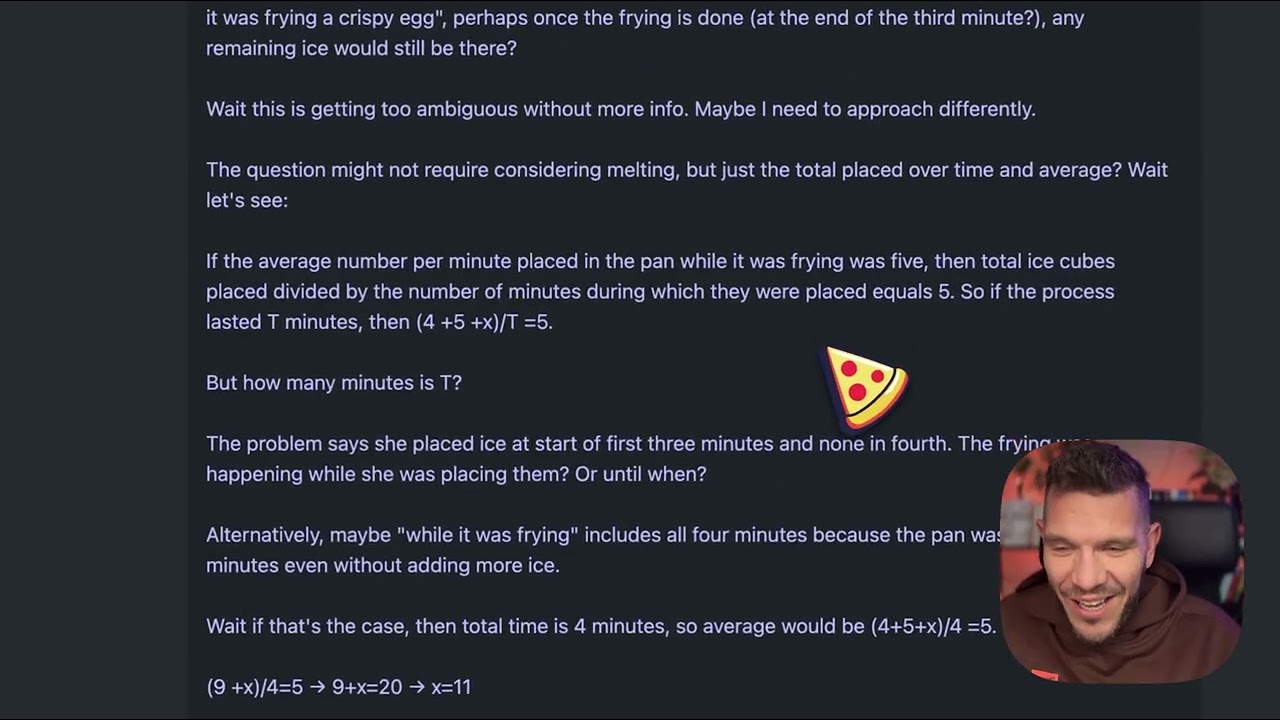

Pour comprendre concrètement les différences entre modèles de raisonnement, prenons un problème apparemment simple devenu un standard pour évaluer leur qualité : « Beth place des glaçons entiers dans un plat. Après une minute, il y a 20 glaçons. Après deux minutes, il y en a 10. Après trois minutes, il y en a 0. Combien de glaçons entiers reste-t-il dans le plat à la fin de la troisième minute ? » La bonne réponse est zéro, car la question porte explicitement sur les glaçons entiers à la fin de la troisième minute, et l’énoncé indique qu’il n’y en a plus. Mais ce problème est conçu pour piéger les modèles qui sur-analysent ou se perdent dans la narration de fonte des glaçons. Certains modèles pourraient chercher à calculer les taux de fonte et s’éloigner de la réponse évidente. Lorsqu’EXAONE Deep a été testé sur ce problème, il a généré environ 5 000 tokens de réflexion sans arriver à une conclusion cohérente. Son processus de raisonnement a rapidement déraillé, le texte généré devenant incohérent et ne montrant aucune résolution logique. Les fragments produits n’étaient pas des pensées complètes, et le modèle n’a jamais explicitement énoncé une démarche ou une réponse finale. Cette performance contraste fortement avec la manière dont le problème devrait être traité : un modèle de raisonnement devrait reconnaître le piège, dérouler le raisonnement clairement, et arriver à la réponse efficacement.

Quand le même problème du glaçon a été soumis à DeepSeek R1 et au modèle QwQ d’Alibaba, tous deux ont montré de bien meilleures performances. DeepSeek R1 a produit un raisonnement clair, traité le problème méthodiquement, et trouvé la bonne réponse (zéro). Le raisonnement du modèle était transparent et logique, montrant comment il a analysé la question, reconnu le piège, puis donné la bonne réponse. QwQ a également bien performé, générant aussi un processus de réflexion détaillé. Fait intéressant, QwQ s’est d’abord interrogé sur la physique ou les mathématiques du problème, avant de conclure correctement. La différence clé est que ces deux modèles ont fait preuve de cohérence dans leur raisonnement, même en explorant plusieurs pistes. Ils savaient reconnaître quand ils disposaient d’informations suffisantes pour répondre et s’y tenir. EXAONE Deep, en revanche, n’a jamais atteint ce stade. Il continuait à générer des tokens sans but apparent, sans jamais s’arrêter ni montrer une progression logique. Cela suggère des problèmes fondamentaux dans la façon dont le modèle gère les tâches de raisonnement, malgré les promesses affichées.

Un aspect technique intéressant de la sortie d’EXAONE Deep est l’inclusion de plusieurs tailles de modèles conçues pour fonctionner ensemble via le décodage spéculatif. La version à 2,4 milliards de paramètres peut servir de modèle ébauche, prédisant les tokens que le modèle principal à 32 milliards de paramètres générera. Lorsque les prédictions du modèle ébauche correspondent à la sortie du modèle principal, le système peut sauter le calcul principal et utiliser la prédiction, accélérant ainsi l’inférence. C’est une technique d’optimisation sophistiquée qui peut réduire la latence et la consommation de ressources. Lors des tests, l’implémentation du décodage spéculatif montrait des tokens verts indiquant le succès des prédictions, preuve que la technique fonctionnait comme prévu. Cependant, cette optimisation n’adresse pas le problème fondamental de la qualité du raisonnement du modèle principal. Une inférence rapide mais de faible qualité reste un mauvais raisonnement. La présence de cette optimisation soulève aussi des questions : les résultats de benchmark de LG ont-ils été obtenus avec des configurations ou techniques qui ne se traduisent pas dans les usages réels ?

Pour les organisations confrontées à l’évaluation de plusieurs modèles IA, FlowHunt propose une plateforme d’automatisation complète, facilitant le test et le benchmarking. Plutôt que de tester manuellement différents modèles et de comparer les résultats, FlowHunt permet aux équipes de mettre en place des workflows automatisés pour évaluer systématiquement la performance sur plusieurs dimensions. Ceci est particulièrement précieux pour comparer des modèles de raisonnement, dont les performances varient selon le type de problème, la complexité, ou le prompt utilisé. Les capacités d’automatisation de FlowHunt permettent de tester les modèles sur des jeux de problèmes standardisés, de suivre les métriques dans le temps, et de générer des rapports comparatifs. La plateforme s’intègre à divers fournisseurs de modèles et APIs, rendant possible l’évaluation de modèles provenant de différents éditeurs dans un même workflow. Pour les équipes qui envisagent le déploiement de modèles comme EXAONE Deep, DeepSeek R1 ou QwQ, FlowHunt fournit l’infrastructure nécessaire pour prendre des décisions fondées sur des performances réelles et non sur les promesses. L’automatisation des tests répétitifs libère également des ressources ingénierie pour se concentrer sur l’intégration et l’optimisation, plutôt que sur le benchmarking manuel.

L’écart entre la performance annoncée d’EXAONE Deep et son comportement réel souligne une leçon clé pour l’adoption de l’IA : les benchmarks fournisseurs doivent toujours être vérifiés par des tests indépendants. Les résultats de benchmark peuvent être influencés par de nombreux facteurs : jeu de test utilisé, méthodologie d’évaluation, configuration matérielle, paramètres d’inférence… Un modèle peut bien performer sur un benchmark donné et échouer sur d’autres types de problèmes ou des scénarios réels. C’est pourquoi des acteurs comme Weights & Biases et des chercheurs indépendants jouent un rôle crucial : ils offrent des analyses impartiales qui aident la communauté à comprendre les véritables capacités des modèles. Lors de l’évaluation de modèles de raisonnement pour la production, les organisations doivent effectuer leurs propres tests sur des jeux de problèmes représentatifs de leur domaine. Un modèle très performant en mathématiques peut échouer en déduction logique ou en génération de code. Le problème du glaçon, bien que simple, sert de test diagnostic utile car il révèle si un modèle sait gérer les questions pièges sans sur-analyser. Les modèles qui échouent sur ce type de problème risquent d’avoir des difficultés sur des tâches plus complexes.

Les boucles de réflexion prolongée observées lors des tests d’EXAONE Deep peuvent venir de plusieurs problèmes. Une première possibilité est que le processus d’entraînement n’a pas appris au modèle quand s’arrêter et donner une réponse. Les modèles de raisonnement nécessitent un calibrage fin pour équilibrer les bénéfices d’une réflexion étendue et les risques de sur-analyse et de génération de tokens inutiles. Si la phase d’entraînement manque d’exemples de situations où il faut s’arrêter, le modèle peut se contenter de générer des tokens jusqu’à atteindre une limite. Une autre possibilité est un souci dans la gestion des prompts, notamment dans l’interprétation de certains types de questions ou d’instructions. Certains modèles sont sensibles à la formulation des prompts et peuvent se comporter différemment selon la manière dont une question est posée. Le fait qu’EXAONE Deep produise des séquences de tokens incohérentes suggère que le modèle peut entrer dans un état où il génère des tokens sans contenu sémantique, ce qui peut indiquer des problèmes d’attention ou de logique de prédiction. Enfin, la méthodologie d’évaluation des benchmarks a peut-être utilisé des configurations ou des stratégies de prompting différentes de celles des tests réels, d’où l’écart entre performance annoncée et réelle.

Les problèmes de performance rencontrés avec EXAONE Deep ont des implications plus larges pour le marché des modèles de raisonnement. À mesure que de nouveaux modèles apparaissent, le risque est de voir un marché saturé de modèles affichant des benchmarks spectaculaires mais aux performances réelles douteuses. Cela complique la tâche des organisations qui doivent choisir un modèle pour la production. La solution passe par une insistance accrue sur les tests indépendants, des méthodologies d’évaluation standardisées, et une transparence sur les limites des modèles. Le secteur bénéficierait de normes industrielles pour l’évaluation et la comparaison, à l’image de ce qui existe pour d’autres benchmarks IA. Les organisations doivent aussi se méfier des modèles qui revendiquent de dépasser largement la concurrence, surtout si cet écart paraît incompatible avec l’architecture ou le processus d’entraînement. DeepSeek R1 et QwQ ont montré une performance constante dans différents scénarios, ce qui inspire confiance. L’inconstance d’EXAONE Deep — benchmarks excellents mais résultats pratiques médiocres — suggère soit des problèmes dans le modèle, soit dans la façon dont les benchmarks ont été réalisés.

Découvrez comment FlowHunt automatise vos workflows IA et SEO — de la recherche et génération de contenu jusqu’à la publication et l’analyse — tout-en-un.

Les organisations qui envisagent de déployer des modèles de raisonnement doivent suivre un processus d’évaluation structuré. Premièrement, constituez un jeu de tests représentatif incluant des problèmes de votre domaine ou cas d’usage spécifique. Les benchmarks génériques ne reflètent pas toujours la performance sur vos problèmes réels. Deuxièmement, testez plusieurs modèles sur les mêmes problèmes pour permettre une comparaison directe. Cela implique de standardiser l’environnement de test : matériel, paramètres d’inférence et formulation des prompts. Troisièmement, évaluez non seulement la précision mais aussi l’efficacité : latence, nombre de tokens générés… Un modèle qui donne la bonne réponse mais nécessite 10 000 tokens de réflexion risque de ne pas être viable en production si vous exigez une réponse temps-réel. Quatrièmement, examinez le processus de raisonnement du modèle, pas seulement la réponse finale. Un modèle qui aboutit à la bonne réponse via un raisonnement erroné risque d’échouer sur des variantes du même problème. Cinquièmement, testez les cas limites et les questions pièges afin de comprendre comment le modèle gère les scénarios conçus pour le dérouter. Enfin, prenez en compte le coût total d’acquisition : licence ou coût API, ressources pour l’inférence, et effort d’ingénierie pour l’intégration.

La taille de 32 milliards de paramètres d’EXAONE Deep est inférieure à celle de certains concurrents, ce qui pose la question de savoir si les problèmes observés sont dus à une capacité insuffisante. Cependant, la taille seule ne fait pas le raisonnement. QwQ, qui opère dans la même gamme de paramètres, démontre de bonnes capacités de raisonnement. Cela suggère que les difficultés d’EXAONE Deep tiennent plus à la méthodologie d’entraînement, à l’architecture ou à la configuration d’inférence qu’à une limite fondamentale de taille. L’inclusion d’un modèle ébauche à 2,4 milliards de paramètres dans l’offre EXAONE Deep montre que LG réfléchit à l’efficacité, ce qui est louable. Mais l’efficacité n’a d’intérêt que si le modèle sous-jacent produit des résultats corrects. Une réponse fausse rapide est pire qu’une bonne réponse lente dans la plupart des cas de production. Le marché des modèles de raisonnement mettra probablement de plus en plus l’accent sur l’efficacité, mais cette optimisation ne doit pas se faire au détriment de la qualité du raisonnement.

Le domaine des modèles de raisonnement n’en est qu’à ses débuts, et l’on peut s’attendre à une évolution rapide dans les mois et années à venir. À mesure que de nouveaux modèles sortent et que les tests indépendants se multiplient, le marché va probablement se consolider autour de modèles affichant des performances fiables et cohérentes. Des organisations comme DeepSeek et Alibaba ont établi leur crédibilité grâce à cette constance, tandis que de nouveaux entrants comme LG devront corriger les problèmes de performance identifiés pour espérer s’imposer. On peut aussi s’attendre à de l’innovation dans les modes d’entraînement et d’évaluation. L’approche actuelle, qui consiste à générer de nombreux tokens de réflexion, est efficace mais coûteuse en calcul. Les modèles futurs pourraient développer des mécanismes de raisonnement plus efficaces, atteignant une précision similaire avec moins de tokens. On verra aussi sans doute une spécialisation accrue, avec des modèles optimisés pour les mathématiques, la génération de code ou le raisonnement logique. L’intégration des modèles de raisonnement avec d’autres techniques IA, comme la génération augmentée par récupération ou l’utilisation d’outils, élargira également leurs capacités et leurs usages.

EXAONE Deep de LG représente une entrée ambitieuse sur le marché des modèles de raisonnement, mais les tests en conditions réelles révèlent un écart important entre les performances annoncées et les capacités effectives. Bien que les benchmarks laissent entrevoir une concurrence avec DeepSeek R1 et QwQ d’Alibaba, les tests pratiques sur des problèmes standards montrent qu’EXAONE Deep peine sur des tâches de base, générant trop de tokens sans parvenir à des conclusions cohérentes. DeepSeek R1 et QwQ ont tous deux montré de meilleures performances sur les mêmes problèmes, arrivant à des réponses correctes par des raisonnements clairs et logiques. Pour les organisations évaluant des modèles de raisonnement pour la production, cette analyse rappelle l’importance cruciale des tests et de la vérification indépendants. Les benchmarks fournisseurs doivent servir de point de départ, non de mesure définitive des capacités. Le marché bénéficiera d’une transparence accrue, de méthodologies d’évaluation standardisées, et de tests indépendants continus par la communauté de recherche. À mesure que la technologie mûrit, les organisations qui investiront dans une évaluation rigoureuse et des comparaisons objectives sauront sélectionner et déployer les modèles de raisonnement offrant une réelle valeur pour leurs besoins spécifiques.

EXAONE Deep est un modèle de raisonnement de 32 milliards de paramètres développé par LG, qui utilise le décodage à l’inférence pour résoudre des problèmes complexes. Contrairement aux modèles de langage standard, il alloue des ressources informatiques lors de l’inférence pour réfléchir étape par étape, à l’image de DeepSeek R1 et QwQ d’Alibaba.

Lors de tests pratiques sur des tâches de raisonnement comme le problème du glaçon, EXAONE Deep a montré d’importants problèmes de sur-réflexion et générait un trop grand nombre de tokens sans parvenir à une conclusion logique. DeepSeek R1 et QwQ ont tous deux obtenu de meilleurs résultats, trouvant la réponse correcte plus efficacement.

Le décodage à l’inférence est une technique permettant aux modèles IA d’allouer plus de ressources de calcul lors de l’inférence pour raisonner sur des problèmes complexes. Cela permet aux modèles de montrer leur processus de réflexion et d’arriver à des réponses plus précises, bien que cela exige un calibrage minutieux pour éviter la sur-réflexion.

FlowHunt automatise le workflow de test, comparaison et évaluation de plusieurs modèles IA, permettant aux équipes de benchmarker systématiquement les performances, de suivre les métriques et de prendre des décisions éclairées sur les modèles à déployer selon les cas d’usage.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

Utilisez FlowHunt pour rationaliser vos flux de tests, de comparaison et de suivi de performances des modèles IA grâce à une automatisation intelligente.

Découvrez les capacités avancées de l’agent IA Llama 3.2 3B. Cette analyse approfondie révèle comment il va au-delà de la génération de texte, en mettant en ava...

Explorez le monde des modèles d'agents IA grâce à une analyse approfondie de 20 systèmes de pointe. Découvrez comment ils réfléchissent, raisonnent et performen...

Découvrez comment un minuscule modèle à 7 millions de paramètres surpasse Gemini, DeepSeek et Claude grâce au raisonnement récursif et à la supervision profonde...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.