Métaprompt

Un métaprompt en intelligence artificielle est une instruction de haut niveau conçue pour générer ou améliorer d'autres prompts pour les grands modèles de langa...

Maîtrisez l’optimisation des prompts pour l’IA en rédigeant des requêtes claires et riches en contexte afin d’améliorer la qualité des résultats, réduire les coûts et diminuer le temps de traitement. Découvrez des techniques pour des workflows IA plus intelligents.

L’optimisation des prompts consiste à affiner l’entrée que vous fournissez à un modèle IA afin qu’il délivre les réponses les plus précises et efficaces possible. Il ne s’agit pas seulement de communiquer clairement : des prompts optimisés réduisent également la charge de calcul, ce qui accélère le traitement et diminue les coûts. Que vous rédigiez des requêtes pour des chatbots de support client ou que vous génériez des rapports complexes, la manière dont vous structurez et formulez vos prompts est essentielle.

Avez-vous déjà essayé de demander à une IA d’écrire une meta description ? Il y a de fortes chances que votre premier prompt ressemblait à ceci :

Écris-moi une meta description sur le thème de l’optimisation des prompts.

Ce prompt est incorrect pour plusieurs raisons. Si vous ne précisez pas la longueur de 140 caractères exigée par Google, l’IA dépassera largement. Même si la longueur est respectée, elle adoptera souvent un style différent ou rendra la description trop descriptive et peu attrayante. Enfin, sans avoir lu votre article, elle ne peut produire que des meta descriptions vagues.

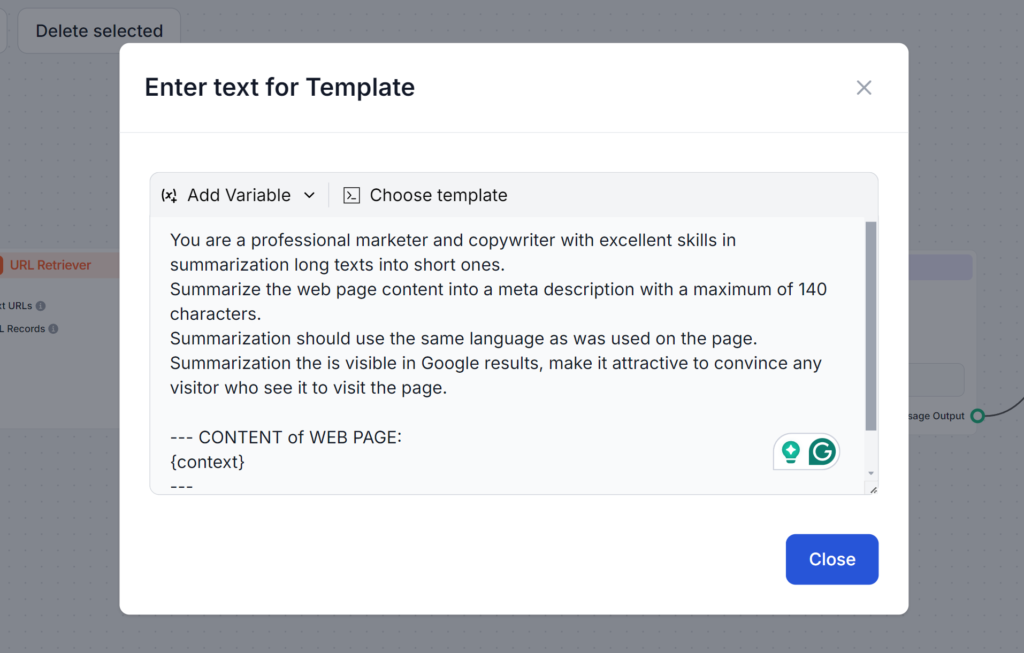

Regardez le prompt ci-dessous. Il est plus long et utilise plusieurs techniques que nous allons découvrir dans ce blog. Ce que ce prompt fait de bien, c’est qu’il anticipe tous les problèmes possibles, garantissant que vous obtiendrez le résultat exact dès le premier essai :

Les tokens sont les éléments de base du texte que les modèles IA traitent. Les modèles découpent le texte en ces tokens. Un token peut être un mot, plusieurs mots, ou même une partie de mot. Plus il y a de tokens, plus les réponses sont lentes et les coûts de calcul élevés. Comprendre le fonctionnement des tokens est donc essentiel pour améliorer les prompts et s’assurer qu’ils sont économiques et rapides à exécuter.

Pourquoi les tokens sont-ils importants :

Par exemple :

Dans le prompt avec beaucoup de tokens, l’IA doit détailler toutes les options possibles, tandis qu’avec moins de tokens, elle doit simplement fournir un aperçu. Grâce à cet aperçu, vous pouvez développer selon vos besoins, atteignant ainsi le résultat souhaité plus rapidement et à moindre coût.

Créer des prompts efficaces nécessite un mélange de clarté, de contexte et de créativité. Il est recommandé d’expérimenter différents formats pour découvrir les méthodes les plus performantes. Voici quelques techniques essentielles :

Des prompts ambigus peuvent induire le modèle en erreur. Un prompt bien structuré garantit que l’IA comprend votre intention.

Exemple :

Inclure des détails pertinents aide l’IA à générer des réponses adaptées à vos besoins.

Exemple :

Ajouter des exemples guide l’IA sur le format ou le ton souhaité.

Exemple :

Utiliser des modèles standardisés pour des tâches similaires garantit la cohérence et fait gagner du temps.

Exemple de modèle pour la rédaction de blogs :

“Rédige un article de blog de [nombre de mots] sur [sujet], en te concentrant sur [détails spécifiques]. Utilise un ton convivial et inclue [mots-clés].”

Plusieurs stratégies avancées permettent d’aller plus loin dans l’optimisation des prompts. Ces techniques dépassent la simple clarté et la structure, et permettent de gérer des tâches complexes, d’intégrer des données dynamiques et d’adapter la réponse de l’IA à des domaines ou besoins spécifiques. Voici un aperçu de chaque technique, avec des exemples pratiques.

Le few-shot learning consiste à fournir quelques exemples dans votre prompt pour aider l’IA à comprendre le format ou le schéma attendu. Cela permet au modèle de généraliser efficacement avec un minimum de données, idéal pour des tâches nouvelles ou peu familières.

Donnez simplement quelques exemples dans le prompt pour clarifier vos attentes au modèle.

Exemple de prompt :

Traduisez les phrases suivantes en français :

L’enchaînement de prompts consiste à décomposer des tâches complexes en étapes plus petites et gérables qui se construisent les unes sur les autres. Cette méthode permet à l’IA de traiter des problèmes en plusieurs étapes de manière systématique, garantissant clarté et précision dans le résultat.

Exemple de prompt :

La recherche contextuelle intègre des informations pertinentes et à jour dans le prompt en référant à des sources externes ou en résumant des détails clés. Ainsi, l’IA accède à des données précises et actuelles pour des réponses plus informées.

Exemple :

“En utilisant les données de ce rapport [insérer le lien], résume les principaux résultats sur les tendances des énergies renouvelables.”

L’ajustement fin avec des embeddings permet d’adapter le modèle IA à des tâches ou domaines spécifiques à l’aide de représentations de données spécialisées. Cette personnalisation améliore la pertinence et la précision des réponses pour des applications de niche ou sectorielles.

La gestion de l’utilisation des tokens vous permet de contrôler la rapidité et le coût de traitement des entrées et sorties par l’IA. En réduisant le nombre de tokens traités, vous pouvez économiser des coûts et obtenir des réponses plus rapides sans sacrifier la qualité. Voici quelques techniques pour gérer efficacement les tokens :

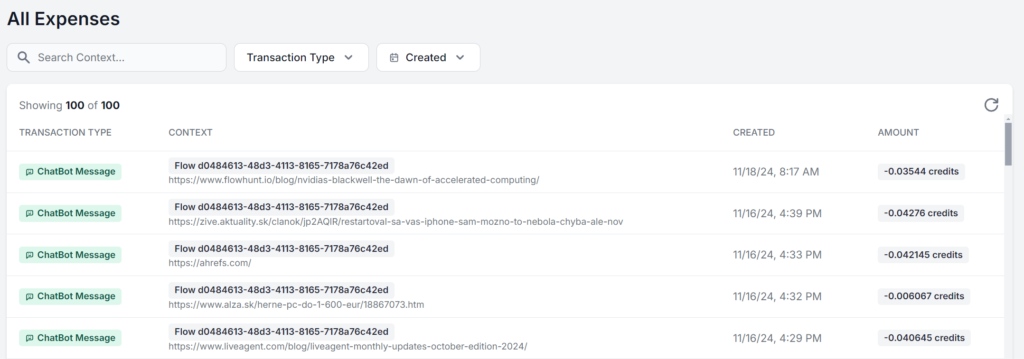

L’optimisation ne s’arrête pas à la rédaction de meilleurs prompts. Suivez régulièrement la performance et itérez en fonction des retours. Ce suivi continu permet un affinement progressif et vous donne la possibilité d’apporter des changements judicieux.

Concentrez-vous sur ces points clés :

La meilleure approche est d’utiliser une interface qui vous permet de visualiser et d’analyser l’utilisation exacte pour chaque prompt. Voici un même workflow IA FlowHunt exécuté 5 fois avec seulement la source qui change. La différence de coût ne se chiffre qu’en centimes, mais à mesure que les requêtes s’accumulent, l’écart devient vite significatif :

Que vous cherchiez à profiter au maximum de la limite gratuite des modèles IA ou que vous construisiez votre stratégie IA à grande échelle, l’optimisation des prompts est essentielle pour quiconque utilise l’IA. Ces techniques vous permettent d’utiliser l’IA efficacement, d’obtenir des résultats précis et de réduire les coûts.

Au fur et à mesure que la technologie IA progresse, l’importance d’une communication claire et optimisée avec les modèles ne fera que croître. Commencez dès aujourd’hui à expérimenter ces stratégies gratuitement. FlowHunt vous permet de travailler avec différents modèles et capacités IA via un tableau de bord unique, pour des workflows IA optimisés et efficaces pour toutes vos tâches. Essayez la version d’essai gratuite de 14 jours !

L'optimisation des prompts consiste à affiner l'entrée que vous fournissez à un modèle IA afin qu'il délivre des réponses les plus précises et efficaces possible. Des prompts optimisés réduisent la charge de calcul, ce qui permet des temps de traitement plus rapides et des coûts moindres.

Le nombre de tokens influence à la fois la vitesse et le coût des résultats IA. Moins de tokens entraînent des réponses plus rapides et des coûts réduits, tandis que des prompts concis aident les modèles à se concentrer sur les détails pertinents.

Les techniques avancées incluent le few-shot learning, l'enchaînement de prompts, la recherche contextuelle et l'ajustement fin avec des embeddings. Ces méthodes aident à résoudre des tâches complexes, intégrer des données dynamiques et adapter les réponses à des besoins spécifiques.

Surveillez la précision des réponses, l'utilisation des tokens et les temps de traitement. Un suivi régulier et des itérations basées sur les retours permettent d'affiner les prompts et de maintenir l'efficacité.

FlowHunt propose des outils et un tableau de bord pour créer, tester et optimiser vos prompts IA, vous permettant d'expérimenter différents modèles et stratégies pour des workflows IA efficaces.

Maria est rédactrice chez FlowHunt. Passionnée de langues et active dans les communautés littéraires, elle est pleinement consciente que l'IA transforme notre façon d'écrire. Plutôt que de résister, elle cherche à aider à définir l'équilibre parfait entre les flux de travail de l'IA et la valeur irremplaçable de la créativité humaine.

Commencez à créer des workflows IA optimisés avec FlowHunt. Expérimentez l'ingénierie des prompts et boostez votre productivité.

Un métaprompt en intelligence artificielle est une instruction de haut niveau conçue pour générer ou améliorer d'autres prompts pour les grands modèles de langa...

Maîtrisez les prompts de chatbot IA avec notre guide complet. Découvrez le cadre CARE, les techniques d’ingénierie de prompt et les meilleures pratiques pour ob...

Découvrez pourquoi l’ingénierie des prompts devient rapidement une compétence essentielle pour tous les professionnels, comment elle transforme la productivité ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.