Politique de sécurité

Découvrez la politique de sécurité complète de FlowHunt, couvrant l’infrastructure, l’organisation, le produit et les pratiques de confidentialité des données p...

Un guide complet pour intégrer en toute sécurité les plateformes d’IA à votre base de données à l’aide de passerelles API, du chiffrement, du contrôle d’accès et de stratégies de surveillance.

Principales pratiques de sécurité pour exposer des bases de données à l’IA :

Exposer une base de données en toute sécurité signifie permettre aux systèmes d’IA d’accéder aux données dont ils ont besoin tout en maintenant des contrôles stricts sur les données consultées, qui (ou quoi) y accède, à quel moment, et comment cet accès est surveillé et journalisé. Cela diffère fondamentalement du simple fait d’ouvrir votre base de données à Internet ou de fournir des identifiants directs à des plateformes d’IA.

Lorsque nous parlons d’exposer une base de données à des plateformes d’IA, nous décrivons une décision architecturale délibérée visant à créer une interface contrôlée entre vos données et les systèmes d’IA externes. Cette interface agit comme un point de contrôle de sécurité, appliquant l’authentification, l’autorisation, le chiffrement et la journalisation à chaque étape. L’objectif est de créer ce que les professionnels de la sécurité appellent un « point de passage unique » — un emplacement centralisé où tous les accès peuvent être surveillés, contrôlés et validés.

Le défi est que les plateformes d’IA nécessitent souvent un accès large à des jeux de données variés pour fonctionner efficacement. Un modèle de machine learning peut avoir besoin d’analyser à la fois les comportements clients, l’historique des transactions et les informations produits. Un système IA génératif peut devoir rechercher dans plusieurs tables pour répondre à des questions complexes. Accorder cet accès sans protection adéquate peut exposer votre organisation à des violations de données, des infractions à la conformité et des menaces internes.

L’intérêt métier d’exposer en toute sécurité les bases de données à l’IA est fort. Les organisations qui intègrent avec succès l’IA à leur infrastructure de données bénéficient d’avantages concurrentiels majeurs : prise de décision plus rapide, automatisation des analyses, amélioration de l’expérience client et efficacité opérationnelle. Mais les risques sont tout aussi importants.

Les violations de données impliquant des bases de données exposées sont de plus en plus fréquentes et coûteuses. En 2024, le coût moyen d’une violation de données a dépassé 4,45 millions de dollars, les incidents liés aux bases de données représentant une part substantielle de ces pertes. Si la violation concerne des données personnelles soumises à des réglementations comme le RGPD ou le CCPA, les impacts financiers et réputationnels sont encore amplifiés. Au-delà des coûts directs, les organisations font face à des interruptions d’activité, une perte de confiance des clients et une responsabilité juridique potentielle.

Le défi s’accroît avec l’implication de systèmes d’IA. Les modèles IA peuvent mémoriser involontairement des données sensibles d’entraînement, les rendant récupérables via des attaques d’injection de prompt ou d’extraction de modèle. Les agents IA ayant accès à la base de données peuvent être manipulés à travers des prompts soigneusement conçus pour exécuter des requêtes non prévues ou divulguer des informations confidentielles. Ces nouveaux vecteurs d’attaque nécessitent des approches de sécurité dépassant la simple protection classique des bases de données.

De plus, la surveillance réglementaire sur l’IA s’intensifie rapidement. Les autorités de protection des données du monde entier publient des recommandations sur la gestion des données personnelles lors de l’utilisation de systèmes d’IA. La conformité au RGPD, CCPA, HIPAA et aux nouvelles réglementations spécifiques à l’IA exige de démontrer que vous avez mis en place des mesures de protection appropriées avant toute exposition de données à des plateformes IA.

Avant de mettre en place une stratégie d’exposition de votre base de données à des plateformes d’IA, vous devez avoir une vision claire de votre infrastructure de sécurité et de votre paysage de données. Cette évaluation doit répondre à plusieurs questions cruciales :

Quelles données possédez-vous réellement ? Réalisez un inventaire complet et une classification des données. Catégorisez vos données par niveau de sensibilité : public, interne, confidentiel, restreint. Identifiez les données contenant des informations personnelles (PII), des données de carte bancaire (PCI), des informations de santé (PHI) ou d’autres types de données réglementées. Cette classification constitue la base de toutes les décisions ultérieures de contrôle d’accès.

Quels sont vos contrôles de sécurité actuels ? Documentez vos mesures de sécurité existantes : mécanismes d’authentification, état du chiffrement (en transit et au repos), segmentation réseau, procédures de sauvegarde et de restauration, capacités de journalisation d’audit. Identifiez les lacunes où les contrôles sont manquants ou obsolètes.

Quelles sont vos obligations en matière de conformité ? Passez en revue les réglementations applicables à votre secteur et votre zone géographique. Si vous traitez des données personnelles, le RGPD s’applique probablement. Si vous êtes dans la santé, l’HIPAA s’impose. Les entreprises de services financiers doivent considérer la norme PCI-DSS. Comprendre ces obligations façonne votre architecture de sécurité.

Quelle est votre tolérance au risque ? Chaque organisation a un appétit pour le risque différent. Un prestataire de santé traitant des données patient est plus averses au risque qu’une entreprise SaaS analysant des métriques anonymisées. Votre tolérance au risque doit guider le degré de restriction de vos contrôles d’accès.

La décision architecturale la plus critique est de ne jamais exposer directement votre base de données aux plateformes d’IA. Il faut plutôt mettre en place une passerelle API sécurisée entre votre base de données et les systèmes externes. Cette passerelle devient le point de contrôle unique pour tous les accès à la base de données.

Une passerelle API remplit plusieurs fonctions essentielles. D’abord, elle offre une couche d’abstraction qui découple la plateforme IA de la structure de votre base de données. Si la structure change, il suffit de mettre à jour l’API, sans devoir renégocier l’accès avec chaque plateforme IA. Ensuite, elle permet d’appliquer des politiques de sécurité cohérentes à toutes les requêtes. Enfin, elle centralise la surveillance, la journalisation et l’alerte sur les activités suspectes.

Lors du choix ou du développement d’une passerelle API, privilégiez les solutions prenant en charge le proxy conscient de l’identité (IAP). Un proxy IAP authentifie chaque requête avant qu’elle n’atteigne votre base de données, garantissant que seuls les systèmes autorisés accèdent aux données. Il doit prendre en charge divers modes d’authentification comme OAuth 2.0, les jetons JWT, le TLS mutuel (mTLS) et les clés API. La passerelle doit aussi appliquer des limites de taux pour prévenir les abus et valider les requêtes pour bloquer les requêtes malformées ou suspectes.

Parmi les options populaires : les solutions cloud natives comme AWS API Gateway avec intégration IAM, Identity-Aware Proxy de Google, Azure API Management, ou des solutions spécialisées comme Hoop ou DreamFactory. Toutes reposent sur le principe commun de créer une couche d’accès contrôlé.

Une fois votre passerelle API mise en place, la couche suivante consiste à implémenter des mécanismes robustes d’authentification et d’autorisation. Ces deux concepts sont souvent confondus mais sont distincts : l’authentification vérifie qui (ou quoi) fait la demande, l’autorisation détermine ce que cet acteur a le droit de faire.

Pour les utilisateurs humains accédant à des systèmes IA connectés à votre base de données, implémentez l’authentification multifacteur (MFA). Cela combine généralement un mot de passe, un élément possédé (téléphone ou token physique) et une caractéristique biométrique. La MFA réduit considérablement le risque de compromission de compte, souvent à l’origine des violations de données.

Pour les systèmes IA et les principaux de service, utilisez des identifiants forts, renouvelés automatiquement. Ne stockez jamais d’identifiants de base de données dans le code ou les fichiers de configuration. Utilisez plutôt des variables d’environnement, des coffres forts de secrets (HashiCorp Vault, AWS Secrets Manager, Azure Key Vault) ou des systèmes cloud natifs qui renouvellent automatiquement les identifiants.

Privilégiez l’authentification basée sur les certificats lorsque c’est possible. L’authentification mutuelle TLS (mTLS), où client et serveur s’authentifient mutuellement avec des certificats numériques, est plus sûre que l’authentification par mot de passe. Chaque plateforme IA ou service reçoit un certificat unique qui doit être présenté pour accéder à la passerelle API.

Le contrôle d’accès basé sur les rôles (RBAC) est le modèle d’autorisation le plus courant. Vous définissez des rôles (comme « AI_Analytics_Reader » ou « ML_Training_Agent ») et assignez des permissions à chaque rôle. Chaque système IA se voit attribuer un ou plusieurs rôles et ne peut effectuer que les actions permises par ces rôles. Le RBAC est simple à mettre en œuvre et à comprendre, ce qui le rend adapté à la plupart des organisations.

Le contrôle d’accès basé sur les attributs (ABAC) est plus sophistiqué et flexible. Au lieu d’assigner des rôles, vous définissez des politiques en fonction d’attributs de la requête : le département de l’utilisateur, le niveau de classification des données, l’heure, la localisation géographique, le but de l’accès, etc. L’ABAC permet un contrôle plus fin mais demande une conception de politique plus rigoureuse.

Appliquez le principe du moindre privilège : accordez à chaque système IA uniquement les permissions minimales nécessaires. Si un système IA n’a besoin que de lire les noms et emails clients, n’autorisez pas l’accès aux informations de paiement ou de sécurité sociale. S’il n’a besoin que de lire les données, ne lui donnez pas de droits d’écriture ou de suppression.

Même avec une authentification et une autorisation solides, il faut protéger les données elles-mêmes. Cela passe par deux stratégies complémentaires : le chiffrement et le masquage des données.

Le chiffrement en transit protège les données lors de leur circulation entre la base et la plateforme IA. Utilisez TLS 1.2 ou supérieur pour toutes les connexions. Ainsi, même si le trafic est intercepté, les données restent illisibles sans les clés. La plupart des passerelles API et des bases modernes supportent le TLS par défaut, mais vérifiez qu’il est bien activé et correctement configuré.

Le chiffrement au repos protège les données stockées dans la base. Même si un attaquant accède aux fichiers ou sauvegardes, il ne pourra pas lire les données sans les clés de chiffrement. La plupart des bases de données modernes proposent le chiffrement transparent des données (TDE) ou équivalent. Activez cette fonctionnalité et assurez-vous que la gestion des clés est sécurisée.

La gestion des clés est cruciale. Ne stockez jamais les clés de chiffrement au même endroit que les données chiffrées. Utilisez un service dédié de gestion des clés (KMS) qui contrôle l’accès aux clés séparément de la base. Faites tourner les clés régulièrement — au moins une fois par an, plus fréquemment pour les données sensibles. Prévoyez la gestion des versions des clés pour déchiffrer les anciennes données.

Le masquage des données consiste à remplacer les valeurs sensibles par des valeurs obfusquées ou synthétiques. Par exemple, un numéro de sécurité sociale peut être masqué en « XXX-XX-1234 », ne montrant que les quatre derniers chiffres. Un numéro de carte bancaire peut être affiché en « --****-4567 ». Cela permet aux systèmes IA de manipuler des données structurées proches de la réalité sans exposer les valeurs sensibles.

Le masquage dynamique applique des règles de masquage au moment de la requête, selon le rôle de l’utilisateur et la sensibilité des données. Un service client voit les noms et numéros complets, un système d’analytique IA voit seulement des valeurs masquées. Cette approche est plus flexible que le masquage statique car elle permet des règles adaptées à chaque type d’utilisateur.

Implémentez le masquage au niveau des colonnes pour vos données les plus sensibles. Identifiez les colonnes contenant des PII, informations de paiement, données de santé ou autres données réglementées, et appliquez des règles de masquage. Beaucoup de bases le supportent nativement, sinon vous pouvez l’implémenter dans la couche API.

Voyons comment le RBAC fonctionne dans un cas concret. Imaginons une base contenant des informations clients, l’historique des transactions et des données produits. Vous souhaitez exposer cette base à trois systèmes IA : un moteur de recommandation, un système de détection de fraude, et une plateforme d’analytique client.

| Système IA | Accès requis | Rôle recommandé | Permissions spécifiques |

|---|---|---|---|

| Moteur de recommandation | Profils clients, historique d’achats | AI_RECOMMENDATIONS_READER | SELECT sur les tables clients, commandes, produits ; pas d’accès aux moyens de paiement ni aux contacts privés |

| Détection de fraude | Détails des transactions, historique client | AI_FRAUD_DETECTOR | SELECT sur transactions, clients, comptes ; accès aux infos de paiement mais pas aux contacts clients |

| Plateforme analytique | Données clients agrégées | AI_ANALYTICS_READER | SELECT uniquement sur les vues agrégées ; pas d’accès aux enregistrements individuels ou détails des transactions |

Chaque rôle a des permissions limitées à ce qui est strictement nécessaire. Le moteur de recommandation ne voit pas les informations de paiement. Le système de fraude a accès aux transactions mais pas aux emails. La plateforme analytique n’a accès qu’aux données agrégées.

Ainsi, même si un système IA est compromis, l’accès de l’attaquant est limité au strict nécessaire. Le rayon d’action d’un incident est réduit.

Même avec de solides contrôles préventifs, il faut détecter et réagir aux incidents de sécurité. Cela exige une surveillance complète, des audits détaillés et une détection automatisée des menaces.

Activez la journalisation détaillée de tous les accès à la base. Chaque requête exécutée par un système IA doit être loggée avec :

Stockez ces logs dans un emplacement sécurisé et immuable, distinct de la base de données. Les fournisseurs cloud proposent des services de logs managés (AWS CloudTrail, Google Cloud Logging, Azure Monitor). Gardez les logs au moins un an, plus pour les données sensibles.

Mettez en place une surveillance en temps réel pour détecter les accès suspects. Prévoyez des alertes sur :

Des outils modernes de surveillance des bases peuvent reconnaître les requêtes et détecter automatiquement les anomalies. Imperva, Satori et d’autres proposent une détection de menaces alimentée par l’IA.

Élaborez un plan de réponse aux incidents spécifique à la sécurité des bases et à l’IA. Ce plan doit inclure :

Pour les organisations aux jeux de données volumineux ou diversifiés, pensez à segmenter vos données pour réduire l’exposition. Plusieurs approches existent :

Segmentation réseau : Placez la base sur un segment réseau isolé avec accès restreint. Seule la passerelle API communique directement avec la base. Les plateformes IA n’y accèdent qu’à travers la passerelle, jamais directement.

Segmentation de base : Si vos données sensibles et non sensibles sont ensemble, utilisez plusieurs bases. Ainsi, une IA accède seulement à la base nécessaire.

Sharding des données : Pour de très gros jeux de données, divisez-les en fragments (shards) selon des critères (ID client, région…). Les IA n’accèdent qu’aux fragments dont elles ont besoin.

Données synthétiques : Pour le développement et les tests, utilisez des données synthétiques mimant la structure et la distribution réelles mais sans aucune information sensible. Les IA peuvent ainsi être entraînées/testées sans exposer de vraies données.

Exposer votre base à des plateformes IA a de forts enjeux de conformité. Les réglementations varient :

RGPD (Règlement général sur la protection des données) : Si vous traitez des données personnelles de résidents de l’UE, le RGPD s’applique. Points clés :

CCPA (California Consumer Privacy Act) : Si vous traitez des données de résidents californiens, le CCPA s’applique. Points clés :

HIPAA (Health Insurance Portability and Accountability Act) : Si vous gérez des informations de santé, l’HIPAA s’applique. Points clés :

Normes sectorielles : Selon votre secteur :

Avant toute exposition de données à l’IA, réalisez une évaluation de conformité pour identifier les réglementations applicables et leurs exigences.

Gérer l’accès sécurisé d’une base à des plateformes IA implique de coordonner de multiples systèmes et d’appliquer des politiques cohérentes à travers l’organisation. C’est là que des plateformes d’automatisation des workflows comme FlowHunt sont précieuses.

FlowHunt vous permet de construire des workflows automatisés intégrant en toute sécurité les IA à vos bases. Au lieu de gérer manuellement les clés API, la surveillance des accès et la coordination inter-équipes, FlowHunt propose une plateforme unifiée pour :

Orchestration des workflows : Définissez des workflows complexes impliquant des requêtes base, des traitements IA, des transformations de données. FlowHunt orchestre le tout, en toute sécurité et dans le bon ordre.

Intégration des contrôles d’accès : FlowHunt s’intègre à vos systèmes de gestion des identités, appliquant automatiquement le RBAC et le moindre privilège à tous les workflows IA.

Audit et conformité : FlowHunt conserve des logs complets de toutes les exécutions de workflows : quelles données accédées, quand, par qui. Ces logs facilitent la conformité RGPD, CCPA, HIPAA, etc.

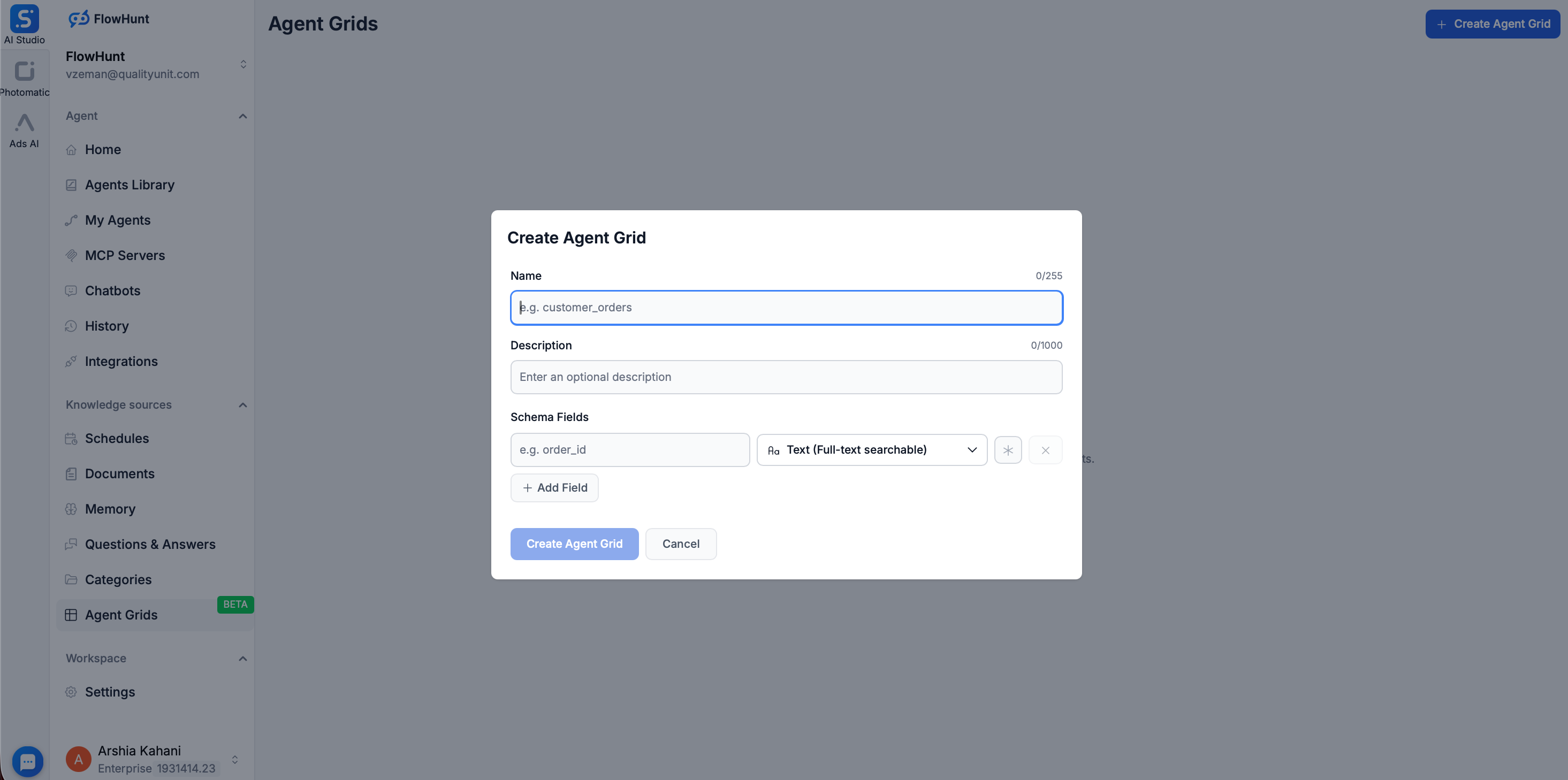

Pour un isolement supplémentaire entre vos modèles IA et les bases de production, FlowHunt propose la fonctionnalité Grid. Elle permet de créer une base de données consultable simplement en téléchargeant des fichiers structurés (CSV, etc.).

Une fois le CSV chargé dans Grid, FlowHunt utilise Elasticsearch pour indexer les données, transformant un fichier statique en source de connaissance dynamique à haute performance. Les avantages sécurité sont majeurs :

En utilisant Grid et les capacités de workflow de FlowHunt, vous simplifiez la gestion des contrôles de sécurité et garantissez l’application cohérente des politiques.

Mettre en place une exposition sécurisée de la base à l’IA passe par plusieurs étapes. Voici une feuille de route :

Étape 1 : Évaluer l’existant

Étape 2 : Concevoir votre architecture

Étape 3 : Mettre en œuvre les contrôles de base

Étape 4 : Protéger les données

Étape 5 : Déployer la surveillance et l’audit

Étape 6 : Tester et valider

Étape 7 : Exploiter et maintenir

Lors de la mise en œuvre, surveillez ces erreurs fréquentes :

Exposition directe de la base : N’exposez jamais directement la base à Internet ou à l’IA sans passerelle API. C’est le plus grand risque.

Permissions trop larges : Accorder trop de droits à l’IA va à l’encontre du moindre privilège. Commencez minimal et élargissez seulement si besoin.

Chiffrement insuffisant : Protéger uniquement en transit ou seulement au repos laisse des failles. Chiffrez à tous les niveaux.

Gestion faible des identifiants : Stocker les identifiants dans le code, les versions, ou ne pas les renouveler régulièrement crée de gros risques.

Surveillance insuffisante : Sans surveillance, vous ne saurez pas si vos contrôles sont contournés.

Négliger la conformité : Attendre une violation pour penser conformité coûte cher. Intégrez-la dès la conception.

Tests insuffisants : Des contrôles déployés mais non testés peuvent échouer au moment critique.

Avec la sophistication croissante de l’IA, de nouveaux vecteurs apparaissent : injection de prompt et extraction de modèle.

Injection de prompt : Un attaquant conçoit un prompt qui force l’IA à exécuter des actions non prévues, par exemple à ignorer les contrôles d’accès et à divulguer des données confidentielles. Défenses :

Extraction de modèle : Un attaquant interroge l’IA pour extraire des informations sur les données d’entraînement ou la structure interne. Défenses :

Exposer en toute sécurité votre base de données aux plateformes d’IA n’est pas seulement possible — c’est de plus en plus nécessaire pour tirer parti des capacités de l’IA tout en protégeant votre actif le plus précieux. L’essentiel est d’appliquer une approche multicouche combinant authentification et autorisation fortes, chiffrement, masquage des données, surveillance complète et tests réguliers.

Commencez par les fondamentaux : n’exposez jamais directement la base, utilisez toujours une passerelle API, mettez en place une authentification et une autorisation solides, et chiffrez vos données. Ajoutez ensuite le masquage, la surveillance, et les contrôles de conformité adaptés à votre profil de risque et vos obligations réglementaires.

Gardez à l’esprit que la sécurité n’est pas une action ponctuelle mais un processus continu. Révisez régulièrement vos contrôles, testez les vulnérabilités, surveillez les menaces et adaptez-vous aux nouveaux risques. En considérant la sécurité de la base comme une priorité permanente et non comme une case à cocher, vous pouvez exploiter la valeur de l’IA tout en protégeant les données et la réputation de votre organisation.

Découvrez comment FlowHunt automatise vos workflows IA et SEO — de la recherche à la génération de contenu, à la publication et à l’analytique — tout-en-un.

Oui, c’est sûr lorsque vous mettez en place des mesures de sécurité appropriées, notamment des passerelles API, le chiffrement, un contrôle d’accès basé sur les rôles et une surveillance complète. L’essentiel est d’utiliser une couche middleware sécurisée plutôt qu’une exposition directe de la base de données.

Utilisez des identifiants forts, à rotation régulière, avec une authentification multifacteur (MFA) pour les utilisateurs humains et les principaux de service. Implémentez OAuth, des jetons JWT ou des clés API avec des limites de taux strictes et une liste blanche d’IP pour les agents IA.

Mettez en place le masquage des données, le chiffrement au niveau des colonnes, un contrôle d’accès basé sur les rôles (RBAC) et séparez les données de production des données d’entraînement IA. Utilisez le masquage dynamique pour masquer les champs sensibles dans les résultats de requête et maintenez des journaux d’audit immuables.

Selon le type de vos données, tenez compte du RGPD, du CCPA, de l’HIPAA et d’autres réglementations pertinentes. Assurez-vous d’avoir une classification des données appropriée, des politiques de conservation, et des mécanismes de consentement avant toute exposition de données personnelles ou sensibles.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

Rationalisez vos workflows de données alimentés par l’IA tout en maintenant des standards de sécurité et de conformité de niveau entreprise.

Découvrez la politique de sécurité complète de FlowHunt, couvrant l’infrastructure, l’organisation, le produit et les pratiques de confidentialité des données p...

La transparence de l'IA est la pratique consistant à rendre les mécanismes et les processus de prise de décision des systèmes d'intelligence artificielle compré...

Intégrez FlowHunt avec le serveur Model Context Protocol (MCP) de GreptimeDB pour permettre un accès sécurisé, structuré et alimenté par l’IA à votre base de do...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.