Comment Tester un Chatbot IA

Découvrez des stratégies complètes de test de chatbots IA incluant des tests fonctionnels, de performance, de sécurité et d’utilisabilité. Explorez les meilleur...

Découvrez comment le moteur de simulation de Snowglobe vous aide à tester vos agents IA, chatbots et systèmes d’IA générative avant leur mise en production en simulant de vraies interactions utilisateurs et en identifiant les points de défaillance.

Construire des agents IA et chatbots fiables est devenu l’un des enjeux majeurs du développement logiciel moderne. Bien que les modèles d’apprentissage automatique soient de plus en plus sophistiqués, un écart important subsiste entre la performance en laboratoire et le comportement réel. Lorsque vous déployez un système IA en production, vous êtes inévitablement confronté à une infinité de contextes humains, de buts et de schémas d’interaction qu’aucun jeu de données d’entraînement ne peut complètement anticiper. C’est là qu’intervient Snowglobe : un moteur de simulation conçu pour combler ce fossé, en vous permettant de tester la façon dont les utilisateurs interagiront réellement avec votre produit IA avant sa mise en production. Plutôt que de découvrir les problèmes après le déploiement, Snowglobe vous permet de simuler des milliers d’interactions utilisateurs, d’identifier les points de défaillance, et de valider le comportement de votre système selon les exigences spécifiques de votre produit. Ce guide complet explique le fonctionnement de Snowglobe, pourquoi la simulation est devenue essentielle à la fiabilité de l’IA, et comment elle s’intègre dans une stratégie globale de construction de systèmes IA de confiance.

Déployer des systèmes IA de façon fiable est un défi qui remonte à la naissance de l’apprentissage automatique et des systèmes autonomes. Depuis des décennies, chercheurs et ingénieurs se heurtent au problème fondamental selon lequel les modèles entraînés sur des données historiques se comportent souvent de manière imprévisible face à des situations nouvelles et réelles. Ce problème est devenu particulièrement aigu dans les domaines critiques comme les véhicules autonomes, où les conséquences d’un comportement inattendu peuvent être catastrophiques. L’industrie de la voiture autonome a développé des approches sophistiquées pour relever ce défi, dont beaucoup sont aujourd’hui adaptées aux agents IA et aux systèmes génératifs. L’un des enseignements majeurs de ce domaine est que la simulation a joué un rôle clé, tant pour les tests que pour l’entraînement : des entreprises comme Waymo ont effectué des milliards de kilomètres de conduite simulée pour valider leurs systèmes avant de les déployer sur route. Le principe est simple : en exposant votre système à une grande variété de scénarios dans un environnement contrôlé et peu coûteux, vous pouvez identifier et corriger les problèmes avant qu’ils n’affectent des utilisateurs réels. Ce même principe s’applique aux agents IA, aux chatbots et autres applications d’IA générative, même si les scénarios simulés sont ici des interactions conversationnelles plutôt que des situations de conduite. Le fossé de fiabilité existe parce que les environnements de production introduisent des variables que les jeux de données d’entraînement ne peuvent représenter complètement : styles de communication variés, cas limites inattendus, exigences contextuelles et comportements émergents liés à l’interaction entre le système IA et de vrais humains.

Lorsque les organisations commencent à développer des systèmes IA, elles se tournent généralement vers des cadres de sécurité reconnus tels que le NIST AI Risk Management Framework ou l’OWASP Top 10 for Large Language Models. Ces référentiels fournissent des conseils précieux sur les risques courants comme l’hallucination, l’injection de prompt ou la génération de contenu toxique. Cependant, il existe une distinction cruciale entre les risques intrinsèques au modèle et ceux qui émergent de l’implémentation du modèle dans le contexte spécifique du produit. La plupart des cadres traditionnels s’intéressent aux premiers — les propriétés générales de sécurité que les fournisseurs s’efforcent déjà d’adresser. Un modèle d’un grand fournisseur comme OpenAI ou Anthropic a déjà été entraîné pour minimiser l’hallucination et les réponses toxiques. Sauf tentative explicite de contournement, vous êtes peu susceptible de rencontrer ces problèmes en utilisant le modèle tel quel. Les véritables défis émergent au niveau de l’implémentation, lorsque votre cas d’usage, vos exigences produit et votre design système créent de nouveaux modes de défaillance que les cadres génériques ne peuvent anticiper. Prenons l’exemple d’un chatbot de support client basé sur un modèle de langage : le modèle peut être fiable et sûr, mais si votre système est configuré trop prudemment, il risque de refuser de répondre à des questions légitimes, conduisant à une mauvaise expérience et à une perte d’adhésion. Ce phénomène de « surréfutation » est un problème produit que les benchmarks de sécurité traditionnels ne détecteront pas ; il n’émerge que par la simulation d’interactions réelles et l’observation du comportement de votre implémentation. C’est pourquoi le test par simulation est devenu indispensable : il permet d’identifier les modes de défaillance qui comptent vraiment pour votre produit, au lieu de se concentrer uniquement sur des métriques de sécurité génériques.

Le passage des garde-fous à la simulation est une évolution logique de la façon dont les organisations abordent la fiabilité de l’IA. Les garde-fous — règles et filtres empêchant certains types de réponses — sont utiles en dernier recours pour bloquer ce que vous ne pouvez tolérer en production. Mais ils sont insuffisants, car ils supposent que vous savez à l’avance ce qu’il faut bloquer. Dès la construction des systèmes de garde-fous, une question persistait : lesquels mettre en place ? Faut-il cibler l’hallucination ? La protection des données sensibles ? La toxicité ? Le biais ? La réponse dépendait toujours du cas d’usage spécifique et de l’implémentation. Un chatbot santé n’a pas les mêmes préoccupations qu’un assistant littéraire, un bot financier n’a pas les mêmes garde-fous qu’un chatbot généraliste. Plutôt que de deviner ce qui compte, la simulation permet de déterminer empiriquement où votre système casse. En générant un vaste ensemble d’interactions simulées et en observant les réponses de votre système, vous identifiez les vraies faiblesses qui affectent votre produit. Une fois ces points faibles connus, vous pouvez alors mettre en place des garde-fous ciblés ou améliorer le système pour traiter ces problèmes spécifiques. Cette approche basée sur la donnée est bien plus efficace que l’application de cadres génériques. Dans la pratique, les simulations révèlent souvent des problèmes inattendus. Un partenaire de conception utilisant la simulation craignait initialement la toxicité de son chatbot et a mis en place des garde-fous en conséquence. Mais les simulations ont montré que la toxicité n’était pas un vrai problème pour son cas d’usage. Ce qui est apparu, c’est la surréfutation : le chatbot était tellement prudent qu’il refusait des requêtes bénignes qui auraient dû être acceptées. Cette découverte n’aurait jamais émergé d’un cadre de sécurité traditionnel — elle n’a été révélée que grâce à la simulation.

Snowglobe repose sur un principe simple en apparence : se connecter à votre système IA, décrire ce qu’il fait, puis générer des milliers d’interactions utilisateurs simulées pour observer son comportement. Mais l’implémentation fait appel à plusieurs composants sophistiqués collaborant pour créer des scénarios réalistes, variés et pertinents. La première exigence est une connexion directe avec le système IA à tester — une API, un chatbot déployé, un agent, ou toute autre application IA. Snowglobe établit et maintient cette connexion durant toute la simulation, ce qui permet d’envoyer des requêtes tests et d’obtenir des réponses comme le ferait un utilisateur réel. Cette connexion « live » est cruciale car elle garantit que vous testez votre système réel, pas une version simplifiée ou simulée. La seconde exigence est une description de ce que fait votre système IA. Il ne s’agit pas d’un prompt d’ingénierie complexe : quelques phrases suffisent pour expliquer la finalité du système, son public cible et les cas d’usage attendus. Cette description sert de base pour générer des utilisateurs et interactions simulés représentatifs de votre contexte. Snowglobe utilise cette description pour comprendre le périmètre de votre système et générer des scénarios de test réellement pertinents pour votre cas d’usage. Le troisième composant, optionnel mais puissant, est votre base de connaissances ou vos historiques d’interactions. Si votre système IA interroge une base de connaissances, Snowglobe peut l’explorer thématiquement et générer des questions qui nécessitent de la consulter pour répondre, assurant ainsi une couverture programmatique complète. De même, si vous disposez d’historiques d’utilisateurs, Snowglobe peut les analyser pour générer des scénarios reflétant les usages réels. Une fois ces éléments en place, vous définissez un prompt de simulation qui précise les types d’utilisateurs et d’interactions à tester. C’est là que Snowglobe révèle toute sa flexibilité : vous pouvez tester des utilisateurs généraux, ou cibler des scénarios spécifiques — par exemple des questions sur les transitions de carrière pour un chatbot coach. Vous pouvez également lancer des tests comportementaux (tentatives de contournement, tests de limites) ou de sécurité (sujets sensibles, auto-dommages). Pour chaque simulation, vous configurez l’échelle : nombre de personas à générer, nombre de conversations par persona, longueur des échanges. Vous spécifiez aussi les risques à tester (sécurité, auto-dommages, hallucination, etc.). Une fois lancée, Snowglobe génère des personas variés avec des styles de communication, des backgrounds et des cas d’usage différents, puis analyse toutes les interactions pour identifier les motifs, échecs ou comportements inattendus.

L’un des aspects les plus avancés de Snowglobe est la génération de personas diversifiés pour les tests. Plutôt que de créer des utilisateurs génériques, Snowglobe génère des personas aux styles de communication, backgrounds, préoccupations et modes d’interaction distincts. Cette diversité est essentielle car les utilisateurs réels ne sont pas homogènes : ils s’expriment différemment, ont des niveaux techniques variés, des cultures et des objectifs divers. En simulant cette diversité, vous pouvez identifier des modes de défaillance qui n’apparaîtraient qu’avec certains types d’utilisateurs ou styles de communication. Lorsqu’un persona est généré, il comprend un profil détaillé : non seulement des informations démographiques mais aussi des caractéristiques comportementales. Un persona peut, par exemple, être décrit comme quelqu’un qui réfléchit beaucoup, change souvent d’avis, utilise un langage formel et une grammaire irréprochable, et communique de façon très polie et nuancée. Ses cas d’usage peuvent inclure transitions de carrière, dynamiques relationnelles, blocages créatifs. Ce niveau de détail garantit des interactions réalistes et représentatives de vrais utilisateurs. Cette approche prend tout son sens lorsqu’on constate que des personas différents exposent des faiblesses différentes : un persona formel et réfléchi fera émerger d’autres cas limites qu’un persona au langage familier et abrégé ; un persona centré sur la santé mentale déclenchera d’autres comportements qu’un persona posant des questions générales. En simulant des dizaines ou centaines de personas, vous couvrez un spectre d’interactions bien plus large qu’avec des tests manuels. De plus, Snowglobe vous permet de contrôler les caractéristiques comportementales des personas pour cibler des scénarios précis : tester la robustesse face à des tentatives de contournement, ou la réaction à des sujets sensibles. Cette génération ciblée permet des tests de sécurité approfondis tout en conservant la capacité de simuler des interactions générales révélant des situations inattendues.

L’un des grands enseignements de Snowglobe est que les tests les plus importants ne concernent pas les métriques génériques recommandées par les cadres de sécurité, mais bien les KPIs produits qui déterminent réellement si votre système IA apporte de la valeur. Il s’agit d’un changement de paradigme dans la façon d’envisager la fiabilité de l’IA. Les cadres traditionnels visent à prévenir les « mauvaises » issues — hallucination, contenu toxique, violations de la vie privée. Ces aspects sont importants, mais souvent secondaires dans la réussite d’un produit. Ce qui détermine le succès, c’est la capacité du système à aider les utilisateurs à atteindre leurs objectifs, à communiquer selon les valeurs et le ton de la marque, à fournir des informations exactes et utiles, et à garantir une expérience positive. Ces métriques produits sont invisibles pour les cadres de sécurité mais cruciales à tester par simulation. Prenons un agent de support par e-mail : le cadre traditionnel vérifiera l’absence de toxicité ou d’hallucination, mais le vrai enjeu est de savoir si l’agent répond selon les standards de communication et de ton de votre équipe support. Si votre service client est réputé pour sa chaleur, son empathie et son efficacité, mais que votre agent IA répond de manière froide et distante, le produit échouera, même s’il respecte toutes les règles de sécurité. C’est un échec produit détectable uniquement par la simulation. De même, pour un chatbot commercial, le cadre de sécurité s’intéresse aux fausses affirmations, mais le vrai KPI est : le bot aide-t-il vraiment l’utilisateur à progresser vers l’achat ? Répond-il aux questions précises des prospects ? Maintient-il leur engagement ? En concentrant les simulations sur ces métriques produits, vous détectez les modes de défaillance qui comptent pour votre business — et vous obtenez un diagnostic bien plus actionnable. Si la simulation révèle que votre agent support surréfute, vous avez un problème précis à résoudre. Si le chatbot commercial ne répond pas efficacement aux objections, c’est un levier concret d’amélioration. Ces enseignements produits sont bien plus utiles que de simples alertes sécurité, car ils sont directement reliés à la performance business.

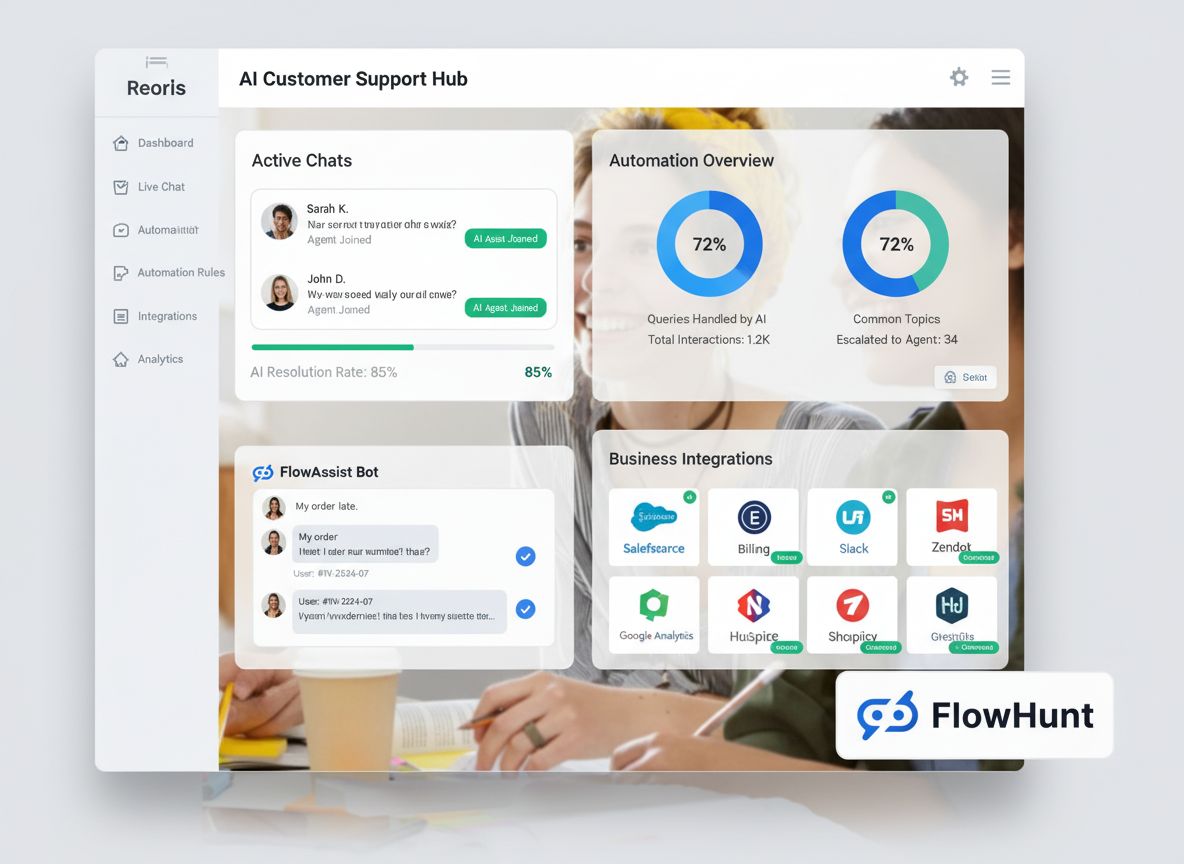

Découvrez comment FlowHunt automatise vos workflows IA et SEO — de la recherche à la génération de contenu, jusqu’à la publication et l’analyse — tout en un seul endroit.

Mettre en œuvre des simulations avec Snowglobe s’appuie sur un workflow simple adaptable à différents scénarios de test et besoins organisationnels. Première étape : établir une connexion active avec votre système IA. Cette connexion doit être maintenue pendant toute la simulation, car Snowglobe doit envoyer des requêtes et recevoir des réponses en temps réel. Le processus est conçu pour être rapide — il faut généralement quelques secondes pour établir et vérifier la communication avec votre système. Une fois la connexion établie, vous passez à la deuxième étape : fournir une description de votre système IA. Cette description doit répondre à quelques questions clés : Quel est l’objectif principal du système ? Qui sont les utilisateurs cibles ? Quels types de questions ou de requêtes vont-ils soumettre ? Quels sont les cas d’usage majeurs ? Pas besoin d’un texte exhaustif ou parfaitement rédigé : Snowglobe fonctionne avec des descriptions brèves et naturelles. Le but est simplement d’établir une base réaliste pour générer des scénarios de test représentatifs du périmètre réel de votre système. Troisième étape, optionnelle mais vivement recommandée : connecter votre base de connaissances ou vos historiques d’interactions. Si votre système IA interroge une base pour répondre, vous pouvez la connecter à Snowglobe. Ce dernier en analysera les sujets et générera des questions qui obligent le système à y puiser, assurant ainsi une couverture complète et détectant les éventuelles failles de récupération ou d’utilisation de l’information. De même, si vous disposez d’historiques, vous pouvez les fournir à Snowglobe pour générer des scénarios basés sur de vrais schémas d’utilisation. Quatrième étape : définir le prompt de simulation. C’est ici que vous indiquez les types d’utilisateurs et d’interactions à tester. Vous pouvez écrire par exemple « utilisateurs généraux posant des questions sur la vie et le travail », « utilisateurs tentant de contourner le système », ou « questions sur des sujets sensibles de santé mentale ». Ce prompt est un levier puissant pour cibler des scénarios précis ou explorer des comportements particuliers. Vous pouvez bien sûr lancer plusieurs simulations avec différents prompts pour couvrir toutes les facettes de votre système. Cinquième étape : configurer l’échelle de la simulation. Indiquez combien de personas générer, combien de conversations chacun doit avoir, et combien d’échanges par conversation. Précisez aussi les risques à tester : sécurité du contenu, auto-dommages, hallucination, biais, etc. Ces options vous permettent d’équilibrer profondeur et temps de simulation. Une petite simulation peut comprendre 10 personas, 30 conversations et 4 à 5 échanges chacune ; une grande simulation peut en inclure des centaines, voire des milliers. Une fois tout configuré, lancez la simulation : Snowglobe commence à générer personas et conversations, et vous pouvez suivre en temps réel la création des personas et le déroulement des échanges. Le système affiche des informations détaillées sur chaque persona : style de communication, background, cas d’usage, caractéristiques comportementales. Au fil des conversations, vous observez comment votre système IA réagit à différents profils et questions. Une fois la simulation terminée, Snowglobe fournit des analyses et des rapports complets pour identifier les tendances, faiblesses et axes d’amélioration.

La valeur de la simulation se révèle lors de l’analyse des résultats et l’extraction de pistes actionnables. Snowglobe propose des outils d’analyse et de reporting détaillés pour comprendre la performance de votre IA sur des milliers d’interactions simulées. L’analyse se concentre généralement sur plusieurs dimensions clés. Premièrement, vous examinez les taux de succès globaux et les schémas d’échec : combien d’interactions aboutissent à une réponse utile et exacte ? Combien se soldent par un refus, une information incorrecte ou un comportement inattendu ? Ces métriques globales donnent une idée de la fiabilité générale du système. Deuxièmement, vous pouvez approfondir les modes de défaillance précis : quand le système échoue, quelle est la nature de l’échec ? Refus d’une question qui aurait dû être acceptée ? Information inexacte ? Mauvaise compréhension de l’intention ? Non-conformité aux consignes de communication ? En catégorisant les échecs, vous identifiez des motifs récurrents et pouvez prioriser les corrections. Troisièmement, vous analysez l’expérience des différents personas : certains profils rencontrent-ils plus de problèmes ? Les utilisateurs avec un style ou un background particulier obtiennent-ils de moins bons résultats ? Cette analyse révèle d’éventuels biais ou cas limites invisibles dans les statistiques agrégées. Quatrièmement, vous pouvez étudier des conversations précises en détail : Snowglobe permet de relire chaque échange entre utilisateur simulé et système, ce qui aide à comprendre le contexte et la nuance des échecs. Parfois, un échec qui semble grave dans les statistiques se révèle raisonnable en contexte, ou inversement, un détail anodin cache un problème structurel de compréhension. Cinquièmement, vous pouvez comparer les résultats de différentes simulations : en variant les configurations, les prompts ou les personas, vous mesurez l’impact des changements sur le comportement du système. Cela permet de tester des hypothèses : par exemple, vous identifiez par simulation un problème de surréfutation, modifiez le prompt système pour assouplir la réponse, puis relancez une simulation pour vérifier si le problème est résolu. Cette boucle itérative d’amélioration est bien plus efficace que les ajustements basés sur l’intuition ou le feedback anecdotique.

L’approche de Snowglobe s’inspire de l’utilisation de la simulation à grande échelle dans l’industrie des véhicules autonomes. Ce contexte historique montre que le test par simulation n’est ni nouveau ni expérimental : il a été affiné pendant des décennies dans l’un des domaines les plus critiques pour la sécurité. Pour les voitures autonomes, la simulation est devenue incontournable car les tests en conditions réelles étaient insuffisants pour atteindre la fiabilité requise. Une voiture autonome doit gérer des millions de cas limites, dont certains ne surviennent qu’une fois tous les millions de kilomètres. Tester uniquement sur route demanderait un temps et des ressources irréalistes. À la place, des entreprises comme Waymo ont développé des environnements de simulation sophistiqués leur permettant de tester sur des milliards de kilomètres virtuels, incluant conditions normales mais aussi cas rares, météo extrême, obstacles inattendus, etc. L’ordre de grandeur est frappant : Waymo a effectué près de 20 milliards de kilomètres simulés pour 20 millions réels — un ratio de 1000 pour 1. Cette couverture massive a permis d’identifier et corriger des problèmes quasiment impossibles à trouver sur route. L’enseignement clé : la simulation permet d’explorer exhaustivement l’espace des scénarios, bien au-delà de ce que le réel autorise. Le même principe s’applique aux agents IA et aux systèmes génératifs : l’espace des scénarios conversationnels est virtuellement infini — manières de formuler, types de requêtes, cas limites. Tester uniquement sur de vrais utilisateurs exigerait des années pour découvrir tous les échecs. La simulation permet de générer des milliers ou millions de scénarios programmatiquement, pour une couverture exhaustive et à coût quasi nul (juste de la computation). En outre, la simulation coûte infiniment moins cher que le test réel : il n’y a pas à recruter d’utilisateurs, à gérer les conséquences d’un échec ou à risquer l’image de la marque. Identifier et corriger les problèmes avant qu’ils n’atteignent les vrais utilisateurs réduit considérablement le coût et le risque du déploiement. L’expérience des voitures autonomes montre également l’importance de la simulation continue : Waymo n’a pas simulé une fois pour toutes, mais a maintenu un cycle permanent de simulation à chaque évolution de son système, rencontre de nouveaux cas limites, ou expansion géographique. Cette boucle continue a permis de maintenir et d’améliorer la fiabilité dans le temps. Même logique pour les agents IA : la simulation ne doit pas être vue comme une étape ponctuelle avant le lancement, mais comme partie intégrante du processus d’amélioration continue. À chaque modification, on simule pour valider la fiabilité. Tout incident réel alimente la suite de simulation pour éviter les régressions. Toute expansion fonctionnelle doit être validée par simulation sur le nouveau périmètre.

Un point à considérer avec la simulation à grande échelle concerne la gestion des personas : faut-il en générer de nouveaux à chaque simulation, ou peut-on en réutiliser ? La réponse dépend des objectifs de test et de la stratégie choisie. Si votre but est de tester la robustesse de votre système sur un large spectre de profils et d’interactions, mieux vaut générer de nouveaux personas à chaque fois : cela multiplie les scénarios imprévus et évite d’« overfitter » le système à un jeu de tests fixe. À l’inverse, si vous souhaitez mesurer précisément l’impact d’une évolution du système, réutiliser les mêmes personas d’une simulation à l’autre est pertinent : vous pouvez ainsi comparer l’avant/après sur des profils identiques, à la façon d’un test de non-régression. En pratique, de nombreuses organisations adoptent une approche hybride : elles gardent un « noyau » de personas représentatifs pour le suivi des régressions, tout en générant à chaque simulation de nouveaux profils pour découvrir en continu de nouveaux cas limites. Cette flexibilité de la simulation permet d’adapter la stratégie de test à vos besoins et à votre process.

Pour les organisations qui construisent des workflows et agents IA, l’intégration de la simulation dans le process de développement devient encore plus puissante lorsqu’elle est couplée à une plateforme d’automatisation comme FlowHunt. FlowHunt permet d’automatiser tout le cycle de vie d’un agent IA, de la conception au déploiement en passant par les tests et la supervision. En intégrant les capacités de simulation de Snowglobe avec les workflows FlowHunt, vous disposez d’un système complet pour construire des agents IA fiables à grande échelle. L’intégration opère à plusieurs niveaux. D’abord, FlowHunt peut automatiser la configuration et l’exécution des simulations. Plus besoin de tout paramétrer à la main : vous définissez des workflows qui lancent automatiquement des simulations à chaque changement du système IA, garantissant que chaque évolution soit validée avant la production. Ensuite, FlowHunt automatise l’analyse des résultats : au lieu d’examiner manuellement des milliers d’interactions, vous définissez des analyses qui extraient les métriques clés, identifient les échecs et génèrent des rapports. Ces analyses peuvent déclencher des alertes si la fiabilité tombe sous un seuil, permettant de réagir immédiatement. Troisièmement, FlowHunt automatise l’itération sur le système : si la simulation révèle un problème (ex : surréfutation), un workflow peut automatiquement ajuster le prompt système, relancer la simulation et comparer les résultats. Ce cycle d’amélioration peut ainsi être largement automatisé, accélérant la fiabilité. Enfin, FlowHunt intègre la simulation dans tout le pipeline de développement IA : à chaque modification (prompt, outil, pipeline RAG…), une simulation est lancée automatiquement pour vérifier la fiabilité. Cette approche continue garantit la robustesse du système à chaque étape. L’alliance des simulations Snowglobe et de l’automatisation FlowHunt constitue une plateforme puissante pour construire des agents IA fiables, dépassant le test manuel et l’assurance qualité ponctuelle au profit d’une démarche systématique et automatisée de fiabilisation.

Snowglobe marque un tournant dans la fiabilisation des systèmes IA, passant des cadres génériques à une démarche empirique fondée sur la simulation des modes de défaillance spécifiques à votre produit. En générant des milliers d’interactions utilisateurs simulées et en observant la réponse de votre IA, vous identifiez les problèmes avant qu’ils n’atteignent les vrais utilisateurs, comprenez les points faibles du système et pouvez cibler les améliorations pour gagner en fiabilité. Cette approche s’appuie sur des décennies d’expérience dans l’automobile autonome, où la simulation s’est avérée indispensable pour atteindre la fiabilité requise en contexte critique. Pour les organisations développant des agents IA, chatbots ou applications génératives, intégrer la simulation dans le processus de développement n’est plus une option, mais une nécessité pour rester compétitif sur un marché où la fiabilité et l’expérience utilisateur font la différence. En combinant le test par simulation à l’automatisation des workflows via FlowHunt, vous disposez d’une plateforme complète pour construire, tester et améliorer en continu vos agents IA à grande échelle.

Snowglobe est un moteur de simulation qui vous permet de tester la manière dont les utilisateurs interagiront avec vos produits IA avant de les déployer en production. Il génère des interactions utilisateurs simulées à partir de la description de votre système IA, ce qui vous permet d’identifier les potentielles défaillances et comportements inattendus avant que de vrais utilisateurs ne les rencontrent.

Alors que les benchmarks traditionnels comme le NIST AIMF se concentrent sur des métriques générales de sécurité comme la toxicité ou l’hallucination, Snowglobe se focalise sur les KPIs spécifiques au produit et les problèmes liés à l’implémentation. Il aide à identifier les problèmes propres à votre cas d’usage, comme la surréfutation chez un agent de support client ou un décalage dans le style de communication.

Oui, Snowglobe peut se connecter à votre base de connaissances et l’explorer automatiquement par thématique. Il génère ensuite des questions qui nécessitent que votre agent interroge la base de connaissances pour répondre, assurant ainsi une couverture programmatique sur l’ensemble de votre base.

Vous pouvez lancer des simulations utilisateurs générales, des simulations thématiques (par exemple des questions sur des promotions), des tests comportementaux (tentatives de contournement), et des tests axés sur la sécurité. Vous pouvez également configurer le nombre de personas, la longueur des conversations et les risques spécifiques à tester.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

Optimisez le développement de vos agents IA grâce à des workflows de simulation et de test intelligents alimentés par la plateforme d’automatisation FlowHunt.

Découvrez des stratégies complètes de test de chatbots IA incluant des tests fonctionnels, de performance, de sécurité et d’utilisabilité. Explorez les meilleur...

Découvrez comment concevoir le contexte pour les agents IA en gérant les retours d’outils, en optimisant l’utilisation des tokens et en appliquant des stratégie...

Découvrez comment créer un chatbot IA puissant pour votre site web en seulement 10 minutes avec FlowHunt. Ce guide couvre la configuration, la gestion de la bas...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.