Comment créer un chatbot IA : Guide complet étape par étape

Découvrez comment créer un chatbot IA de A à Z grâce à notre guide complet. Trouvez les meilleurs outils, frameworks et la démarche détaillée pour concevoir des...

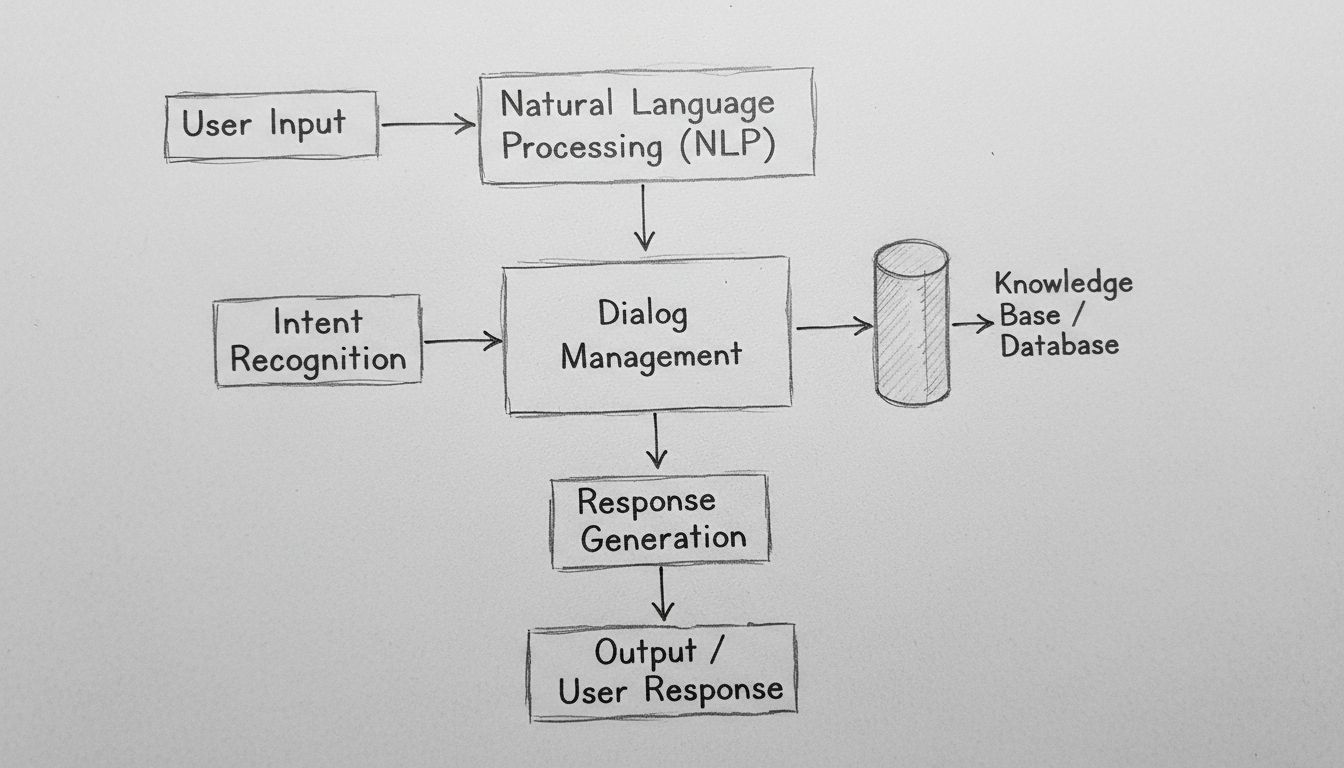

Découvrez comment les chatbots IA traitent le langage naturel, comprennent l’intention de l’utilisateur et génèrent des réponses intelligentes. Apprenez le NLP, le machine learning et l’architecture des chatbots avec une profondeur technique.

Les chatbots IA fonctionnent en traitant les entrées en langage naturel via des algorithmes de NLP, en reconnaissant l’intention de l’utilisateur, en accédant à des bases de connaissances et en générant des réponses contextuellement pertinentes à l’aide de modèles d’apprentissage automatique. Les chatbots modernes combinent la tokenisation, l’extraction d’entités, la gestion du dialogue et les réseaux neuronaux pour simuler des conversations humaines à grande échelle.

Les chatbots IA représentent une convergence sophistiquée du traitement du langage naturel, du machine learning et des systèmes de gestion du dialogue travaillant de concert pour simuler une conversation humaine. Lorsque vous interagissez avec un chatbot IA moderne, vous engagez un système technologique à plusieurs couches qui traite votre entrée à travers plusieurs étapes distinctes avant de fournir une réponse. L’architecture sous-jacente à ces systèmes a considérablement évolué, passant de simples arbres de décision basés sur des règles à des réseaux neuronaux complexes capables de comprendre le contexte, la nuance et même le sentiment. Comprendre le fonctionnement de ces systèmes exige d’examiner chaque composant de la chaîne et de reconnaître comment ils interagissent pour créer des expériences conversationnelles fluides.

Le parcours de tout message utilisateur dans un chatbot IA commence par le traitement de l’entrée, une phase critique qui transforme le texte brut en données structurées que le système peut analyser. Lorsque vous tapez un message comme « Je dois réinitialiser mon mot de passe », le chatbot ne comprend pas immédiatement votre intention ; il doit d’abord décomposer votre message en éléments gérables. Ce processus, appelé tokenisation, divise votre phrase en mots individuels ou en unités significatives appelées tokens. Le système convertit « Je dois réinitialiser mon mot de passe » en tokens : [“Je”, “dois”, “réinitialiser”, “mon”, “mot”, “de”, “passe”]. Cette étape apparemment simple est fondamentale car elle permet au chatbot d’analyser chaque élément linguistique indépendamment tout en gardant la conscience de leurs relations dans la structure de la phrase.

Après la tokenisation, le système applique une normalisation, qui standardise le texte en le convertissant en minuscules, en supprimant la ponctuation et en corrigeant les variantes orthographiques courantes. Cela garantit que « Réinitialisation du mot de passe », « réinitialisation du mot de passe » et « reinitialisation du mot de passe » sont tous reconnus comme se référant au même concept. Le chatbot supprime également les mots vides — des mots courants comme « le », « est », « et » et « à » qui portent peu de signification sémantique. En les filtrant, le système concentre ses ressources de calcul sur les mots qui véhiculent effectivement du sens. De plus, le système effectue un étiquetage des parties du discours, identifiant si chaque mot fonctionne comme un nom, un verbe, un adjectif ou une autre catégorie grammaticale. Cette compréhension grammaticale aide le chatbot à reconnaître que « réinitialiser » est un verbe d’action dans votre message, ce qui est essentiel pour déterminer ce que vous souhaitez accomplir.

Le Traitement du Langage Naturel (NLP) constitue la base technologique qui permet aux chatbots de comprendre le langage humain au niveau sémantique. Le NLP englobe de multiples techniques interconnectées qui travaillent ensemble pour extraire le sens du texte. La Reconnaissance d’Entités Nommées (NER) identifie les entités spécifiques dans votre message — noms propres, dates, lieux, noms de produits et autres informations importantes. Dans l’exemple de réinitialisation de mot de passe, la NER identifierait « mot de passe » comme une entité système pertinente pour la base de connaissances du chatbot. Cette capacité devient encore plus puissante dans des scénarios complexes : si vous écrivez « Je veux réserver un vol de Paris à Londres le 15 décembre », la NER extrait la ville de départ, la ville d’arrivée et la date — toutes des informations critiques pour satisfaire votre demande.

L’analyse de sentiment représente un autre élément crucial du NLP, permettant aux chatbots de détecter le ton émotionnel sous-jacent à votre message. Un client qui dit « J’attends depuis trois heures et je n’ai toujours pas reçu ma commande » exprime de la frustration, que le chatbot doit reconnaître pour ajuster le ton de sa réponse et prioriser le problème de manière appropriée. L’analyse de sentiment moderne utilise des modèles d’apprentissage automatique entraînés sur des milliers d’exemples pour classer le texte comme positif, négatif ou neutre, et de plus en plus, pour détecter des émotions plus nuancées comme la frustration, la confusion ou la satisfaction. Cette intelligence émotionnelle permet aux chatbots de répondre avec empathie et urgence, améliorant significativement les indicateurs de satisfaction client.

Après avoir traité le texte brut, le chatbot doit déterminer ce que l’utilisateur veut réellement — son intention. La reconnaissance d’intention est l’une des fonctions les plus critiques dans l’architecture des chatbots car elle comble le fossé entre ce que les utilisateurs disent et ce qu’ils veulent accomplir. Le système utilise des classificateurs d’apprentissage automatique entraînés sur des milliers de conversations pour associer les énoncés des utilisateurs à des intentions prédéfinies. Par exemple, les phrases « J’ai oublié mon mot de passe », « Comment réinitialiser mon mot de passe ? », « Je ne peux pas me connecter » et « Mon compte est bloqué » pourraient toutes correspondre à la même intention « réinitialisation_mot_de_passe », même si elles sont formulées différemment.

Simultanément, le système effectue une extraction d’entités, identifiant des données spécifiques dans le message de l’utilisateur pertinentes pour satisfaire la demande. Si un client dit « Je souhaite passer à l’offre premium », le système extrait deux entités clés : l’action (« passer à ») et la cible (« offre premium »). Ces entités extraites deviennent des paramètres qui guident la génération de réponse du chatbot. Les chatbots avancés utilisent l’analyse de dépendances pour comprendre les relations grammaticales entre les mots, reconnaissant quels noms sont des sujets, lesquels sont des objets, et comment ils se rapportent aux verbes et modificateurs. Cette compréhension syntaxique approfondie permet au chatbot de gérer des phrases complexes à plusieurs propositions et des formulations ambiguës qui dérouteraient des systèmes plus simples.

La gestion du dialogue représente le « cerveau » du chatbot, responsable du maintien du contexte et de la détermination des réponses appropriées. Contrairement aux systèmes simples à recherche directe, les gestionnaires de dialogue sophistiqués maintiennent un état de conversation qui suit ce qui a été discuté, quelles informations ont été recueillies et quel est l’objectif actuel de l’utilisateur. Cette conscience du contexte permet des conversations naturelles et fluides où le chatbot se souvient des échanges précédents et peut s’y référer de manière appropriée. Si vous demandez « Quel temps fait-il à Paris ? » puis enchaînez avec « Et demain ? », le gestionnaire de dialogue comprend que « demain » fait référence à la météo à Paris, et non à un autre endroit.

Le gestionnaire de dialogue met en œuvre la gestion du contexte en stockant les informations pertinentes dans un format structuré tout au long de la conversation. Cela peut inclure les informations de compte de l’utilisateur, ses précédentes demandes, ses préférences, et le sujet actuel de la conversation. Les systèmes avancés utilisent des machines à états ou des réseaux hiérarchiques de tâches pour modéliser les flux conversationnels, définissant quels états sont accessibles depuis d’autres et quelles transitions sont valides. Par exemple, un chatbot de service client peut avoir des états « accueil », « identification du problème », « résolution », « escalade », « clôture ». Le gestionnaire de dialogue garantit que la conversation progresse logiquement à travers ces états plutôt que de passer aléatoirement de l’un à l’autre.

Les chatbots IA modernes ne génèrent pas leurs réponses uniquement à partir de leurs données d’entraînement — ils accèdent à des bases de connaissances contenant des informations actuelles et précises spécifiques à l’organisation. Cette intégration est essentielle pour garantir l’exactitude et la pertinence. Lorsqu’un client demande « Quel est le solde de mon compte ? », le chatbot doit interroger le système bancaire réel pour obtenir le solde actuel plutôt que de générer un nombre plausible. De même, pour « Quels sont vos horaires d’ouverture ? », le chatbot accède à la base de données des informations commerciales pour fournir des horaires à jour plutôt que de s’appuyer sur des données d’entraînement potentiellement obsolètes.

La génération augmentée par récupération (RAG) représente une approche sophistiquée de l’intégration des connaissances devenue de plus en plus importante en 2025. Les systèmes RAG récupèrent d’abord les documents ou informations pertinents d’une base de connaissances en fonction de la requête de l’utilisateur, puis utilisent ces informations récupérées pour générer une réponse contextuelle appropriée. Ce processus en deux étapes améliore considérablement la précision par rapport aux approches purement génératives. Par exemple, si un client pose une question sur une fonctionnalité produit, le système RAG récupère la documentation du produit, extrait la section pertinente et génère une réponse fondée sur cette documentation réelle plutôt que sur des informations potentiellement inventées. Cette approche s’avère particulièrement précieuse en entreprise où l’exactitude et la conformité sont primordiales.

Après avoir compris l’intention de l’utilisateur et collecté les informations nécessaires, le chatbot doit générer une réponse appropriée. La génération de réponses peut suivre différentes approches, chacune ayant ses avantages et limites. La génération basée sur des modèles utilise des templates de réponses prédéfinis avec des variables à remplir. Par exemple : « Votre commande n°[NUMERO_COMMANDE] arrivera le [DATE_LIVRAISON]. » Cette approche est très fiable et prévisible mais limitée en flexibilité et naturel.

La génération basée sur des règles applique des règles linguistiques spécifiques pour construire les réponses en fonction de l’intention et des entités extraites. Ces règles peuvent spécifier que pour une intention « réinitialisation_mot_de_passe », la réponse doit inclure un message de confirmation, un lien vers la page de réinitialisation et des instructions pour la suite. Cette approche offre plus de flexibilité que les modèles tout en restant fiable, bien qu’elle nécessite une ingénierie de règles poussée pour les scénarios complexes.

La génération basée sur les réseaux neuronaux, propulsée par les grands modèles de langage (LLM), représente l’état de l’art en matière de génération de réponses. Ces systèmes utilisent des architectures de deep learning comme les Transformers pour générer des réponses inédites et contextuelles qui sonnent remarquablement humain. Les LLM modernes sont entraînés sur des milliards de tokens textuels, apprenant les schémas statistiques du langage et les relations conceptuelles. Lors de la génération d’une réponse, ces modèles prédisent le mot le plus probable après les précédents, répétant ce processus jusqu’à produire des phrases complètes. L’avantage de la génération neuronale est sa flexibilité et son naturel ; l’inconvénient est que ces systèmes peuvent parfois halluciner — générer des informations plausibles mais incorrectes.

L’apprentissage automatique constitue le mécanisme par lequel les chatbots s’améliorent au fil du temps. Au lieu d’être des systèmes statiques à règles fixes, les chatbots modernes apprennent de chaque interaction, affinant progressivement leur compréhension des schémas linguistiques et des intentions utilisateurs. L’apprentissage supervisé implique d’entraîner le chatbot sur des exemples annotés où des humains ont identifié la bonne intention et les entités pour des milliers de messages. L’algorithme apprend à reconnaître les motifs qui distinguent une intention d’une autre, construisant progressivement un modèle capable de classer de nouveaux messages avec une grande précision.

L’apprentissage par renforcement permet aux chatbots d’optimiser leurs réponses à partir des retours des utilisateurs. Quand un utilisateur indique sa satisfaction (via un feedback explicite ou des signaux implicites comme la poursuite de la conversation), le système renforce les schémas ayant mené à cette réponse. Inversement, en cas d’insatisfaction ou d’abandon, le système apprend à éviter ces schémas à l’avenir. Cette boucle de rétroaction crée un cercle vertueux d’amélioration continue. Les systèmes avancés mettent en œuvre un apprentissage avec intervention humaine, où des agents humains révisent les conversations difficiles et fournissent des corrections dont le système tire des enseignements, accélérant nettement l’amélioration par rapport à un apprentissage purement automatique.

Les grands modèles de langage (LLM) ont fondamentalement transformé les capacités des chatbots depuis 2023. Entraînés sur des centaines de milliards de tokens, ces modèles développent une compréhension sophistiquée du langage, du contexte et des connaissances métier. Des modèles comme GPT-4, Claude et Gemini peuvent mener des conversations nuancées, comprendre des instructions complexes et générer des réponses cohérentes sur divers sujets. Leur puissance réside dans l’architecture Transformer, qui utilise des mécanismes d’attention pour comprendre les relations entre des mots éloignés dans une phrase, permettant ainsi au modèle de maintenir le contexte sur de longues conversations.

Cependant, les LLM présentent des limites que les organisations doivent gérer. Ils peuvent halluciner — générer avec assurance de fausses informations plausibles. Ils peuvent avoir des difficultés avec des informations très récentes absentes de leurs données d’entraînement. Ils peuvent exprimer des biais présents dans leurs données. Pour pallier ces limites, les organisations recourent de plus en plus à l’affinage (fine-tuning) pour adapter les LLM à des domaines spécifiques, et à l’ingénierie de prompt pour orienter les modèles vers les comportements souhaités. L’approche FlowHunt pour la création de chatbots exploite ces modèles avancés tout en offrant des garde-fous et une intégration de sources de connaissances pour garantir l’exactitude et la fiabilité.

| Aspect | Chatbots à règles | Chatbots IA | Chatbots LLM |

|---|---|---|---|

| Technologie | Arbres de décision, correspondance de motifs | NLP, algorithmes ML, reconnaissance d’intention | Grands modèles de langage, transformers |

| Flexibilité | Limitée aux règles définies | S’adapte aux variations de formulation | Très flexible, gère les entrées inédites |

| Précision | Élevée pour les scénarios définis | Bonne avec un bon entraînement | Excellente mais nécessite des garde-fous |

| Apprentissage | Aucune capacité d’apprentissage | Apprend des interactions | Apprend via affinage et retours utilisateurs |

| Risque d’hallucination | Aucun | Minime | Nécessite des stratégies d’atténuation |

| Délai de mise en œuvre | Rapide | Modéré | Rapide avec des plateformes comme FlowHunt |

| Maintenance | Élevée (mise à jour des règles) | Modérée | Modérée (mise à jour modèles, surveillance) |

| Coût | Faible | Modéré | Modéré à élevé |

| Cas d’usage idéaux | FAQ simples, routage basique | Service client, qualification de leads | Raisonnement complexe, génération de contenu |

Les chatbots modernes exploitent l’architecture Transformer, un design de réseau neuronal qui a révolutionné le traitement du langage naturel. Les Transformers utilisent des mécanismes d’attention permettant au modèle de se concentrer sur les parties pertinentes de l’entrée lors de la génération de chaque mot en sortie. Lors du traitement de « Le banquier était préoccupé par l’érosion de la berge du fleuve », l’attention aide le modèle à comprendre que le premier « banque » désigne une institution financière alors que le second fait référence à une berge, selon le contexte. Cette compréhension contextuelle est bien supérieure aux approches anciennes qui traitaient le texte séquentiellement sans ce niveau de conscience contextuelle.

L’attention multi-têtes étend ce concept en permettant au modèle de se concentrer simultanément sur différents aspects de l’entrée. Une tête d’attention peut se focaliser sur les relations grammaticales, une autre sur les relations sémantiques, une autre sur la structure du discours. Ce traitement parallèle des phénomènes linguistiques permet au modèle de construire des représentations riches et nuancées du sens. Le codage positionnel dans les Transformers permet au modèle de comprendre l’ordre des mots, même en traitant tous les mots en parallèle, une capacité essentielle pour saisir la signification là où l’ordre des mots est important.

FlowHunt propose une approche moderne du développement de chatbots qui abstrait une grande partie de la complexité technique tout en offrant un accès à de puissantes capacités IA. Plutôt que d’exiger la création d’une infrastructure de chatbot sur mesure, FlowHunt fournit un constructeur visuel permettant aux utilisateurs non techniques de concevoir des flux de conversation par simple assemblage de composants représentant différentes fonctions du chatbot. La plateforme gère le NLP, la reconnaissance d’intention et la génération de réponses, laissant les équipes se concentrer sur la conception de l’expérience conversationnelle et l’intégration à leurs systèmes métiers.

La fonctionnalité Sources de connaissances de FlowHunt permet aux chatbots d’accéder à des informations en temps réel depuis des documents, sites web et bases de données, mettant en œuvre les principes RAG pour garantir l’exactitude. La capacité Agents IA de la plateforme permet de créer des systèmes autonomes capables d’agir au-delà de la simple conversation — mise à jour de bases de données, envoi d’e-mails, planification de rendez-vous ou déclenchement de workflows. Cela représente une évolution majeure par rapport aux chatbots traditionnels qui se limitaient à fournir des informations : les systèmes FlowHunt peuvent réellement accomplir des tâches pour le compte des utilisateurs. Les capacités d’intégration de la plateforme relient les chatbots aux CRM, logiciels de helpdesk et applications métier, assurant un flux de données et une exécution d’actions sans couture.

Un déploiement efficace de chatbot nécessite la surveillance d’indicateurs clés révélant si le système atteint les objectifs fixés. L’exactitude de la reconnaissance d’intention mesure le pourcentage de messages utilisateurs correctement classés. L’exactitude de l’extraction d’entités mesure si le système identifie les données pertinentes. Les scores de satisfaction utilisateur collectés via des enquêtes indiquent si l’interaction a été jugée utile. Le taux de complétion de conversation mesure la part des conversations où le problème de l’utilisateur est résolu sans intervention humaine.

La latence de réponse mesure la rapidité de génération des réponses — essentielle pour l’expérience utilisateur, car des délais de quelques secondes suffisent à réduire la satisfaction. Le taux d’escalade indique la part des conversations nécessitant un transfert à un humain, un taux faible étant généralement signe de bonne performance. Le coût par conversation mesure l’efficacité économique du chatbot, comparant le coût du traitement IA à celui d’un agent humain. Les organisations doivent établir des valeurs de référence avant le déploiement puis surveiller continuellement ces indicateurs pour identifier des axes d’amélioration et garantir la création de valeur au fil de l’évolution des usages.

Les chatbots gèrent fréquemment des informations sensibles : données personnelles, informations financières, détails confidentiels d’entreprise. Le chiffrement des données garantit que les informations transmises entre utilisateurs et systèmes chatbot sont protégées contre l’interception. Les mécanismes d’authentification vérifient l’identité des utilisateurs avant de donner accès à des informations sensibles. Les contrôles d’accès s’assurent que les chatbots ne consultent que les données strictement nécessaires, selon le principe du moindre privilège. Il est impératif de mettre en œuvre une journalisation des accès pour conserver des traces de toutes les interactions, à des fins de conformité et de sécurité.

Les principes de privacy by design doivent guider le développement, en minimisant la collecte de données personnelles, en limitant leur conservation, et en assurant la transparence sur leur utilisation. Le respect des réglementations telles que RGPD, CCPA, ou celles spécifiques à l’industrie comme HIPAA ou PCI-DSS, est essentiel. Il convient de réaliser des audits de sécurité pour identifier les vulnérabilités et déployer des mesures adaptées. La responsabilité en matière de sécurité s’étend au-delà de la plateforme de chatbot elle-même aux bases de connaissances, intégrations et systèmes back-end auxquels le chatbot accède.

L’évolution des chatbots s’accélère. Les chatbots multimodaux capables de traiter et générer du texte, de la voix, des images et de la vidéo représentent la prochaine frontière. Plutôt que des interactions uniquement textuelles, les utilisateurs dialogueront de plus en plus via le canal de leur choix — la voix pour les situations mains libres, l’image pour des questions visuelles produits, la vidéo pour des démonstrations complexes. L’intelligence émotionnelle progressera au-delà de la simple détection du sentiment vers une compréhension nuancée de l’état émotionnel de l’utilisateur et des réponses appropriées. Les chatbots détecteront la frustration, la confusion ou la satisfaction, et adapteront leur style de communication en conséquence.

L’assistance proactive est une autre capacité émergente où le chatbot anticipe les besoins de l’utilisateur avant même une demande explicite. Plutôt que d’attendre les questions, il saura détecter des indices de problèmes potentiels et proposer spontanément de l’aide. La personnalisation deviendra plus sophistiquée, avec des chatbots adaptant leur style, recommandations et assistance selon les préférences, l’historique et le contexte de chaque utilisateur. L’intégration aux systèmes autonomes permettra aux chatbots de coordonner des processus automatisés, des objets connectés et d’autres systèmes pour accomplir des tâches complexes nécessitant orchestration et transversalité.

Comprendre comment fonctionnent les chatbots IA explique pourquoi ils sont devenus des outils incontournables dans tous les secteurs. L’interaction sophistiquée entre NLP, apprentissage automatique, gestion du dialogue et intégration de connaissances permet aux chatbots de traiter des tâches toujours plus complexes tout en maintenant des échanges naturels. Les organisations qui déploient efficacement des chatbots — via des plateformes comme FlowHunt qui abstraient la complexité technique tout en conservant de puissantes capacités — bénéficient d’avantages concurrentiels majeurs grâce à une meilleure satisfaction client, une réduction des coûts et des délais de réponse accélérés.

La technologie évolue rapidement, avec l’essor des modèles de langage, des capacités multimodales et des agents autonomes élargissant le champ des possibles. Les organisations doivent considérer la mise en place d’un chatbot non pas comme un projet ponctuel, mais comme une capacité évolutive s’améliorant au fil des apprentissages, optimisations et enrichissements continus. Les déploiements les plus réussis combinent une technologie IA puissante à une conception conversationnelle réfléchie, des garde-fous pour garantir la sécurité et l’exactitude, et une intégration aux systèmes métiers permettant aux chatbots d’agir concrètement. À l’horizon 2025 et au-delà, les chatbots deviendront de plus en plus l’interface principale entre clients, collaborateurs et organisations, faisant de l’investissement dans cette technologie un enjeu stratégique pour la réussite des entreprises.

Cessez de gérer manuellement les demandes répétitives des clients. Le générateur de chatbots IA sans code de FlowHunt vous permet de créer des chatbots intelligents et autonomes qui gèrent le service client, la génération de leads et le support 24h/24. Déployez en quelques minutes, pas en semaines.

Découvrez comment créer un chatbot IA de A à Z grâce à notre guide complet. Trouvez les meilleurs outils, frameworks et la démarche détaillée pour concevoir des...

Découvrez comment construire un chatbot IA pour Discord avec des instructions étape par étape, des méthodes d'intégration d'API, la gestion des erreurs, les mei...

Découvrez à quel domaine de l'IA appartiennent les chatbots. Comprenez le Traitement du Langage Naturel, l'apprentissage automatique, le Deep Learning et les te...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.