Réseaux Bayésiens

Un Réseau Bayésien (BN) est un modèle graphique probabiliste qui représente des variables et leurs dépendances conditionnelles via un graphe orienté acyclique (...

Naive Bayes est une famille d’algorithmes de classification simples mais puissants utilisant le théorème de Bayes, couramment utilisée pour des tâches évolutives comme la détection de spam et la classification de texte.

Naive Bayes est une famille d’algorithmes de classification simples et efficaces, basée sur le théorème de Bayes, supposant l’indépendance conditionnelle entre les variables. Il est largement utilisé pour la détection de spam, la classification de texte, et bien plus, en raison de sa simplicité et de son évolutivité.

Naive Bayes est une famille d’algorithmes de classification fondée sur le théorème de Bayes, qui applique le principe de probabilité conditionnelle. Le terme « naïf » fait référence à l’hypothèse simplificatrice selon laquelle toutes les variables d’un ensemble de données sont conditionnellement indépendantes les unes des autres, étant donné l’étiquette de classe. Bien que cette hypothèse soit souvent violée dans les données réelles, les classificateurs Naive Bayes sont reconnus pour leur simplicité et leur efficacité dans de nombreuses applications, telles que la classification de texte et la détection de spam.

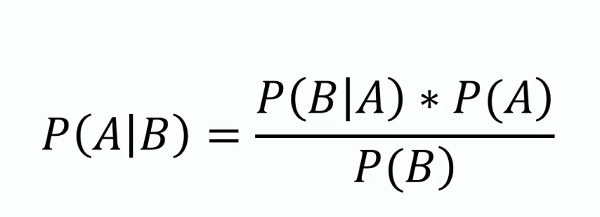

Théorème de Bayes

Ce théorème constitue la base de Naive Bayes, fournissant une méthode pour mettre à jour l’estimation de probabilité d’une hypothèse à mesure que de nouvelles informations deviennent disponibles. Mathématiquement, il s’exprime ainsi :

où ( P(A|B) ) est la probabilité a posteriori, ( P(B|A) ) la vraisemblance, ( P(A) ) la probabilité a priori, et ( P(B) ) la probabilité de l’évidence.

Indépendance conditionnelle

L’hypothèse naïve selon laquelle chaque variable est indépendante de toutes les autres, étant donné l’étiquette de classe. Cette hypothèse simplifie le calcul et permet à l’algorithme de passer à l’échelle sur de grands jeux de données.

Probabilité a posteriori

La probabilité de l’étiquette de classe au vu des valeurs des variables, calculée à l’aide du théorème de Bayes. C’est l’élément central pour faire des prédictions avec Naive Bayes.

Types de classificateurs Naive Bayes

Les classificateurs Naive Bayes fonctionnent en calculant la probabilité a posteriori pour chaque classe en fonction d’un ensemble de variables, puis en sélectionnant la classe ayant la probabilité a posteriori la plus élevée. Le processus implique les étapes suivantes :

Les classificateurs Naive Bayes sont particulièrement efficaces dans les applications suivantes :

Prenons l’exemple d’une application de filtrage de spam utilisant Naive Bayes. Les données d’entraînement sont constituées d’e-mails étiquetés « spam » ou « non spam ». Chaque e-mail est représenté par un ensemble de variables telles que la présence de mots spécifiques. Lors de l’apprentissage, l’algorithme calcule la probabilité de chaque mot selon l’étiquette de classe. Pour un nouvel e-mail, l’algorithme calcule la probabilité a posteriori pour « spam » et « non spam » et attribue l’étiquette la plus probable.

Les classificateurs Naive Bayes peuvent être intégrés dans des systèmes d’IA et des chatbots pour améliorer leurs capacités de traitement du langage naturel et renforcer l’interaction homme-machine. Par exemple, ils peuvent servir à détecter l’intention des requêtes utilisateur, classer des textes dans des catégories prédéfinies ou filtrer du contenu inapproprié. Cette fonctionnalité améliore la qualité et la pertinence des solutions basées sur l’IA. De plus, l’efficacité de l’algorithme le rend adapté aux applications en temps réel, un point clé pour l’automatisation par IA et les systèmes de chatbots.

Naive Bayes est une famille d’algorithmes probabilistes simples mais puissants, reposant sur l’application du théorème de Bayes avec des hypothèses fortes d’indépendance entre les variables. Il est largement utilisé pour les tâches de classification en raison de sa simplicité et de son efficacité. Voici quelques articles scientifiques présentant diverses applications et améliorations du classificateur Naive Bayes :

Amélioration du filtrage de spam en combinant Naive Bayes avec des recherches k-plus proches voisins simples

Auteur : Daniel Etzold

Publié : 30 novembre 2003

Cet article explore l’utilisation de Naive Bayes pour la classification des e-mails, mettant en avant sa simplicité d’implémentation et son efficacité. L’étude présente des résultats empiriques montrant que la combinaison de Naive Bayes avec des recherches k-plus proches voisins peut améliorer la précision des filtres anti-spam. La combinaison apporte de légères améliorations avec un grand nombre de variables et des améliorations significatives avec moins de variables. Lire l’article.

Naive Bayes pondéré localement

Auteurs : Eibe Frank, Mark Hall, Bernhard Pfahringer

Publié : 19 octobre 2012

Cet article s’attaque à la principale faiblesse de Naive Bayes : l’hypothèse d’indépendance des variables. Il introduit une version localement pondérée de Naive Bayes qui apprend des modèles locaux lors de la prédiction, relâchant ainsi l’hypothèse d’indépendance. Les résultats expérimentaux montrent que cette approche ne dégrade que rarement la précision et l’améliore souvent significativement. Cette méthode est saluée pour sa simplicité conceptuelle et computationnelle par rapport à d’autres techniques. Lire l’article.

Détection de l’enlisement des rovers planétaires par Naive Bayes

Auteur : Dicong Qiu

Publié : 31 janvier 2018

Cette étude traite de l’application des classificateurs Naive Bayes pour la détection de l’enlisement des rovers planétaires. Elle définit les critères d’enlisement et démontre l’utilisation de Naive Bayes pour détecter de tels scénarios. L’article détaille des expériences réalisées avec des rovers AutoKrawler, donnant un aperçu de l’efficacité de Naive Bayes pour les procédures de secours autonomes. Lire l’article.

Naive Bayes est une famille d'algorithmes de classification basée sur le théorème de Bayes, qui suppose que toutes les variables sont conditionnellement indépendantes étant donné l'étiquette de classe. Il est largement utilisé pour la classification de texte, le filtrage de spam et l'analyse de sentiment.

Les principaux types sont : Naive Bayes Gaussien (pour les variables continues), Naive Bayes Multinomial (pour les variables discrètes comme les occurrences de mots) et Naive Bayes Bernoulli (pour les variables binaires/booléennes).

Naive Bayes est simple à implémenter, efficace en calcul, évolutif sur de grands jeux de données et gère bien les données de haute dimension.

Sa principale limitation est l’hypothèse d’indépendance des variables, qui est souvent fausse dans les données réelles. Il peut aussi attribuer une probabilité nulle aux variables non observées, ce qui peut être atténué par des techniques comme le lissage de Laplace.

Naive Bayes est utilisé dans les systèmes d'IA et les chatbots pour la détection d’intention, la classification de texte, le filtrage de spam et l’analyse de sentiment, améliorant les capacités de traitement du langage naturel et permettant la prise de décision en temps réel.

Chatbots intelligents et outils d’IA sous un même toit. Connectez des blocs intuitifs pour transformer vos idées en Flows automatisés.

Un Réseau Bayésien (BN) est un modèle graphique probabiliste qui représente des variables et leurs dépendances conditionnelles via un graphe orienté acyclique (...

Un classificateur IA est un algorithme d'apprentissage automatique qui attribue des étiquettes de classe aux données d'entrée, en catégorisant les informations ...

L'apprentissage non supervisé est une branche de l'apprentissage automatique axée sur la découverte de motifs, de structures et de relations dans des données no...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.